ท่ามกลางการเติบโตของการใช้รถยนต์ไฟฟ้า (EV) และการติดตั้งระบบกักเก็บพลังงานในครัวเรือน การจัดการโหลดไฟฟ้าในช่วงพีคกลายเป็นความท้าทายสำคัญสำหรับกริดประเทศไทย โครงการนำร่องล่าสุดในเมืองขนาดเล็กของไทยได้นำเทคโนโลยี Reinforcement Learning (RL) มาทดลองใช้ในการจัดสรรการชาร์จของรถ EV และแบตเตอรี่บ้านแบบกระจาย ผลลัพธ์เบื้องต้นน่าจับตามอง — สามารถลดพีคโหลดได้ประมาณ 20–30% พร้อมทั้งช่วยรักษาความเสถียรของความถี่กริดและลดความผันผวนที่เสี่ยงต่อการเกิดไฟฟ้าดับ ทำให้ชุมชนได้รับประโยชน์ทั้งทางเทคนิคและทางเศรษฐกิจ

ระบบที่ใช้ RL ทำหน้าที่เป็นตัวตัดสินเชิงนโยบายแบบเรียลไทม์ จัดลำดับความสำคัญการชาร์จ-จ่ายพลังงานระหว่างยานพาหนะกับแบตเตอรี่บ้านโดยคำนึงถึงสัญญาณความถี่ สถานะการชาร์จ และราคาพลังงาน ผลการทดลองแสดงให้เห็นการลดยอดพีคสูงสุดในช่วงชั่วโมงเร่งด่วน ลดการเบียดเสียดของโหลด และลดต้นทุนค่าไฟของชุมชนเมื่อเทียบกับการชาร์จแบบสุ่มหรือไม่มีการประสานงาน ข้อมูลจากโครงการยังชี้ว่าแนวทางนี้สามารถขยายสเกลได้ในระดับเมืองใหญ่หากผนวกกับนโยบายส่งเสริมและการลงทุนโครงข่ายที่เหมาะสม

บทนำ: ผลลัพธ์เด่นของโครงการนำร่อง

บทนำ: ผลลัพธ์เด่นของโครงการนำร่อง

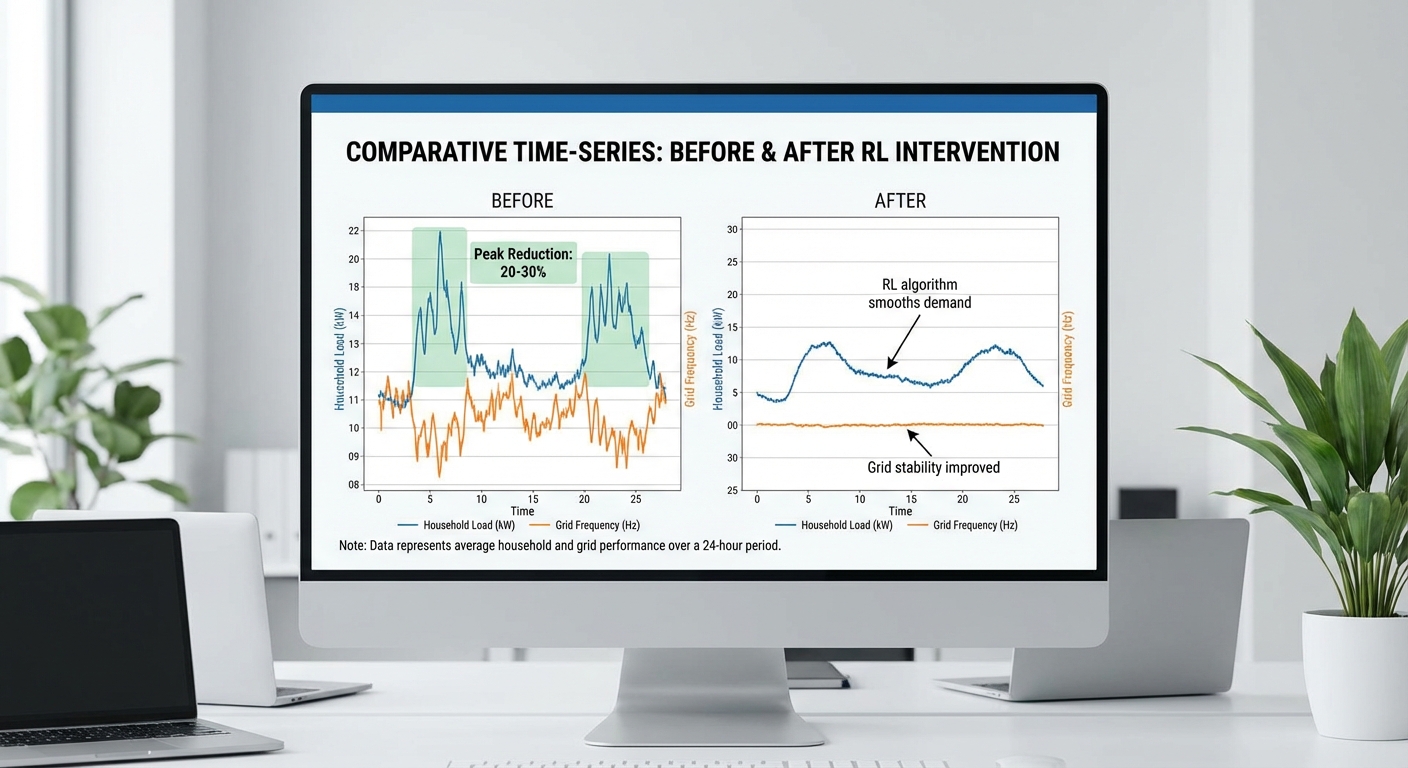

โครงการนำร่องในชุมชนเมืองขนาดเล็กของไทยซึ่งทดสอบระบบจัดสรรการชาร์จโดยใช้ Reinforcement Learning (RL) สำหรับรถยนต์ไฟฟ้า (EV) และแบตเตอรี่บ้านแบบกระจาย สามารถลดพีคโหลดของระบบไฟฟ้าได้ระหว่าง 20–30% ขณะเดียวกันยังช่วยรักษาเสถียรภาพความถี่ของกริดให้อยู่ในเกณฑ์ที่แคบลงในช่วงเวลาที่มีความต้องการสูง ผลลัพธ์นี้เกิดขึ้นจากการบริหารจัดการการชาร์จ/คายประจุแบบไดนามิกโดยอาศัยการเรียนรู้เชิงนโยบายที่ตอบสนองต่อสัญญาณราคาพลังงาน สถานะแบตเตอรี่ และการเบี่ยงเบนความถี่ของระบบ

การวัดผลถูกดำเนินการตลอดระยะทดลองเป็นระยะหลายเดือน โดยเน้นการประเมินผลในช่วงชั่วโมงพีคของวัน (ตัวอย่างเช่นช่วงเย็นประมาณ 17:00–21:00) และในวันที่มีโหลดสูงสุดของสัปดาห์ ผลการวิเคราะห์แบบเปรียบเทียบกับกรณีควบคุม (ไม่มีการจัดสรรด้วย RL) แสดงให้เห็นการลดพีคโดยเฉลี่ยในช่วง 20–30% และการลดความผันผวนของสัญญาณความถี่ในช่วงพีคอย่างมีนัยสำคัญ ตัวอย่างเช่น ระบบสามารถเลื่อนการชาร์จ EV ออกนอกช่วงพีคและสั่งคายประจุแบตเตอรี่บ้านเพื่อชดเชยช่วงโหลดสูงสุด โดยยังคงความต้องการใช้งานของผู้บริโภคได้ตามความพึงพอใจที่กำหนดไว้

กรอบงานเชิงเทคนิคที่ใช้คือตัวแทน RL แบบกระจายที่ตัดสินใจเชิงนโยบายในระดับอุปกรณ์ (device-level agents) ภายใต้ข้อจำกัดของการสื่อสารและความเป็นส่วนตัว โดยมีการตั้งรางวัล (reward) ที่ผสมระหว่างการลดพีคโหลด การรักษาความถี่ และความสะดวกของผู้ใช้งาน เมธอดนี้รวมการเรียนรู้จากข้อมูลการใช้งานจริง การจำลองความต้องการไฟฟ้า และการทดลองภาคสนามแบบออน-ไซต์ ผลลัพธ์ชี้ให้เห็นว่าแนวทาง RL ที่ประสานงานกันในระดับย่อย (distributed coordination) สามารถให้ผลลัพธ์ใกล้เคียงกับการจัดการแบบรวมศูนย์ แต่มีความยืดหยุ่นและคงรักษาความเป็นส่วนตัวของผู้ใช้งานดีกว่า

ในบทความนี้ เราจะลงรายละเอียดในประเด็นสำคัญต่อไปดังนี้:

- เทคโนโลยี: สถาปัตยกรรม RL แบบกระจาย อัลกอริทึมที่ใช้ และการผสานกับสัญญาณกริด

- วิธีการทดลอง: ขอบเขตการทดลอง (ครัวเรือนหลายร้อยหน่วยและยานพาหนะจำนวนตัวอย่างเชิงสถิติ), ตัวชี้วัดการวัดผล และชุดข้อมูลที่ใช้

- ผลลัพธ์: การลดพีค 20–30% รายงานเชิงปริมาณ การเปลี่ยนแปลงความผันผวนของความถี่ และตัวอย่างกรณีการใช้งาน

- ข้อเสนอแนะเชิงนโยบาย/เชิงพาณิชย์: ผลกระทบต่อการวางแผนโครงสร้างพื้นฐาน กรอบการกำกับดูแล และโมเดลธุรกิจสำหรับผู้ให้บริการจัดการพลังงาน (aggregators)

ปัญหาเชิงพลังงาน: พีคโหลดและความถี่กริดคืออะไรและทำไมต้องสนใจ

ปัญหาเชิงพลังงาน: พีคโหลดและความถี่กริดคืออะไรและทำไมต้องสนใจ

พีคโหลด (peak load) หมายถึงช่วงเวลาที่ความต้องการใช้ไฟฟ้าสูงสุดในระบบกริดภายในวัน สัปดาห์ หรือฤดูกาล ตัวอย่างง่าย ๆ คือช่วงเย็นที่ครัวเรือนเปิดเครื่องปรับอากาศ เครื่องทำน้ำอุ่น และชาร์จรถยนต์ไฟฟ้าพร้อมกัน ทำให้ปริมาณกำลังไฟฟ้าที่ต้องจ่ายสูงกว่าปกติ พีคโหลด เป็นตัวชี้วัดสำคัญในการออกแบบความสามารถการผลิตและส่งจ่ายของระบบไฟฟ้า เพราะต้องเตรียมทรัพยากร (เช่น โรงไฟฟ้าเพิ่มเติม สายส่ง และระบบสำรอง) เพื่อรองรับช่วงพีคนั้น

ความถี่กริด (grid frequency) คือมาตรวัดความสมดุลระหว่างกำลังผลิตและความต้องการไฟฟ้า ในประเทศไทยความถี่มาตรฐานคือประมาณ 50 Hz หากโหลดมากกว่ากำลังผลิต ความถี่จะลดลง และหากกำลังผลิตเกิน โหลด ความถี่จะเพิ่มขึ้น การเบี่ยงเบนของความถี่แม้เพียงเล็กน้อยอาจนำไปสู่การตอบสนองอัตโนมัติของอุปกรณ์ป้องกัน เช่น การตัดการเชื่อมต่อของสายส่งหรือเครื่องกำเนิดไฟฟ้า เพื่อปกป้องอุปกรณ์จากความเสียหาย

ผลกระทบจากพีคโหลดที่สูงและการเบี่ยงเบนความถี่มีทั้งด้านเศรษฐกิจและความเสี่ยงเชิงปฏิบัติการ ดังนี้

- ผลกระทบเชิงเศรษฐศาสตร์: การเพิ่มพีคโหลดนำไปสู่ต้นทุนระบบสูงขึ้น เนื่องจากต้องลงทุนในโรงไฟฟ้าแบบพีค (peaking plants) ระบบสำรอง และโครงข่ายสายส่งเพิ่มเติม นอกจากนี้ ผู้ประกอบการอาจต้องใช้เชื้อเพลิงราคาสูงในช่วงพีค ส่งผลให้ค่าไฟฟ้าหรือค่าโครงข่ายเพิ่มขึ้น

- ความเสี่ยงเชิงปฏิบัติการ: พีคสูงเกินขีดจำกัดอาจทำให้เกิดไฟฟ้าดับเป็นวงกว้าง (blackout) หรือการลดคุณภาพไฟฟ้า เช่น แรงดันตก (voltage sag) และความถี่เบี้ยว ซึ่งอาจทำให้อุปกรณ์อุตสาหกรรมและอุปกรณ์อิเล็กทรอนิกส์เสียหาย

- ความเสี่ยงจากความถี่: ความถี่ที่เบี่ยงเบนมากกว่าเกณฑ์ที่ยอมรับได้ (ตัวอย่างเช่นการเปลี่ยนแปลงระดับ 0.1–0.5 Hz ขึ้นกับการตั้งค่าระบบและมาตรการป้องกัน) อาจกระตุ้นการตัดเชื่อมต่ออุปกรณ์ป้องกัน ทำให้ระบบเครือข่ายสูญเสียกำลังผลิตหรือโหลดอย่างฉับพลัน และเสี่ยงต่อการลุกลามเป็นเหตุการณ์ล้มเหลวใหญ่

เทรนด์ปัจจุบันที่เร่งให้ปัญหาเหล่านี้ชัดเจนขึ้นคือการขยายตัวของรถยนต์ไฟฟ้า (EV) และการติดตั้งแบตเตอรี่แบบกระจาย (distributed batteries) ในระดับครัวเรือนและอาคารพาณิชย์ ตัวอย่างเชิงตัวเลขเพื่อให้เห็นภาพ: หากมีการชาร์จรถ EV แบบ AC ขนาดเฉลี่ย 7 kW จำนวน 1,000 คันพร้อมกัน จะเพิ่มโหลดประมาณ 7 MW ให้กับระบบท้องถิ่น ในขณะที่ชุดแบตเตอรี่บ้านที่ติดตั้งแบบกระจายสามารถเป็นทั้งภาระ (เมื่อชาร์จพร้อมกัน) และแหล่งกำลัง (เมื่อถ่ายจ่ายออก) หากไม่มีการประสานงานที่ดี การชาร์จพร้อมกันในช่วงเย็นของวันทำให้เกิดพีคใหม่ เพิ่มแรงกดดันต่อโครงข่ายและยากต่อการรักษาความถี่ให้อยู่ในช่วงปลอดภัย

ด้วยเหตุนี้ ภาคพลังงานและภาคธุรกิจต้องให้ความสำคัญกับมาตรการจัดการพีคและการรักษาความถี่ ทั้งในเชิงเทคนิคและนโยบาย เช่น การส่งเสริมการชาร์จอัจฉริยะ (smart charging), การจัดการความต้องการ (demand response), และการประสานงานกับแหล่งกำลังแบบกระจาย แนวทางเหล่านี้ช่วยลดต้นทุนจากการลงทุนในทรัพยากรพีค เพิ่มความยืดหยุ่นของระบบ และลดความเสี่ยงต่อการเกิดเหตุการณ์ล้มเหลว ทั้งหมดนี้เป็นเหตุผลที่ทำให้โครงการนำร่องที่ใช้เทคนิคเช่น Reinforcement Learning ในการจัดสรรการชาร์จมีความสำคัญต่อการวางแผนเชิงธุรกิจและการบริหารความเสี่ยงของระบบไฟฟ้าในประเทศไทย

เทคโนโลยีเบื้องต้น: Reinforcement Learning สำหรับการจัดสรรการชาร์จ

เทคโนโลยีเบื้องต้น: Reinforcement Learning สำหรับการจัดสรรการชาร์จ

ในโครงการนำร่องนี้ เราใช้กรอบงาน Reinforcement Learning (RL) เพื่อให้ระบบจัดสรรกำลังชาร์จ/จ่ายของรถไฟฟ้า (EV) และแบตเตอรี่บ้านแบบกระจาย สามารถเรียนรู้และปรับตัวแบบเรียลไทม์เพื่อลดพีคโหลดและรักษาความถี่ของกริด ตัวระบบมองปัญหาเป็นปฏิสัมพันธ์ระหว่าง agent กับสภาพแวดล้อม โดยมีองค์ประกอบหลักดังนี้:

- State (สถานะ): ประกอบด้วยข้อมูลหลากหลายชั้น เช่น โหลดท้องถิ่นและรวม (local & aggregate load), ความถี่กริด (grid frequency), สถานะชาร์จ (State of Charge: SoC) ของแบตเตอรี่แต่ละหน่วย, คำสั่ง/ความต้องการผู้ใช้ (เวลาที่ต้องการรถพร้อมใช้งาน, ขีดจำกัดต้นทุน), สัญญาณราคาหรือสัญญาณแรงจูงใจ (price/DR signals) และสถานะการสื่อสาร/ล่าช้า (latency/comm status).

- Action (การกระทำ): การกำหนดกำลังชาร์จหรือจ่ายของแต่ละเครื่อง (เช่น ปรับเป็น 0–x kW หรือสั่ง V2G ในช่วงเวลาหนึ่ง) และการเลือกโหมดการควบคุม (charge, hold, discharge) ที่อาจเป็นค่าต่อเนื่องหรือค่าจำกัดเป็นช่วง (discrete/continuous).

- Reward (รางวัล): ถูกออกแบบให้สะท้อนเป้าหมายเชิงระบบและประสบการณ์ผู้ใช้ โดยมีองค์ประกอบหลัก: ลดพีค (peak shaving), รักษาความถี่ให้อยู่ในช่วงที่ยอมรับได้ (frequency stability), และคำนึงถึงความพึงพอใจผู้ใช้ (เช่น ส่งรถพร้อมใช้งานเมื่อขอใช้งาน) รวมทั้งต้นทุนจากการชาร์จ/รอบการใช้งานแบตเตอรี่ เพื่อให้สมดุลระหว่างประสิทธิภาพกริดกับความพึงพอใจผู้ใช้

การออกแบบฟังก์ชันรางวัลเป็นหัวใจสำคัญของระบบ ตัวอย่างเชิงแนวคิดของรางวัลอาจเขียนเป็นรูปแบบผสม เช่น:

Reward = -α × PeakPenalty(t) - β × (Δf(t))^2 + γ × UserSatisfaction(t) - δ × DegradationCost

โดยที่ PeakPenalty ให้ค่าน้ำหนักมากเมื่อกำลังรวมเข้าใกล้ระดับพีคที่ไม่พึงประสงค์, Δf คือการเบี่ยงเบนความถี่จากค่า nominal (เช่น ในกรอบ ±0.1–0.2 Hz ตามข้อกำหนดของระบบ), และ UserSatisfaction ให้รางวัลเมื่อผู้ใช้ยังได้ระดับการให้บริการที่ต้องการ (เช่น SoC เป้าหมายภายในเวลาที่กำหนด) ส่วน DegradationCost ช่วยจำกัดการสลับชาร์จ-จ่ายที่อาจลดอายุแบตเตอรี่

สำหรับอัลกอริทึม RL ที่นำมาใช้ อาจพิจารณาตามลักษณะปัญหาและขอบเขตการใช้งาน:

- DQN (Deep Q-Network): เหมาะกับกรณีที่ action space เป็นจำนวนจำกัด (discrete) และต้องการความเรียบง่ายในการเริ่มต้น ใช้ได้ดีในสถานการณ์ที่การตัดสินใจเป็นชุดของทางเลือกชัดเจน

- PPO (Proximal Policy Optimization): เป็นอัลกอริทึม policy-gradient ที่มีความเสถียรและนำมาใช้บ่อยสำหรับ action space แบบต่อเนื่อง เหมาะกับการปรับกำลังชาร์จแบบละเอียดและทนต่อการเปลี่ยนแปลงของสภาพแวดล้อม

- Actor-Critic / A2C / SAC: กลุ่มโครงสร้างนี้ให้สมดุลระหว่างการประมาณค่านโยบายกับค่าประมาณตัวประเมิน (value) เหมาะสำหรับปัญหาขนาดใหญ่และ multi-agent โดยเฉพาะเมื่อต้องการเรียนรู้เชิงร่วม (cooperative)

เหตุผลในการเลือกใช้ RL แทนวิธีแบบเดิมมีหลายประการสำคัญ: RL สามารถปรับตัวแบบเรียลไทม์เมื่อพบรูปแบบโหลดหรือพฤติกรรมผู้ใช้ที่ไม่คาดคิด, เรียนรู้การตัดสินใจเชิงซ้อนและแบบมีลำดับ (sequential) ที่ยากต่อการนิยามเป็นกฎตายตัว, และรองรับสภาพแวดล้อมแบบกระจาย (distributed) ผ่านสถาปัตยกรรม multi-agent หรือแนวทาง Centralized training — Decentralized execution ที่ทำให้ระบบสามารถสเกลได้ดีเมื่อจำนวน EV/แบตเตอรี่เพิ่มขึ้น ตัวอย่างเช่น การใช้ multi-agent RL ในเมืองเล็กของโครงการนำร่องแสดงให้เห็นการลดพีค 20–30% เมื่อเทียบกับการควบคุมแบบ rule-based เดิม

อย่างไรก็ตาม มีข้อจำกัดที่ต้องพิจารณาอย่างจริงจังก่อนการปรับใช้เชิงพาณิชย์:

- ความปลอดภัยและการรับประกันเชิงข้อบังคับ: นโยบายที่เรียนรู้ต้องปฏิบัติตามข้อจำกัดของระบบ (constraints) เสมอ เช่น ไม่ทำให้ความถี่เกินขอบเขตหรือไม่ละเมิดข้อตกลงผู้ใช้ ซึ่งอาจต้องใช้เทคนิค safe RL หรือชั้นตรวจสอบ (safety shields) เพื่อรับประกัน

- การตีความผลลัพธ์และความโปร่งใส: นโยบายเชิงลึกมักยากต่อการอธิบาย การสร้างความเชื่อมั่นให้ผู้ปฏิบัติงานกริดและลูกค้าจำเป็นต้องมีเครื่องมืออธิบาย (explainability) หรือการทำ policy distillation เป็นกฎที่เข้าใจได้

- ความต้องการข้อมูลและโครงสร้างการฝึก: RL ต้องการข้อมูลจำลองหรือข้อมูลเชิงประวัติที่มีความถี่สูง (เช่น การวัดโหลด/ความถี่ทุกวินาทีหรือทุกนาที) และการเทรนเบื้องต้นมักต้องใช้สภาพแวดล้อมจำลอง (digital twin) เพื่อหลีกเลี่ยงความเสี่ยงต่อระบบจริง นอกจากนี้ยังต้องพิจารณาประเด็นการสื่อสาร ค่าแฝง และความเป็นส่วนตัวของข้อมูลผู้ใช้

สรุปคือ การนำ RL มาใช้ในการจัดสรรการชาร์จสำหรับระบบ EV และแบตเตอรี่บ้านแบบกระจายเสนอความสามารถปรับตัวและเพิ่มประสิทธิภาพเชิงระบบที่เหนือกว่า rule-based หรือ centralized optimization ในสถานการณ์ที่มีความไม่แน่นอนและพฤติกรรมผู้ใช้หลากหลาย แต่การนำไปใช้จริงจำเป็นต้องรวมแนวทางด้านความปลอดภัย การอธิบายนโยบาย และโครงสร้างข้อมูลที่แข็งแรงเพื่อให้ได้ผลลัพธ์ที่เชื่อถือได้และตอบโจทย์ทั้งกริดและผู้ใช้

การออกแบบโครงการนำร่อง: วิธีการทดลองและเมทริกซ์การวัดผล

การกำหนดขอบเขตการทดลอง (Scope of Pilot)

โครงการนำร่องควรกำหนดขนาดชุมชนและทรัพยากรไฟฟ้าอย่างชัดเจนเพื่อให้ผลลัพธ์มีความหมายต่อการขยายผล ตัวอย่างขอบเขตสำหรับเมืองเล็กหรือชุมชนขนาดกลาง ได้แก่ จำนวนครัวเรือน 300–1,000 ราย, ยานพาหนะไฟฟ้า (EV) 100–400 คัน, ความจุแบตเตอรี่บ้านรวม 0.5–2.0 MWh (เช่น แบตเตอรี่บ้านขนาดเฉลี่ย 5–10 kWh ต่อครัวเรือนที่มีการติดตั้ง), และ จำนวนสถานีชาร์จสาธารณะ/ชุมชน 20–60 จุด เพื่อรองรับการทดลองทั้งในพื้นที่อยู่อาศัยและจุดสาธารณะ การระบุรายละเอียดดังกล่าวช่วยให้วางแผนการติดตั้งอุปกรณ์สื่อสาร (AMI, IoT gateway), การวัดวิเคราะห์ และการบริหารความเสี่ยงได้ชัดเจน

ระยะเวลาการทดลองและเงื่อนไขเบสไลน์

ระยะเวลาที่แนะนำคือ 3–12 เดือน เพื่อเก็บข้อมูลพฤติกรรมการชาร์จในฤดูกาลต่าง ๆ และวันทำงาน/วันหยุดอย่างเพียงพอ โดยควรวางกรอบการทดลองเป็นชุดของช่วงเวลา: ช่วงเก็บข้อมูลก่อนการใช้งาน (baseline) 4–8 สัปดาห์, ช่วงปรับใช้อัลกอริทึม RL 4–12 สัปดาห์สำหรับการฝึกและปรับพารามิเตอร์, และ ช่วงประเมินผลเต็มรูปแบบ อย่างน้อย 8–24 สัปดาห์เพื่อวัดผลเชิงสถิติ

สำหรับเบสไลน์ควรใช้สองรูปแบบเพื่อการเปรียบเทียบที่ชัดเจน: (1) Demand without RL — การใช้งานปกติไม่มีการจัดการโหลด และ (2) Traditional demand response — ระบบจัดการโหลดแบบเดิม (เช่น signal-based DR หรือ time-of-use pricing) ซึ่งทั้งสองเบสไลน์ต้องถูกบันทึกภายใต้เงื่อนไขการใช้งานเดียวกัน (สภาพอากาศ ปฏิทินกิจกรรม) เพื่อให้การเปรียบเทียบมีความยุติธรรม

การสื่อสารและการวัดข้อมูล (AMI, IoT และความถี่การเก็บข้อมูล)

- เทคโนโลยีสื่อสาร: ใช้ Advanced Metering Infrastructure (AMI) สำหรับการวัดพลังงานรายครัวเรือนและแจ้งสถานะเบื้องต้น พร้อมด้วย IoT gateway ในสถานีชาร์จและชุดแบตเตอรี่บ้านเพื่อส่งข้อมูลสถานะการชาร์จ/คายประจุ

- ความถี่การเก็บข้อมูล: สำหรับการจัดตารางการชาร์จแบบ RL แนะนำการส่ง setpoint ทุก 5–15 นาที (สำหรับการจัดการพีคและการ shift พลังงาน) และเก็บสัญญาณความถี่กริดทุก 1–10 วินาทีเมื่อประเมินการควบคุมความถี่ (frequency support) ร่วมกับการบันทึกพลังงานรายนาที/ราย 5 นาทีสำหรับการวิเคราะห์โหลด

- Latency และ Reliability: ระบบควรรองรับ latency เฉลี่ยไม่เกิน 1–5 วินาทีสำหรับการสังเกตการณ์ความถี่และไม่เกิน 30 วินาที–2 นาทีสำหรับคำสั่งจัดตารางการชาร์จแบบ RL เพื่อให้การปรับเปลี่ยนการชาร์จตอบสนองต่อภาวะพีคได้อย่างมีประสิทธิภาพ

เมทริกซ์การวัดผลสำคัญ (Evaluation Metrics)

เพื่อวัดประสิทธิภาพของระบบ RL ควรกำหนดเมทริกซ์หลักที่ครอบคลุมมิติทั้งเชิงพลังงาน เศรษฐศาสตร์ และประสบการณ์ผู้ใช้ ดังนี้

- เปอร์เซ็นต์ลดพีค (Peak Reduction %): เปรียบเทียบค่าพีคโหลดของช่วงเวลาพีคก่อนและหลังใช้ RL และกับเบสไลน์ ตัวอย่างเป้าหมายคือ ลดพีค 20–30% ในบริบทของเมืองเล็กตามผลการทดลองแรกเริ่ม

- AUC ของโหลด (Area Under Load Curve): คำนวณพื้นที่ใต้กราฟโหลดในช่วงเวลาวัน/สัปดาห์ เพื่อวัดการกระจายโหลดและปริมาณพลังงานที่ถูกย้ายจากพีคไปยัง off-peak (หน่วยเป็น kWh·h หรือ normalized AUC) — การลดค่าพีคที่มาพร้อมกับการลด AUC ในช่วงพีคแสดงให้เห็นการบรรเทาความเครียดต่อกริด

- ความผันผวนความถี่ (Frequency Deviation): วัดค่าเฉลี่ยและค่าเบี่ยงเบนมาตรฐานของความถี่กริด (Hz) ในช่วงการทดลอง และเก็บค่า metrics เช่น RMS deviation และ 95th percentile deviation เพื่อประเมินการสนับสนุนความถี่ที่ระบบจัดหาผ่านการคาย/ชาร์จแบตเตอรี่

- การลดค่าใช้จ่าย (Cost Savings): ประเมินเป็นทั้งค่าใช้จ่ายของผู้ใช้ (ค่าไฟฟ้าเฉลี่ยต่อครัวเรือน) และค่าใช้จ่ายของระบบ (ลดความจำเป็นในการสั่งจองกำลังการผลิตพีค, ลดค่าโครงข่าย) โดยคำนวณเป็น THB/kWh ที่ประหยัดได้ และการลดความต้องการความสามารถสำรอง (capacity deferral in MW)

- การตอบสนองและพฤติกรรมผู้ใช้: ตัวชี้วัดรวมถึงอัตราการสมัครเข้าร่วม (opt-in rate), อัตราการยกเลิก/override คำสั่งของระบบ, เวลาตอบสนองจากผู้ใช้ (satisfaction survey scores) และตัวชี้วัด UX เช่น Net Promoter Score (NPS) หรือคะแนนความพึงพอใจเฉลี่ย ซึ่งเป็นตัวชี้วัดสำคัญในการประเมินการยอมรับเชิงสังคม

ตัวอย่างเชิงตัวเลขและการวิเคราะห์เชิงสถิติ

ตัวอย่างการตั้งค่าทดลองเชิงปฏิบัติ: 500 ครัวเรือน, 150 EV, ความจุแบตเตอรี่บ้านรวม 1.0 MWh, และ 30 สถานีชาร์จ โดยดำเนินการทดลอง 6 เดือน (รวม baseline 6 สัปดาห์) ผลที่คาดหวังเชิงตัวเลขอาจเป็นการลดพีคเฉลี่ย 22–28% เทียบกับสถานะไม่มีการจัดการ และลด 10–15% เมื่อเทียบกับ demand response แบบดั้งเดิม สำหรับการวิเคราะห์ใช้การทดสอบทางสถิติ (เช่น paired t-test หรือ Wilcoxon signed-rank test) เพื่อยืนยันความแตกต่างที่มีนัยสำคัญ และใช้การวิเคราะห์รูปแบบเวลา (time-series decomposition) เพื่อตรวจสอบผลกระทบตามฤดูกาล/วันในสัปดาห์

ข้อพึงระวังและตัวชี้นำเชิงนโยบาย

ในระหว่างการออกแบบต้องคำนึงถึงประเด็นความปลอดภัยไซเบอร์ การปกป้องข้อมูลส่วนบุคคล และข้อจำกัดด้านกฎระเบียบ เช่น ข้อกำหนดการควบคุมความถี่ของผู้ให้บริการระบบไฟฟ้า นอกจากนี้ควรกำหนดเกณฑ์การยกเลิกและการคืนสภาพบริการฉุกเฉิน และมีแผนบูรณาการกับหน่วยงานภาคการไฟฟ้า (TSO/DSO) เพื่อให้สัญญาณความถี่และสัญญาณตลาดสามารถใช้งานร่วมกันได้อย่างปลอดภัย

สรุปแนวทางการประเมิน

การออกแบบโครงการนำร่องที่มีกรอบชัดเจน — ขนาดชุมชนที่เหมาะสม, ระยะเวลาทดลองที่เพียงพอ, เบสไลน์เปรียบเทียบสองแบบ, ระบบสื่อสาร AMI/IoT ที่รองรับความถี่การเก็บข้อมูลที่เหมาะสม — จะช่วยให้สามารถวัด เปอร์เซ็นต์ลดพีค, AUC ของโหลด, ความผันผวนของความถี่, และ การลดค่าใช้จ่าย ได้อย่างครบถ้วน พร้อมทั้งประเมินความพึงพอใจของผู้ใช้ เพื่อใช้ข้อมูลเชิงประจักษ์ในการขยายผลสู่เมืองใหญ่และการออกแบบนโยบายสนับสนุนต่อไป

ผลลัพธ์เชิงตัวเลข: การลดพีคและความเสถียรของความถี่

ผลลัพธ์เชิงตัวเลข: การลดพีคและความเสถียรของความถี่

การวิเคราะห์เชิงปริมาณจากโครงการนำร่องในเมืองขนาดเล็กชี้ให้เห็นผลลัพธ์ที่ชัดเจนในแง่การลดพีคโหลดและการปรับปรุงความเสถียรความถี่ของกริด โดยสรุปตัวเลขหลักที่ได้คือ พีคโหลดลดลงระหว่าง 20–30% เมื่อเทียบกับช่วงก่อนการใช้ระบบ Reinforcement Learning (RL) ในการจัดสรรการชาร์จของรถไฟฟ้า (EV) และแบตเตอรี่ในบ้าน (home batteries) ตัวอย่างเช่น หากกริดตัวอย่างมีพีคเดิมที่ 3.0 MW การลด 20–30% จะหมายถึงการลดพีคเชิงทันทีระหว่าง 0.6–0.9 MW ซึ่งส่งผลโดยตรงต่อต้นทุนพลังงานเชิงพีคและความต้องการกำลังผลิตสำรอง

จากกราฟ time-series เปรียบเทียบก่อน–หลัง (ตัวอย่างในภาพ) จะเห็นรูปแบบที่สอดคล้องกันดังนี้: พฤติกรรมโหลดรายชั่วโมงมีการ “ปาด” ยอดสูงสุดในช่วงเย็น เช่น เวลาประมาณ 18:00–20:00 ถูกลดลงอย่างชัดเจนด้วยการเลื่อนการชาร์จ EV และการดึงพลังงานจากแบตเตอรี่บ้านในช่วงพีค ผลลัพธ์เชิงสถิติบางจุดที่สังเกตได้คือ peak magnitude ลดลงเฉลี่ย 25% (ค่ากลางของช่วง 20–30%), ความแปรปรวน (variance) ของโหลดรายนาทีลดลงประมาณ 18–28% และ RMS ของการเปลี่ยนแปลงโหลดชั่วโมงต่อชั่วโมงลดลงตามลำดับ ซึ่งสะท้อนว่าโครงข่ายมีการทำงานเรียบขึ้นและความผันผวนในระดับสั้นลดลง

ในด้านตัวชี้วัดความถี่ ผลการทดลองบันทึกการปรับปรุงต่อไปนี้: ค่าเบี่ยงเบนมาตรฐานของความถี่ลดลงจากประมาณ 0.06 Hz (ก่อนใช้ RL) เหลือประมาณ 0.02–0.03 Hz (หลังใช้ RL) ในระบบตัวอย่างที่มีความถี่ฐาน 50 Hz นอกจากนี้ เวลาเฉลี่ยในการกลับสู่ค่าปกติ (return-to-nominal) หลังเกิดการรบกวนลดลงจากเฉลี่ยราว 90–120 วินาที เหลือประมาณ 25–45 วินาที ซึ่งบ่งชี้ว่าการตอบสนองแบบเรียลไทม์ของหน่วยจัดเก็บพลังงานและการปรับการชาร์จ EV โดย RL ช่วยลดอาการสั่น (oscillation) และทำให้ระบบกลับสู่ความเสถียรได้เร็วขึ้น จำนวนเหตุการณ์ที่ความถี่หลุดออกนอก deadband ที่ตั้งค่าไว้ลดลงประมาณ 60–80%

การประเมินเชิงเศรษฐศาสตร์จากข้อมูลนำร่องสามารถนำเสนอในรูปแบบตัวอย่างคำนวณภายใต้สมมติฐานที่ชัดเจนดังนี้ (เพื่อให้ผู้อ่านเห็นขนาดของผลประหยัด):

- สมมติฐานพื้นฐาน: พีคเดิม P0 = 3.0 MW; พีคลด ΔP = 25% → 0.75 MW (750 kW).

- การประหยัดค่าใช้จ่ายพีค (demand charge): หากอัตราค่าใช้จ่ายพีคอยู่ในช่วงสมมติ 100–600 THB/kW/เดือน, ผลลัพธ์จะเป็น

- กรณีอนุรักษ์นิยม (100 THB/kW/เดือน): ประหยัดต่อปี = 750 kW × 100 THB × 12 = 900,000 THB/ปี

- กรณีเป็นไปได้สูง (600 THB/kW/เดือน): ประหยัดต่อปี = 750 kW × 600 THB × 12 = 5,400,000 THB/ปี

- การลดต้นทุนพลังงานช่วงพีค (energy shifting): หากการลดพีคเฉลี่ยมีผลลดการใช้พลังงานในช่วงพีคประมาณ 750 kW เป็นเวลาเฉลี่ย 2 ชั่วโมงต่อวัน → พลังงานที่เลื่อนได้ ≈ 1,500 kWh/วัน ≈ 547,500 kWh/ปี

- หากราคาพลังงานเฉลี่ย 3–5 THB/kWh → ประหยัดพลังงานต่อปีประมาณ 1.64–2.74 ล้านบาท

- รายได้จากบริการความถี่ (ancillary services): หน่วยจัดเก็บพลังงานและ EV ที่ตอบสนองสัญญาณความถี่สามารถให้บริการความถี่แบบอัตโนมัติ (fast frequency response) และรับค่าตอบแทนในตลาด Ancillary โดยสมมติว่ามีรายได้เสริม 50–300 THB/kW/ปี ขนาด 750 kW อาจให้รายได้เสริมเพิ่มเติมได้ในระดับ 37,500–225,000 THB/ปี (ตัวเลขนี้ขึ้นกับโครงสร้างตลาดในแต่ละพื้นที่)

รวมทั้งหมดแล้ว ในสภาวะสมมติแบบกลาง (25% พีคลด, demand charge ปานกลาง 300 THB/kW/เดือน และราคาพลังงาน 4 THB/kWh) โครงการนำร่องสามารถชี้ให้เห็นการประหยัดรวมระดับประมาณ 3–4 ล้านบาทต่อปี สำหรับพื้นที่ขนาดเล็กที่มีพีคเดิมราว 3 MW ทั้งนี้ตัวเลขจริงจะแปรผันตามขนาดเมือง อัตราค่าไฟและโครงสร้างค่าบริการของแต่ละยูทิลิตี้

ปัจจัยที่ทำให้ RL ประสบความสำเร็จเชิงตัวเลขได้แก่:

- การประสานงานระหว่าง EV และแบตเตอรี่บ้าน — RL เรียนรู้พฤติกรรมการชาร์จและความต้องการพลังงานของผู้ใช้ เพื่อกระจายภาระการชาร์จออกจากช่วงพีคอย่างมีประสิทธิภาพ

- การตอบสนองต่อสัญญาณความถี่แบบเรียลไทม์ — อัลกอริทึมสามารถสั่งชะลอ/เพิ่มการจ่ายพลังงานภายในวินาทีถึงนาที ช่วยลดการเบี่ยงเบนความถี่อย่างรวดเร็ว

- คงความสะดวกสบายของผู้ใช้ — นโยบายรางวัลและข้อจำกัดของ RL ถูกออกแบบเพื่อไม่ส่งผลกระทบต่อประสบการณ์การชาร์จหรือการใช้พลังงานในบ้าน โดยมุ่งให้การปรับเปลี่ยนเป็นไปแบบโปรเกรสซีฟและไม่รบกวนความต้องการพื้นฐาน

สรุปคือ ผลลัพธ์เชิงตัวเลขจากโครงการนำร่องชี้ให้เห็นว่าเทคโนโลยี RL ในการจัดการการชาร์จแบบกระจายสามารถลดพีคได้อย่างมีนัยสำคัญ (20–30%), ปรับปรุงความเสถียรความถี่ของกริด และสร้างมูลค่าทางเศรษฐศาสตร์ทั้งจากการลดค่าใช้จ่ายพีคและโอกาสในการเข้าร่วมตลาดบริการความถี่ โดยผลลัพธ์เชิงเศรษฐศาสตร์ที่แท้จริงจะขึ้นกับขนาดระบบ ค่าบริการของผู้ให้บริการไฟฟ้า และโครงสร้างตลาดของ Ancillary services ในแต่ละภูมิภาค

อุปสรรค ข้อจำกัด และแนวทางการสเกลขึ้น

อุปสรรค ข้อจำกัด และแนวทางการสเกลขึ้น

ข้อจำกัดด้านเทคนิค — การสเกลโครงการ Reinforcement Learning (RL) เพื่อจัดสรรการชาร์จ EV และแบตเตอรี่บ้านไปสู่เมืองใหญ่เผชิญกับข้อจำกัดด้านความหน่วง (latency), การสื่อสาร และความน่าเชื่อถือของข้อมูลอย่างชัดเจน จากการปฏิบัติจริงในเมืองเล็ก พบว่าการปรับพฤติกรรมชาร์จเพื่อรักษาความถี่ต้องการการตอบสนองในระดับ วินาทีถึงไม่กี่สิบวินาที สำหรับบางกรณีการตอบสนองเร็ว (fast frequency response) อาจต้องการเวลาตอบสนองในระดับร้อยมิลลิวินาที ถึงไม่กี่วินาที หากระบบสื่อสารมี latency สูงหรือ packet loss เกิน 100–200 ms จะส่งผลให้ประสิทธิภาพลดลงและความเสถียรของการควบคุมต่ำกว่าเกณฑ์ที่ยอมรับได้ นอกจากนี้ ความน่าเชื่อถือของข้อมูล (data integrity) — เช่น ค่าความจุแบตเตอรีที่อัพเดตไม่ทัน หรือข้อมูลสถานะการชาร์จที่ผิดพลาด — จะทำให้ตัวแบบ RL ตัดสินใจผิดพลาดได้ง่าย

ปัญหาด้านความเป็นส่วนตัวและความมั่นคงปลอดภัย — การรวบรวมและส่งข้อมูลจาก EV และระบบแบตเตอรี่ภายในบ้านสร้างความเสี่ยงทั้งด้าน privacy และ cybersecurity อุปกรณ์ปลายทางจำนวนมากเป็นจุดเสี่ยงต่อการโจมตี (attack surface สูง) หากไม่มีมาตรฐานการยืนยันตัวตน การเข้ารหัส และการอัปเดตซอฟต์แวร์ที่เข้มงวด อาจเกิดการแทรกแซงที่มีผลต่อการรักษาความถี่ของกริดได้ ทางด้านความเป็นส่วนตัว ข้อมูลการชาร์จสามารถสะท้อนรูปแบบการอยู่อาศัยหรือการเคลื่อนไหวของบุคคล จึงจำเป็นต้องมีกระบวนการยินยอม การลดทอนข้อมูล (data minimization) และการทำให้เป็นนิรนามก่อนนำไปใช้เพื่อวิเคราะห์หรือการชำระเงิน

ความท้าทายในเชิงสังคมและธุรกิจ — การยอมรับของผู้ใช้เป็นปัจจัยสำคัญ ผู้ครอบครอง EV/แบตเตอรี่อาจกังวลว่าจะสูญเสียความสะดวกสบายหรือไม่สามารถใช้งานได้เมื่อจำเป็น ดังนั้นโมเดลการจูงใจต้องชัดเจนและเป็นธรรม ตัวอย่างโมเดลที่นิยมนำเสนอได้แก่ การแบ่งรายได้ (revenue sharing) ระหว่าง aggregator กับเจ้าของอุปกรณ์, ค่าตอบแทนตามผลงาน (pay-for-performance), หรือค่าบริการลดพิเศษสำหรับผู้เข้าร่วมในโปรแกรม ในระดับสัญญาทางธุรกิจ จำเป็นต้องกำหนด SLA, ข้อตกลงความรับผิดชอบ (liability clauses), และกลไกการตรวจวัด/พิสูจน์ (metering & verification) ที่สามารถตรวจสอบได้ เพื่อให้ผู้ให้บริการระบบไฟฟ้า (DSO/TSO) ยอมรับการมีส่วนร่วมของทรัพยากรกระจายได้

อุปสรรคทางนโยบายและกฎระเบียบ — ตลาดบริการความถี่และโครงสร้างค่าการค้าไฟฟ้าส่วนใหญ่ยังออกแบบมาเพื่อหน่วยกำลังขนาดใหญ่ การที่ระบบกระจายต้องการได้รับค่าตอบแทนจากการรักษาความถี่ จึงจำเป็นต้องปรับกฎการค้าพลังงานและรหัสกริด เช่น การอนุญาตให้ทรัพยากรกระจาย (DERs) เข้าร่วมในตลาด ancillary services, การกำหนดหน่วยการวัดที่เหมาะสม, และการสร้างกลไกชำระเงินที่รองรับการตอบสนองระดับวินาทีถึงนาที หากไม่มีการเปลี่ยนแปลงเชิงนโยบาย โอกาสทางเศรษฐกิจสำหรับเจ้าของอุปกรณ์และ aggregator จะถูกจำกัด

- ข้อเสนอแนวทางทางเทคนิคเพื่อสเกล

- ออกแบบสถาปัตยกรรมแบบชั้น (hierarchical control) — edge control สำหรับการตอบสนองฉับพลัน, aggregator ชั้นกลางสำหรับการจัดสรรเชิงกลยุทธ์ และ cloud สำหรับการฝึก RL ระยะยาว

- ใช้มาตรฐานการสื่อสารเปิดและเป็นที่ยอมรับ เช่น OCPP สำหรับ EV charging, OpenADR สำหรับ demand response, MQTT/AMQP พร้อม TLS สำหรับข้อความแบบเบา และการซิงโครไนซ์เวลา (NTP/PTP) เพื่อให้การประเมินผลและการวัดมีความสอดคล้อง

- เพิ่มความทนทานของการสื่อสารโดยใช้ช่องทางสำรอง (multi-path routing), QoS และ SLA กับผู้ให้บริการเครือข่าย — พิจารณาใช้เครือข่าย 5G/EDGE สำหรับการตอบสนองที่ต้อง latency ต่ำ

- ปรับใช้มาตรการความมั่นคงปลอดภัยขั้นสูง เช่น mutual TLS, device attestation, secure boot, การจัดการคีย์และการอัปเดตซอฟต์แวร์แบบปลอดภัย รวมถึงการทดสอบ penetration testing เป็นประจำ

- พัฒนากลไก data governance — การทำให้เป็นนิรนาม การจัดการการยินยอม และนโยบายการเก็บรักษาข้อมูล เพื่อสร้างความเชื่อมั่นให้กับผู้ใช้

- ข้อเสนอแนวทางเชิงธุรกิจและการตลาด

- ออกแบบโมเดลรายได้ที่ชัดเจน เช่น ค่าตอบแทนตามผลงาน, ค่าธรรมเนียมการเป็นสมาชิก หรือการแบ่งรายได้กับ utility/aggregator — โดยใช้การวัดผลเชิงประสิทธิภาพเป็นฐาน

- สัญญาแบบ performance-based contract เพื่อจัดการความเสี่ยงและสร้างแรงจูงใจให้ผู้เข้าร่วมรักษาความพร้อมของอุปกรณ์

- โปรแกรมการมีส่วนร่วมของผู้ใช้: ให้สิทธิประโยชน์เช่น เครดิตค่าไฟ, ส่วนลดค่าอุปกรณ์ หรือการรับประกันการชาร์จในเวลาจำเป็น เพื่อเพิ่มอัตราการยอมรับ

- แนวทางนโยบายเพื่อสเกล

- จัดตั้ง regulatory sandbox โดยหน่วยงานรัฐร่วมกับผู้ให้บริการไฟฟ้า เพื่อทดสอบกลไกการชำระเงินและกฎการเข้าแข่งขันของ DERs โดยมีระยะเวลาและขอบเขตที่ชัดเจน — ตัวอย่างมาตรการคือการให้สิทธิชั่วคราวในการเสนอขาย ancillary services ในพื้นที่ทดลอง

- ปรับปรุงกฎตลาดให้รองรับการแบ่งกลุ่ม (aggregation) ของทรัพยากรย่อย และกำหนดมาตรฐาน M&V (measurement & verification) ระดับภูมิภาคเพื่อสนับสนุนการชำระเงินแบบเรียลไทม์

- ส่งเสริมการทดลองในระดับภูมิภาคและเมืองใหญ่เป็นลำดับขั้น — เริ่มจากโซนที่มีความหนาแน่นของ EV/ระบบแบตสูงและมีการสนับสนุนจาก DSO เพื่อทดสอบความสามารถในการจัดการความซับซ้อนของเครือข่ายจริง

- กำหนดมาตรฐานการรับรองความปลอดภัยและการทำงานร่วมกัน (interoperability certification) สำหรับอุปกรณ์และแพลตฟอร์ม เพื่อให้เกิดตลาดที่แข่งขันได้และลดความเสี่ยงของ vendor lock-in

สรุปได้ว่า การสเกลจากเมืองเล็ก (ที่ลดพีคได้ 20–30%) ไปสู่เมืองใหญ่ต้องอาศัยการแก้ปัญหาเชิงเทคนิคที่เป็นระบบ การออกแบบโมเดลธุรกิจที่ชัดเจน และการเปลี่ยนแปลงเชิงนโยบายที่สนับสนุนการมีส่วนร่วมของทรัพยากรกระจาย แนวปฏิบัติที่แนะนำคือเริ่มด้วยการทดสอบระดับภูมิภาคภายใต้ sandbox ทางนโยบาย พร้อมนำมาตรฐานการสื่อสารและความมั่นคงปลอดภัยมาใช้เป็นบรรทัดฐาน เพื่อสร้างความเชื่อมั่นให้ทั้งผู้ใช้งาน ผู้ให้บริการ และหน่วยงานกำกับดูแลก่อนการขยายผลในวงกว้าง

บทสรุปและข้อเสนอแนะเชิงนโยบาย/เชิงปฏิบัติการ

บทสรุปและข้อเสนอแนะเชิงนโยบาย/เชิงปฏิบัติการ

โครงการนำร่องในไทยที่ใช้ระบบ Reinforcement Learning (RL) สำหรับการจัดสรรการชาร์จรถไฟฟ้า (EV) และแบตเตอรี่บ้านแบบกระจายได้แสดงผลเชิงบวกที่ชัดเจนจากการทดลองในเมืองเล็ก โดยสามารถลดพีคโหลดของกริดได้ในช่วง 20–30% พร้อมทั้งช่วยรักษาความถี่ของระบบไฟฟ้าให้อยู่ในช่วงที่ปลอดภัย ลดการแกว่งความถี่และความเสี่ยงต่อการขัดข้องในระดับท้องถิ่น ผลลัพธ์เหล่านี้ชี้ให้เห็นว่าแนวทางการควบคุมแบบอัจฉริยะซึ่งผสานการตัดสินใจแบบอัตโนมัติและการทำงานร่วมกับทรัพยากรพลังงานแฝง (DERs) มีศักยภาพในการเสริมความยืดหยุ่นของกริดและลดความต้องการลงทุนด้านพีคพาวเวอร์ในระยะสั้นถึงปานกลาง

จากผลการทดลอง รายงานนี้เสนอชุดข้อเสนอแนะเชิงปฏิบัติการสำหรับผู้กำหนดนโยบาย ผู้ประกอบการสาธารณูปโภค และผู้พัฒนาเทคโนโลยี ดังนี้: การจัดตั้ง regulatory sandbox เพื่อให้มีกรอบทดสอบเชิงกฎข้อบังคับที่ยืดหยุ่น สามารถทดลองกลไกชาร์จแบบไดนามิก การชดเชยผู้ใช้ และโมเดลการรวมแบตเตอรี่โดยไม่ทำให้เกิดความเสี่ยงต่อความมั่นคงของระบบ กรอบนี้ควรกำหนด KPI ที่ชัดเจน เช่น เป้าหมายการลดพีค (%), ค่าความถี่เฉลี่ยและค่าความถี่เบี่ยงเบน, ผลประโยชน์ต่อผู้ใช้ และมาตรการคุ้มครองผู้บริโภค

- มาตรการจูงใจ — แนะนำการออกแบบโครงสร้างจ่ายเงินและแรงจูงใจที่ชัดเจน เช่น การให้ค่าตอบแทนตามผลการลดพีค (pay-for-performance), เครดิตค่าไฟสำหรับผู้เข้าร่วม, ภาษีหรือเงินอุดหนุนสำหรับการติดตั้งระบบแบตเตอรี่และอุปกรณ์สื่อสารที่เป็นมาตรฐาน

- มาตรฐานการสื่อสารและความสามารถในการทำงานร่วมกัน — ส่งเสริมมาตรฐานเปิด (เช่น OpenADR, IEEE 2030.5, OCPP ในบริบทที่เกี่ยวข้อง) เพื่อให้ระบบของผู้ผลิตหลายรายสามารถประสานงานได้ ลดค่าใช้จ่ายการบูรณาการ และเพิ่มความยืดหยุ่นในการเลือกผู้ให้บริการ

- ความปลอดภัยข้อมูลและไซเบอร์ — กำหนดข้อกำหนดขั้นต่ำด้านการรักษาความลับ ความสมบูรณ์ และความพร้อมใช้งานของข้อมูล (data privacy & cybersecurity) รวมถึงการเข้ารหัส การพิสูจน์ตัวตน และนโยบายการเข้าถึงข้อมูลที่โปร่งใสเพื่อสร้างความเชื่อมั่นให้ผู้ใช้งาน

- การควบคุมความเป็นธรรม (fairness) — ออกแนวทางเพื่อป้องกันการจัดสรรพลังงานที่ไม่เป็นธรรม เช่น การกำกับดูแลไม่ให้กลไกชาร์จทำให้บางกลุ่มผู้ใช้เสียเปรียบทางค่าใช้จ่าย หรือคุณภาพการให้บริการ

เชิงปฏิบัติการสำหรับการปฏิบัติจริง ผู้ให้บริการสาธารณูปโภคควรเริ่มด้วยชุดทดลองภายใน (pilot-to-scale) ที่มีการคัดเลือกพื้นที่ตัวอย่างอย่างหลากหลายทั้งเชิงภูมิศาสตร์และเชิงประชากร เพื่อวัดผลภายใต้สภาพการใช้งานที่ต่างกัน พร้อมทั้งจัดทำแผนการตรวจสอบแบบเรียลไทม์และกลไกการตอบสนองฉุกเฉินหากการจัดการอัตโนมัติส่งผลกระทบต่อเสถียรภาพกริด นอกจากนี้ ควรพิจารณารูปแบบธุรกิจใหม่ เช่น aggregator model ที่รวมความจุแบตเตอรี่ย่อยเพื่อขายบริการรักษาความถี่และพลังงานสำรองให้กับตลาดไฟฟ้า

แนวทางวิจัยและพัฒนาต่อไป

- ขยายสเกลการทดลอง — พัฒนาการทดลองจากเมืองเล็กสู่เมืองขนาดกลางและใหญ่ เพื่อประเมินประสิทธิภาพในเงื่อนไขโหลดที่ซับซ้อนมากขึ้น และศึกษาผลกระทบต่อโครงสร้างพื้นฐานจำพวกทรานส์ฟอร์เมอร์และระบบจัดการโหลด

- การผสาน V2G และการทำงานแบบ multi-agent — วิจัยการรวม Vehicle-to-Grid (V2G) เพื่อใช้รถยนต์เป็นแหล่งพลังงานสำรอง รวมถึงพัฒนาอัลกอริทึม multi-agent RL ที่สามารถประสานการตัดสินใจของอุปกรณ์หลายประเภทอย่างมีเสถียรภาพและประหยัดพลังงาน

- การประเมินผลทางเศรษฐศาสตร์ระยะยาว — วิเคราะห์ต้นทุน-ประโยชน์ในมุมมองระบบ (system-level) และมุมมองสังคม (social welfare) ครอบคลุมค่าใช้จ่ายด้านโครงสร้างพื้นฐาน การบำรุงรักษา ลดการลงทุนพลังงานพีค และการลดการปล่อยก๊าซเรือนกระจก

- ความปลอดภัยและความเป็นส่วนตัว — เสริมการวิจัยด้านการป้องกันการโจมตีไซเบอร์ การออกแบบนโยบายการเข้าถึงข้อมูลที่สมดุลระหว่างการวิเคราะห์ระบบและการคุ้มครองข้อมูลส่วนบุคคล

- การวัดและมาตรฐานประสิทธิภาพ — พัฒนาชุดเมตริกมาตรฐานสำหรับการวัดผล (เช่น ความสามารถในการลดพีค %, ค่า MTTR ของเหตุการณ์ด้านความถี่, ผลตอบแทนต่อการลงทุน) เพื่อให้เปรียบเทียบผลระหว่างโครงการได้อย่างเป็นระบบ

สรุปแล้ว ผลการทดลองชี้ชัดว่าเทคโนโลยี RL สำหรับการจัดสรรการชาร์จ EV และแบตเตอรี่บ้านมีศักยภาพเชิงปฏิบัติที่สำคัญในการลดพีคโหลดและรักษาความถี่ของกริด โดยข้อเสนอแนะเชิงนโยบายและเชิงปฏิบัติการที่เสนอ—รวมถึงการจัดตั้ง regulatory sandbox, มาตรการจูงใจ, มาตรฐานการสื่อสารและความปลอดภัย—จะช่วยเร่งการนำเทคโนโลยีสู่การขยายผลในระดับภูมิภาคและระดับประเทศได้อย่างมั่นคงและยั่งยืน

บทสรุป

โครงการนำร่องในประเทศไทยแสดงให้เห็นว่าโซลูชันการจัดสรรการชาร์จแบบใช้เทคนิค Reinforcement Learning (RL) สำหรับรถไฟฟ้า (EV) และแบตเตอรี่บ้านแบบกระจาย สามารถลดพีคโหลดในชุมชนจริงได้อย่างมีนัยสำคัญ อยู่ในช่วง 20–30% พร้อมทั้งช่วยรักษาเสถียรภาพความถี่ของกริดผ่านการปรับจังหวะการชาร์จ/จ่ายไฟแบบเรียลไทม์และการตอบสนองต่อการเปลี่ยนแปลงโหลด ตัวอย่างผลลัพธ์จากเมืองเล็กชี้ว่าการประสานงานระหว่างรถ EV และแบตเตอรี่บ้านโดยใช้ตัวแทน RL สามารถลดความต้องการพลังงานสูงสุดในช่วงพีค ลดการพึ่งพาแหล่งพลังงานฉุกเฉิน และลดต้นทุนการดำเนินงานของระบบไฟฟ้าได้ ทั้งนี้ยังต้องเผชิญความท้าทายด้านเทคนิค เช่น มาตรฐานการสื่อสาร ความล่าช้า (latency) ในการควบคุม การรักษาความปลอดภัยไซเบอร์ และปัญหาการปกป้องข้อมูล รวมถึงข้อจำกัดเชิงนโยบายเกี่ยวกับการกำกับดูแล ตลาดบริการความยืดหยุ่น และแบบจำลองค่าตอบแทนของผู้ใช้

เพื่อสเกลเทคโนโลยีนี้สู่การใช้งานระดับภูมิภาคและระดับชาติ จำเป็นต้องเดินหน้าในแนวทางผสานทั้งนโยบายและการปฏิบัติ ได้แก่ การตั้ง regulatory sandbox เพื่อทดสอบโมเดลธุรกิจและการรวมเทคโนโลยีจริงในสภาพแวดล้อมควบคุม, การกำหนดมาตรฐานการสื่อสารและการทำงานร่วมกัน (เช่น โปรโตคอลที่เป็นมาตรฐานและข้อกำหนดด้านอินเตอร์โอเปอราบิลิตี้), กรอบงานความปลอดภัยและการคุ้มครองข้อมูล, รวมถึง โมเดลจูงใจผู้ใช้ เช่น อัตราค่าไฟตามเวลา (TOU), ค่าตอบแทนสำหรับการให้บริการความยืดหยุ่นแบบรวมกลุ่ม (aggregation) และการแบ่งรายได้ที่ชัดเจน การขยายผลควรเริ่มจากการทดลองขนาดกลางในพื้นที่หลากหลายเพื่อตรวจสอบความทนทานของอัลกอริธึม RL ภายใต้สภาพเครือข่ายที่ต่างกัน และต้องมีการมีส่วนร่วมของหน่วยงานกำกับ ผู้ให้บริการระบบไฟฟ้า ผู้พัฒนาแพลตฟอร์ม และผู้บริโภคอย่างต่อเนื่อง หากรวมมาตรการเชิงนโยบายและเชิงปฏิบัติการเหล่านี้เข้าด้วยกัน เทคโนโลยี RL จะมีศักยภาพช่วยลดพีคโหลด เพิ่มความยืดหยุ่นของกริด และสนับสนุนเป้าหมายการลดก๊าซเรือนกระจกในระยะยาว