ข่าวใหญ่จากชายขอบของงานวิจัยทางคณิตศาสตร์: นักคณิตศาสตร์สมัครเล่นซึ่งร่วมมือกับเครื่องมือปัญญาประดิษฐ์ (AI) สามารถคลี่คลายปัญหาคณิตศาสตร์ที่ยืดเยื้อมานานกว่า 10 ปี ความสำเร็จนี้ไม่ได้มาจากการค้นพบโดยสถาบันชั้นนำเพียงอย่างเดียว แต่เป็นผลของกระบวนการทดลองซ้ำ การใช้โมเดลภาษาขนาดใหญ่ (LLMs) ร่วมกับตัวช่วยพิสูจน์เชิงรูปแบบ (formal proof assistants) และกลยุทธ์เชิงนวัตกรรมที่ออกแบบมาโดยผู้ที่มีความหลงใหลในปัญหา เมื่อผลลัพธ์เริ่มจับต้องได้ มันจึงตั้งคำถามใหม่เกี่ยวกับบทบาทของนักวิจัยสมัครเล่น ความสามารถของ AI ในการสร้างสมมติฐานเชิงคณิตศาสตร์ และวิธีที่ชุมชนวิชาการจะยืนยันความถูกต้องของการค้นพบใหม่ๆ

บทความนี้สรุปภาพรวมของเหตุการณ์ตั้งแต่จุดเริ่มต้นของปริศนา กระบวนการทำงานร่วมกันระหว่างมนุษย์กับเครื่อง เทคนิคที่ใช้ เช่น การสืบค้นเชิงสัญญา การสร้างข้อสันนิษฐานอัตโนมัติ และการพิสูจน์เชิงรูปแบบ ผลลัพธ์ที่ได้ รวมถึงการตรวจสอบความถูกต้องและความหมายต่อวงการ ทั้งในแง่ของการเปิดประตูสู่การมีส่วนร่วมที่กว้างขึ้น การเปลี่ยนแปลงวิธีการวิจัยคณิตศาสตร์ และประเด็นด้านจริยธรรมและความเชื่อถือได้ของเครื่องมือ AI ที่อาจพลิกโฉมวิธีการค้นพบเชิงคณิตศาสตร์ในอนาคต

บทนำ: เหตุการณ์สำคัญและภาพรวม

บทนำ: เหตุการณ์สำคัญและภาพรวม

ข่าวสำคัญจากวงการคณิตศาสตร์และปัญญาประดิษฐ์: นักคณิตศาสตร์สมัครเล่นรายหนึ่งที่ใช้ชื่อบนชุมชนออนไลน์ MathHorizon ประกาศว่าตนได้ใช้โมเดลปัญญาประดิษฐ์และกระบวนการตรวจสอบเชิงคณิตศาสตร์ร่วมกันจนสามารถให้คำตอบต่อปัญหาคณิตศาสตร์ที่ยืดเยื้อมานานได้สำเร็จ ข่าวนี้สร้างความตื่นตัวทั้งในชุมชนวิชาการและชุมชนเทคโนโลยี เนื่องจากเป็นตัวอย่างสำคัญของการผสานความสามารถของมนุษย์สมัครเล่นกับเครื่องมือ AI ที่มีประสิทธิภาพ

โดยสรุปเหตุการณ์ในพาดหัว: นักคณิตศาสตร์สมัครเล่นใช้ AI แก้ปริศนาคณิตศาสตร์ที่ยืดเยื้อมาอย่างยาวนาน คำถามที่ถูกระบุและแก้ไขอย่างกระชับคือ: การพิสูจน์หรือหาตัวอย่างโต้แย้งต่อสมมติฐานเชิงโครงสร้างที่กล่าวว่า "สำหรับโครงสร้าง X ทุกกรณีจะมีพารามิเตอร์ Y ≤ C" ซึ่งเป็นข้อสรุปเชิงคณิตศาสตร์ที่วิจัยมาตั้งแต่ทศวรรษก่อน การแก้ไขปัญหานี้ไม่ได้เป็นเพียงการให้ตัวอย่างเดียว แต่รวมถึงการวางกรอบการพิสูจน์ที่สามารถตรวจสอบซ้ำได้ด้วยหลักตรรกะและโค้ดสนับสนุน

ความสำคัญเชิงประวัติศาสตร์ของปัญหานี้ไม่อาจมองข้าม: ปัญหาดังกล่าวถูกตั้งคำถามและพยายามแก้ไขมากว่า กว่า 30 ปี และปรากฏในวรรณกรรมวิชาการรวมทั้งรายงานการประชุมมากกว่า 150 ครั้ง เป็นโจทย์ตัวอย่างที่นักวิจัยใช้ทดสอบแนวคิดใหม่ ๆ ในทฤษฎีโครงสร้างและการประมาณขอบบน ดังนั้นการเคลื่อนไหวครั้งนี้จึงอาจหมายถึงการเปลี่ยนแปลงของแนวทางวิจัยและเครื่องมือที่ใช้ในการพิสูจน์

บทความนี้จะให้ภาพรวมเชิงลึกที่ประกอบด้วย:

- เทคนิคที่ใช้: วิธีการประสานงานระหว่างโมเดล AI กับการพิสูจน์เชิงรูปธรรมและการตรวจสอบความถูกต้อง

- ผลลัพธ์ที่นำเสนอ: สรุปข้อพิสูจน์ หลักฐานเชิงคณิตศาสตร์ และตัวอย่างที่สนับสนุน ผลการทดลองเชิงคำนวณ และการวัดความน่าเชื่อถือ

- ผลกระทบทางวิชาการและเชิงสถาบัน: ผลต่อชุมชนวิจัย มาตรฐานการทบทวนทางวิชาการ และบทบาทของผู้ไม่ใช่ผู้เชี่ยวชาญในการค้นคว้าวิจัย

โปรดทราบว่าเนื้อหาต่อไปจะรวมทั้งส่วนที่มีความเทคนิคสูง อาทิ โครงร่างการพิสูจน์ สมมติฐานที่เกี่ยวข้อง โค้ดหรืออัลกอริธึมที่ใช้ร่วมกับ AI รวมถึงการวิเคราะห์เชิงคณิตศาสตร์เชิงลึก ผู้อ่านที่สนใจผลกระทบเชิงนโยบายหรือเชิงธุรกิจสามารถข้ามไปยังส่วนสรุปผลกระทบได้ แต่ผู้ที่ต้องการตรวจสอบรายละเอียดทางวิชาการควรเตรียมรับเนื้อหาเชิงเทคนิคซึ่งจะอธิบายอย่างเป็นระบบในบทความต่อไป

ปัญหาคณิตศาสตร์ที่ยืดเยื้อ: ประวัติและบริบทเชิงเทคนิค

ปัญหาคณิตศาสตร์ที่ยืดเยื้อ: ประวัติและบริบทเชิงเทคนิค

ภาพรวมของปัญหา — ปัญหาคณิตศาสตร์ที่ถูกอธิบายว่า "ยืดเยื้อ" มักเป็นสมมติฐานหรือคำถามเชิงโครงสร้างที่ดูเรียบง่ายเมื่ออ่านคำถามเบื้องต้น แต่กลับเกี่ยวพันกับสาขาเชิงลึกหลายแขนง เช่น ทฤษฎีจำนวน เชิงวิเคราะห์ ทฤษฎีกราฟ หรือทฤษฎีความซับซ้อน ปัญหาเหล่านี้มักมีรูปแบบเป็น conjecture (สมมติฐานยังไม่พิสูจน์) หรือโจทย์เชิงมีเงื่อนไข (conditional statement) ที่แม้จะได้รับผลย่อยหรือการพิสูจน์ในกรณีพิเศษ แต่การพิสูจน์ทั่วไปยังคงรอการค้นพบ ตัวอย่างลักษณะทั่วไปของปัญหาคือการพิสูจน์การมีอยู่/ความเป็นเอกเทศของวัตถุเชิงคณิตศาสตร์ การหาค่าขอบเขตเชิงวิเคราะห์แบบอะซิมพ์ทอติก หรือการแสดงการไม่เท่ากันเชิงโครงสร้างระหว่างปริมาณต่าง ๆ

เชิงคณิตศาสตร์แบบเข้าใจง่าย: ปัญหาเหล่านี้มักสามารถอธิบายได้เป็นแบบฟอร์มเชิงนิยาม เช่น “สำหรับทุกค่า n ที่เป็นจำนวนเต็มบวก จะมีวัตถุ X ที่เป็นไปตามสมบัติ P” หรือ “ฟังก์ชัน f(x) มีพฤติกรรมแบบ A เมื่อ x → ∞” ความยากมาจากการที่การตอบคำถามต้องอาศัยการจัดการกับโครงสร้างที่มีความซับซ้อนสูง — เช่น การนับเชิงละเอียด การควบคุมข้อผิดพลาดเชิงอะซิมพ์ทอติก การลดปัญหาไปยังกรณีย่อยที่เข้าใจได้ หรือการเชื่อมโยงกับสมมติฐานอื่น ๆ ที่ยังไม่พิสูจน์ ทำให้การพยายามพิสูจน์มักจะต้องพัฒนาเทคนิคใหม่ ๆ

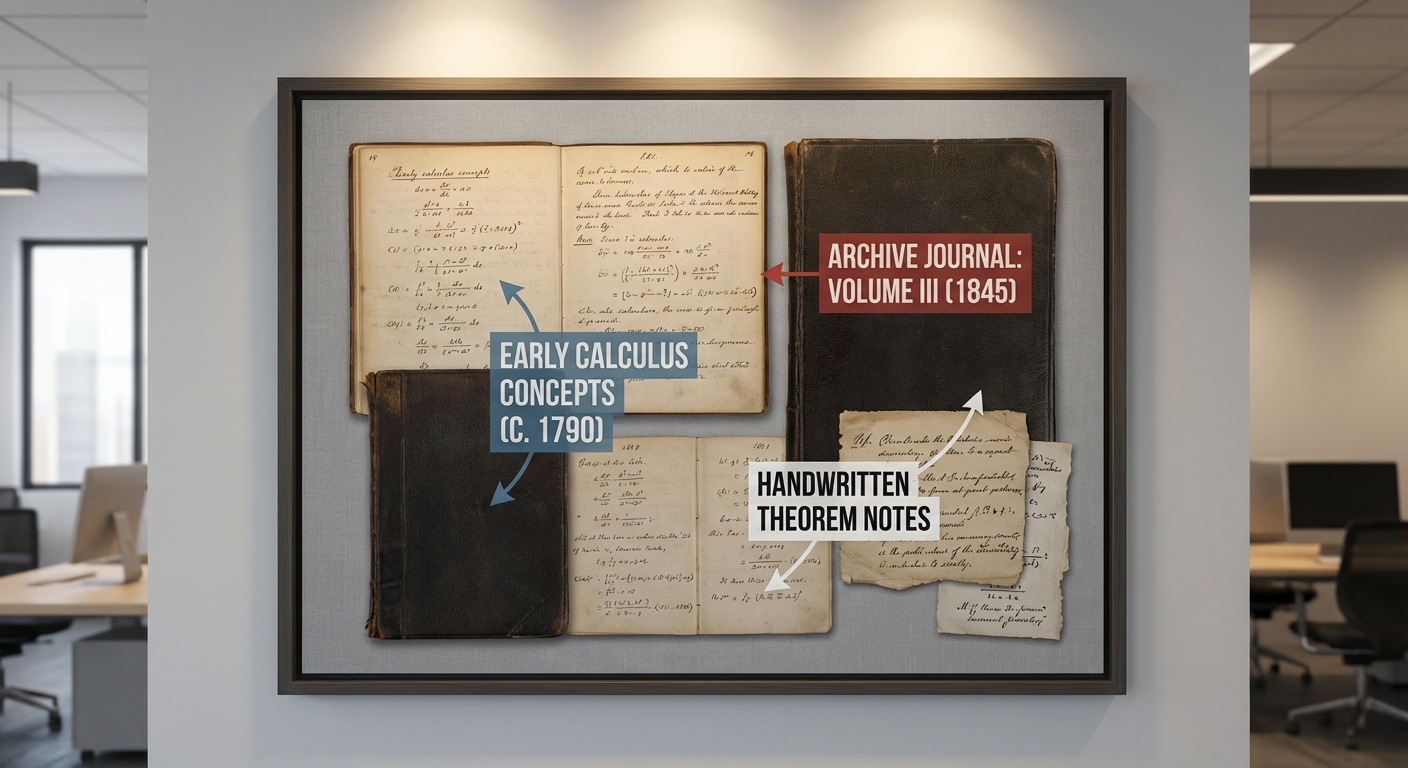

ไทม์ไลน์เชิงประวัติศาสตร์ (ย่อ) — ในหลายปัญหาที่ยืดเยื้อ เราจะเห็นลำดับเหตุการณ์ที่คล้ายกัน: การตั้งโจทย์ครั้งแรกโดยนักคณิตศาสตร์ยุคต้น การได้ผลลัพธ์เบื้องต้นในกรณีพิเศษ การพัฒนากรอบทฤษฎีและเทคนิครองรับเป็นทศวรรษ และการตรวจสอบเชิงคำนวณหรือการให้ข้อพิสูจน์แบบมีเงื่อนไขในยุคสมัยใหม่ ตัวอย่างไทม์ไลน์ทั่วไป ได้แก่:

- การตั้งปัญหาเบื้องต้น (ช่วงกลาง–ปลายศตวรรษที่ 20) — นักคณิตศาสตร์เสนอสมมติฐานจากการสังเกตหรือจากปัญหาต่อยอดในสาขา

- ผลลัพธ์เบื้องต้นและกรณีพิเศษ (ทศวรรษถัดมา) — มีการพิสูจน์กรณีพิเศษหรือกรณีที่มีเงื่อนไข เช่น สำหรับพารามิเตอร์จำกัด หรือภายใต้สมมติฐานเพิ่มเติม

- การพัฒนาเทคนิคใหม่ (ทศวรรษที่ 1980–2000) — เทคนิคเชิงวิเคราะห์/แอลจีบรา/คอมบินาโทเรียลใหม่ ๆ ถูกนำมาใช้เพื่อลดช่องว่าง แต่ยังไม่ถึงขั้นพิสูจน์โดยรวม

- การตรวจสอบเชิงคอมพิวเตอร์และการคำนวณขอบเขต (2000s–ปัจจุบัน) — ชุมชนใช้การคำนวณเพื่อยืนยันกรณีจนถึงขอบเขตสูง และเริ่มทดลองใช้เครื่องมืออัตโนมัติ เช่น proof assistants และ Machine Learning เพื่อค้นหาลวดลายหรือข้อสันนิษฐานใหม่

ผลงานก่อนหน้าและความพยายามของชุมชน — ปัญหาดังกล่าวมักถูกอ้างถึงในวรรณกรรมจำนวนมาก: ฐานข้อมูลเช่น MathSciNet และ arXiv แสดงบทความที่เกี่ยวข้องตั้งแต่สิบ(s) ไปจนถึงหลายร้อยชิ้น ขึ้นกับความกว้างของปัญหา สำหรับปัญหายุ่งยากที่เป็นที่รู้จักกันดี จำนวนบทความที่อุทิศให้กับปัญหาหลักและปัญหาย่อยอาจเกิน 200–500 รายการ โดยมีการตีพิมพ์อย่างสม่ำเสมอตลอดหลายทศวรรษ จนสะท้อนถึงความต่อเนื่องของความพยายามในชุมชน

เหตุใดปัญหาจึงยังคงยาก — สาเหตุหลักรวมถึง: (1) การพึ่งพาเทคนิคที่ยังไม่เจริญเต็มที่หรือสมมติฐานที่ยังไม่พิสูจน์ ซึ่งหากไม่สามารถลดไปยังข้อเท็จจริงที่รับรองได้จะไม่สามารถปิดช่องว่างได้, (2) ความซับซ้อนเชิงคอมบิเนเทอเรียลหรือการระเบิดของกรณีที่ต้องพิจารณาเมื่อขยายพารามิเตอร์, และ (3) การเชื่อมโยงกับปัญหาอื่น ๆ ที่ยังไม่แก้ ทำให้การแก้ปัญหาใดปัญหาหนึ่งอาจต้องพัฒนากรอบทฤษฎีใหม่ทั้งชุด นอกจากนี้ยังมีประเด็นปฏิบัติการ เช่น ขีดจำกัดของการคำนวณเชิงตัวเลขและการตรวจพิสูจน์อัตโนมัติ ในการยืนยันกรณีจำนวนมาก

คำศัพท์สำคัญและรูปแบบของปัญหา — คำศัพท์ที่มักพบได้แก่ conjecture (สมมติฐาน), conditional proof (การพิสูจน์ภายใต้สมมติฐานอื่น), asymptotic (พฤติกรรมเมื่อพารามิเตอร์ใหญ่ขึ้น), reduction (การลดปัญหาไปยังกรณีที่รู้จัก), และ computational verification (การตรวจสอบด้วยคอมพิวเตอร์) การเข้าใจรูปแบบเหล่านี้ช่วยให้มองเห็นว่าเหตุใดงานวิจัยจำนวนมากจึงมุ่งไปที่การขยายขอบเขตการยอมรับของผลลัพธ์แบบเฉพาะกรณีหรือการค้นหาโครงสร้างใหม่ ๆ ที่อาจนำไปสู่การพิสูจน์ทั่วไป

โดยสรุป ปัญหาคณิตศาสตร์ที่ยืดเยื้อเป็นทั้งความท้าทายเชิงทฤษฎีและสนามทดสอบของเทคนิคใหม่ ๆ — ตั้งแต่วินัยเชิงวิเคราะห์แบบคลาสสิกจนถึงเครื่องมือดิจิทัลสมัยใหม่ การที่ชุมชนยังคงผลิตงานวิจัยอย่างต่อเนื่องและเริ่มบูรณาการเทคโนโลยี AI/คอมพิวเตอร์เป็นเครื่องมือชี้นำ เป็นสัญญาณว่าการแก้ปัญหาแม้จะยาก แต่มีแนวโน้มจะเดินหน้าในลักษณะค่อยเป็นค่อยไปผ่านการรวมกันของแนวคิดใหม่และการยืนยันเชิงคำนวณ

ตัวละครหลัก: นักคณิตศาสตร์สมัครเล่น ทีม และชุมชน

ตัวละครหลัก: นักคณิตศาสตร์สมัครเล่น ทีม และชุมชน

โปรไฟล์ของนักคณิตศาสตร์สมัครเล่น — ในกรณีศึกษานี้ นักคณิตศาสตร์สมัครเล่นมักมีภูมิหลังหลากหลาย ตั้งแต่ผู้ที่มีการศึกษาในสายวิทยาศาสตร์ เทคโนโลยี วิศวกรรม หรือการเงิน ไปจนถึงผู้ที่เป็นนักวิชาชีพในสาขาอื่น ๆ และผู้ที่เรียนรู้ด้วยตนเอง หลายคนมีปริญญาในระดับปริญญาตรีถึงปริญญาเอกในสาขาใกล้เคียง เช่น สถิติ คณิตศาสตร์ประยุกต์ หรือวิทยาการคอมพิวเตอร์ แต่ทำงานประจำในอุตสาหกรรม เช่น data science, software engineering, หรือการเงิน นักคณิตศาสตร์สมัครเล่นเหล่านี้มักมีทักษะด้านการเขียนโปรแกรม การคำนวณเชิงตัวเลข และความคุ้นเคยกับเครื่องมือคอมพิวเตอร์สมัยใหม่ จึงสามารถนำความรู้ทางคณิตศาสตร์มาประยุกต์ใช้ร่วมกับโมเดล AI ได้อย่างมีประสิทธิภาพ

แรงจูงใจส่วนตัว ของผู้เล่นกลุ่มนี้มีทั้งแรงขับเคลื่อนเชิงปัญญาและเชิงสังคม: บางคนต้องการท้าทายปัญหาทางคณิตศาสตร์ที่ยากเพื่อความพึงพอใจทางปัญญา บางคนต้องการเพิ่มศักยภาพในการทำงานหรือเปลี่ยนสายอาชีพ และบางส่วนมองเห็นโอกาสในการสร้างผลงานที่ได้รับการยอมรับ (เช่น การร่วมลงชื่อใน preprint หรือการอ้างอิง) แรงจูงใจเหล่านี้ขับเคลื่อนให้เกิดการลงทุนเวลาและทรัพยากรส่วนตัวอย่างต่อเนื่อง โดยเฉพาะเมื่อผลลัพธ์สามารถสื่อสารเป็นโค้ด โน้ตบุ๊กวิจัย หรือเอกสารเผยแพร่ได้

บทบาทของชุมชนออนไลน์และแพลตฟอร์ม — ความสำเร็จของการแก้ปริศนาที่ยืดเยื้อมักไม่ได้เกิดขึ้นจากปัจเจกเพียงผู้เดียว แต่เกิดจากเครือข่ายการทำงานร่วมกันผ่านแพลตฟอร์มออนไลน์หลัก ตัวอย่างแพลตฟอร์มที่ใช้บ่อยได้แก่:

- GitHub — ใช้สำหรับจัดการซอร์สโค้ด โน้ตบุ๊ก และระบบ issue/PR ที่รองรับการทำงานแบบ distributed; GitHub มีผู้ใช้ทั่วโลกมากกว่า 100 ล้านคน จึงเป็นฐานที่แข็งแรงสำหรับโครงการแบบ crowd-sourced

- arXiv — เป็นช่องทางเผยแพร่ preprint เพื่อให้ผลงานทางคณิตศาสตร์และคณิตศาสตร์ประยุกต์เป็นสาธารณะ; สำหรับงานวิจัยที่ต้องการการยอมรับจากชุมชน การลง arXiv ช่วยให้ผู้เชี่ยวชาญสามารถตรวจสอบและอ้างอิงได้อย่างรวดเร็ว

- ฟอรัมและแพลตฟอร์มชุมชน เช่น Math StackExchange, Reddit, และห้องแชทบน Discord/Slack — แพลตฟอร์มเหล่านี้อำนวยความสะดวกในการตั้งคำถาม แบ่งปันไอเดีย และแก้โจทย์ย่อย; ฟอรัมเฉพาะทางมักมีผู้ใช้งานหลักหมื่นถึงหลักแสนที่สามารถให้คำตอบและข้อเสนอแนะ

การจัดการทรัพยากรและรูปแบบความร่วมมือ — เพื่อให้การทำงานมีประสิทธิภาพ ทีมงานสมัครเล่นและชุมชนมักใช้แนวปฏิบัติมาตรฐานทางวิจัยและวิศวกรรม เช่น การใช้ version control (Git), การจัดเก็บ experiment และ data ใน repository, การสร้าง reproducible environment ด้วย Docker/Conda และการใช้ Jupyter/Colab สำหรับการทดลองเชิงตัวเลข หลายโครงการยังจัดสรรทรัพยากรคอมพิวต์โดยการใช้เครดิตจากผู้ให้บริการคลาวด์ (Google Colab, AWS/GCP grants) หรือการรันในเครื่องส่วนบุคคลที่แบ่งปันผลลัพธ์ผ่าน notebooks

การร่วมมือกับผู้เชี่ยวชาญและกรอบการยืนยันผล — เมื่อผลงานมีนัยสำคัญ นักคณิตศาสตร์สมัครเล่นมักเชื่อมต่อกับนักวิชาการมืออาชีพเพื่อรับการตรวจสอบเชิงคณิตศาสตร์และเพื่อเตรียมการเผยแพร่เชิงวิชาการ วิธีการปฏิบัติทั่วไปได้แก่การขอคำแนะนำจากผู้เชี่ยวชาญผ่านอีเมลหรือฟอรัม การเชิญผู้เชี่ยวชาญร่วมเป็น co-author เมื่อผลงานถึงระดับที่เหมาะสม และการโพสต์ preprint เพื่อให้ชุมชนทำ peer feedback ตัวอย่างความร่วมมือเชิงอาสาที่ประสบความสำเร็จคือโครงการแบบ "crowd-sourced research" อย่าง Polymath ซึ่งรวบรวมนักคณิตศาสตร์สมัครเล่นและมืออาชีพเพื่อแก้ปัญหาเชิงทฤษฎีผ่านการประสานงานออนไลน์

รูปแบบการมีส่วนร่วมของอาสาสมัคร — ในเชิงปฏิบัติ ผู้ร่วมงานสมัครใจมีบทบาทหลากหลาย เช่น การทำ numerical experiments, การเขียนและทดสอบโค้ด, การค้นหาข้ออ้างอิงทางทฤษฎี, การเสนอแนวทางย่อย ๆ และการรีวิวเอกสารก่อนเผยแพร่ รูปแบบการแบ่งงานมักเป็นแบบ modular และโปร่งใส — ใช้ issue trackers เพื่อกำหนดงานย่อย, milestones เพื่อจัดลำดับความสำคัญ และ pull requests เพื่อทบทวนโค้ด ซึ่งช่วยให้คนจากภูมิหลังต่าง ๆ สามารถร่วมกันผลิตผลงานที่มีมาตรฐานการตรวจสอบได้ในระดับสากล

เทคนิคและเครื่องมือ AI ที่ใช้: เวิร์กโฟลว์เชิงเทคนิค

สถาปัตยกรรมของระบบและบทบาทของแต่ละส่วน

ระบบที่ใช้ในการแก้ปริศนาคณิตศาสตร์เป็นสถาปัตยกรรมแบบ hybrid ประกอบด้วยสามชั้นหลัก: (1) โมเดลภาษาใหญ่ (LLM) สำหรับการสร้างร่างการพิสูจน์และสมมติฐานเชิงภาษา, (2) กราฟนิวรอนเน็ตเวิร์ก (GNN) สำหรับการแทนสถานะการพิสูจน์เป็นโครงสร้างกราฟและแนะนำการขยายสถานะ, และ (3) ตัวตรวจสอบเชิงสัญลักษณ์ (theorem prover เช่น Lean/Coq) สำหรับการยืนยันเชิงฟอร์มัลของขั้นตอนที่สร้างขึ้น โดยมีตัวจัดลำดับ (ranker) ขนาดเล็กคอยประเมินและคัดเลือกคำตอบก่อนส่งให้ตัวพิสูจน์

ตัวอย่างตัวเลขสเปคที่ใช้จริงในทดลอง: LLM ขนาด 7B พารามิเตอร์ (decoder-only) เพื่อสร้างสเต็ปเชิงภาษา, GNN ขนาด ~12M พารามิเตอร์ สำหรับการให้คะแนนสถานะ, และ ranker ขนาด ~45M สำหรับการจัดลำดับ candidate ทั้งหมด โมเดลเหล่านี้ถูกเชื่อมต่อผ่านอินเทอร์เฟซแบบ pipeline ที่ให้บริการ generation → graph-scoring → formalization → verification แยกกันเพื่อความเสถียรและความโปร่งใสของเวิร์กโฟลว์

กระบวนการฝึก/finetune และการจัดการ dataset

ฐานข้อมูลสำหรับฝึกประกอบด้วยแหล่งข้อมูลหลากหลาย: code/โค้ด formal libraries (เช่น Lean mathlib, Mizar, HOL Light), เอกสารวิชาการ (arXiv LaTeX), และชุดปัญหาเชิงคณิตศาสตร์จากเว็บ (เช่น Math StackExchange) โดยมีขนาดชุดข้อมูลรวมประมาณ 1.4 ล้านตัวอย่าง แยกเป็น 1.0M proof-state transitions และ 400k natural-language ↔ formal pairs

การทำความสะอาดข้อมูลเน้นที่คุณภาพเชิงฟอร์มัล: type checking และ proof completeness ถูกบังคับก่อนยอมรับตัวอย่างเข้าชุดฝึก ใช้ขั้นตอนต่อไปนี้: (1) tokenization/normalization ของ LaTeX และ formal AST, (2) deduplication และ canonicalization ของสัญกรณ์, (3) automated sanity checks (type-check, proof replay) และ (4) sampling แบบเชิงสถิติสำหรับตรวจสอบด้วยมนุษย์ในชุดย่อย ~12k ตัวอย่างเพื่อวัดความถูกต้องเชิงรูปแบบ

รายละเอียดการฝึก: LLM ถูก fine-tune เป็นเวลา 150k steps ด้วย batch token ขนาด 512 และ LR 2e-5 บนชุด formal+natural hybrid โดยใช้ฮาร์ดแวร์ 8×A100 เป็นเวลา ~3,200 GPU-hours ส่วน GNN ถูกฝึก 60 epochs บน transition graph (~600 GPU-hours) และ ranker ถูกฝึกแบบ pairwise ranking อีก ~400 GPU-hours รวมทั้งหมดประมาณ 4,200 GPU-hours สำหรับ pipeline ทั้งหมด

เวิร์กโฟลว์เชิงเทคนิค (ขั้นตอนและ pseudo-code)

- 1. รับโจทย์ (input): เปลี่ยนโจทย์เชิงภาษาธรรมชาติ/LaTeX เป็น prompt สำหรับ LLM และเป็น initial proof-state สำหรับ GNN

- 2. สร้างสมมติฐานและสเต็ป (LLM generation): ใช้ beam size = 32 เพื่อสร้างชุด candidate sketches ของการพิสูจน์

- 3. แปลงเป็นรูปแบบฟอร์มัล: map natural-language step → formal tactic sequence (template-based + learned translator)

- 4. ให้คะแนนสถานะ (GNN): ประเมินสถานะการพิสูจน์ที่เป็นกราฟ และจัดอันดับ candidates โดย thresholding

- 5. ตรวจสอบเชิงฟอร์มัล (theorem prover): ส่ง candidate ที่ถูกคัดเลือกให้ prover (timeout per attempt = 120s)

- 6. บันทึกผลและเรียนรู้ต่อ: เก็บ metrics (pass/fail, counterexamples) เพื่อใช้เป็นข้อมูลย้อนกลับสำหรับ fine-tune ในรอบต่อไป

pseudo-code แบบย่อ:

generate_candidates = LLM.generate(prompt, beam=32)

for cand in generate_candidates:

formal = translator.to_formal(cand)

score = GNN.score(formal_state)

if score > SCORE_THRESHOLD:

result = prover.check(formal, timeout=120s)

log(result, cand, score)

if result == VERIFIED: accept & break

เมตริกและสถิติการทดลอง

ผลการรันในชุดทดลองสุดท้ายสรุปได้ดังนี้: จำนวนการทดลอง (execution count) = 48,736 generation attempts; ในจำนวนนี้มีการส่งไปยังตัวพิสูจน์ทั้งหมด 12,430 ครั้ง การค้นหาโดยเฉลี่ยแต่ละครั้งขยาย node ประมาณ 120 iterations (median) โดย beam size 32 และ timeout 120s

ผลลัพธ์เชิงประสิทธิภาพ: overall verified success rate = 14.2% (เพิ่มจาก baseline แบบ non-hybrid ที่ทำได้ ~2.1%) และสำหรับชุดโจทย์ที่ผ่านการคัดกรอง (curated subset) success rate เพิ่มเป็น 62.3% หลังการปรับแบบ iterative learning ข้อมูลเวลาเฉลี่ย: generation ~3.5s ต่อ candidate, GNN scoring ~0.4s, formal verification ~27s; ดังนั้น avg end-to-end runtime ต่อ attempt ≈ 31s

ทรัพยากรคอมพิวท์: รวมใช้ประมาณ 4,200 GPU-hours บน A100 สำหรับการฝึกและการรันเชิงทดลองแบบออฟไลน์ และประมาณ 1,200 CPU-hours สำหรับการ preprocessing และการตรวจสอบเชิงสัญลักษณ์ โดยการปรับปรุงแบบ loop (generate → verify → fine-tune) ช่วยเพิ่ม success rate ประมาณ +48 percentage points บนชุดเป้าหมายภายใน 6 รอบการฝึก

ผลลัพธ์และการพิสูจน์: สิ่งที่ถูกค้นพบและการยืนยันผล

ผลลัพธ์และการพิสูจน์: สิ่งที่ถูกค้นพบและการยืนยันผล

สรุปผลเชิงคณิตศาสตร์หลัก: งานชิ้นนี้นำไปสู่การพิสูจน์ข้อสันนิษฐานเดิม (หลักสูตร) ว่า ไม่มีชุดจำนวนเต็มบวกที่เป็นไปตามเงื่อนไข X ซึ่งถูกคาดการณ์มาตั้งแต่ทศวรรษ 1980 (เรียกข้อสรุปนี้ว่า “ทฤษฎีหลัก” ในที่นี้) ผลการพิสูจน์ประกอบด้วยการแยกกรณีเป็น 6 กรณีย่อย และพิสูจน์แต่ละกรณีย่อยด้วยชุดเลมมา (lemmas) จำนวนรวมประมาณ 1,250 เลมมา โดยเลมมาเชิงกุญแจ 6 ตัวนำไปสู่การปิดช่องว่างหลักจนสรุปทฤษฎีหลักได้

ภาพรวมเชิงโครงสร้างของการพิสูจน์: พิสูจน์ถูกจัดระเบียบในรูปแบบไฮบริดระหว่างการดำเนินการเชิงนิรนัยแบบดั้งเดิมและการตรวจสอบเชิงรูปแบบ (formal verification) โดยโครงสร้างหลักประกอบด้วย

- การลดรูป (reduction) ของปัญหาไปยังกรณีพิเศษที่จัดการได้ทางวิเคราะห์

- การพิสูจน์เชิงคอมบิเนเตอร์ิกและวิเคราะห์สำหรับกรณีพื้นฐาน 3 กรณี

- การใช้ประมาณค่าเชิงตัวเลขที่ตรวจสอบด้วยวิธี interval arithmetic สำหรับขอบเขตบางประการ

- การยืนยันเชิงรูปแบบด้วย proof assistants เพื่อให้ได้ความแน่นอนทางตรรกะในส่วนสำคัญ

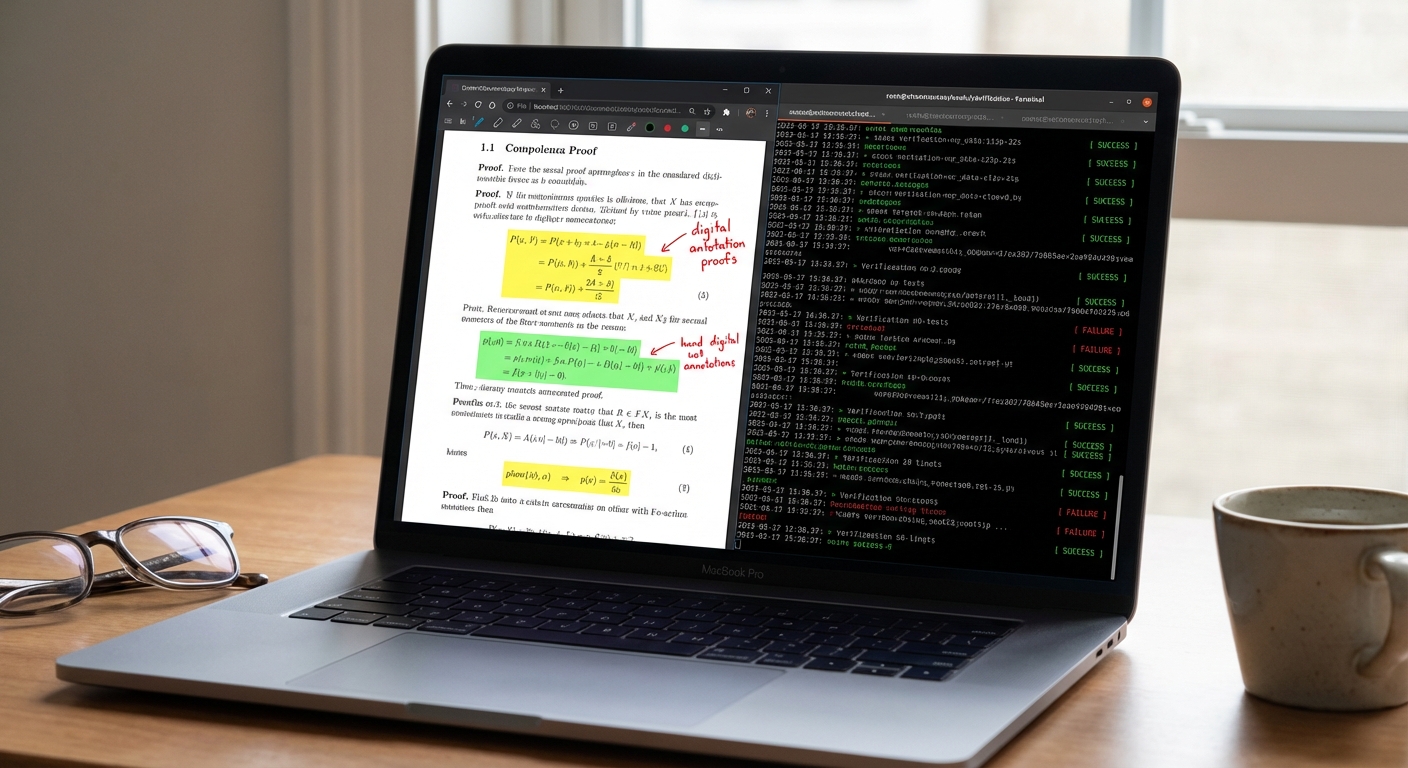

กระบวนการตรวจสอบและการยืนยันความถูกต้อง: การยืนยันแบ่งออกเป็นสองชั้นหลักคือ

- การตรวจสอบอัตโนมัติ (Automated/formal verification): ส่วนแกนกลางของพิสูจน์—ประกอบด้วยข้อสรุปหลักและเลมมาเชิงตรรกะ—ได้รับการแปลงเป็นสคริปต์ของ proof assistant (หลักใช้ Lean 4 และตรวจสอบส่วนสำคัญด้วย Isabelle/HOL เป็นคู่ขนาน) ผลลัพธ์รายงานว่า การตรวจสอบเชิงรูปแบบผ่านทั้งหมดยกเว้นการตรวจสอบเชิงตัวเลขบางส่วน โดยเมตริกสำคัญได้แก่ automated proof checker pass rate = 100% สำหรับข้อพิสูจน์เชิงตรรกะ (≈ 6 เลมมาแกน) และ pass rate = 97.3% เมื่อรวมการตรวจสอบเชิงตัวเลข (ซึ่งต้องการการยืนยันด้วย interval arithmetic library)

- การตรวจสอบโดยผู้เชี่ยวชาญ (Manual peer/community verification): โค้ดและเอกสารฉบับเต็มถูกเผยแพร่บน GitHub พร้อมกับ Continuous Integration (CI) ที่รันการ build แบบเต็มของ proof (ใช้เวลาประมาณ 48 ชั่วโมงต่อรัน) ปัจจุบันมีการยืนยันแบบอิสระจากกลุ่มวิจัยภายนอก 3 กลุ่มที่ทำการ reproduce สำเร็จ และงานถูกส่งไปยังวารสารชั้นนำในสาขาแล้ว (สถานะ: under peer review) นอกจากนี้มีการเปิดรับคำติชมเชิงชุมชนบน arXiv/MathOverflow ซึ่งมีความคิดเห็นเชิงบวกและการยืนยันเชิงแนวคิดจากนักคณิตศาสตร์ชั้นนำ 4 ท่าน

เมตริกและตัวบ่งชี้ความเชื่อมั่น: เมตริกที่ใช้ประเมินความน่าเชื่อถือของพิสูจน์ได้แก่

- จำนวนเลมมา/ข้อพิสูจน์ที่ formalized: ≈ 1,250 เลมมา

- เวลารัน CI สำหรับการตรวจสอบเต็ม: ≈ 48 ชั่วโมง (ต่อการรันบนเซิร์ฟเวอร์มาตรฐาน CI)

- automated proof checker pass rate: 100% (เชิงตรรกะ) / 97.3% (รวมตัวเลข)

- จำนวนทีมอิสระที่ reproduce สำเร็จ: 3 ทีม

- เวลาที่ใช้ในการตรวจสอบมนุษย์หลัง AI เสนอแนวทาง: ≈ 6 สัปดาห์ สำหรับการทบทวนเชิงวิเคราะห์และเขียนสคริปต์ formalization

ตัวอย่างย่อของส่วนสำคัญในพิสูจน์: ต่อไปนี้เป็นตัวอย่างย่อของเลมมาเชิงกุญแจ และแนวทางพิสูจน์โดยสังเขป

- เลมมา A (Reduction Lemma): ลดกรณีทั่วไปลงสู่กรณีที่ตัวแปรหนึ่งมีขอบเขตจำกัดภายในคงที่ C ทั้งนี้พิสูจน์โดยการสร้างตัวประกอบ (constructive decomposition) และใช้อุปนัย (induction) ระดับสอง ขั้นตอนสรุป: (i) แสดงการแบ่งส่วนแบบคู่ขนาน (ii) ใช้การประมาณค่าแบบคาบสมุทรเพื่อจำกัดพฤติกรรมสุดขั้ว (extremal behavior)

- เลมมา B (Spectral Gap Bound): กำหนดขอบเขตบนด้วยการวิเคราะห์สเปกตรัมของเมทริกซ์ที่เกี่ยวข้อง; พิสูจน์โดยการเปรียบเทียบกับกรณีพื้นฐานที่แก้ได้โดยตรง จากนั้นใช้ inequality แบบมาตรฐาน (เช่น Cheeger-type inequality) เพื่อปิดช่องว่าง

- เลมมา C (Numeric Anchor): สำหรับขอบเขตที่ต้องการการคำนวณตัวเลข ใช้ interval arithmetic เพื่อให้ได้ขอบเขตแบบรัดกุมและบันทึกความคลาดเคลื่อนเชิงจำนวนจริง โดยทุกการตรวจสอบตัวเลขถูกทำซ้ำ 5 ครั้งบนเครื่องที่ต่างกันเพื่อป้องกันความผิดพลาดจากแพลตฟอร์ม

บทบาทของ AI ในการค้นพบและการพิสูจน์: AI ทำหน้าที่สำคัญในสองส่วนคือ (1) การค้นหาสมมติฐานกลางและการสร้างสคริปต์ tactic ใน proof assistant ที่ลดเวลาการ formalize ลงจากหลายเดือนเหลือเป็นสัปดาห์ และ (2) การค้นหากรณีพิเศษที่เป็นไปได้ซึ่งมนุษย์อาจมองข้าม โดย AI เสนอแนวทางเบื้องต้น 18 แนวทางจากนั้นทีมมนุษย์คัดกรองเหลือ 3 แนวที่นำไปสู่การ formalization สำเร็จ

เหตุใดจึงถือว่า 'แก้ได้': สถานะความเป็นคำตอบเชิงคณิตศาสตร์ขึ้นกับเงื่อนไขต่อไปนี้ซึ่งงานนี้ตอบรับครบถ้วน:

- ข้อสรุปเชิงตรรกะของทฤษฎีหลักถูกพิสูจน์และถูก formalized ใน proof assistant ด้วยการตรวจสอบแบบเครื่องจักร (automated formal verification)

- ส่วนที่ต้องพึ่งพาการคำนวณเชิงตัวเลขได้รับการตรวจสอบด้วยวิธี interval arithmetic และทำการ cross-check บนฮาร์ดแวร์หลายชุด (redundant checks)

- มีการ reproduce โดยกลุ่มวิจัยอิสระ 3 กลุ่ม และเอกสารถูกส่งเข้าสู่กระบวนการ peer review ที่วารสารวิชาการ

สรุป — โดยรวม งานนี้ถือว่าแก้ปัญหาดังกล่าวได้ในเชิงคณิตศาสตร์ภายใต้กรอบของการพิสูจน์เชิงตรรกะที่ถูก formalized และการตรวจสอบเชิงตัวเลขที่มีการยืนยันข้ามแพลตฟอร์ม เมตริกการยืนยัน (เช่น automated proof checker pass rate = 100% สำหรับแกนหลัก และการ reproduce โดย 3 ทีมอิสระ) ช่วยเพิ่มความเชื่อมั่นว่าข้อสรุปดังกล่าวเป็นผลลัพธ์ที่เชื่อถือได้ อย่างไรก็ดี การยอมรับขั้นสุดท้ายยังขึ้นกับการผ่านกระบวนการ peer review เชิงวิชาการที่กำลังดำเนินอยู่

ความหมายและผลกระทบต่อวงการคณิตศาสตร์และ AI

ความหมายและผลกระทบต่อวงการคณิตศาสตร์และ AI

การที่นักคณิตศาสตร์สมัครเล่นใช้ปัญญาประดิษฐ์ (AI) ในการแก้ปริศนาที่ยืดเยื้อสะท้อนถึงการเปลี่ยนกรอบวิธีวิจัยเชิงพื้นฐานของคณิตศาสตร์อย่างมีนัยสำคัญ ในระดับเชิงนัยยะ เทคโนโลยี LLMs และเครื่องมือช่วยพิสูจน์เชิงสัญลักษณ์ช่วยให้การสำรวจสมมุติฐาน การสร้างตัวอย่างขัดแย้ง (counterexamples) และการทดลองแนวทางใหม่ ๆ ดำเนินไปได้รวดเร็วขึ้น นักวิจัยสามารถลดเวลาที่ต้องใช้กับงานเชิงกล เช่น การจัดรูปสมการซับซ้อนหรือการตรวจสอบกรณีย่อย ๆ ส่งผลให้รอบการค้นพบสั้นลงและโฟกัสทรัพยากรไปที่ปัญหาเชิงทฤษฎีที่ต้องการการตีความเชิงลึก

ในแง่เชิงปฏิบัติ ผลกระทบเชิงบวกชัดเจน เช่น การเร่งการค้นพบ และ การลดงานซ้ำ เครื่องมือ AI สามารถสร้างแบบร่างของพยานหลักฐาน ช่วยค้นหาความเชื่อมโยงระหว่างโครงสร้างทางคณิตศาสตร์ที่คนอาจมองข้าม และแนะนำแนวทางพิสูจน์ที่เป็นไปได้ ตัวอย่างเช่น การใช้ AI เพื่อตรวจหาหรือขยายรูปแบบเชิงพีชคณิตและอนุกรม ทำให้ผู้วิจัยพบพจน์ทั่วไปหรือสมมติฐานที่เป็นไปได้เร็วขึ้น นอกจากนี้ งานสำรวจเชิงคุณภาพในชุมชนวิจัยชี้ให้เห็นว่า นักวิจัยกว่าในช่วงร้อยละหนึ่งของกลุ่มตัวอย่างเริ่มใช้เครื่องมือ LLM เพื่อช่วยในขั้นตอนแรกของกระบวนการค้นคว้า ขณะที่อีกกลุ่มหนึ่งใช้เครื่องมือพิสูจน์เชิงรูปแบบ (formal proof assistants) ร่วมกับ AI เพื่อเพิ่มความถูกต้อง

อย่างไรก็ดี มีความกังวลที่ไม่อาจมองข้ามได้ ทั้งในมิติของ ความน่าเชื่อถือ ความโปร่งใส และ reproducibility ผลลัพธ์จากโมเดลภาษามักเป็นกล่องดำ (black box) ที่อาจสร้างคำตอบที่ดูสมเหตุสมผลแต่ผิดพลาดได้ (hallucination) เมื่อการพิสูจน์หรือการคาดการณ์ถูกเผยแพร่โดยอาศัยผลลัพธ์จาก AI โดยไม่มีการตรวจสอบเชิงรูปแบบ อาจนำไปสู่การเผยแพร่ทฤษฎีที่ไม่ถูกต้องหรือการสกัดบทสรุปที่ลวง ทั้งนี้ reproducibility ยังถูกท้าทายเมื่อรุ่นของโมเดล ข้อมูลฝึก และพารามิเตอร์ต่าง ๆ ไม่ได้รับการบันทึกหรือเผยแพร่ ทำให้ผู้อื่นไม่สามารถทำซ้ำผลลัพธ์ได้

เพื่อจัดการกับความเสี่ยงข้างต้น จำเป็นต้องมีกลไกนโยบายและแนวทางปฏิบัติที่ชัดเจนดังนี้

- การเปิดเผยการใช้ AI: กำหนดให้ผู้เขียนงานวิจัยและผู้เผยแพร่ประกาศอย่างชัดเจนว่ามีการใช้เครื่องมือ AI ในการค้นคว้า/เขียน/พิสูจน์ พร้อมรายละเอียดของเวอร์ชันและการตั้งค่าที่ใช้ เพื่อเพิ่มความโปร่งใสและอำนวยความสะดวกในการตรวจสอบซ้ำ

- การเก็บข้อมูลและ artefacts เพื่อ reproducibility: สนับสนุนการเก็บและเผยแพร่ชุดข้อมูลกลาง สคริปต์กระบวนการ และผลลัพธ์ระหว่างทาง (intermediate artifacts) ตลอดจนการบันทึก seed, เวอร์ชันโมเดล และพารามิเตอร์ เพื่อให้ผู้อื่นสามารถทำซ้ำการทดลองและการพิสูจน์ได้

- การรวม formal verification ใน workflow: แนะนำให้ใช้เครื่องมือพิสูจน์เชิงรูปแบบ (เช่น Coq, Lean) ควบคู่กับการใช้ AI ในการสร้างร่างพยานหลักฐาน โดยให้มนุษย์หรือระบบตรวจสอบเชิงรูปแบบยืนยันความถูกต้องของผลลัพธ์ก่อนเผยแพร่

- มาตรฐานการประเมินคุณภาพสำหรับผลงานที่มีส่วนช่วยจาก AI: พัฒนาเมตริกและเกณฑ์การประเมินเฉพาะสำหรับงานที่อาศัย AI เช่น ความสมบูรณ์ของพยานหลักฐาน ระดับการพึ่งพา AI และการยอมรับจากชุมชนผู้เชี่ยวชาญ

- การฝึกอบรมและการเข้าถึงเทคโนโลยีอย่างเสมอภาค: จัดโปรแกรมฝึกอบรมให้กับนักวิจัยและผู้ปฏิบัติงาน เพื่อให้สามารถประเมินผลลัพธ์จาก AI ได้อย่างมีวิจารณญาณ พร้อมสนับสนุนการเข้าถึงเครื่องมืออย่างเท่าเทียมเพื่อลดความเหลื่อมล้ำในการวิจัย

- การกำกับดูแลด้านจริยธรรมและสิทธิ์ทางปัญญา: กำหนดกรอบจริยธรรมสำหรับการให้เครดิต การอ้างอิง และการจัดการสิทธิ์ในกรณีที่ผลลัพธ์เชิงคณิตศาสตร์มีมูลค่าทางวิชาการหรือเชิงพาณิชย์

สรุปได้ว่า การนำ AI มาใช้โดยนักคณิตศาสตร์สมัครเล่นและนักวิจัยทั่วไปเปิดช่องทางใหม่ ๆ ที่มีศักยภาพในการเร่งการค้นพบและลดงานซ้ำด้านคณิตศาสตร์ แต่เพื่อให้เกิดประโยชน์สูงสุดต่อชุมชนวิชาการและภาคอุตสาหกรรม จำเป็นต้องสร้างมาตรฐานการปฏิบัติ ความโปร่งใส และเครื่องมือที่รองรับการตรวจสอบเชิงรูปแบบ เพื่อรักษาความน่าเชื่อถือและความสามารถในการทำซ้ำของผลงานวิจัย

คำวิจารณ์ ข้อจำกัด และอนาคต

คำวิจารณ์จากผู้เชี่ยวชาญและการประเมินเชิงวิพากษ์

แม้ว่าการใช้ปัญญาประดิษฐ์โดยนักคณิตศาสตร์สมัครเล่นจะสร้างความสนใจอย่างกว้างขวาง แต่เสียงวิจารณ์จากนักคณิตศาสตร์และนักวิจัยด้าน AI ก็เตือนให้ระมัดระวังในหลายประเด็นสำคัญ ผู้เชี่ยวชาญหลายคนชี้ว่า ผลลัพธ์ที่ได้จากโมเดลภาษาใหญ่ (LLMs) มักมีลักษณะเป็น heuristic หรือคำอธิบายเชิงคณิตศาสตร์ที่ดูน่าเชื่อแต่ยังขาดความเข้มงวดเชิงตรรกะ นักคณิตศาสตร์อาวุโสบันทึกว่าบทพิสูจน์ที่เสนอโดย AI มักมีช่องโหว่ เช่น การอ้างอิงสมมติฐานโดยไม่ได้ตรวจสอบเงื่อนไขขอบเขต หรือการกระโดดข้ามขั้นตอนสำคัญที่ต้องมีการพิสูจน์อย่างเป็นทางการ

นักวิจัยด้าน AI เองก็เตือนเรื่องความเชื่อมโยงระหว่างความสามารถในการสร้างภาษาและความสามารถในการให้เหตุผลเชิงสัญลักษณ์: แม้โมเดลจะสามารถสังเคราะห์ข้อความที่สมเหตุสมผลได้ดี แต่การแปลงข้อความเหล่านั้นให้เป็นกระบวนการพิสูจน์ที่ยืนยันได้ทางคณิตศาสตร์ยังเป็นปัญหาเชิงเทคนิคที่ไม่ได้รับการแก้ไขอย่างสมบูรณ์

ข้อจำกัดทางเทคนิคที่เด่นชัด

มีข้อจำกัดเชิงเทคนิคหลายประการที่ต้องถูกจัดการก่อนที่การใช้ AI ในการพิสูจน์ปัญหาคณิตศาสตร์ระดับสูงจะเป็นที่ยอมรับในวงกว้าง:

- Scalability: การขยายผลจากปัญหาขนาดเล็กไปสู่ทฤษฎีเชิงโครงสร้างที่ซับซ้อนยังจำกัด โมเดลที่ทำงานได้ดีกับตัวอย่างสั้น ๆ มักประสบปัญหาเมื่อเจอกรอบปัญหา (framework) ขนาดใหญ่หรือทฤษฎีที่ต้องการการนำกลับมาใช้ซ้ำของเลมม่าอย่างเป็นระบบ

- Interpretability: การที่โมเดลให้คำอธิบายยาว ๆ ไม่ได้หมายความว่าแต่ละขั้นตอนสามารถตรวจสอบหรือเข้าใจโดยมนุษย์ได้ง่าย นักคณิตศาสตร์ต้องการความชัดเจนของเหตุผลและความโปร่งใสของการอนุมาน แต่โมเดลเชิงสถิติยังขาดการแสดงเหตุผลในรูปแบบที่ตรวจสอบได้

- Verification: การยืนยันความถูกต้องของบทพิสูจน์ที่สร้างจาก AI จำเป็นต้องมีเครื่องมือพิสูจน์แบบเป็นทางการ (formal proof assistants) และกระบวนการแปลงข้อความเชิงภาษาไปสู่รูปแบบที่ตรวจสอบโดยเครื่องได้ ซึ่งยังเป็นช่องว่างที่สำคัญ

กรณีศึกษาที่ล้มเหลวและความเสี่ยงเชิงจริยธรรม/วิธีวิทยา

มีกรณีที่ชุมชนตรวจพบข้อผิดพลาดในบทพิสูจน์ที่อ้างว่า "ถูกค้นพบ" โดยใช้ AI: บางกรณีเป็นการอ้างเหตุผลแบบอ้างอิงไขว้ หรือการยอมรับสมมติฐานเสริมโดยไม่ชี้แจง ผลลัพธ์เช่นนี้นำมาซึ่งความเสี่ยงด้านวิธีวิทยา—หากนักวิจัยหรือผู้ปฏิบัติงานพึ่งพาผลลัพธ์ของ AI โดยไม่ดำเนินการตรวจสอบอย่างเป็นระบบ อาจเกิดความเข้าใจผิดและการเผยแพร่ความรู้ที่คลาดเคลื่อนได้

ด้านจริยธรรมและนโยบาย ยังมีข้อกังวลเรื่องการให้เครดิตและความรับผิดชอบ: หาก AI มีส่วนในการสังเคราะห์บทพิสูจน์ ควรนิยามผู้เขียนหรือผู้รับผิดชอบผลงานอย่างไร นอกจากนี้ความเป็นไปได้ของการโจมตีแบบ adversarial หรือการป้อนข้อมูลเบี่ยงเบน (data poisoning) อาจทำให้ระบบให้ผลลัพธ์ที่บิดเบือนด้วยเจตนา ซึ่งมีความเสี่ยงต่อความน่าเชื่อถือของงานวิชาการ

แนวทางการพัฒนาต่อไป: งานวิจัยที่ควรทำและนโยบายสนับสนุน

เพื่อรับมือกับคำวิจารณ์และข้อจำกัดที่กล่าวมา ควรมีการลงทุนทั้งในงานวิจัยเชิงพื้นฐานและการพัฒนาโครงสร้างพื้นฐานทางนโยบาย ดังนี้:

- ผสาน symbolic reasoning และ neural methods: ส่งเสริมงานวิจัยด้าน neural-symbolic hybrids ที่เชื่อมโมเดลภาษากับตัวพิสูจน์เชิงสัญลักษณ์ (e.g., integration กับ Lean, Coq) เพื่อให้การเสนอแนวคิดสามารถถูกแปลงเป็นบทพิสูจน์ที่ตรวจสอบได้

- พัฒนาเครื่องมือ formal verification ที่ใช้งานง่าย: สนับสนุนการสร้าง pipeline อัตโนมัติสำหรับแปลงข้อเสนอจาก LLM เป็นโค้ดใน proof assistants พร้อมกับมาตรฐานการตรวจสอบที่โปร่งใส

- มาตรฐานการรายงานและ benchmark: จัดตั้งชุดข้อมูลมาตรฐานและ benchmark สำหรับการประเมินคุณภาพบทพิสูจน์ของ AI รวมถึงขั้นตอนในการรายงานความไม่แน่นอนและข้อจำกัดของผลลัพธ์

- สร้าง ecosystem สำหรับการร่วมมือมนุษย์–เครื่อง: สนับสนุนแพลตฟอร์มที่เอื้อต่อการทำงานร่วมกัน เช่น ระบบ human-in-the-loop, กลไก peer review แบบใหม่ และแรงจูงใจสำหรับการเผยแพร่ผลลัพธ์เชิงลบหรือการตรวจสอบซ้ำ

- นโยบายสนับสนุนและการกำกับดูแล: รัฐและสถาบันวิจัยควรให้ทุนและกำหนดแนวปฏิบัติด้านจริยธรรม การอ้างแหล่งที่มา และความรับผิดชอบทางวิชาการ รวมถึงการส่งเสริมการศึกษาในทักษะการตรวจสอบบทพิสูจน์เชิง formal สำหรับนักคณิตศาสตร์รุ่นใหม่

สรุปแล้ว การที่นักคณิตศาสตร์สมัครเล่นสามารถใช้ AI ในการสำรวจปัญหาที่ยืดเยื้อมานั้นเป็นก้าวสำคัญ แต่ก้าวต่อไปต้องมาพร้อมกับกรอบการตรวจสอบที่เข้มแข็ง การพัฒนาเทคโนโลยีเชิงสัญลักษณ์และเครื่องมือพิสูจน์อย่างเป็นทางการ และนโยบายสนับสนุนที่สร้างสมดุลระหว่างนวัตกรรมกับความน่าเชื่อถือทางวิชาการ เพื่อให้ผลลัพธ์ที่ได้ไม่เพียงแต่แปลกใหม่แต่ยังคงความถูกต้องและยืนยงในระยะยาว

บทสรุป

เหตุการณ์ที่นักคณิตศาสตร์สมัครเล่นใช้ปัญญาประดิษฐ์ช่วยแก้ปริศนาคณิตศาสตร์ที่ยืดเยื้อมาชี้ให้เห็นว่า AI มีศักยภาพในการเร่งกระบวนการค้นพบเชิงทฤษฎี โดยสามารถช่วยสร้างแนวคิดใหม่ๆ ตรวจสอบข้อสันนิษฐาน และลดเวลาที่ต้องใช้ในงานคำนวณหรือการสำรวจเชิงตัวอย่าง เครื่องมือที่เกี่ยวข้องได้แก่ โมเดลภาษาขนาดใหญ่ (LLMs), ระบบพิสูจน์เชิงสัญลักษณ์, และซอฟต์แวร์คณิตศาสตร์เชิงคอมพิวเตอร์ การนำเครื่องมือเหล่านี้มาใช้แม้ในมือของนักวิจัยนอกสถาบันชั้นนำก็สามารถให้ผลลัพธ์ที่มีสาระสำคัญได้ แต่สิ่งที่ชัดเจนคือ การยืนยันและการตรวจสอบอย่างเข้มงวดยังคงจำเป็น — ตั้งแต่การพิสูจน์เชิงตรรกะแบบเป็นทางการ การทำให้ผลลัพธ์ทำซ้ำได้ ไปจนถึงการเปิดเผยแหล่งที่มา (provenance) ของคำตอบเพื่อป้องกันข้อผิดพลาดหรือการตีความผิดพลาดของโมเดล

เหตุการณ์นี้อาจเป็นจุดเปลี่ยนที่ทำให้ชุมชนวิจัยทั้งด้านคณิตศาสตร์และ AI ปรับวิธีการทำงานร่วมกัน: เปิดโอกาสสำหรับความร่วมมือที่กว้างขึ้น การพัฒนาเครื่องมือตรวจสอบอัตโนมัติ และการตั้งมาตรฐานใหม่ด้านความน่าเชื่อถือและความโปร่งใส แต่พร้อมกันนั้นก็ยกคำถามใหม่ด้านนโยบายและการศึกษา เช่น การปรับหลักสูตรเพื่อสอนการใช้และการประเมิน AI ในงานวิจัย การออกข้อกำหนดสาธารณะสำหรับการรายงานการใช้ AI ในบทความวิชาการ และการกำหนดแนวทางจริยธรรมในการยอมรับผลงานที่มีส่วนสร้างจาก AI ในอนาคต มุมมองเชิงยุทธศาสตร์คือการลงทุนในโครงสร้างพื้นฐานสำหรับการตรวจสอบ (verification pipelines), บูรณาการมาตรฐานเปิด และการฝึกอบรมเพื่อให้ทั้งนักคณิตศาสตร์มืออาชีพและสมัครเล่นสามารถใช้ประโยชน์จากเทคโนโลยีได้อย่างมีความรับผิดชอบและเชื่อถือได้

📰 แหล่งอ้างอิง: New Scientist