ในยุคที่ปัญญาประดิษฐ์ (AI) ถูกผลักดันให้เป็นเครื่องมือสำคัญในการบริหารจัดการพรมแดนและการคัดกรองผู้อพยพ หน่วยงานตรวจคนเข้าเมืองหลายแห่งเร่งนำระบบอัตโนมัติและโมเดลวิเคราะห์ข้อมูลมาใช้เพื่อเพิ่มความรวดเร็วและประสิทธิภาพ แต่สิ่งที่ตามมาคือการส่งเจ้าหน้าที่ออกปฏิบัติภารกิจโดยอาศัยเครื่องมือเหล่านี้โดยไร้การฝึกอบรมที่เพียงพอ — สถานการณ์ที่อาจนำไปสู่การตัดสินใจผิดพลาด การละเมิดสิทธิ และความเสี่ยงด้านความปลอดภัยทั้งต่อเจ้าหน้าที่และประชาชน ยิ่งกว่านั้น ปัญหาดังกล่าวยังสะท้อนปัญหาเชิงโครงสร้าง เช่น การจัดซื้อเทคโนโลยีอย่างเร่งรีบ การพึ่งพาผู้ขายภายนอก และช่องว่างด้านทักษะดิจิทัลภายในองค์กร

บทความนี้จะวิเคราะห์สาเหตุที่ทำให้เกิดปรากฏการณ์ดังกล่าว รวมทั้งชวนพิจารณาผลกระทบเชิงปฏิบัติและเชิงกฎหมายผ่านกรณีศึกษาที่เกิดขึ้นจริง ตลอดจนเสนอแนวทางแก้ไขเชิงนโยบายและมาตรการปฏิบัติการ เช่น การกำกับดูแลอัลกอริธึม การฝึกอบรมมาตรฐาน การออกแบบระบบแบบ human-in-the-loop และการประเมินความเสี่ยงเชิงนโยบาย เพื่อป้องกันไม่ให้การนำ AI มาใช้กลายเป็นข้ออ้างในการลดมาตรฐานการฝึกอบรมของเจ้าหน้าที่ และเพื่อให้การใช้เทคโนโลยีเป็นไปอย่างปลอดภัย โปร่งใส และมีความรับผิดชอบต่อสาธารณะ

สรุปภาพรวม (Lead)

สรุปภาพรวม (Lead)

ขณะที่หน่วยงานตรวจคนเข้าเมืองทั่วโลกหันมาใช้เครื่องมือปัญญาประดิษฐ์เพื่อเพิ่มประสิทธิภาพการคัดกรองและตัดสินใจเชิงปฏิบัติการ รายงานล่าสุดชี้ว่ามีกรณีที่ เจ้าหน้าที่ถูกส่งออกปฏิบัติหน้าที่โดยขาดการฝึกอบรมที่เพียงพอ เนื่องจากการพึ่งพาการประเมินหรือคำแนะนำที่มาจากระบบอัตโนมัติ การขึ้นรูปของระบบ AI ในกระบวนการตัดสินใจนี้ไม่ได้เป็นเพียงการสนับสนุนเชิงข้อมูลเท่านั้น แต่ยังเปลี่ยนรูปแบบการบริหารจัดการกำลังพลและความเสี่ยงภาคสนามอย่างมีนัยสำคัญ

ปัญหาที่ถูกเน้นในบทความนี้คือความเชื่อมโยงระหว่าง ผลลัพธ์ที่ระบบ AI ให้มา กับการตัดสินใจเชิงปฏิบัติการ เช่น การคัดเลือกบุคลากรสำหรับการลาดตระเวน การกำหนดระดับความเสี่ยงของกรณี หรือการให้คำสั่งให้ลงพื้นที่ ซึ่งในหลายกรณีระบบเหล่านี้ทำหน้าที่เป็นตัวชี้นำหลัก ทำให้กระบวนการตรวจสอบโดยมนุษย์เกิดความไม่แน่นอนหรือถูกละเลย ส่งผลให้เจ้าหน้าที่บางคนไปปฏิบัติหน้าที่โดยไม่ได้รับการอบรมหรือเตรียมความพร้อมเพียงพอสำหรับสถานการณ์จริง

เหตุผลที่ผู้อ่าน—โดยเฉพาะผู้บริหารหน่วยงาน ภาคธุรกิจ และผู้กำหนดนโยบาย—ควรให้ความสนใจ คือความเสี่ยงต่อชีวิตของเจ้าหน้าที่และประชาชน สิทธิมนุษยชนที่อาจถูกละเมิดเมื่อการตัดสินใจถูกทำโดยระบบที่ขาดความโปร่งใส และผลทางกฎหมายและชื่อเสียงที่อาจเกิดขึ้นเมื่อการปฏิบัติการล้มเหลว นอกจากนี้ยังมีความเสี่ยงด้านประสิทธิภาพและต้นทุนเมื่อต้องแก้ปัญหาที่เกิดจากการตัดสินใจที่ไม่ได้คำนึงถึงบริบทหน้างานอย่างเพียงพอ

บทความฉบับเต็มจะนำเสนอภาพรวมของหลักฐานที่เผยแพร่ รายงานกรณีตัวอย่าง ความเห็นจากผู้เชี่ยวชาญ และข้อเสนอเชิงนโยบายเพื่อปรับปรุงการฝึกอบรม ความรับผิดชอบ และความโปร่งใสของระบบ AI โดยภาพรวมจะครอบคลุมหัวข้อสำคัญดังต่อไปนี้

- หลักฐานและกรณีตัวอย่าง: การรายงานเหตุการณ์จริงและลักษณะข้อบกพร่องของการฝึกอบรม

- การทำงานของระบบ AI: วิธีที่โมเดลและระบบอัตโนมัติกำหนดคำแนะนำเชิงปฏิบัติการ

- ความเสี่ยงเชิงปฏิบัติและกฎหมาย: ผลกระทบต่อชีวิต สิทธิมนุษยชน และความรับผิดชอบของหน่วยงาน

- แนวทางแก้ไข: มาตรการฝึกอบรม ระบบตรวจสอบ และหลักการความโปร่งใสที่ควรนำไปใช้

พื้นหลัง: เครื่องมือ AI ที่ใช้ในหน่วยงานตรวจคนเข้าเมือง

หน่วยงานตรวจคนเข้าเมืองในหลายประเทศนำระบบอัตโนมัติที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ (AI) มาใช้เพื่อเพิ่มความรวดเร็วและประสิทธิภาพในการคัดกรอง การจัดลำดับคดี และการตัดสินใจเชิงปฏิบัติการ เครื่องมือเหล่านี้มีตั้งแต่ระบบกฎ (rule-based) แบบดั้งเดิม ไปจนถึงโมเดลการเรียนรู้ของเครื่อง (machine learning), การประมวลผลภาพ (computer vision) สำหรับการรู้จำใบหน้า และระบบให้คะแนนความเสี่ยง (risk scoring) ที่รวมข้อมูลหลายมิติ ตัวอย่างการใช้งานได้แก่ ระบบจับคู่บุคคลกับรายชื่อเฝ้าระวัง (watchlists), การจัดลำดับคดีขอลี้ภัยตามความเร่งด่วน และการพยากรณ์ความเสี่ยงที่จะเกิดเหตุซ้ำหรือหลบหนีเพื่อตัดสินใจเรื่องการกักตัวหรือประกันตัว

ประเภทของระบบ AI ที่พบบ่อย

- Rule-based systems — ระบบที่ทำงานตามกฎเงื่อนไขที่กำหนดไว้ล่วงหน้า เช่น หากพบชื่อ/หมายเลขหนังสือเดินทางตรงกับรายชื่อ จะทำเครื่องหมายเป็น "ต้องตรวจสอบเพิ่มเติม" เหมาะกับงานที่มีตรรกะชัดเจน แต่จำกัดเมื่อต้องจัดการความไม่แน่นอน

- Machine learning models — โมเดลที่เรียนรู้จากข้อมูลอดีตเพื่อทำนายผลลัพธ์ เช่น การคัดกรองเอกสารหรือการคาดการณ์โอกาสหลบหนี โมเดลเหล่านี้สามารถจับรูปแบบที่ซับซ้อน แต่ต้องการชุดข้อมูลฝึกขนาดใหญ่และมีคุณภาพ

- Computer vision / Facial recognition — ใช้ในจุดผ่านแดนและการตรวจสอบตัวตน เพื่อจับคู่ภาพถ่ายกับฐานข้อมูล รูปแบบนี้เพิ่มความรวดเร็วในการยืนยันบุคคลแต่มีประเด็นเรื่องความแม่นยำตามกลุ่มคนและมุมกล้อง

- Risk scoring systems — ให้คะแนนความเสี่ยงโดยรวมจากตัวแปรหลายมิติ (ประวัติการเดินทาง, ข้อมูลอาชีพ, ประวัติอาชญากรรม) คะแนนนี้มักใช้เป็นตัวชี้นำการจัดลำดับคดีหรือการตัดสินใจเชิงปฏิบัติการ

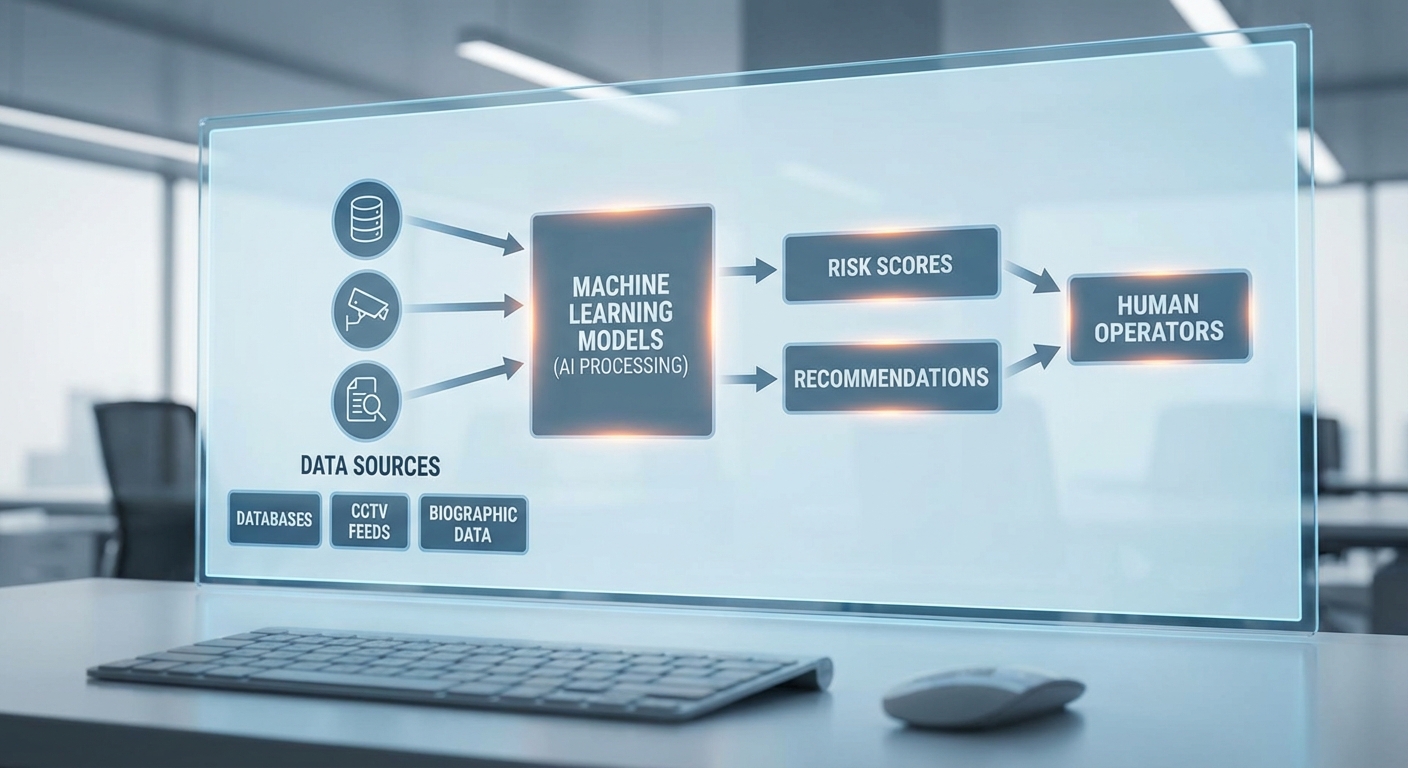

แผนผังการไหลของข้อมูลและจุดที่ AI ให้คำแนะนำ

กระบวนการทั่วไปในการใช้งานเครื่องมือ AI ภายในหน่วยงานตรวจคนเข้าเมืองสามารถอธิบายเป็นลำดับขั้นตอนหลักดังนี้:

- Data input: การรับข้อมูลจากแหล่งต่าง ๆ เช่น แบบฟอร์มคำร้อง, ภาพถ่าย, ข้อมูลเดินทาง, ฐานข้อมูลภายในและภายนอก

- Preprocessing: การทำความสะอาดข้อมูล, การจับคู่ฟีเจอร์, การเข้ารหัสข้อมูลที่จำเป็น เพื่อเตรียมข้อมูลให้พร้อมต่อการประมวลผล

- Model inference: โมเดล AI ประมวลผลและให้ผลลัพธ์ — ตัวอย่างเช่น การจับคู่ใบหน้า, การคาดการณ์ความเสี่ยง หรือการจัดลำดับความสำคัญของคดี

- Recommendation: ระบบส่งคำแนะนำหรือคะแนนไปยังผู้ปฏิบัติงาน เช่น "คดีนี้จัดเป็นความเสี่ยงสูง — แนะนำการกักตัวชั่วคราว" หรือ "บุคคลนี้ต้องตรวจสอบเอกสารเพิ่มเติม"

- Operational decision: ผู้ปฏิบัติงานมนุษย์เป็นผู้ตัดสินใจขั้นสุดท้ายโดยพิจารณาข้อมูลเสริมและบริบททางกฎหมาย

ในหลายระบบ จุดที่ AI ให้คำแนะนำเกิดขึ้นระหว่างขั้นตอน Model inference และ Recommendation — แต่การนำคำแนะนำไปใช้จริงมักขึ้นกับผู้ปฏิบัติงานซึ่งอาจยอมรับ/ปรับ/หักล้างคำแนะนำเหล่านั้น

ปัญหาและความเสี่ยงที่มักเกิดขึ้น

แม้ AI จะเพิ่มความเร็วและความสม่ำเสมอ แต่ปัญหาที่เกิดขึ้นบ่อยคือ:

- ข้อมูลฝึกที่มีอคติ (biased training data) — หากชุดข้อมูลอดีตมีอคติ ระบบจะเรียนรู้และขยายอคตินั้น เช่น การถูกลงโทษหรือการจับตามองกลุ่มบุคคลบางกลุ่มมากกว่าปกติ งานวิจัยหลายฉบับและการประเมินโดยหน่วยงานอิสระพบความไม่เป็นธรรมในระบบจำแนกตัวบุคคลและการให้คะแนนความเสี่ยง

- ขาดการอธิบายเหตุผล (black box) — โมเดลที่ซับซ้อนมักให้ผลลัพธ์โดยไม่สามารถอธิบายได้ชัดเจนว่าทำไมจึงได้คำแนะนำเช่นนั้น สิ่งนี้เป็นปัญหาเชิงกฎหมายและเชิงจริยธรรมเมื่อต้องอธิบายการตัดสินใจต่อผู้ได้รับผลกระทบ

- การตั้งค่า threshold ที่ไม่ชัดเจน — ค่าเกณฑ์ (threshold) สำหรับการจัดประเภทหรือการเตือน เช่น กำหนดคะแนนความเสี่ยงที่ต้องดำเนินการ หากไม่ได้กำหนดหลักเกณฑ์เชิงนโยบายและบริบทอย่างชัดเจน จะเกิดความไม่สอดคล้องในการปฏิบัติงาน

- ความเสี่ยงเชิงปฏิบัติการและการฝึกอบรม — ผู้ปฏิบัติงานที่ได้รับคำแนะนำจาก AI โดยไม่มีการฝึกอบรมเพียงพออาจตีความผลลัพธ์ผิดพลาดหรือพึ่งพา AI มากเกินไป ส่งผลให้เกิดการตัดสินใจที่มีผลกระทบร้ายแรง

สรุปได้ว่า การนำเครื่องมือ AI มาใช้ในหน่วยงานตรวจคนเข้าเมืองเป็นกระบวนการที่มีศักยภาพในการเพิ่มประสิทธิภาพ แต่ต้องมีการออกแบบระบบที่โปร่งใส การกำกับดูแลเรื่องคุณภาพข้อมูล การกำหนดค่าเกณฑ์เชิงนโยบาย และการฝึกอบรมบุคลากรอย่างเพียงพอ เพื่อป้องกันผลกระทบเชิงลบต่อสิทธิมนุษยชนและความชอบด้วยกฎหมาย

กรณีตัวอย่างและสถิติที่เกี่ยวข้อง

กรณีตัวอย่างและสถิติที่เกี่ยวข้อง

การตรวจสอบเชิงสืบสวนโดย NGO และการสอบสวนภายในหน่วยงานชี้ให้เห็นรูปแบบซ้ำซ้อนของการส่งเจ้าหน้าที่ออกปฏิบัติภารกิจโดยที่ยังไม่ได้รับการฝึกอบรมที่เพียงพอต่อการใช้เครื่องมือ AI และเวิร์กโฟลว์ใหม่ ตัวอย่างที่สรุปได้จากเอกสารสาธารณะและรายงานที่ไม่เปิดเผยชื่อมีทั้งกรณีที่นำไปสู่การจับกุมผิดตัว การใช้กำลังเกินความจำเป็น และการร้องเรียนทางวินัยของพลเรือน ซึ่งสะท้อนขนาดของปัญหาในหลายภูมิภาค

-

กรณีที่ 1 — หน่วยงานตรวจคนเข้าเมืองในประเทศ A (anonymized), 2021–2022:

หลังติดตั้งระบบคัดกรองและจัดลำดับความเสี่ยงด้วย AI หน่วยงานได้ส่งทีม "Rapid Response" เพื่อตรวจสอบผู้ที่ระบบชี้เป็นกลุ่มเสี่ยงหลายร้อยกรณีโดยไม่มีการฝึกอบรมการตีความผลลัพธ์ของโมเดลให้เจ้าหน้าที่รายใหม่ รายงานการตรวจสอบภายในระบุว่า ประมาณ 37% ของการเรียกออกปฏิบัติการในช่วง 12 เดือนแรกเกิดขึ้นกับเจ้าหน้าที่ที่ยังไม่ผ่านการฝึกอบรมเฉพาะด้าน ผลลัพธ์รวมถึงการควบคุมตัวที่ตามมาซึ่งใน 12 กรณีถูกระบุว่าเป็นการจับกุมผิดเป้าหมายและ 4 กรณีนำไปสู่การบาดเจ็บร่างกายที่ต้องเข้ารับการรักษา

-

กรณีที่ 2 — เคสการใช้เทคโนโลยีจดจำใบหน้าเชื่อมกับการตัดสินใจภาคสนามในประเทศ B, 2019–2020:

สำนักข่าวและรายงานจากองค์กรสิทธิมนุษยชนรายงานการนำผลจากระบบจดจำใบหน้ามาใช้เป็นเหตุผลเร่งด่วนในการส่งเจ้าหน้าที่ตรวจสอบโดยไม่ได้มีขั้นตอนยืนยันข้อมูลสมัครเข้า ผลการติดตามของ NGOs ระบุว่าในช่วง 6 เดือนแรกหลังการติดตั้ง เกิดเหตุการณ์การระบุผิดว่าเป็นบุคคลต้องสงสัยอย่างน้อย 12 ครั้ง และมีการยื่นเรื่องร้องเรียนต่อหน่วยงานรวมกันไม่ต่ำกว่า 68 เรื่อง โดยคำร้องเรียนส่วนหนึ่งระบุถึงการปฏิบัติที่ใช้กำลังที่ไม่สอดคล้องกับความเสี่ยงจริง

-

กรณีที่ 3 — หน่วยงานพรมแดนในภูมิภาค C (anonymized), รายงาน NGO ร่วม, 2020–2023:

องค์กรระหว่างประเทศและ NGO ด้านสิทธิมนุษยชนได้รวบรวมเบาะแสจากผู้ถูกปฏิบัติและพยาน สนับสนุนด้วยข้อมูลการร้องเรียนของสาธารณะ พบแนวโน้มว่า อัตราการร้องเรียนเกี่ยวกับการใช้กำลังและการละเมิดขั้นตอนเพิ่มขึ้นระหว่าง 20% ถึง 50% หลังการนำระบบ AI เข้ามาช่วยจัดลำดับงาน รายงานระบุเหตุการณ์ที่มีผลลัพธ์ไม่พึงประสงค์ เช่น การกักขังชั่วคราวโดยไม่มีเอกสารประกอบเหตุผลเพียงพอ และความล่าช้าในการเข้าถึงแนวทางเยียวยาสำหรับผู้ได้รับผลกระทบ

สถิติที่สะท้อนแนวโน้มจากแหล่งต่างๆ แสดงให้เห็นองค์ประกอบสำคัญสองประการ: ก่อนอื่นคือความถี่ของเหตุการณ์ไม่พึงประสงค์และการร้องเรียนที่เพิ่มขึ้นในช่วงระยะเวลาหลังการใช้งานระบบ AI ใหม่ และประการที่สองคือความเชื่อมโยงระหว่างการขาดการฝึกอบรมเชิงปฏิบัติการกับผลลัพธ์ที่เป็นอันตราย ตัวอย่างเช่น รายงานการตรวจสอบภายในที่ไม่เปิดเผยชื่อระบุการเพิ่มขึ้นของเรื่องร้องเรียนด้านการปฏิบัติหน้าที่ของเจ้าหน้าที่ 23–40% ในไตรมาสแรกหลังปรับใช้ระบบ ในขณะที่การวิเคราะห์ของ NGO หลายแห่งชี้ว่ากรณีการระบุผิดและการใช้กำลังเกินความจำเป็นมักเกี่ยวพันกับการพึ่งพาผลลัพธ์ของโมเดลโดยตรงโดยไม่ผ่านการตรวจสอบจากมนุษย์อย่างเพียงพอ

ข้อสังเกตจากรายงานอิสระ (เช่น งานวิจัยที่มาจากสถาบันวิชาการ รายงาน NGO ระหว่างประเทศ และการสืบสวนของสื่อมวลชน) ให้การยืนยันแนวโน้มเดียวกันว่าการนำ AI เข้ามาโดยไม่มีกรอบการฝึกอบรม การกำกับดูแล และมาตรการประเมินความเสี่ยงที่ชัดเจน จะเพิ่มความเสี่ยงต่อการละเมิดสิทธิและผลลัพธ์ทางลบต่อพลเรือน รายงานเหล่านี้ยังเรียกร้องให้มีการบันทึกเหตุการณ์อย่างเป็นระบบ การติดตามตัวชี้วัดเชิงผลลัพธ์ (เช่น จำนวนการระบุผิด อัตราการร้องเรียน ความถี่ของการใช้กำลัง) และการตรวจสอบอิสระเพื่อลดความเสี่ยงจากการนำระบบอัตโนมัติมาใช้ในงานบังคับใช้กฎหมายชายแดน

ช่องว่างด้านการฝึกอบรมและปัจจัยมนุษย์ (Human Factors)

ช่องว่างด้านการฝึกอบรมและปัจจัยมนุษย์ (Human Factors)

การใช้งานเครื่องมือปัญญาประดิษฐ์ในหน่วยงานตรวจคนเข้าเมืองมักถูกผลักดันด้วยความเร่งด่วนด้านการจัดซื้อและการนำเทคโนโลยีมาใช้จริง (procurement pressure) ส่งผลให้แผนการฝึกอบรมระยะยาวถูกละเลยหรือถูกบีบให้สั้นลงเป็นการชั่วคราว ในหลายกรณี งบประมาณที่จัดสรรเน้นไปที่ค่าซอฟต์แวร์และฮาร์ดแวร์ โดยไม่รวมค่าใช้จ่ายที่จำเป็นสำหรับการฝึกซ้อม การพัฒนาเนื้อหาฝึกอบรม หรือการประเมินผลอย่างต่อเนื่อง ผลลัพธ์คือเจ้าหน้าที่จำนวนมากได้รับการอบรมแบบพื้นฐานหรือเพียงการสอนการใช้งานฟังก์ชันเทคนิคเท่านั้น แทนที่จะได้รับการฝึกเพื่อทำงานร่วมกับระบบอัตโนมัติอย่างปลอดภัยและมีประสิทธิภาพ

ปัจจัยด้านมนุษย์เป็นหัวใจของปัญหา: automation bias — หรือความโน้มเอียงที่จะยอมรับผลลัพธ์จากระบบอัตโนมัติโดยไม่ตรวจสอบ — เกิดขึ้นบ่อยเมื่อผู้ปฏิบัติงานไม่มีความเข้าใจลึกซึ้งเกี่ยวกับขอบเขตและข้อจำกัดของโมเดล AI งานวิจัยในโดเมนที่คล้ายกันรายงานว่า 50–70% ของผู้ใช้มีแนวโน้มยอมรับคำแนะนำจากระบบอัตโนมัติแม้จะมีข้อมูลซ้อนทับที่ขัดแย้ง การออกแบบอินเทอร์เฟซที่ไม่ชัดเจน (poor interface) และข้อมูลแสดงผลที่ซับซ้อนยิ่งเสริมให้เกิดความสับสนและการตีความผลที่ผิดพลาด นอกจากนี้ภาระงานสูงและปริมาณข้อมูลที่ต้องประมวลผล (overload) ทำให้ผู้ปฏิบัติงานอาศัยสัญชาตญาณหรือคำแนะนำจากระบบเป็นทางลัด ซึ่งเพิ่มความเสี่ยงของการตัดสินใจผิดพลาดในสถานการณ์วิกฤต

ผลทางพฤติกรรมจากช่องว่างการฝึกอบรมยังรวมถึงการเสื่อมทักษะ (de-skilling) ของบุคลากร เมื่อหน้าที่บางส่วนถูกย้ายไปให้ระบบอัตโนมัติทำแทนอย่างต่อเนื่อง เจ้าหน้าที่อาจสูญเสียความสามารถในการตัดสินใจเชิงวิจารณ์ การตรวจสอบข้าม และการประเมินความเสี่ยงด้วยวิธีดั้งเดิม สถานการณ์นี้ยิ่งทวีความรุนแรงหากองค์กรขาดกลไกการประเมินความน่าเชื่อถือของผลลัพธ์ AI และไม่มีมาตรการด้านการควบคุมทางเลือก (fallback procedures) เมื่อระบบส่งสัญญาณผิดพลาด

เพื่อปิดช่องว่างเหล่านี้ ควรออกแบบโปรแกรมฝึกอบรมที่เป็นระบบและวางแผนระยะยาว โดยเน้นการฝึกเชิงสถานการณ์ (scenario-based training) เพื่อจำลองเหตุการณ์จริงและฝึกการตัดสินใจภายใต้ความไม่แน่นอน, การฝึกแบบ human-in-the-loop เพื่อให้เจ้าหน้าที่ได้ฝึกการแทรกแซง การยืนยัน และการประเมินผล AI ในเวลาจริง และการซ้อมขั้นตอนการยกระดับปัญหา (escalation protocols) ที่ชัดเจนเมื่อเกิดข้อกังวลเกี่ยวกับความถูกต้องของระบบ ตัวอย่างองค์ประกอบที่ควรรวมในหลักสูตรฝึกอบรมมีดังนี้:

- Scenario-based training: แบบฝึกหัดที่จำลองกรณีหลากหลายทั้งกรณีปกติและกรณีผิดปกติ รวมถึงการจำลองความผิดพลาดของระบบ เพื่อฝึกการตัดสินใจภายใต้แรงกดดัน

- Human-in-the-loop drills: การซ้อมที่กำหนดให้เจ้าหน้าที่ต้องตรวจสอบและแก้ไขคำแนะนำจาก AI ก่อนอนุมัติการดำเนินการจริง เพื่อรักษาทักษะการตรวจสอบและการตัดสินใจของมนุษย์

- Escalation protocols: แนวทางและช่องทางที่ชัดเจนสำหรับการยกระดับปัญหาไปยังผู้เชี่ยวชาญหรือผู้บริหาร เมื่อผลลัพธ์ของ AI ขัดแย้งกับข้อมูลภาคสนามหรือมีความไม่แน่นอนสูง

- Usability training: การสอนการตีความอินเทอร์เฟซ การเข้าใจเมตริกความเชื่อมั่น (confidence scores) และการรู้จักข้อจำกัดของโมเดล

- Regular audits and red-team exercises: การประเมินอย่างสม่ำเสมอด้วยทีมภายนอกหรือทีมทดสอบเพื่อตรวจหาจุดอ่อนทั้งด้านเทคนิคและการใช้งาน

สุดท้ายองค์กรต้องเปลี่ยนมุมมองการลงทุนจากการซื้อเพียงครั้งเดียวเป็นการลงทุนในความสามารถ (capability investment) ซึ่งรวมถึงงบประมาณสำหรับการฝึกอบรมเชิงลึก การอัปเดตหลักสูตรตามการเปลี่ยนแปลงของเทคโนโลยี และการวัดผลผ่าน KPI เช่น อัตราความคลาดเคลื่อนของการตัดสินใจ อัตราการยกระดับกรณีที่ผิดปกติ และความสามารถในการกู้คืนเมื่อระบบล้มเหลว การดำเนินการเช่นนี้จะช่วยลดผลกระทบจาก automation bias และเพิ่มความปลอดภัยในการตัดสินใจของเจ้าหน้าที่ได้อย่างยั่งยืน

ผลทางกฎหมาย จริยธรรม และความรับผิดชอบ

ภาพรวมเชิงกฎหมายและบริบท

การนำเครื่องมือปัญญาประดิษฐ์ (AI) มาใช้โดยหน่วยงานตรวจคนเข้าเมืองเพื่อแนะนำการส่งเจ้าหน้าที่ลงปฏิบัติการ โดยเฉพาะเมื่อไม่มีการฝึกอบรมผู้ปฏิบัติงานและไม่มีการทดสอบความถูกต้องของระบบอย่างเพียงพอ ย่อมก่อให้เกิดความเสี่ยงทั้งทางกฎหมายและจริยธรรมในหลายมิติ ทั้งสิทธิของผู้ถูกตรวจสอบ สิทธิขั้นพื้นฐานตามกระบวนการยุติธรรม และความรับผิดชอบของรัฐและเอกชนที่เกี่ยวข้อง เหตุการณ์ลักษณะนี้สามารถนำไปสู่การละเมิดสิทธิส่วนบุคคล การตัดสินใจที่ไม่เป็นธรรม และการใช้กำลังที่ไม่จำเป็นหรือละเมิดข้อกฎหมายเกี่ยวกับการใช้ความรุนแรง

ประเด็นกฎหมายที่อาจถูกละเมิด

- สิทธิความเป็นส่วนตัว (Privacy) – การประมวลผลข้อมูลส่วนบุคคลของผู้ถูกตรวจสอบโดยไม่มีฐานทางกฎหมายที่ชัดเจนหรือการแจ้งสิทธิ อาจขัดต่อพระราชบัญญัติคุ้มครองข้อมูลส่วนบุคคล (PDPA) ในประเทศไทย, GDPR ในสหภาพยุโรป หรือกฎหมายความเป็นส่วนตัวระดับชาติอื่น ๆ ซึ่งรวมถึงสิทธิในการเข้าถึง แก้ไข และคัดค้านการตัดสินใจที่เกิดขึ้นจากระบบอัตโนมัติ

- กระบวนการยุติธรรม (Due Process) – การตัดสินใจที่มีผลกระทบต่อสิทธิขั้นพื้นฐานของบุคคลโดยอาศัยคำแนะนำจาก AI โดยไม่มีการตรวจสอบจากมนุษย์ อาจละเมิดหลักสิทธิในการได้รับกระบวนการยุติธรรมตามรัฐธรรมนูญหรืออนุสัญญาสากล (เช่น สิทธิตามมาตราที่เกี่ยวข้องใน ICCPR และสิทธิตามกฎหมายภายใน เช่น Due Process Clauses)

- กฎหมายเกี่ยวกับการใช้กำลัง (Use of Force) – หากคำแนะนำของ AI นำไปสู่การใช้กำลังที่ไม่จำเป็นหรือเกินสมควร เจ้าหน้าที่ที่ลงมือกระทำและหน่วยงานที่สั่งการอาจต้องรับผิดทั้งในทางอาญาและทางแพ่งตามกฎหมายอาญา/กฎหมายความรับผิดของรัฐ รวมถึงพันธกรณีระหว่างประเทศเกี่ยวกับการคุ้มครองชีวิตและความปลอดภัยของบุคคล

- ความรับผิดชอบของรัฐและผู้ประกอบการ (State and Corporate Liability) – รัฐอาจมีความรับผิดชอบตามหลักกฎหมายปกครองและสิทธิมนุษยชน หากการจัดหาหรือใช้งานระบบ AI ถูกพิสูจน์ว่าเป็นสาเหตุของการละเมิด สิ่งนี้ยังเชื่อมโยงกับหลักความรับผิดทางแพ่งต่อความประมาทหรือการละเมิดหน้าที่

ตัวอย่างคดีและข้อร้องเรียนที่เกี่ยวข้อง

จากกรณีศึกษาระดับสากล มีตัวอย่างที่เป็นบทเรียนสำคัญ ได้แก่กรณีการวิจัยของ ProPublica (2016) ที่พบว่าเครื่องมือประเมินความเสี่ยงในการกลับมากระทำผิดซ้ำ (COMPAS) มีอคติทางเชื้อชาติ โดยผู้ต้องหาชาวผิวดำถูกจัดให้อยู่ในกลุ่มความเสี่ยงสูงมากกว่าชาวผิวขาวอย่างมีนัยสำคัญ ซึ่งชี้ให้เห็นถึงผลกระทบเชิงโครงสร้างของโมเดลต่อสิทธิในกระบวนการยุติธรรม นอกจากนี้ คดีของเนเธอร์แลนด์กับระบบ SyRI (Systeem Risico Indicatie) ถูกศาลพิจารณาว่าการประมวลผลเพื่อตรวจจับความเสี่ยงด้านสวัสดิการละเมิดสิทธิความเป็นส่วนตัวและขาดฐานทางกฎหมายที่เหมาะสมจนระบบถูกระงับในปี 2020

ในบริบทการบังคับใช้กฎหมายและตรวจคนเข้าเมือง มีรายงานข่าวเชิงสืบสวนและข้อกังวลจากองค์กรสิทธิมนุษยชนเกี่ยวกับการใช้เครื่องมือเชิงพาณิชย์ (เช่น ซอฟต์แวร์วิเคราะห์ข้อมูลขนาดใหญ่) โดยหน่วยงานตรวจคนเข้าเมืองในบางประเทศ ซึ่งองค์กรสิทธิมนุษยชนและนักวิชาการได้ยื่นคำร้องและเรียกร้องให้มีการตรวจสอบความโปร่งใสและผลกระทบต่อสิทธิขั้นพื้นฐาน

ประเด็นจริยธรรม: ความไม่เป็นกลาง ขาดการอธิบายได้ และช่องว่างความรับผิดชอบ

ด้านจริยธรรม ปัญหาหลักที่เกิดขึ้นได้แก่ bias ของชุดข้อมูลและอัลกอริธึมที่ทำให้กลุ่มเปราะบางถูกเลือกปฏิบัติ, lack of explainability หรือความไม่สามารถอธิบายเหตุผลการตัดสินใจของโมเดลได้ ซึ่งเป็นอุปสรรคต่อสิทธิในการทราบเหตุและการชี้แจงในกระบวนการยุติธรรม และ accountability gaps เมื่อไม่มีการระบุความรับผิดชอบที่ชัดเจนระหว่างผู้พัฒนา ผู้จัดซื้อ และผู้ปฏิบัติการ

- Bias: อัลกอริธึมเรียนรู้จากข้อมูลในอดีต ซึ่งอาจสะท้อนความไม่เป็นธรรมทางสังคม ทำให้การคัดกรองหรือการชี้เป้ากลุ่มคนบางกลุ่มมีแนวโน้มถูกรบกวนมากขึ้น

- Explainability: เมื่อคำแนะนำของ AI ไม่สามารถอธิบายได้ในเชิงเหตุผล ผู้ปฏิบัติงานอาจยอมรับคำแนะนำโดยไม่ตั้งคำถาม ซึ่งเป็นปัญหาทั้งเชิงจริยธรรมและทางกฎหมาย เพราะผู้ถูกกระทำอาจไม่สามารถท้าทายการตัดสินใจได้

- Auditability: การขาดบันทึก (logging) และกระบวนการตรวจสอบอิสระทำให้ยากต่อการสืบสวนกรณีละเมิดหรือข้อผิดพลาด และเป็นช่องว่างสำคัญที่ทำให้ผู้เกี่ยวข้องเลี่ยงความรับผิดชอบ

คำถามสำคัญเกี่ยวกับความรับผิดชอบ

เมื่อ AI ให้คำแนะนำที่ผิดพลาดและนำไปสู่การละเมิด ใครควรรับผิดชอบ? คำถามนี้ไม่มีคำตอบเดียวและมักขึ้นกับข้อเท็จจริงเช่น การออกแบบระบบ การทดสอบก่อนใช้งาน ขอบเขตการใช้งานตามข้อกำหนดการจัดซื้อ และการตัดสินใจของผู้ปฏิบัติงาน ตัวเลือกทางกฎหมายที่เป็นไปได้ได้แก่:

- ผู้พัฒนา/ผู้ขาย – อาจรับผิดชอบภายใต้หลักความประมาท ผลิตภัณฑ์บกพร่อง หรือการละเมิดสัญญา หากระบบมีข้อบกพร่องร้ายแรงหรือไม่ได้ให้คำเตือน/ข้อจำกัดที่เหมาะสม

- หน่วยงานรัฐ/ผู้จัดซื้อ – มีหน้าที่ในการประเมินความเสี่ยง เลือกจัดซื้ออย่างรอบคอบ และกำหนดนโยบายการใช้งานที่ปกป้องสิทธิ หากไม่ปฏิบัติตามอาจรับผิดตามกฎหมายปกครองหรือความรับผิดของรัฐ

- ผู้ปฏิบัติงานภาคสนาม – ผู้ที่ลงมือกระทำอาจต้องรับผิดเมื่อมีการใช้ดุลยพินิจส่วนบุคคล โดยเฉพาะเมื่อสามารถท้าทายคำแนะนำของ AI แต่เลือกปฏิบัติตามโดยไม่พิจารณา

- ความรับผิดร่วมกัน – ในหลายกรณี ความรับผิดชอบอาจแบ่งร่วมกันระหว่างหลายฝ่าย ขึ้นกับสาเหตุและบทบาทของแต่ละฝ่าย

เพื่อปิดช่องว่างด้านความรับผิดชอบ จำเป็นต้องมีกฎหมายและนโยบายที่ชัดเจน เช่น ข้อกำหนดการตรวจสอบอิสระ (independent audits), นโยบาย human-in-the-loop, การบันทึกข้อมูลการตัดสินใจของระบบ และการกำหนดกรอบความรับผิดชอบทางสัญญาเมื่อจัดซื้อระบบจากเอกชน

สรุปเชิงบทเรียน

กรณีการใช้ AI โดยหน่วยงานตรวจคนเข้าเมืองที่ส่งเจ้าหน้าที่ปฏิบัติการโดยขาดการฝึกอบรมและการตรวจสอบ ย้ำให้เห็นว่าการนำเทคโนโลยีมาใช้ในงานที่มีความเสี่ยงสูงต้องไม่ได้อยู่เพียงด้านเทคนิคเท่านั้น แต่ต้องมาพร้อมกับกรอบกฎหมายที่ชัดเจน มาตรการป้องกันอคติ ความโปร่งใสในการตัดสินใจ และกลไกความรับผิดชอบที่สามารถบังคับใช้ได้ หากละเลย ผลกระทบทั้งต่อสิทธิมนุษยชนและความชอบธรรมของหน่วยงานอาจรุนแรงและยากต่อการแก้ไข

การตอบสนองของหน่วยงานและผู้ให้บริการเทคโนโลยี

การตอบสนองของหน่วยงานและผู้ให้บริการเทคโนโลยี

เมื่อเกิดเหตุการณ์ที่ระบบปัญญาประดิษฐ์ของหน่วยงานตรวจคนเข้าเมืองส่งเจ้าหน้าที่ออกปฏิบัติภารกิจโดยขาดการฝึกอบรมที่เพียงพอ การตอบโต้เบื้องต้นจากหน่วยงานมักประกอบด้วยการประกาศคำสั่งชั่วคราวเพื่อลดความเสี่ยงและเปิดการสอบสวนภายใน โดยรูปแบบการตอบสนองทั่วไป ได้แก่ การสั่งพักการใช้งานบางฟีเจอร์, การปรับค่า threshold เพื่อให้ระบบต้องการหลักฐานเข้มงวดขึ้นก่อนให้คำแนะนำ และการออกแนวปฏิบัติชั่วคราวเพื่อจำกัดขอบเขตการตัดสินใจของ AI จนกว่าจะมีการประเมินความเสี่ยงครบถ้วน ในหลายกรณี หน่วยงานเลือกใช้มาตรการชั่วคราวเป็นเวลาหลายสัปดาห์ถึงหลายเดือนเพื่อทำการตรวจสอบและแก้ไขจุดบกพร่องก่อนจะกลับมาใช้งานเต็มรูปแบบ

ในเชิงปฏิบัติ หน่วยงานมักใช้วิธีการหลายอย่างร่วมกันเพื่อรับมือกับเหตุการณ์ เช่นการเรียกตรวจสอบ log เชิงลึก การทบทวนข้อมูลฝึกสอน (training data) และการดำเนินการทดสอบย้อนหลัง (retrospective testing) เพื่อประเมินผลกระทบต่อบุคคลที่ได้รับคำแนะนำผิดพลาด ตัวอย่างเช่น ในเหตุการณ์ของระบบราชการและเทคโนโลยีที่คล้ายกันทั่วโลกประมาณครึ่งหนึ่งของกรณีมีการสั่งพักการใช้งานบางส่วนเป็นมาตรการแรก ขณะที่อีกหลายหน่วยงานเลือกปรับค่า threshold ชั่วคราวก่อนลงมือปรับปรุงสถาปัตยกรรมหรือกระบวนการฝึกอบรมของโมเดล

จากมุมมองของผู้ขายซอฟต์แวร์ ความสัมพันธ์กับลูกค้าถูกกำหนดโดยสัญญาและข้อกำหนดการให้บริการ (SLA) ซึ่งมักมี ข้อกำหนดจำกัดความรับผิด (liability clauses) และข้อยกเว้นที่ป้องกันไม่ให้ผู้ให้บริการต้องรับผิดชอบเต็มจำนวนต่อความเสียหายที่เกิดจากการใช้งาน AI ผู้ขายส่วนใหญ่จะเสนอการสนับสนุนหลังการขาย เช่น แพตช์ความปลอดภัย การปรับแต่งโมเดล และบริการฝึกอบรมเพิ่มเติม แต่สัญญาทางกฎหมายมักจำกัดการชดเชยและกำหนดให้ความรับผิดชอบบางส่วนตกอยู่กับหน่วยงานผู้ใช้งาน นอกจากนี้ ผู้ขายบางรายมักอ้างว่าโมเดลเป็นเพียง "เครื่องมือช่วยตัดสินใจ" (decision-support) เพื่อจำกัดความรับผิดชอบเชิงกฎหมาย ทำให้หน่วยงานต้องวางแผนรับความเสี่ยงและมาตรการกำกับดูแลภายในเพิ่มเติม

บทบาทของภาคประชาสังคมและสื่อมวลชนมีความสำคัญต่อการขับเคลื่อนความโปร่งใสและการเปลี่ยนแปลง บรรดาองค์กรสิทธิ ด้านดิจิทัล และนักข่าว investigative มักใช้เครื่องมือเช่น คำร้องขอข้อมูลสาธารณะ (FOI), การทดสอบภาคสนาม และการเปิดเผยข้อมูลเชิงวิเคราะห์ เพื่อกดดันให้หน่วยงานและผู้ขายเปิดเผยรายละเอียดของระบบ ผลการสอบสวน และมาตรการเยียวยา ความกดดันดังกล่าวบ่อยครั้งนำไปสู่การเปิดเผยรายงานเหตุการณ์ ไทม์ไลน์การตอบสนอง และแม้กระทั่งการเรียกร้องการตรวจสอบอิสระจากหน่วยงานภายนอก

เมื่อตีความความเพียงพอและความโปร่งใสของมาตรการที่ดำเนินการแล้ว พบว่าแม้บางมาตรการจะมีประสิทธิภาพในเชิงเทคนิค แต่โดยรวมยังคงมีข้อจำกัดด้านความโปร่งใสและความรับผิดชอบ ตัวอย่างปัญหาที่พบบ่อยได้แก่ การเปิดเผยข้อมูลที่ไม่ครบถ้วน (เช่น ไม่เปิดเผยชุดข้อมูลฝึกสอนหรือเกณฑ์การปรับ threshold), การใช้ข้อกำหนดทางสัญญาที่จำกัดการตรวจสอบภายนอก, และการที่รายงานเหตุการณ์มักเป็นสรุปเชิงนโยบายแทนรายละเอียดเชิงเทคนิค ซึ่งทำให้การประเมินผลกระทบต่อบุคคลจริงทำได้ยาก การแก้ไขที่ยั่งยืนจึงต้องประกอบด้วย การตรวจสอบอิสระ, การเปิดเผยไทม์ไลน์เหตุการณ์และผลการทดสอบ, การทบทวนสัญญาเพื่อขยายความรับผิดชอบเมื่อจำเป็น และการจัดตั้งกระบวนการชดเชยหรือเยียวยาสำหรับผู้ได้รับผลกระทบ

สรุปคือ มาตรการที่หน่วยงานและผู้ขายนำมาใช้ในภาวะวิกฤตช่วยลดความเสี่ยงเชิงปฏิบัติได้ในระยะสั้น แต่อย่างยิ่งในการยกระดับความเชื่อมั่นของสาธารณะต้องการความโปร่งใสมากกว่าเดิม ทั้งในเชิงเทคนิคและเชิงสัญญา พร้อมทั้งการมีส่วนร่วมของภาคประชาสังคมและสื่อเพื่อให้เกิดการตรวจสอบถ่วงดุลอย่างแท้จริง

ข้อเสนอแนะแนวปฏิบัติและนโยบายเพื่อป้องกันเหตุซ้ำ

ข้อเสนอแนะแนวปฏิบัติและนโยบายเพื่อป้องกันเหตุซ้ำ

เพื่อป้องกันการนำระบบปัญญาประดิษฐ์ (AI) มาใช้ในภารกิจที่มีความเสี่ยงสูงโดยปราศจากการเตรียมพร้อมที่เพียงพอ จำเป็นต้องมีแนวปฏิบัติระดับหน่วยงานและนโยบายระดับชาติที่เชื่อมโยงกันอย่างเป็นระบบ ข้อเสนอเหล่านี้มุ่งเน้นการสร้างความมั่นใจในความปลอดภัยของมนุษย์ (human safety), ความรับผิดชอบ (accountability) และความโปร่งใส (transparency) ตลอดวงจรชีวิตของการจัดซื้อ ติดตั้ง และใช้งาน AI โดยเฉพาะในบริบทงานตรวจคนเข้าเมืองและการปฏิบัติการภาคสนามที่มีความเสี่ยงสูง

1. ข้อกำหนดฝึกอบรม (Training Requirements)

การฝึกอบรมต้องเป็นไปตามหลักสูตรที่ออกแบบมาเฉพาะสำหรับบทบาทการใช้งาน AI ในหน่วยงาน รวมทั้งมีการประเมินผลอย่างเป็นรูปธรรมและการรับรองความสามารถก่อนนำผู้ปฏิบัติงานเข้าสู่ภารกิจจริง ตัวอย่างแนวปฏิบัติที่แนะนำ ได้แก่:

- Curriculum: แบ่งเป็นโมดูล เช่น พื้นฐานการทำงานของโมเดล AI, ขอบเขตความสามารถและข้อจำกัด, การประเมินความเสี่ยง, วิธีการอ่านผลลัพธ์และการตัดสินใจร่วมกับมนุษย์, จริยธรรมและกฎหมายที่เกี่ยวข้อง, กระบวนการบันทึกเหตุการณ์ (logging) และรายงานเหตุผิดปกติ

- Frequency: การฝึกอบรมพื้นฐานก่อนปฏิบัติงานจริง, การทบทวนเต็มรูปแบบอย่างน้อยปีละครั้ง และการอบรมย่อย (refresher) ทุก 3–6 เดือนสำหรับผู้ปฏิบัติงานเชิงปฏิบัติการ

- Scenario drills: บังคับให้มีการซ้อมเชิงสถานการณ์ (tabletop exercises) ทุกไตรมาส และการซ้อมภาคสนามแบบเต็มรูปแบบอย่างน้อยปีละ 1–2 ครั้งเพื่อทดสอบการทำงานร่วมกับระบบ AI ในเงื่อนไขจริง เช่น กรณีการตัดสินใจฉุกเฉินหรือความผิดพลาดของเซนเซอร์

- การประเมินผล: ใช้การทดสอบเชิงประสิทธิภาพ (competency tests) ที่มีเกณฑ์ผ่านชัดเจน เช่น คะแนนขั้นต่ำ 80% ในการประเมินทักษะการตีความผลและการใช้เครื่องมือกรณีฉุกเฉิน และกำหนดการออกใบรับรอง (certification) กับการต่ออายุใบรับรองเป็นประจำ

2. มาตรการด้านเทคนิค (Technical Measures)

เทคโนโลยีต้องถูกออกแบบและติดตั้งพร้อมกลไกที่ยืนยันการทำงานอย่างปลอดภัยและตรวจสอบได้ โดยมาตรการสำคัญประกอบด้วย:

- Explainability: บังคับให้ผู้จัดหาแสดงเอกสารอธิบายการทำงานของโมเดล (model cards) และการตัดสินใจในรูปแบบที่เข้าใจได้สำหรับผู้ปฏิบัติงาน เช่น การให้เหตุผลเชิงสรุปสำหรับคำแนะนำที่ระบบให้ พร้อมตัวอย่างเหตุการณ์ย้อนหลัง (decision logs)

- Fallback procedures: กำหนดขั้นตอนสำรองที่ชัดเจนเมื่อตรวจพบความผิดปกติ เช่น โหมดความปลอดภัย (safe mode), การสลับไปใช้การตัดสินใจแบบแมนนวล, ปุ่มหยุดฉุกเฉิน และโปรโตคอลการประสานงานกับทีมสนับสนุนภายใน 24 ชั่วโมง

- Real-time monitoring: ติดตั้งระบบเฝ้าระวังแบบเรียลไทม์ที่ตรวจจับความเบี่ยงเบนของการทำงาน (anomaly detection), เมตริกสำคัญ เช่น Mean Time to Detect (MTTD) และ Mean Time to Recover (MTTR) โดยตั้งค่าเกณฑ์เตือนที่สามารถกระตุ้นการแทรกแซงของมนุษย์ได้ทันที

- Logging and audit trails: เก็บบันทึกการตัดสินใจของระบบอย่างละเอียด รวมถึงข้อมูลอินพุต เวลาการดำเนินการ และผู้ที่อนุมัติการตัดสินใจ เพื่อให้สามารถตรวจสอบย้อนหลังโดยหน่วยงานอิสระได้

3. นโยบายกว้าง (Policy-level Measures)

ระดับนโยบายต้องกำหนดกฎบังคับและกลไกเชิงบังคับให้หน่วยงานปฏิบัติตาม เพื่อสร้างมาตรฐานและความรับผิดชอบต่อสาธารณะ:

- Procurement clauses: รวมข้อกำหนดด้านความปลอดภัยของมนุษย์ไว้ในสัญญาจัดซื้อ เช่น เงื่อนไขที่ผู้จัดหาให้ข้อมูลด้านความเสี่ยงและการทดสอบ, ข้อผูกพันในการอัปเดตซอฟต์แวร์, การรับประกันการสนับสนุนด้านการฝึกอบรม และเงื่อนไขการชดใช้ค่าเสียหาย (liability clauses) เมื่อเกิดความบกพร่อง

- Mandatory audits: กำหนดการตรวจสอบโดยบุคคลที่สามอย่างน้อยปีละครั้งรวมถึงการทดสอบความปลอดภัยเชิงปฏิบัติการ (operational safety testing) และการประเมินผลความเป็นธรรมของโมเดล (bias assessment) โดยผลการตรวจสอบจะต้องถูกส่งให้หน่วยกำกับดูแล

- Public transparency reports: หน่วยงานต้องเผยแพร่รายงานสรุปประจำปีที่ครอบคลุมสถิติการใช้ระบบ AI, เหตุการณ์ด้านความปลอดภัยที่สำคัญ, ดัชนีชี้วัดความเสี่ยง เช่น จำนวนเหตุการณ์ที่ต้องใช้การแทรกแซงของมนุษย์ และมาตรการที่ดำเนินการแก้ไข โดยสามารถจัดทำเป็นฉบับสรุปสาธารณะที่ไม่เปิดเผยข้อมูลส่วนบุคคล

- Pilot testing and phased deployment: ห้ามนำระบบเข้าสู่การใช้งานเต็มรูปแบบโดยตรง ให้มีการทดสอบนำร่อง (pilot) ในสภาพแวดล้อมจำกัดเป็นเวลาอย่างน้อย 6–12 เดือน พร้อมเกณฑ์ความสำเร็จชัดเจนก่อนขยายสู่การใช้งานระดับภูมิภาคหรือระดับชาติ

- Human-in-the-loop mandates: ระบุขอบเขตการตัดสินใจที่ต้องมีมนุษย์ตรวจสอบ โดยเฉพาะการตัดสินใจที่มีผลต่อสิทธิมนุษยชน ความเป็นอันตรายต่อบุคคล หรือการดำเนินคดี เช่น กำหนดระดับความเสี่ยงที่ระบบต้องส่งคำแนะนำให้ผู้ปฏิบัติงานยืนยันก่อนดำเนินการ

สรุปแล้ว การป้องกันเหตุซ้ำจากการนำ AI ไปใช้โดยไม่พร้อมต้องอาศัยการออกแบบมาตรการเชิงเทคนิค การฝึกอบรมผู้ปฏิบัติงานที่เข้มงวด และกรอบนโยบายที่บังคับใช้ได้จริง การผสานแนวทางทั้งสามระดับนี้จะช่วยลดความเสี่ยง เพิ่มความโปร่งใส และสร้างความเชื่อมั่นของสาธารณชนต่อการใช้เทคโนโลยี AI ในภารกิจที่มีความเสี่ยงสูง

บทสรุป

การนำปัญญาประดิษฐ์ (AI) มาใช้ในการปฏิบัติหน้าที่ของหน่วยงานตรวจคนเข้าเมืองมีศักยภาพช่วยเพิ่มประสิทธิภาพ แต่ต้องมาพร้อมกับการฝึกอบรมและกรอบความรับผิดชอบที่ชัดเจน มิฉะนั้นจะเพิ่มความเสี่ยงทั้งต่อชีวิตของบุคคลที่เกี่ยวข้อง สิทธิเสรีภาพ และความน่าเชื่อถือของหน่วยงาน ตัวอย่างเหตุการณ์ในต่างประเทศแสดงให้เห็นการจับกุมหรือปฏิสัมพันธ์ที่ผิดพลาดเมื่อเจ้าหน้าที่ใช้งานระบบอัตโนมัติโดยไม่มีการฝึกฝนเพียงพอ และงานวิจัย/การสำรวจหลายแห่งชี้ว่าประมาณ 50–70% ของโครงการ AI ในภาครัฐเริ่มใช้งานก่อนจะมีมาตรการฝึกอบรมหรือการกำกับดูแลที่เต็มที่ จึงต้องเน้นทั้งการอบรมภาคปฏิบัติ การสร้างแนวทางปฏิบัติที่ชัดเจน และมาตรการโปร่งใส เช่น การบันทึกการตัดสินใจของระบบและการทดสอบความลำเอียง (bias testing) เพื่อปกป้องสิทธิและลดความเสี่ยง

แนวทางแก้ไขต้องเป็นการผสานกันระหว่างมาตรการทางเทคนิค การบริหารจัดการ และการกำกับดูแล: ทางเทคนิคต้องรวม explainability, การตรวจสอบแบบต่อเนื่อง (continuous monitoring), ข้อชี้วัดสมรรถนะและการทดสอบความเป็นธรรม; ทางบริหารต้องปรับกระบวนการจัดซื้อ (procurement) ให้บังคับข้อกำหนดด้านความปลอดภัยและความโปร่งใส พร้อมแผนการฝึกอบรมแบบบังคับและการฝึกซ้อมสถานการณ์จริง; ทางกำกับดูแลต้องมีการตรวจสอบอิสระ (audits), กลไกรายงานเหตุผิดพลาด, และกรอบกฎหมาย/นโยบายที่ชัดเจนเพื่อรับผิดชอบต่อผลกระทบ หากดำเนินการอย่างเป็นระบบในอีก 1–3 ปีข้างหน้า หน่วยงานจะสามารถลดเหตุการณ์ผิดพลาด เพิ่มความเชื่อมั่นสาธารณะ และรักษาสมดุลระหว่างความมั่นคงและสิทธิมนุษยชน แต่หากละเลยความร่วมมือระหว่างภาคเทคนิค ภาครัฐ และภาคประชาสังคม เหตุการณ์ซ้ำซ้อนและผลเสียต่อประชาชนก็มีแนวโน้มเพิ่มขึ้น

📰 แหล่งอ้างอิง: Gizmodo