Anthropic เปิดตัวเครื่องมือ AI รุ่นใหม่ที่อ้างว่าสามารถเขียน ทดสอบ และบูรณาการโค้ดได้อย่างอัตโนมัติ ส่งสัญญาณการเปลี่ยนแปลงครั้งใหญ่ในวงการซอฟต์แวร์ โดยไม่เพียงแต่ยกระดับประสิทธิภาพการพัฒนา แต่ยังท้าทายโมเดลการทำงานของเครื่องมือจัดการโครงการและระบบ CI/CD แบบดั้งเดิม ทำให้นักพัฒนา ผู้จัดการผลิตภัณฑ์ และนักลงทุนจับตามองอย่างใกล้ชิด ข่าวการเปิดตัวนี้ยังสะเทือนตลาดการเงินทันที เมื่อหุ้นของ Atlassian ปรับตัวอย่างรวดเร็ว ทิ้งคำถามเกี่ยวกับความเสี่ยงของแพลตฟอร์มจัดการงานและเครื่องมือร่วมทีมในยุคที่การสร้างซอฟต์แวร์อาจถูกอัตโนมัติไปมากขึ้น

บทความนี้จะวิเคราะห์ผลกระทบเชิงเทคนิค ธุรกิจ และการเงินจากเครื่องมือของ Anthropic ตั้งแต่สถาปัตยกรรมและความสามารถในการบูรณาการกับโครงสร้างพื้นฐานเดิม ไปจนถึงโมเดลรายได้และการแข่งขันในตลาดซอฟต์แวร์สำหรับทีมพัฒนา เราจะสำรวจเหตุผลที่ทำให้ผู้ลงทุนหวั่นไหว รวมทั้งประเมินความเป็นไปได้ที่ผลิตภัณฑ์ใหม่นี้จะเปลี่ยนพฤติกรรมการใช้งานของลูกค้า และสิ่งที่ Atlassian และผู้เล่นรายอื่นอาจต้องทำเพื่อตอบโต้หรือปรับตัว

เบื้องต้น: ข่าวสำคัญและบริบททางตลาด

เบื้องต้น: ข่าวสำคัญและบริบททางตลาด

Anthropic ประกาศเปิดตัวเครื่องมือใหม่สำหรับนักพัฒนาซอฟต์แวร์และองค์กร เมื่อวันที่ 25 มกราคม 2026 เวลา 08:30 น. ตามเวลาแปซิฟิก ในแถลงการณ์อย่างเป็นทางการบนเว็บไซต์ของบริษัทและผ่านบันทึกข่าวประชาสัมพันธ์ที่ส่งถึงสื่อมวลชน (Press Release ของ Anthropic) รายงานระบุว่าเครื่องมือนี้ออกแบบมาเพื่อรวมการทำงานของโมเดลภาษาใหญ่เข้ากับเวิร์กโฟลว์การพัฒนาซอฟต์แวร์และการจัดการโปรเจ็กต์ขององค์กร โดยเน้นทั้งด้านการผลิตซอฟต์แวร์ที่มีความปลอดภัยและการทำงานร่วมกันในระดับองค์กร

ภาพรวมความสำคัญของเครื่องมือนี้อยู่ที่จุดขายหลักที่ Anthropic เน้นว่าแตกต่างจากคู่แข่งหลายประการ ได้แก่:

- ความปลอดภัยและความน่าเชื่อถือ — โมเดลได้รับการปรับแต่งเพื่อจำกัดการสร้างโค้ดหรือคำตอบที่เสี่ยงต่อการละเมิดนโยบายความปลอดภัยขององค์กร

- การผนวกรวมเข้ากับระบบองค์กร — รองรับการเชื่อมต่อกับเครื่องมือจัดการโครงการและรีโปซิทอรี่ เช่น Jira/Confluence, Git, และ CI/CD ผ่าน API องค์กร

- บริบทยาวและความต่อเนื่องของโปรเจ็กต์ — สามารถรักษาบริบทโค้ดและข้อกำหนดของโปรเจ็กต์ในระดับยาว เพื่อให้คำแนะนำที่สอดคล้องกันข้ามสปรินท์และรีลีส

- ฟีเจอร์การร่วมเขียนโค้ดและรีวิวอัตโนมัติ — มุ่งเน้นเพิ่ม Productivity ของทีมพัฒนา โดยมีการให้คำแนะนำเชิงสถาปัตยกรรมและการตรวจสอบการเปลี่ยนแปลงโค้ด

การตอบสนองของตลาดเป็นไปอย่างทันทีและมีความผันผวนสูง: หุ้น Atlassian (NASDAQ: TEAM) เคลื่อนไหวอย่างมีนัยสำคัญหลังข่าวเปิดตัว โดยในชั่วโมงแรกของการซื้อขายหลังประกาศมีรายงานการปรับตัวลง ตัวอย่างเช่น ราว 4–8% (ตัวเลขเบื้องต้นเป็นค่าประมาณ) ขณะที่ปริมาณการซื้อขายเพิ่มขึ้นอย่างชัดเจน แสดงให้เห็นว่าผู้ลงทุนกำลังประเมินความเสี่ยงจากการเข้ามาของโซลูชั่นใหม่ที่อาจสร้างแรงกดดันต่อตำแหน่งทางการตลาดของซอฟต์แวร์จัดการการทำงานและเครื่องมือสำหรับนักพัฒนา

หมายเหตุ: ตัวเลขราคาหุ้นและเปอร์เซ็นต์การเปลี่ยนแปลงที่ระบุข้างต้นเป็นข้อมูลเบื้องต้นและเป็นตัวอย่างของการเคลื่อนไหวในช่วงสั้น ๆ ทางทีมข่าวจะทำการตรวจสอบและ อัปเดตตัวเลขราคาหุ้นจริงก่อนเผยแพร่ฉบับสุดท้าย เพื่อให้ข้อมูลทางการตลาดมีความถูกต้องและเชื่อถือได้

เครื่องมือใหม่ของ Anthropic: ฟีเจอร์และเทคโนโลยีเบื้องหลัง

ภาพรวมฟีเจอร์เด่นของเครื่องมือใหม่จาก Anthropic

เครื่องมือชุดใหม่ของ Anthropic ถูกออกแบบมาเพื่อเป็นแพลตฟอร์มช่วยพัฒนาโค้ดแบบครบวงจร โดยจุดขายหลักคือความสามารถในการให้ คอนเท็กซ์ของระบบทั้งระบบ (whole-system context) แก่โมเดล ทำให้การเขียนโค้ดอัตโนมัติและการรีแฟคเตอร์คำนึงถึงสถาปัตยกรรม โครงสร้างโมดูล และการไหลของข้อมูลภายในโครงการ ไม่ใช่แค่การแก้ปัญหาเฉพาะจุดเดียว ตัวอย่างการใช้งานเช่น การให้คำแนะนำการเปลี่ยน API แบบข้ามโมดูลพร้อมปรับ unit tests และ dependency graph อัตโนมัติ

ฟีเจอร์สำคัญที่โดดเด่นได้แก่:

- การเขียนโค้ดอัตโนมัติ (Auto-generation): รองรับหลายภาษาโปรแกรม เช่น Python, JavaScript/TypeScript, Java, Go, และ Rust พร้อมตัวอย่างโค้ดที่ใช้มาตรฐานองค์กร และมีความสามารถเสนอทั้งฟังก์ชันย่อยและโครงสร้างคลาส/โมดูล

- การรีแฟคเตอร์อัจฉริยะ: วิเคราะห์ผลกระทบข้ามไฟล์ ปรับชื่อฟังก์ชัน/อินเตอร์เฟซ และเสนอแผนการทำงานพร้อมรหัสตัวอย่างเพื่อให้การเปลี่ยนแปลงปลอดภัย

- การสร้าง Unit และ Integration Tests อัตโนมัติ: สร้างชุดทดสอบเชิงหน่วยและเชิงบูรณาการ โดยสามารถเลือก framwork เช่น pytest, JUnit, Jest หรือสร้างเทสต์แบบ end-to-end สำหรับ API/UI (เช่น Cypress) พร้อมข้อมูล mock และตัวอย่าง input/output

- การรวมกับ CI/CD: เชื่อมต่อกับระบบ CI/CD ยอดนิยม (GitHub Actions, GitLab CI, Jenkins, CircleCI) เพื่อรันเทสต์อัตโนมัติ สร้าง Pull Request ที่มีรายละเอียดการแก้ไขและผลการทดสอบ รวมถึง pre-commit hooks และ automated code review

- การรักษาความปลอดภัยของโค้ด: สแกนหาช่องโหว่ (SAST/SCA), ตรวจสอบการรั่วไหลของคีย์ลับ และเสนอแพทช์พร้อมคำอธิบายความเสี่ยง ทำงานร่วมกับเครื่องมือความปลอดภัยเดิมขององค์กรได้

ตัวอย่างเชิงปฏิบัติและสถิติ

ในเชิงปฏิบัติ Anthropic แสดงตัวอย่างการใช้งาน เช่น การให้โมเดลสร้าง Pull Request ที่แก้บั๊กในบริการเว็บขนาดเล็ก โดยสร้างทั้งโค้ด กรณีทดสอบ และบรรยายการเปลี่ยนแปลง ในองค์กรต้นแบบบางแห่งที่ทดลองใช้รายงานว่า ระยะเวลาแก้บั๊กลดลงอย่างมีนัยสำคัญ และทีม QA สามารถโฟกัสไปที่กรณีทดสอบเชิงลึกได้มากขึ้น (บางองค์กรรายงานการเพิ่ม productivity ระหว่าง 20–40% สำหรับงานบางประเภท) อย่างไรก็ตาม ผลลัพธ์จะแตกต่างตามสภาพแวดล้อมและการกำกับดูแลของแต่ละทีม

เทคโนโลยีหลักและสถาปัตยกรรมเบื้องหลัง

เครื่องมือของ Anthropic พึ่งพาเทคนิคหลายชั้นเพื่อให้ได้ความสามารถข้างต้น โดยองค์ประกอบสำคัญได้แก่:

- โมเดลภาษาใหญ่ (LLM): เป็นแกนหลักสำหรับการสังเคราะห์โค้ด การอธิบายการเปลี่ยนแปลง และการสร้างเทสต์ โมเดลถูกออกแบบให้รองรับ input ที่มีคอนเท็กซ์โค้ดปริมาณมากและโครงสร้างข้อมูลเชิงโปรแกรม

- การฝึกและปรับแต่งเชิงเฉพาะ (fine-tuning & instruction tuning): โมเดลได้รับการ fine-tune ด้วยชุดข้อมูลโค้ดคุณภาพสูง รวมทั้งตัวอย่าง refactor, test-generation และ security-fixes เพื่อให้ผลลัพธ์ตรงตามมาตรฐานวิศวกรรมซอฟต์แวร์

- Retrieval-Augmented Generation (RAG): เมื่อเผชิญคำถามที่ต้องอ้างอิงเอกสารโครงการหรือประวัติการคอมมิต โมเดลจะเรียกข้อมูลที่เกี่ยวข้องจาก repository, docs หรือ knowledge base เพื่อให้คำตอบไม่ขึ้นกับการจำเพียงอย่างเดียว ช่วยลดการ hallucination

- Tool-augmented reasoning & execution: ระบบผสานการเรียกใช้งานเครื่องมือภายนอก เช่น static analyzers, linters, security scanners และ sandboxed code execution environment เพื่อทดสอบโค้ดที่สร้างขึ้นจริงก่อนเสนอผลลัพธ์

- Context orchestration: การจัดการ context window ขนาดใหญ่และการสร้าง representation ของ dependency graph ช่วยให้โมเดลเข้าใจผลกระทบในระดับสถาปัตยกรรม ไม่ใช่แค่ไฟล์เดียว

ข้อจำกัดทางเทคนิคที่ต้องระวัง

แม้เทคโนโลยีจะก้าวหน้า แต่ยังมีข้อจำกัดสำคัญที่ผู้บริหารและทีมเทคนิคควรรับรู้ก่อนนำไปใช้งานในระดับองค์กร:

- ความแม่นยำของโค้ดและ hallucination: LLM อาจสร้างโค้ดที่ดูถูกต้องแต่ทำงานผิดหรือมีบั๊กซ่อนอยู่ การทดสอบอัตโนมัติช่วยลดความเสี่ยงได้แต่ไม่สามารถแทนการตรวจทานโดยมนุษย์ได้ทั้งหมด

- ความลำเอียงและคุณภาพข้อมูลฝึก: ผลลัพธ์ขึ้นอยู่กับข้อมูลที่ใช้ฝึก หากชุดข้อมูลมีโค้ดที่ล้าสมัยหรือมีรูปแบบที่ไม่ตรงกับนโยบายองค์กร อาจนำไปสู่แนวปฏิบัติที่ไม่เหมาะสม

- ข้อจำกัดด้านคอมพิวต์และค่าใช้จ่าย: การรันโมเดลขนาดใหญ่โดยเฉพาะในโหมดที่ต้องเรียกใช้งาน batch RAG หรือ sandboxed execution อาจมีค่าใช้จ่ายสูง และต้องการทรัพยากรทั้ง CPU/GPU ส่งผลต่อ latency ใน pipeline ของ CI/CD

- ความเป็นส่วนตัวและการคุมข้อมูล: การนำซอร์สโค้ดไป process ผ่านบริการคลาวด์ต้องจัดการประเด็นความลับทางการค้าและกฎหมายคุ้มครองข้อมูล องค์กรอาจต้องการ deployment แบบ on-premise หรือ hybrid

- ช่องโหว่ด้านความปลอดภัยและ supply-chain: การสร้างโค้ดอัตโนมัติอาจแนะนำ dependency ที่มีช่องโหว่หรือการเรียกใช้แพ็คเกจที่มีสัญญาอนุญาตไม่ชัดเจน ต้องมีการตรวจสอบ SCA และนโยบายการรับ dependency อย่างเข้มงวด

สรุปแล้ว เครื่องมือของ Anthropic นำเสนอการยกระดับ workflow ทางวิศวกรรมซอฟต์แวร์ด้วยฟีเจอร์เชิงระบบและเทคนิคสมัยใหม่ เช่น LLM + RAG + tool-augmented reasoning แต่การนำไปใช้ในระดับองค์กรจำเป็นต้องมี governance, การทดสอบเชิงลึก และการจัดการทรัพยากรเพื่อควบคุมความเสี่ยงและค่าใช้จ่ายอย่างเหมาะสม

ผลกระทบต่อวงจรการพัฒนา: ประสิทธิภาพและการเปลี่ยนแปลงเวิร์กโฟลว์

ผลกระทบต่อวงจรการพัฒนา: ประสิทธิภาพและการเปลี่ยนแปลงเวิร์กโฟลว์

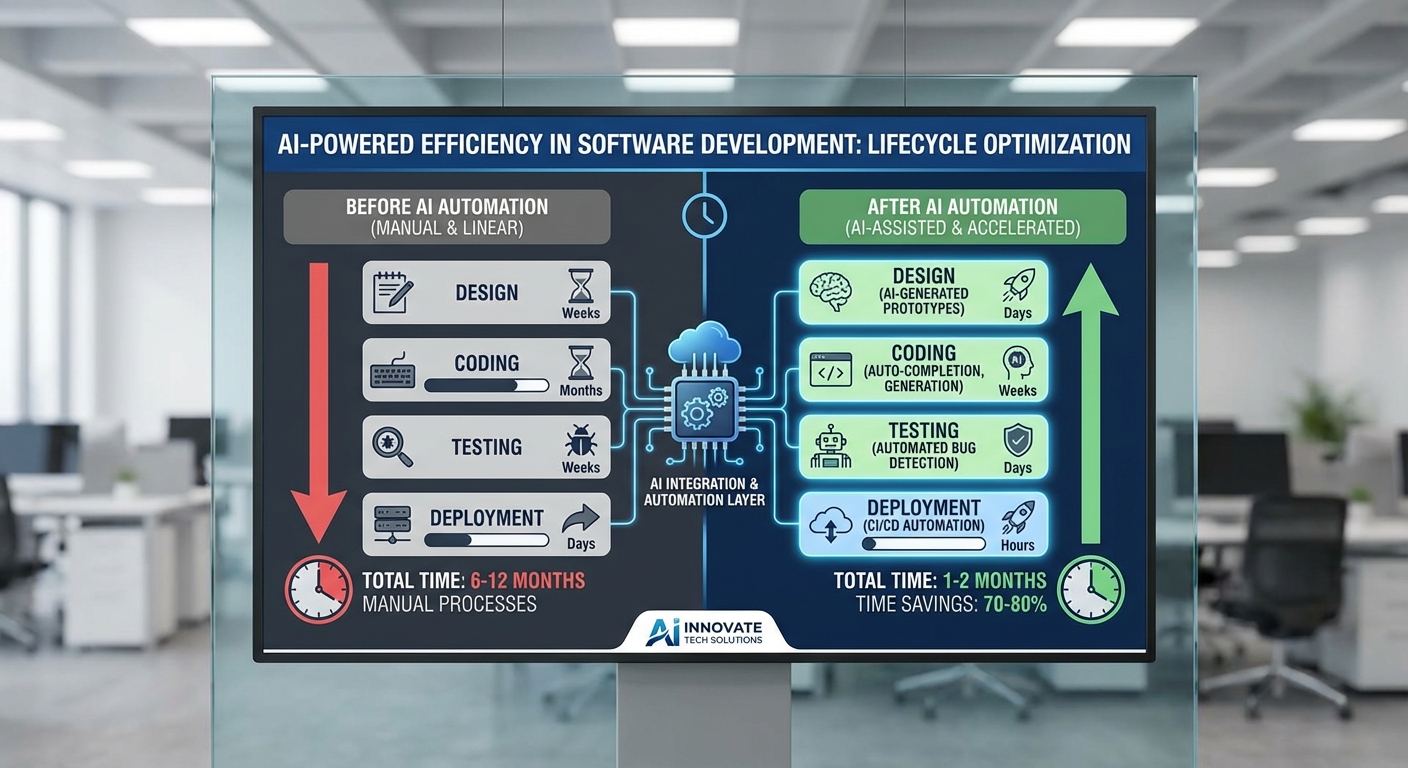

เครื่องมือใหม่จาก Anthropic มีศักยภาพในการเปลี่ยนโฉมวงจรการพัฒนา (SDLC) ตั้งแต่การออกแบบไปจนถึงการดูแลรักษาหลังการปล่อยใช้งาน โดยยกระดับความเร็วในการสร้างโค้ด การสร้างและรันเทส รวมทั้งการตรวจสอบก่อนปล่อย (pre-release checks) ซึ่งส่งผลโดยตรงต่อ lead time และ cycle time ของทีมพัฒนา ตัวอย่างการเปลี่ยนแปลงที่สำคัญได้แก่ การใช้โมเดลช่วยออกแบบสถาปัตยกรรม ร่าง API contract อัตโนมัติ สร้างโค้ด boilerplate และสร้างชุดเทสอัตโนมัติ ทำให้ขั้นตอนที่ต้องใช้เวลามือ (manual) ลดลงอย่างมีนัยสำคัญ

ในเชิงตัวเลข หากนำมาวิเคราะห์จากการทดลองนำร่อง (pilot) แบบสมมติ สมมติทีมขนาด 12 คน ทำงานเป็นสปรินต์สองสัปดาห์ โดยปกติทีมสามารถปิดงาน feature/backlog เฉลี่ย 60 รายการต่อสปรินต์ และใช้เวลาเฉลี่ยในการเขียนโค้ดต่อ tiket เท่ากับ 8 ชั่วโมง (รวมการทดสอบขั้นต้น) หากเครื่องมือช่วยลดเวลาการเขียนโค้ดเฉลี่ยลง 30% จะเท่ากับการลดเวลาเหลือ ~5.6 ชั่วโมงต่อ tiket ซึ่งหมายถึงการประหยัดเวลา ~2.4 ชั่วโมงต่อ tiket รวมเป็น ~144 ชั่วโมงต่อสปรินต์ หรือเทียบได้กับ ~18 วันคน (developer-days) ต่อสปรินต์ นั่นคือสามารถเพิ่มความจุทีมได้ ~30% หรือใช้ประโยชน์ในการทำงานเชิงนวัตกรรมอื่นๆ

การประหยัดต้นทุนจากมุมมองธุรกิจสามารถคำนวณง่ายๆ ดังนี้ หากพิจารณาเวลาทำงานที่ประหยัดได้ 144 ชั่วโมงต่อสปรินต์ และแต่ละสปรินต์สองสัปดาห์ ทีมทำ 26 สปรินต์ต่อปี จะได้เวลา ~3,744 ชั่วโมงต่อปี หรือเทียบเท่า ~1.8 FTE (สมมติปีทำงาน 2,080 ชั่วโมงต่อคน) ผลนี้สามารถแปลงเป็นต้นทุนที่ลดลงหรือเป็นการนำทรัพยากรไปใช้ทำงานที่เพิ่มมูลค่ามากขึ้น เช่น การทำ refactor, security hardening หรืองาน UX ที่มักถูกเลื่อนไป

การเปลี่ยนบทบาทของบุคลากรเป็นอีกประเด็นสำคัญ: งานของนักพัฒนา QA และ DevOps จะขยับจากการทำงานแบบ manual ไปสู่บทบาท oversight และการควบคุมคุณภาพเชิงกลยุทธ์ มากกว่าการกดปุ่มซ้ำๆ ตัวอย่างเช่น:

- นักพัฒนา (Developers) จะใช้เวลาในการออกแบบระบบและการรีวิวโค้ดเชิงลึกมากขึ้น แทนที่จะเขียนโค้ด boilerplate แบบเดิม

- QA จะเปลี่ยนเป็นการตรวจสอบและปรับชุดเทสที่โมเดลสร้างให้ ดูแลความถูกต้องของเทสเชิงตรรกะ และออกแบบการทดสอบเชิงสำคัญ (edge cases)

- DevOps จะเน้นการสร้าง pipeline ที่สอดคล้องกับโมเดล (model-aware CI/CD), การตั้ง guardrails, การมอนิเตอร์เมตริกเช่น deployment success rate และ MTTR มากขึ้น

อย่างไรก็ตาม การนำเครื่องมือไปใช้งานจริงย่อมมีความท้าทายที่ต้องคำนึงถึงอย่างรอบด้าน โดยเฉพาะ:

- การผสานเข้ากับระบบเก่า (legacy systems) — ระบบที่มีสถาปัตยกรรมเก่า ขาด API ที่ชัดเจน หรือมีฐานข้อมูลแบบ proprietory จะต้องออกแบบ adapter และ wrapper เพิ่มเติม รวมถึงอาจต้องใช้ effort ในการ mapping ข้อมูลและการทดสอบเชิงบูรณาการ ซึ่งลดประโยชน์เชิงเวลาที่คาดการณ์ได้หากไม่วางแผนล่วงหน้า

- การจัดการ false positives / false negatives — โมเดลอาจแนะนำโค้ดหรือเทสที่ผิดพลาดหรือข้ามเงื่อนไขสำคัญได้ ดังนั้นต้องมีกระบวนการวัดค่า precision/recall ของคำแนะนำ และตั้งเกณฑ์ยอมรับความเสี่ยง เช่น จำกัดการอนุญาตให้อัตโนมัติ (auto-merge) เฉพาะกรณีที่ confidence สูงเกิน threshold หรือใช้ human-in-the-loop ในกรณีที่ความเสี่ยงสูง

- ความปลอดภัยและความเป็นส่วนตัวของข้อมูล — การส่งตัวอย่างโค้ดหรือข้อมูลระบบไปประมวลผล ต้องมีมาตรการป้องกันข้อมูลลับและ compliance (เช่น การทำ data minimization, on-premise deployment หรือการเข้ารหัส)

เพื่อให้การนำไปใช้มีประสิทธิผล ควรออกแบบโครงการนำร่องที่วัดผลชัดเจน เช่น กำหนดตัวชี้วัด (KPIs) ก่อน/หลัง ได้แก่ time-to-merge, deployment frequency, defect escape rate, MTTR, และ developer satisfaction ตัวอย่างกรอบการทดลองนำร่อง 3 เดือน อาจประกอบด้วย:

- เฟสที่ 1 (สัปดาห์ 1–2): baseline metrics เก็บข้อมูล 4 สปรินต์ก่อนหน้า

- เฟสที่ 2 (สัปดาห์ 3–6): เปิดใช้เครื่องมือกับ 25% ของ repository หรือทีมย่อย และมอนิเตอร์ precision ของคำแนะนำโค้ด และ false positive rate ของเทสที่สร้าง

- เฟสที่ 3 (สัปดาห์ 7–12): ขยาย scope เป็น 50–75% พร้อมบูรณาการกับ CI/CD และมอนิเตอร์ผลกระทบต่อ cycle time และ defect escape rate

สรุปแล้ว เครื่องมือจาก Anthropic สามารถลดเวลาการทำงานที่เป็น routine ได้อย่างชัดเจน (ตัวเลขการลดเวลาในงานบางประเภทที่ผู้ผลิตสาธิตอยู่ในช่วง 20–50%) และสามารถเพิ่มความเร็วในการส่งมอบซอฟต์แวร์ได้จริง แต่การได้มาซึ่งประสิทธิผลเต็มที่ต้องการการวางสถาปัตยกรรม integration ที่รัดกุม การออกแบบกระบวนการตรวจสอบเพื่อลด false positive/negative และการปรับบทบาทบุคลากรจากการทำงานเชิงปฏิบัติการไปสู่การกำกับดูแลเชิงกลยุทธ์

ผลกระทบทางการเงิน: ทำไมหุ้น Atlassian จึงปรับตัว

ผลกระทบทางการเงิน: ทำไมหุ้น Atlassian จึงปรับตัว

เมื่อข่าวเครื่องมือใหม่จาก Anthropic ปรากฏต่อตลาด นักลงทุนมักตีความความสามารถของคู่แข่งด้านปัญญาประดิษฐ์ว่าเป็นความเสี่ยงต่อผลิตภัณฑ์ที่มีรายได้ประจำของ Atlassian (เช่น Jira, Confluence และผลิตภัณฑ์ในตระกูลการทำงานร่วมกันอื่น ๆ) ส่งผลให้เกิดแรงขายเฉพาะกิจและความผันผวนของราคาหุ้นในระยะสั้น เหตุผลที่นักลงทุนตอบสนองเช่นนี้มีทั้งเชิงเทคนิคและเชิงธุรกิจ ดังนี้

- ฟีเจอร์ทดแทนและการลดความจำเป็นของผลิตภัณฑ์เดิม: หากเครื่องมือของ Anthropic สามารถนำเสนอการจัดการงาน, การค้นหาเนื้อหา หรือการสรุปความจากเอกสารเชิงคอนเท็กซ์ได้ด้วยประสิทธิภาพที่เทียบเท่าหรือดีกว่า ผู้ใช้ระดับองค์กรอาจลดการพึ่งพา Jira/Confluence ซึ่งกระทบตรงต่อการต่ออายุสัญญา (renewal) และอัตราการเติบโตของรายได้ประจำ

- การรวมระบบ (integrations) ของคู่แข่ง: Anthropic หากผสานฟีเจอร์กับระบบการสื่อสารหรือแพลตฟอร์ม workflow อื่น ๆ ได้ง่าย จะลดอุปสรรคในการย้ายออกจากระบบของ Atlassian และเพิ่มแรงกดดันด้านราคาและข้อเสนอเชิงมูลค่า

- โมเดลรายได้ที่ถูกคุกคาม: Atlassian มีรายได้จาก subscription, add-ons และ marketplace – หากคู่แข่งนำเสนอ AI-as-a-Service ที่รวมฟีเจอร์พื้นฐานไว้โดยไม่ต้องซื้อ license เพิ่ม ผู้ขาย add-ons และ Atlassian เองอาจเห็นอัตรา churn เพิ่มขึ้น

- ความเสี่ยงการสูญเสียส่วนแบ่งตลาด: ตลาด enterprise software มีต้นทุนการเปลี่ยนผ่าน (switching costs) สูง แต่เมื่อฟีเจอร์ AI ช่วยลดต้นทุนในการย้ายข้อมูลและฝึกอบรมผู้ใช้ ความเป็นอุปสรรคต่อการย้ายระบบจะลดลง ทำให้ส่วนแบ่งตลาดของผู้เล่นเดิมอาจถูกกัดเซาะได้อย่างรวดเร็ว

ในเชิงการตอบสนองของราคาหุ้น จริงอยู่ที่แรงขายส่วนใหญ่เป็นการประเมินความเสี่ยงล่วงหน้า (forward-looking) มากกว่าดัชนีผลประกอบการในปัจจุบัน ตัวอย่างของการเคลื่อนไหวแบบนี้มักเห็นได้เมื่อมีข่าว disruptive: ราคาหุ้นมักปรับลงในวันประกาศ (intraday) เป็นสัดส่วนหลักของการเปลี่ยนแปลงในระยะสั้น ซึ่งจะถูกขยายโดยการเทขายจากกองทุนที่เน้นนโยบายการบริหารความเสี่ยง อย่างไรก็ดี หากต้องการตัวเลขที่แน่นอน (เช่น วันที่/เวลา และเปอร์เซ็นต์การเปลี่ยนแปลงของหุ้น Atlassian รวมถึงมูลค่าตลาดที่หายไป) ควรอ้างอิงข้อมูลการซื้อขายจริงจากแหล่งเช่น Bloomberg, Reuters หรือ Yahoo Finance เนื่องจากตัวเลขเหล่านี้เปลี่ยนแปลงตามเวลาและบริบทการซื้อขาย

เพื่อให้ผู้บริหารและนักลงทุนประเมินสถานการณ์ได้ชัดเจน แนะนำนำเสนอกราฟ/ตารางเปรียบเทียบดังต่อไปนี้ (ใช้

- กราฟเวลา (time-series): ราคาหุ้น TEAM รายชั่วโมง/รายวันช่วงก่อนและหลังประกาศข่าว เพื่อแสดงการตอบสนองทันทีของตลาด

- ตารางผลกระทบมูลค่าตลาด: ระบุมูลค่าตลาดก่อนข่าว (Market Cap ณ ปิดวันก่อนหน้า), มูลค่าตลาดหลังข่าว (Market Cap ณ ปิดวันประกาศ) และผลต่างเป็นมูลค่าเงิน (เช่น มูลค่าตลาดหายไป X ล้าน/พันล้านดอลลาร์) — ตารางนี้ช่วยเปรียบเทียบความรุนแรงของการปรับฐาน

- เปรียบเทียบคู่แข่ง: กราฟเส้นเปรียบเทียบการเคลื่อนไหวหุ้นของ Atlassian กับผู้ให้บริการ collaboration/ALM รายอื่น และดัชนีเทคโนโลยี เพื่อดูว่าปรากฏการณ์เป็นเฉพาะบริษัทหรือเป็นภาคส่วน

การประเมินผลระยะสั้น vs ระยะยาว:

- ระยะสั้น (weeks–months): ความเสี่ยงหลักคือความผันผวนของราคาหุ้นและแรงขายจากนักลงทุนที่ประเมินว่าส่วนแบ่งการใช้งานจะลดลง คาดว่าจะเห็นการเปลี่ยนแปลงราคาเฉียบพลัน (เช่น หลายเปอร์เซ็นต์ภายในวันเดียว) แต่หาก Atlassian สื่อสารแผนป้องกัน (roadmap, partnership, quick-fix) ได้ชัดเจน ราคามักปรับฐานกลับบ้าง

- ระยะกลาง–ยาว (1–5 ปี): ผลลัพธ์ขึ้นกับสองปัจจัยหลัก: ความสามารถของ Atlassian ในการตอบโต้ด้วย AI/ML ที่ผสานกับผลิตภัณฑ์เดิม และการเปลี่ยนแปลงพฤติกรรมลูกค้า ถ้า Atlassian เร่งลงทุน/ซื้อกิจการเพื่อเสริมความสามารถ AI และสามารถรักษา ecosystem ของ marketplace ได้ จะมีโอกาสรักษาหรือขยายรายได้ ในทางตรงข้าม หาก Anthropic หรือผู้เล่นรายอื่นสามารถให้ฟีเจอร์แบบ plug-and-play ที่องค์กรยอมรับได้ ส่วนแบ่งตลาดและอำนาจในการตั้งราคา (pricing power) ของ Atlassian อาจลดลงอย่างถาวร

สรุปแล้ว การปรับตัวของหุ้น Atlassian เมื่อมีข่าวจาก Anthropic เป็นผลจากการประเมินความเสี่ยงว่าฟีเจอร์ AI ใหม่จะขจัดหรือบ่อนทำลายข้อได้เปรียบเชิงผลิตภัณฑ์และโมเดลรายได้ของ Atlassian ในระยะยาว นักลงทุนจึงต้องติดตามตัวชี้วัดเชิงปฏิบัติการ (user retention, net retention rate, new ARR) และสัญญาณการตอบโต้จาก Atlassian เช่น การเปิดตัวฟีเจอร์ AI, การร่วมมือเชิงกลยุทธ์ หรือการควบรวมกิจการ เพื่อประเมินว่าการปรับฐานครั้งนี้เป็นเพียงการตอบสนองระยะสั้นหรือเป็นการเปลี่ยนแปลงโครงสร้างตลาดอย่างแท้จริง

การแข่งขันและปฏิกิริยาจากอุตสาหกรรม

การแข่งขันและปฏิกิริยาจากอุตสาหกรรม

การออกเครื่องมือใหม่จาก Anthropic ที่มีศักยภาพในการพลิกโฉมการพัฒนาซอฟต์แวร์ย่อมกระตุ้นให้ผู้เล่นรายใหญ่ในตลาด AI ตอบโต้ทันที ทั้งในรูปแบบการพัฒนาเทคโนโลยีภายในและการรุกพันธมิตรเชิงกลยุทธ์ ผู้แข่งขันหลักที่ต้องจับตาประกอบด้วย OpenAI (และผลิตภัณฑ์ตระกูล GPT), Microsoft (ซึ่งผสาน AI เข้ากับแพลตฟอร์ม Azure, GitHub, และชุดเครื่องมือสำหรับองค์กร), AWS (ผ่านบริการเช่น Bedrock และโมเดลตลาด), และ GitHub Copilot ที่มีฐานผู้ใช้ด้านการพัฒนาอยู่แล้ว ตัวแปรที่จะเป็นตัวตัดสินการแข่งขันได้แก่ ความแม่นยำของโมเดลในบริบทการเขียนโค้ด, ความสามารถในการปรับแต่งตามโดเมนธุรกิจ, ความเร็วในการประมวลผล, ค่าใช้จ่ายต่อการใช้งานจริง และการรวมเข้ากับสภาพแวดล้อมการพัฒนา (IDE, CI/CD, แพลตฟอร์มการจัดการงาน)

แนวทางตอบโต้ของผู้เล่นเหล่านี้จะมีทั้งการพัฒนาเทคโนโลยีเองและการจับมือเป็นพันธมิตร ตัวอย่างเช่น Microsoft อาจเร่งเพิ่มฟีเจอร์ AI แบบฝังลึกใน Azure DevOps, Visual Studio และ GitHub เพื่อเพิ่มค่าเชื่อมโยงทางธุรกิจ ทำให้ลูกค้าองค์กรไม่ต้องเปลี่ยนระบบมากนัก ในขณะเดียวกัน OpenAI อาจเน้นการออกโมเดลเวอร์ชันเฉพาะทาง (specialized models) หรือข้อตกลงเชิงลึกกับผู้ให้บริการคลาวด์เพื่อจัดส่งโมเดลแบบ latency ต่ำ ส่วน AWS อาจขยายบริการ marketplace และจูงใจพันธมิตรให้สร้างบริการเสริม (plug‑ins, connectors) เพื่อรักษาระบบนิเวศบนคลาวด์ของตน

ในแง่กลยุทธ์พันธมิตร เรามองเห็น 3 แนวทางที่ผู้ขายซอฟต์แวร์องค์กรมักเลือกใช้: (1) ผสานเทคโนโลยีแบบลึก—ผนวกโมเดล AI เข้ากับผลิตภัณฑ์หลักอย่างถาวรเพื่อเพิ่มคุณค่า (เช่น การทำ code suggestions ในระดับ workflow), (2) ร่วมมือกับผู้เชี่ยวชาญ—จับมือกับบริษัทผู้เชี่ยวชาญด้าน LLM เพื่อเพิ่มฟีเจอร์เฉพาะทางอย่างรวดเร็ว และ (3) โมเดลธุรกิจแบบไฮบริด—ปรับโครงสร้างราคาจาก per‑seat ไปสู่การคิดค่าบริการตามการใช้งาน API หรือแพ็คเกจโมดูล ตัวอย่างเชิงปฏิบัติที่เคยเกิดขึ้นคือการรวม GitHub Copilot เข้ากับ Visual Studio ซึ่งช่วยเร่งการยอมรับในหมู่นักพัฒนา และสะท้อนแนวทางที่บริษัทซอฟต์แวร์อื่นอาจเลียนแบบ

ผลกระทบต่อระบบนิเวศของแพลตฟอร์มและพันธมิตรท้องถิ่นจะเห็นได้ชัด ทั้งในด้านโอกาสและความเสี่ยง บริษัทรายกลางที่พึ่งพารายได้จาก marketplace, plugins หรือ consulting อาจเผชิญแรงกดดันจากการที่ฟีเจอร์ AI ถูกฝังเข้าไปในผลิตภัณฑ์หลักของผู้ให้บริการรายใหญ่ ทำให้เกิดความเสี่ยงของการ disintermediation ถึงกระนั้น ตลาดยังเปิดให้ผู้พัฒนารายย่อยและพันธมิตรท้องถิ่นสร้างมูลค่าเพิ่มผ่านการทำ specialization เช่น ปรับโมเดลให้เข้ากับภาษาท้องถิ่น, compliance ของแต่ละประเทศ, หรือการเชื่อมระบบเก่า (legacy integration)

ในภาพรวม การตอบสนองของอุตสาหกรรมจะเป็นการผสมผสานระหว่างการลงทุนด้าน R&D เพื่อรักษาความได้เปรียบเชิงเทคนิค กับการสร้างเครือข่ายพันธมิตรเชิงกลยุทธ์เพื่อขยายการเข้าถึงตลาด ระยะสั้นอาจเห็นการแย่งชิงลูกค้าด้วยข้อเสนอทดลองใช้งานฟรีหรือราคาแนะนำ ระยะยาวผู้ชนะจะเป็นเจ้าที่สามารถนำเสนอระบบนิเวศที่ครบวงจร—รวมถึงเครื่องมือพัฒนา, ตลาดปลั๊กอิน, การสนับสนุนด้านความปลอดภัยและการปฏิบัติตามกฎระเบียบ—พร้อมโมเดลธุรกิจที่ยืดหยุ่นต่อการใช้งานระดับองค์กร

- ปัจจัยตัดสิน: ประสิทธิภาพของโมเดลในงานจริง, ต้นทุนต่อการใช้งาน, ความสามารถในการปรับแต่งและบูรณาการ

- ตอบโต้เชิงเทคนิค: พัฒนา LLM เอง, fine‑tune สำหรับโดเมน, ปรับปรุง latency และ security

- ตอบโต้เชิงพันธมิตร: ผนึกกำลังกับผู้ให้บริการคลาวด์, ผู้ขายซอฟต์แวร์องค์กร และผู้พัฒนา plugin/extension

- ผลต่อระบบนิเวศ: เพิ่มแรงกดดันต่อ marketplace และพันธมิตรท้องถิ่น แต่เปิดโอกาสสำหรับ niche providers ที่เชี่ยวชาญด้านท้องถิ่นและการปฏิบัติตามกฎ

ความเสี่ยงด้านความปลอดภัย กฎหมาย และจริยธรรม

ความเสี่ยงด้านความปลอดภัย: การรั่วไหลของข้อมูลและการฝังช่องโหว่โดยไม่ได้ตั้งใจ

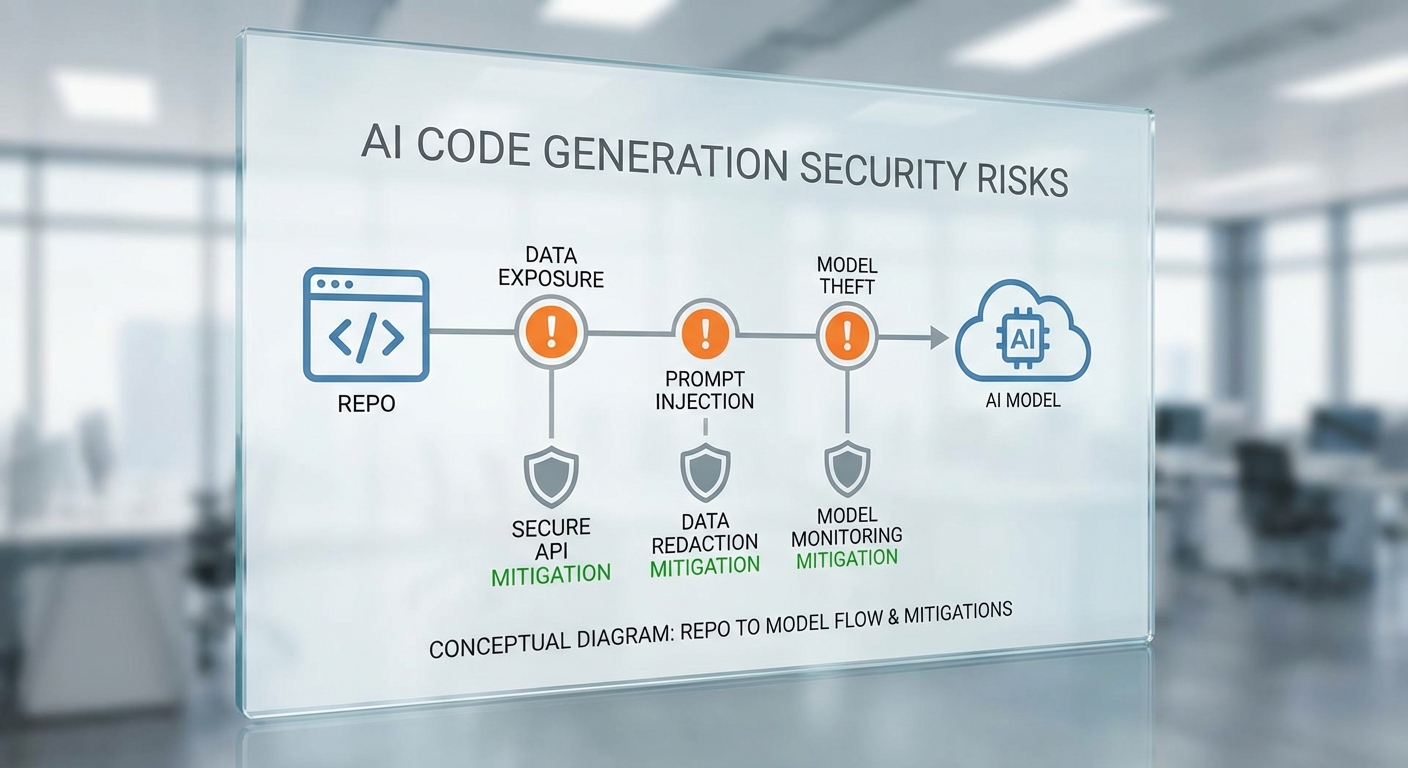

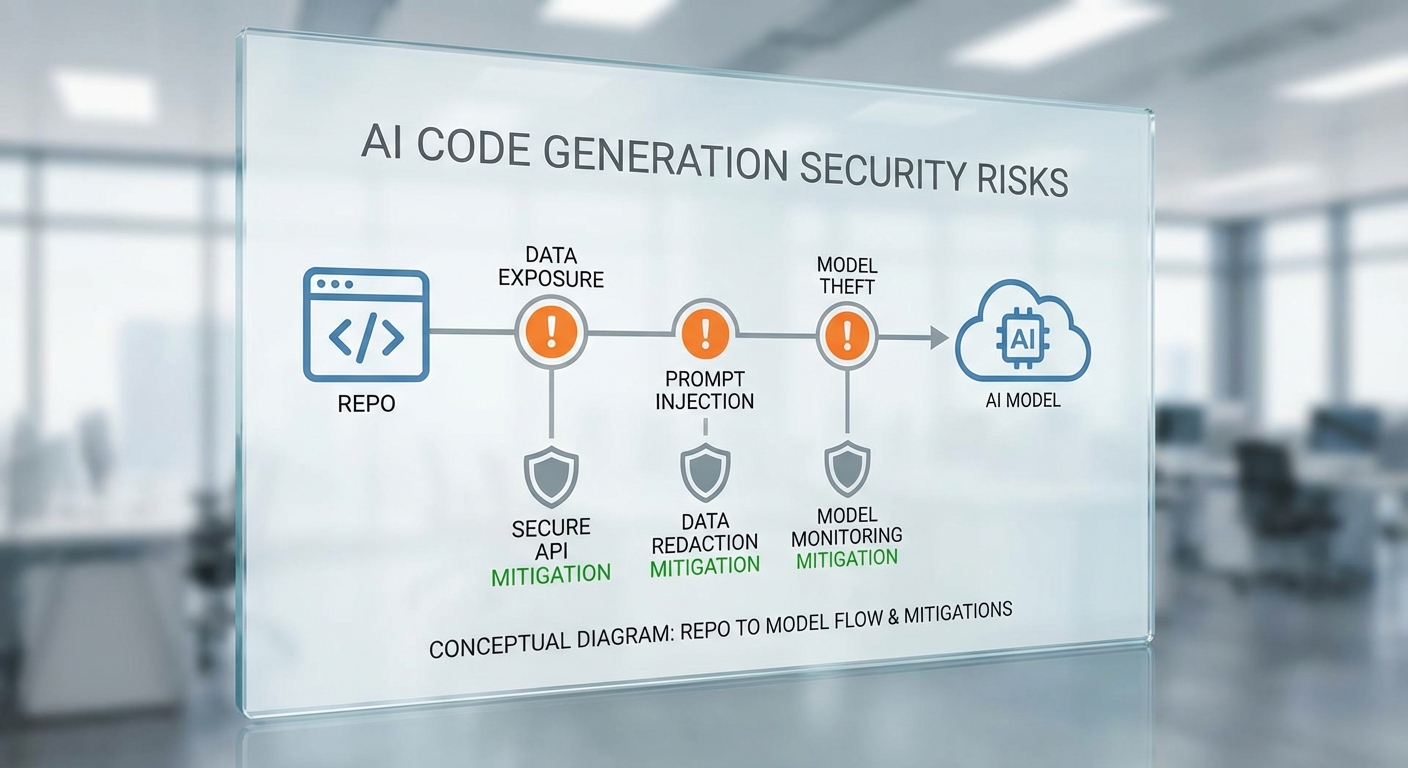

การให้อัลกอริทึม AI เขียนโค้ดและเข้าถึง repository ขององค์กรเปิดช่องทางใหม่สำหรับการรั่วไหลของข้อมูล (data leakage) และการนำเข้าชุดคำสั่งที่มีช่องโหว่โดยไม่ตั้งใจ ตัวอย่างความเสี่ยงที่พบได้บ่อยได้แก่ การสร้างโค้ดที่มี คีย์ API/รหัสผ่านถูกฝัง หรือการเปิดเผยข้อมูลเชิงธุรกิจในคอมเมนต์อัตโนมัติ รวมถึงการแนะนำ pattern ที่ไม่ปลอดภัย เช่น การปิดการตรวจสอบใบรับรอง TLS, การใช้ฟังก์ชันเข้ารหัสที่อ่อนแอ หรือการไม่ตรวจสอบอินพุตของผู้ใช้ เทคนิคการโจมตีรูปแบบ supply chain เช่น การฝัง backdoor ในโค้ดที่ถูกสร้างหรือผสานอัตโนมัติ ก็กลายเป็นความเสี่ยงที่จับต้องได้เมื่อระบบ CI/CD อนุญาตให้โค้ดที่ผลิตจาก AI รันผ่าน pipeline โดยไม่มีการตรวจสอบเพียงพอ

ประเด็นด้านกฎหมายและการละเมิดลิขสิทธิ์

เรื่องสิทธิ์การใช้และการละเมิดลิขสิทธิ์เป็นอีกมิติสำคัญเมื่อใช้โมเดลที่ฝึกบนซอร์สโค้ดสาธารณะ โมเดลอาจคืนผลลัพธ์ที่ใกล้เคียงหรือซ้ำกับโค้ดที่มีลิขสิทธิ์หรืออยู่ภายใต้สัญญาอนุญาตแบบจำกัด (เช่น GPL) ซึ่งอาจทำให้องค์กรเผชิญความเสี่ยงทางกฎหมาย นอกจากนี้ กรอบข้อกำกับดูแลด้านข้อมูลส่วนบุคคล เช่น GDPR ในสหภาพยุโรป กำหนดหน้าที่ของผู้นำข้อมูล (data controller) และผู้ประมวลผล (data processor) ให้ต้องมีมาตรการด้านความปลอดภัยและพื้นฐานทางกฎหมายในการประมวลผลข้อมูลส่วนบุคคล หากเราอนุญาตให้โมเดลเข้าถึง repository ที่มีข้อมูลส่วนบุคคลโดยไม่มีการประเมินผลกระทบด้านความเป็นส่วนตัว (DPIA) หรือข้อตกลงที่ชัดเจน อาจเกิดการละเมิดบทบัญญัติด้านการคุ้มครองข้อมูลและโทษทางปรับได้

กรอบกฎระเบียบและข้อกำกับภายในที่ต้องพิจารณา

นอกเหนือจาก GDPR แล้ว องค์กรควรพิจารณามาตรฐานและข้อกำกับภายในอื่นๆ เช่น ISO 27001, SOC 2 และข้อกำหนดเฉพาะอุตสาหกรรม (เช่น PCI-DSS สำหรับการชำระเงิน หรือ HIPAA สำหรับข้อมูลสุขภาพ) เพื่อกำหนดมาตรการควบคุมการเข้าถึง การเก็บรักษา และการตรวจสอบการใช้โมเดล AI ต่อไปนี้เป็นประเด็นสำคัญที่ต้องประเมิน: สิทธิ์เข้าถึง repo ของโมเดล ใครเป็นเจ้าของข้อมูล/ผลลัพธ์ทางปัญญา (IP ownership) การเก็บ log และการแจ้งเตือนเมื่อพบการละเมิด รวมถึงการกำหนดขอบเขตการใช้งานของโมเดลในสัญญากับผู้ให้บริการ AI ภายนอก

แนวทางการลดความเสี่ยง: Governance, Testing และ Human-in-the-Loop

การจัดการความเสี่ยงจากการใช้ AI ในการพัฒนาโค้ดต้องอาศัยมาตรการเชิงระบบทั้งด้านนโยบาย เทคนิค และบุคลากร โดยแนวทางปฏิบัติที่แนะนำได้แก่

- Governance และนโยบาย — จัดตั้งนโยบายการใช้ AI อย่างชัดเจน (model inventory, permitted data sources, SLA และขอบเขตการใช้งาน) รวมทั้งกำหนดบทบาทความรับผิดชอบ เช่น เจ้าของโมเดล ผู้ควบคุมความเสี่ยง และทีมความปลอดภัยของแอปพลิเคชัน

- การควบคุมการเข้าถึงและการคัดกรองข้อมูล — ใช้หลัก Least Privilege, การเข้ารหัสที่เหมาะสม, และการล้างข้อมูล (data minimization) ก่อนส่งให้โมเดล ตรวจจับและป้องกันการส่ง secrets ไปยังระบบภายนอกด้วย secret-scanner ใน pipeline

- Testing และการตรวจสอบโค้ด — นำ SAST/DAST, dependency scanning, fuzzing, และ static analysis มารวมไว้ใน CI/CD pipeline เพื่อจับ pattern ที่ไม่ปลอดภัยตั้งแต่ต้น รวมถึงการใช้เครื่องมือตรวจสอบความเป็นไปได้ของการละเมิดลิขสิทธิ์และการวิเคราะห์ provenance ของโค้ดที่ได้

- Human-in-the-Loop — กำหนดจุดยับยั้ง (approval gates) ที่ต้องให้มนุษย์ตรวจทานก่อนนำโค้ดที่ AI สร้างไปใช้งานจริง โดยเฉพาะในส่วนที่เกี่ยวกับ security-sensitive หรือ business-critical และจัดให้มี peer review, threat modeling และ security sign-off เป็นมาตรฐาน

- Red teaming และ Continuous Monitoring — จัดให้มีการทดสอบเชิงรุก (red team) เพื่อค้นหาช่องโหว่ที่อาจถูกฝัง และติดตั้งระบบมอนิเตอร์เพื่อตรวจจับพฤติกรรมผิดปกติหลัง deployment พร้อมแผน incident response เฉพาะกรณีที่พบการรั่วไหลหรือการโจมตี

- ข้อกำหนดทางสัญญาและการประเมินผู้ให้บริการ — ในกรณีใช้โมเดลของผู้ให้บริการภายนอก ต้องระบุเงื่อนไขด้าน data processing, IP rights, audit rights และมาตรการรักษาความปลอดภัยในสัญญา รวมถึงการประเมินและตรวจสอบผู้ให้บริการเป็นครั้งคราว

สรุปคือ การนำเครื่องมือ AI มาช่วยเขียนโค้ดให้ประสิทธิภาพและนวัตกรรมไม่จำเป็นต้องมาพร้อมกับความเสี่ยงที่ไม่สามารถจัดการได้ แต่องค์กรต้องวางกรอบการบริหารความเสี่ยงเชิงรุก ประยุกต์ใช้การทดสอบและการตรวจสอบอย่างต่อเนื่อง และรักษา human-in-the-loop เป็นจุดคุมสุดท้ายเพื่อให้การนำ AI มาใช้เกิดประโยชน์สูงสุดโดยไม่ละเลยความปลอดภัย กฎหมาย และจริยธรรม

กรณีศึกษาเบื้องต้นและคำแนะนำสำหรับองค์กร

กรณีศึกษาเบื้องต้น (สรุปผลการทดสอบแบบสมมติ)

จากการจำลองการนำเครื่องมือใหม่ของ Anthropic มาทดสอบในสององค์กรรูปแบบต่างกัน — บริษัท SaaS ขนาดกลางที่พัฒนาผลิตภัณฑ์เว็บ และสถาบันการเงินขนาดใหญ่ที่มีระบบแบ็กเอนด์เชิงธุรกรรม — พบแนวโน้มผลลัพธ์ที่เป็นประโยชน์ต่อการพิจารณาเชิงปฏิบัติการ ตัวอย่างสมมติจาก pilot ขนาด 30 คน (ทีมพัฒนารวม) ระยะเวลา 8 สัปดาห์ แสดงว่าเวลาเฉลี่ยในการแก้บั๊กลดลงจาก 48 ชั่วโมงเหลือ 30 ชั่วโมง (~37% ลดลง) และความครอบคลุมของ unit test เพิ่มขึ้นจากเฉลี่ย 62% เป็น 74% (เพิ่ม 12 จุด) ขณะที่อัตราการเสนอโค้ดที่มีข้อผิดพลาดชัดเจน (false positive/incorrect suggestion) ประเมินไว้ต่ำกว่า 8% โดยมีอัตราการยอมรับคำแนะนำของเครื่องมือโดยนักพัฒนาประมาณ 55% ในบริบท SaaS

สำหรับสถาบันการเงิน pilot แบบเคร่งครัดใน sandbox environment (ทีม 20 คน เป็นเวลา 6 สัปดาห์) ให้ผลว่าเวลาตรวจสอบ PR ลดลง 25% และพบจุดอ่อนด้านความปลอดภัย (security smell) ได้เร็วขึ้นในสเตจต้น (shift-left) ทำให้จำนวนบั๊กเชิงความปลอดภัยที่ถูกส่งขึ้น production ลดลงราว 15% อย่างไรก็ตาม องค์กรนี้พบข้อจำกัดด้านการเชื่อมต่อข้อมูลภายในและความต้องการ masking/PAI (privacy-aware instrumentation) ซึ่งต้องกำหนดนโยบายเพิ่มเติมก่อนขยายใช้งานจริง

ตัวอย่างสคริปต์ทดสอบ (pilot) และ KPI ที่ควรติดตาม

ด้านล่างเป็นสคริปต์ทดสอบแบบสำเร็จรูปที่ CTO/Head of Engineering สามารถนำไปปรับใช้ได้ พร้อมรายการ KPI ที่ชัดเจนเพื่อวัดผล

- ระยะเตรียมการ (Week 0): กำหนดขอบเขตโมดูล (เช่น service A, repository B), เลือก cohort ของนักพัฒนา (10–50 คน), ตั้ง baseline metrics จาก 4 สัปดาห์ก่อนหน้า (เวลาการแก้บั๊ก, coverage, PR lead time)

- สคริปต์ทดสอบเชิงปฏิบัติ (Run per sprint):

- ขั้นตอน 1: ติดตั้ง plugin/extension ของ Anthropic ใน environment sandbox และเชื่อมต่อกับ staging CI/CD (read-only) สำหรับโค้ดเดียว

- ขั้นตอน 2: ให้เครื่องมือวิเคราะห์ PR อัตโนมัติและสร้างคำแนะนำ, สร้าง unit test templates และรันการแนะนำในการแก้บั๊ก

- ขั้นตอน 3: ให้ developer ทำงานตามปกติ บันทึกการยอมรับ/ปฏิเสธคำแนะนำ และเวลาที่เริ่ม/สิ้นสุดการแก้บั๊ก

- ขั้นตอน 4: ทีม QA รัน regression suite และบันทึกผลความล้มเหลว/false negative

- ขั้นตอน 5: ประเมินรายสัปดาห์และปรับ rule set (เช่น ความเข้มข้นของ linting หรือ threshold ของ suggestion)

- KPI ที่ควรวัดชัดเจน:

- Mean Time to Repair (MTTR) — เวลาเฉลี่ยจากการรายงานบั๊กจนปิดการแก้ไข (เป้าหมาย pilot: ลดอย่างน้อย 20%)

- PR Lead Time — เวลาตั้งแต่สร้าง PR จน merge (เป้าหมาย: ลดอย่างน้อย 15%)

- Unit Test Coverage — เปอร์เซ็นต์ความครอบคลุมของเทสต์ในโมดูลที่ทดสอบ (เป้าหมาย: เพิ่ม 8–15 จุด)

- Suggestion Acceptance Rate — เปอร์เซ็นต์คำแนะนำที่นักพัฒนาใช้จริง (ใช้เป็น proxy คุณภาพของคำแนะนำ)

- False Positive / False Negative Rate — อัตราคำแนะนำผิดพลาด ที่ส่งผลต่อความเชื่อถือของทีม (เป้าหมาย: FP <10%, FN ต่ำสุดเท่าที่เป็นไปได้)

- Security Findings Shift-Left — จำนวนช่องโหว่ที่พบก่อน production เทียบกับก่อนใช้เครื่องมือ

- Developer Satisfaction / Productivity Survey — คะแนนคุณภาพและความพร้อมใช้งาน (ควรมี baseline และ post-pilot survey)

- การวัดเชิงสถิติ: ตั้งระยะเวลา pilot อย่างน้อย 4–8 สัปดาห์ (ขึ้นกับการปลดปล่อยสปรินท์) และกำหนดขนาดกลุ่มที่ให้พลังงานเชิงสถิติ — แนะนำ 20+ devs เพื่อความมั่นใจ ผลต่างควรตรวจสอบด้วย t-test หรือ bootstrap เพื่อยืนยันความมีนัยสำคัญ

ขั้นตอนการนำร่อง: ขอบเขต การประเมินความเสี่ยง และการฝึกอบรมทีม

การนำเครื่องมือใหม่เข้าสู่องค์กรควรทำเป็นขั้นตอน มีการกำหนดขอบเขตและการควบคุมความเสี่ยงอย่างชัดเจน:

- กำหนดขอบเขตเชิงเทคนิคและธุรกิจ — ระบุ repository, service, หรือ module ที่จะทดลอง แยก staging/sandbox environment ออกจาก production และตั้งค่าการเข้าถึงข้อมูลแบบ least privilege

- การประเมินความเสี่ยง — ทบทวนประเด็นด้านความเป็นส่วนตัว (PII), กฎระเบียบ (เช่น GDPR), ความเสี่ยงด้านความปลอดภัย (exposure ของ secrets) และความเสี่ยงจากการแนะนำโค้ดที่ผิดพลาด ควรจัดทำ threat model และนโยบาย rollback

- กระบวนการตรวจสอบคุณภาพ — บังคับใช้งาน manual review สำหรับคำแนะนำที่เปลี่ยน logic สำคัญ, ปรับ policy สำหรับคำแนะนำที่แก้ไข security-sensitive code

- การฝึกอบรมและการเปลี่ยนแปลงกระบวนงาน — จัด workshop สอนการใช้งาน, guideline สำหรับการรับ/ปฏิเสธคำแนะนำ, pair-programming sessions ระหว่าง senior engineers กับ tool เพื่อเร่ง adoption และลดความเสี่ยงจาก misuse

- การติดตั้ง instrumentation — เปิดระบบ logging สำหรับ suggestion metadata, ติดตามเวลาแก้บั๊ก, สถานะ PR, และผล regression test เพื่อให้สามารถทำ root-cause analysis เมื่อเกิดปัญหา

- แผนฉุกเฉินและ governance — สร้าง playbook สำหรับ rollback, ระบุ owner ของการตัดสินใจ และทำ periodic review กับทีม security/compliance

คำแนะนำเชิงกลยุทธ์สำหรับ CTO / Head of Engineering

เมื่อพิจารณาจะนำเครื่องมือของ Anthropic เข้าสู่สเตจใช้งานจริง ควรพิจารณาในมุมกลยุทธ์และองค์กรดังต่อไปนี้:

- เกณฑ์ Go/No-Go — ควรก้าวสู่ production เมื่อ KPI หลัก (MTTR, PR lead time, test coverage) แสดงแนวโน้มเชิงบวกอย่างสม่ำเสมอ เช่น ลด MTTR >= 20% และ Suggestion Acceptance >= 40% พร้อมกับ FP rate อยู่ในเกณฑ์ยอมรับได้ และทีม security รับรองการควบคุมความเสี่ยงแล้ว

- เริ่มแบบค่อยเป็นค่อยไป — แนะนำให้กระจาย rollout แบบ staged (เริ่มจาก non-critical services → business-critical internal services → customer-facing services) ใช้ feature flags และ canary releases เพื่อลด blast radius

- ตรวจสอบด้านสัญญาและ SLA — ต่อรองสัญญาที่ครอบคลุมเรื่องข้อมูล, liability, และ time-to-fix ในกรณีที่คำแนะนำก่อให้เกิดปัญหา และตรวจสอบเรื่องการเก็บ logs / audit trail เพื่อการตรวจสอบย้อนหลัง

- วาง governance ระยะยาว — ตั้งคณะกรรมการข้ามฝ่าย (engineering, security, legal, product) เพื่อตรวจสอบผลลัพธ์และปรับนโยบายการใช้งานทุกไตรมาส รวมถึง KPI ที่เปลี่ยนไปตามการเติบโต

- เมื่อต้องรอดู — หยุดหรือล่าชาการนำมาใช้จริงหากพบว่า FP/FN rate สูงจนส่งผลต่อความปลอดภัยหรือความถูกต้องของธุรกิจ, หรือตัวชี้วัด productivity แสดงการถดถอย และกรณีที่ vendor ยังไม่สามารถตอบคำถามด้าน data governance ได้เพียงพอ

- ลงทุนในทักษะคน — แม้เครื่องมือจะเพิ่มประสิทธิภาพ ควรลงทุนฝึกฝนทีมด้าน code review ที่เน้นการตรวจสอบ logic และ security มากขึ้น เพราะเครื่องมือเป็นตัวช่วย ไม่ใช่ตัวทดแทนการตัดสินใจเชิงวิศวกรรม

สรุปคือ การทดสอบอย่างเป็นระบบและการมี governance ที่เหมาะสมจะช่วยให้องค์กรสามารถเก็บประโยชน์จากเทคโนโลยีใหม่ได้โดยควบคุมความเสี่ยงได้ดีขึ้น CTO ควรกำหนดเกณฑ์เชิงปริมาณสำหรับ Go/No-Go และเริ่ม rollout แบบเป็นขั้นตอนพร้อมแผนสำรองและการฝึกอบรมที่ครอบคลุม

บทสรุป

เครื่องมือใหม่จาก Anthropic มีศักยภาพในการเปลี่ยนรูปแบบการพัฒนาซอฟต์แวร์อย่างรวดเร็ว โดยสามารถเพิ่มประสิทธิภาพการเขียนโค้ด, อัตโนมัติกระบวนการทดสอบ และย่นระยะเวลาการส่งมอบผลิตภัณฑ์ ซึ่งส่งผลกระทบถึงโครงสร้างตลาดซอฟต์แวร์ ทั้งในแง่ของคู่แข่ง รายได้จากเครื่องมือสำหรับนักพัฒนา และรูปแบบการให้บริการตัวอย่างเช่น ความเคลื่อนไหวของหุ้น Atlassian หลังข่าวแสดงให้เห็นว่าตลาดตอบสนองอย่างรวดเร็วเมื่อมีนวัตกรรมชิ้นสำคัญ อย่างไรก็ดี ต้องพิจารณาความเสี่ยงด้านเทคนิคและการควบคุมดูแลอย่างรอบคอบ—รวมถึงความเสี่ยงด้านความน่าเชื่อถือของโมเดล, ปัญหาการรวมเข้ากับระบบเดิม, ประเด็นสิทธิ์ทรัพย์สินทางปัญญา และความเสี่ยงด้านความปลอดภัยของข้อมูล—ซึ่งหากละเลยอาจลดทอนประโยชน์ที่คาดหวังได้ ผู้เล่นในตลาดจึงต้องชั่งน้ำหนักศักยภาพทางธุรกิจควบคู่กับมาตรการด้านความเสี่ยง และคำนึงว่ามีรายงานหลายฉบับคาดการณ์การเติบโตของตลาด AI/Generative AI ในระดับสูงในทศวรรษหน้า ทำให้แรงกดดันด้านปรับตัวมีความเข้มข้นขึ้น

สำหรับนักลงทุนและองค์กร ควรติดตามตัวเลขตลาดจริงอย่างใกล้ชิด—เช่น อัตราการยอมรับของลูกค้า, แนวโน้มรายได้จากเครื่องมือใหม่, และการเปลี่ยนแปลงของมาร์จิ้น—เพื่อประเมินผลกระทบทันทีกับแผนการปรับตัวระยะยาว นโยบายที่แนะนำได้แก่ การทำการทดสอบเชิงประจักษ์ (pilot) ก่อนขยายใช้งาน, การประเมินความเสี่ยงของซัพพลายเชนโมเดล, และการจัดตั้งกรอบการกำกับดูแล (governance) เช่น การบริหารความเสี่ยงของโมเดล, การควบคุมการเข้าถึงข้อมูล และแผนตอบโต้เหตุการณ์ด้านความปลอดภัย นอกจากนี้มุมมองอนาคตบ่งชี้ว่าในระยะสั้นตลาดอาจเกิดความผันผวนขณะที่ผู้เล่นปรับตัว แต่ในระยะกลาง-ยาว บริษัทที่ลงทุนในมาตรการความปลอดภัยและโครงสร้างการกำกับดูแลที่แข็งแกร่งพร้อมกับแผนปรับเปลี่ยนธุรกิจจะได้เปรียบในการรักษาผลตอบแทนและความยั่งยืนของธุรกิจ

📰 แหล่งอ้างอิง: AFR