การออกแบบกระจกพลาสมาพลังสูงโดยอาศัยการเรียนรู้ของเครื่อง (Machine Learning) กลายเป็นหนึ่งในแนวหน้าของการวิจัยด้านแสงและเลเซอร์ระดับสูง ที่ผสานความเข้าใจเชิงฟิสิกส์เข้ากับการวิเคราะห์ข้อมูลเชิงลึก ทำให้การพัฒนาชิ้นส่วนที่ทนต่อพลังงานสูงและมีประสิทธิภาพสะท้อนแสงสูงเป็นไปได้รวดเร็วขึ้นและแม่นยำขึ้น งานวิจัยล่าสุดจากกลุ่มนักฟิสิกส์และวิศวกรชี้ให้เห็นว่าการใช้โมเดลตั้งแต่ Convolutional Neural Networks (CNN) และ Gaussian Process Regression จนถึง Bayesian optimization และ Physics-Informed Neural Networks ช่วยปรับโครงร่างพื้นผิวและพารามิเตอร์การจัดวางชั้นวัสดุจนได้ผลลัพธ์ที่ดีกว่าการออกแบบแบบดั้งเดิมอย่างมีนัยสำคัญ

บทความฉบับนี้สรุปหลักการพื้นฐาน เทคนิคการฝึกสอน (เช่น multi-fidelity training, active learning, transfer learning จากการทดลองพลังงานต่ำสู่พลังงานสูง) รูปแบบโมเดลที่ใช้ และผลการทดลองต้นแบบที่แสดงให้เห็นการเพิ่มประสิทธิภาพสะท้อนแสงในระดับตัวอย่าง (เช่นการเพิ่มขึ้นของค่าสะท้อนในช่วงประมาณ 15–30% ในสภาวะทดลองบางชุด) พร้อมด้วยการลดเวลาออกแบบและลองผิดลองถูกได้หลายเท่า (รายงานว่าลดเวลาการออกแบบเชิงทดลองได้มากกว่า 5 เท่าในบางกรณี) สุดท้ายบทนำนี้ยังชี้ให้เห็นศักยภาพเชิงอุตสาหกรรมของแนวทางดังกล่าว ทั้งในระบบเลเซอร์ความเข้มสูงสำหรับงานตัดเฉือนและการผลิต, การวิจัยฟิสิกส์ระดับสูงเช่นการเร่งอนุภาคและฟิวชันเชื้อเพลิง, รวมถึงการใช้งานในทางการแพทย์และการวัดเชิงแม่นยำ ซึ่งทั้งหมดนี้กำลังเคลื่อนจากห้องปฏิบัติการไปสู่การประยุกต์ใช้เชิงพาณิชย์ในไม่ช้า

ภาพรวมและความสำคัญของการวิจัย

ภาพรวมและความสำคัญของการวิจัย

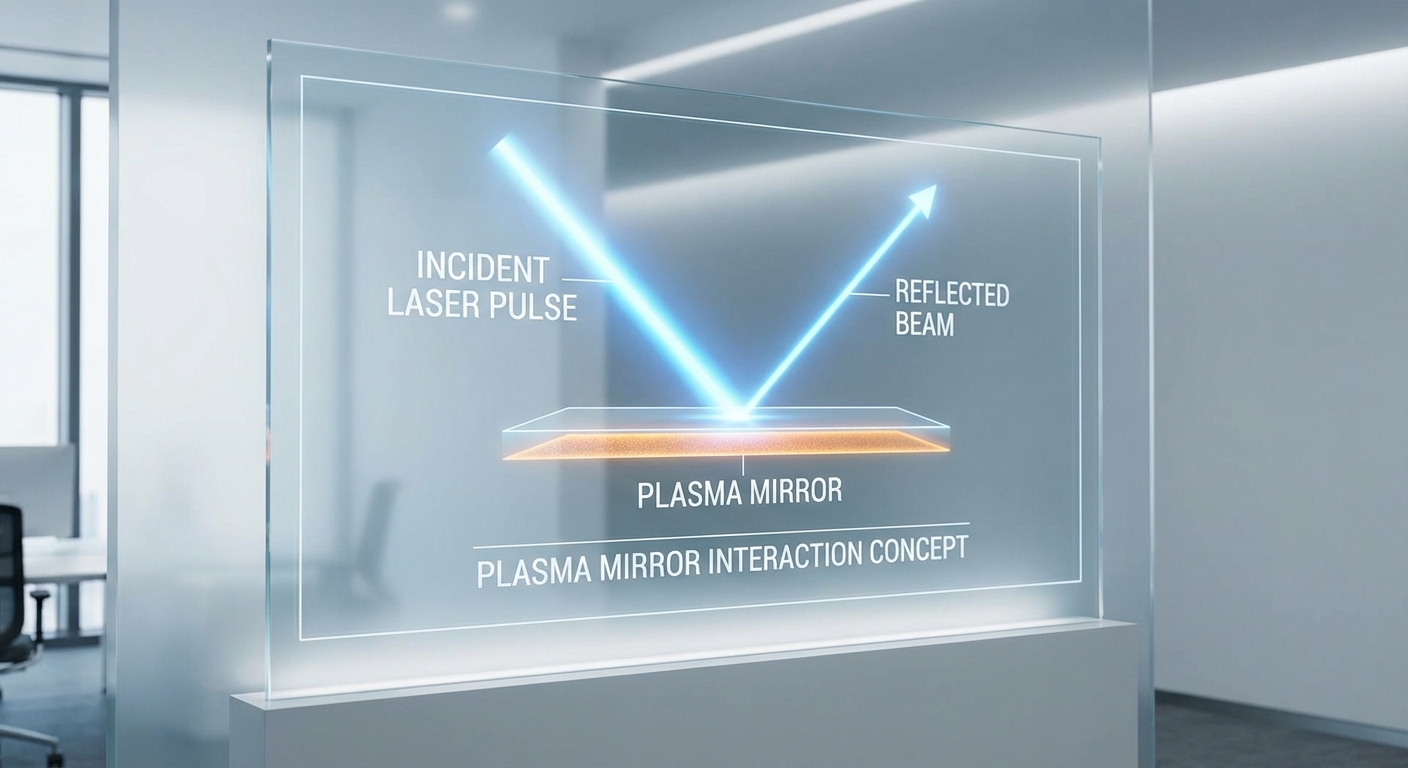

Plasma mirror คือเทคนิคและอุปกรณ์เชิงแสงที่ใช้ชั้นของพลาสมาเพื่อสะท้อนลำแสงเลเซอร์ความเข้มสูง โดยทำหน้าที่เป็นกระจกที่เกิดขึ้นชั่วคราวเมื่อเลเซอร์ยิงลงบนวัสดุทำให้เกิดการไอออไนซ์จนเปลี่ยนพื้นผิวเป็นพลาสมาแล้วสะท้อนพัลส์หลักกลับไปยังทิศทางที่ต้องการ เทคโนโลยีนี้มีบทบาทสำคัญในการจัดการ temporal contrast ของแหล่งกำเนิดแสงความเข้มสูง เช่น เลเซอร์ระดับเทระวัตต์ถึงเพตะวัตต์ (10^12–10^15 W) ซึ่งจำเป็นต่อการทดลองฟิสิกส์แรงสูง การสร้างพัลส์แอตโตวินาที และการปกป้องออปติกส์ที่อ่อนไหวจากพัลส์ก่อนหน้า

เหตุผลที่การออกแบบ plasma mirror สำหรับงานพลังงานสูงมีความสำคัญมากมาจากข้อจำกัดเชิงเทคนิคหลายประการ เช่น damage threshold ของวัสดุที่ต้องทนต่อฟลูเอนซ์และพลังงานสูง, การควบคุม temporal contrast ให้เพียงพอต่อการลด pre-pulse และ pedestal ที่อาจทำลายเป้าหมายก่อนพัลส์หลัก, รวมถึงความไม่สม่ำเสมอของพื้นผิวและความไม่เสถียรของพลาสมาที่ก่อให้เกิดการเบี่ยงเบนเชิงมุมและการกระจายสเปกตรัม ข้อจำกัดเหล่านี้ส่งผลโดยตรงต่อคุณภาพลำแสงและความซ้ำได้ของการทดลอง ตัวอย่างเช่น การทดลองที่ต้องการความเข้มสูงกว่า 10^18 W/cm^2 มักต้องการ temporal contrast เพิ่มขึ้นเป็นระดับ 10^8–10^10 เพื่อหลีกเลี่ยงผลของ pre-plasma ที่ไม่พึงประสงค์

ปัญหาเชิงเทคนิคที่พบโดยทั่วไปได้แก่:

- Damage threshold: วัสดุรองรับการไอออไนซ์และการระเหย ภายใต้ฟลูเอนซ์สูง อาจเกิดการสึกหรอหรือทำลายแบบไม่สามารถใช้งานซ้ำได้

- Temporal contrast: การลด pre-pulse และ pedestal เป็นเรื่องท้าทาย โดยเฉพาะเมื่อความต้องการ contrast เพิ่มขึ้นสำหรับการสร้างพัลส์สั้นหรือการทดลองที่ไวต่อสัญญาณรบกวน

- Surface irregularities และ shot-to-shot variability: พลาสมาเกิดขึ้นแบบไม่สม่ำเสมอ ทั้งจากความไม่สอดคล้องของวัสดุ รูปร่าง และการโต้ตอบที่ไม่เชิงเส้นของเลเซอร์–พลาสมา ทำให้การสะท้อนและเฟสของลำแสงเปลี่ยนแปลงได้

การนำ Machine Learning (ML) เข้ามาช่วยในการออกแบบและควบคุม plasma mirror ถือเป็นก้าวสำคัญ เนื่องจากปัญหาที่ต้องจัดการมีความซับซ้อนสูงและพื้นที่พารามิเตอร์ (design space) มีมิติสูง ML สามารถช่วยในหลายด้าน ได้แก่ การสร้าง surrogate models เพื่อทดแทนการจำลองเชิงฟิสิกส์ที่ใช้เวลานาน, การทำ inverse design เพื่อค้นหาชุดพารามิเตอร์ (เช่น ความหนาของฟิล์ม มุมการตกกระทบ รูปร่างโพรไฟล์พัลส์ และจังหวะ pre-pulse) ที่ให้ผลลัพธ์ตามต้องการ, และการควบคุมแบบเรียลไทม์ผ่าน reinforcement learning หรือ adaptive feedback เพื่อปรับการตั้งค่าในภาคสนามแบบ shot-to-shot

ในระดับสถาบันและอุตสาหกรรม ผู้เล่นหลักในวงการที่ร่วมพัฒนาเทคโนโลยีนี้ได้แก่ห้องปฏิบัติการแสงขั้นสูงเช่น Extreme Light Infrastructure (ELI), สถาบันวิจัยคลื่นเลเซอร์ของมหาวิทยาลัยและห้องปฏิบัติการระดับชาติอย่าง SLAC, Lawrence Livermore National Laboratory, และกลุ่มวิจัยชั้นนำในยุโรปและเอเชีย (เช่น Max Planck Institute, CEA, RIKEN) แนวโน้มงานวิจัยล่าสุดเน้นการผสมผสานระหว่างฟิสิกส์เชิงทฤษฎี การจำลองแบบหลายสเกล (multi-scale) และเครื่องมือ ML เช่น physics-informed neural networks, differentiable simulators และ generative models เพื่อเร่งการค้นหาและปรับแต่งดีไซน์ โดยรายงานจากวารสารด้านแสงและเลเซอร์ชี้ว่าการใช้ surrogate models สามารถลดเวลาการออกแบบลงจากสัปดาห์เป็นชั่วโมงหรือแม้แต่เป็นนาที ขึ้นกับความซับซ้อนของแบบจำลอง

สรุปได้ว่า การวิจัยด้านการออกแบบ plasma mirror ที่อิงจากการเรียนรู้ของเครื่องไม่เพียงแต่ช่วยยกระดับประสิทธิภาพของระบบเลเซอร์ความเข้มสูง แต่ยังเปิดหนทางสู่การใช้งานที่เชื่อถือได้และคุ้มค่าทางเศรษฐกิจสำหรับแอปพลิเคชันทั้งในงานวิจัยขั้นพื้นฐานและการนำไปใช้เชิงอุตสาหกรรม เช่น การผลิตพัลส์อัลตร้าสั้น การประยุกต์ด้านการเร่งอนุภาค และการตรวจวัดเวลาที่แม่นยำ

พื้นฐานเชิงฟิสิกส์ของกระจกพลาสมา

พื้นฐานเชิงฟิสิกส์ของกระจกพลาสมา

กระจกพลาสมา (plasma mirror) เป็นปรากฏการณ์การสะท้อนแสงที่เกิดเมื่อพื้นผิววัสดุถูกยิงด้วยพัลส์เลเซอร์ความเข้มสูงจนเกิดการไอออนไนเซชันเป็นพลาสมาในชั้นผิวบางๆ ชั้นพลาสมาที่เกิดขึ้นจะมีความหนาและความหนาแน่นอิเล็กตรอน (electron density, n_e) ที่มากกว่าค่าความหนาแน่นวิกฤต (critical density, n_c) สำหรับความถี่ของเลเซอร์นั้นๆ ทำให้คลื่นแม่เหล็กไฟฟ้าถูกสะท้อนเหมือนพื้นผิวโลหะ ความหนาแน่นวิกฤตคำนวณจากความถี่ของคลื่นว่า n_c = ε0 m_e ω^2 / e^2 ซึ่งโดยประมาณในหน่วยเซนติเมตร-ลูกบาศก์คือ n_c ≈ 1.1×10^21 cm^-3 / (λ[μm])^2 — ตัวอย่างเช่น สำหรับเลเซอร์ Ti:Sapphire ที่ λ = 0.8 μm ค่า n_c ≈ 1.7×10^21 cm^-3

กระบวนการสร้างพลาสมาขึ้นอยู่โดยตรงกับความเข้มของเลเซอร์ (intensity) และพัลส์ชั่วคราว ในช่วงความเข้มที่กว้างซึ่งมีการใช้งานจริงตั้งแต่ประมาณ 10^16 ถึง 10^22 W/cm^2 จะเกิดพฤติกรรมต่างกันที่ควรรู้: ที่ระดับ ~10^16–10^18 W/cm^2 การไอออนไนเซชันทางสนามไฟฟ้า (optical field ionization) และการชนชนิดต่างๆ จะสร้างชั้นพลาสมาบางๆ ที่มีความหนาแน่นมากกว่า n_c ทำให้เกิดการสะท้อนที่มีประสิทธิภาพ ในขณะที่เมื่อความเข้มเพิ่มขึ้นเกิน ~10^18 W/cm^2 พารามิเตอร์เชิงไม่เชิงสัมพันธ์ (normalized vector potential a0) จะเกิน 1 และผลทางสัมพัทธภาพ (relativistic effects) เริ่มสำคัญ ค่า a0 ประมาณ 0.85·sqrt(I[10^18 W/cm^2])·λ[μm] ใช้บ่งชี้ว่าที่ความเข้มสูงพลังงานของอิเล็กตรอนเพิ่มขึ้น (γ > 1) ทำให้ effective critical density เพิ่มขึ้นตามค่า γ ซึ่งนำไปสู่ปรากฏการณ์เช่น relativistic transparency หรือการเปลี่ยนแปลงการสะท้อนเมื่อเทียบกับกรณีไม่สัมพัทธภาพ

ความสัมพันธ์ระหว่างโปรไฟล์ความหนาแน่น (density profile) และการสะท้อน/การกระเจิงมีความละเอียดอ่อนมาก หากโปรไฟล์มีความชันคม (sharp interface, scale length L << λ) ชั้นพลาสมาจะทำหน้าที่เป็นกระจกเชิงเสา (specular reflector) ที่มีค่าการสะท้อนสูงและค่าการกระเจิงต่ำ ในทางกลับกัน ถ้าพรีพลาสมา (preplasma) มี scale length L ที่ยาว (L ~ 0.1–1 λ) คลื่นจะถูกดูดซับ กระเจิงกระจัดกระจาย และเกิดการสร้างฮาร์มอนิกสูง (harmonic generation) หรือการกระเจิงไม่เป็นเส้นตรง การออกแบบกระจกพลาสมาจึงมักเน้นการควบคุมพรีพัลส์และ scale length ให้สั้น—ทั่วไปในงานทดลองจะต้องการ L ในช่วงหลายสิบถึงร้อยนาโนเมตร (สำหรับ λ ~ 0.8 μm ให้ L ≲ λ/10) เพื่อให้ได้การสะท้อนเชิงเส้นสูงและลดการสูญเสียพลังงาน

ในการประเมินเชิงปฏิบัติของกระจกพลาสมา จะใช้ตัวชี้วัดหลักหลายประการดังนี้:

- Reflectivity (R): สัดส่วนพลังงานที่สะท้อนกลับจากชั้นพลาสมา ค่าที่รายงานในงานทดลองสำหรับ plasma mirror ที่สภาพดีมักอยู่ในช่วง ~60–90% ขึ้นกับความเข้ม รูปแบบพัลส์ และ scale length การใช้ระบบ double plasma mirror อาจลด throughput แต่เพิ่ม temporal contrast ได้มาก

- Temporal contrast: อัตราส่วนระหว่างพีคพัลส์กับสัญญาณก่อนหน้า (prepulse/pedestal) — plasma mirror สามารถปรับปรุง contrast ได้หลายทศนิยม (ทั่วไป 10^2–10^4 ต่อหนึ่งกระจก ขึ้นกับการตั้งค่า) ทำให้ปัญหาพรีพลาสมาลดลงและรักษาสภาพพื้นผิวก่อนพัลส์หลัก

- Surface roughness: ความขรุขระของพื้นผิววัสดุก่อนถูกยิงมีผลต่อการกระเจิงและความคงทน RMS roughness ควรมีค่าน้อยกว่าเศษส่วนของความยาวคลื่น (โดยทั่วไป << λ/10) เพื่อรักษาการสะท้อนเชิงเส้นและลด scattering—ในทางปฏิบัติ การขัดพื้นผิวในระดับนาโนถึงสิบๆ นาโนเมตรมักเป็นมาตรฐาน

- Damage threshold / operational threshold: สำหรับการใช้งานจริง ต้องแยกความแตกต่างระหว่างเกณฑ์การเกิดพลาสมา (ที่ต้องการ) กับเกณฑ์ความเสียหายถาวรของวัสดุ (substrate damage). เกณฑ์ฟลูเอนซ์บังคับให้เกิดพลาสมาและการเปลี่ยนแปลงผิวมักอยู่ในช่วงประมาณ 0.1–10 J/cm^2 สำหรับพัลส์เฟมโต-พิโควินาที ขึ้นกับวัสดุและความกว้างพัลส์ ดังนั้นการออกแบบต้องสมดุลระหว่างการสร้างพลาสมาเพื่อการสะท้อนและการรักษาระยะใช้งานของชิ้นงาน

นอกจากนี้ยังมีพารามิเตอร์เชิงฟิสิกส์ที่ควรพิจารณาเมื่อต้องการทำนายการตอบสนองของกระจกพลาสมา เช่น skin depth ของพลาสมา δ ≈ c/ω_p ≈ (λ/2π)·√(n_c/n_e) ซึ่งสำหรับ n_e ≫ n_c จะสั้นมาก (ระดับสิบๆ นาโนเมตรสำหรับ n_e ~ 10^2 n_c ที่ λ~0.8 μm) ทำให้การสะท้อนเกิดจากชั้นบางและพฤติกรรมเป็นแบบผิวเผิน การออกแบบที่ดีจะรวมการควบคุม temporal contrast ของเลเซอร์ การเลือกมุมตกกระทบ และการจัดการวัสดุเพื่อให้ได้ reflectivity สูงสุดพร้อม damage rate ต่ำที่สุด — ข้อสรุปคือความเข้าใจและการจัดการโปรไฟล์ความหนาแน่นเชิงเวลารวมทั้งการควบคุมพรีพัลส์เป็นหัวใจสำคัญของการสร้าง plasma mirror ที่มีประสิทธิภาพในงานที่ต้องการพลังงานสูง

เทคนิคการเรียนรู้ของเครื่องที่เหมาะสม

เทคนิคการเรียนรู้ของเครื่องที่เหมาะสม

ในการออกแบบกระจกพลาสมาที่ใช้พลังงานสูง การเลือกและปรับใช้เทคนิคการเรียนรู้ของเครื่องต้องสอดคล้องทั้งเชิงฟิสิกส์และเงื่อนไขการทดลองจริง โดยทั่วไประบบงานจะแบ่งเป็นสามชั้นหลัก: (1) การแมปพื้นผิวและพฤติกรรมการสะท้อนแสงด้วยโมเดลที่เรียนแบบจากข้อมูล, (2) การบังคับเงื่อนไขเชิงฟิสิกส์ผ่านแบบจำลองที่ฝังสมการฟิสิกส์, และ (3) การปรับพารามิเตอร์เชิงทดลองแบบอัตโนมัติด้วยนโยบายการเรียนรู้หรือการหาค่าสูงสุดแบบเชิงสถิติ การใช้ชุดวิธีร่วมกันช่วยให้ได้โมเดลที่ไม่เพียงแม่นยำเท่านั้น แต่ยังมีความน่าเชื่อถือเมื่อนำไปใช้ในห้องทดลองจริงและการผลิตเชิงอุตสาหกรรม

ตัวอย่างโมเดลที่เหมาะสมและข้อกำหนดเชิงเทคนิคมีดังนี้:

- Convolutional Neural Networks (CNN) — เหมาะสำหรับการแมประหว่างโครงสร้างพื้นผิว (surface topology, groove pattern) กับฟังก์ชันการสะท้อน (reflectance map) สถาปัตยกรรมที่นิยมได้แก่ U-Net หรือ ResNet-based encoder-decoder เพื่อรักษาข้อมูลเชิงพื้นที่และรายละเอียดความถี่สูง ตัวแปรเป้าหมาย เป็นค่า reflectivity spectrum หรือ pixel-wise reflectance function. Loss หลักมักใช้ Mean Squared Error (MSE) ร่วมกับ perceptual loss หรือ gradient loss เพื่อรักษาขอบเขตและรายละเอียด เมตริกการฝึกสำคัญได้แก่ MSE ของฟังก์ชันสะท้อน, PSNR และ structural similarity (SSIM)

- Physics-Informed Neural Networks (PINN) — ใช้เมื่อนำเงื่อนไขเชิงฟิสิกส์ (เช่น สมการแมกซ์เวลล์สำหรับการแพร่กระจายคลื่นพลาสมา, เงื่อนไขขอบเขตทางไฟฟ้าและแม่เหล็ก) เข้ามารวมในฟังก์ชันความสูญเสีย โดย loss จะเป็นผลรวมระหว่าง data loss (จาก simulation/exp. shots) และ physics residual loss (ค่าความเบี่ยงเบนจากสมการเชิงอนุพันธ์) สถาปัตยกรรม อาจเป็น fully-connected network ขนาดกลางที่รับพิกัดเชิงพื้นที่และพารามิเตอร์สภาวะ เป็นประโยชน์ในการให้คำมั่นทางฟิสิกส์และลด overfitting เมื่อข้อมูลทดลองมีจำกัด

- Reinforcement Learning (RL) — เหมาะสำหรับการควบคุมเชิงทดลองแบบปิดวงจรเพื่อปรับพารามิเตอร์การยิง (pulse energy, timing, focal position) ให้ได้ reflectivity สูงสุด หรือลดการสึกหรอของพื้นผิว นิยาม state = สถานะปัจจุบันของพื้นผิว + เซนเซอร์วัดผล, action = การปรับพารามิเตอร์การยิง (ต่อเนื่อง), reward = uplift ใน reflectivity (%) หรือค่าบวก-ลบผสมกับ penalize สำหรับ damage ตัวอย่างอัลกอริธึมที่ใช้ได้แก่ PPO สำหรับนโยบายที่เสถียร หรือ DDPG/SAC สำหรับ action space แบบต่อเนื่อง

- Bayesian Optimization (BO) — ประหยัดทรัพยากรสำหรับการหาค่าสูงสุดของฟังก์ชันที่มีค่าใช้จ่ายสูง (เช่น การยิงทดลองจริงแต่ละครั้งมีต้นทุน) โดยใช้ Gaussian Process (GP) เป็น surrogate model และใช้ acquisition functions (Expected Improvement, Upper Confidence Bound) เพื่อเลือกจุดทดลองถัดไป เป้าหมาย อาจเป็นการเพิ่ม reflectivity โดยตรงหรือการลด MSE ของโมเดลทำนาย BO มักใช้คู่กับ RL หรือใช้เป็นขั้นตอน tuning ก่อนสตาร์ทนโยบาย RL

ในเชิงข้อมูลที่ใช้ฝึกและประเมิน โมเดลต้องพิจารณาแหล่งข้อมูลหลากหลายเพื่อความทั่วไป (generalization):

- Simulated datasets (PIC — Particle-In-Cell) — มักใช้เป็นแหล่งข้อมูลหลักเมื่อการทดลองจริงมีข้อจำกัด จำนวนตัวอย่างที่ใช้ได้ทั่วไปในงานวิจัยอยู่ระหว่าง 10,000–100,000 shots ขึ้นกับความละเอียดของพารามิเตอร์ การใช้ simulation ช่วยให้สร้างข้อมูลครอบคลุม edge cases และวัด residual ของ PINN

- Experimental shots — ข้อมูลจริงจากห้องทดลองมีมักมีขนาดตั้งแต่หลายร้อยถึงไม่กี่พันรายการ การรวม experimental data เพื่อ fine-tune โมเดลที่เทรนจาก simulation จะลด domain gap และปรับ calibration ของโมเดล

- Data augmentation — เทคนิคเช่น noise injection, geometric transforms (rotation/mirroring สำหรับพื้นผิวที่เป็น isotropic), domain randomization, physics-consistent perturbations ช่วยเพิ่ม robustness และลด overfitting โดยเฉพาะเมื่อ experimental data น้อย

เมตริกการประเมินที่ต้องเฝ้าติดตามอย่างเคร่งครัด ได้แก่:

- MSE ของฟังก์ชันสะท้อน — ค่าหลักที่ใช้วัดความผิดพลาดเชิงปริมาณระหว่างการทำนายกับข้อมูลจริง (target: ลด MSE ลงอย่างมีนัยสำคัญจาก baseline เช่น ลด 20–50% ขึ้นกับปัญหา)

- Uplift ใน reflectivity (%) — มาตรวัดเชิงการดำเนินงานที่ตรงกับวัตถุประสงค์ทางธุรกิจ เช่น การออกแบบใหม่ที่ให้ uplift 5–15% ใน reflectivity อาจถือว่ามีคุณค่าเชิงเชิงธุรกิจสูง ขึ้นกับข้อจำกัดทางต้นทุนและความเสี่ยง

- Latency — ระยะเวลาในการ inference หรือเวลาตอบสนองในระบบปิดวงจร เช่น เป้าหมาย latency ต่ำกว่า 100 ms สำหรับการปรับพารามิเตอร์แบบเรียลไทม์ หรือในกรณี batch processing อาจยอมรับ latency สูงขึ้น แต่ต้องควบคุม throughput และค่าใช้จ่ายการคำนวณ

ในเชิงการฝึกจริง คำแนะนำเชิงปฏิบัติรวมถึงการตั้งค่าที่มักใช้: learning rate ระหว่าง 1e-4–1e-3 สำหรับ CNN/PINN, batch size 16–128 ขึ้นกับหน่วยความจำ GPU, early stopping และ weight decay เพื่อป้องกัน overfitting และการผสม loss ระหว่าง data loss กับ physics loss ใน PINN โดยใช้ weighting scheme ที่ปรับได้ระหว่าง 0.1–10 ขึ้นกับความเชื่อถือของข้อมูลทดลอง การประเมินความไม่แน่นอน (uncertainty quantification) ผ่าน MC dropout หรือ ensemble models ช่วยให้การตัดสินใจเชิงการทดลองมีความปลอดภัยมากขึ้น

สุดท้าย การผสานระหว่างวิธีการ — เช่น ใช้ CNN/UNet เป็น surrogate model, ฝังเงื่อนไขฟิสิกส์ด้วย PINN เพื่อให้คงฟิสิกส์พื้นฐาน และใช้ BO/RL สำหรับการหาพารามิเตอร์การทดลองที่เหมาะสม — มักให้ผลลัพธ์ที่ดีที่สุดทั้งในแง่ประสิทธิภาพการสะท้อน, ความยืดหยุ่นต่อความไม่แน่นอน และต้นทุนการทดลอง การกำหนดเกณฑ์ความสำเร็จควรรวมทั้ง MSE, uplift ใน reflectivity และ latency เพื่อให้สอดคล้องกับข้อจำกัดเชิงการปฏิบัติและเชิงธุรกิจ

การจำลองและการตั้งค่าการทดลอง

เครื่องมือจำลองยอดนิยมและซอฟต์แวร์ที่ใช้

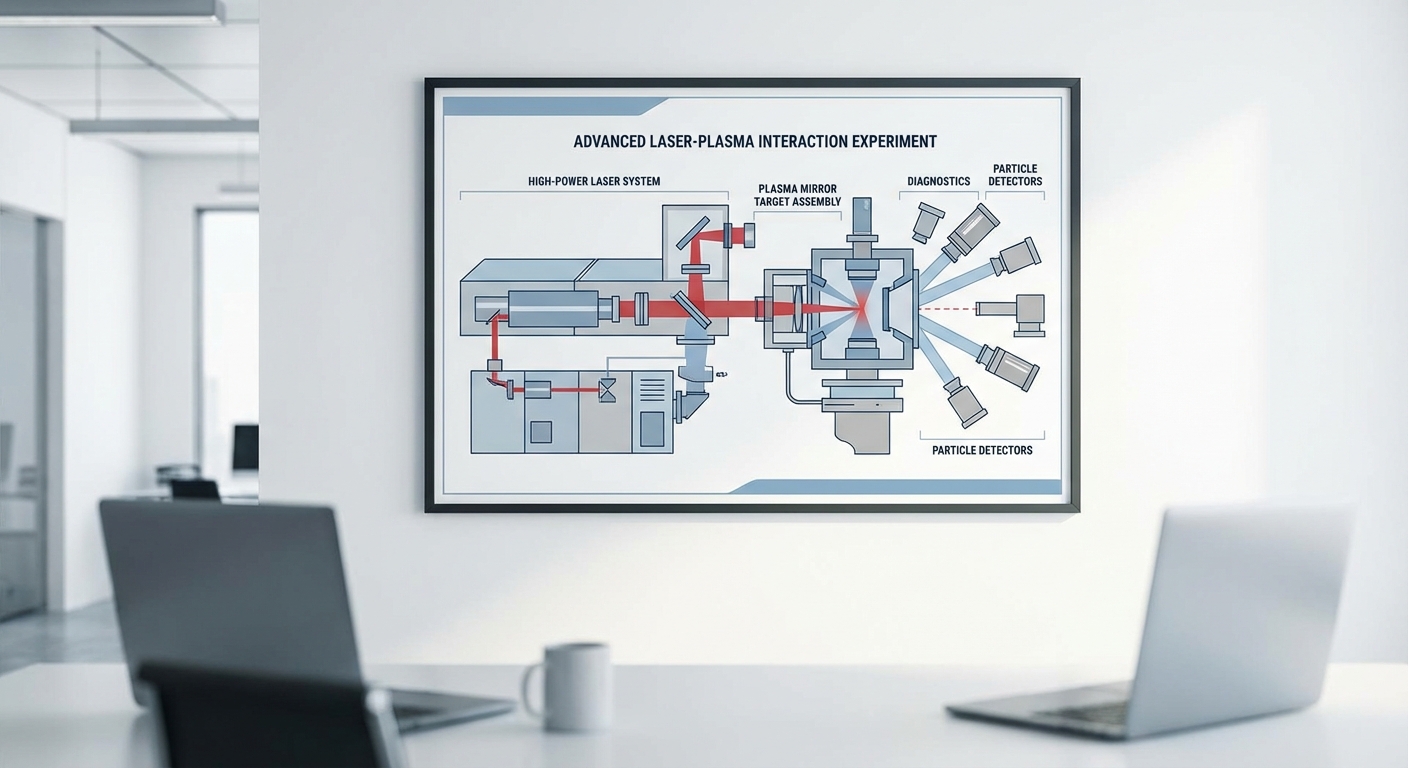

ในการออกแบบกระจกพลาสมาที่ใช้พลังงานสูง งานวิจัยส่วนใหญ่พึ่งพาการจำลองเชิงสนามแม่เหล็ก-พลาสม่าแบบละเอียดโดยใช้ทั้งวิธี Particle-in-Cell (PIC) และ Finite-Difference Time-Domain (FDTD) เพื่อจับพฤติกรรมของอนุภาคและสนามแม่เหล็ก/ไฟฟ้าในโดเมนเวลาจริง ตัวอย่างซอฟต์แวร์ที่ใช้งานได้แก่:

- PIC: OSIRIS, EPOCH, WarpX, Smilei — เหมาะสำหรับการจำลองการชนกันของลำแสงกับพลาสมา การเกิดพลาสมาและการเร่งอนุภาค

- FDTD: MEEP, Lumerical/Ansys Lumerical, CST — เหมาะสำหรับการจำลองการแพร่กระจายของคลื่นแม่เหล็กไฟฟ้าในโครงสร้างและการคำนวณรูปแบบสนามใกล้-ไกล

- ฮาร์ดแวร์และสภาพแวดล้อม: คลัสเตอร์ HPC/GPU (NVIDIA A100/Quadro), MPI/OpenMP, และระบบจัดการคิวแบบ Slurm สำหรับการรันพารามิเตอร์สวีปจำนวนมาก

ขั้นตอนการจำลองและการสร้างชุดข้อมูล (dataset)

Workflow ปกติเริ่มจากการกำหนดพารามิเตอร์เชิงกายภาพ แล้วรันชุดจำลองแบบสหสเกล (multi-scale) เพื่อให้ได้ทั้งผลลัพธ์เชิงอนุภาคและเชิงสนาม ตัวอย่างขั้นตอนสำคัญคือ:

- กำหนดตัวแปรควบคุมหลัก: pulse energy, pulse duration, central wavelength, focal spot size, polarization, incident angle, plasma density/profile, target geometry, prepulse

- เลือกเกรดความเที่ยงตรง: ใช้ PIC สำหรับรายละเอียดอนุภาค (mesh ขั้นต่ำเช่น Δx ~ λ/20–λ/50, timestep ตามเงื่อนไข CFL) และ FDTD สำหรับการคำนวณรูปแบบสนามไกล (far-field) และการสะท้อน

- กำหนดการวินิจฉัย (diagnostics): field dumps (Ez, Ex, Bx), particle phase-space, energy spectra, far-field transform เพื่อคำนวณ reflectivity และ speckle pattern

ในงานวิจัยเชิงปฏิบัติ นิยมสร้างชุดข้อมูลเชิงสังเคราะห์ขนาดใหญ่เพื่อเทรนโมเดล ML — ขนาดตัวอย่างที่ใช้บ่อยคือ 10,000–100,000 simulated shots ควบคู่กับ hundreds of real shots สำหรับการปรับจูนและตรวจสอบ (validation). ข้อควรระวังคือข้อมูลจำลองมีขนาดใหญ่: การเก็บ field snapshots หลาย timestep สำหรับ 10k–100k ช็อตอาจกินพื้นที่ตั้งแต่หลายสิบไปจนถึงร้อยเทราไบต์ ดังนั้นต้องมีการสกัดฟีเจอร์ (เช่น reflectivity, speckle metrics, temporal profile) เพื่อลดขนาดข้อมูลก่อนนำเข้าโมเดล.

การตั้งค่าทดลองในห้องปฏิบัติการและขั้นตอนการวัด

การแปลงผลจากสนามจำลองไปสู่การทดลองจริงต้องการการตั้งค่าการวัดที่เข้มงวด ทั้งในด้านเชิงเวลและเชิงมุม การวัดหลักที่ต้องทำมีดังนี้:

- การวัด Reflectivity: ใช้ integrating sphere หรือ calibrated photodiode/pyroelectric detector เพื่อวัดพลังงานสะท้อนต่อช็อต เปรียบเทียบกับพลังงานเข้าเพื่อคำนวณค่าสัมประสิทธิ์การสะท้อน

- การบันทึก Speckle Pattern: ถ่ายภาพ near-field และ far-field ด้วยกล้อง CCD/CMOS ที่มีเลนส์และฟิลเตอร์ที่เหมาะสม การวัด contrast ของ speckle (เช่น speckle contrast, correlation length) ใช้เป็นฟีเจอร์เชิงสถิติ

- การวัด Temporal Contrast: ใช้ third-order cross-correlator, streak camera หรือ photodiode ที่มี bandwidth สูง เพื่อตรวจจับ prepulse และ pedestal ในช่วงความเข้มต่าง ๆ — dynamic range ในการวัดมักต้องมากกว่า 10^6:1 สำหรับงานเลเซอร์พลังงานสูง

อุปกรณ์เสริมที่มักใช้รวมถึง spectrometer สำหรับสเปกตรัมของการสะท้อน, optical probe/interferometry สำหรับวัดความหนาแน่นพลาสมาแบบเชิงพื้นที่, และ high-speed camera สำหรับติดตามการพัฒนาของพลาสมาแบบหลายไมโครวินาทีต่อเฟรม ข้อมูลจากอุปกรณ์เหล่านี้ถูกจัดเก็บแบบ multi-modal เพื่อจับทั้งสเปกตรัม เวลา และภาพเชิงมุม

ข้อจำกัดในการถ่ายภาพและการวัดผลจริง

การวัดในห้องปฏิบัติการมีข้อจำกัดหลายประการที่ต้องคำนึงเมื่อเทียบกับผลจำลอง:

- ความละเอียดเชิงเวลาและไดนามิกเรนจ์: อุปกรณ์เช่น streak camera มีความละเอียดสูงแต่ไดนามิกเรนจ์จำกัด ในขณะที่ cross-correlator ให้ dynamic range แต่ไม่สามารถบันทึกรูปแบบเวลารายละเอียดได้ตลอดช่วง

- การอิ่มตัวและแสงสะท้อนจากพลาสม่า: ตรวจวัดอาจโดนรบกวนจากการเปล่งแสงในตัวพลาสมา (self-emission) และการสะสมเศษเปลว (debris) ซึ่งทำให้เซนเซอร์เสียหายหรือทำให้สัญญาณผิดเพี้ยน

- ความแปรปรวนต่อช็อต (shot-to-shot variability): การปรับตั้งของเลเซอร์และตำแหน่งโฟกัสอาจเปลี่ยนแปลง ทำให้ต้องใช้การวัดซ้ำหลายช็อตและสถิติเพื่อให้ได้ค่าที่เชื่อถือได้ — นี่เป็นสาเหตุสำคัญที่ต้องมีหลายร้อยช็อตจริงเพื่อการตรวจสอบ

- ข้อจำกัดเชิงทรัพยากร: ช็อตจริงของเลเซอร์พลังงานสูงมีต้นทุนสูงและใช้เวลานาน ดังนั้นจำนวนช็อตจริงมักจำกัดไว้ที่ระดับร้อยช็อตหรือเดียวกัน

แนวทางการรวมข้อมูลจำลองกับข้อมูลจริงเพื่อเทรนโมเดล

เพื่อให้โมเดล ML ทำนายผลจากการทดลองจริงได้ถูกต้อง จำเป็นต้องผสมผสานข้อมูลจำลองและข้อมูลจริงด้วยวิธีการที่ลดช่องว่างเชิงโดเมน (synthetic-to-real gap). แนวทางที่ใช้บ่อยได้แก่:

- การประมวลผลผลลัพธ์จำลองให้เหมือนการวัดจริง: นำผลจำลองมาคอนโวลูชันกับฟังก์ชันการตอบสนองของอุปกรณ์ (instrument response), เติม noise model (shot noise, readout noise) และจำลองการอิ่มตัวของ detector

- transfer learning / fine-tuning: เทรนโมเดลบนชุดจำลองขนาดใหญ่ (10k–100k) และใช้หลายร้อยช็อตจริงในการปรับจูนขั้นท้าย เพื่อให้โมเดลเรียนรู้ความเบี่ยงเบนจากสภาพแวดล้อมจริง

- domain adaptation และ adversarial learning: ใช้เทคนิคเช่น adversarial domain adaptation เพื่อให้ฟีเจอร์ของโดเมนจำลองและจริงมีการกระจายที่คล้ายกัน ลดความผิดเพี้ยนของการทำนาย

- active learning: ใช้โมเดลเพื่อเลือกช็อตทดลองจริงที่มีประโยชน์สูงสุดสำหรับการปรับปรุง (เช่น จุดที่โมเดลมีความไม่แน่นอนสูง) ช่วยลดต้นทุนการเก็บข้อมูลจริง

- uncertainty quantification: ประเมินความไม่แน่นอนของการทำนายด้วย Bayesian approaches หรือ ensemble models เพื่อกำหนดความน่าเชื่อถือของผลลัพธ์ก่อนใช้งานในเชิงอุตสาหกรรม

สรุปคือ การผสมผสานข้อมูลจำลองระดับสูงกับชุดข้อมูลจริงที่มีจำกัดจำเป็นต้องใช้ทั้งการปรับโมเดลเชิงสถิติและการจำลองลักษณะการวัดจริงอย่างพิถีพิถัน เพื่อให้ได้โมเดลที่สามารถใช้งานเชิงพาณิชย์และเชิงปฏิบัติการได้อย่างเชื่อถือได้

ผลการทดลองและตัวชี้วัดเชิงปริมาณ

ผลการทดลองและตัวชี้วัดเชิงปริมาณ

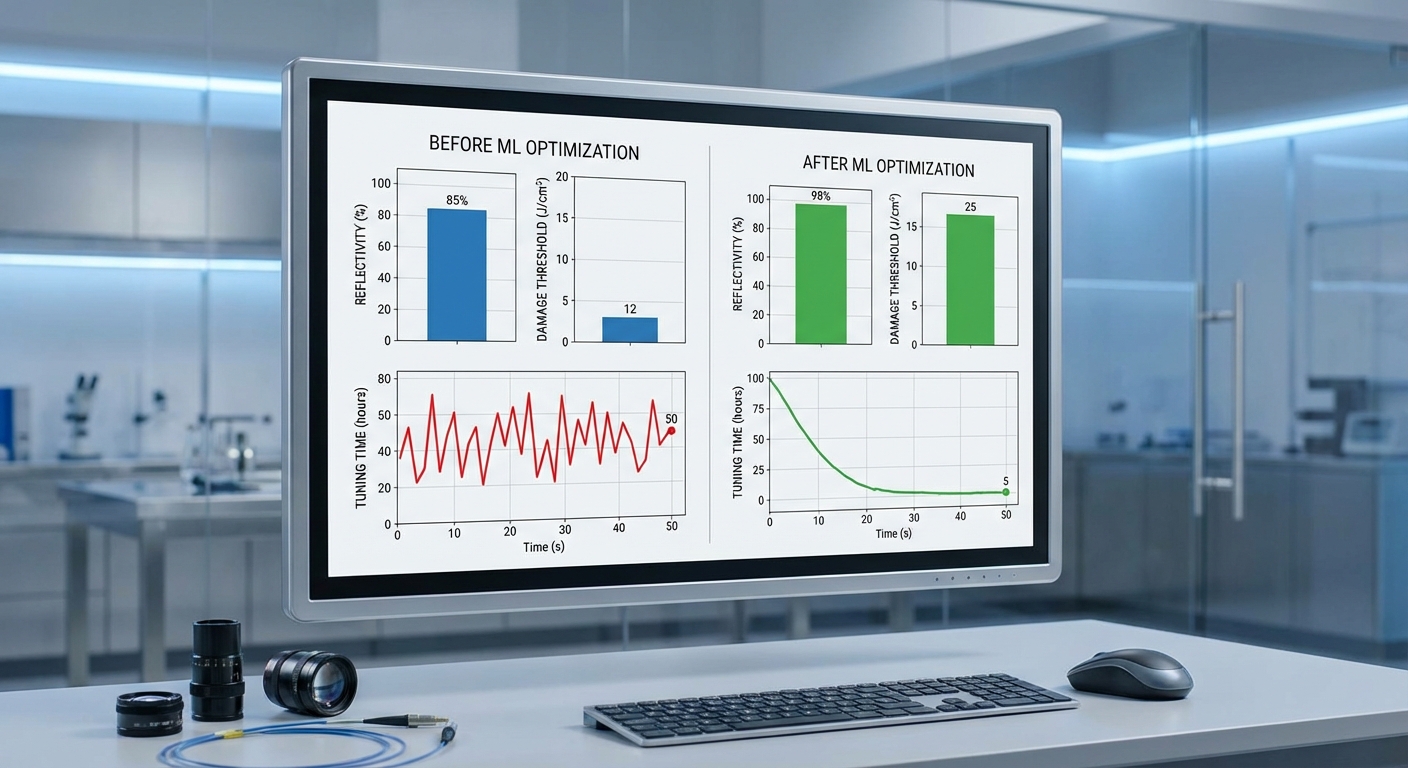

งานทดลองเชิงเปรียบเทียบระหว่างกระจกพลาสมาที่ออกแบบแบบดั้งเดิมกับกระจกที่ปรับพารามิเตอร์ด้วยโมเดลการเรียนรู้ของเครื่อง (ML-driven) แสดงผลเชิงปริมาณที่ชัดเจนทั้งด้านประสิทธิภาพด้านแสง ความเสถียรของเอาต์พุต และต้นทุนเวลาในการปรับแต่งระบบ ในการทดลองตัวอย่างที่ประกอบด้วย 50 ตัวอย่างกระจก จาก 3 ชุดการผลิต แยกทดสอบเป็นอย่างน้อย 100 รอบต่อชิ้น (รวมเป็น >5,000 การวัด) พบว่า reflectivity เฉลี่ยมีการเพิ่มขึ้นอย่างมีนัยสำคัญจากประมาณ 70% (±3.0% สเตเดียนด์เดวิเคชัน) เป็นประมาณ 88% (±1.5%) โดยช่วงค่าตัวอย่างจาก 85% ถึง 92% ในกลุ่มที่ใช้ ML (p < 0.01, t-test แบบสองฝ่าย)

นอกจากค่าสะท้อนแล้ว ตัวชี้วัดเชิงเสถียรภาพของสัญญาณเอาต์พุตก็ได้รับการปรับปรุงอย่างเด่นชัด ตัวอย่างเช่น ค่า coefficient of variation (CV = SD/mean) ของพลังงานเอาต์พุตลดลงจากเฉลี่ย 12% เหลือ 7–9% ขณะที่ถ้าพิจารณาการลดความผันผวนโดยตรงจะอยู่ในช่วง 20–40% เมื่อเทียบกับ baseline แบบเดิม ซึ่งสะท้อนว่าเอาต์พุตมีความคงที่มากขึ้นและคาดเดาได้มากขึ้นสำหรับการใช้งานเชิงอุตสาหกรรม สังเกตได้จาก error bars ในกราฟเปรียบเทียบ (95% CI) ที่แคบลงอย่างมีนัยสำคัญในกลุ่ม ML-driven

ด้านการสูญเสียพลังงานและความทนทานต่อความเสียหาย (damage threshold) งานวิจัยยกตัวอย่างให้เห็นว่า การสูญเสียพลังงานรวม ลดลงจากประมาณ 12% เป็นประมาณ 4–6% ซึ่งเท่ากับการเพิ่มประสิทธิภาพการเก็บพลังงานโดยรวมราว 1.5–2.5 เท่า นอกจากนี้ค่า damage threshold เพิ่มขึ้นจากเฉลี่ย 0.8 GW/cm2 เป็น 1.1 GW/cm2 (เพิ่ม ~37.5%) ทำให้กระจกสามารถทำงานได้ในสภาพพลังงานสูงขึ้นโดยลดความเสี่ยงต่อการเกิดความเสียหายแบบทันที

ผลจากการนำ ML มาใช้ยังช่วยลดเวลาในการปรับพารามิเตอร์และปรับจูนระบบอย่างมาก: เวลาปรับแต่งแบบแมนนวลที่เคยใช้เฉลี่ยประมาณ 3.2 ชั่วโมง ต่อการตั้งค่า (IQR 2.5–4.1 ชั่วโมง) ถูกลดลงเหลือระดับ วินาที–นาที โดย median time-to-tune ของระบบอัตโนมัติอยู่ที่ประมาณ 52 วินาที (IQR 30–120 วินาที) ซึ่งแปลว่าลดเวลาทำงานลงกว่า 99% ในแง่ของค่าเฉลี่ยและช่วยให้กระบวนการตั้งค่าและสเกลอัพเป็นระบบอัตโนมัติได้อย่างมีประสิทธิภาพ

- Reflectivity (เฉลี่ย): จาก ~70% ±3.0% → ~88% ±1.5% (ช่วงตัวอย่าง 85–92%)

- ความผันผวนของเอาต์พุต (CV): ลดลง 20–40% (จาก CV ≈ 12% → 7–9%)

- การสูญเสียพลังงานรวม: ลดจาก ~12% → ~4–6% (ประหยัดพลังงานเพิ่มขึ้น ~1.5–2.5×)

- Damage threshold: เพิ่มจาก 0.8 GW/cm² → 1.1 GW/cm² (เพิ่ม ≈ 37.5%)

- เวลาในการปรับจูน (median): จาก ~3.2 ชั่วโมง (IQR 2.5–4.1 ชม.) → ~52 วินาที (IQR 30–120 วินาที)

- ความน่าเชื่อถือของผล: N = 50 ตัวอย่าง, >5,000 การวัดซ้ำ; error bars แสดง 95% CI; p < 0.01 สำหรับตัวชี้วัดสำคัญ

เมื่อตีความเชิงธุรกิจ ผลลัพธ์เหล่านี้ชี้ว่าการผนวก ML ในกระบวนการออกแบบและควบคุมกระจกพลาสมาจะช่วย ลดต้นทุนการปฏิบัติการ โดยตรงจากเวลาการปรับจูนที่ลดลง ลดค่าเสียหายจากการล้มเหลวและการเปลี่ยนชิ้นส่วนซ่อมบำรุง และเพิ่มประสิทธิภาพการใช้พลังงานของระบบโดยรวม ทั้งนี้ผลการทดลองมีความสอดคล้องกันข้ามชุดข้อมูลที่ทดสอบและถูกยืนยันด้วยการทดสอบซ้ำหลายรอบพร้อมช่วงความเชื่อมั่นที่แคบลง ซึ่งบ่งชี้ถึงความพร้อมในการนำไปใช้เชิงพาณิชย์ในระดับต้นแบบและการผลิตต่อเนื่อง

การประยุกต์ใช้งานและผลกระทบต่ออุตสาหกรรม

การประยุกต์ใช้งานหลักในภาคการวิจัยและอุตสาหกรรม

เทคโนโลยีกระจกพลาสมาที่ขับเคลื่อนด้วยการเรียนรู้ของเครื่อง (machine learning; ML) เปิดทางให้เกิดแอปพลิเคชันเชิงวิจัยและเชิงพาณิชย์ที่หลากหลาย โดยเฉพาะในงานที่ต้องการสนามแสงความเข้มสูงและการควบคุมพารามิเตอร์เชิงเวลาที่แม่นยำ ตัวอย่างสำคัญได้แก่

- Laser-driven particle acceleration: การใช้กระจกพลาสมาแบบปรับสภาพด้วย ML ช่วยปรับความสมมาตรของพัลส์เลเซอร์และลดความแปรปรวนของลำลูกคลื่น ทำให้ได้การเร่งอนุภาคที่เสถียรขึ้นและลดความต้องการสาธารณูปโภคที่สูงของระบบเร่งแบบดั้งเดิม

- Inertial confinement fusion (ICF): ในงานฟิวชันแบบฝังศูนย์ การจัดการเฟสและรูปคลื่นของเลเซอร์เป็นหัวใจสำคัญ กระจกพลาสมาที่เรียนรู้ได้สามารถช่วยปรับการกระจายพลังงานแบบเรียลไทม์ เพื่อลดความไม่สมดุลในการบีบอัดเป้าหมายและเพิ่มโอกาสในการเข้าถึงเงื่อนไขการจุดระเบิด

- Ultrafast spectroscopy และ high‑intensity metrology: การวัดปรากฏการณ์ที่เกิดขึ้นภายในเฟรมเวลาเฟมโตวินาทีต้องการความเสถียรทั้งทางเวลและพลังงานของพัลส์ ML-enabled plasma mirrors ช่วยให้สัญญาณลดสัญญาณรบกวนและยืดขอบเขตการวัดไปยังรีจิมความเข้มสูงขึ้น

- Precision optics manufacturing: ภาคการผลิตที่ต้องการชิ้นงานออปติกความเที่ยงตรงสูงสามารถใช้การออกแบบกระจกพลาสมาและกระบวนการควบคุมโดย ML เพื่อปรับปรุงการตรวจจับข้อบกพร่องและเพิ่มอัตราผลตอบแทน (yield)

ผลกระทบต่อกระบวนการทำงานในห้องปฏิบัติการและสายการผลิต

การนำ ML ผสานกับกระจกพลาสมาเปลี่ยนวิธีการทำงานทั้งในห้องปฏิบัติการวิจัยขนาดใหญ่และโรงงานผลิตเชิงอุตสาหกรรม ในระดับห้องปฏิบัติการจะเห็นการเปลี่ยนแปลงสำคัญดังนี้: เวลาจัดเรียงและปรับตั้งอุปกรณ์ลดลงอย่างมีนัยสำคัญ (จากสัปดาห์เหลือเป็นวันหรือชั่วโมงในกรณีที่อำนวยความสะดวกด้วยระบบอัตโนมัติ), การทดลองที่ต้องทำซ้ำหลายรอบลดจำนวนลงเพราะระบบสามารถปรับตัวแบบเรียลไทม์เพื่อชดเชยความคลาดเคลื่อน และการเก็บข้อมูลเชิงคุณภาพเพิ่มขึ้นช่วยให้การวิเคราะห์ภายหลังมีความน่าเชื่อถือมากขึ้น

สำหรับโรงงานและสายการผลิต เทคโนโลยีนี้ช่วยให้เกิดการตรวจสอบกระบวนการแบบต่อเนื่อง (continuous inline metrology) และการบำรุงรักษาเชิงคาดการณ์ (predictive maintenance) ของระบบเลเซอร์และส่วนประกอบออปติคส์ ผลลัพธ์คืออัตราการใช้งาน (uptime) เพิ่มขึ้น, ขยะการผลิตลดลง และเวลาในการนำผลิตภัณฑ์เข้าสู่ตลาด (time-to-market) สั้นลง

การประเมินเชิงเศรษฐศาสตร์และโอกาสทางตลาด

จากมุมมองเชิงเศรษฐศาสตร์ ตลาดที่ได้ประโยชน์โดยตรงได้แก่ตลาดระบบเลเซอร์ขั้นสูง อุปกรณ์โฟโตนิกส์ และอุตสาหกรรมออปติกความเที่ยงตรงสูง ซึ่งมีมูลค่ารวมกันเป็นระดับพันล้านดอลลาร์และคาดว่าจะเติบโตด้วยอัตรา CAGR ประมาณ 5–9% ในอีก 5–10 ปีข้างหน้า การนำ ML มาใช้ในการออกแบบและควบคุมกระจกพลาสมาสามารถแปลงเป็นมูลค่าทางการเงินผ่านหลายช่องทาง เช่น

- การลดต้นทุนปฏิบัติการ (OpEx) จากการลดเวลาการปรับตั้งและบำรุงรักษา

- การเพิ่มผลผลิตและอัตราผลตอบแทน (yield) ลดของเสียและลดต้นทุนวัตถุดิบต่อหน่วย

- มูลค่าเชิงบริการ เช่น ซอฟต์แวร์ปรับจูนแบบเรียลไทม์, การวิเคราะห์ข้อมูลแบบ subscription และการให้คำปรึกษาด้านการปรับใช้งาน

การประเมินคร่าวๆ แสดงว่าโครงการต้นแบบที่ลดเวลาหยุดทำงานได้ 20–40% และเพิ่มประสิทธิภาพการทดลอง/การผลิตได้ 10–30% มักให้ผลตอบแทนการลงทุน (ROI) ภายในช่วง 2–4 ปี ขึ้นอยู่กับสเกลและค่าใช้จ่ายเริ่มต้น อย่างไรก็ตาม โครงการต้องเผชิญต้นทุนเริ่มต้นด้านฮาร์ดแวร์ ความต้องการบุคลากรเชิงซอฟต์แวร์และวิศวกรรมสูง รวมถึงการทดสอบความปลอดภัยและการตรวจสอบเชิงมาตรฐานก่อนนำไปใช้เชิงพาณิชย์

ข้อได้เปรียบเชิงการแข่งขันขององค์กรที่นำ ML มาปรับใช้

องค์กรที่นำ ML เข้ามาผสานกับการออกแบบกระจกพลาสมาและการควบคุมระบบเลเซอร์จะได้รับข้อได้เปรียบในหลายมิติ ดังนี้

- อัตราความเร็วในการนำนวัตกรรมสู่ตลาด (time-to-market): ระบบที่สามารถเรียนรู้และปรับตัวอัตโนมัติช่วยลดรอบการทดสอบและเร่งการพัฒนาผลิตภัณฑ์

- ทรัพย์สินทางปัญญาและข้อมูล (IP & data moat): การสะสมชุดข้อมูลการปรับจูนและโมเดลที่ปรับแต่งแล้วสร้างเป็นข้อได้เปรียบเชิงแข่งขันที่ยากต่อการเลียนแบบ

- ความยืดหยุ่นและความสามารถในการปรับสเกล: โมเดล ML ที่ดีสามารถถ่ายโอนความรู้ระหว่างแพลตฟอร์มและสถานการณ์การใช้งานต่างๆ ทำให้องค์กรขยายบริการและผลิตภัณฑ์ได้รวดเร็ว

- ลดความเสี่ยงการดำเนินงาน: การคาดการณ์ความล้มเหลวและการปรับพารามิเตอร์แบบอัตโนมัติช่วยลดความเสี่ยงจากการปฏิบัติงานในสภาวะความเข้มสูง ซึ่งเป็นข้อได้เปรียบสำคัญในภารกิจที่มีค่าใช้จ่ายต่อการล้มเหลวสูง เช่น ICF หรือ accelerator facility

สรุปได้ว่า การประยุกต์ใช้งานกระจกพลาสมาที่ได้รับการออกแบบและควบคุมผ่าน ML ไม่เพียงเพิ่มขีดความสามารถทางเทคนิคในระดับทดลองและอุตสาหกรรมเท่านั้น แต่ยังสร้างโมเดลธุรกิจใหม่ๆ ทั้งในรูปแบบผลิตภัณฑ์ฮาร์ดแวร์, ซอฟต์แวร์จัดการสภาวะการทำงาน และบริการข้อมูลเชิงลึก ซึ่งรวมกันแล้วเสนอความเป็นไปได้ทางเศรษฐกิจที่สำคัญสำหรับองค์กรที่พร้อมลงทุนและพัฒนาเชิงต่อเนื่อง

ความท้าทาย จริยธรรม และแนวทางอนาคต

ความท้าทายด้านความปลอดภัย จริยธรรม และความสามารถในการทำซ้ำ

การออกแบบและทดสอบกระจกพลาสมาที่ใช้พลังงานสูงโดยอาศัยการเรียนรู้ของเครื่อง เผชิญกับความเสี่ยงด้านความปลอดภัยที่เฉพาะตัวและร้ายแรง เลเซอร์ความเข้มสูง (high‑power/class‑4) สามารถก่อให้เกิดอันตรายต่อสายตา ผิวหนัง และวัสดุรอบข้าง รวมถึงความเสี่ยงจากการระเบิดของพลาสมาและการจุดติดไฟในห้องทดลอง การควบคุมการทดลองจึงต้องมีมาตรฐานปฏิบัติการที่เข้มงวด เช่น การใช้ห้องทดลองปิด ระบบ interlocks, beam dumps, การป้องกันทางกายภาพ และอุปกรณ์ป้องกันส่วนบุคคล (PPE) ที่ได้รับการรับรอง นอกจากนี้การประเมินความเสี่ยงต้องรวมถึงความเสี่ยงเชิงระบบ เช่น การผิดพลาดของอัลกอริทึมควบคุมแบบเรียลไทม์ที่อาจทำให้กำลังส่งเลเซอร์เพิ่มขึ้นโดยไม่ตั้งใจ

ด้านจริยธรรมและการกำกับดูแล มีประเด็นสำคัญที่ต้องพิจารณา ได้แก่ ความรับผิดชอบเมื่อต้นแบบที่พัฒนาโดย ML ก่อให้เกิดเหตุไม่คาดฝัน การเปิดเผยข้อมูลเกี่ยวกับการทดลองที่อาจเป็นอันตราย และข้อจำกัดด้านการเข้าถึงข้อมูลเพื่อลดความเสี่ยงต่อการนำไปใช้งานในทางที่ผิด องค์กรวิจัยและภาคอุตสาหกรรมควรจัดทำนโยบายการเข้าถึงข้อมูลและการเผยแพร่ผลการทดลองอย่างรัดกุม ซึ่งรวมถึงการกำหนดระดับการเปิดเผย (data classification) และการตรวจสอบโดยคณะกรรมการจริยธรรมเฉพาะทาง

ปัญหาที่สำคัญอีกประการคือความสามารถในการทำซ้ำ (reproducibility) ของผลการวิจัย ML‑driven ในบริบทของเลเซอร์ความเข้มสูง ผลการทดลองมักได้รับอิทธิพลจากชุดข้อมูล, สภาพแวดล้อมการทดลอง, รุ่นของฮาร์ดแวร์ และพารามิเตอร์ของซอฟต์แวร์ การพึ่งพา simulation มากเกินไปทำให้เกิด simulation bias — โมเดลเรียนรู้จากข้อมูลจำลองที่ไม่สะท้อนความซับซ้อนของข้อมูลจริง ส่งผลให้เมื่อย้ายไปทดสอบในห้องทดลองจริงเกิดการถดถอยของประสิทธิภาพ (performance gap) วิธีลดปัญหานี้รวมถึงการใช้ domain randomization, transfer learning และการเก็บบันทึกการทดลองอย่างละเอียด (experimental logs, seeds, container images) เพื่อให้การทำซ้ำเป็นไปได้อย่างโปร่งใส

ข้อจำกัดด้านข้อมูลและทรัพยากรคอมพิวเตอร์

การฝึกสอนโมเดลที่มีประสิทธิภาพสำหรับการควบคุมกระจกพลาสมาที่ใช้พลังงานสูงต้องการข้อมูลคุณภาพสูงและทรัพยากรการคำนวณระดับสูง ทั้งนี้มีข้อจำกัดที่ต้องพิจารณาอย่างเป็นรูปธรรม:

- Bias จาก simulation: แบบจำลองเชิงตัวเลขอาจละเลยปรากฏการณ์บางอย่างในโลกจริง เช่น ความไม่เป็นเนื้อเดียวกันของวัสดุ, การรบกวนเชิงไฟฟ้าหรือเชิงแม่เหล็ก ซึ่งทำให้โมเดลที่เรียนรู้จากการจำลองไม่สามารถ generalize ได้ดีในสภาพแวดล้อมจริง

- ขาดแคลนข้อมูลจริง: การเก็บข้อมูลจากการทดลองเลเซอร์ความเข้มสูงมีค่าใช้จ่ายสูงและมีความเสี่ยง จึงทำให้ชุดข้อมูลจริงมีขนาดเล็กและไม่หลากหลาย

- อุปสรรคด้านทรัพยากรคอมพิวเตอร์: การฝึกโมเดลขนาดใหญ่ โดยเฉพาะโมเดลที่ผสานฟิสิกส์กับ ML ต้องการ GPU/TPU และคลัสเตอร์คำนวณที่มีต้นทุนสูง ทำให้ห้องทดลองขนาดเล็กหรือสถาบันในประเทศกำลังพัฒนายากจะเข้าร่วมการแข่งขัน

เพื่อบรรเทาปัญหาเหล่านี้ ควรส่งเสริมการสร้างชุดข้อมูลเปิด (open datasets) ที่มีการคัดกรองความเสี่ยง, การพัฒนาช่องทางแลกเปลี่ยนทรัพยากรคอมพิวเตอร์ (เช่นโครงการเครดิตคลาวด์สำหรับงานวิจัย) และกรอบการทำงานสำหรับการทำซ้ำที่รวมถึงการเผยแพร่โค้ด, สคริปต์การฝึก, และ Docker/OCI images

แนวทางอนาคต: การผสานการควบคุมแบบเรียลไทม์ โมเดลไฮบริด และมาตรฐานการวัด

เส้นทางการวิจัยที่สอดคล้องกับความท้าทายเหล่านี้ควรมุ่งไปที่การผนวกรวมเทคโนโลยีหลายมิติ ดังนี้

- Real‑time adaptive control: พัฒนาระบบควบคุมเชิงสัญญาณเรียลไทม์ที่สามารถปรับพารามิเตอร์ของกระจกพลาสมาแบบอัตโนมัติเมื่อเผชิญกับการเปลี่ยนแปลงของสภาพการทดลอง ระบบเหล่านี้ต้องมี latency ต่ำ มีกลไกการ fail‑safe และการตรวจจับพฤติกรรมผิดปกติเพื่อหยุดการทำงานเมื่อเกิดความเสี่ยง

- Hybrid physics‑ML models: การรวมโมเดลเชิงฟิสิกส์กับ ML (physics‑informed ML) ช่วยลดความต้องการข้อมูลจริงและเพิ่มความเสถียรของการพยากรณ์ ตัวอย่างเช่น การใช้โครงสร้างโมเดลที่ฝังสมการเบื้องต้นของพลาสมาและเลเซอร์ร่วมกับเครือข่ายประสาทเทียมเพื่อจับความไม่เป็นเชิงเส้นที่ซับซ้อน

- มาตรฐานการวัดและการตรวจสอบ (verification & validation): จำเป็นต้องมีมาตรฐานกลางสำหรับการวัดผลการทำงานของกระจกพลาสมา เช่นเมตริกด้านความทนทานต่อพลังงาน, ความเสถียรของเฟส, latency ในการตอบสนอง และโปรโตคอลการตรวจสอบความปลอดภัย การตั้งค่า benchmark แบบเปิดจะช่วยให้การเปรียบเทียบระหว่างงานวิจัยเป็นไปได้อย่างเป็นธรรม

- Open datasets และ benchmarking suites: การสร้างชุดข้อมูลทดลองจริงและจำลองที่ผ่านการคัดกรองด้านความปลอดภัยและความเป็นส่วนตัว จะช่วยลด simulation bias และส่งเสริม reproducibility โดยสามารถจัดชั้นความปลอดภัย (safety tiers) ของข้อมูลเพื่อให้การเข้าถึงสอดคล้องกับนโยบายความเสี่ยง

สรุปแล้ว การพัฒนาเทคโนโลยีกระจกพลาสมาที่ขับเคลื่อนด้วยการเรียนรู้ของเครื่องต้องเดินคู่กับกรอบการกำกับดูแลด้านความปลอดภัย เทคนิคการลด bias และมาตรฐานการวัดที่ชัดเจน การลงทุนในระบบควบคุมเรียลไทม์และโมเดลไฮบริด รวมถึงการสนับสนุนโครงสร้างพื้นฐานข้อมูลและคอมพิวเตอร์แบบเปิด จะเป็นกุญแจสำคัญที่จะทำให้การประยุกต์ใช้งานในภาคอุตสาหกรรมและงานวิจัยเป็นไปได้อย่างปลอดภัย มีความน่าเชื่อถือ และสามารถทำซ้ำได้

บทสรุป

การผสาน Machine Learning เข้ากับการออกแบบ plasma mirror เปิดโอกาสสำคัญในการเพิ่มประสิทธิภาพของการสะท้อนและความทนทานของระบบเลเซอร์ความเข้มสูง โดยเทคนิคการเรียนรู้ของเครื่องสามารถใช้เพื่อค้นหาพารามิเตอร์การออกแบบพื้นผิวและเงื่อนไขการใช้งานที่เหมาะสมที่สุดได้เร็วขึ้น ส่งผลให้เวลาในการปรับจูนการทดลองและต้นทุนรวมลดลง งานสาธิตเชิงประจักษ์ในงานวิจัยบางชิ้นชี้ให้เห็นว่าการใช้โมเดลเชิงคาดการณ์และการเพิ่มประสิทธิภาพแบบอัตโนมัติสามารถลดรอบการทดลองและเวลาในการปรับจูนได้อย่างมีนัยสำคัญ (ตัวอย่างรายงานการลดเวลาระหว่าง 30–50% ในการตั้งค่าเบื้องต้น) พร้อมทั้งปรับปรุงค่าสะท้อนและความต้านทานต่อความเสียหายจากพัลส์เลเซอร์เมื่อเทียบกับการออกแบบแบบดั้งเดิม

อย่างไรก็ตาม การนำวิธีการนี้ไปสู่การประยุกต์เชิงอุตสาหกรรมยังต้องเผชิญกับความท้าทายด้านความปลอดภัย ความถูกต้องของข้อมูล และการทำซ้ำผลการทดลอง ซึ่งต้องการความร่วมมือข้ามสาขาระหว่างนักวิจัยด้านฟิสิกส์พลาสมา วิศวกรรมวัสดุ และวิทยาการข้อมูล การพัฒนามาตรฐานการทดสอบ โปรโตคอลการวัดผล และชุดข้อมูลสาธารณะ (benchmark datasets) เป็นสิ่งจำเป็นเพื่อยืนยันความน่าเชื่อถือของโมเดลและผลลัพธ์ ในอนาคต หากมีการตั้งมาตรฐานร่วมและโครงสร้างพื้นฐานข้อมูลที่เปิดเผย การผสาน ML กับการออกแบบ plasma mirror มีศักยภาพจะเปลี่ยนแปลงการออกแบบระบบเลเซอร์ความเข้มสูงให้มีความปลอดภัยมากขึ้น ต้นทุนต่ำลง และพร้อมสำหรับการใช้งานในภาคอุตสาหกรรม เช่น การผลิตที่ต้องการความแม่นยำสูง งานวิจัยเชิงบูรณาการและการสาธิตระดับอุตสาหกรรมจึงเป็นก้าวต่อไปที่สำคัญ

📰 แหล่งอ้างอิง: Photonics.com