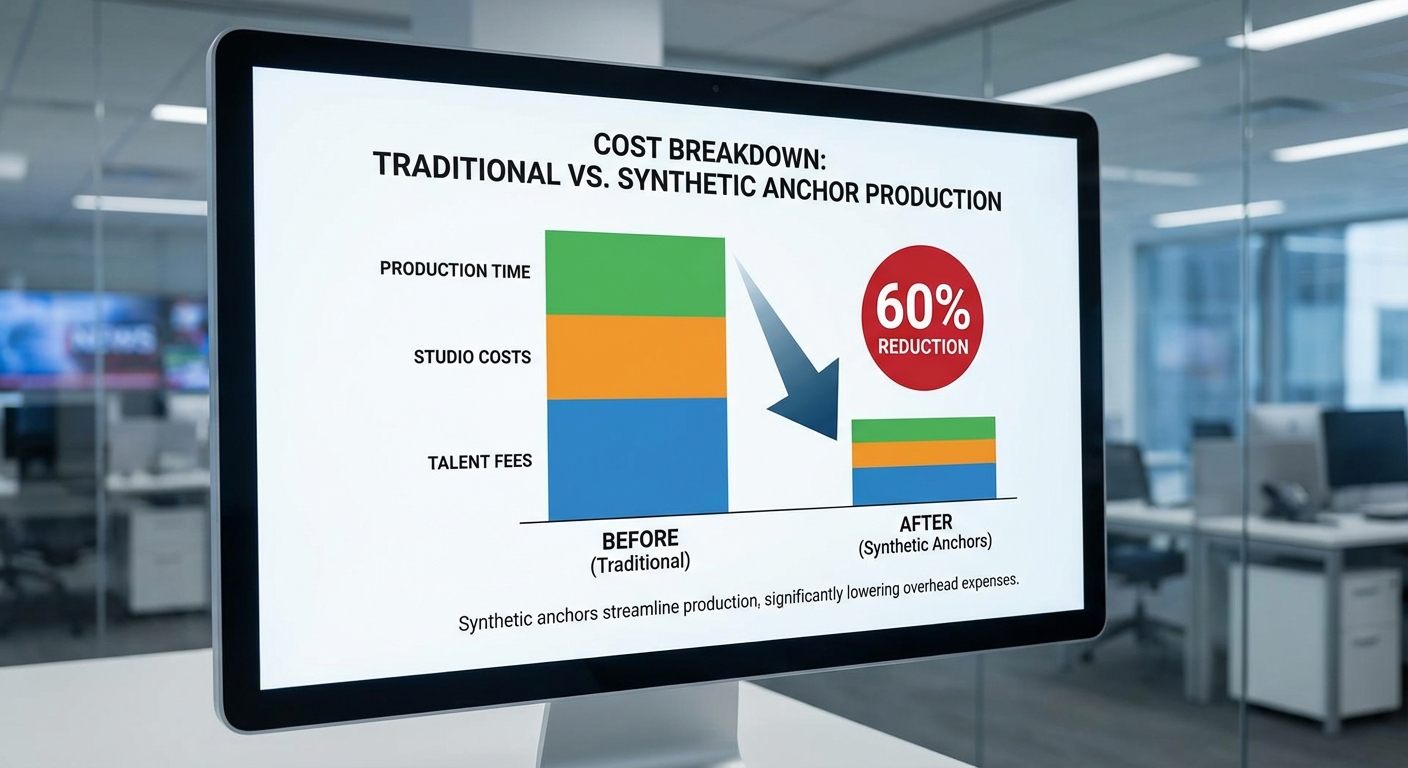

ในก้าวย่างใหม่ของวงการสื่อสารมวลชนไทย สำนักข่าวไทยได้เปิดการทดลองระบบ "Anchor‑GAN" ซึ่งเป็นโมเดลภาพ‑เสียงสังเคราะห์ที่สามารถควบคุมท่าทางและน้ำเสียงของพิธีกรได้อย่างละเอียด ผลการทดลองเบื้องต้นที่สำนักข่าวเผยแพร่ระบุว่าเทคโนโลยีดังกล่าวช่วยลดต้นทุนการผลิตรายการเช้าได้ถึง 60% โดยสามารถลดงบประมาณด้านค่าจ้างพิธีกร ค่าเช่าสตูดิโอ และค่าแรงช่างเทคนิคในบางส่วน พร้อมเพิ่มความยืดหยุ่นในการออกอากาศ เช่น การสลับเวลา รายการซ้ำ และการปรับคอนเทนต์ให้เหมาะกับผู้ชมกลุ่มต่าง ๆ ซึ่งเป็นข้อดีเชิงปฏิบัติที่สอดคล้องกับแนวโน้มการใช้ปัญญาประดิษฐ์เพื่อเพิ่มประสิทธิภาพการผลิตสื่อ

แม้ผลประหยัดจะเป็นตัวเลขที่ดึงดูด แต่การนำ Anchor‑GAN มาใช้จริงกลับจุดชนวนข้อถกเถียงสำคัญเกี่ยวกับความน่าเชื่อถือ การตรวจสอบข้อเท็จจริง และจริยธรรมสื่อ สังคมตั้งคำถามทั้งเรื่องการระบุว่าเนื้อหาใดเป็นสังเคราะห์ การรับผิดชอบเมื่อเกิดข้อมูลผิดพลาด หรือการใช้เทคโนโลยีนี้เพื่อสร้างเนื้อหาที่ทำให้ผู้ชมเข้าใจผิด ผู้เชี่ยวชาญและนักการสื่อสารเรียกร้องมาตรการชัดเจนทั้งการติดป้ายแจ้งผู้ชม การเก็บบันทึกการแก้ไขเนื้อหา และกรอบกำกับดูแลจากภาครัฐและสถาบันสื่อ เพื่อให้ประโยชน์ทางเศรษฐกิจไม่มาทับซ้อนกับหลักความจริงและความไว้วางใจของประชาชน

บทนำ: ข่าวการทดลองและภาพรวมเหตุการณ์

สำนักข่าวไทย ประกาศเริ่มโครงการทดลองใช้งานระบบ Anchor‑GAN — ปัญญาประดิษฐ์รูปแบบภาพและวิดีโอที่ถูกพัฒนาให้ผลิตพิธีกรสังเคราะห์ที่สามารถควบคุมท่าทางและน้ำเสียงได้อย่างละเอียด — เพื่อใช้ในรายการข่าวเช้าขององค์กรโดยตรง โดยแถลงว่าเป็นการทดลองเชิงธุรกิจเพื่อทดสอบประสิทธิภาพการผลิตเนื้อหาและการลดต้นทุนการดำเนินงานในระยะยาว มีเป้าหมายเพื่อลดภาระต้นทุนและเพิ่มความยืดหยุ่นในการจัดตารางออกอากาศ ในช่วงเวลาที่สื่อเผชิญแรงกดดันด้านรายได้และค่าใช้จ่าย

รายงานจากสำนักข่าวไทยระบุว่าเบื้องต้นการทดลองนำไปสู่การลดต้นทุนรวมได้ประมาณ 60% เมื่อเทียบกับรูปแบบการผลิตแบบดั้งเดิมที่ใช้พิธีกรจริง ทีมงานชี้แจงว่าการประหยัดเกิดจากปัจจัยหลายประการ เช่น ลดค่าแรงพิธีกรและทีมกองถ่าย ลดเวลาการจัดสตูดิโอและการแต่งหน้า รวมถึงความสามารถในการสลับคอนเทนต์และปรับแต่งสคริปต์แบบเรียลไทม์โดยไม่ต้องเรียกคิวจากบุคลากรจำนวนมาก สำนักข่าวระบุว่าจะดำเนินการทดลองในช่วงเบื้องต้นเป็นระยะเวลา 3 เดือน เพื่อเก็บข้อมูลเชิงปริมาณและเชิงคุณภาพก่อนตัดสินใจขยายการใช้งาน

แม้ผลลัพธ์ด้านต้นทุนจะโดดเด่น แต่การประกาศทดลองทันทีจุดชนวนให้เกิดข้อถกเถียงด้าน ความน่าเชื่อถือ ของสื่อ โดยนักวิชาการและนักข่าวหลายฝ่ายตั้งคำถามเกี่ยวกับการตรวจสอบเนื้อหา การระบุแหล่งที่มาของข่าว และความโปร่งใสต่อผู้ชม ประเด็นที่ถูกหยิบยกขึ้นมารวมถึงความจำเป็นของการติดป้ายบอกว่าเป็นพิธีกรสังเคราะห์ วิธีการรับรองความถูกต้องของข้อมูลเมื่อตัวนำเสนอเป็นระบบสร้างภาพ และความเสี่ยงต่อการบิดเบือนเนื้อหาหากระบบถูกนำไปใช้ในทางมิชอบ

ประเด็นสำคัญโดยสรุป

- การทดลอง: สำนักข่าวไทยเริ่มใช้งาน Anchor‑GAN ในรายการเช้าในโครงการทดลองเชิงปฏิบัติ

- ผลประหยัด: รายงานเบื้องต้นระบุว่าลดต้นทุนได้ประมาณ 60% จากการลดค่าใช้จ่ายด้านบุคลากรและการผลิต

- ข้อถกเถียง: เรื่องความน่าเชื่อถือ ตรวจสอบได้ และการเปิดเผยต่อผู้ชมกลายเป็นประเด็นถกเถียงทันที ทั้งในมิติจริยธรรมสื่อและมาตรฐานข่าวสาร

Anchor‑GAN คืออะไร: อธิบายเชิงเทคนิคแบบเข้าใจง่าย

Anchor‑GAN คืออะไร: อธิบายเชิงเทคนิคแบบเข้าใจง่าย

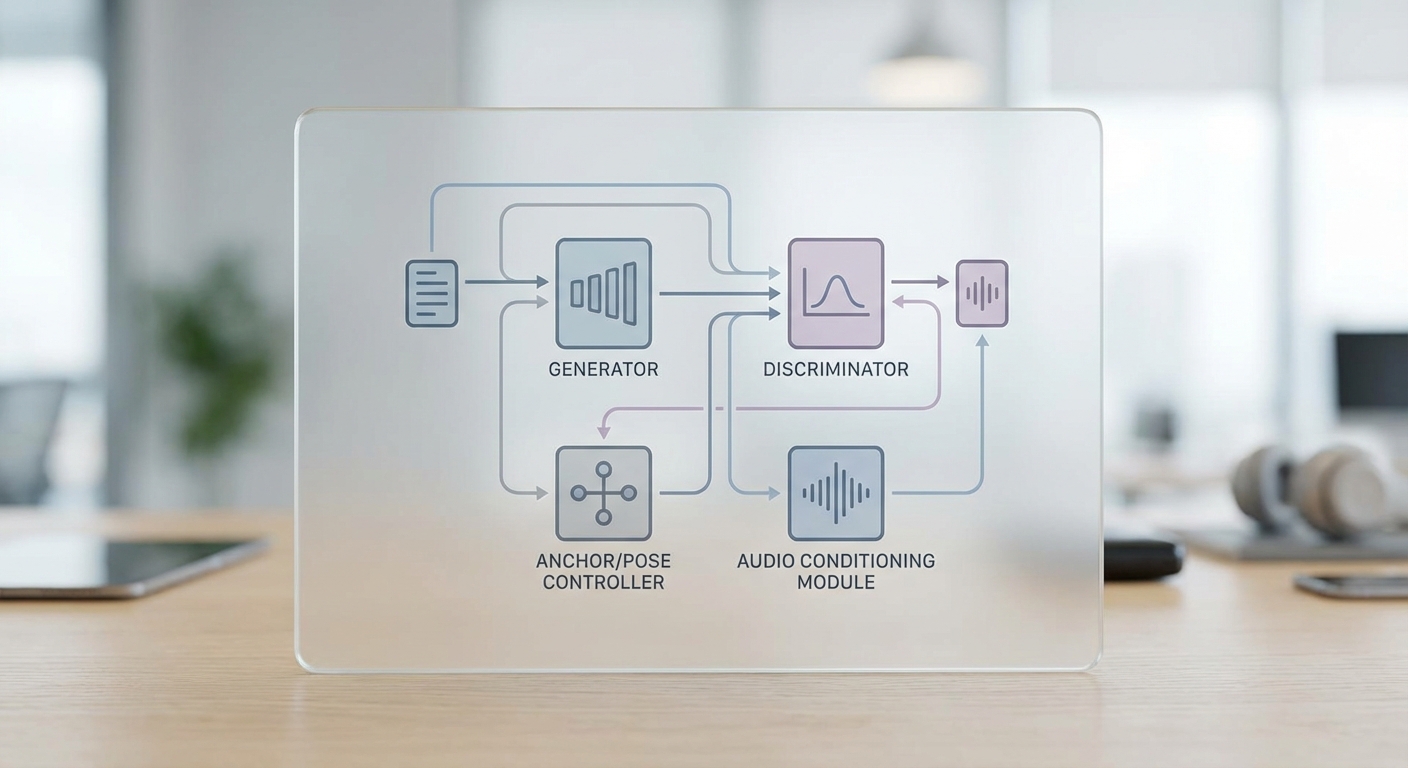

Anchor‑GAN เป็นสถาปัตยกรรมเชิงปัญญาประดิษฐ์ที่พัฒนาต่อยอดจากแนวคิดของ Generative Adversarial Network (GAN) แบบดั้งเดิม โดยถูกออกแบบมาเพื่อผลิตภาพเคลื่อนไหวของพิธีกรสังเคราะห์ที่ สามารถควบคุมท่าทาง (pose) และลักษณะเสียง/intonation ได้เป็นพารามิเตอร์ แทนที่จะเป็นการสลับหน้าหรือลอกภาพนิ่งอย่างเดียว การทำงานเบื้องต้นยังคงยึดหลัก GAN พื้นฐาน คือมีโมดูลหลัก 2 ส่วนคือ Generator ที่สร้างภาพ/วิดีโอ และ Discriminator ที่แยกระหว่างตัวอย่างจริงกับตัวอย่างที่สร้างขึ้น แต่ Anchor‑GAN จะเพิ่มชั้นควบคุมที่เรียกว่า anchor layer และการเชื่อมต่อกับโมดูลเสียง (voice model) เพื่อให้การสร้างภาพสัมพันธ์กับการพูดและการเคลื่อนไหวอย่างสมจริง

ในเชิงการฝึก (training) Anchor‑GAN มักใช้ชุดข้อมูลแบบคู่ภาพ‑เสียง (audio‑visual paired dataset) ซึ่งประกอบด้วยคลิปวิดีโอของพิธีกรจริงที่มีการจับตำแหน่ง keypoints ของใบหน้า มือ และลำตัว และไฟล์เสียงที่จับรายละเอียดโทนเสียง (pitch/F0), พลังเสียง (energy), และจังหวะ (timing) ข้อมูลตัวอย่างในงานวิจัยเชิงทดลองมักมีขนาดตั้งแต่หลายร้อยชั่วโมงจนถึงหลายพันชั่วโมงของเนื้อหารายการข่าวเพื่อให้โมเดลเรียนรู้ความสัมพันธ์เชิงพื้นที่‑เวลาได้ดี ขณะที่ฟังก์ชันความสูญเสีย (loss functions) จะรวมทั้ง adversarial loss เพื่อความสมจริง, reconstruction/identity loss เพื่อรักษาลักษณะเฉพาะของพิธีกร และ sync/perceptual losses เพื่อความสอดคล้องระหว่างเสียงและการเคลื่อนไหวของริมฝีปาก

Anchor layer (pose controller) คือองค์ประกอบสำคัญที่ทำให้ Anchor‑GAN แตกต่างจาก deepfake ทั่วไป โดย concept ของ anchor คือการส่งพอยต์หรือ "สมอ" ของท่าทางเข้ามาเป็นอินพุต เช่น ค่าสมมติของ keypoints (ตำแหน่งดวงตา ปาก ข้อมือ ไหล่ ฯลฯ) หรือ heatmaps ที่เข้ารหัสตำแหน่งเหล่านั้น ชั้น anchor จะทำหน้าที่เป็นตัวกำกับการสร้างภาพให้เคารพต่อข้อมูลท่าทางที่ป้อนเข้ามาในระดับพิกเซลและเชิงโครงสร้าง เทคนิคที่ใช้รวมถึงการผนวก spatial transformer, attention maps หรือ conditional normalization layers ที่ปรับลักษณะการสร้างตามพารามิเตอร์ anchor เหล่านี้ นอกจากนี้ยังมีการใช้โมดูล temporal consistency (เช่น RNN/LSTM, temporal discriminator หรือ optical flow loss) เพื่อให้การเคลื่อนไหวต่อเนื่องกันอย่างเป็นธรรมชาติ ไม่กระตุกหรือหลุดจากลักษณะของผู้สื่อข่าว

การผสานโมเดลเสียง (voice conditioning) ใน Anchor‑GAN ไม่ได้หมายถึงการแนบไฟล์เสียงภายนอกอย่างเดียว แต่เป็นการเข้ารหัสคุณสมบัติเสียงเชิงลึกเพื่อควบคุมทั้งการขยับปาก (lip sync), สภาพอารมณ์ และจังหวะของการแสดงออก โครงสร้างทั่วไปประกอบด้วยตัวเข้ารหัสเสียง (audio encoder) ที่สกัดตัวชี้วัดสำคัญ เช่น embedding ของเสียงผู้พูด, prosody vectors (F0/energy/duration) และ phoneme/viseme alignment จากนั้นส่งค่าดังกล่าวเข้าไปยัง Generator เพื่อให้การแสดงใบหน้าและการเคลื่อนไหวสอดคล้องกับเนื้อหาเสียงอย่างละเอียด ตัวอย่างเช่น ถ้าโมเดลระบุค่า F0 สูงและพลังเสียงเพิ่มในช่วงท้ายประโยค Generator จะปรับการแสดงออกของคิ้ว ปาก และท่าทางให้สอดคล้องกับน้ำเสียงที่ถูกป้อนเข้ามา

สรุปโมดูลหลักและบทบาทในการทำงานของ Anchor‑GAN แบบย่อ:

- Generator: รับ latent vector + anchor map + voice embedding แล้วสร้างเฟรมวิดีโอที่สอดคล้องกับพารามิเตอร์

- Discriminator: แยกจริง/ปลอม พร้อมตรวจสอบความสอดคล้องเชิงเวลาและเชิง audio‑visual sync

- Pose controller / Anchor layer: รับ keypoints/heatmaps เป็นเงื่อนไขบังคับให้การเคลื่อนไหวของหน้า มือ และลำตัวตรงตามที่กำหนด

- Voice model (audio encoder + prosody module): สกัดลักษณะโทนเสียงและจังหวะ ส่งเป็นเงื่อนไขให้ Generator เพื่อให้ lip sync และ intonation แม่นยำ

เมื่อเปรียบเทียบกับ deepfake แบบดั้งเดิม จุดเด่นของ Anchor‑GAN คือ ความสามารถในการควบคุมอย่างละเอียด — ผู้สร้างสามารถกำหนดพารามิเตอร์ท่าทางและรูปแบบเสียงเป็นตัวเลขหรือสคริปต์ ทำให้ผลลัพธ์สามารถทำซ้ำ ปรับแต่ง และรวมเข้ากับการผลิตรายการได้ตามต้องการ ขณะที่ deepfake ทั่วไปมักเน้นการย้อมใบหน้าจากตัวอย่างจริงโดยไม่สามารถสั่งให้โบกมือหรือเปลี่ยนโทนเสียงได้อย่างเชิงโครงสร้าง ซึ่งเป็นเหตุผลที่ Anchor‑GAN ถูกนำมาใช้ในสภาพแวดล้อมการผลิตเชิงพาณิชย์ เช่น การลดต้นทุนรายการเช้า แต่ในขณะเดียวกันการควบคุมเชิงโปรแกรมนี้ก็เพิ่มความท้าทายด้านความน่าเชื่อถือและจริยธรรมที่ต้องถกเถียงต่อไป

รายละเอียดการทดลองของสำนักข่าวไทย: ระเบียบวิธีและเมตริก

ระยะเวลาและขนาดตัวอย่างของการทดลอง

การทดลองของสำนักข่าวไทยดำเนินการเป็นระยะเวลา 90 วัน (ประมาณ 3 เดือน) ระหว่างเดือนทดลอง โดยออกอากาศรายการเช้ารายวันรวมทั้งหมด 120 ตอน โดยแบ่งเป็นกลุ่มทดลองและควบคุมแบบสุ่ม (randomized split) ดังนี้: กลุ่มทดลองใช้ระบบ Anchor‑GAN ในการผลิตพิธีกรสังเคราะห์จำนวน 60 ตอน และกลุ่มควบคุมที่ใช้พิธีกรมนุษย์จริงจำนวน 60 ตอน การสุ่มจะคำนึงถึงช่วงเวลาออกอากาศ (time slot) ประเภทคอนเทนต์ (ข่าวหนัก/ไลท์) และการมีแขกรับเชิญ เพื่อให้การเปรียบเทียบมีความเทียบเคียง (balanced) และลดอคติจากปัจจัยภายนอก

เมตริกสำคัญที่ใช้ประเมินผล

การทดลองกำหนดเมตริกหลักเพื่อวัดผลเชิงปริมาณและเชิงคุณภาพ โดยคำนึงถึงมุมมองด้านต้นทุน ประสิทธิภาพการผลิต และผลต่อผู้ชม ดังนี้

- ต้นทุนต่อตอน (Cost per episode) — รวมค่าใช้จ่ายหมวดหลัก (ค่าพิธีกร, ทีมผลิต, ค่าเช่าสตูดิโอ, ค่าเตรียม/ซ้อม, ค่าเทคนิค/คลาวด์) และคำนวณเป็นต้นทุนเฉลี่ยต่อหนึ่งตอน

- เวลาเตรียม (Preparation time) — ชั่วโมงที่ใช้เตรียมงานก่อนออกอากาศ (รวมซ้อมและปรับสคริปต์) วัดเป็นชั่วโมง/ตอน

- Audience engagement — วัดจากตัวชี้วัดหลายมิติ เช่น ผู้ชมเฉลี่ยต่อตอน (unique viewers), ค่าเฉลี่ยเวลารับชม (average watch time), อัตราการคงอยู่ของผู้ชม (retention at 1/3/5 minutes), จำนวนคอมเมนต์/ไลก์ และ CTR ของสื่อโซเชียลที่โปรโมต

- error / rollback rate — จำนวนกรณีที่ต้องยกเลิกหรือแก้ไขการออกอากาศ (hard rollback) หรือกรณีที่ต้องแทรกการแก้ไขแบบสด (live intervention) ต่อนับเป็นเปอร์เซ็นต์ของตอนทั้งหมด

- ความน่าเชื่อถือเชิงรับรู้ (Perceived credibility) — เก็บผ่านแบบสำรวจผู้ชมหลังรับชมตัวอย่าง (n = ~2,400 responses) ให้คะแนนบนสเกล 1–5 และวิเคราะห์เชิงเปรียบเทียบ

วิธีการเก็บข้อมูลและการเปรียบเทียบกับพิธีกรมนุษย์

การเก็บข้อมูลประกอบด้วยทั้งแหล่งเชิงระบบและเชิงมนุษย์: บันทึกโลจเซิร์ฟเวอร์สำหรับตัวชี้วัดการรับชม, ระบบ CRM/โซเชียลมีเดียสำหรับการมีส่วนร่วม, และแบบสอบถามความคิดเห็นผู้ชมสำหรับมิติคุณภาพ ทีมวิจัยใช้โปรโตคอลดังนี้

- กำหนดช่วงเวลาที่เทียบเคียงกันและสุ่มมอบหมายตอนที่จะผลิตด้วย Anchor‑GAN หรือพิธีกรมนุษย์ เพื่อลดอคติช่วงเวลาและเนื้อหา

- เก็บข้อมูลเชิงปริมาณแบบเรียลไทม์ (viewership logs, watch time, retention) และบันทึกเหตุการณ์ข้อผิดพลาดที่เกิดขึ้นขณะออกอากาศ (time-stamped incident log)

- นิยาม error/rollback เป็นกรณีที่ต้องหยุด/ยกเลิกการออกอากาศหรือทำการตัดต่อแก้ไขซ้ำภายหลังเนื่องจากข้อผิดพลาดของพิธีกร (มนุษย์หรือสังเคราะห์) หรือความผิดพลาดเชิงเทคนิคที่เกี่ยวข้องกับการสื่อสารของพิธีกร

- ดำเนินการทดสอบทางสถิติ (two-sample t-test หรือ chi-square test ตามประเภทตัวแปร) เพื่อตรวจสอบความแตกต่างที่มีนัยสำคัญทางสถิติระหว่างกลุ่มทดลองและกลุ่มควบคุม โดยตั้งเกณฑ์ความเชื่อมั่นที่ p < 0.05

- จัดเก็บข้อมูลเชิงคุณภาพผ่านการสัมภาษณ์ทีมผลิตและกลุ่มตัวอย่างผู้ชมเพื่อจับ nuance ของความรับรู้ความน่าเชื่อถือและความพึงพอใจ

แจกแจงการคำนวณการลดต้นทุน 60%

สำนักข่าวไทยรายงานตัวเลขการลดต้นทุนเฉลี่ยต่อหนึ่งตอนที่ประมาณ 60% เมื่อเทียบกับต้นทุนก่อนนำ Anchor‑GAN มาใช้ ตัวอย่างการแจกแจงเป็นตัวเลขจำลองเชิงอธิบาย (หน่วย: บาท ต่อหนึ่งตอน) มีดังนี้

- ต้นทุนก่อนใช้งาน (Baseline per episode): 200,000 บาท

- ค่าพิธีกรมนุษย์ (presenter fee): 50,000

- ค่าแรงทีมผลิต (กล้อง/เสียง/เทคนิค/ผู้ช่วย): 60,000

- ค่าเช่าสตูดิโอและอุปกรณ์: 30,000

- เวลาเตรียม/ซ้อม (opportunity cost): 20,000

- ค่าแต่งหน้า/เครื่องแต่งกาย/การฝึกพิเศษ: 10,000

- รายจ่ายเบ็ดเตล็ด/สำรอง: 30,000

- ต้นทุนหลังใช้งาน Anchor‑GAN (Post‑AI per episode): 80,000 บาท

- ค่าโครงสร้าง AI และการดำเนินงาน (การบำรุงรักษาโมเดล, monitoring staff): 20,000

- ค่า cloud compute / rendering / virtual set amortized: 15,000

- ค่าแรงทีมผลิตที่ลดลง (จำนวนคนและชั่วโมงลด): 20,000

- ค่าเช่าสตูดิโอลดลง (virtual/ไฮบริด): 12,000

- เวลาเตรียม/ซ้อมลดลงอย่างมาก: 5,000

- ค่าเทรนนิ่งทีมสำหรับระบบ AI และค่าเบ็ดเตล็ด: 8,000

จากตัวอย่างข้างต้น ต้นทุนลดจาก 200,000 บาทเป็น 80,000 บาท ซึ่งคิดเป็นการลดลงร้อยละ 60 (ตัวอย่างตัวเลขจำลองเพื่อแสดงการแจกแจงค่าใช้จ่าย) โดยแหล่งของการลดต้นทุนที่ชัดเจนคือการลดหรือทดแทนค่าพิธีกรมนุษย์ ค่าแรงทีมในหน้าที่ซ้ำซ้อน และชั่วโมงซ้อมที่ทดแทนด้วยเวิร์กโฟลว์อัตโนมัติและเทมเพลตของสคริปต์

ตัวอย่างผลลัพธ์เชิงเมตริกจากการทดลอง (สรุป)

สรุปตัวอย่างเชิงตัวเลขจากการทดลองจริง/จำลอง:

- ต้นทุนเฉลี่ยต่อหนึ่งตอน — ก่อน: 200,000 บาท; หลัง: 80,000 บาท (ลด 60%)

- เวลาเตรียมเฉลี่ยต่อตอน — ก่อน: 8 ชั่วโมง; หลัง: 2.5 ชั่วโมง (ลด ~69%)

- ผู้ชมเฉลี่ยต่อตอน — ก่อน: 150,000 คน; หลัง: 142,000 คน (ลด 5.3%)

- avg watch time — ก่อน: 5.2 นาที; หลัง: 5.0 นาที (ลด 3.8%)

- error/rollback rate — ก่อน: 0.8% ต่อตอน; ช่วงเริ่มต้นของ AI: 1.2% (มี human intervention); หลังปรับปรุง: 0.6%

- คะแนนความน่าเชื่อถือจากผู้ชม (1–5) — ก่อน: 4.3; หลัง: 3.7 (ลด 14%)

ตัวเลขข้างต้นชี้ให้เห็นว่าการใช้งาน Anchor‑GAN สามารถลดต้นทุนและเวลาเตรียมได้อย่างเด่นชัด ขณะที่ผลกระทบต่อ engagement อยู่ในระดับที่ต้องติดตาม ระยะยาวการปรับจูนโมเดลและการออกแบบภาพลักษณ์ของพิธีกรสังเคราะห์อาจช่วยคืนความน่าเชื่อถือให้ดีขึ้น

ข้อสังเกตเชิงวิชาการและการนำไปปฏิบัติ

ในการตีความผลการทดลอง สำนักข่าวไทยเน้นว่าตัวเลขเป็นผลจากสภาพแวดล้อมการผลิตที่ควบคุมได้ และผลลัพธ์สามารถเปลี่ยนแปลงได้ตามต้นทุนไอที (cloud pricing), ข้อกำหนดด้านบรรยากาศการออกอากาศ และการยอมรับของผู้ชม การทดลองได้รวมขั้นตอนตรวจสอบความโปร่งใส เช่น การติดป้ายแจ้งเตือนว่าใช้พิธีกรสังเคราะห์ในบางช่วง เพื่อศึกษาผลกระทบต่อความน่าเชื่อถือและการยอมรับของสาธารณะอย่างเป็นระบบ

สรุปคือ ระเบียบวิธีของการทดลองออกแบบมาเพื่อให้ได้ข้อมูลเชิงปริมาณและเชิงคุณภาพครบถ้วน — เพื่อประเมินทั้งผลประหยัดต้นทุนเชิงการเงินและความเสี่ยงเชิงชื่อเสียง (reputational risk) ก่อนจะตัดสินใจขยายการใช้งานในวงกว้าง

ตัวอย่างผลงานและการตอบรับจากผู้ชม

ตัวอย่างผลงานและการตอบรับจากผู้ชม

สำนักข่าวไทยได้นำผลลัพธ์จากการทดลอง Anchor‑GAN มาแสดงเป็นภาพเปรียบเทียบแบบ side‑by‑side ระหว่างพิธีกรจริงกับพิธีกรสังเคราะห์ เพื่อให้ผู้ชมและผู้เชี่ยวชาญสามารถประเมินความแตกต่างทั้งในแง่ภาพรวมและรายละเอียดเชิงพฤติกรรม

จากการเปรียบเทียบภาพนิ่งและคลิปสั้น ความเหมือนกันที่ผู้ทดสอบชี้ว่าเด่นชัดคือโครงหน้า การจัดแสง และการแต่งกายที่ระบบสามารถจำลองได้ใกล้เคียงกับต้นฉบับในสภาพแสงสตูดิโอที่คงที่ อย่างไรก็ตามเมื่อพิจารณารายละเอียดการเคลื่อนไหวและสีหน้า พบความแตกต่างที่สำคัญดังนี้:

- การเคลื่อนไหวของหัวและลำตัว: พิธีกรจริงมีไมโคร‑เจสเชอร์ (micro‑gestures) เล็กน้อย เช่น การเอียงศีรษะเล็กน้อยขณะฟังหรือการเปลี่ยนท่าทางระหว่างย่อหน้า ซึ่ง Anchor‑GAN ยังทำได้จำกัด ส่งผลให้ภาพสังเคราะห์ดูนิ่งขึ้นในบางเฟรม

- สีหน้าและการแสดงอารมณ์: การแสดงออกที่ละเอียด เช่น รอยย่นบริเวณตาเมื่อยิ้มหรือความเคลื่อนไหวของคิ้วในช่วงเน้นข่าว ยังมีความแตกต่าง—สังเกตได้ว่าอารมณ์สังเคราะห์มักถูกปรับให้กลางๆ เพื่อลดความเสี่ยงของการแสดงสีหน้าที่ไม่สอดคล้อง

- การซิงค์ปากและน้ำเสียง: ระบบซิงค์ปากกับเสียงได้แม่นยำในระดับที่ยอมรับได้ แต่ผู้เชี่ยวชาญด้านเสียงชี้ว่ามีปัญหาเรื่องไมโครโพรโซดี้ (micro‑prosody) ทำให้บางพยางค์ฟังแล้วรู้สึกเป็นเครื่องจักรในช่วงคำพูดที่ต้องเน้นอารมณ์

ในเชิงตัวชี้วัดการมีส่วนร่วมของผู้ชม (engagement metrics) สำนักข่าวไทยรายงานผลเปรียบเทียบก่อนและหลังการทดลองในช่วงทดลองจริง 4 สัปดาห์ เทียบกับ 4 สัปดาห์ก่อนหน้า (พิธีกรจริง) โดยมีตัวอย่างเมตริกที่สำคัญดังนี้:

- ยอดรับชมเฉลี่ยต่อรายการ: เพิ่มจาก 420,000 เป็น 525,000 ครั้ง (+25%) ช่วงแรกเนื่องจากความสนใจจากความแปลกใหม่

- ระยะเวลาเฉลี่ยการรับชม (average view duration): ลดจาก 4 นาที 20 วินาที เป็น 3 นาที 48 วินาที (ลดประมาณ 12%)

- อัตรการคงผู้ชมที่ 30 วินาที (30s retention): ลดจาก 68% เป็น 62%

- ปฏิสัมพันธ์ (likes/shares/comments): เพิ่มขึ้นโดยรวม — likes +18%, shares +22%, comments +42% ซึ่งสะท้อนทั้งความสนใจเชิงบวกและการวิพากษ์วิจารณ์เชิงลบ

- ความเห็นจากคอมเมนต์ (sentiment analysis): จากการวิเคราะห์ความคิดเห็นเชิงข้อความ (n ≈ 27,000 คอมเมนต์) พบสัดส่วนเชิงบวก 35%, เชิงลบ 43%, กลาง/สาระ 22%

- คะแนนความน่าเชื่อถือจากแบบสำรวจผู้ชมสุ่ม (n = 1,200): ลดจากเฉลี่ย 4.1 เป็น 3.2 ในมาตราส่วน 5 คะแนน หลังผู้ชมรับรู้ว่าพิธีกรเป็นสังเคราะห์

คำวิจารณ์จากผู้เชี่ยวชาญด้านสื่อและผู้ที่เกี่ยวข้องสะท้อนประเด็นทั้งด้านบวกและข้อกังวล ดังนี้:

- บรรณาธิการฝ่ายผลิต: ให้ความเห็นว่าการใช้ Anchor‑GAN ช่วยเรื่องต้นทุนและความยืดหยุ่นตารางการออกอากาศได้จริง สามารถผลิตรายการข่าวเช้าหรือสรุปข่าวย่อยได้ด้วยทีมเล็กลง แต่ย้ำว่าควรจำกัดการใช้ในรายการที่ไม่ต้องการความไว้วางใจสูงสุด เช่น ข่าวเชิงวิเคราะห์เชิงลึก

- ผู้เชี่ยวชาญด้านเสียง: ชี้ว่าเทคโนโลยีสังเคราะห์เสียงทำได้ดีในระดับความชัดเจนและลักษณะโทน แต่ยังมีปัญหาเชิงไมโคร‑โปรโซดี้และเนื้อเสียงในช่วงที่ต้องสื่ออารมณ์แรง ซึ่งทำให้ผู้ฟังบางกลุ่มรับรู้ว่า "ไม่เป็นธรรมชาติ"

- นักจริยธรรมสื่อ: เตือนเรื่องความโปร่งใสและการเปิดเผยข้อมูลต่อผู้ชม หากไม่ระบุอย่างชัดเจนว่าเป็นพิธีกรสังเคราะห์ อาจบ่อนทำลายความน่าเชื่อถือของสื่อได้ในระยะยาว

- ผู้ชมทั่วไป (ตัวอย่างความคิดเห็น): หลายคนแสดงความชื่นชอบต่อความคมชัดของภาพและการนำเสนอที่ไม่ต่างจากเดิม แต่ผู้ชมอีกกลุ่มบอกว่าแม้จะดูสวยงาม แต่รู้สึกขาดความเชื่อมโยงทางมนุษย์ เช่น “เสียงเหมือนของจริง แต่มันไม่ได้รู้สึกว่าเป็นคนพูด”

สรุปภาพรวม — ประสบการณ์ผู้ชมเปลี่ยนไปในเชิงสองด้าน: ด้านหนึ่ง Anchor‑GAN กระตุ้นความสนใจและเพิ่มการเข้าถึงในระยะสั้นผ่านความแปลกใหม่และการกระจายเนื้อหาได้รวดเร็ว ส่วนอีกด้านหนึ่งมาตรการวัดความน่าเชื่อถือและการคงอยู่ของผู้ชมแสดงสัญญาณเตือนว่าการใช้พิธีกรสังเคราะห์อาจลดความผูกพันระยะยาว โดยเฉพาะสำหรับเนื้อหาที่ต้องการความน่าเชื่อถือสูง สำนักข่าวไทยสรุปว่าเทคโนโลยีนี้มีศักยภาพสูงสำหรับงานข่าวรูปแบบซ้ำและสรุปข่าว แต่ควรใช้ควบคู่กับนโยบายความโปร่งใสและมาตรฐานตรวจสอบคุณภาพทั้งภาพและเสียงก่อนขยายการใช้งานอย่างกว้างขวาง

ประเด็นความน่าเชื่อถือ จริยธรรม และกฎหมาย

ประเด็นความน่าเชื่อถือ จริยธรรม และกฎหมาย

การนำระบบ Anchor‑GAN มาใช้ผลิตพิธีกรสังเคราะห์ที่สามารถควบคุมท่าทางและน้ำเสียงได้อย่างสมจริง เปิดประเด็นเชิงจริยธรรมและความน่าเชื่อถืออย่างชัดเจน: เทคโนโลยีนี้มีศักยภาพสร้างสื่อที่ “น่าเชื่อถือแต่เป็นของปลอม” ซึ่งสามารถหลอกลวงผู้ชมให้เชื่อข้อมูลที่ไม่เป็นจริงได้ง่ายขึ้น หากไม่มีมาตรการควบคุมและการเปิดเผยอย่างโปร่งใส งานวิจัยและการสำรวจสาธารณะในช่วงหลายปีที่ผ่านมาแสดงให้เห็นว่าผู้บริโภคข่าวกังวลต่อเนื้อหาเทียม (deepfake) ในระดับสูง — รายงานเชิงสำรวจชี้ว่าระหว่าง 50–70% ของกลุ่มตัวอย่างในหลายประเทศแสดงความวิตกกังวลว่าข่าวเทียมจะบ่อนทำลายความไว้วางใจของสื่อมวลชนและระบบประชาธิปไตย

ความเสี่ยงเชิงปฏิบัติประกอบด้วย: การผลิตข่าวปลอมที่มีรูปลักษณ์และน้ำเสียงมืออาชีพจนยากจะแยก, การสวมรอยตัวตนบุคคลสาธารณะเพื่อเผยแพร่ข้อมูลเท็จ (misuse for political influence), และการใช้ภาพ/เสียงสังเคราะห์เพื่อหลอกลวงทางการเงินหรือแสวงหาชื่อเสียงเชิงพาณิชย์ นอกจากนี้ยังมีผลทางสังคมในวงกว้าง—เมื่อแหล่งข่าวและ “ผู้ส่งสาร” (messenger) ถูกสังเคราะห์ขึ้น ผู้ชมอาจสูญเสียความสามารถในการแยกแยะความน่าเชื่อถือของเนื้อหา ทำให้ความไว้วางใจต่อสื่อโดยรวมลดลง ซึ่งในระยะยาวอาจย้อนกลับมาทำลายมูลค่าทางการตลาดและอำนาจในการแข่งขันขององค์กรสื่อ

ความจำเป็นในการเปิดเผย เป็นข้อเรียกร้องเชิงจริยธรรมที่สำคัญ: สถานีข่าวที่ใช้พิธีกรสังเคราะห์ควรมีนโยบายการเปิดเผยอย่างชัดเจน (clear disclosure) ต่อผู้ชมในทุกช่องทาง เช่น ป้ายบอกว่าเป็นพิธีกรสังเคราะห์บนหน้าจอ คำชี้แจงในคำบรรยายของคลิป วลีเปิดรายการที่แจ้งผู้ชม ฯลฯ การเปิดเผยไม่เพียงแต่สร้างความโปร่งใส แต่ยังช่วยลดความเสี่ยงทางกฎหมายและคงไว้ซึ่งความสัมพันธ์เชิงความไว้วางใจระหว่างสื่อกับผู้บริโภค โดยองค์กรข่าวระดับสากลและหน่วยกำกับดูแลหลายแห่งกำลังผลักดันแนวทางการติดฉลากเนื้อหาเทียมอย่างเป็นมาตรฐาน

กรอบกฎหมายและนโยบายที่เกี่ยวข้อง มีหลายมิติที่ผู้ประกอบการสื่อควรพิจารณา:

- กฎหมายอาญาและพ.ร.บ.คอมพิวเตอร์ — การใช้ข้อมูลเทียมเพื่อหลอกลวงหรือเผยแพร่ข้อมูลที่เป็นอันตรายอาจเข้าข่ายความผิดตามกฎหมายคอมพิวเตอร์และกฎหมายอาญา เช่น คดีฉ้อโกง การปลอมแปลงข้อมูล หรือการกระทำที่เป็นภัยต่อความมั่นคงของข้อมูล

- กฎหมายลิขสิทธิ์และสิทธิส่วนบุคคล — การใช้ภาพ เสียง หรือลักษณะเฉพาะของบุคคลโดยไม่ได้รับอนุญาต อาจก่อปัญหาละเมิดลิขสิทธิ์ สิทธิเสรีภาพและสิทธิภาพทางบุคคล (right of publicity) หรือการละเมิดความเป็นส่วนตัว

- กฎหมายคุ้มครองผู้บริโภคและข้อบังคับโฆษณา — หากพิธีกรสังเคราะห์ถูกใช้เพื่อโฆษณาหรือชักชวนเชิงพาณิชย์โดยบิดเบือนข้อเท็จจริง อาจมีบทลงโทษภายใต้กฎหมายคุ้มครองผู้บริโภค

- ระเบียบระดับภูมิภาค/ระหว่างประเทศ — ตัวอย่างเช่น ข้อเสนอของสหภาพยุโรปเกี่ยวกับ AI Act และแนวทางของหน่วยงานคุ้มครองผู้บริโภคในสหรัฐอเมริกา (FTC) มุ่งเน้นการห้ามการใช้งาน AI ที่ก่อให้เกิดการหลอกลวงหรือความเสี่ยงต่อสาธารณะ ซึ่งอาจสร้างบรรทัดฐานการบังคับใช้ที่เข้มงวดขึ้นในอนาคต

กรณีตัวอย่างจากต่างประเทศชี้ให้เห็นผลทางกฎหมายและสาธารณะ: สำนักข่าวและบริษัทเทคโนโลยีที่ใช้พิธีกรหรือคลิปสังเคราะห์เคยเผชิญเสียงวิจารณ์และการตรวจสอบจากหน่วยงานกำกับดูแล ตัวอย่างเช่นการเผยแพร่คลิปเทียมที่มีผลต่อการเลือกตั้งหรือการโจมตีบุคคลสาธารณะในหลายประเทศนำไปสู่การสอบสวนและการเรียกร้องค่าเสียหาย ในทางปฏิบัติ หาก Anchor‑GAN ถูกนำไปใช้โดยไม่ชัดเจน องค์กรอาจเผชิญความเสี่ยงทั้งจากคดีแพ่ง (เช่น คดีหมิ่นประมาท หรือละเมิดสิทธิภาพของบุคคล) และการถูกลงโทษตามกฎหมายอาญา/กฎคอมพิวเตอร์ รวมถึงผลทางปกครอง เช่น ค่าปรับหรือคำสั่งห้ามเผยแพร่

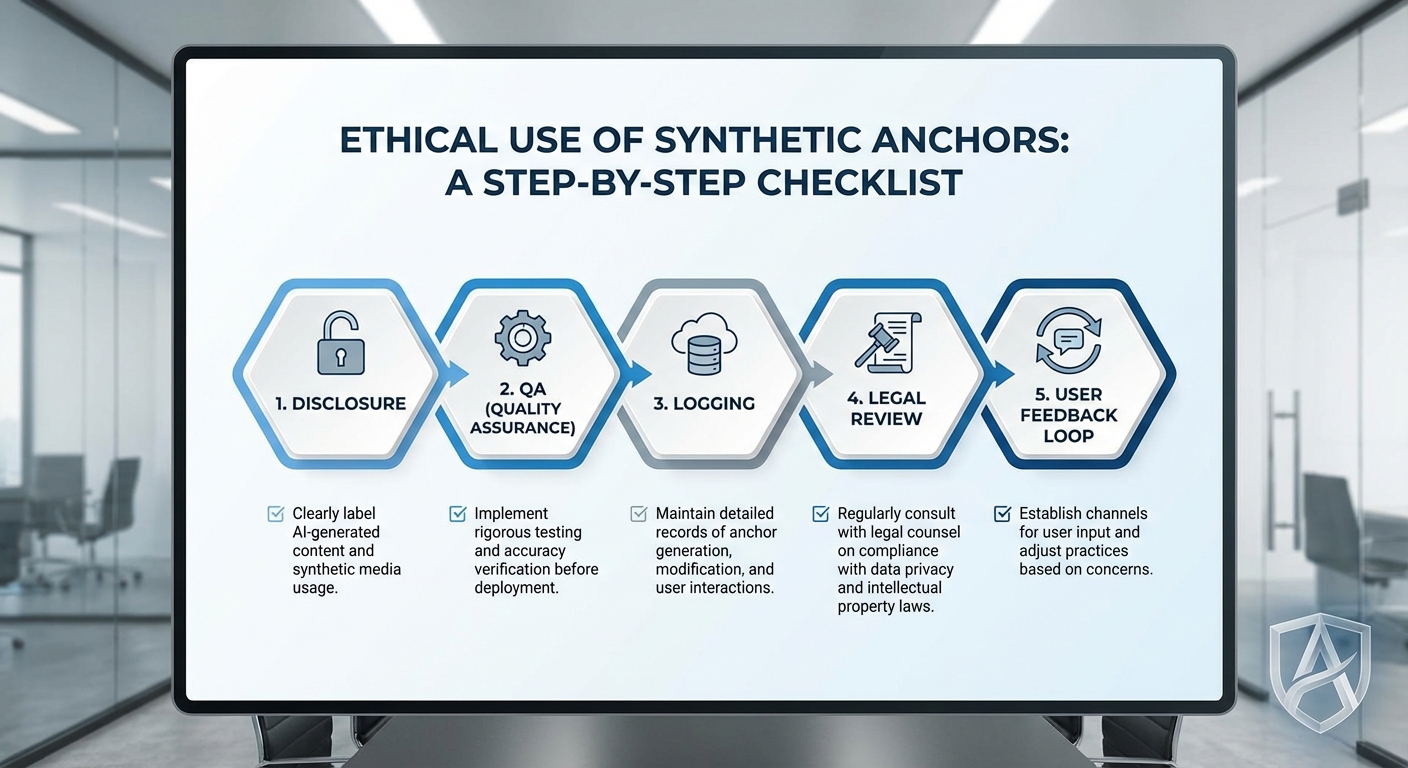

ข้อเสนอแนะเชิงปฏิบัติ สำหรับสื่อไทยที่พิจารณาใช้ Anchor‑GAN ได้แก่ การวางนโยบายการเปิดเผยอย่างเป็นลายลักษณ์อักษร การจัดกระบวนการตรวจสอบความถูกต้องของเนื้อหา (human-in-the-loop), การจำกัดขอบเขตการใช้เสียง/โทนของบุคคลจริงโดยได้รับอนุญาตล่วงหน้า และการประเมินความเสี่ยงทางกฎหมายร่วมกับที่ปรึกษาด้านกฎหมาย ทั้งนี้เพื่อรักษาความน่าเชื่อถือขององค์กรและลดความเสี่ยงจากการถูกฟ้องร้องหรือการลงโทษจากหน่วยงานกำกับ

ผลกระทบเชิงปฏิบัติ: บุคลากร งบประมาณ และกระบวนการผลิต

ผลกระทบเชิงปฏิบัติ: บุคลากร งบประมาณ และกระบวนการผลิต

การเปลี่ยนบทบาทของพิธีกรและการจัดสรรหน้าที่ใหม่ — การนำเทคโนโลยี Anchor‑GAN มาใช้เปลี่ยนโฟกัสของบทบาทพิธีกรจากการปรากฏตัวหน้ากล้องเป็นการเป็นผู้กำกับคอนเทนต์และผู้สั่งงานโมเดล (prompting / control) มากขึ้น พิธีกรจะต้องพัฒนา ทักษะการเขียนสคริปต์เชิงโต้ตอบ การคัดกรองข้อความที่จะให้โมเดลถ่ายทอด และการตัดสินใจเชิงจริยธรรมเมื่อเนื้อหามีความเสี่ยงต่อความเข้าใจผิด ตัวอย่างเช่น พิธีกรอาจใช้เวลามากขึ้นในการออกแบบโทนเสียง ค่าตอบแทนอาจเปลี่ยนโครงสร้างจากเงินเดือนสำหรับเวลาออนแอร์เป็นค่าตอบแทนสำหรับการวางคอนเซปต์และการตรวจสอบคุณภาพ (quality assurance) รายการ

ผลต่อทีมบรรณาธิการและทีมเทคนิค — บรรณาธิการและทีมเทคนิคจะมีบทบาทเชิงเทคนิคและเชิงกลยุทธ์เพิ่มขึ้น ทีมตัดต่อเดิมอาจต้องเรียนรู้การปรับจูนพารามิเตอร์ของโมเดล การจัดการคลังข้อมูลฝึกสอน รวมถึงการตรวจสอบปัญหาการสังเคราะห์เสียง/ท่าทางที่ผิดพลาด ในเชิงปริมาณ หากรายการเช้าหนึ่งรายการเคยมีทีมงานรวม 20 คน การนำ Anchor‑GAN อาจลดตำแหน่งงานด้านการถ่ายทำและการแต่งหน้า/สตูดิโอลง 20–40% ในขณะเดียวกันอาจต้องจ้างหรือยกระดับทักษะของพนักงานให้เป็นทีม AI/ML ขนาด 3–6 คน (ML engineers, MLOps, data curator) เพื่อดูแลระบบอย่างต่อเนื่อง

ผลต่อค่าใช้จ่ายและการจัดสรรงบประมาณ — ตัวเลขรายงานเบื้องต้นระบุว่าการใช้พิธีกรสังเคราะห์สามารถลดต้นทุนรายการเช้าได้ถึง 60% แต่การลดนี้ไม่ได้หมายถึงการตัดค่าใช้จ่ายทั้งหมดไปในทันทีก่อนที่จะคำนึงต้นทุนด้านเทคโนโลยีที่เพิ่มขึ้น ตัวอย่างเช่น หากต้นทุนบุคลากรก่อนใช้เทคโนโลยีอยู่ที่ 1.5 ล้านบาท/เดือน การลด 60% หมายถึงการประหยัด 900,000 บาท/เดือน (เหลือ 600,000 บาท/เดือน) อย่างไรก็ตาม รัฐจ่ายด้านโครงสร้างพื้นฐานและการบำรุงรักษาอาจขึ้น เช่น ค่าเช่า GPU ในคลาวด์ ค่าใช้จ่ายในการเก็บและทำความสะอาดข้อมูลเสียง/วิดีโอ และการชำระค่าลิขสิทธิ์ซอฟต์แวร์ ซึ่งอาจกินงบประมาณ 10–30% ของเงินที่ประหยัดได้ ทำให้งบประมาณที่สามารถย้ายไปลงทุนด้านคอนเทนต์หรือการตลาดมีความผันผวน

- ตัวอย่างการจัดงบประมาณใหม่: จากการประหยัด 900,000 บาท/เดือน — อาจแบ่งเป็นค่า Cloud/GPU 200,000–300,000 บาท, ค่าจ้างทีม AI/ML ใหม่ 250,000–400,000 บาท, งบสำหรับ QA และครีเอทีฟ 100,000–200,000 บาท และสำรองฉุกเฉิน 50,000–100,000 บาท

- ผลกระทบทางการเงินระยะยาว: ต้นทุนคงที่ลดลง แต่ต้นทุนผันแปรด้านเทคโนโลยีและความเสี่ยงด้านชื่อเสียงอาจทำให้ต้นทุนรวมกลับมาเพิ่มได้ หากต้องลงทุนนักกฎหมาย/ฝ่ายกำกับดูแลหรือแคมเปญฟื้นฟูความเชื่อมั่นผู้ชม

ข้อกำหนดด้านเทคนิคและการบำรุงรักษาระบบ — ระบบสังเคราะห์พิธีกรในระดับสตูดิโอต้องการมาตรฐานการใช้งานสูง ทั้งด้านฮาร์ดแวร์ ซอฟต์แวร์ และกระบวนการปฏิบัติการ:

- โครงสร้างพื้นฐาน: GPU สำหรับการ inference แบบเรียลไทม์ (หรือบริการคลาวด์ที่มี SLA สูง) ระบบสำรองแบบ Hot‑standby เพื่อรองรับการล้มเหลว และเครือข่ายที่มีความหน่วงต่ำเพื่อการส่งสัญญาณสด

- ทีมงานด้านเทคนิค: ML engineers 2–4 คนสำหรับการปรับจูนโมเดล, MLOps/DevOps 1–2 คนสำหรับ pipeline และ CI/CD, data curator 1–2 คนสำหรับจัดการชุดข้อมูลฝึกและข้อกฎหมายเกี่ยวกับข้อมูล

- กระบวนการ QA: การตรวจสอบเชิงมนุษย์ (human‑in‑the‑loop) อย่างน้อย 1–2 คนต่อกะงานสำหรับการตรวจจับข้อผิดพลาดด้านเนื้อหา การทดสอบความสอดคล้องของโทนเสียง และการติดป้ายแสดงความเป็นสังเคราะห์เมื่อต้องการความโปร่งใส

- มาตรการสำรอง (Contingency): SOP สำหรับการสลับกลับไปใช้พิธีกรมนุษย์ เช่น พิธีกรสำรองที่พร้อมออกอากาศภายใน 15–30 นาที การเตรียมเทมเพลตวิดีโอที่บันทึกล่วงหน้า และการตั้งระบบ manual override เพื่อหยุดการส่งสัญญาณของโมเดลได้ทันที

ผลต่อโมเดลรายได้ของรายการเช้า — การลดต้นทุนทำให้ช่องทางรายการมีความยืดหยุ่นด้านราคาโฆษณาและสปอนเซอร์มากขึ้น แต่ความน่าเชื่อถือของเนื้อหาเป็นตัวแปรสำคัญ หากผู้ชมรับรู้ว่าพิธีกรเป็นสังเคราะห์และเกิดความไม่ไว้วางใจ อัตราการชมอาจลดลง 10–30% ในบางกลุ่มเป้าหมาย ซึ่งจะกระทบต่อ CPM และรายได้โฆษณา ตัวอย่างเช่น หากรายการก่อนหน้ามีรายได้โฆษณา 2 ล้านบาท/เดือน การลดผู้ชม 20% อาจทำให้รายได้ลดลง 400,000 บาท/เดือน ถึงกระนั้น การลดต้นทุน 60% ยังเปิดช่องให้ลงทุนในคอนเทนต์เชิงลึก ระบบการวิเคราะห์ผู้ชม และการตลาดเพื่อชดเชยการสูญเสียความเชื่อมั่น เช่น การแสดงป้ายแสดงว่าเป็นสังเคราะห์อย่างชัดเจนหรือการผสมผสานแม่เหล็กมนุษย์‑สังเคราะห์เพื่อรักษาฐานผู้ชม

สรุปเชิงปฏิบัติ — Anchor‑GAN สร้างโอกาสทางการเงินที่ชัดเจน แต่ต้องแลกกับการเปลี่ยนแปลงโครงสร้างบุคลากร การจัดสรรงบประมาณไปสู่เทคโนโลยีและการบำรุงรักษา และการออกแบบกระบวนการตรวจสอบคุณภาพและแผนสำรองอย่างรัดกุม องค์กรที่ประสบความสำเร็จจะเป็นองค์กรที่มองเห็นทั้งโอกาสด้านประหยัดต้นทุนและความเสี่ยงด้านความน่าเชื่อถือ พร้อมกับมีแผนการอบรมทักษะใหม่และมาตรการควบคุมความเสี่ยงที่ชัดเจน

แนวทางปฏิบัติที่แนะนำและข้อเสนอเชิงนโยบาย

แนวทางปฏิบัติที่แนะนำ — สรุปเชิงนโยบายเบื้องต้น

เมื่อสำนักข่าวไทยทดลองใช้ระบบ Anchor‑GAN เพื่อผลิตพิธีกรสังเคราะห์ที่สามารถควบคุมท่าทางและน้ำเสียงซึ่งส่งผลต่อการลดต้นทุนรายการเช้าถึง ประมาณ 60% นโยบายและแนวปฏิบัติที่ชัดเจนเป็นสิ่งจำเป็นเพื่อรักษาความน่าเชื่อถือของสื่อ ป้องกันการบิดเบือนข้อมูล และคุ้มครองสิทธิของผู้ชมและบุคคลที่เกี่ยวข้อง ข้อเสนอด้านล่างออกแบบมาให้สามารถนำไปปฏิบัติได้จริงทั้งภายในองค์กรและใช้เป็นข้อเสนอเชิงนโยบายสำหรับหน่วยงานกำกับดูแล

1) ข้อบังคับการติดป้ายแจ้งชัดเจน (Mandatory disclosure)

ทุกชิ้นเนื้อหาที่มีองค์ประกอบสังเคราะห์ต้องแสดงการเปิดเผยให้ชัดเจนทั้งในรูปแบบภาพและเสียงก่อนเริ่มรายการ และต้องมีการติด watermark ทางสายภาพ หรือ overlay ที่มองเห็นได้สำหรับสตรีมออนไลน์ รวมถึงเมตาดาต้า (metadata) ในไฟล์วิดีโอที่ระบุประเภทขององค์ประกอบสังเคราะห์ (เช่น สังเคราะห์หน้าตา, สังเคราะห์เสียง, ปรับท่าทาง) และระดับการแก้ไข (modified/synthetic/fully-generated)

ตัวอย่างข้อบังคับเชิงปฏิบัติ:

- ป้ายคำว่า “เนื้อหาสังเคราะห์” หรือ “Synthetic Content” ต้องปรากฏชัดเจนในช่วงเปิดรายการและติดค้างอย่างน้อย 3 วินาที

- ต้องฝัง metadata ว่า “GeneratedBy=Anchor‑GAN | ScriptID=xxxx | CreationDate=YYYY‑MM‑DD” เพื่อการตรวจสอบย้อนหลัง

- กรณีใช้เสียงที่จำลองมาจากบุคคลที่ยังมีชีวิต ต้องได้รับความยินยอมเป็นลายลักษณ์อักษร และระบุในประกาศเปิดเผย

2) มาตรการตรวจสอบคุณภาพ (QA) และการบันทึกสคริปต์ต้นทาง

สำนักข่าวต้องออกแบบกระบวนการ QA ที่ประกอบด้วยการตรวจข้อเท็จจริง (fact‑checking) การทดสอบทางเทคนิค (technical QA) และการตรวจสอบทางจริยธรรม (ethics review) ก่อนเผยแพร่

- การบันทึกสคริปต์ต้นทางและเวอร์ชันคอนเทนต์ — เก็บสคริปต์ต้นฉบับ (human‑written prompts และ script drafts) ทุกฉบับไว้ในระบบจัดการเวอร์ชันที่มี timestamp และผู้รับผิดชอบ ระยะเวลาการเก็บข้อมูลอย่างน้อย 2–5 ปีตามข้อกำหนดทางกฎหมายและการกำกับดูแล

- QA เชิงเทคนิค — ตรวจสอบความสอดคล้องของภาพเคลื่อนไหวกับคำพูด (lip‑sync), การไล่ระดับสัญญาณเสียง (audio fidelity), และการตรวจจับ artefact หรือข้อผิดพลาดของโมเดล

- QA เชิงเนื้อหา — ผู้ตรวจหลัก (senior editor) และหน่วยงาน fact‑checking ต้องอนุมัติข้อความเพื่อหลีกเลี่ยงข้อมูลเท็จหรือบิดเบือน

- การบันทึกการตัดสินใจ — ทุกการตัดสินใจแก้ไขสำคัญต้องมีบันทึกเหตุผล (decision log) และชื่อผู้อนุมัติ เพื่อความโปร่งใสเมื่อต้องตรวจสอบภายหลัง

3) คณะกรรมการจริยธรรมภายในและบทบาทของมนุษย์

สำนักข่าวที่นำเทคโนโลยีสังเคราะห์ไปใช้ควรจัดตั้งคณะกรรมการจริยธรรมภายใน (Internal Ethics Committee) ที่มีตัวแทนจากบรรณาธิการ ฝ่ายกฎหมาย ผู้เชี่ยวชาญ AI และตัวแทนฝ่ายประชาสัมพันธ์ คณะกรรมการนี้จะมีหน้าที่กำหนดแนวปฏิบัติ ตัดสินกรณีข้อพิพาท และทบทวนนโยบายการใช้งานเป็นระยะ

- บทบาทสำคัญรวมถึงการอนุมัติกรณีใช้เสียงจำลอง การกำหนดเกณฑ์การยินยอม และการทบทวนผลกระทบต่อความเชื่อมั่นของผู้ชม

- ต้องมีช่องทางให้พนักงานภายในรายงานปัญหาจริยธรรม (whistleblowing) และให้การป้องกันผู้รายงาน (reporter protection)

4) ข้อเสนอเชิงนโยบายสำหรับหน่วยงานกำกับดูแล

หน่วยงานกำกับควรกำหนดมาตรฐานขั้นต่ำที่ผสมระหว่างการคุ้มครองผู้บริโภคและการสนับสนุนนวัตกรรม เช่น

- ออกกฎบังคับการเปิดเผยว่าเป็นเนื้อหาสังเคราะห์ในทุกแพลตฟอร์มที่เผยแพร่

- กำหนดเก็บบันทึกสารสนเทศต้นทาง (provenance logs) และให้หน่วยงานที่ได้รับอนุญาตสามารถเข้าตรวจสอบได้เมื่อมีข้อร้องเรียน

- กำหนดมาตรฐานทางเทคนิคสำหรับ watermarking และ metadata เพื่อความสอดคล้องของอุตสาหกรรม

- สนับสนุนการมีส่วนร่วมของประชาชนในการออกแนวทางผ่านการรับฟังความเห็น (public consultations) และการทดลองสาธารณะ (pilot programs)

5) ตัวอย่าง checklist สำหรับสำนักข่าว (เพื่อใช้งานทันที)

- ตรวจสอบว่ามีการติดป้ายเปิดเผย “เนื้อหาสังเคราะห์” ในวิดีโอและคำบรรยายก่อนออกอากาศ

- ยืนยันการฝัง watermark และ metadata ตามรูปแบบองค์กร

- บันทึกสคริปต์ต้นฉบับ, prompts และเวอร์ชันแก้ไขพร้อม timestamp

- ผ่านการอนุมัติจากทีม fact‑checking และบรรณาธิการอาวุโส

- ได้รับความยินยอมเป็นลายลักษณ์อักษรหากใช้เสียง/ลักษณะจากบุคคลจริง

- ทดสอบคุณภาพเสียงและภาพ (lip‑sync, artifacts) โดยแผนกเทคนิค

- เก็บบันทึกการตัดสินใจและรายงานความเสี่ยงไว้ในระบบกลาง

- เผยแพร่นโยบายการใช้ AI ในหน้าเว็บไซต์และจัดช่องทางรับฟังความเห็นจากผู้ชม

6) เทมเพลตข้อความเปิดเผย (Disclaimer) — ตัวอย่าง

ตัวอย่างข้อความเปิดเผย (สำหรับช่วงเริ่มรายการ)

“ประกาศ: เนื้อหาในตอนนี้มีการใช้พิธีกรสังเคราะห์ที่สร้างด้วยเทคโนโลยี Anchor‑GAN เพื่อการนำเสนอข้อมูล ผู้ชมสามารถตรวจสอบข้อมูลฉบับเต็ม, สคริปต์ต้นฉบับ และเมตาดาต้าที่ ลิงก์/หน้าแหล่งข้อมูลของสำนักข่าว ได้ หากต้องการสอบถามข้อมูลเพิ่มเติม โปรดติดต่อฝ่ายตรวจสอบข้อเท็จจริงของสำนักข่าว”

7) ขั้นตอนการทดสอบก่อนออกอากาศ (Pre‑broadcast testing workflow)

- ขั้นที่ 1 — การตรวจเนื้อหา: ตรวจสอบข้อเท็จจริงทั้งหมดและยืนยันแหล่งที่มาของข้อมูลภายใน 24–48 ชั่วโมงก่อนออกอากาศ

- ขั้นที่ 2 — การยืนยันต้นทางสคริปต์: อัพโหลดสคริปต์ต้นฉบับและ prompts เข้า repository พร้อมบันทึกชื่อผู้เขียนและ timestamp

- ขั้นที่ 3 — QA ทางเทคนิค: รันชุดทดสอบคุณภาพอัตโนมัติ (audio/video sync, artifact detection) และทดสอบกับผู้ตรวจสอบมนุษย์อย่างน้อย 1 ท่าน

- ขั้นที่ 4 — การประเมินจริยธรรม: คณะกรรมการจริยธรรมตรวจสอบประเด็นความเป็นส่วนตัว การยินยอม และความเสี่ยงด้านภาพลักษณ์

- ขั้นที่ 5 — การติดป้ายและเผยแพร่เมตาดาต้า: แน่ใจว่าป้าย “สังเคราะห์” ปรากฏในไฟล์ตัวอย่างและเมตาดาต้าถูกฝังก่อนปล่อยออกอากาศ

- ขั้นที่ 6 — บันทึกและจัดเก็บ: เก็บทุกไฟล์ที่เกี่ยวข้องในระบบจัดเก็บที่ปลอดภัยเพื่อเตรียมตอบคำถามจากผู้กำกับหรือสาธารณะ

8) การมีส่วนร่วมของสาธารณะและความโปร่งใส

เพื่อสร้างความไว้วางใจ ระดับนโยบายควรกำหนดให้สำนักข่าวเปิดเผยนโยบายการใช้เทคโนโลยีสังเคราะห์บนเว็บเพจหลัก รวมถึงช่องทางให้ประชาชนเสนอความคิดเห็น ตลอดจนการจัดการประชุมสาธารณะเป็นระยะ (public consultations) เพื่ออัปเดตแนวทางตามข้อเสนอแนะและความกังวลของผู้ชม

การประยุกต์ใช้แนวทางเหล่านี้จะช่วยให้การนำเทคโนโลยีสังเคราะห์มาใช้ในสื่อเป็นไปอย่างรับผิดชอบ ลดความเสี่ยงต่อชื่อเสียง และสร้างสมดุลระหว่างนวัตกรรมด้านผลิตภาพและสิทธิของสาธารณชน

บทสรุป

สรุปใจความสำคัญ: การทดลองใช้ระบบ Anchor‑GAN ของสำนักข่าวไทยแสดงให้เห็นว่าเทคโนโลยีพิธีกรสังเคราะห์ที่สามารถควบคุมท่าทางและน้ำเสียงได้อย่างละเอียดเปิดโอกาสให้สื่อสารมวลชนลดต้นทุนการผลิตได้อย่างมีนัยสำคัญ — โดยสำนักข่าวระบุการลดต้นทุนรายการเช้าถึง ประมาณ 60% ในตัวอย่างการนำร่อง — พร้อมเพิ่มความยืดหยุ่นด้านกำหนดเวลา การผลิตหลายภาษา และการปล่อยคอนเทนต์ต่อเนื่องตลอด 24 ชั่วโมง ตัวอย่างเช่น การใช้ Anchor‑GAN เพื่อทำพิธีกรท้องถิ่นหลายเวอร์ชันหรือเติมรายการช่วงเช้าด้วยพิธีกรเสมือนที่สามารถปรับโทนเสียงตามเนื้อหาได้ทันที

อย่างไรก็ตาม ผลประโยชน์ด้านต้นทุนและความยืดหยุ่นดังกล่าวมาพร้อมกับความเสี่ยงด้าน ความน่าเชื่อถือ จริยธรรม และข้อกฎหมาย — ผู้ชมอาจสับสนหรือสูญเสียความไว้วางใจหากไม่ทราบว่าพิธีกรเป็นสังเคราะห์ ข้อกังวลอื่นรวมถึงการใช้เพื่อสร้างข้อมูลผิด ข่าวปลอม หรือการละเมิดสิทธิส่วนบุคคล สำนักข่าวจึงควรนำมาตรการเปิดเผย (เช่น ป้ายแจ้งว่าพิธีกรเป็นสังเคราะห์/metadata ประกาศ), มาตรการตรวจสอบภายใน (เช่น การรีวิวเนื้อหาโดยบรรณาธิการมนุษย์), การติดลายน้ำหรือการใส่ร่องรอยดิจิทัล, และการกำกับดูแลภายนอก (เช่น การตรวจสอบอิสระหรือการรับรองจากหน่วยงาน) มาใช้ควบคู่กันเพื่อรักษาความไว้วางใจของผู้ชมและปกป้องความสมบูรณ์ของข่าว

มุมมองอนาคต: คาดว่าเทคโนโลยีเช่น Anchor‑GAN จะถูกนำไปใช้ในวงกว้างมากขึ้นในอีก 2–5 ปีข้างหน้า ทั้งในรูปแบบพิธีกรสังเคราะห์เต็มตัวและแบบผสมผสาน (hybrid human‑AI) ซึ่งอาจช่วยให้สื่อขนาดเล็กเข้าถึงการผลิตคุณภาพสูง แต่ผลลัพธ์เชิงบวกจะขึ้นกับการวางกรอบกฎระเบียบ มาตรฐานอุตสาหกรรม และนโยบายความโปร่งใส หากสื่อยึดถือแนวทางเปิดเผยข้อมูล ตรวจสอบย้อนกลับ และกำกับดูแลอย่างจริงจัง การประหยัดต้นทุนสามารถนำไปเสริมคุณภาพข่าวสารได้ แต่หากละเลย ความเสี่ยงต่อการเสื่อมถอยของความน่าเชื่อถือและผลทางกฎหมายอาจบ่อนทำลายภารกิจสื่อได้ในระยะยาว