PixVerse เปิดตัวแพลตฟอร์มวิดีโอ AI แบบเรียลไทม์ที่สัญญาว่าจะ "พลิกโฉมการสร้างเนื้อหา" สำหรับสื่อและธุรกิจ ด้วยการผสานโมเดลเชิงสร้างสรรค์ (generative models), อวาตาร์เสมือน และการสตรีมสดเข้าด้วยกัน แพลตฟอร์มนี้ช่วยให้ผู้ผลิตสามารถสร้างเนื้อหาแบบโต้ตอบและปรับแต่งตามผู้ชมได้ทันที ลดขั้นตอนการผลิตแบบดั้งเดิมที่กินทั้งเวลาและทรัพยากร บริษัทระบุว่าในบางกรณีการใช้ PixVerse สามารถลดเวลาและต้นทุนการผลิตลงอย่างมีนัยสำคัญ (บางกรณีถึงครึ่งหนึ่ง) เมื่อเทียบกับเวิร์กโฟลว์ดั้งเดิม

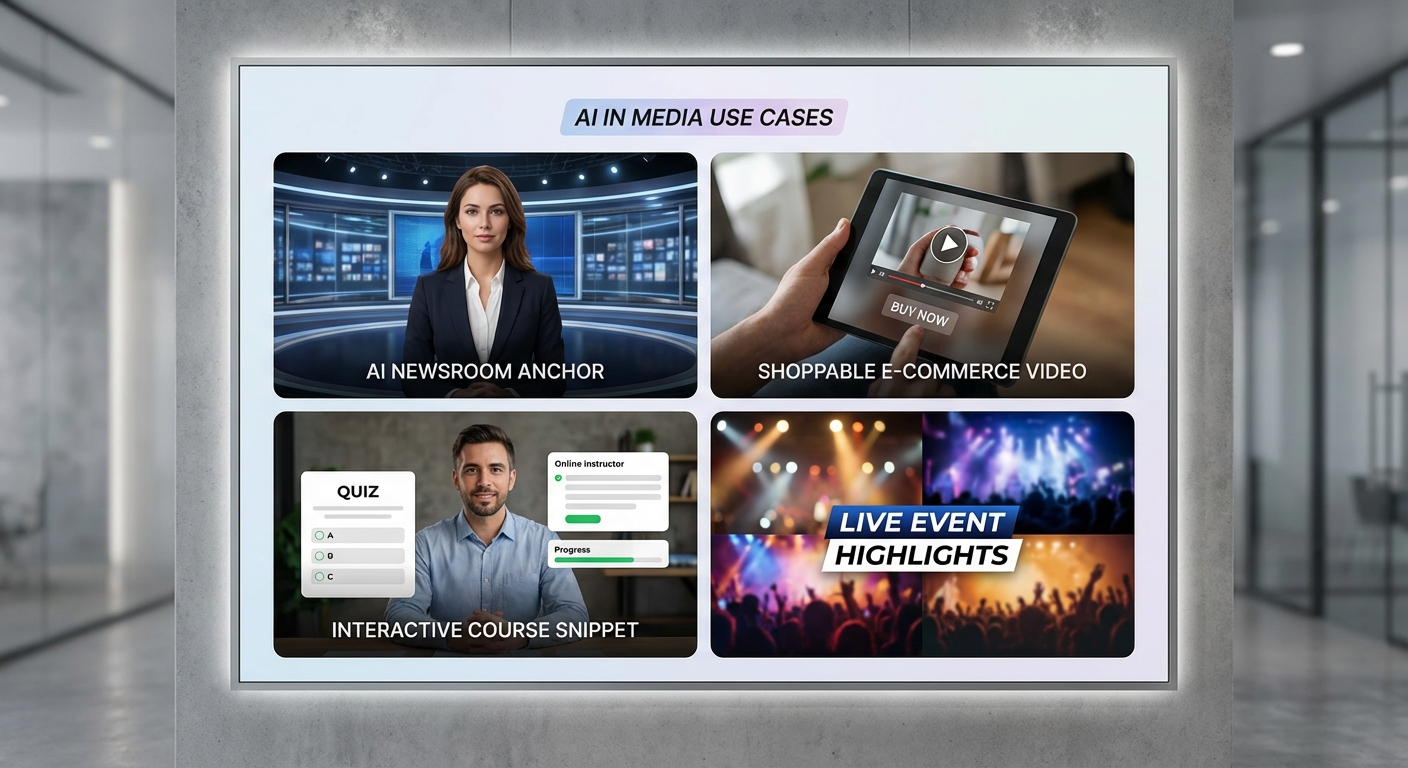

จุดเด่นของ PixVerse คือความสามารถในการนำ AI มาสร้างแอนเคอร์ข่าวเสมือน, วิดีโอเชิงพาณิชย์ที่รองรับการสั่งซื้อแบบทันที (shoppable), และบทเรียนเชิงโต้ตอบสำหรับการศึกษา ตัวอย่างการใช้งานรวมถึงการออกอากาศข่าวด่วนด้วยอวาตาร์ AI ที่อัปเดตข้อมูลเรียลไทม์, การไลฟ์สตรีมขายสินค้าที่ฝังระบบแนะนำและสรุปคุณสมบัติสินค้าอัตโนมัติ และคอร์สออนไลน์ที่ปรับเนื้อหาให้เหมาะกับระดับผู้เรียน ความสามารถเหล่านี้ไม่เพียงลดต้นทุน แต่ยังเปิดโอกาสให้สำนักข่าว, แบรนด์ค้าปลีก และสถาบันการศึกษาขยายการเข้าถึงและปรับขนาดการผลิตเนื้อหาได้ง่ายขึ้นในยุคที่ความต้องการวิดีโอแบบทันทีสูงขึ้น

1. บทนำ — ข่าวการเปิดตัวและความสำคัญ

1. บทนำ — ข่าวการเปิดตัวและความสำคัญ

เมื่อวันที่ 14 มกราคม 2026 บริษัทเทคโนโลยี PixVerse ประกาศเปิดตัวแพลตฟอร์มเครื่องมือวิดีโอที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ในชื่อเดียวกัน โดยนำเสนอฟังก์ชันการสร้างวิดีโอแบบเรียลไทม์ (real-time generative video) ร่วมกับชุดเครื่องมือสำหรับการผลิตเนื้อหาเชิงโต้ตอบและการสตรีมสด เป้าหมายของการเปิดตัวครั้งนี้คือการย่นระยะเวลาและลดต้นทุนการผลิตวิดีโอสำหรับสื่อ มาร์เก็ตติ้ง และครีเอเตอร์ พร้อมทั้งเปิดโอกาสให้การสื่อสารผ่านวิดีโอเป็นไปอย่างทันท่วงทีและปรับแต่งได้ตามบริบทผู้ชม

โดยรวม PixVerse ระบุว่าการเปิดตัวครั้งนี้เป็นจุดเปลี่ยนที่มุ่งหวังจะเปลี่ยนกระบวนการผลิตเนื้อหาแบบเดิมที่มักใช้เวลาหลายวันถึงหลายสัปดาห์ให้กลายเป็นเวิร์กโฟลว์ที่สามารถสร้างและปรับแต่งวิดีโอได้ในเวลาเพียงไม่กี่นาทีถึงชั่วโมง บริษัทชี้ว่าในบางกรณีแพลตฟอร์มสามารถลดเวลาในการผลิตและต้นทุนได้อย่างมีนัยสำคัญ (บริษัทอ้างว่าในกรณีตัวอย่าง การลดเวลาสูงสุดถึงประมาณ 70–80%) ซึ่งจะส่งผลโดยตรงต่อการเพิ่มความคล่องตัวด้านการตลาดและการสื่อสารขององค์กร

ฟีเจอร์หลักที่ PixVerse ประกาศมีข้อเด่นชัดเจนดังนี้

- Real-time generative video — สร้างหรือปรับแต่งคอนเทนต์วิดีโอแบบเรียลไทม์โดยใช้โมเดล generative ที่ตอบสนองต่อคำสั่งหรือข้อมูลอินพุตทันที

- Avatar สร้างจากข้อความ (text-to-avatar) — ผลิตตัวแทนบุคคลหรือโฮสต์ดิจิทัลจากสคริปต์ข้อความ พร้อมเสียงและการเคลื่อนไหวที่ปรับได้

- Overlay แบบ dynamic — ชั้นกราฟิก ข้อความ และข้อมูลเรียลไทม์ที่ปรับเปลี่ยนตามบริบทหรือพฤติกรรมผู้ชม เช่น ราคา สต็อก หรือคอมเมนต์สด

- รองรับการสตรีมสด (low-latency live-stream) — ผสานการสตรีมสดเข้ากับการสร้างคอนเทนต์แบบเรียลไทม์เพื่อการโต้ตอบกับผู้ชมแบบทันที

ในด้านสถานะการเปิดตัว PixVerse เปิดตัวในรูปแบบ public beta พร้อมโปรแกรมเข้าถึงล่วงหน้า (early access) สำหรับลูกค้าองค์กรสื่อ บริษัทอีคอมเมิร์ซ ช่องทีวี และครีเอเตอร์ชั้นนำที่สมัครเข้าร่วมทดสอบโดยตรง ทางบริษัทระบุแผนจะขยายสู่สถานะการให้บริการเชิงพาณิชย์ (general availability) ภายในไตรมาสถัดไปหลังการเก็บฟีดแบ็กจากผู้ใช้งานกลุ่มแรก

คีย์เมสเสจจากผู้บริหารของ PixVerse เน้นย้ำว่าแพลตฟอร์มนี้ถูกออกแบบมาเพื่อลดความซับซ้อนในการผลิตเนื้อหา เพิ่มความเร็วในการตอบแคมเปญ และเปิดทางให้การสื่อสารเชิงวิดีโอกลายเป็นช่องทางหลักของธุรกิจยุคดิจิทัล "เราตั้งใจให้ PixVerse เป็นเครื่องมือที่ช่วยให้องค์กรและครีเอเตอร์ผลิตวิดีโอคุณภาพสูงได้เร็วขึ้น ถูกลง และเข้าถึงผู้ชมได้แบบเรียลไทม์ — เป้าหมายคือการปลดล็อกความคิดสร้างสรรค์โดยไม่ต้องแลกมาด้วยต้นทุนที่สูง" — นาย/นาง [ชื่อผู้บริหาร], CEO ของ PixVerse

2. ฟีเจอร์เด่นและตัวอย่างการใช้งาน (workflow และ demo)

อินเตอร์เฟซ (UI) และภาพรวมระบบ

PixVerse ออกแบบอินเตอร์เฟซให้เน้นความเรียบง่ายและเหมาะกับการใช้งานเชิงธุรกิจ โดยแบ่งเป็นโมดูลหลักที่ชัดเจน ได้แก่ แถบสคริปต์ (Script Editor), ห้องเลือก Avatar, ตัวจัดการ Scene, เครื่องมือ Overlay & Branding และแผงควบคุมการสตรีม/เผยแพร่ (Publish). UI รองรับการลากวาง (drag-and-drop) สำหรับการจัดฉากและชิ้นส่วนกราฟิก ทำให้ผู้ใช้งานสามารถสร้างวิดีโอเรียลไทม์ได้โดยไม่จำเป็นต้องมีทักษะด้านเอฟเฟกต์วิดีโอเชิงลึก

สาธิต workflow แบบ Step-by-step (จากสคริปต์สู่การเผยแพร่)

ต่อไปนี้เป็น workflow แบบเป็นขั้นตอนที่ PixVerse นำเสนอสำหรับการสร้างวิดีโอเรียลไทม์ ตั้งแต่การป้อนเนื้อหาดิบจนถึงการเผยแพร่แบบสดหรือบันทึก:

- 1) เขียนหรืออัปโหลดสคริปต์ (Script) — ผู้ใช้สามารถพิมพ์สคริปต์ในตัวแก้ไขที่รองรับการแบ่งพารากราฟ, การเน้นคำ, และการกำหนดจังหวะย่อหน้า ระบบยังมีเทมเพลตสคริปต์สำเร็จรูปกว่า 50 แบบ สำหรับข่าวด่วน, เสนอขายสินค้า, บทเรียน และพอดแคสต์วิดีโอ

- 2) เลือกและปรับแต่ง Avatar — เลือกจากคลังอวาตาร์ 2D/3D หรืออัปโหลดอวาตาร์บริษัท ปรับลักษณะใบหน้า สีผิว ทรงผม เสื้อผ้า และน้ำเสียงการพูด (TTS voice) เพื่อให้ตรงกับแบรนด์

- 3) สร้าง Scene และจัดวางกล้อง — กำหนดฉากหลัง, วางตำแหน่งกล้องเสมือน, เพิ่มพร็อพ และกำหนดทริกเกอร์โมชัน (เช่น การชูมือ, การกวาดสายตา) แบบเรียลไทม์

- 4) Overlay & Branding — เพิ่มโลโก้, lower-third, เค้าโครงข้อความโปรโมชั่น รวมถึงชั้นข้อมูลแบบไดนามิก (เช่น ผลโหวตหรือสกอร์สด)

- 5) ตรวจสอบ, ตัดต่อแบบเรียลไทม์ และ Publish/Stream — ใช้โหมดพรีวิวแบบเรียลไทม์ ก่อนกดสตรีมสดไปยังแพลตฟอร์มต่าง ๆ หรือบันทึกเป็นไฟล์คุณภาพสูง

ตัวอย่างการเวิร์กโฟลว์สำหรับการผลิตข่าวด่วน: นำเข้าข่าวเป็นสคริปต์ -> ตั้งค่าอวาตาร์ผู้ประกาศ -> เลือกฉากสตูดิโอข่าว -> เพิ่ม lower-third แสดงหัวข้อข่าวและเวลา -> สตรีมสดไปยัง YouTube และ Facebook พร้อมแคปชั่นอัตโนมัติ

ฟีเจอร์ปรับแต่ง (Avatar customization, Branding overlay, Auto-caption, Multi-language)

PixVerse เน้นความยืดหยุ่นในการปรับแต่งเพื่อรองรับความต้องการเชิงธุรกิจ ดังนี้:

- Avatar Customization — ปรับแต่งรายละเอียดเชิงสุนทรียะ (appearance), อนิเมชันใบหน้า (facial blendshapes), และโมชันของร่างกาย ผู้ใช้สามารถอัปโหลดชุดคอร์ปอเรตเพื่อให้ Avatar สวมใส่เครื่องแบบขององค์กรได้

- Branding Overlay — เลเยอร์สำหรับโลโก้, สีแบรนด์, ฟอนต์ และ lower-thirds ที่ซิงค์กับข้อมูลแบบเรียลไทม์ (เช่น ราคาหุ้นหรือคะแนนโหวต) รองรับการบันทึกเป็นธีมแบรนด์เพื่อใช้งานครั้งต่อไป

- Auto-caption & Subtitle — ระบบสร้างคำบรรยายอัตโนมัติแบบเรียลไทม์พร้อมตัวเลือกแก้ไขข้อความก่อนเผยแพร่ รองรับทั้งการฝังซับไตเติลในวิดีโอและการดาวน์โหลดไฟล์ SRT

- Multi-language & TTS — แปลงสคริปต์เป็นหลายภาษาโดยอัตโนมัติ รองรับมากกว่า 30 ภาษา พร้อมเสียง TTS คุณภาพสูงที่สามารถปรับน้ำเสียงและอารมณ์ได้

ความสามารถเหล่านี้ช่วยให้ทีมสื่อสารสามารถรักษามาตรฐานแบรนด์ได้อย่างสม่ำเสมอ ขณะที่ลดเวลาในการผลิต ตัวอย่างจากลูกค้าภาคสื่อบางแห่งระบุว่าเวลาในการเตรียมวิดีโอสำหรับเผยแพร่ลดลงสูงสุดถึง 70% เมื่อเทียบกับกระบวนการผลิตแบบเดิม

การสตรีมสดไปยังแพลตฟอร์มต่าง ๆ และตัวอย่างเดโม (use-cases)

PixVerse รองรับการสตรีมแบบ Multi-destination — ส่งสัญญาณพร้อมกันไปยังแพลตฟอร์มยอดนิยม เช่น YouTube, Facebook Live, Twitch, LinkedIn Live และ RTMP endpoint อื่น ๆ ผู้ใช้สามารถตั้งค่า bitrate, resolution และแชนเนลเสียงแยกต่างหากได้ในหน้าคอนฟิกการสตรีม

ตัวอย่าง use-case จากเดโมแพลตฟอร์ม:

- ข่าวด่วน (Breaking News) — ทีมบรรณาธิการป้อนสคริปต์สั้น ๆ เลือกเทมเพลตสตูดิโอข่าว, เปิดฟีเจอร์ auto-caption และสตรีมสดพร้อม lower-third แสดงแหล่งข่าว เหมาะกับการรายงานเหตุการณ์แบบเรียลไทม์

- โฆษณาสด (Live Ad) — แคมเปญโปรโมชั่นแบบเวลาจำกัด ใช้ Avatar พูดนำเสนอข้อเสนอ พร้อมกราฟิกโปรโมชั่นชนิดไดนามิกที่อัปเดตอินเวนทอรีแบบเรียลไทม์

- คอร์สออนไลน์แบบ Interactive — ผู้สอนใช้ Avatar เป็นตัวกลางในการนำเสนอ หัวข้อสามารถเปลี่ยนได้ตามผลโหวตของผู้ชม ระบบรองรับการฝังแบบทดสอบสั้นและแสดงคะแนนแบบเรียลไทม์

ตัวอย่างสคริปต์เทมเพลตที่ PixVerse เตรียมไว้ (ย่อ):

- Template: ข่าวด่วน — "สวัสดีครับ/ค่ะ ผม/ดิฉันคือ [ชื่อผู้ประกาศ] มีรายงานด่วนเกี่ยวกับ [หัวข้อ] ณ เวลา [เวลา] รายละเอียดพบว่า..."

- Template: โฆษณาสั้น 30 วินาที — "วันนี้เท่านั้น! รับส่วนลด X% เมื่อซื้อ [สินค้า] ใช้โค้ด [CODE] ทางออนไลน์เท่านั้น คลิกเลย!"

- Template: คอร์สสั้น 5 นาที — "ยินดีต้อนรับสู่บทเรียนเรื่อง [หัวข้อ] วันนี้เราจะเรียนรู้ 3 ข้อสำคัญ: 1) ... 2) ... 3) ..."

ฟีเจอร์ตัวอย่างและเทมเพลตเหล่านี้ช่วยให้ทีมสื่อและการตลาดสามารถเริ่มผลิตคอนเทนต์แบบเรียลไทม์ได้ทันที โดยลดความซับซ้อนของขั้นตอนการจัดเตรียมและการเผยแพร่

3. สถาปัตยกรรมเทคโนโลยีและประสิทธิภาพ

3. สถาปัตยกรรมเทคโนโลยีและประสิทธิภาพ

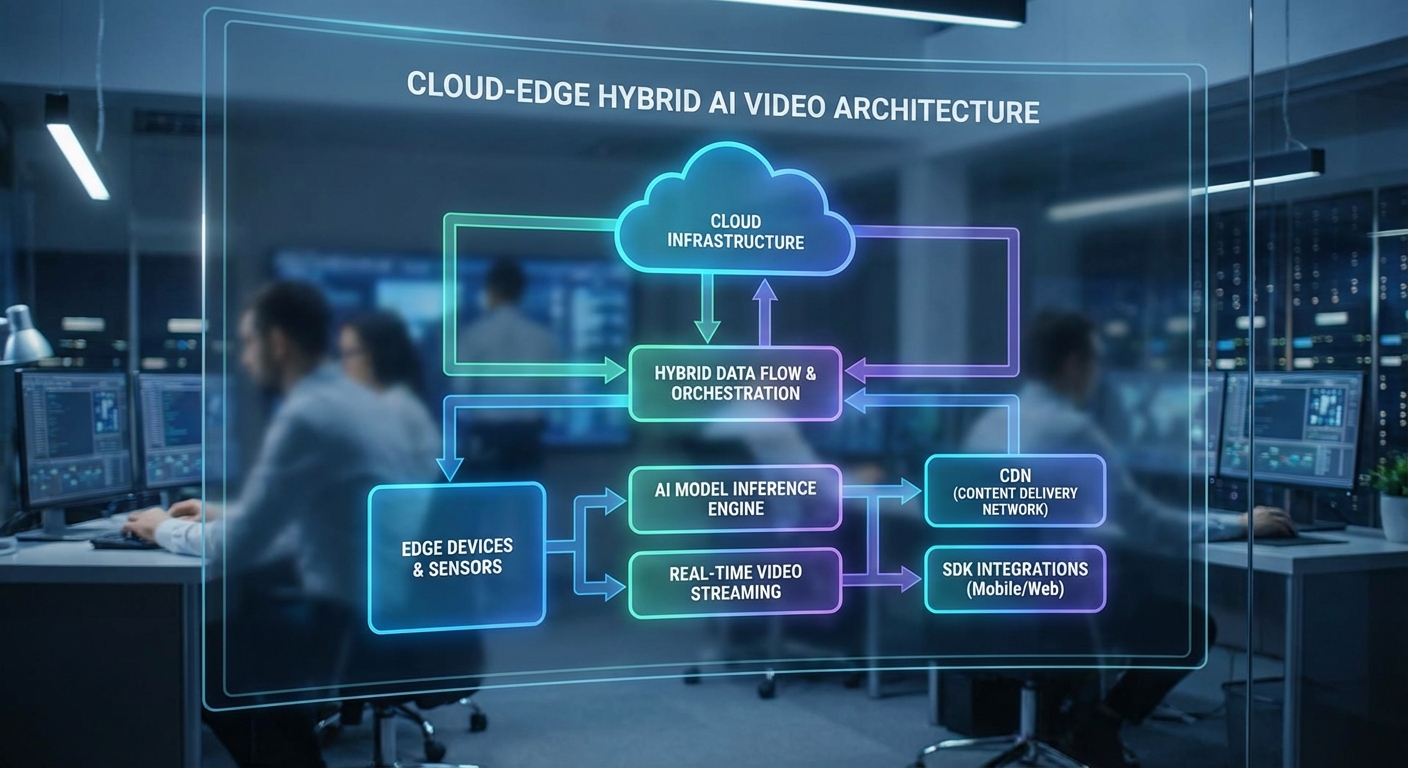

PixVerse วางสถาปัตยกรรมในรูปแบบโมดูลาร์ (modular pipeline) เพื่อรองรับการสร้างวิดีโอเชิงสร้างสรรค์แบบเรียลไทม์ โดยแยกฟังก์ชันหลักออกเป็นโมดูลย่อย เช่น scene/layout planner, motion & pose controller, frame renderer และ audio synthesis ที่ทำงานร่วมกับโมเดลตระกูลต่าง ๆ (vision, audio, control nets) อย่างชัดเจน โมเดล generative ที่คาดว่า PixVerse ใช้เป็นหลัก ได้แก่ latent diffusion models ที่ขยายการทำงานไปยังลำดับเฟรม (video diffusion), และ transformer-based video models (เช่น ViViT แนวทาง temporal-attention หรือ recurrent latent transformer สำหรับความต่อเนื่องของเคลื่อนไหว) ในส่วนของเสียงจะมีการใช้งานโมเดล TTS/voice-cloning (ตัวอย่างเช่น FastSpeech2/VITS สำหรับสังเคราะห์สเปกตรัม และ HiFi-GAN สำหรับโค้ดดิ้งเสียง) เพื่อให้ได้คุณภาพและการซิงค์กับภาพที่แม่นยำ

โครงสร้างแบบผสมผสาน (hybrid) ของ PixVerse มักประกอบด้วยชั้นต่อไปนี้:

- Perception & Conditioning: โมดูลตรวจจับคีย์พอยต์ (keypoint), segmentation, depth/normal estimation และ optical-flow ที่รันได้ทั้งบน edge และ cloud เพื่อเตรียมข้อมูล conditioning ให้ control nets

- Control Nets & Planner: รับอินพุตเชิงโครงสร้าง เช่น pose, semantic mask, motion guides เพื่อควบคุม diffusion/transformer generator ให้เกิดความสอดคล้องเชิงพื้นที่และเวลา

- Generative Renderer: Latent diffusion / video-transformer ทำหน้าที่ขยายเป็นเฟรมภาพจริง โดยใช้เทคนิค temporal consistency (temporal attention, flow-guided warping) เพื่อหลีกเลี่ยงการกระพริบและ artifact

- Audio Stack: TTS + neural vocoder พร้อมโมดูล voice-cloning/voice conversion และ time-alignment (phoneme-level alignment) เพื่อซิงค์เสียงกับเฟรม

เพื่อให้ตอบสนองแบบเรียลไทม์ PixVerse นำกลยุทธ์หลายด้านมารวมกันเพื่อลด latency และเพิ่ม throughput:

- Edge vs Cloud Partitioning: งานที่ต้องการความหน่วงต่ำ เช่น keypoint detection, low-resolution preview rendering, หรือ audio pre-processing ถูกย้ายไปทำบน edge devices (mobile NPU / Apple Neural Engine / on-prem GPU) ขณะที่การเรนเดอร์ความละเอียดสูงและโมเดล generative ขนาดใหญ่จะรันบน cloud GPU/TPU ที่มี tensor cores

- Model Optimization: Quantization (INT8/FP16), pruning, knowledge distillation, และการแปลงเป็น ONNX/TFLite สำหรับ inference บนอุปกรณ์ เพื่อให้โมเดลขนาดหลายร้อยล้านถึงไม่กี่พันล้านพารามิเตอร์ใช้งานจริงได้

- Progressive Rendering & Multi-Stage Refinement: ระบบให้ preview แบบ progressive — เริ่มด้วย low-res/low-fidelity ที่มี latency ต่ำ (ตัวอย่างเป้าหมาย interactive response < 150–250 ms) แล้วค่อย refine เป็นภาพความละเอียดสูงใน background

- Batching และ Micro-batching: บนคลาวด์ใช้ dynamic batching และ micro-batching เพื่อเพิ่ม throughput ของ GPU โดยคงเวลาตอบกลับเฉลี่ย (p99) ภายในค่าที่ตั้งเป้าไว้

- Chunked Temporal Generation: แทนการสร้างวิดีโอทั้งรายการในครั้งเดียว ระบบแบ่งเป็นชิ้นเวลา (chunks) เช่น 0.5–2 วินาทีต่อชุด เพื่อให้สามารถสตรีมและแก้ไขแบบ incremental ได้

ตัวเลขเป้าหมายด้านประสิทธิภาพที่ PixVerse ระบุหรือคาดการณ์ได้แก่:

- Latency เป้าหมาย: interactive control response < 200 ms (edge preview), full-frame generation สำหรับ 720p อยู่ที่ประมาณ 250–500 ms ต่อเฟรมในโหมด low-latency บนคลัสเตอร์ GPU ขณะที่ 1080p อาจอยู่ในช่วง 500 ms–2 s ต่อเฟรม ขึ้นกับระดับการ refine และ 4K อาจต้องการหลายวินาทีถึงสิบวินาทีต่อ keyframe หากต้องการคุณภาพสูง

- Frame-rate & ความต่อเนื่อง: รองรับการสตรีมที่ 15–30 fps สำหรับงานออนไลน์แบบ near-real-time และสามารถเรนเดอร์เอาต์พุตสุดท้ายที่ 24/30 fps สำหรับงานส่งมอบเชิงคุณภาพสูง โดยมีเป้าหมายรองรับ 60 fps สำหรับ use-case เฉพาะเมื่อใช้ pipeline optimized

- ความละเอียดที่รองรับ: แบบเรียลไทม์มักเน้น 720p–1080p เป็นหลัก แต่ระบบออกแบบให้สามารถขยายสู่ 2K/4K ด้วยการใช้ progressive upscaling (super-resolution) และ cloud render

- ขนาดโมเดล: โมเดล diffusion/transformer ในสแต็กอาจมีช่วง 500M–10B พารามิเตอร์ ขึ้นกับความต้องการคุณภาพและ latency — โดยใช้ distillation/quantization เพื่อลดค่า latency บนอุปกรณ์

ด้านการผสานระบบและมาตรฐานการเชื่อมต่อ PixVerse มี API/SDK ที่ออกแบบมาเพื่อการผนวกรวมแบบ enterprise:

- API Types: REST/JSON สำหรับงาน asynchronous, gRPC สำหรับ throughput สูง, และ WebSocket/WebRTC สำหรับสตรีมมิงแบบเรียลไทม์

- SDKs: ไคลเอนต์แบบ ready-made ใน JavaScript (browser + Node), Python (data-science & backend), C++/Swift/Kotlin (สำหรับ mobile & native) พร้อมตัวอย่างแสดงการใช้ WebRTC สำหรับ low-latency preview และการเรียก generator แบบ chunked

- Authentication & Security: OAuth2/JWT, per-request signatures, rate limiting และการจัดการคีย์ (key rotation) เพื่อรองรับการใช้งานในระดับองค์กร

ความปลอดภัยและความน่าเชื่อถือของคอนเทนต์เป็นหัวใจสำคัญของสถาปัตยกรรม PixVerse โดยมีมาตรการต่อไปนี้:

- Watermarking & Content Provenance: ฝัง watermark แบบมองไม่เห็น (robust invisible watermark) ทั้งในโดเมนภาพและเสียง พร้อม metadata เชื่อมโยงตามมาตรฐาน C2PA (Coalition for Content Provenance and Authenticity) เพื่อบันทึก chain-of-creation และยืนยันแหล่งที่มา

- Forensics & Tamper-Resistance: ใช้วิธีฝังลายนิ้วมือเชิงสถิติ (perceptual hashes), signature metadata และการลงทะเบียน hash บน ledger/anchor เพื่อสนับสนุนการตรวจสอบย้อนหลังและการพิสูจน์ความถูกต้อง

- Safety Filters: แนบโมดูลตรวจสอบเนื้อหา (safety classifiers) ทั้งภาพและเสียงก่อนอนุญาตการเรนเดอร์เต็มรูปแบบ เพื่อป้องกันการสร้างเนื้อหาที่ผิดกฎหมายหรือเป็นอันตราย

- Compliance & Privacy: การเข้ารหัส TLS1.3 end-to-end, การควบคุมสิทธิ์การเข้าถึงข้อมูล และตัวเลือกการประมวลผลในโซน (region-specific processing) สำหรับลูกค้าที่ต้องการความเป็นส่วนตัวหรือข้อกำหนดด้านข้อมูล

โดยสรุป สถาปัตยกรรมของ PixVerse ผสานโมเดล generative ชั้นนำเข้ากับแนวทาง engineering ชั้นสูง (edge-cloud hybrid, model optimization, progressive rendering) และมาตรการด้านความปลอดภัยเชิงรุก เพื่อให้บรรลุเป้าหมายด้าน latency, frame-rate และความคงเส้นคงวาของคอนเทนต์ ทำให้บริการสามารถรองรับทั้ง use-case แบบ interactive บนอุปกรณ์ปลายทางและการเรนเดอร์คุณภาพสูงบนคลาวด์สำหรับการส่งมอบเชิงพาณิชย์

4. กรณีใช้งานจริงและผลลัพธ์เชิงธุรกิจ

4. กรณีใช้งานจริงและผลลัพธ์เชิงธุรกิจ

PixVerse วางตำแหน่งตัวเองเป็นเครื่องมือวิดีโอ AI แบบเรียลไทม์ที่ตอบโจทย์หลายกลุ่มอุตสาหกรรม โดยมุ่งเน้นการลดเวลาการผลิต เพิ่มความถี่ของการเผยแพร่ และยกระดับตัวชี้วัดเชิงธุรกิจสำคัญ เช่น การมีส่วนร่วม (engagement), อัตราการแปลง (conversion) และการรักษาผู้ชม (retention) ด้านล่างเป็นสี่กรณีใช้งานหลักที่ PixVerse มุ่งเป้า พร้อมตัวอย่างการประยุกต์และตัวเลขผลลัพธ์ที่คาดว่าองค์กรจะได้รับเมื่อนำไปใช้งานจริง

- Newsrooms (สำนักข่าว) — PixVerse ช่วยให้สำนักข่าวผลิตคลิปสรุปเหตุการณ์แบบเรียลไทม์จากฟีดข่าวและทรานสคริปต์อัตโนมัติ โดยลูกค้าเชิงตัวอย่างสามารถเพิ่มปริมาณคอนเทนต์วิดีโอได้มากกว่า 3–5 เท่า ในขณะที่ลดเวลาเฉลี่ยต่อคลิปจาก 60–120 นาที เหลือเพียง 10–20 นาที (ลดเวลา 70–85%) ผลลัพธ์เชิง engagement คาดว่าจะเห็นการเพิ่มขึ้นของวิวและการแชร์ประมาณ 30–80% เมื่อเปรียบเทียบกับวิดีโอที่ผลิตด้วยกระบวนการแบบดั้งเดิม

- E‑commerce brands (แบรนด์อีคอมเมิร์ซ) — ด้วยความสามารถสร้างวิดีโอสาธิตสินค้าและรีวิวแบบไดนามิกที่ปรับตามข้อมูลสินค้าจริง PixVerse ลดต้นทุนการผลิตคอนเทนต์ต่อสินค้าได้ประมาณ 40–60% และลดเวลาการออกวิดีโอให้พร้อมใช้งานจากสัปดาห์เหลือเป็นวัน ผลกระทบทางธุรกิจที่คาดหวังคืออัตราการแปลง (conversion rate) เพิ่มขึ้น 15–35% และอัตราการคลิกผ่าน (CTR) เพิ่มขึ้น 20–50% จากการใช้วิดีโอที่ปรับแต่งตามกลุ่มเป้าหมาย

- Education platforms (แพลตฟอร์มการศึกษา) — ในระบบการเรียนออนไลน์ PixVerse สามารถสร้างบทเรียนวิดีโอสั้นแบบโต้ตอบหรือสรุปเนื้อหาแบบสั้น (microlearning) ที่ปรับตามความก้าวหน้าของผู้เรียน ผลลัพธ์เบื้องต้นคาดว่าจะช่วยเพิ่มอัตราการจบคอร์ส (completion rate) ประมาณ 10–25% และลดเวลาในการผลิตคอนเทนต์การสอนแบบวิดีโอ 50–75% นอกจากนี้ยังช่วยลดค่าใช้จ่ายการจ้างสตูดิโอและครูพิเศษสำหรับการอัดวิดีโอซ้ำซ้อน

- Live event producers (ผู้ผลิตงานอีเวนต์สด) — PixVerse สนับสนุนการสร้างไฮไลต์แบบเรียลไทม์ การแทรกกราฟิกอัตโนมัติ และการสรุปวิดีโอทันทีหลังจบงาน ทำให้ทีมงานผลิตคอนเทนต์หลังงานได้เร็วขึ้นมาก จากเดิมต้องใช้หลายชั่วโมงถึงวัน เหลือเพียงไม่กี่นาทีถึงชั่วโมง ผลเชิงธุรกิจรวมถึงการยืดอายุคอนเทนต์ (evergreen) เพิ่มยอดชมซ้ำ และเพิ่มรายได้จากโฆษณา/สปอนเซอร์ได้ประมาณ 25–60% ขึ้นอยู่กับรูปแบบงาน

ผลลัพธ์จากลูกค้ารายแรกในช่วงเบต้า (กลุ่มตัวอย่างหลายราย) แสดงให้เห็นภาพรวมที่สอดคล้องกับตัวเลขข้างต้น ตัวอย่างเช่น สำนักข่าวดิจิทัลรายหนึ่งรายงานว่า สามารถเพิ่มความถี่การปล่อยวิดีโอรายวันจาก 4 คลิปเป็น 18 คลิปภายในสัปดาห์เดียว และลดต้นทุนต่อคลิปลงประมาณ 65% ขณะที่อัตราการมีส่วนร่วม (average watch time) เพิ่มขึ้นราว 45% แบรนด์อีคอมเมิร์ซรายหนึ่งระบุว่า วิดีโอที่สร้างโดย PixVerse ช่วยให้ conversion เพิ่มขึ้นจาก 2.8% เป็น 3.9% ในแคมเปญทดสอบ (เพิ่มขึ้นประมาณ 39%)

มุมมองเชิงอุตสาหกรรมสนับสนุนความต้องการเทคโนโลยีนี้: รายงานหลายสำนักระบุว่า วิดีโอคิดเป็นกว่า 80% ของทราฟฟิกออนไลน์ และผู้บริโภคให้ความสำคัญกับวิดีโอเป็นรูปแบบเนื้อหาหลัก ทั้งนี้ตลาดวิดีโอที่ใช้ปัญญาประดิษฐ์ (AI video) ถูกประเมินว่ามีการเติบโตอย่างรวดเร็ว โดยหลายรายงานคาดการณ์อัตราการเติบโตเฉลี่ยต่อปี (CAGR) อยู่ในช่วงประมาณ 30–40% ในช่วงหลายปีข้างหน้า ซึ่งหมายความว่าการลงทุนในแพลตฟอร์มที่สามารถสเกลการผลิตวิดีโอได้อัตโนมัติจะให้ผลตอบแทนทางธุรกิจที่ชัดเจนทั้งในเชิงค่าใช้จ่ายและโอกาสการสร้างรายได้ใหม่

สรุปคือ PixVerse มอบผลลัพธ์เชิงธุรกิจที่จับต้องได้สำหรับองค์กรที่ต้องการสเกลการผลิตวิดีโอ: ลดเวลาและต้นทุนการผลิตอย่างมีนัยสำคัญ เพิ่มปริมาณคอนเทนต์และความถี่ในการสื่อสาร ไปพร้อมกับการยกระดับตัวชี้วัด engagement และ conversion ซึ่งช่วยให้ ROI ในโครงการคอนเทนต์ดิจิทัลเร่งตัวขึ้นภายในไตรมาสแรกของการใช้งานจริง

5. โมเดลธุรกิจ พันธมิตร และการแข่งขันในตลาด

5. โมเดลธุรกิจ พันธมิตร และการแข่งขันในตลาด

PixVerse สามารถสร้างโครงสร้างรายได้ที่หลากหลายและยืดหยุ่นเพื่อตอบโจทย์ลูกค้าหลายกลุ่ม ตั้งแต่ผู้ผลิตคอนเทนต์ขนาดเล็ก ไปจนถึงองค์กรสื่อขนาดใหญ่ โมเดลหลักที่เป็นไปได้ประกอบด้วย Subscription (รายเดือน/รายปี), Pay‑per‑use (คิดตามการใช้งานจริง เช่น นาทีการเรนเดอร์หรือจำนวนวิดีโอ), Enterprise licensing (สัญญาองค์กรแบบเหมาจ่ายพร้อม SLA) และ Revenue‑share กับ publishers (แบ่งรายได้จากโฆษณาหรือการสมัครสมาชิกที่ใช้เครื่องมือของ PixVerse) ทั้งนี้การผสมผสานโมเดลเหล่านี้ช่วยให้บริษัทสามารถสร้างรายได้ประจำ (recurring revenue) พร้อมกับโอกาสสร้างรายได้ผันแปรเมื่อบริการมีการใช้งานสูง

ภาพรวมราคาต้นแบบที่เป็นไปได้อาจแบ่งเป็นแพ็กเกจตัวอย่างดังนี้:

- Starter — เหมาะสำหรับครีเอเตอร์รายย่อย: ฟรี/ชำระเล็กน้อย (เช่น $0–$15/เดือน หรือ 0–500 บาท) พร้อมการใช้งานจำกัดและลายน้ำ

- Pro — สำหรับผู้สร้างคอนเทนต์มืออาชีพ: $29–$199/เดือน (~1,000–7,000 บาท) ขึ้นกับคุณภาพวิดีโอ ฟีเจอร์ AI แบบเรียลไทม์ และความจุการเรนเดอร์

- Pay‑per‑use — คิดตามนาทีการประมวลผล/ความละเอียด: ประมาณ $0.05–$2.00 ต่อวิดีโอต่อนาที ขึ้นกับความซับซ้อน (SD → HD → 4K, real‑time vs batch)

- Enterprise — สัญญาแบบเหมาจ่ายพร้อม SLA, การรวมระบบ (SSO, DRM, SSAI) และการสนับสนุนระดับสูง: ราคาแบบเจรจาตามขอบเขตโครงการ (มักเริ่มที่หลักหมื่นดอลลาร์ต่อปี)

- Revenue share — ข้อเสนอสำหรับพาร์ทเนอร์สื่อ: ตัวอย่างการแบ่งรายได้ 70/30 หรือ 60/40 (ผู้ผลิต/แพลตฟอร์ม) ขึ้นกับการลงทุนด้านการตลาดและการจัดสรรโฆษณา

พันธมิตรเชิงเทคนิคและเชิงธุรกิจจะเป็นกุญแจสำคัญสำหรับ PixVerse ในการลดต้นทุนและขยายตลาดได้รวดเร็ว โดยพาร์ทเนอร์ที่สำคัญได้แก่:

- Cloud providers และ GPU providers — เช่น AWS, Google Cloud, Microsoft Azure และผู้ให้บริการ GPU เฉพาะทางอย่าง NVIDIA / Lambda เพื่อรองรับการเรนเดอร์เรียลไทม์และการสเกลทราฟฟิก

- CDN และ Streaming Infrastructure — Akamai, Cloudflare, Fastly, Mux หรือ AWS IVS เพื่อให้การส่งมอบวิดีโอมี latency ต่ำและคุณภาพสม่ำเสมอทั่วโลก

- Media houses และ publishers — สำนักข่าว ช่องทีวี และผู้ผลิตคอนเทนต์ดิจิทัลที่ต้องการ personalization/real‑time highlights เพื่อนำเทคโนโลยีไปใช้จริงและแบ่งปันรายได้

- Adtech และ Analytics partners — SSP/DSP และผู้ให้บริการวัดผล (เช่น Nielsen‑type analytics) สำหรับการติดตามประสิทธิภาพโฆษณาและระบบแบ่งรายได้

- ระบบรักษาความปลอดภัยและสิทธิ์เนื้อหา — ผู้ให้บริการ DRM, watermarking และโซลูชันตรวจสอบสิทธิ์เนื้อหาเพื่อรับประกันความปลอดภัยและการปฏิบัติตามกฎหมายลิขสิทธิ์

ในการเปรียบเทียบเชิงการแข่งขัน PixVerse จะเผชิญกับทั้งสตาร์ทอัพ AI‑video ที่เชี่ยวชาญด้านการสร้างวิดีโอ (เช่น Synthesia, Runway, Pictory) และผู้ให้บริการโครงสร้างพื้นฐานสตรีมมิง/วิดีโอที่เริ่มเพิ่มฟีเจอร์ AI (เช่น Mux, AWS IVS, Vimeo Enterprise) จุดเด่นและข้อจำกัดเมื่อเทียบกับคู่แข่ง ได้แก่:

- จุดแข็งของ PixVerse

- ความสามารถแบบเรียลไทม์ (low‑latency personalization) ที่สามารถสตรีมคอนเทนต์ส่วนบุคคลได้ทันทีซึ่งเป็นข้อได้เปรียบเชิงธุรกิจสำหรับกีฬา ข่าว และโฆษณา

- โมเดลรายได้ยืดหยุ่น ที่ผสาน Subscription, pay‑per‑use และ revenue‑share ทำให้เข้าถึงลูกค้าหลากหลายกลุ่ม

- โอกาสเป็นพันธมิตรเชิงลึก กับสำนักข่าวและแพลตฟอร์มสื่อเพื่อขยายการใช้งานจริงและแชร์รายได้

- ข้อจำกัดของ PixVerse

- ต้นทุนโครงสร้างพื้นฐานสูง โดยเฉพาะ GPU สำหรับการเรนเดอร์เรียลไทม์และ CDN สำหรับการส่งมอบวิดีโอคุณภาพสูง

- การแข่งขันจากผู้เล่นที่มีฐานลูกค้าและผลิตภัณฑ์ประจำตัวแล้ว เช่น Synthesia ที่มี focus บน avatar-based content หรือ Runway ที่เด่นด้าน editing workflows

- ความเสี่ยงด้านสิทธิ์ข้อมูลและความปลอดภัย ซึ่งองค์กรขนาดใหญ่ให้ความสำคัญและอาจต้องการการรับรอง/มาตรฐานเพิ่มเติมก่อนตกลงสัญญา

กลยุทธ์ที่แนะนำคือการเริ่มจากตลาดเชิงแนวดิ่ง (verticals) ที่ต้องการ real‑time personalization มาก เช่น กีฬา การแข่งรถ ข่าวสด และโฆษณา programmatic โดยใช้พันธมิตรสื่อเป็นกลไกนำร่อง พร้อมกับเสนอแพ็กเกจ enterprise ที่รวม SLA, การดูแลเชิงเทคนิค และข้อตกลง revenue‑share เพื่อสร้างรายได้ระยะยาว ในขณะเดียวกัน PixVerse ควรลงทุนในการเพิ่มประสิทธิภาพต้นทุน (เช่น spot GPU, edge rendering กับ CDN) และสร้างความน่าเชื่อถือด้านความปลอดภัย/การปฏิบัติตามกฎระเบียบ เพื่อแข่งขันกับผู้ให้บริการรายใหญ่ได้อย่างยั่งยืน

6. ประเด็นจริยธรรม ความเป็นส่วนตัว และโรดแมปในอนาคต

6. ประเด็นจริยธรรม ความเป็นส่วนตัว และโรดแมปในอนาคต

การเปิดตัวเครื่องมือวิดีโอ AI ของ PixVerse นำมาซึ่งศักยภาพในการสร้างเนื้อหาแบบเรียลไทม์ที่สูงขึ้นอย่างมาก แต่ในเวลาเดียวกันก็ยกระดับความเสี่ยงเชิงจริยธรรม และประเด็นด้านความเป็นส่วนตัวที่องค์กรต้องพิจารณาอย่างรอบคอบ โดยเฉพาะเมื่อเทคโนโลยีนี้สามารถผลิตภาพและเสียงที่มีความสมจริงจนแยกความแตกต่างจากของจริงได้ยาก ตัวอย่างความเสี่ยงที่ชัดเจนรวมถึงการสร้าง deepfake เพื่อนำไปใช้หลอกลวง ทำลายชื่อเสียง หรือขัดขวางกระบวนการทางประชาธิปไตย ซึ่งงานวิเคราะห์อุตสาหกรรมชี้ให้เห็นว่าเนื้อหา deepfake เติบโตอย่างรวดเร็วในช่วงไม่กี่ปีที่ผ่านมา ทำให้การวางมาตรการป้องกันเป็นเรื่องจำเป็น

แนวทางการบรรเทาความเสี่ยงเชิงจริยธรรม ที่ PixVerse และองค์กรควรนำมาใช้ร่วมกัน ได้แก่

- Digital watermarking และ provenance: ใส่ watermark ทางดิจิทัลแบบทนทาน (robust, imperceptible) และใช้มาตรฐาน provenance เช่น C2PA / Content Credentials เพื่อยืนยันแหล่งที่มาและประวัติการแก้ไขของไฟล์วิดีโอ ตั้งแต่จุดสร้างจนถึงการเผยแพร่

- Consent flows ที่โปร่งใสสำหรับ talent และผู้ให้เสียง: บังคับให้มีการเก็บความยินยอม (explicit opt-in) พร้อมบันทึกเวลาที่ยินยอม ขอบเขตการใช้งาน และการจำกัดระยะเวลา รวมถึงสัญญาทางกฎหมายที่ชัดเจนสำหรับการใช้ likeness, voice clones หรือการสังเคราะห์ใบหน้า

- Audit trails และ logging: เก็บบันทึกการสร้าง/แก้ไขวิดีโออย่างละเอียด (who, when, what parameters/models used) เพื่อให้สามารถตรวจสอบย้อนกลับและตอบคำถามด้านความรับผิดชอบได้

- ระบบตรวจจับ deepfake และ human-in-the-loop: ผสานเครื่องมือตรวจจับอัตโนมัติพร้อมการตรวจสอบของมนุษย์สำหรับคอนเทนต์ที่มีความเสี่ยงสูง โดยจัดลำดับความสำคัญให้เนื้อหาทางการเมือง การเงิน หรือที่เกี่ยวข้องกับบุคคลสาธารณะ

ประเด็นความเป็นส่วนตัวและการปฏิบัติตามกฎระเบียบ เป็นอีกมิติที่องค์กรต้องปรับกระบวนการให้สอดคล้อง กรอบกฎหมายสำคัญที่ต้องพิจารณารวมถึง GDPR (สหภาพยุโรป) และ PDPA (ประเทศไทย) ซึ่งมีข้อกำหนดเกี่ยวกับการประมวลผลข้อมูลชีวภาพ ข้อมูลภาพ/เสียง และสิทธิของเจ้าของข้อมูล เช่น สิทธิขอเข้าถึง แก้ไข หรือขอลบข้อมูล (right to erasure) คำแนะนำปฏิบัติได้แก่:

- ดำเนินการ Data Protection Impact Assessment (DPIA): ก่อนเปิดใช้งานระบบที่ใช้การสังเคราะห์เสียงหรือใบหน้า เพื่อประเมินความเสี่ยงต่อสิทธิพื้นฐานของบุคคลและออกมาตรการควบคุม

- หลักการ data minimization และ retention policy: เก็บเฉพาะข้อมูลที่จำเป็น ตั้งค่าระยะเวลาเก็บข้อมูลชัดเจน และทำลายข้อมูลต้นทางเมื่อครบกำหนดหรือเมื่อเจ้าของข้อมูลร้องขอ

- การปกป้องข้อมูลชีวภาพ: ปรับใช้เทคนิคการปกป้อง เช่น การทำ pseudonymization/encryption ของไฟล์เสียงและภาพ และการควบคุมการเข้าถึงแบบ role-based access control (RBAC)

- การแจ้งเตือนและการรายงานเหตุละเมิด: มีแผนการแจ้งผู้มีส่วนได้เสียและหน่วยงานกำกับเมื่อเกิดเหตุละเมิดตามข้อกำหนดของกฎหมายท้องถิ่น (เช่น ภายใน 72 ชั่วโมงสำหรับ GDPR เมื่อมีเหตุละเมิดข้อมูลส่วนบุคคล)

โรดแมปฟีเจอร์อนาคตของ PixVerse (แนวทางเชิงเทคนิคและการจัดการ):

- ระยะสั้น (3–6 เดือน): เปิดตัวระบบ moderation อัตโนมัติพื้นฐานพร้อม human review, ฟีเจอร์ consent capture ที่บันทึกเมตาดาต้า, การใส่ watermark แบบพื้นฐาน และ dashboard สำหรับ audit logs

- ระยะกลาง (6–18 เดือน): ปรับปรุงระบบตรวจจับ deepfake ด้วยโมเดลเฉพาะทาง, เปิดตัว compliance toolkit ที่รองรับ C2PA/Content Credentials, เพิ่มการรองรับหลายภาษาและรูปแบบภูมิภาค (locale-specific consent workflows), และฟีเจอร์ role-based governance สำหรับองค์กร

- ระยะยาว (18–36 เดือน): พัฒนาโมเดลที่มีความยั่งยืนด้านความเป็นธรรม (bias mitigation), เวอร์ชัน low-latency สำหรับการสตรีมแบบเรียลไทม์, การรวมเทคโนโลยี cryptographic attestation สำหรับ provenance, และการรับรองตามมาตรฐานอุตสาหกรรมที่เกี่ยวข้อง

คำแนะนำสำหรับองค์กรที่พิจารณานำ PixVerse ไปใช้งานจริง:

- เริ่มด้วยโปรแกรมนำร่อง (pilot): ทดสอบในสเกลเล็กกับกรณีการใช้งานที่มีความเสี่ยงต่ำก่อนขยายสู่การใช้งานจริง เพื่อประเมินผลกระทบเชิงเทคนิคและจริยธรรม

- ตั้งคณะกรรมการกำกับดูแล (governance): รวมฝ่ายกฎหมาย ความเป็นส่วนตัว ฝ่ายไอที ฝ่ายบริหารความเสี่ยง และตัวแทนจากธุรกิจ เพื่อกำหนดนโยบายการใช้ AI, consent policy และ incident response plan

- ทดสอบด้านความปลอดภัยและการโจมตี (red-team): จำลองการโจมตีเพื่อประเมินความเสี่ยงจาก misuse และปรับปรุงระบบตรวจจับ/ป้องกัน

- ฝึกอบรมและสร้างความตระหนัก: ให้ความรู้แก่พนักงานและ partner เกี่ยวกับข้อจำกัดของเทคโนโลยี วิธีตรวจสอบ provenance และแนวปฏิบัติเมื่อตรวจพบเนื้อหาที่น่าสงสัย

- ทำสัญญาและการจัดซื้อที่มีเงื่อนไขด้านความรับผิดชอบ: เมื่อใช้บริการคลาวด์หรือ third-party models ให้มีข้อกำหนดด้านความรับผิดชอบ ความยินยอม และการปกป้องข้อมูลในสัญญา

สรุปคือ การนำเทคโนโลยีวิดีโอ AI ไปใช้งานต้องมาพร้อมกับมาตรการด้านจริยธรรม ความเป็นส่วนตัว และการกำกับดูแลที่รัดกุม PixVerse ควรเดินหน้าพัฒนาฟีเจอร์ด้าน moderation, provenance และ compliance ในโรดแมปอย่างโปร่งใส ขณะเดียวกันองค์กรผู้ใช้งานต้องมีการกำกับดูแลภายในที่ชัดเจน โดยผสานเทคนิคทางเทคนิค กฎหมาย และแนวปฏิบัติด้านจริยธรรมเข้าด้วยกันเพื่อให้การใช้งานเกิดประโยชน์สูงสุดโดยลดความเสี่ยงต่อสังคมและบุคคล

บทสรุป

PixVerse เปิดตัวเครื่องมือวิดีโอ AI แบบเรียลไทม์ที่มีศักยภาพในการปฏิวัติการผลิตคอนเทนต์ โดยช่วยให้สื่อและแบรนด์สร้างวิดีโอสั้น รีคัป และสตรีมสดได้รวดเร็วขึ้น ซึ่งอาจช่วย ลดเวลาและต้นทุน ในการผลิตอย่างมีนัยสำคัญ — ในบางกรณีผู้พัฒนาระบุว่าการประมวลผลอัตโนมัติและเทมเพลตที่ปรับแต่งได้ช่วยลดเวลาทำงานได้มากกว่าครึ่ง ตัวอย่างการใช้งานที่ชัดเจนได้แก่ ข่าวด่วน โฆษณาไมโครคอนเทนต์ และการรายงานเหตุการณ์สด ที่ต้องการความเร็วในการออกอากาศและการปรับข้อความให้เหมาะกับกลุ่มเป้าหมาย เพื่อให้เกิดผลเชิงพาณิชย์ที่แท้จริง เครื่องมือนี้จำเป็นต้องพิสูจน์คุณภาพของภาพและเสียง ความหน่วงของระบบ และการตอบรับจากผู้ชมในสภาพแวดล้อมจริง รวมถึงยังต้องพิจารณาค่าใช้จ่ายรวมเมื่อรวมการปรับแต่งและบำรุงรักษาระยะยาว

ความสำเร็จเชิงพาณิชย์ของ PixVerse ขึ้นกับปัจจัยสำคัญหลายด้าน ได้แก่ ประสิทธิภาพในโลกจริง ข้อกำกับด้านจริยธรรม (เช่น การป้องกันการสร้าง deepfake และการคุ้มครองข้อมูลส่วนบุคคล) และการผนวกรวมเข้ากับเวิร์กโฟลว์ของลูกค้า การนำไปใช้งานที่ปลอดภัยและยั่งยืนจึงควรเริ่มด้วยการ ทดสอบในสเกลเล็ก กำหนด KPI เช่น คุณภาพภาพ เวลาตอบสนอง และต้นทุนต่อชิ้นงาน พร้อมทั้งจัดทำนโยบายกำกับดูแล (governance) ที่รวมบทบาทมนุษย์ในการตรวจสอบการสร้างเนื้อหา ก่อนขยายการใช้งานเป็นวงกว้าง ในอนาคต หาก PixVerse ปรับปรุงคุณภาพ ขยายการผสานระบบด้วย API มาตรฐาน และวางกรอบจริยธรรมที่ชัดเจน ก็มีโอกาสสูงที่จะกลายเป็นเครื่องมือสำคัญสำหรับการผลิตคอนเทนต์แบบเรียลไทม์ในอุตสาหกรรมสื่อและการตลาดดิจิทัล

📰 แหล่งอ้างอิง: CNBC