ตลาดเครื่องมือวิเคราะห์ด้วยปัญญาประดิษฐ์ (AI) กำลังเข้าสู่ระยะเติบโตแบบก้าวกระโดด โดยหลายสำนักวิจัยคาดการณ์อัตราการเติบโตเฉลี่ยต่อปี (CAGR) ราว 30% ในช่วงไม่กี่ปีข้างหน้า — ตัวเลขที่สะท้อนการเปลี่ยนผ่านจากการวิเคราะห์เชิงพรรณนาไปสู่การวิเคราะห์เชิงทำนายและการตัดสินใจอัตโนมัติอย่างรวดเร็ว เทคโนโลยีด้านข้อมูลขนาดใหญ่, ความสามารถในการประมวลผลบนคลาวด์, และโมเดลการเรียนรู้เชิงลึกที่ใช้งานได้จริง ล้วนเป็นแรงขับเคลื่อนสำคัญ ทำให้ทั้งองค์กรขนาดใหญ่และสตาร์ทอัพเข้ามาลงทุนในเครื่องมือ เช่น AutoML, Explainable AI, แพลตฟอร์มการวิเคราะห์แบบรวมศูนย์ และโซลูชันการเตรียมข้อมูล

บทความนี้จะสรุปปัจจัยขับเคลื่อนหลัก กลุ่มผลิตภัณฑ์ที่น่าสนใจ กรณีใช้งานสำคัญทั้งในภาคการเงิน การตลาด ซัพพลายเชน และภาคสาธารณสุข รวมถึงข้อพึงระวังและคำแนะนำเชิงกลยุทธ์สำหรับผู้บริหารและนักลงทุน เช่น การจัดลำดับความสำคัญในโครงการนำร่อง การสร้างทักษะภายใน การกำกับดูแลข้อมูล และการเลือกพันธมิตรด้านเทคโนโลยี เพื่อให้สามารถคว้าโอกาสจากการเติบโตของตลาดนี้ได้อย่างมั่นคงและยั่งยืน

ภาพรวมตลาดและตัวเลขสำคัญ

ภาพรวมตลาดและตัวเลขสำคัญ

ตลาดเครื่องมือวิเคราะห์ด้วย AI กำลังอยู่ในช่วงการเติบโตอย่างรวดเร็ว โดยมีการประเมินขนาดตลาดปัจจุบันอยู่ในช่วงประมาณ 10–15 พันล้านดอลลาร์สหรัฐ (ตัวเลขโดยรวมแบบกว้างเพื่อสะท้อนมุมมองหลากหลายการสำรวจเชิงอุตสาหกรรม) นโยบายการลงทุนด้านข้อมูลและระบบอัตโนมัติขององค์กร รวมถึงการนำบริการคลาวด์มาใช้ในวงกว้าง เป็นปัจจัยที่ผลักดันให้เกิดการยอมรับเครื่องมือวิเคราะห์ที่ขับเคลื่อนด้วย AI อย่างกว้างขวางในหลายภาคส่วน เช่น การเงิน การดูแลสุขภาพ ค้าปลีก และโลจิสติกส์

ประเด็นศูนย์กลางของข่าวนี้คือการคาดการณ์อัตราการเติบโตเฉลี่ยต่อปี (CAGR) ที่ 30% ซึ่งมีความหมายเชิงธุรกิจตรงไปตรงมา: อัตราเติบโตระดับนี้บ่งชี้ว่าตลาดจะเพิ่มขนาดอย่างรวดเร็วและทวีคูณในช่วงเวลาไม่กี่ปี ตัวอย่างเชิงตัวเลข หากใช้ฐานตลาดปัจจุบันที่ประมาณ 10–15 พันล้านดอลลาร์ การเติบโตที่ CAGR 30% จะให้ผลลัพธ์โดยประมาณดังนี้

กราฟ: การเติบโตของมูลค่าตลาดภายใต้สมมติฐาน CAGR 30% (แสดงการเพิ่มขึ้นแบบทวีคูณในช่วง 3–5 ปี)

- หลัง 3 ปี: ขนาดตลาดคาดว่าจะอยู่ที่ประมาณ 22–33 พันล้านดอลลาร์ (คำนวณจาก 10–15 พันล้านดอลลาร์ × 1.3^3 ≈ 2.20 เท่า)

- หลัง 5 ปี: ขนาดตลาดคาดว่าจะอยู่ที่ประมาณ 37–56 พันล้านดอลลาร์ (คำนวณจาก 10–15 พันล้านดอลลาร์ × 1.3^5 ≈ 3.71 เท่า)

การเติบโตในระดับ CAGR 30% มีความหมายเชิงกลยุทธ์ต่อผู้เล่นในตลาดอย่างชัดเจน ได้แก่ ความต้องการสำหรับการลงทุนด้านเทคโนโลยีและบุคลากรจะเร่งขึ้น ผู้ให้บริการซอฟต์แวร์จะสามารถขยายรายได้ได้อย่างรวดเร็ว แต่ก็ต้องแข่งขันด้านนวัตกรรม ฟีเจอร์ และโมเดลการตั้งราคาอย่างเข้มข้น นอกจากนี้ นักลงทุนและหน่วยงานบริหารต้องประเมินความเสี่ยงด้านการปรับใช้ เทคโนโลยี และการปฏิบัติตามกฎระเบียบควบคู่ไปด้วย

ปัจจัยระดับมาโครที่ขับเคลื่อนการเติบโตของตลาดประกอบด้วย:

- การย้ายขึ้นสู่คลาวด์อย่างแพร่หลาย (Cloud adoption) — โครงสร้างพื้นฐานคลาวด์ช่วยให้ติดตั้งและสเกลเครื่องมือวิเคราะห์โดยใช้โมเดล AI ได้เร็วขึ้นและต้นทุนต่อหน่วยลดลง

- การระเบิดของปริมาณข้อมูล (Data explosion) — อุปกรณ์ IoT, ธุรกรรมดิจิทัล และการสื่อสารออนไลน์สร้างข้อมูลในปริมาณมากที่เป็นเชื้อเพลิงให้กับโมเดลวิเคราะห์

- การเดินหน้าองค์กรสู่ระบบอัตโนมัติ (Enterprise automation) — ความต้องการลดเวลาการตัดสินใจและเพิ่มประสิทธิภาพกระบวนการ ทำให้เครื่องมือวิเคราะห์ด้วย AI เป็นส่วนสำคัญของสแต็กเทคโนโลยีในองค์กร

- ความก้าวหน้าทางเทคนิคและโมเดลขนาดใหญ่ — ปรับปรุงความแม่นยำและฟีเจอร์การวิเคราะห์ ทำให้กรณีใช้งานขยายจากการรายงานไปสู่การคาดการณ์เชิงรุกและการตัดสินใจแบบเรียลไทม์

จากมุมมองเชิงการใช้งาน ผลลัพธ์ที่องค์กรคาดหวังจากการลงทุนในเครื่องมือวิเคราะห์ด้วย AI ได้แก่การลดเวลาการตัดสินใจ การปรับปรุงอัตราการรักษาลูกค้า (retention) การเพิ่มประสิทธิภาพห่วงโซ่อุปทาน และการลดต้นทุนจากกระบวนการที่เป็นอัตโนมัติ ตัวอย่างเช่น ในภาคการเงินและธนาคาร เครื่องมือนี้ถูกนำไปใช้ในการตรวจจับการฉ้อโกงแบบเรียลไทม์ ในค้าปลีกใช้เพื่อการปรับแต่งโปรโมชั่นแบบเฉพาะบุคคล และในภาคสุขภาพใช้เพื่อสนับสนุนการตัดสินใจทางคลินิก

สรุปโดยย่อ: การคาดการณ์ CAGR 30% แสดงถึงการเปลี่ยนผ่านเชิงโครงสร้างของตลาดเครื่องมือวิเคราะห์ด้วย AI ภายในระยะ 3–5 ปีข้างหน้า ตลาดมีศักยภาพที่จะขยายเป็นหลายสิบพันล้านดอลลาร์ พร้อมทั้งเปิดโอกาสและความท้าทายทั้งด้านเทคโนโลยี การแข่งขัน และการกำกับดูแล ที่ผู้บริหารและนักลงทุนต้องจับตามองอย่างใกล้ชิด

ปัจจัยขับเคลื่อนการเติบโต

ปัจจัยขับเคลื่อนการเติบโต

การเติบโตอย่างรวดเร็วของตลาดเครื่องมือวิเคราะห์ด้วย AI มีรากฐานมาจากปัจจัยเชิงโครงสร้างที่ผสานกันอย่างชัดเจน ประการแรกคือปริมาณข้อมูลที่มหาศาลและความสามารถในการจัดเก็บ/ประมวลผลที่พัฒนาขึ้นอย่างทวีคูณ ตามรายงานของ IDC ข้อมูลทั่วโลก (global datasphere) ถูกคาดการณ์ว่าจะขยายตัวอย่างมีนัยสำคัญในช่วงไม่กี่ปีที่ผ่านมา ทำให้การลงทุนใน data lakes, data warehouses และสถาปัตยกรรมแบบ lakehouse รวมทั้งเทคโนโลยีสตรีมมิงเรียลไทม์ เช่น Apache Kafka กลายเป็นพื้นฐานสำคัญสำหรับการนำ AI มาประยุกต์ใช้จริง ตัวอย่างเช่น แพลตฟอร์มอย่าง Snowflake, Databricks, AWS S3 และ Google BigQuery ช่วยให้การเข้าถึงข้อมูลระดับเพตะไบต์/แซตตะไบต์เป็นไปได้อย่างมีประสิทธิภาพและคุ้มค่า

ประการที่สองคือการแพร่หลายของแพลตฟอร์มคลาวด์และบริการ managed AI ผู้ให้บริการคลาวด์รายใหญ่ (AWS, Microsoft Azure, Google Cloud) ได้พัฒนาเครื่องมือที่ทำให้การฝึกสอนและปรับใช้โมเดลง่ายขึ้น เช่น Amazon SageMaker, Azure Machine Learning, Google Vertex AI รวมถึงฮาร์ดแวร์เฉพาะทาง (GPU/TPU และชิปเร่งความเร็วเช่น AWS Inferentia) ซึ่งลดอุปสรรคด้านการลงทุนล่วงหน้าและเพิ่มความยืดหยุ่นในการสเกล ทำให้ธุรกิจขนาดกลางและใหญ่สามารถทดลองและใช้งานโมเดลได้เร็วขึ้น รายงานจากหลายสำนักยังชี้ให้เห็นว่าการใช้จ่ายด้านคลาวด์ยังคงเติบโตอย่างต่อเนื่อง ส่งเสริมการเข้าถึงทรัพยากรประมวลผลความเร็วสูงสำหรับงานวิเคราะห์เชิงลึก

นอกจากนี้ เทคโนโลยีด้าน democratization เช่น no-code/low-code และ AutoML เป็นตัวเปลี่ยนเกมที่สำคัญ เครื่องมือเหล่านี้ลดความจำเป็นในการมีทีม Data Science ขนาดใหญ่โดยอนุญาตให้ผู้ใช้งานธุรกิจทั่วไปสร้างต้นแบบ วิเคราะห์ข้อมูล และนำโมเดลไปใช้ได้จริง ตัวอย่างแพลตฟอร์มที่เป็นที่รู้จักได้แก่ DataRobot, H2O.ai, Google AutoML และ Microsoft Power Platform กรณีศึกษาจากองค์กรหลายแห่งแสดงให้เห็นว่าการใช้ AutoML และเครื่องมือแบบ low-code สามารถย่นระยะเวลาในการสร้างโมเดลจากหลายสัปดาห์เหลือเป็นวันหรือเป็นสัปดาห์สั้น ๆ ช่วยให้การตัดสินใจทางธุรกิจตอบสนองต่อเหตุการณ์ได้รวดเร็วขึ้น

สุดท้าย ความต้องการผลตอบแทนจากการลงทุน (ROI) ที่รวดเร็วเป็นแรงขับเคลื่อนเชิงธุรกิจที่มีพลัง องค์กรในหลายอุตสาหกรรม เช่น การค้าปลีก การเงิน และการผลิต มองหาโซลูชันที่ให้ผลลัพธ์วัดได้ เช่น การลดการลาออกของลูกค้า (churn), การเพิ่มอัตราการแปลง (conversion), หรือลดเวลาหยุดทำงานของเครื่องจักร (predictive maintenance) ซึ่งการฝังการวิเคราะห์เชิงพยากรณ์ไว้ในผลิตภัณฑ์และกระบวนการ (embedded analytics) ช่วยให้การวัดผลและการปรับปรุงมีความต่อเนื่อง ตัวอย่างเครื่องมือที่รองรับการฝังการวิเคราะห์ ได้แก่ Looker, Power BI Embedded และ Tableau Embedded ซึ่งช่วยเพิ่มมูลค่าเชิงพาณิชย์และตอบโจทย์ความคาดหวัง ROI ภายในกรอบเวลาที่สั้นขึ้น

- ข้อมูลจำนวนมากและความสามารถในการจัดเก็บ/ประมวลผล — การมี data lakes และเทคโนโลยี lakehouse พร้อมสถาปัตยกรรมสตรีมมิงทำให้การวิเคราะห์เชิง AI ในระดับขนาดใหญ่เป็นไปได้จริง (ตัวอย่าง: Snowflake, Databricks, BigQuery)

- แพลตฟอร์มคลาวด์และบริการ managed AI — บริการอย่าง Amazon SageMaker, Azure ML, Google Vertex AI ช่วยลดอุปสรรคด้านโครงสร้างพื้นฐานและเร่งเวลาในการนำโมเดลสู่การใช้งานจริง

- เทคโนโลยี democratization (no-code/low-code และ AutoML) — เครื่องมือเหล่านี้ขยายฐานผู้ใช้งาน ช่วยลดเวลาและต้นทุนในการพัฒนาโมเดล และเพิ่มอัตราการนำไปใช้ในหน่วยงานธุรกิจ

- embedded analytics และความต้องการ ROI ที่รวดเร็ว — การฝังการวิเคราะห์และโมเดลไว้ในผลิตภัณฑ์และเวิร์กโฟลว์ ทำให้สามารถวัดผลเชิงธุรกิจได้ชัดเจนและรีดผลตอบแทนจากการลงทุนได้เร็วขึ้น

กลุ่มผลิตภัณฑ์หลักและผู้เล่นสำคัญในตลาด

เนื้อหาส่วน กลุ่มผลิตภัณฑ์หลักและผู้เล่นสำคัญในตลาด ยังไม่สามารถสร้างได้

กรณีใช้งานที่สร้างมูลค่าสูง (Use Cases)

กรณีใช้งานที่สร้างมูลค่าสูง (Use Cases)

ตลาดเครื่องมือวิเคราะห์ด้วย AI ก่อให้เกิดกรณีใช้งานที่สร้างมูลค่าในระดับสูงข้ามอุตสาหกรรม โดยเฉพาะในด้านการลดความเสี่ยง การเพิ่มรายได้ และการปรับปรุงประสิทธิภาพการปฏิบัติการ ตัวอย่างต่อไปนี้นำเสนอ use case ที่ชัดเจนในภาคการเงิน (finance), ค้าปลีก (retail), การผลิต (manufacturing) และการดูแลสุขภาพ (healthcare) พร้อมตัวชี้วัดเชิงธุรกิจ (เช่น revenue lift, cost reduction, time-to-insight) และเทคโนโลยีที่เหมาะสมเพื่อการนำไปใช้จริง

1) การตรวจจับการฉ้อโกง (Finance) — Real-time scoring และ Explainable AI

การนำ AI มาใช้ตรวจจับการฉ้อโกงในการเงินมักใช้โมเดลเรียลไทม์ (real-time scoring) ร่วมกับการตรวจจับความผิดปกติ (anomaly detection) และระบบ rule-based เพื่อบล็อกธุรกรรมที่น่าสงสัยในเสี้ยววินาที ธนาคารและผู้ให้บริการบัตรเครดิตรายงานว่าการใช้งานเหล่านี้สามารถลดความสูญเสียจากการฉ้อโกงได้โดยทั่วไปราว 30%-70% และลด false positive ที่สร้างภาระแก่ลูกค้าได้ถึง 20%-50%.

ธุรกิจมักวัด ROI ด้วยตัวชี้วัดเช่น reduction in fraud losses, cost per investigation และ time-to-flag (เวลาจากเกิดเหตุถึงการแจ้งเตือน) โดยระบบเรียลไทม์ที่ตอบสนองเร็วสามารถลดเวลาตรวจจับจากชั่วโมงเป็นวินาที ขณะที่ Explainable AI ช่วยให้ทีมปฏิบัติการและหน่วยงานกำกับดูแลเข้าใจเหตุผลเบื้องหลังการตัดสินใจ จึงลดความเสี่ยงด้านการปฏิบัติตามกฎระเบียบ

2) การวิเคราะห์ลูกค้าเชิงพฤติกรรม (Retail) — Batch analytics และ Real-time personalization

ในค้าปลีก การใช้ AI เพื่อวิเคราะห์พฤติกรรมลูกค้าและปรับเสนอสินค้าส่วนบุคคล (personalization) ทั้งแบบ batch และแบบเรียลไทม์สามารถเพิ่ม conversion และมูลค่าการสั่งซื้อได้ ตัวอย่างที่มักถูกรายงานคือ revenue lift 5%-20% จากการแนะนำสินค้าอัจฉริยะ และการเพิ่ม retention ที่ 3%-10% เมื่อใช้การสื่อสารที่ตรงกับลูกค้า

ตัวชี้วัดที่ผู้บริหารให้ความสำคัญได้แก่ average order value (AOV), customer lifetime value (CLV), click-through rate และ time-to-insight สำหรับการวิเคราะห์เชิงพฤติกรรม Batch analytics เหมาะกับการสร้างเซกเมนต์ลูกค้ารายใหญ่และอัลกอริธึมการจัดกลุ่ม ในขณะที่ real-time scoring/streaming เหมาะกับการปรับเนื้อหาโปรโมชั่นขณะลูกค้าเข้าชมเว็บไซต์หรือร้านค้าออนไลน์

3) Predictive Maintenance (Manufacturing) — Streaming analytics และ Edge AI

การใช้ AI วิเคราะห์ข้อมูลเซนเซอร์เพื่อคาดการณ์ความล้มเหลวของอุปกรณ์ (predictive maintenance) ช่วยลดเวลาเครื่องจักรหยุดทำงานแบบไม่คาดคิดและลดต้นทุนการบำรุงรักษา บริษัทการผลิตมักรายงานการลด downtime ระหว่าง 30%-50% และลดค่าใช้จ่ายการบำรุงรักษารวมได้ประมาณ 10%-40%

เทคโนโลยีที่เหมาะสมได้แก่ streaming analytics และ edge AI (เมื่อข้อมูลต้องประมวลผลใกล้แหล่งกำเนิด) เพื่อแจ้งเตือนทันทีเมื่อค่าพารามิเตอร์เบี่ยงเบน นอกจากนี้การบูรณาการกับระบบ CMMS (Computerized Maintenance Management System) และ MLOps ช่วยให้วัดผล ROI โดยตรงจากการลดชั่วโมงหยุดเครื่องและการยืดอายุอุปกรณ์

4) Decision Support (Healthcare) — Explainable AI และ Batch/Realtime Hybrid

ในภาคการดูแลสุขภาพ AI ถูกนำมาเป็นระบบสนับสนุนการตัดสินใจ เช่น ช่วยอ่านภาพรังสีวินิจฉัย วิเคราะห์สัญญาณชีพ หรือคัดกรองผู้ป่วยที่มีความเสี่ยงสูง การศึกษาหลายชิ้นชี้ว่าเทคโนโลยีเหล่านี้สามารถลดอัตราข้อผิดพลาดในการวินิจฉัยได้ประมาณ 20%-40% และลดเวลาการอ่านผลหรือ time-to-diagnosis ลงได้ถึง 30%-60%

สำหรับ use case นี้ explainable AI มีความสำคัญสูงเพื่อให้แพทย์เข้าใจคำอธิบายของโมเดลและสามารถนำผลไปใช้ร่วมกับการตัดสินใจทางคลินิก ระบบมักผสมผสาน batch analytics สำหรับการฝึกโมเดลและ real-time scoring สำหรับการให้ผลวินิจฉัยทันทีในห้องฉุกเฉิน ตัวชี้วัดธุรกิจรวมถึง diagnostic accuracy, patient throughput, และ cost per case

ตัวชี้วัด ROI และการเลือกเทคโนโลยีที่สอดคล้อง

- ตัวชี้วัดยอดนิยมที่ธุรกิจติดตาม: revenue lift (%), cost reduction (%), reduction in error rates (%), downtime reduction (%), time-to-insight (จากวัน/ชั่วโมง เป็นนาที/วินาที), และ customer/clinical outcomes

- การประเมิน ROI แบบคร่าว ๆ: หากระบบ personalization เพิ่มยอดขาย 10% บนรายได้พื้นฐาน 100 ล้านบาท จะได้ revenue lift 10 ล้านบาทต่อปี หักค่าใช้จ่ายระบบและการดำเนินงานเป็น ROI ที่ชัดเจน ในทางกลับกัน ระบบ predictive maintenance ที่ลด downtime 40% อาจประหยัดต้นทุนการผลิตได้เป็นจำนวนหลายสิบล้านต่อปีขึ้นอยู่กับมูลค่าการผลิตต่อชั่วโมง

- การจับคู่ use case กับเทคโนโลยี:

- Real-time scoring/streaming analytics — เหมาะกับ fraud detection, real-time personalization, และการแจ้งเตือนเครื่องจักร

- Batch analytics — เหมาะกับการสร้างโมเดลเซกเมนต์ลูกค้า, การฝึกโมเดลวินิจฉัย และการวิเคราะห์แนวโน้มระยะยาว

- Explainable AI — สำคัญในสภาพแวดล้อมที่ต้องการการอธิบายผล เช่น การเงินและการแพทย์ เพื่อการยอมรับจากผู้ใช้งานและหน่วยงานกำกับดูแล

สรุปคือ เครื่องมือวิเคราะห์ด้วย AI สามารถสร้างมูลค่าเชิงธุรกิจได้อย่างชัดเจนเมื่อจับคู่ use case กับสถาปัตยกรรมและเทคโนโลยีที่เหมาะสม พร้อมการวัดผลด้วยตัวชี้วัดเชิงธุรกิจที่ชัดเจน การประสานงานระหว่างทีม data, IT และ domain experts รวมถึงการเน้น Explainability และการวัดผลหลังใช้งาน จะเป็นกุญแจสู่การสร้าง ROI ที่ยั่งยืนข้ามอุตสาหกรรม

เทคโนโลยีเบื้องหลังและความท้าทายทางเทคนิค

เทคโนโลยีเบื้องหลังและความท้าทายทางเทคนิค

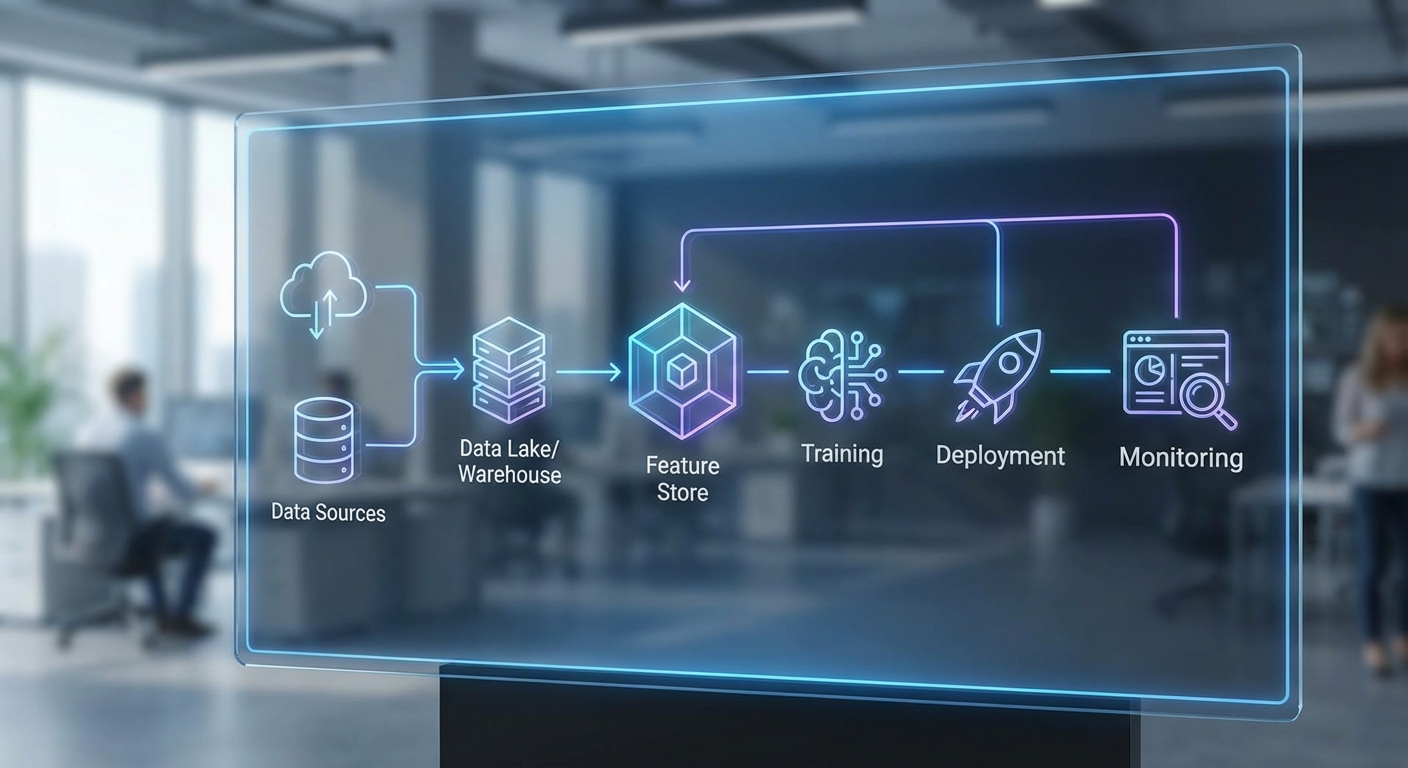

สแตกเทคนิคของเครื่องมือวิเคราะห์ด้วย AI ประกอบด้วยองค์ประกอบหลายชั้นที่ทำงานร่วมกันตั้งแต่การรวบรวมข้อมูลจนถึงการให้บริการผลลัพธ์เชิงธุรกิจ โดยหลักๆ จะมีส่วนของ data ingestion & preprocessing, feature engineering และ feature stores, model training & experiment tracking, model deployment / serving สำหรับการใช้งานแบบ batch และ real‑time inference รวมถึง monitoring, observability และ explainability tools สำหรับติดตามประสิทธิภาพและความโปร่งใสของโมเดล ในเชิงปฏิบัติ สแตกเหล่านี้มักถูกรันบนโครงสร้างพื้นฐานแบบผสมผสาน (cloud, on‑premise, edge) โดยใช้เครื่องมือ orchestration (เช่น workflow scheduler หรือ MLOps platforms) เพื่อบริหาร pipeline ตั้งแต่การฝึกสอนจนถึงการอัปเดตโมเดลใน production

ตัวอย่างองค์ประกอบสำคัญที่ธุรกิจต้องพิจารณา ได้แก่:

- Feature stores: เก็บและจัดการ features แบบ reuseable และ versioned เพื่อให้การฝึกสอนและ inference ใช้ข้อมูลเดียวกัน ลดความเสี่ยงของ data leakage และ inconsistency

- Training & deployment pipelines: ระบบที่รองรับ experiment tracking, model registry, automated retraining และ deployment (เช่น Canary / Blue‑Green) เพื่อให้การเปลี่ยนแปลงโมเดลปลอดภัยและควบคุมได้

- Real‑time inference infrastructure: การให้บริการโมเดลแบบเรียลไทม์ต้องการการ optimize ทั้งด้าน latency, throughput และ resource orchestration (CPU/GPU/TPU, autoscaling)

- Explainability & auditing tools: เช่นการใช้ local/global explainers, feature importance, counterfactual analysis เพื่อให้ผู้ใช้งานและหน่วยงานกำกับดูแลสามารถตรวจสอบการตัดสินใจของโมเดลได้

แม้สแตกจะก้าวหน้า แต่ก็ยังเผชิญกับปัญหาทางเทคนิคหลายด้านที่ส่งผลต่อผลลัพธ์เชิงธุรกิจ ตัวอย่างปัญหาที่พบบ่อยได้แก่ data quality (missing values, noisy labels), data drift และ concept drift ที่ทำให้ความแม่นยำลดลงเมื่อเวลาผ่านไป, model governance ที่เกี่ยวข้องกับการติดตาม lineage, versioning และการอนุมัติโมเดล, รวมถึง latency/throughput สำหรับงาน real‑time ที่ต้องการคำตอบทันที นอกจากนี้การปรับสเกลระบบเมื่อข้อมูลเพิ่มขึ้นและการบูรณาการกับระบบ IT เดิม (legacy systems) ที่อาจใช้เทคโนโลยีเก่าเป็นอีกหนึ่งความท้าทายเชิงปฏิบัติการ

เพื่อบรรเทาความเสี่ยงเหล่านี้ องค์กรนิยมยึดแนวปฏิบัติแบบ MLOps และ CI/CD for ML ที่ออกแบบเฉพาะสำหรับลูป ML โดยรวมมาตรการดังต่อไปนี้:

- Automated testing & CI/CD ของโมเดล: รวม unit/integration tests สำหรับ data pipelines, model checks (performance, fairness thresholds) และการ deploy แบบค่อยเป็นค่อยไป (canary, shadow testing)

- Monitoring & alerting แบบต่อเนื่อง: ตรวจจับ data drift, label skew, latency spike ผ่าน metrics และ data quality checks เพื่อเปิดกระบวนการ retraining หรือ rollback อัตโนมัติ

- Data contracts & schema validation: ข้อตกลงและการ validate รูปแบบข้อมูลระหว่างระบบต่างๆ เพื่อลดการเปลี่ยนแปลงแบบไม่คาดคิดและป้องกันการล้มเหลวของ pipeline

- Model registry และ governance framework: บันทึก metadata, lineage, audit trails และนโยบายการอนุมัติ เพื่อให้การควบคุม การตรวจสอบ และการปฏิบัติตามข้อบังคับเป็นระบบ

- Infrastructure as code และ containerization: ใช้การแพ็กเกจ (containers) และ orchestration (Kubernetes) เพื่อให้การ deploy มีความสม่ำเสมอและปรับขนาดได้ง่ายเมื่อต้องรองรับปริมาณงานเพิ่มขึ้น

- Explainability & bias mitigation: ผสมผสานเครื่องมืออธิบายผลลัพธ์และกระบวนการตรวจสอบ fairness เช่นการทดสอบกลุ่มย่อย เพื่อรองรับข้อกำหนดด้านความโปร่งใสและลดความเสี่ยงเชิงกฎหมาย

สุดท้าย การผสานระบบ AI เข้ากับ legacy IT ต้องใช้กลยุทธ์ชั้นเลเยอร์ เช่นการสร้าง API/adapter ชั้นกลาง การทำ strangler pattern ค่อยๆ ทดแทนฟังก์ชันเดิม และการตั้ง gateway สำหรับการแลกเปลี่ยนข้อมูลที่ปลอดภัย ทั้งหมดนี้ต้องมาพร้อมกับแผนบริหารความเสี่ยงด้านข้อมูลและโครงสร้างพื้นฐาน เพื่อให้การนำ AI ไปสู่การใช้งานเชิงธุรกิจเกิดขึ้นได้อย่างรวดเร็ว แต่ยังคงรักษาเสถียรภาพ ความโปร่งใส และการปฏิบัติตามกฎระเบียบ

แนวโน้มตลาด, โอกาสการลงทุน และคำแนะนำเชิงกลยุทธ์

แนวโน้มตลาดใน 3–5 ปีข้างหน้า

ด้วยอัตราเติบโตเฉลี่ยต่อปี (CAGR) ที่คาดการณ์ราว 30% ตลาดเครื่องมือวิเคราะห์ด้วย AI จะขยายตัวอย่างรวดเร็ว ทั้งในแง่ของมูลค่าตลาดและการนำไปใช้งานจริงในองค์กรทุกขนาด ภายในช่วง 3–5 ปีข้างหน้า เราจะเห็นการกระจายตัวของโซลูชันจากระดับพื้นฐานไปสู่ความสามารถขั้นสูง เช่น การวิเคราะห์เชิงทำนาย (predictive analytics), การแนะนำเชิงสรุป (prescriptive analytics), และการผสานรวมกับระบบธุรกิจแบบเรียลไทม์ การเติบโตนี้ถูกขับเคลื่อนโดยปัจจัยสำคัญหลายประการ ได้แก่ ปริมาณข้อมูลที่เพิ่มขึ้น ความพร้อมใช้งานของโมเดลและเครื่องมือต้นทุนต่ำขึ้น และแรงกดดันทางธุรกิจที่ต้องการการตัดสินใจเร็วและมีข้อมูลรองรับ

ในเชิงโครงสร้างตลาด เราคาดว่าจะเห็นการเพิ่มขึ้นอย่างต่อเนื่องของสตาร์ทอัพที่มุ่งเน้นปัญหาจำเพาะด้านอุตสาหกรรม (vertical AI) และโซลูชันเสริมด้านความปลอดภัย ความโปร่งใส และการจัดการวงจรชีวิตโมเดล (MLOps) ขณะเดียวกัน ผู้เล่นขนาดใหญ่และผู้ให้บริการคลาวด์จะเร่งขยายพอร์ตโฟลิโอเพื่อครอบคลุมความต้องการองค์กร ซึ่งนำไปสู่สภาพตลาดที่ผสมผสานระหว่างนวัตกรรมสตาร์ทอัพและแพลตฟอร์มรวมศูนย์จากผู้ให้บริการรายใหญ่

คาดการณ์แนวโน้ม M&A และการรวมบริการ

ในอีก 3–5 ปีข้างหน้า แนวโน้มการควบรวมและซื้อกิจการ (M&A) จะยังคงเด่นชัด: ผู้เล่นรายใหญ่จะซื้อสตาร์ทอัพที่มีเทคโนโลยีหรือฐานลูกค้าที่เติมเต็มช่องว่างของตนได้อย่างรวดเร็ว โดยเฉพาะสตาร์ทอัพที่มีความเชี่ยวชาญด้านการอธิบายผลลัพธ์ (explainability), การรักษาความเป็นส่วนตัวของข้อมูล (privacy-preserving ML), และการปฏิบัติการโมเดล (modelops/ML platform)

ผลลัพธ์ของคลื่น M&A นี้คาดว่าจะเป็นการรวมฟังก์ชันหลายอย่างเข้าเป็นชุดแพลตฟอร์มเดียวเพื่อลดความซับซ้อนของสภาพแวดล้อมไอที แต่ก็จะสร้างความต้องการด้านการบูรณาการ ระบบมาตรฐานกลาง และโซลูชันแบบ hybrid ที่สามารถทำงานร่วมกับโครงสร้างพื้นฐานเดิมขององค์กรได้

โอกาสสำหรับ VC และองค์กรลงทุน

- ลงทุนในสตาร์ทอัพที่แก้ pain point เฉพาะทาง: โซลูชันเชิงแนวดิ่ง (เช่น การเงิน การแพทย์ โลจิสติกส์) และเครื่องมือเสริม MLOps มีโอกาสสร้างมูลค่าเพิ่มสูงและถูกเป้าหมายเข้าซื้อโดยผู้เล่นรายใหญ่

- ให้ความสำคัญกับโครงสร้างพื้นฐานและความปลอดภัย: งานที่เกี่ยวกับข้อมูลคุณภาพ (data engineering, data catalog), privacy, และ governance มีอัตราการนำไปใช้ที่มั่นคงและมักมีรายได้ซ้ำ (recurring revenue)

- มองหา exit ทาง M&A และพันธมิตรเชิงกลยุทธ์: การลงทุนในบริษัทที่สามารถขยายเป็นส่วนหนึ่งของแพลตฟอร์มใหญ่ได้จะเพิ่มโอกาสการขายในช่วง 2–5 ปี

- แบ่งพอร์ตการลงทุนตามความเสี่ยง: ผสมระหว่าง seed/early-stage เพื่อจับนวัตกรรม กับ growth-stage ที่มุ่งสู่การเติบโตเชิงพาณิชย์และมีความเป็นไปได้สูงในการ exit

คำแนะนำเชิงกลยุทธ์สำหรับ CIO และ CFO

จัดลำดับความสำคัญของ use cases ด้วยกรอบการประเมินที่ชัดเจน เช่น “ผลกระทบต่อรายได้/ต้นทุน” เทียบกับ “ความยาก/เวลาในการนำไปใช้” ให้เริ่มจากโครงการที่มี ROI สูงและเวลาในการติดตั้งสั้น เพื่อสร้างความเชื่อมั่นและกรณีธุรกิจ จากนั้นขยายไปสู่โครงการเชิงยุทธศาสตร์ที่ต้องการการลงทุนมากขึ้น

การจัดสรรงบประมาณ ควรเป็นแบบเวที (phased budgeting): แบ่งงบประมาณสำหรับการลงทุนพื้นฐาน (data platform, security, integration) ราว 40–60% สำหรับ pilot และ proof-of-value ประมาณ 20–30% และสำรอง 10–30% สำหรับการพัฒนาทักษะ การบำรุงรักษา และ contingency ซึ่งช่วงสัดส่วนขึ้นกับความพร้อมขององค์กรและความสามารถในการรับความเสี่ยง

การเลือกผู้ให้บริการแบบ hybrid มีความสำคัญเพื่อลดความเสี่ยงเรื่อง vendor lock-in และรองรับข้อจำกัดด้านข้อมูลที่ต้องเก็บภายในองค์กร เลือกผู้ให้บริการที่สนับสนุนมาตรฐานเปิด มี API ชัดเจน และให้ทางเลือกการ deploy ทั้ง on‑premise, private cloud และ public cloud รวมทั้งกำหนด SLA และข้อกำหนดด้านความปลอดภัยในสัญญา

เตรียมคนและ governance เพื่อลดความเสี่ยง โดยตั้งทีมกลาง (Center of Excellence) ที่ประกอบด้วย data engineers, ML engineers, product managers และ compliance officers เพื่อกำหนดมาตรฐานการใช้งานข้อมูล การทดสอบโมเดล การติดตามประสิทธิภาพ และการจัดการวงจรชีวิตของโมเดล นโยบายสำคัญที่ควรมีได้แก่ data catalog & lineage, model validation & monitoring, access control และ incident response plan นอกจากนี้ ให้ลงทุนในโปรแกรม upskilling ที่ต่อเนื่องและแผนการสรรหาทรัพยากรที่ขาด เพื่อให้การนำ AI สู่การใช้งานจริงเป็นไปอย่างยั่งยืน

สรุปคือ ในช่วงการเติบโตอย่างรวดเร็วนี้ องค์กรควรเดินหน้าอย่างเป็นขั้นตอน ผสมผสานระหว่างการทดลองเชิงนวัตกรรมกับการสร้างรากฐานที่มั่นคงทางด้านข้อมูลและการกำกับดูแล เพื่อเก็บเกี่ยวประโยชน์เชิงธุรกิจอย่างต่อเนื่องและลดความเสี่ยงจากความเปลี่ยนแปลงของตลาด

บทสรุป

ตลาดเครื่องมือวิเคราะห์ด้วย AI กำลังเติบโตอย่างรวดเร็ว โดยคาดว่าจะมีการเติบโตเฉลี่ยต่อปี (CAGR) ประมาณ 30% ซึ่งสะท้อนโอกาสเชิงธุรกิจที่สูงในด้านการปรับปรุงประสิทธิภาพ ลดต้นทุน และสร้างแหล่งรายได้ใหม่ อย่างไรก็ตาม โอกาสเหล่านี้จะถูกเปลี่ยนเป็นผลลัพธ์เชิงธุรกิจได้จริงก็ต่อเมื่อองค์กรจับคู่การลงทุนด้านเครื่องมือ AI กับแผนด้าน data, governance และ talent ที่ชัดเจน—รวมถึงการจัดการคุณภาพข้อมูล นโยบายความเป็นส่วนตัว การควบคุมการเข้าถึง และการพัฒนาทักษะบุคลากร ตัวอย่างกรณีใช้งานที่มักมี ROI ชัดเจนได้แก่ การลดอัตราการลาออกของลูกค้า (churn) การเพิ่มประสิทธิภาพห่วงโซ่อุปทาน และการพยากรณ์บำรุงรักษาเชิงคาดการณ์ ซึ่งในเชิงปฏิบัติสามารถลดต้นทุนการดำเนินงานได้หรือเพิ่มรายได้ในอัตราที่วัดได้ (เช่น ตัวอย่างทั่วไป 5–30% ขึ้นกับอุตสาหกรรมและการนำไปใช้)

ในมุมมองอนาคต การลงทุนเชิงกลยุทธ์ควรมุ่งไปที่แพลตฟอร์มแบบเปิด (open platforms) และโครงการต้นแบบ (PoC) ที่กำหนด KPI และตัวชี้วัด ROI อย่างชัดเจน เพื่อหลีกเลี่ยงการล็อกกับผู้ให้บริการเดียวและเร่งการทำงานร่วมกันระหว่างทีมข้อมูลและธุรกิจ การพัฒนาแผนการกำกับดูแลข้อมูล (data governance), กรอบการวัดผล และแผนพัฒนาทักษะบุคลากร จะเป็นกุญแจสำคัญในการแปลงการลงทุนเป็นผลลัพธ์เชิงธุรกิจจริง ในระยะยาว องค์กรที่รวมกลยุทธ์ข้อมูล นโยบายกำกับดูแล และแพลตฟอร์มแบบเปิดเข้าด้วยกันมีแนวโน้มจะได้ประโยชน์สูงสุดจากการเติบโตของตลาด AI ที่คาดการณ์ไว้ แต่ต้องคำนึงถึงความเสี่ยงเรื่องการปฏิบัติตามกฎระเบียบ ความเป็นส่วนตัว และการบริหารการเปลี่ยนแปลงภายในองค์กรควบคู่ไปด้วย

📰 แหล่งอ้างอิง: Market.us