สตาร์ทอัพไทยเปิดตัว "AR‑FieldCopilot" แพลตฟอร์มใหม่ที่ผสานเทคโนโลยี AR (Augmented Reality), Computer Vision และ Large Language Models เข้าด้วยกันเพื่อยกระดับการทำงานของช่างภาคสนาม — ให้ช่างสามารถส่องภาพอุปกรณ์ผ่านกล้อง แยกแยะความผิดปกติแบบเรียลไทม์ และรับคำแนะนำการซ่อมเป็นขั้นตอนที่แสดงทับบนภาพจริงทันที รายงานจากการทดลองภาคสนามชี้ว่าแพลตฟอร์มนี้ช่วยลดเวลาแก้ไขเครื่องจักรลงถึง 50% พร้อมทั้งเพิ่มอัตราการแก้ปัญหาได้สำเร็จในครั้งแรก (first‑time fix) อย่างมีนัยสำคัญ

การรวมกันของ AR‑CV‑LLM ทำให้ AR‑FieldCopilot ไม่เพียงแต่ระบุข้อบกพร่องจากภาพเท่านั้น แต่ยังเชื่อมโยงกับฐานความรู้ ให้คู่มือเชิงปฏิบัติ (step‑by‑step) และเสนอคำอธิบายเชิงสาเหตุ ช่วยลดการพึ่งพาผู้เชี่ยวชาญระยะไกล ตัวอย่างภาคอุตสาหกรรม เช่น โรงงานการผลิต โรงไฟฟ้า และงานโทรคมนาคม พบว่าระบบช่วยลดเวลาเสียหาย (downtime) และต้นทุนการเดินทาง ให้ผลลัพธ์ที่ชัดเจนทั้งด้านประสิทธิภาพการบำรุงรักษาและความต่อเนื่องของการผลิต

ภาพรวมข่าวและจุดเด่นของ AR‑FieldCopilot

สรุปการเปิดตัว

สตาร์ทอัพไทยเปิดตัว AR‑FieldCopilot อย่างเป็นทางการเมื่อวันที่ 5 กุมภาพันธ์ 2026 ผลิตภัณฑ์นี้พัฒนาโดยทีมผู้ก่อตั้งกลุ่มเล็กที่ประกอบด้วยอดีตวิศวกรภาคสนาม, นักวิจัยด้านคอมพิวเตอร์วิทัศน์ และวิศวกรซอฟต์แวร์ด้านภาษาธรรมชาติ รวมเป็นทีมหลัก 3 คน ปัจจุบันบริษัทอยู่ในสถานะ รอบ Seed โดยเพิ่งปิดรอบระดมทุนเบื้องต้นจากกลุ่มนักลงทุนแองเจิลและกองทุนเทคโนโลยีของไทย

จุดเด่นเชิงเทคโนโลยีและการใช้งาน

AR‑FieldCopilot ผสานเทคโนโลยี Augmented Reality (AR), Computer Vision และ Large Language Models (LLM) เพื่อช่วยช่างภาคสนามส่องภาพอุปกรณ์หรือเครื่องจักรผ่านกล้องมือถือหรือแว่น AR แล้วได้รับการวินิจฉัยปัญหาแบบ เรียลไทม์ พร้อมแสดงทิศทางการซ่อมและคู่มือเป็นขั้นตอนบนภาพจริงที่ช่างมองเห็น (AR overlay) ระบบสามารถระบุชิ้นส่วนที่ผิดปกติ, ประเมินความรุนแรงของความเสียหาย และสร้างคำแนะนำเชิงปฏิบัติการทันที

ฟีเจอร์สำคัญของ AR‑FieldCopilot ประกอบด้วย:

- Real‑time diagnosis — วิเคราะห์ภาพและแจ้งสาเหตุที่เป็นไปได้ภายในไม่กี่วินาที

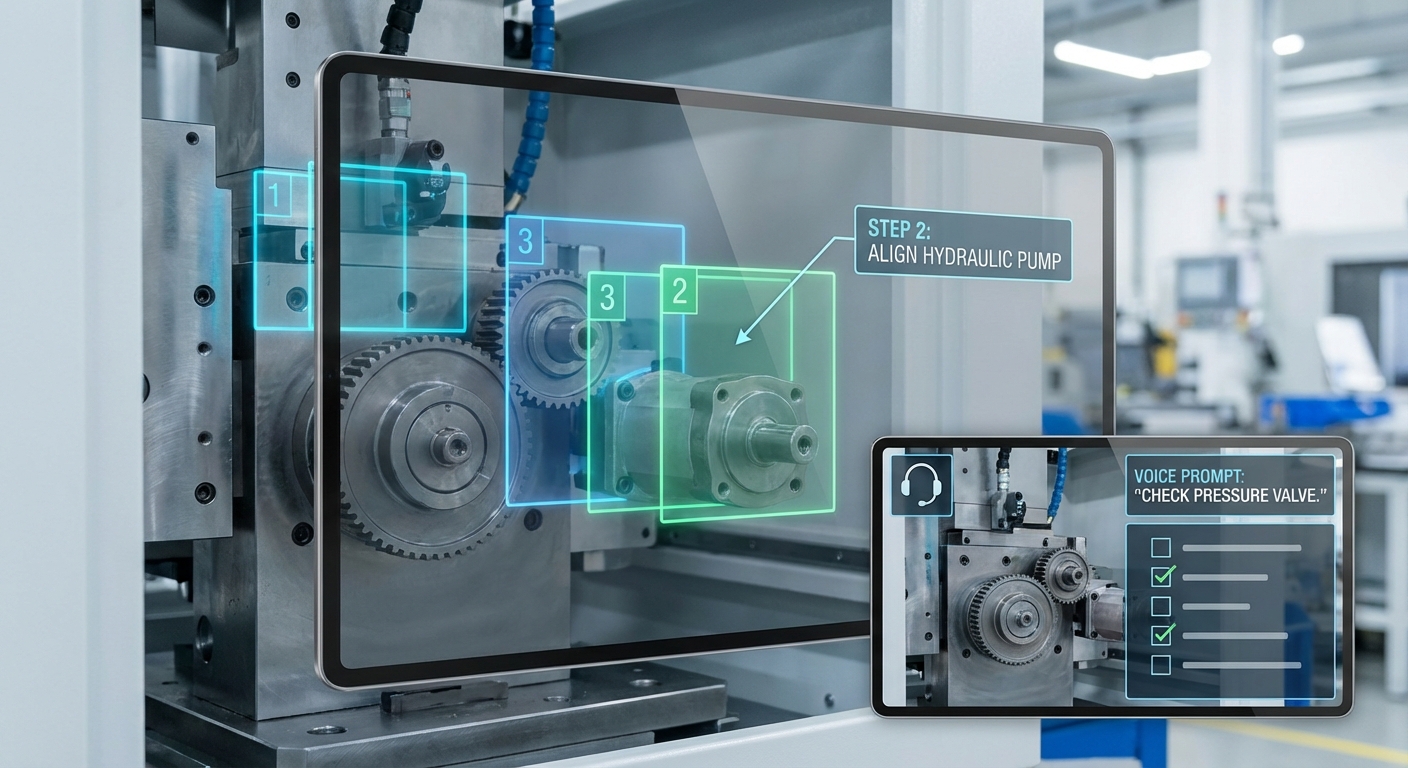

- Step‑by‑step repair guide — แสดงขั้นตอนการซ่อมแบบทีละขั้นบนภาพจริง พร้อมหมายเหตุทางเทคนิคและรายการอุปกรณ์ที่ต้องใช้

- AR overlay — ไฮไลต์ชิ้นส่วนที่ต้องตรวจหรือเปลี่ยน และแสดงตำแหน่งการขันสกรู/เชื่อมต่อแบบอินเตอร์แอคทีฟ

- รองรับการใช้งานแบบออฟไลน์สำหรับไซต์ที่ไม่มีอินเทอร์เน็ต และสามารถซิงก์ข้อมูลเมื่อเชื่อมต่อ

- เชื่อมต่อกับระบบการจัดการสินทรัพย์ (CMMS/ERP) เพื่อบันทึกประวัติการซ่อมและวิเคราะห์เชิงพยากรณ์

ผลลัพธ์เบื้องต้นจากการทดลองภาคสนามที่ดำเนินการร่วมกับผู้ประกอบการอุตสาหกรรม 10 แห่งและผู้ให้บริการซ่อมบำรุง 6 ราย ระบุว่าเวลาเฉลี่ยในการแก้ไขเครื่องจักรถูกลดลงประมาณ 50% ตัวอย่างกรณีศึกษาในโรงงานผลิตชิ้นส่วนอุตสาหกรรมพบว่า เวลาจากการวินิจฉัยและซ่อมลดจาก 120 นาทีเหลือประมาณ 60 นาที และการเรียกทีมผู้เชี่ยวชาญภายนอกเพื่อลงไซต์ลดลงราว 30% ส่งผลให้ระยะเวลาหยุดทำงาน (downtime) และต้นทุนการบำรุงรักษาลดลงอย่างมีนัยสำคัญ

เทคโนโลยีเบื้องหลัง: ทำงานอย่างไร (AR, Computer Vision, LLM)

สถาปัตยกรรมระบบโดยรวม

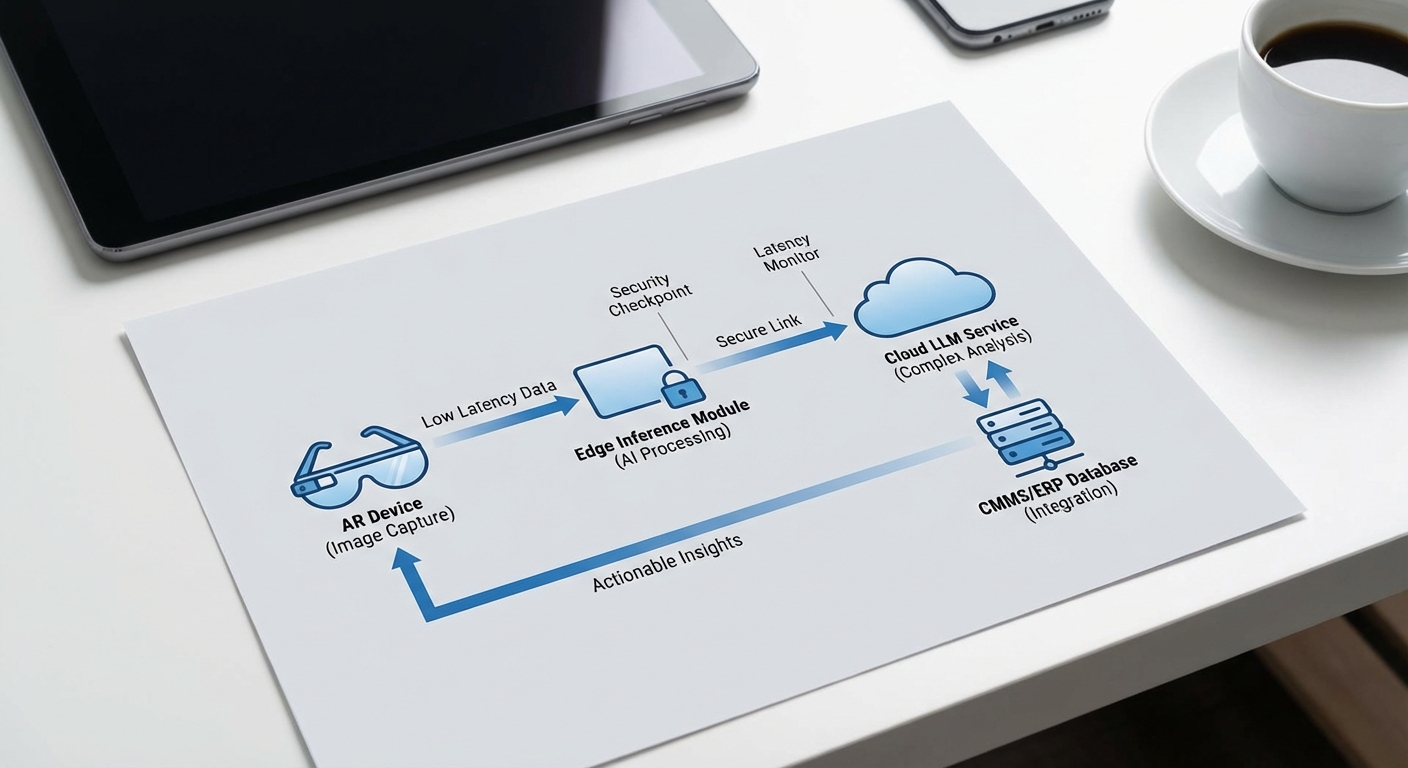

AR‑FieldCopilot ออกแบบในรูปแบบสถาปัตยกรรมแบบผสมผสานระหว่าง Edge และ Cloud เพื่อให้สามารถตอบสนองต่อความต้องการของงานภาคสนามที่ต้องการทั้งความเร็วและความรู้เชิงบริบทสูงสุด ณ จุดปฏิบัติงาน ระบบเริ่มจากการจับภาพด้วยกล้องบนอุปกรณ์ AR (เช่น AR glasses หรือ mobile AR headset) ที่มีเซนเซอร์ภาพแบบความละเอียดพอเหมาะและ IMU เพื่อให้ได้ทั้งภาพและข้อมูลเชิงตำแหน่ง จากนั้นภาพถูกส่งไปยังโมดูลประมวลผลขอบ (edge) เพื่อทำการประมวลผลเร็ว เช่น การตรวจจับชิ้นส่วน/ข้อบ่งชี้ความเสียหายแบบเบื้องต้น (bounding boxes, segmentation) และการสกัดคุณลักษณะสำคัญ (feature extraction) ก่อนจะส่งผลลัพธ์เชิงรายการหรือ descriptors ไปยังคลาวด์เพื่อการสังเคราะห์เชิงความรู้เพิ่มเติมโดยใช้ LLM และการเข้าถึงฐานข้อมูล CMMS (Computerized Maintenance Management System) ของลูกค้า

Pipeline: Capture → CV inference → LLM prompt → Step‑by‑step instruction

Pipeline ของ AR‑FieldCopilot แบ่งได้เป็นขั้นตอนชัดเจนดังนี้:

- Capture: กล้อง AR จับภาพ/วิดีโอพร้อมข้อมูลตำแหน่ง (pose) และเมตา‑ข้อมูลของเครื่องจักร (asset ID) โดยระบบสามารถทำ preprocessing เบื้องต้น เช่น white balance และ denoise เพื่อเพิ่มความถูกต้องของ CV inference

- CV Inference (Edge): โมเดล Computer Vision เบาขนาด (เช่น YOLOv5‑nano, MobileNet‑based detector หรือโมเดล segmentation ขนาดเล็ก) ทำการตรวจจับชิ้นส่วนที่เกี่ยวข้องและความเสียหาย เช่น รอยแตก รอยสึกหรอ หรือการรั่วไหล ผลลัพธ์จะเป็นตำแหน่ง/ประเภทของปัญหาและค่าความเชื่อมั่น (confidence score)

- LLM Prompt (Cloud หรือ Hybrid): ข้อมูลจาก CV (ภาพตัวอย่าง, bounding boxes, confidence, pose) ร่วมกับบริบทจาก CMMS (ประวัติงานซ่อม, คู่มือผู้ผลิต, spare parts) ถูกสร้างเป็น prompt ที่มีโครงสร้างแล้วส่งไปยังโมเดลภาษาขนาดใหญ่ (LLM) ในคลาวด์ โมเดลจะสังเคราะห์การวินิจฉัย เชื่อมโยงสาเหตุที่เป็นไปได้ และเลือกขั้นตอนการแก้ไขที่เหมาะสม

- Step‑by‑step Instruction (Edge/AR Overlay): คำแนะนำเชิงลำดับ (stepwise) ที่ได้จะถูกส่งกลับมาที่อุปกรณ์ AR เพื่อแสดงแบบเรียลไทม์เป็น overlay บนชิ้นส่วนจริง ตัวอย่าง: “ขั้นตอนที่ 1: ปิดแหล่งพลังงาน X (ภาพแสดงสวิตช์) — ขั้นตอนที่ 2: ถอดน็อต Y ด้วยประแจขนาด Z — ขั้นตอนที่ 3: เปลี่ยนซีล part#123”

การแบ่งงานระหว่าง Edge และ Cloud

การตัดสินใจว่าโมดูลไหนทำงานที่ขอบหรือบนคลาวด์เป็นปัจจัยสำคัญเพื่อให้ระบบมีประสิทธิภาพและเชื่อถือได้ โดยหลักการคือให้การตัดสินใจที่ต้องการ latency ต่ำ ทำบน Edge เช่น การตรวจจับฉุกเฉินและการแสดง overlay ส่วนงานที่ต้องอาศัยบริบทความรู้ขนาดใหญ่ เช่น การสังเคราะห์คู่มือ การอ้างอิงเอกสารผู้ผลิต หรือการเรียนรู้ต่อเนื่องแบบรวบยอด ให้ทำบน Cloud

- Edge เหมาะกับ: CV inference แบบเร่งด่วน (inference time เป้าหมายโดยทั่วไป 50–200 มิลลิวินาที), การประมวลผลภาพพื้นฐาน, การแสดงผล AR แบบทันที

- Cloud เหมาะกับ: LLM ที่ใช้ความสามารถเชิงบริบทสูง การรวมข้อมูลจาก CMMS/ERP การจัดเก็บภาพเชิงประวัติศาสตร์และการอัปเดตโมเดลขนาดใหญ่

- Syncing: ข้อมูลการวินิจฉัยและตัวอย่างภาพจะถูกซิงก์ขึ้นคลาวด์แบบเป็นชุดหรือแบบทันทีขึ้นอยู่กับนโยบายแบนด์วิดท์และความเร่งด่วน เพื่อให้เกิดการเรียนรู้ (retraining) และการปรับจูนโมเดลอัตโนมัติ

การเชื่อมต่อกับฐานข้อมูลความรู้/CMMS

LLM จะใช้ข้อมูลจากฐานความรู้ภายในองค์กรและ CMMS เพื่อให้คำแนะนำที่สอดคล้องกับประวัติการซ่อมและนโยบายความปลอดภัย ตัวอย่างเช่น เมื่อ CV ตรวจพบการรั่ว ระบบจะดึงประวัติการซ่อมของ asset ID เดิม ตรวจสอบ spare part ที่สต็อก และรวมขั้นตอนที่ผ่านการรับรองเพื่อให้คำแนะนำที่เหมาะสม นอกจากนี้ยังสามารถสร้าง work order อัตโนมัติและบันทึกการดำเนินงานกลับสู่ CMMS เพื่อการติดตามและวิเคราะห์ต่อไป

ความท้าทายทางเทคนิคและกลยุทธ์บรรเทา

การนำระบบ AR+CV+LLM มาใช้ในสภาพแวดล้อมภาคสนามมีความท้าทายหลายด้าน โดยเฉพาะ latency, data labeling และ model drift ซึ่งสามารถจัดการได้ด้วยแนวทางดังนี้:

- Latency: ใช้การประมวลผลบางส่วนบน Edge (quantized models, model pruning, hardware acceleration ผ่าน NPU/TPU บนอุปกรณ์) และใช้เทคนิค prefetching ของข้อมูลบริบท ทำ caching คำตอบ LLM ที่พบบ่อย และออกแบบ UX ให้แสดงผลแบบ progressive (แสดงผลคร่าวๆ ก่อน จากนั้นเติมรายละเอียดเมื่อ LLM ตอบกลับ) เป้าหมายเชิงปฏิบัติคือรักษา latency สำหรับ CV inference ต่ำกว่า 200 ms และเวลา round‑trip สำหรับคำแนะนำเชิงลึกไม่เกิน 2–5 วินาทีในเครือข่ายภาคสนามทั่วไป

- Data labeling: คุณภาพการฝึก CV ขึ้นกับชุดข้อมูลฉลากภาพที่หลากหลาย — สตาร์ทอัพมักเริ่มด้วยการใช้ transfer learning จากโมเดลสาธารณะและขยายด้วย active learning โดยให้ช่างยืนยัน/แก้ฉลากบนแอปพลิเคชันจริง (human‑in‑the‑loop) เพื่อลดต้นทุนการติดป้ายข้อมูลและเร่งความหลากหลายของชุดข้อมูล ตัวอย่าง: เริ่มต้นด้วย 10k–50k ภาพที่ติดป้ายอย่างมีคุณภาพ เพื่อให้ได้ความแม่นยำการตรวจจับ >85–90%

- Model drift: ความเปลี่ยนแปลงของเครื่องจักร สภาพแวดล้อมแสง หรือส่วนประกอบใหม่ สามารถทำให้โมเดลเสื่อมลงได้ จึงต้องมีระบบมอนิเตอร์เมตริกส์ (accuracy, confidence distribution) และ pipeline สำหรับรีเทรนแบบอัตโนมัติเมื่อพบการเปลี่ยนแปลง เช่น ใช้การเก็บตัวอย่างภาพที่ confidence ต่ำและส่งเข้าสู่กระบวนการ labeling/validation แบบพนักงานตรวจสอบก่อนนำไป retrain เป็นระยะ (เช่น ทุก 2–8 สัปดาห์ ขึ้นอยู่กับอัตราการเปลี่ยนแปลง)

- ความปลอดภัยและความเป็นส่วนตัว: เข้ารหัสข้อมูลระหว่างการส่ง (TLS), บีบอัดภาพก่อนส่งเพื่อประหยัดแบนด์วิดท์ และนโยบายการเก็บข้อมูลตามข้อกำหนดของลูกค้า (on‑premise option หรือ hybrid storage) ซึ่งสำคัญสำหรับลูกค้าในอุตสาหกรรมที่มีข้อจำกัดด้านข้อมูล

- ความน่าเชื่อถือของ LLM: ใช้ prompt engineering ที่มีโครงสร้าง, ให้ citation จาก CMMS/คู่มือผู้ผลิต และผสมผสานการยืนยันจากกฎธุรกิจ (rule‑based checks) เพื่อลดความเสี่ยงของ hallucination รวมถึงเก็บ log ของคำตอบเพื่อ audit และปรับปรุง

โดยสรุป AR‑FieldCopilot ใช้สถาปัตยกรรม Edge‑Cloud แบบผสมเพื่อให้ตอบโจทย์ทั้งความเร็วในการใช้งานจริงและความลึกของความรู้เชิงบริบท ระบบเน้นการผสาน CV ที่มีความไวและประหยัดทรัพยากรบนอุปกรณ์ AR กับ LLM ที่มีความสามารถสังเคราะห์สูงบนคลาวด์ พร้อมกลไกการซิงก์กับ CMMS เพื่อให้คำแนะนำเชิงปฏิบัติการที่ปลอดภัย แม่นยำ และสามารถวัดผลได้ — ซึ่งสอดคล้องกับเป้าหมายลดเวลาแก้เครื่องจักรลงจนถึง 50% ที่รายงานได้จากการทดลองใช้งานต้นแบบในไซต์งานจริง

การทำงานจริง: ยูสเคสและประสบการณ์ของช่างภาคสนาม

การทำงานจริง: ยูสเคสและประสบการณ์ของช่างภาคสนาม

ในการใช้งานจริง AR‑FieldCopilot ถูกออกแบบมาให้สอดคล้องกับพฤติกรรมการปฏิบัติงานของช่างภาคสนาม โดยเริ่มจากการส่องภาพเครื่องจักรด้วยอุปกรณ์ที่ช่างใช้อยู่แล้ว (AR glasses, rugged tablet หรือ smartphone) ระบบจะรันโมดูล computer vision แบบเรียลไทม์เพื่อค้นหาและเน้นตำแหน่งที่ผิดปกติด้วย bounding box และ heatmap บนหน้าจอหรือเลนส์แว่น เมื่อการตรวจจับพบจุดน่าสงสัย ข้อมูลภาพและเมตาดาต้าจะถูกส่งไปยัง LLM และชุดโมดูลวินิจฉัยเพื่อสรุปสาเหตุเป็นภาษาธรรมชาติ พร้อมแปลงเป็นคู่มือปฏิบัติแบบทีละขั้นตอน (step‑by‑step) ที่เหมาะกับสภาพหน้างาน

ตัวอย่าง workflow หน้างานที่ใช้บ่อยมีลักษณะเป็นลำดับชัดเจนดังนี้

- สแกน (Scan) — ช่างส่องบริเวณที่มีปัญหาด้วยกล้องของ AR glasses/แท็บเล็ต/สมาร์ทโฟน แอปจะทำการจับภาพต่อเนื่องและแสดง bounding box/heatmap บนชิ้นส่วนที่มีความผิดปกติ

- รับ diagnosis — ระบบ CV ระบุจุดและส่งภาพให้ LLM เพื่อสรุปสาเหตุเบื้องต้นเป็นภาษาธรรมชาติ เช่น "การรั่วของซีลบริเวณวาล์วเนื่องจากการสึกหรอ" พร้อมให้คะแนนความมั่นใจ (%) และลิงก์ไปยังหน้าอ้างอิงจาก OEM manual

- ทำตาม step‑by‑step — คู่มือที่สร้างโดย LLM จะถูกแสดงเป็นคำสั่งทีละขั้นตอน พร้อม AR overlay (ลูกศรชี้, annotation บนชิ้นส่วน) และ voice guidance เพื่อให้ช่างปฏิบัติตามได้โดยไม่ต้องละมือจากงาน

- บันทึกผล (Log & Review) — เมื่องานเสร็จ ช่างสามารถบันทึกวิดีโอการแก้ไข, ภาพก่อน‑หลัง และกรอกรายงานสั้น ๆ ระบบจะซิงก์ข้อมูลขึ้นคลาวด์ สร้าง audit trail และอัพเดตฐานความรู้ให้โมเดลเรียนรู้ต่อไป

ฟีเจอร์สำคัญที่ช่างภาคสนามให้ความเห็นว่าช่วยลดเวลาและความผิดพลาดได้มาก ได้แก่

- Overlay annotations — ข้อความและมาร์กเกอร์แบบเรียลไทม์ที่ติดบนภาพจริง ช่วยระบุค่าพารามิเตอร์หรือชิ้นส่วนที่ต้องถอดออก

- Voice guidance — คำสั่งเสียงแบบก้าวต่อก้าว (ภาษาไทยหรือภาษาอื่นตามการตั้งค่า) ทำให้ช่างไม่ต้องก้มมองหน้าจอบ่อย

- AR arrows & visual cues — ลูกศรและเส้นแนะนำมุมการขันหรือการวางชิ้นส่วน เพื่อลดความคลาดเคลื่อนจากการอ่านคู่มือแบบข้อความ

- Remote assist / real‑time expert call — เมื่อเกณฑ์ความมั่นใจต่ำกว่าที่กำหนด ช่างสามารถเริ่มวิดีโอคอลล์แบบ low‑latency กับผู้เชี่ยวชาญ พร้อมให้ผู้เชี่ยวชาญมาร์กอัปบนหน้าจอช่างได้ทันที

- OEM manual referencing — ระบบดึงข้อมูลจากคู่มือผู้ผลิต (OEM manual) เพื่อยืนยันขั้นตอนการถอดประกอบหรือค่าทอร์ค ช่วยให้คำแนะนำสอดคล้องกับมาตรฐาน

การนำไปใช้งานจริงพบผลลัพธ์เชิงปริมาณที่น่าสนใจ: ตามการทดสอบภาคสนามของลูกค้าในกลุ่มการผลิตและพลังงาน AR‑FieldCopilot ช่วยลดเวลาการวิเคราะห์และแก้ไขเฉลี่ยประมาณ 50% (ตัวอย่าง: เวลาซ่อมเฉลี่ยจาก 90 นาทีลดเหลือ 45 นาทีในไลน์ผลิตอาหาร) และช่วยเพิ่ม uptime ของเครื่องจักรเฉลี่ย 7–12% ภายใน 3 เดือนแรกของการใช้ โดยปัจจัยสำคัญคือการผสานกันของ CV ที่แม่นยำ, LLM ที่สรุปเป็นภาษาธรรมชาติ และฟีเจอร์ remote assist ที่ลดเวลาเดินทางของผู้เชี่ยวชาญ

ด้านการรองรับอุปกรณ์ ระบบถูกออกแบบให้ยืดหยุ่นกับสภาพหน้างาน:

- AR glasses — เหมาะสำหรับงานที่ต้องใช้มือทำงานต่อเนื่อง เช่น Microsoft HoloLens หรืออุปกรณ์ฟอร์มแฟคเตอร์คล้ายกัน ที่ให้มุมมองตรงและ hands‑free overlays

- Rugged tablet — เหมาะกับสภาพแวดล้อมที่ต้องการหน้าจอใหญ่และทนต่อฝุ่น/แรงกระแทก ให้การดูภาพรายละเอียดและการสั่งงานแบบสัมผัส

- Smartphone — ทางเลือกที่ประหยัดและเข้าถึงได้ง่ายสำหรับทีมที่ไม่มีอุปกรณ์ AR โดยรองรับทั้งการรัน CV บนเครื่องหรือใช้ edge/edge‑cloud สำหรับการประมวลผลหนัก

สรุปแล้ว ประสบการณ์ของช่างภาคสนามที่ใช้งาน AR‑FieldCopilot มักเป็นไปในแนวทางเดียวกันคือ เร็วขึ้น, แม่นยำขึ้น และมีการบันทึกเป็นระบบมากขึ้น ซึ่งช่วยให้ตัดสินใจเชิงปฏิบัติการได้ทันเวลา ลดการเรียกผู้เชี่ยวชาญออกนอกไซต์ และสร้างข้อมูลย้อนกลับ (feedback loop) สำหรับปรับปรุงโมเดลและคู่มือในอนาคต

ผลลัพธ์เชิงตัวเลข: ผลการทดลองภาคสนามและ KPI

สรุปตัวเลขสำคัญ (ภาพรวม)

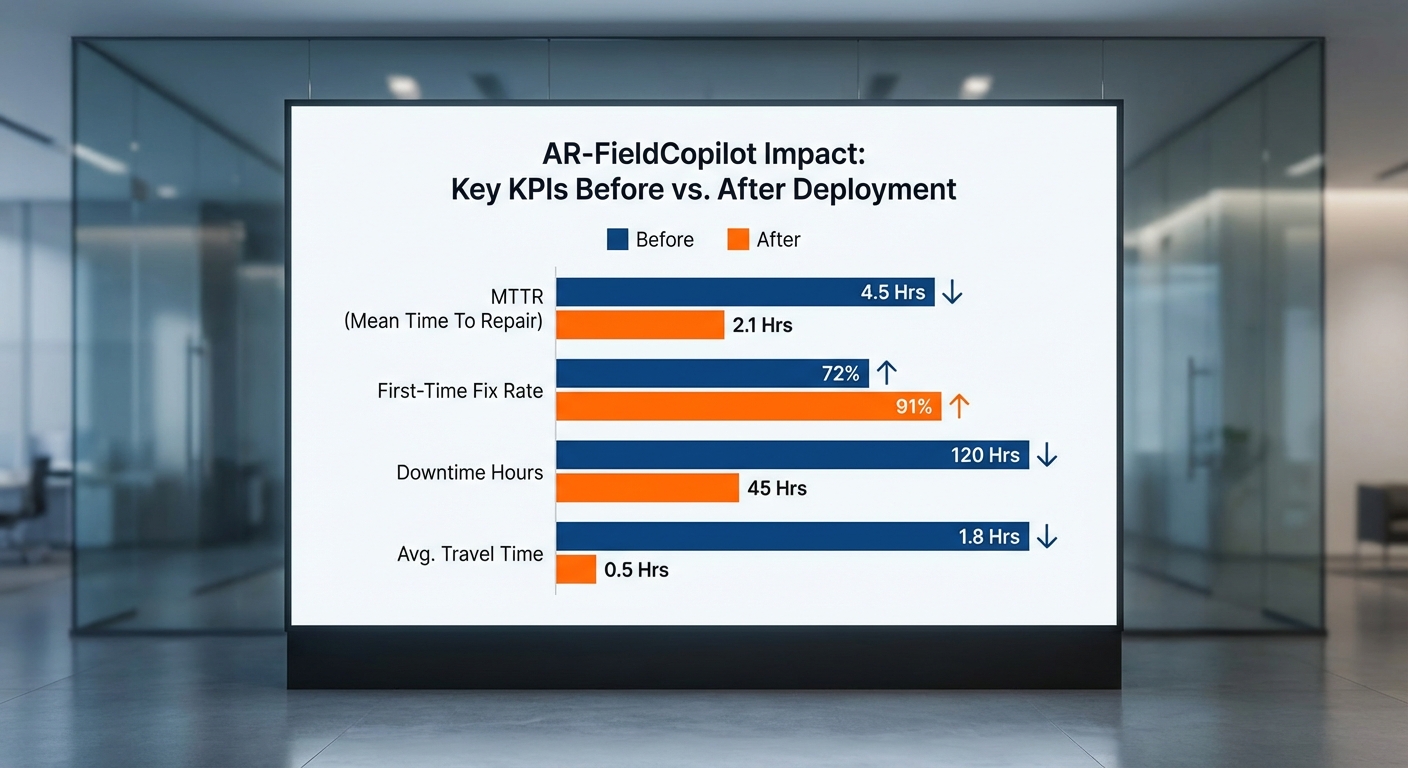

การทดลองภาคสนาม (pilot) ของระบบ AR‑FieldCopilot ดำเนินการเป็นเวลา 3 เดือน โดยเก็บข้อมูลจากการซ่อมแซมกว่า 400+ เคส (รวมทั้งสิ้น 420 เคส) ในโรงงานผลิต 3 แห่งที่ระบุเป็นแบบ anonymized ผลการวัดเชิงตัวเลขที่สำคัญสรุปได้ดังนี้:

- MTTR (Mean Time To Repair) ลดลงประมาณ 50% — จากค่าเฉลี่ยก่อนการทดลอง 3.2 ชั่วโมง/เคส เป็น 1.6 ชั่วโมง/เคส หลังนำ AR‑FieldCopilot มาใช้

- First‑time fix rate เพิ่มขึ้นจาก 62% เป็น 85%

- เวลาหยุดทำงานรวม (Total downtime) ลดลงประมาณ 50% — จากรวม ~1,344 ชั่วโมง เหลือ ~672 ชั่วโมง (ตามจำนวนเคส 420 เคส)

- ระยะเวลา pilot: 3 เดือน, จำนวนเคสทั้งหมด: 420 เคส

รายละเอียดผลการทดลองตามโรงงาน (anonymized)

การทดลองแบ่งข้อมูลตามโรงงาน 3 แห่ง ดังนี้ (ตัวเลขเป็นการสรุปเชิงสถิติจากเคสจริงใน pilot และทำให้เป็นแบบ anonymized เพื่อคงความลับทางการค้า):

- Factory A (อุตสาหกรรมชิ้นส่วนยานยนต์) — 180 เคส

- MTTR ก่อน: 3.8 ชั่วโมง/เคส → หลัง: 1.9 ชั่วโมง/เคส (ลด 50%)

- First‑time fix: จาก 58% → 84%

- Downtime รวมลดจาก ~684 ชั่วโมง → ~342 ชั่วโมง

- Factory B (อุตสาหกรรมอาหารและบรรจุภัณฑ์) — 140 เคส

- MTTR ก่อน: 2.6 ชั่วโมง/เคส → หลัง: 1.3 ชั่วโมง/เคส (ลด 50%)

- First‑time fix: จาก 66% → 86%

- Downtime รวมลดจาก ~364 ชั่วโมง → ~182 ชั่วโมง

- Factory C (อิเล็กทรอนิกส์) — 100 เคส

- MTTR ก่อน: 3.0 ชั่วโมง/เคส → หลัง: 1.5 ชั่วโมง/เคส (ลด 50%)

- First‑time fix: จาก 62% → 85%

- Downtime รวมลดจาก ~300 ชั่วโมง → ~150 ชั่วโมง

การวัดผล วิธีการเก็บข้อมูล และนิยาม KPI

วิธีการวัด — ข้อมูล KPI ถูกดึงจากหลายแหล่ง ได้แก่ บันทึกคำร้องซ่อมของระบบ CMMS ของโรงงาน, เวลาที่บันทึกโดย AR‑FieldCopilot (timestamp ของการเปิดเคส, เริ่มซ่อม, และปิดเคส), และการยืนยันผลจากหัวหน้าทีมซ่อมบำรุง ทีมวิเคราะห์ได้รวม logs ทั้งสองทางเพื่อลดความคลาดเคลื่อน

นิยาม KPI ที่ใช้:

- MTTR — เวลาตั้งแต่มีการแจ้งเหตุขัดข้องจนถึงเวลาที่เครื่องจักรกลับเข้าสู่สถานะผลิตได้ (รวมเวลารอชิ้นส่วนและการทดสอบหลังซ่อม หากเป็นการหยุดฉุกเฉิน)

- First‑time fix rate — สัดส่วนของเคสที่แก้ไขสำเร็จโดยช่างหน้างานเพียงครั้งเดียวโดยไม่ต้องเรียกทีมซ่อมเพิ่มเติมหรือเปลี่ยนเป็นการนัดหมายซ่อมใหม่

- Total downtime — ผลรวมชั่วโมงที่เครื่องจักรหยุดทำงานจากเหตุการณ์ที่ถูกนับใน pilot (ไม่นับ scheduled maintenance)

การเปรียบเทียบก่อน–หลังพิจารณาช่วงเวลาและประเภทความผิดปกติที่สอดคล้องกัน โดยทีมวิเคราะห์กรองเคสที่เป็น non‑representative เช่น เคสที่มีการเปลี่ยนอะไหล่ยาวนานจากซัพพลายเออร์ภายนอกซึ่งอยู่นอกขอบเขตของ AR‑FieldCopilot

การประเมิน ROI เบื้องต้นและข้อจำกัดตัวเลข

ประมาณการ ROI (ตัวอย่าง) — การคำนวณ ROI ในการทดลองนี้ใช้สมมติฐานแบบอนุรักษ์นิยม โดยตั้งสมมติฐานค่าเสียโอกาสจากการหยุดเครื่องระหว่างการผลิตเป็นช่วงกว้างขึ้นตามประเภทโรงงาน (ตัวอย่างสมมติ: THB 2,000–8,000 ต่อชั่วโมง ขึ้นกับมูลค่าการผลิต)

- ตัวอย่างการคำนวณ (สมมติค่าเสียโอกาสเฉลี่ย THB 5,000/ชั่วโมง): การลด downtime ประมาณ 672 ชั่วโมง → ประหยัดมูลค่าเชิงผลิต ~THB 3,360,000

- บวกการลดค่าใช้จ่ายจากการเดินทางของช่างและโอเวอร์ไทม์ (ประเมินเพิ่ม ~15–25% ของมูลค่าการหยุด) → เพิ่มการประหยัด ~THB 504,000–840,000

- หักต้นทุนการติดตั้ง pilot และค่าบริหารระบบ (สมมติ THB 600,000) → ผลตอบแทนเบื้องต้นในช่วงตัวอย่างนี้อยู่ในระดับ หลายร้อยเปอร์เซ็นต์ (ROI คำนวณแบบคร่าว ๆ ≈ (ประหยัดสุทธิ / ต้นทุน) ×100%)

ข้อจำกัดและข้อสังเกตสำคัญ — ตัวเลขที่รายงานมาจากการทดลองภาคสนามในสเกลขนาดเล็ก (420 เคส, 3 เดือน) และมีข้อจำกัดดังนี้:

- ผลลัพธ์อาจมีความผันแปรตามประเภทของความผิดปกติและความซับซ้อนของเครื่องจักรที่รวมอยู่ใน pilot

- โรงงานที่เข้าร่วมเป็นตัวแทนของกลุ่มอุตสาหกรรมเฉพาะ ซึ่งอาจไม่สะท้อนผลลัพธ์สำหรับโรงงานที่มีโปรแกรมการบำรุงรักษาแตกต่างหรือมีอะไหล่ในสต็อกต่ำ

- ตัวเลข ROI นั้นอ่อนไหวต่อสมมติฐานค่าเสียโอกาสต่อชั่วโมง และต้องมีการปรับพารามิเตอร์ตามบริบทของแต่ละโรงงานก่อนสรุปเชิงพาณิชย์

- ปัจจัยภายนอก เช่น คุณภาพเครือข่าย, ประสบการณ์ของช่างผู้ใช้ AR, และความพร้อมของข้อมูลเครื่องจักร มีผลต่อการใช้งานจริงและประสิทธิภาพ

โดยสรุป การทดลองภาคสนามแสดงสัญญาณเชิงบวกที่ชัดเจน: MTTR ลดลงประมาณ 50% และ first‑time fix เพิ่มขึ้นอย่างมีนัยสำคัญ (จาก 62% เป็น 85%) ซึ่งบ่งชี้ว่า AR‑FieldCopilot สามารถยกระดับประสิทธิภาพการซ่อมบำรุงภาคสนามได้อย่างมีนัยสำคัญ แต่การขยายผลสู่การใช้งานจริงในวงกว้างจำเป็นต้องมีการทดลองในช่วงเวลาที่ยาวขึ้น ครอบคลุมโรงงานหลายกลุ่มอุตสาหกรรม และการตรวจสอบสมมติฐานค่าใช้จ่าย/ผลประโยชน์อย่างละเอียดก่อนสรุป ROI เชิงกลยุทธ์

การติดตั้ง การผสานระบบ และความเข้ากันได้กับสภาพแวดล้อมโรงงาน

การติดตั้ง: โหมด Edge + Cloud และ Full‑Cloud

AR‑FieldCopilot รองรับการติดตั้งทั้งในรูปแบบ edge device + cloud sync และ full cloud mode เพื่อสอดคล้องกับข้อจำกัดด้านความปลอดภัย ประสิทธิภาพเครือข่าย และนโยบายไอทีของโรงงาน โดยทั่วไประบบจะแนะนำให้ใช้สถาปัตยกรรมแบบไฮบริด (edge + cloud) สำหรับงานภาคสนามที่ต้องการการตอบสนองแบบเรียลไทม์ เช่น การส่องภาพและวินิจฉัยความผิดปกติของเครื่องจักรที่ต้องการ latency ต่ำ (<50 ms ในระดับการโต้ตอบของ AR) และความทนทานต่อการเชื่อมต่อที่ไม่เสถียร

ตัวอย่างการจัดวางฮาร์ดแวร์ประกอบด้วย: อุปกรณ์ edge (เช่น industrial PC/GPU หรือแพลตฟอร์ม edge AI เช่น NVIDIA Jetson), อุปกรณ์สวมใส่ AR (HMD/AR glasses หรือ rugged tablets), และเซิร์ฟเวอร์ cloud สำหรับการซิงก์ข้อมูล การฝึกโมเดล และเก็บประวัติการบำรุงรักษา ในโหมด full‑cloud ระบบจะใช้การประมวลผลภาพและ LLM บนคลาวด์ทั้งหมด เหมาะเมื่อเครือข่ายมี latency ต่ำและนโยบายอนุญาตให้ข้อมูลภาพออกนอกไซต์ได้

ข้อพิจารณาด้านการตัดสินใจ: หากมีข้อกำหนดด้านความปลอดภัยหรือข้อจำกัดทางกฎหมายที่ห้ามส่งภาพไปนอกหน่วยงาน ควรเลือก deployment แบบ on‑premise/edge‑first เพื่อให้ข้อมูลเชิงภาพและโมเดลเรียลไทม์ถูกประมวลผลในเครือข่ายภายใน อีกทั้งการออกแบบฮาร์ดแวร์ควรคำนึงถึงสภาพแวดล้อมโรงงาน (อุณหภูมิ ฝุ่น ความสั่นสะเทือน) และการรับรองมาตรฐานอุตสาหกรรม

การผสานกับ CMMS/ERP, API และมาตรฐานอุตสาหกรรม

การรวม AR‑FieldCopilot เข้ากับระบบจัดการการบำรุงรักษา (CMMS) และระบบ ERP เป็นหัวใจสำคัญในการสร้าง workflow อัตโนมัติและข้อมูลเชิงบริบทสำหรับช่างภาคสนาม ระบบรองรับแพทเทิร์นการเชื่อมต่อหลากหลายรูปแบบ ได้แก่ RESTful APIs, WebHooks, และ WebSocket สำหรับการอัปเดตแบบเรียลไทม์

- OPC UA: สำหรับการสื่อสารกับ PLC และอุปกรณ์อุตสาหกรรมในระดับโรงงาน เพื่อดึง telemetries และสถานะเครื่องจักรแบบมาตรฐาน

- MQTT: เหมาะสำหรับงาน telemetry ที่ต้องการความเบาและการส่งข้อมูลต่อเนื่องจากอุปกรณ์ IoT ในสายการผลิต

- Data mapping: ระบบมีตัวช่วยสร้าง adapter เพื่อแมปฟิลด์สำคัญ (เช่น หมายเลขชิ้นส่วน, รหัสงานซ่อม, SLAs) ระหว่าง AR‑FieldCopilot กับ CMMS/ERP (เช่น SAP, Oracle, IBM Maximo) โดยรองรับ payload ในรูปแบบ JSON/REST

- Eventing & Triggers: เมื่อ AR ระบบตรวจพบปัญหาแล้ว สามารถสร้าง Work Order อัตโนมัติใน CMMS, แนบรูปภาพ/วิดีโอ และให้คำแนะนำทีละขั้นตอน พร้อมบันทึกการดำเนินการเป็นประวัติ

การเชื่อมต่อควรออกแบบให้มีชั้นความปลอดภัย เช่น การยืนยันตัวตนด้วย OAuth2, mutual TLS, และการเข้ารหัสข้อมูลทั้งขณะส่งและขณะเก็บ เพื่อให้สอดคล้องกับนโยบายความปลอดภัยขององค์กรและมาตรฐานความเป็นส่วนตัวของข้อมูล

ข้อกำหนดเครือข่าย: Latency, Bandwidth และ Offline Mode

สำหรับการใช้งาน AR และ Computer‑Vision ในสนาม ควรพิจารณาค่าเครือข่ายเชิงปริมาณดังนี้เป็นแนวทาง:

- Latency: สำหรับการสตรีมวิดีโอแบบสองทางและการตอบโต้ AR ควรมี latency end‑to‑end ต่ำกว่า 50–100 ms หากใช้การประมวลผลบนคลาวด์ แต่หากใช้ edge inference สามารถยอมรับ latency สูงขึ้นเล็กน้อยสำหรับการซิงก์ข้อมูลหลังการทำงาน

- Bandwidth: สตรีมวิดีโอความละเอียด 720p ที่บีบอัดจะต้องการประมาณ 1.5–4 Mbps ต่อสตรีม ขณะที่ 1080p อาจต้อง 4–10 Mbps ขึ้นอยู่กับ codec และอัตราเฟรม การออกแบบระบบจึงควรรองรับการสตรีมหลายจุดพร้อมกันและควบคุมคุณภาพโดยอัตโนมัติ

- Offline & Sync: ในพื้นที่ที่เครือข่ายไม่เสถียร ระบบต้องสามารถทำงานแบบ offline-first โดยให้ edge device บันทึกเหตุการณ์ วิเคราะห์พื้นฐาน และซิงก์ metadata รูปภาพและ log กลับสู่ cloud เมื่อเครือข่ายพร้อม

การดูแลรักษาและการบริหารหลังติดตั้ง

การดูแลรักษาระบบ AR‑FieldCopilot แบ่งเป็นสองมิติหลัก: ซอฟต์แวร์และโมเดล และ ฮาร์ดแวร์. แนวปฏิบัติแนะนำได้แก่:

- ตั้งกลไก OTA updates สำหรับการอัปเดตแอปพลิเคชันและเวอร์ชันโมเดล พร้อมระบบ rollback หากเกิดปัญหา

- มีการ monitoring & logging แบบเรียลไทม์ (performance metrics, error rates, network stats) และตั้ง alert ตาม SLA ที่ตกลงไว้

- วางแผนสำหรับการ retrain โมเดล CV เป็นระยะ (เช่น ทุก 3–6 เดือน) โดยใช้ข้อมูลจริงที่ฉลากจากภาคสนามเพื่อรักษาความแม่นยำ

- ฮาร์ดแวร์ควรมีสัญญาบริการ (SLA) สำหรับการเปลี่ยนชิ้นส่วนที่เสียหาย และสต็อกอะไหล่สำหรับอุปกรณ์สวมใส่ที่สำคัญ

การฝึกอบรมช่างและการจัดการการเปลี่ยนแปลง (Change Management)

การนำ AR‑FieldCopilot เข้าสู่สภาพแวดล้อมโรงงานต้องมีแผนการฝึกอบรมและการเปลี่ยนแปลงกระบวนการที่เป็นระบบ ประกอบด้วยขั้นตอนสำคัญดังนี้:

- Pilot Phase: เริ่มด้วยกลุ่มช่างเป้าหมาย 5–10 คน ในระยะเวลา 4–8 สัปดาห์ เพื่อตรวจสอบ usability และวัด KPI เช่น เวลารับงาน, เวลาปิดงาน และอัตราความสำเร็จครั้งแรก (first‑time fix rate)

- Train‑the‑Trainer: ฝึกอบรมผู้เชี่ยวชาญภายใน (super users) เพื่อให้สามารถขยายการใช้งานได้เป็นวงกว้าง ลดภาระผู้ขายและสร้างความยั่งยืน

- เนื้อหาการฝึกอบรม: ครอบคลุมการใช้งาน AR device, การอ่านผลวินิจฉัย, การสร้าง/ปิด Work Order ใน CMMS, แนวทางความปลอดภัย และการใช้ฟีเจอร์ offline

- Change Management: ดำเนินการสื่อสารเชิงกลยุทธ์ ประเมินผลกระทบต่อบทบาทงาน ปรับ SOP และ KPI ให้สอดคล้อง และมีแผนจูงใจ (เช่น รางวัลตาม KPI หรือการลดเวลาเดินทาง) เพื่อสร้างการยอมรับ

- Feedback Loop: ตั้งช่องทางรับข้อเสนอแนะจากช่างอย่างสม่ำเสมอสำหรับการปรับปรุง UI, checklist และโมเดล AI โดยการอัปเดตที่ต่อเนื่องควรกำหนดเป็นรอบ (sprint) ชัดเจน

สรุปแล้ว การปรับใช้ AR‑FieldCopilot อย่างประสบความสำเร็จต้องผสานการออกแบบด้านฮาร์ดแวร์และซอฟต์แวร์ที่ยืดหยุ่น เข้ากับมาตรฐานอุตสาหกรรม (เช่น OPC UA, MQTT) และกระบวนการเปลี่ยนแปลงภายในองค์กรที่เน้นการฝึกอบรมเชิงปฏิบัติจริง โดยมีการวัดผลด้วย KPI ที่ชัดเจน เช่น การลดเวลาแก้ไขเครื่องจักร 50% ตามการทดลองภาคสนาม และการคืนทุนภายในกรอบเวลาที่องค์กรยอมรับได้

ธุรกิจ โมเดลรายได้ ตลาดเป้าหมาย และโอกาสเชิงพาณิชย์

ธุรกิจ โมเดลรายได้ ตลาดเป้าหมาย และโอกาสเชิงพาณิชย์

สตาร์ทอัพที่นำเสนอ AR‑FieldCopilot ควรออกแบบโมเดลธุรกิจให้ยืดหยุ่นและผสมผสานกันระหว่าง Subscription (SaaS), Per‑device licensing และ Managed services / Revenue‑share เพื่อรองรับความต้องการที่แตกต่างของลูกค้าอุตสาหกรรม โมเดล Subscription เหมาะสำหรับลูกค้าองค์กรที่ต้องการใช้งานซอฟต์แวร์ต่อเนื่อง โดยกำหนดราคาตามจำนวนผู้ใช้งานหรือจำนวนไซต์ (เช่น แพ็กเกจ Basic 3,000–10,000 บาท/ไซต์/เดือน, Enterprise 30,000++ บาท/เดือน) ขณะที่ Per‑device licensing จะคิดค่าลิขสิทธิ์ตามอุปกรณ์ AR/Tablet/Edge device (เช่น 300–1,500 บาท/อุปกรณ์/เดือน) เพื่อรองรับการใช้งานที่แพร่หลายบนไซต์งานหลายแห่ง

ในเชิงพาณิชย์ การให้บริการแบบ Managed Services หรือ revenue‑share กับผู้ให้บริการบำรุงรักษา (maintenance contractors) และ OEM จะช่วยเปิดช่องทางรายได้ใหม่ เช่น คิดค่าบริการแบบ pay‑per‑incident, คิดเป็นสัดส่วนจากการลดเวลาหยุดทำงาน (performance‑based fee) หรือคิดค่าบริการแบบ Outsourced Field Support ซึ่งรวมการฝึกอบรม สัญญาการให้บริการ (SLA) และการวิเคราะห์ข้อมูลเชิงลึก ตัวอย่างรูปแบบราคาที่ใช้งานได้จริงคือ: ค่าเริ่มต้นติดตั้ง (one‑time implementation fee) 200,000–1,000,000 บาท ขึ้นกับการเชื่อมต่อระบบ ERP/CMMS และค่าบริการรายเดือนสำหรับ support/analysis 50,000–300,000 บาท/เดือนสำหรับลูกค้าองค์กรขนาดกลางถึงใหญ่

ประเมินขนาดตลาด (TAM) ในภูมิภาค: ตลาดบริการ digitalization สำหรับงาน field‑service และ Industry 4.0 ในภูมิภาคอาเซียนมีแนวโน้มเติบโตต่อเนื่องจากการลงทุนในภาคการผลิตและโครงสร้างพื้นฐานดิจิทัล หลายรายงานอุตสาหกรรมชี้ว่าโครงการ Industry 4.0 และการแปลงสู่ดิจิทัลในภาคการผลิตมีอัตราการเติบโต (CAGR) ประมาณ 10–20% ต่อปีในภูมิภาค APAC หากใช้สมมติฐานเชิงอนุรักษ์ว่าในประเทศไทยมี 3,000–6,000 โรงงานระดับกลางถึงใหญ่ที่สามารถเป็นลูกค้าเป้าหมาย และสมมติค่าใช้จ่ายด้านซอฟต์แวร์และบริการดิจิทัลต่อโรงงานอยู่ที่ 10,000–50,000 USD/ปี จะได้ TAM ประมาณ 50–300 ล้าน USD สำหรับไทย ขยายไปยังภูมิภาค SEA (รวมอินโดนีเซีย เวียดนาม มาเลเซีย ฟิลิปปินส์ ฯลฯ) ซึ่งมีจำนวนโรงงานและโครงสร้างพื้นฐานที่ใหญ่กว่า อาจขยายเป็น 0.5–2+ พันล้าน USD ภายในระยะเวลา 3–5 ปี ขึ้นกับอัตราการยอมรับเทคโนโลยีและการลงทุนของ OEM

โอกาสจับคู่กับ OEM และผู้ให้บริการบำรุงรักษามีความสำคัญเชิงกลยุทธ์ เพราะ AR‑FieldCopilot สามารถเป็นส่วนหนึ่งของข้อเสนอหลังการขาย (after‑sales) และบริการเสริม (value‑added service) ให้กับผู้ผลิตเครื่องจักร การร่วมมือกับ OEM สามารถเปิดทางสำหรับการสัญญาแบบระยะยาว (embedded service contracts), การขายแบบ bundle (hardware + software + support) และการใช้ช่องทางจำหน่ายของ OEM ในการเข้าถึงลูกค้าระดับ enterprise นอกจากนี้ ผู้ให้บริการบำรุงรักษา (service integrators) สามารถใช้โมเดล revenue‑share หรือ white‑label เพื่อให้บริการแก่ลูกค้าที่มีฐานอยู่เดิม โดยแบ่งรายได้จากสัญญา SLA และค่าบริการตามผลลัพธ์การลด downtime

- กลยุทธ์การขยายตลาด (Pilot → Enterprise rollout): เริ่มจากโครงการนำร่อง (pilot) กับลูกค้า 1–3 ไซต์เพื่อพิสูจน์ ROI (เช่น ลดเวลาแก้ปัญหา 30–50% ตามตัวอย่าง), เก็บข้อมูลกรณีศึกษา และสร้าง playbook สำหรับการขยายไปยังหน่วยธุรกิจอื่นของลูกค้าเดียวกัน (land‑and‑expand)

- พันธมิตรเชิงกลยุทธ์: ผนึก OEM, system integrators, CMMS/ERP vendors และผู้จำหน่ายอุปกรณ์ AR เพื่อการรวมระบบและการขายร่วม (co‑selling) รวมถึงใช้ช่องทางตัวแทนจำหน่ายในภูมิภาค

- โมเดลราคาเชิงยืดหยุ่น: เสนอแพ็กเกจทดลองฟรี/ต่ำสุด (pilot pricing), subscription แบบ tiered, per‑device pricing สำหรับลูกค้าขนาดเล็ก และ managed services / performance contracts สำหรับลูกค้า enterprise

- การปรับท้องถิ่นและการส่งออก: localization ของภาษา คู่มือมาตรฐานอุตสาหกรรม และการปฏิบัติตามข้อกำหนดในแต่ละประเทศเป็นหัวใจสำคัญสำหรับการออกสู่ตลาด SEA พร้อมใช้พันธมิตรท้องถิ่นเพื่อลดความเสี่ยง

สรุปได้ว่า AR‑FieldCopilot มีศักยภาพเชิงพาณิชย์สูง หากผสมผสานโมเดลรายได้ที่หลากหลาย สร้างกรณีธุรกิจที่ชัดเจนผ่านโครงการนำร่อง และใช้เครือข่ายพันธมิตร OEM/Integrator เพื่อเร่งการยอมรับในตลาด ไทยและภูมิภาค SEA เสนอ TAM ที่น่าสนใจในช่วงหลายร้อยล้านจนถึงพันล้านดอลลาร์ ขึ้นกับความสามารถในการขยายเชิงพาณิชย์ การรับประกันผลงาน (proof‑of‑value) และการรวมระบบเข้ากับ workflow ของลูกค้าอุตสาหกรรม

ความเสี่ยง ประเด็นความเป็นส่วนตัว และแนวทางป้องกัน

ความเสี่ยง ประเด็นความเป็นส่วนตัว และแนวทางป้องกัน

การนำระบบ AR‑FieldCopilot มาใช้ในสภาพแวดล้อมการผลิตและภาคสนาม แม้จะช่วยลดเวลาการแก้ไขเครื่องจักรได้มากถึง 50% แต่ย่อมมาพร้อมกับความเสี่ยงด้านความเป็นส่วนตัว ความลับทางเทคนิค (IP) และความปลอดภัยของอุปกรณ์ที่ไม่อาจมองข้ามได้ โดยความเสี่ยงหลักประกอบด้วยการรั่วไหลของภาพและข้อมูลโรงงานซึ่งอาจเผยโครงสร้างการผลิต วัตถุดิบ และการออกแบบชิ้นส่วนที่ถือเป็นทรัพย์สินทางปัญญา นอกจากนี้การพึ่งพา Large Language Models (LLMs) เพื่อสร้างคำแนะนำในการแก้ไขยังเสี่ยงต่อ hallucination หรือการให้คำตอบที่ไม่ถูกต้อง ซึ่งหากนำไปปฏิบัติจริงอาจก่อความเสียหายต่อเครื่องจักรหรือกระบวนการผลิตได้ และอุปกรณ์ AR เองยังเป็นเป้าหมายของการโจมตีทางไซเบอร์ เช่น การแฮ็กเพื่อเปลี่ยนคำแนะนำ, การสอดแนมภาพแบบเรียลไทม์ หรือการฝังมัลแวร์ในเฟิร์มแวร์

ความเสี่ยงด้านข้อมูลภาพและทรัพย์สินทางปัญญา (IP) — ภาพและวิดีโอจากกล้อง AR อาจบันทึกข้อมูลที่มีความลับของโรงงาน เช่น แบบแม่พิมพ์ การจัดวางเครื่องจักร หรือการตั้งค่าพารามิเตอร์เฉพาะของกระบวนการ หากส่งภาพดิบไปยังคลาวด์โดยไม่ปกป้องอย่างเพียงพอ อาจเกิดการรั่วไหลหรือถูกเข้าถึงโดยบุคคลที่ไม่ได้รับอนุญาต รายงานต้นทุนของการละเมิดข้อมูล (เช่น รายงานด้านความปลอดภัยปีล่าสุด) ชี้ว่าการรั่วไหลของข้อมูลธุรกิจอุตสาหกรรมอาจมีค่าใช้จ่ายเป็นหลักล้านดอลลาร์ต่อเหตุการณ์ จึงจำเป็นต้องวางมาตรการเข้มงวด

- แนวทางเข้ารหัสและควบคุมการเข้าถึง — ใช้การเชื่อมต่อที่เข้ารหัสแบบ TLS 1.3 สำหรับส่งข้อมูลระหว่างอุปกรณ์กับเซิร์ฟเวอร์, end‑to‑end encryption เมื่อเป็นไปได้, การเข้ารหัสข้อมูลขณะพัก (encrypt‑at‑rest) ด้วยการจัดการคีย์แบบศูนย์กลาง (KMS/HSM) และการใช้คีย์เฉพาะอุปกรณ์เพื่อจำกัดการเปิดอ่านข้อมูลหากคีย์ถูกขโมย

- ลดการส่งภาพดิบโดยใช้ edge inference — ย้ายโมดูลวิเคราะห์ภาพ (CV) ไปทำงานบนอุปกรณ์หรืออุปกรณ์ขอบเครือข่าย (edge) เพื่อลดปริมาณภาพดิบที่ต้องส่งขึ้นคลาวด์ ส่งเฉพาะ metadata, feature vectors หรือภาพที่ถูกเบลอ/ลบข้อมูลสำคัญ (redaction) เท่านั้น ซึ่งช่วยลดพื้นผิวการโจมตีและปัญหาความเป็นส่วนตัว

- เทคนิคการปิดบังข้อมูล (anonymization/redaction) — ออกแบบ pipeline ให้สามารถเบลอฉลาก หมายเลขซีเรียล หรือส่วนที่เป็นเอกลักษณ์ของชิ้นส่วนโดยอัตโนมัติก่อนส่งข้อมูล เพื่อป้องกันการเปิดเผย IP

ปัญหา LLM hallucination และแนวทางลดความเสี่ยง — LLM อาจสร้างคำตอบที่ฟังดูมีความมั่นใจแต่ผิดพลาดได้ โดยเฉพาะเมื่อเผชิญบริบทเชิงเทคนิคเฉพาะทางหรือข้อมูลภาคสนามที่ไม่คุ้นเคย การปฏิบัติตามคำแนะนำจาก LLM โดยปราศจากการตรวจสอบอาจนำไปสู่ความเสียหายต่อเครื่องจักรหรือความเสี่ยงด้านความปลอดภัยของพนักงาน

- Human‑in‑the‑loop verification — กำหนดให้คำแนะนำเชิงปฏิบัติการต้องผ่านการยืนยันโดยช่างผู้เชี่ยวชาญก่อนลงมือทำสำหรับงานที่มีความเสี่ยงสูง หรือให้ผู้ใช้งานปฏิบัติตามขั้นตอนภายใต้การตรวจสอบและเซ็นรับรอง

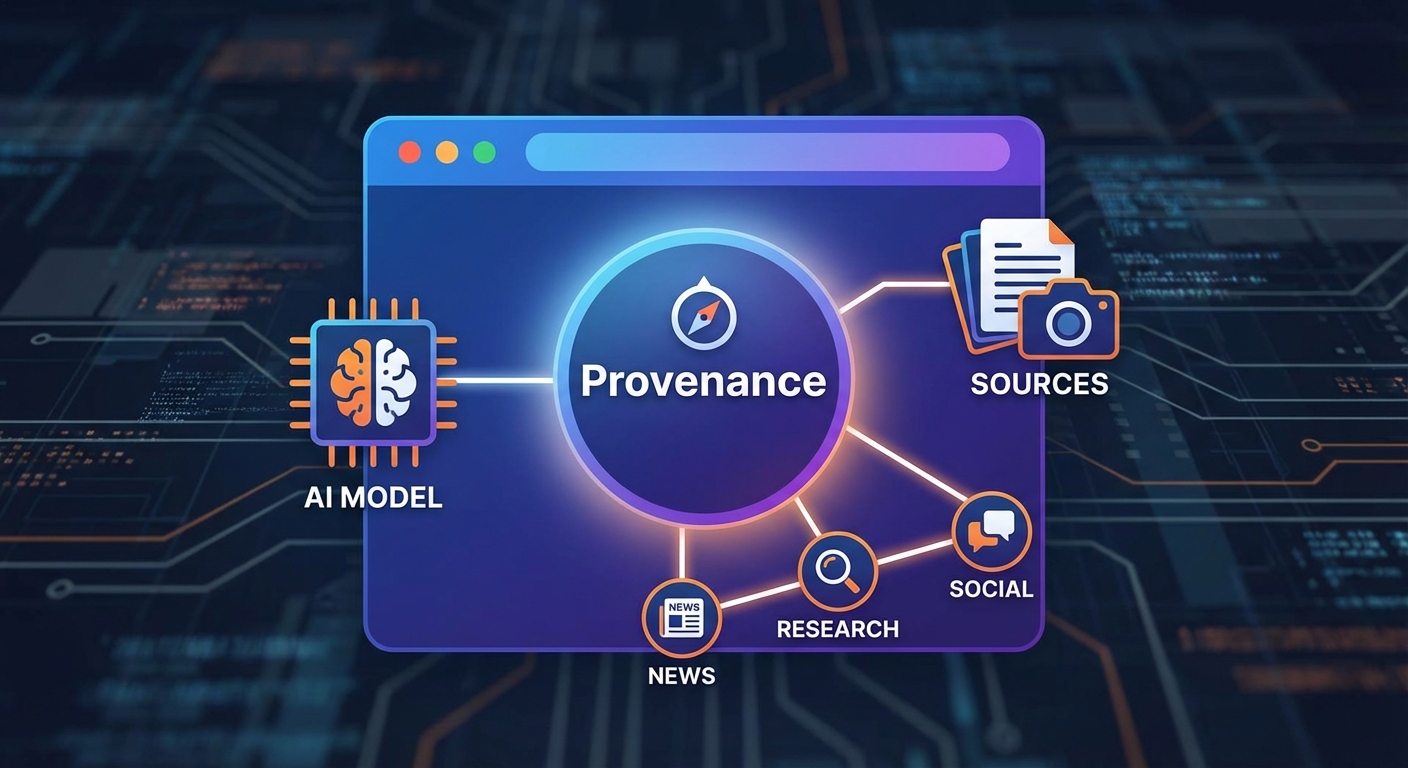

- Constrained prompts และ RAG (retrieval‑augmented generation) — จำกัดขอบเขตคำถามที่ส่งให้ LLM, ใช้เทมเพลตคำสั่งที่ควบคุมได้ และผสานฐานความรู้ที่ผ่านการรับรอง (เช่น แนวปฏิบัติของผู้ผลิต, คู่มือเทคนิค) เพื่อให้โมเดลอ้างอิงแหล่งข้อมูลที่ตรวจสอบได้ แทนการตอบจากความทรงจำของโมเดลเพียงอย่างเดียว

- แสดงความมั่นใจและ provenance — ให้ระบบแสดงคะแนนความเชื่อมั่น (confidence) แหล่งอ้างอิง และบันทึก prompt‑response เพื่อให้สามารถย้อนกลับเพื่อตรวจสอบเมื่อเกิดปัญหา

ความปลอดภัยของอุปกรณ์ AR และการบริหารจัดการ — อุปกรณ์ AR ที่เชื่อมต่ออินเทอร์เน็ตเป็นอีกหนึ่งจุดอ่อนที่อาจถูกโจมตีเพื่อเข้าถึงข้อมูลหรือเปลี่ยนแปลงพฤติกรรมการแสดงผล ควรออกแบบนโยบายบริหารอุปกรณ์อย่างเข้มงวดทั้งในด้านเฟิร์มแวร์ ซอฟต์แวร์ และการจัดการสิทธิ์การใช้งาน

- Patching และ Secure Boot — บังคับใช้นโยบายอัปเดตเฟิร์มแวร์และซอฟต์แวร์อย่างสม่ำเสมอ, ใช้การบูตแบบปลอดภัย (secure boot) และอิมเมจที่ลงนามดิจิทัลเพื่อป้องกันการรันโค้ดที่ไม่ได้รับอนุญาต

- การจัดการสิทธิ์และอุปกรณ์ (MDM/Endpoint management) — ใช้ระบบจัดการอุปกรณ์เคลื่อนที่ (MDM) เพื่อควบคุมสิทธิ์การเข้าถึง, เปิด/ปิดคุณสมบัติของฮาร์ดแวร์, การล็อกและลบข้อมูลระยะไกลกรณีสูญหาย และบังคับใช้นโยบายรหัสผ่านหรือ MFA

- การป้องกันเฟิร์มแวร์และความสมบูรณ์ของซอฟต์แวร์ — ลงนามเฟิร์มแวร์, ตรวจสอบความสมบูรณ์ของไฟล์รันไทม์, ใช้ Trusted Execution Environments (TEE) หรือ TPM สำหรับจัดเก็บคีย์และการตรวจสอบ

การตรวจสอบ การบันทึก และการปฏิบัติตามกฎระเบียบ — ทุกกิจกรรมที่เกี่ยวข้องกับการประมวลผลภาพ คำสั่ง LLM และการแก้ไขเชิงปฏิบัติการควรมีการบันทึกอย่างโปร่งใสและตรวจสอบได้ เพื่อนำไปสู่การติดตามเหตุการณ์ การวิเคราะห์สาเหตุ และการปฏิบัติตามข้อกำหนดทางกฎหมาย

- Auditing / Logging — จัดเก็บบันทึกการเข้าถึงภาพ ข้อความ prompt‑response ของ LLM และการอนุมัติของผู้เชี่ยวชาญในรูปแบบที่ปลอดภัยและไม่สามารถแก้ไขย้อนหลังได้ (immutable logs) เพื่อใช้ในการสอบสวนและปรับปรุงระบบ

- การทดสอบความปลอดภัยเชิงรุก — ดำเนิน penetration testing และ red‑team exercises ทั้งในระดับแอปพลิเคชัน อุปกรณ์ และโมเดล เพื่อค้นหาช่องโหว่ก่อนเกิดเหตุจริง

- การปฏิบัติตามมาตรฐานและข้อกฎหมาย — รับรอง compliance กับมาตรฐานที่เกี่ยวข้อง เช่น ISO 27001, NIST CSF, มาตรฐานอุตสาหกรรมเช่น IEC/ISA 62443 สำหรับระบบควบคุมอุตสาหกรรม รวมถึงกฎหมายคุ้มครองข้อมูลส่วนบุคคล (เช่น PDPA ของไทย หรือ GDPR หากเกี่ยวข้องกับสหภาพยุโรป) และระบุข้อกำหนดด้าน data residency และ retention ในสัญญา SLA กับลูกค้า

สรุปแผนปฏิบัติการที่ควรดำเนินการคือ: (1) ปรับสถาปัตยกรรมให้รองรับการประมวลผลที่ edge และการส่งข้อมูลที่ผ่านการเปลี่ยนรูปเพื่อปกป้อง IP, (2) ใช้มาตรการเข้ารหัสและการจัดการคีย์ที่เข้มงวด, (3) บังคับกระบวนการ human‑in‑the‑loop สำหรับงานวิธีปฏิบัติที่มีความเสี่ยงสูง และ (4) เสริมความปลอดภัยของอุปกรณ์ด้วย secure boot, signed firmware และ MDM พร้อมการบันทึกและตรวจสอบแบบต่อเนื่อง ทั้งหมดนี้ควรบูรณาการเข้ากับกรอบการปฏิบัติตามข้อกฎหมายและมาตรฐานอุตสาหกรรมเพื่อสร้างความมั่นใจให้ทั้งผู้ประกอบการและลูกค้า

บทสรุป

AR‑FieldCopilot เป็นตัวอย่างที่ชัดเจนของการผสานเทคโนโลยี AR, Computer‑Vision และ LLM เพื่อยกระดับการทำงานภาคสนาม โดยระบบช่วยให้ช่างสามารถส่องภาพอุปกรณ์แบบเรียลไทม์ รับการวินิจฉัยอัตโนมัติ และได้รับคู่มือแก้ปัญหาเป็นขั้นตอนทันที ส่งผลให้ ลดเวลาแก้เครื่องจักร (MTTR) ได้ถึง 50% ในการทดสอบเบื้องต้นและเพิ่มอัตรา first‑time fix อย่างมีนัยสำคัญ ซึ่งหากยืนยันผลในสเกลการใช้งานจริง เทคโนโลยีนี้มีศักยภาพที่จะเปลี่ยนมาตรฐานการบำรุงรักษาในอุตสาหกรรม เช่น การผลิต พลังงาน และโลจิสติกส์ โดยช่วยลดเวลาหยุดทำงานและต้นทุนการซ่อมบำรุงผ่านการให้ข้อมูลเชิงภาพและคำแนะนำเชิงปฏิบัติการทันที

แม้ผลลัพธ์เบื้องต้นจะน่าสนใจ แต่ต้องพิจารณาประเด็นด้านความปลอดภัย ข้อจำกัดของตัวอย่างการทดลอง และแผนการขยายเชิงพาณิชย์ก่อนนำไปใช้ในวงกว้าง: ต้องทดสอบความถูกต้องของการวินิจฉัยภายใต้สภาพแวดล้อมจริง, ประเมินความเสี่ยงจากข้อผิดพลาดของโมเดล, ดูแลความเป็นส่วนตัวของข้อมูลภาพภาคสนาม, แก้ปัญหาความเชื่อมต่อและความหน่วง รวมถึงวางโมเดลธุรกิจและแนวทางรับผิดชอบด้านกฎหมาย (liability) และการผสานกับระบบ CMMS/ERP ที่มีอยู่ แนะนำให้เดินหน้าด้วยการทดลองแบบมีการควบคุม (pilot) ในหลายไซต์ กำหนด KPI ชัดเจน (เช่น MTTR, first‑time fix rate, อัตราการแจ้งเตือนผิดพลาด) และมีแผนสำหรับการรับรองความปลอดภัยและการฝึกอบรมบุคลากรก่อนการขยายเชิงพาณิชย์อย่างเป็นระบบ