ในทศวรรษที่เทคโนโลยีปัญญาประดิษฐ์ (AI) ก้าวสู่การใช้งานเชิงพาณิชย์อย่างรวดเร็ว OpenAI กลายเป็นหนึ่งในผู้ขับเคลื่อนสำคัญที่เปลี่ยนโฉมวิธีการทำงาน สื่อสาร และสร้างสรรค์ทั่วโลก จากผลิตภัณฑ์เด่นอย่าง ChatGPT, DALL·E, Codex และ Whisper ที่ส่งผลให้การเข้าถึงความสามารถของโมเดลภาษาขนาดใหญ่เป็นไปอย่างแพร่หลาย — ตัวอย่างเช่น ChatGPT มียอดผู้ใช้งานแตะหลักสิบล้านภายในเวลาไม่กี่เดือนหลังเปิดตัว ขณะที่งานศึกษาต่าง ๆ ประเมินว่า AI อาจเพิ่มมูลค่าให้กับเศรษฐกิจโลกได้อีกหลายล้านล้านดอลลาร์ภายในทศวรรษหน้า ความเปลี่ยนแปลงนี้ไม่เพียงแต่เป็นเรื่องของเทคโนโลยี แต่ยังยกระดับข้อถกเถียงเชิงนโยบาย จริยธรรม และผลกระทบทางสังคมที่หน่วยงานภาครัฐและภาคธุรกิจต้องตอบรับอย่างจริงจัง

บทความนี้จะพาไปวิเคราะห์ภาพรวมการใช้งาน AI ของ OpenAI ด้วยมุมมองเชิงลึก ครอบคลุมทั้งผลิตภัณฑ์หลักและเทคโนโลยีเบื้องหลัง (เช่น สถาปัตยกรรมโมเดลภาษาขนาดใหญ่ การเรียนรู้จากตัวอย่าง และการประมวลผลหลายโหมด) ประเมินผลกระทบทางเศรษฐกิจและสังคมพร้อมยกกรณีศึกษาจากภาคธุรกิจและหน่วยงานสาธารณะ ตลอดจนพิจารณาประเด็นจริยธรรมที่เกิดขึ้นจริงและแนวทางปฏิบัติสำหรับองค์กรและหน่วยกำกับดูแลที่ต้องการนำ AI มาใช้ให้เกิดประโยชน์สูงสุดและลดความเสี่ยง ผู้ที่สนใจแนวทางปฏิบัติที่เป็นรูปธรรม และการวางนโยบายที่สมดุลระหว่างนวัตกรรมกับความรับผิดชอบ จะได้รับข้อเสนอแนะที่ชัดเจนจากบทความนี้

ภาพรวม: OpenAI ในบริบทของการเปลี่ยนแปลงดิจิทัล

ภาพรวม: OpenAI ในบริบทของการเปลี่ยนแปลงดิจิทัล

OpenAI ก่อตั้งขึ้นในปี 2015 โดยกลุ่มผู้ประกอบการและนักวิจัยเทคโนโลยีที่รวมถึงชื่อที่เป็นที่รู้จักในวงการ โดยมีพันธกิจหลักคือ การพัฒนาเอไอขั้นสูง (AGI) ที่เป็นประโยชน์ต่อมนุษยชาติทั้งหมด ในช่วงแรก OpenAI ดำเนินงานในรูปแบบองค์กรไม่แสวงหากำไร ก่อนที่จะปรับโครงสร้างเป็นโมเดล "capped-profit" เพื่อดึงดูดการลงทุนและเพิ่มความสามารถในการแข่งขันเชิงพาณิชย์ โดยยังคงรักษาพันธกิจด้านความปลอดภัยและการประโยชน์ส่วนรวมเป็นแกนกลางของการวิจัยและการพัฒนา

ในเชิงผลิตภัณฑ์ OpenAI ได้พัฒนาและนำเสนอเทคโนโลยีที่มีผลกระทบอย่างรวดเร็วต่อระบบดิจิทัลระดับโลก ตัวอย่างผลิตภัณฑ์สำคัญ ได้แก่:

- ChatGPT — โมเดลการสนทนาที่ทำให้การโต้ตอบกับโมเดลภาษาธรรมชาติเป็นมิตรต่อผู้ใช้ทั่วไปและธุรกิจ เปิดตัวในรูปแบบบริการสาธารณะและกลายเป็นตัวเร่งให้เกิดการรับรู้ AI ในวงกว้าง

- GPT-4 — เวอร์ชันล้ำหน้าของโมเดลภาษาซึ่งเพิ่มความสามารถด้านความเข้าใจข้อความ ความแม่นยำ และการตอบสนองเชิงตรรกะที่เหมาะกับการใช้งานเชิงธุรกิจและงานวิจัย

- DALL·E — โมเดลสร้างภาพจากข้อความที่เปลี่ยนวิธีการผลิตสื่อและการออกแบบเชิงสร้างสรรค์ ทำให้การสร้างคอนเทนต์ภาพเป็นไปได้แบบอัตโนมัติและปรับแต่งได้

- Codex — โมเดลที่เชี่ยวชาญด้านการเขียนโค้ด ถูกนำไปใช้เป็นฐานของเครื่องมืออย่าง GitHub Copilot เพื่อช่วยนักพัฒนาเพิ่มประสิทธิภาพการเขียนโปรแกรม

- Whisper — โมเดลแปลงเสียงเป็นข้อความ (speech-to-text) ซึ่งเปิดทางให้บริการถอดเสียงที่มีความแม่นยำและรองรับภาษาต่าง ๆ มากขึ้น

การยอมรับในตลาดของเทคโนโลยี OpenAI เติบโตอย่างรวดเร็ว: ChatGPT ถูกประเมินว่ามีผู้ใช้รวมกันเกินกว่า 100 ล้านคน ในระดับผู้ใช้รายเดือนเมื่อพิจารณาจากการเติบโตเชิงพาณิชย์และการใช้งานทั่วไป (ตัวเลขเป็นการประมาณเชิงประเมิน) การนำโมเดลไปใช้ในเชิงธุรกิจเกิดขึ้นผ่าน API ของ OpenAI ที่ช่วยให้บริษัทต่าง ๆ สามารถผสานความสามารถของโมเดลเข้าในแอปพลิเคชัน ระบบบริการลูกค้า การผลิตคอนเทนต์ การวิเคราะห์ข้อมูล และระบบสนับสนุนนักพัฒนาได้ ตัวอย่างเชิงพาณิชย์ที่ชัดเจนคือการใช้งาน Codex ใน GitHub Copilot และการผนวกรวม GPT ในผลิตภัณฑ์ขององค์กรที่ต้องการระบบตอบคำถามอัตโนมัติหรือสร้างเอกสาร

ด้านความร่วมมือเชิงกลยุทธ์ OpenAI มีพันธมิตรสำคัญอย่าง Microsoft ซึ่งลงทุนและให้บริการพื้นที่คลาวด์ผ่าน Azure เป็นผู้ให้บริการด้านโครงสร้างพื้นฐานแบบเอ็กซ์คลูซีฟ ทั้งยังผสานความสามารถของโมเดลเข้ากับผลิตภัณฑ์เชิงพาณิชย์ของ Microsoft เช่น Bing Chat, Microsoft 365 Copilot และบริการระดับองค์กร นอกจากนี้ ความร่วมมือกับ GitHub (ซึ่งเป็นบริษัทลูกของ Microsoft) ทำให้ Codex ถูกนำไปใช้ใน GitHub Copilot เพื่อเพิ่มผลิตภาพของนักพัฒนา นี่คือกรณีศึกษาที่แสดงให้เห็นว่าการเป็นพันธมิตรเชิงเทคโนโลยีและเชิงธุรกิจช่วยเปิดช่องทางการใช้งาน AI ในวงกว้างและส่งเสริมการเปลี่ยนแปลงดิจิทัลในภาคอุตสาหกรรมต่าง ๆ

โดยสรุป OpenAI ทำหน้าที่เป็นหนึ่งในแรงขับเคลื่อนหลักของการเปลี่ยนแปลงดิจิทัลระดับโลก ผ่านการพัฒนาโมเดลที่ปฏิวัติการสื่อสาร การสร้างเนื้อหา และการเขียนโปรแกรม ความร่วมมือเชิงกลยุทธ์และช่องทางการจำหน่ายเชิงพาณิชย์ทำให้เทคโนโลยีเหล่านี้กลายเป็นพื้นฐานของนวัตกรรมทางธุรกิจ แต่พร้อมกันนั้นยังท้าทายองค์กรด้วยประเด็นด้านการกำกับดูแล ความปลอดภัย และการปรับกระบวนการทำงานให้สอดคล้องกับการนำ AI มาใช้จริงในระดับองค์กร

พื้นฐานทางเทคโนโลยี: โมเดลภาษาและสถาปัตยกรรมที่ขับเคลื่อน

พื้นฐานทางเทคโนโลยี: โมเดลภาษาและสถาปัตยกรรมที่ขับเคลื่อน

เทคโนโลยีเบื้องหลัง Large Language Models (LLMs) สมัยใหม่มีรากฐานจากสถาปัตยกรรมที่เรียกว่า Transformer ซึ่งถูกออกแบบมาเพื่อจัดการกับข้อมูลลำดับข้อความในขนาดใหญ่ได้อย่างมีประสิทธิภาพ โดยหลักการสำคัญประกอบด้วยกลไก self-attention ที่ช่วยให้โมเดลสามารถถ่วงน้ำหนักความสัมพันธ์ระหว่างคำหรือโทเค็นในบริบทยาว ๆ ได้โดยไม่ต้องพึ่งพาการคำนวณตามลำดับแบบเก่า ข้อได้เปรียบของสถาปัตยกรรมนี้คือความสามารถในการขยายขนาด (scalability) — ยิ่งเพิ่มจำนวนพารามิเตอร์และข้อมูลการฝึก โมเดลมักจะมีความเข้าใจและความสามารถในการสร้างภาษาที่ดียิ่งขึ้น ตัวอย่างเช่น GPT-3 มีประมาณ 175 พันล้านพารามิเตอร์และถูกฝึกด้วยข้อมูลข้อความรวมกันเป็นระดับหลายร้อยพันล้านโทเค็น

โดยสรุปองค์ประกอบหลักของ Transformer ได้แก่:

- Self-attention: ให้โมเดลดูความสัมพันธ์ของแต่ละโทเค็นกับโทเค็นอื่นในประโยคหรือเอกสาร

- Positional encoding: แทนตำแหน่งเชิงลำดับของโทเค็น เพราะ attention เพียงอย่างเดียวไม่รับรู้ตำแหน่ง

- Feed-forward layers และ residual connections: ช่วยให้เรียนรู้ฟังก์ชันเชิงซ้อนและฝึกได้เสถียร

กระบวนการฝึก: Pretraining, Fine-tuning และ RLHF

การสร้าง LLM ประกอบด้วยขั้นตอนที่ต่อเนื่องกันอย่างชัดเจน ซึ่งแต่ละขั้นตอนมีวัตถุประสงค์และวิธีการที่แตกต่างกัน:

- Pretraining (การฝึกล่วงหน้า): โมเดลถูกฝึกด้วยงานแบบไม่ต้องมีป้ายกำกับ (self-supervised) เช่น การทำนายคำถัดไป หรือการเติมคำที่หายไป โดยใช้ข้อมูลข้อความขนาดมหาศาลจากอินเทอร์เน็ต หนังสือ และเอกสารสาธารณะ จุดประสงค์เพื่อสร้างความเข้าใจภาษาครอบคลุมและรูปแบบการใช้ภาษา

- Fine-tuning (การปรับจูนเฉพาะงาน): หลังจาก pretraining แล้ว โมเดลจะถูกปรับจูนด้วยชุดข้อมูลที่เฉพาะเจาะจง เช่น ข้อความธุรกิจ บริบททางการแพทย์ หรือคำถาม-คำตอบ เพื่อให้ทำงานเฉพาะด้านได้ดีขึ้น และลดข้อผิดพลาดในโดเมนนั้น ๆ

- RLHF (Reinforcement Learning from Human Feedback): เทคนิคนี้นำความคิดเห็นจากมนุษย์มาเป็นสัญญาณรางวัลเพื่อฝึกโมเดลให้สร้างผลลัพธ์ที่สอดคล้องกับคุณภาพและความปลอดภัย ตัวอย่างกระบวนการทั่วไปคือ (1) ให้มนุษย์จัดอันดับหรือเลือกคำตอบที่ดีกว่า (2) ฝึกโมเดลให้ทำนายการจัดอันดับนั้นด้วยตัวแบบรางวัล (reward model) (3) ใช้อัลกอริทึม reinforcement learning เช่น PPO (Proximal Policy Optimization) เพื่อปรับนโยบายการสร้างคำตอบของโมเดลให้สอดคล้องกับรางวัล

การรวมกันของสามขั้นตอนนี้ — pretraining ขนาดใหญ่, fine-tuning แบบโดเมน, และ RLHF — เป็นเหตุผลสำคัญที่ทำให้ผลิตภัณฑ์จากองค์กรอย่าง OpenAI สามารถให้ผลลัพธ์ที่เป็นประโยชน์และปลอดภัยมากขึ้นเมื่อใช้งานจริง

แผนผังสถาปัตยกรรมเชิงภาพและคำอธิบายเชิงเทคนิคง่าย ๆ

หากมองในเชิงองค์ประกอบแบบง่าย ๆ แผนผังสถาปัตยกรรมของ LLM แบบมาตรฐานจะแบ่งเป็นชั้นดังนี้:

- Input Layer: รับข้อความและแปลงเป็นโทเค็น (tokenization)

- Embedding Layer: แปลงโทเค็นเป็นเวกเตอร์ตัวแทนเชิงตัวเลข

- Transformer Blocks (ซ้ำหลายครั้ง): แต่ละบล็อกประกอบด้วย self-attention และ feed-forward พร้อม residual และ layer normalization

- Output Layer: ทำนายความน่าจะเป็นของโทเค็นถัดไปหรือสร้างข้อความ

ภาพรวมนี้ช่วยให้ผู้บริหารเห็นว่าโมเดลทำงานเป็นชั้น ๆ — ข้อมูลดิบถูกแปลงเป็นตัวแทนทางคณิตศาสตร์ ประมวลผลผ่านชั้น attention ที่จับความสัมพันธ์ในบริบท แล้วเปลี่ยนกลับเป็นข้อความ ผลลัพธ์สุดท้ายสามารถปรับแต่งเพิ่มเติมด้วยการ fine-tuning หรือ RLHF เพื่อให้ตอบโจทย์เชิงธุรกิจ

ข้อจำกัดทางเทคนิคที่สำคัญและผลกระทบต่อการใช้งานธุรกิจ

แม้ LLM จะทรงพลัง แต่มีข้อจำกัดที่ต้องพิจารณาโดยผู้บริหารและองค์กร:

- Hallucination (การสร้างข้อมูลเท็จ): โมเดลอาจให้คำตอบที่ฟังดูสมเหตุสมผลแต่ผิด เช่น สร้างการอ้างอิงหรือตัวเลขที่ไม่มีจริง งานวิจัยและการทดสอบภาคสนามชี้ว่าระดับ hallucination จะแตกต่างตามงานและสภาวะ แต่ยังคงเป็นความเสี่ยงที่ต้องจัดการผ่านการตรวจสอบความถูกต้องและการเสริมด้วยแหล่งข้อมูลที่เชื่อถือได้

- Token limits และบริบทยาว: โมเดลมีขอบเขตบริบท (context window) ที่จำกัด — ตั้งแต่ประมาณสองพันโทเค็นในโมเดลรุ่นก่อน ๆ ไปจนถึงหลักหมื่นหรือหลักแสนโทเค็นในโมเดลสมัยใหม่ อย่างไรก็ตาม ความซับซ้อนการคำนวณของ attention เพิ่มขึ้นอย่างน้อยเป็นเชิงสี่เหลี่ยมจัตุรัสต่อความยาวบริบท (O(n^2)) ซึ่งส่งผลต่อความต้องการหน่วยความจำและเวลา

- Compute costs และทรัพยากร: การฝึกและใช้งาน LLM ต้องการการคำนวณระดับสูง — การฝึกแบบ pretraining อาจใช้ GPU/TPU เป็นร้อยถึงพันเครื่องเป็นเวลาหลายสัปดาห์หรือหลายเดือน ส่งผลให้ค่าใช้จ่ายเป็นหลักล้านดอลลาร์และมีผลกระทบด้านพลังงานและคาร์บอนฟุตพริ้นท์ การใช้งานจริงในระดับองค์กร (inference at scale) ก็มีค่าใช้จ่ายต่อการตอบ (per-token) ที่ต้องคำนวณเมื่อนำไปให้บริการลูกค้าจำนวนมาก

เพื่อบรรเทาความเสี่ยงเหล่านี้ ธุรกิจมักใช้แนวทางผสมผสาน เช่น การใช้ Retrieval-Augmented Generation (RAG) เพื่อนำข้อมูลจริงมาประกอบคำตอบ, การตรวจสอบความถูกต้องด้วยมนุษย์ในงานที่มีความเสี่ยงสูง, และการเลือกโมเดลขนาดเหมาะสมกับงานเพื่อลดค่าใช้จ่าย

สรุปคือ การเข้าใจพื้นฐานของสถาปัตยกรรม Transformer, กระบวนการฝึก (pretraining, fine-tuning, RLHF) และข้อจำกัดเชิงเทคนิค คือรากฐานที่สำคัญสำหรับการตัดสินใจเชิงกลยุทธ์เมื่อนำ AI แบบ LLM เข้ามาใช้ในองค์กร โดยต้องประเมินทั้งผลประโยชน์ด้านประสิทธิภาพและต้นทุน ความเสี่ยงด้านความถูกต้อง และความสามารถในการตรวจสอบก่อนนำไปใช้ในระดับผลิตจริง

พอร์ตโฟลิโอผลิตภัณฑ์และกรณีใช้งานเชิงธุรกิจ

พอร์ตโฟลิโอผลิตภัณฑ์และกรณีใช้งานเชิงธุรกิจ

OpenAI มีพอร์ตโฟลิโอของโมเดลและบริการที่ครอบคลุมหลายมิติ ซึ่งได้แก่ GPT (ChatGPT) สำหรับการสนทนาเชิงภาษา, Codex / GitHub Copilot สำหรับการช่วยเขียนโค้ด, DALL·E สำหรับการสร้างสื่อภาพเชิงสร้างสรรค์ และ Whisper สำหรับการถอดเสียงและวิเคราะห์ข้อมูลเสียง นอกจากนี้ยังมีชุดความสามารถเชิงเวกเตอร์/embeddings ที่นำไปใช้ในการค้นหาเชิงความหมายและการวิเคราะห์ข้อความเชิงลึก ตัวผลิตภัณฑ์เหล่านี้ถูกนำไปประยุกต์ใช้ในภาคธุรกิจอย่างกว้างขวาง ตั้งแต่การบริการลูกค้า การตลาดเชิงครีเอทีฟ จนถึงการปรับปรุงกระบวนการพัฒนาซอฟต์แวร์และการวิเคราะห์ข้อมูล

ในด้านการบริการลูกค้าและแชทบอท การนำ ChatGPT มาผสานกับระบบสนับสนุนลูกค้าช่วยลดเวลาตอบกลับเฉลี่ยและต้นทุนต่อการติดต่อได้อย่างมีนัยสำคัญ ตัวอย่างกรณีใช้งานจริงหลายองค์กรรายงานว่าแชทบอทที่ขับเคลื่อนด้วยโมเดลภาษาขนาดใหญ่สามารถตอบคำถามพื้นฐานได้อัตโนมัติราว 50–80% ของคำถามทั่วไป ซึ่งช่วยลดภาระของตัวแทนบริการลูกค้า โดยผลลัพธ์เชิงธุรกิจที่สังเกตได้รวมถึงการลดเวลารอของลูกค้าจากหลายนาทีเหลือเป็นวินาที และการลดต้นทุนการบริการต่อเคสในช่วงประมาณ 20–40% ในโครงการนำร่องที่มีการวัดผลอย่างเป็นระบบ ทั้งนี้องค์กรมักใช้กลยุทธ์ human-in-the-loop เพื่อให้แชทบอทจัดการเคสเชิงมาตรฐาน ในขณะที่ตัวแทนยังดูแลเคสที่ซับซ้อน

สำหรับภาคการพัฒนาซอฟต์แวร์ Codex และผลิตภัณฑ์ที่นำโดย GitHub Copilot ได้เปลี่ยนวิธีการทำงานของนักพัฒนาโดยตรง ทั้งในการเติมโค้ด ออกแบบฟังก์ชัน และลดงานเขียนโค้ดแบบซ้ำ ๆ ผลจากการประยุกต์ใช้งานในองค์กรและการศึกษาต่าง ๆ ชี้ให้เห็นถึงการเพิ่ม productivity อย่างมีนัยสำคัญ — ในหลายโครงการพบว่าเวลาที่ใช้ในการเขียนฟีเจอร์หรือแก้บั๊กลดลงอย่างชัดเจน (มีรายงานเชิงกรณีตัวอย่างที่ระบุอัตราการลดเวลางานในช่วงตั้งแต่ประมาณ 30–50% สำหรับงานบางประเภท) นอกจากนี้ Copilot ยังช่วยเพิ่มความเร็วในการทดลองแนวทางใหม่และลดจำนวนบรรทัดโค้ดที่ต้องเขียนด้วยมือ ทำให้องค์กรสามารถเร่งวงจรการส่งมอบ (time-to-market) ได้เร็วขึ้น

DALL·E และเทคโนโลยีสร้างสื่อภาพ/เสียงของ OpenAI มีบทบาทสำคัญในงานด้านการตลาดและสื่อคอนเทนต์ โดยช่วยให้ทีมครีเอทีฟสร้างเวอร์ชันภาพโฆษณาแบบหลายตัวเลือกได้รวดเร็วขึ้นและประหยัดต้นทุนการจัดจ้างภาพถ่ายหรือสตูดิโอ ในหลายแคมเปญเชิงพาณิชย์ การใช้ภาพที่สร้างด้วยโมเดลสามารถลดเวลาในการผลิตครีเอทีฟลงอย่างมีนัยสำคัญ (ตัวอย่างโครงการบางแห่งรายงานการลดเวลาการสร้างสรรค์ลงเกือบครึ่งหนึ่งสำหรับต้นแบบโฆษณา) ขณะเดียวกัน Whisper ถูกนำมาใช้ในการถอดเสียงการสนทนาลูกค้า การสกัดข้อมูลเชิงความรู้จากคอลเซ็นเตอร์ และการทำ sentiment analysis ซึ่งช่วยให้ธุรกิจสามารถวัดและปรับปรุงประสบการณ์ลูกค้าได้รวดเร็วกว่าเดิม โดยการถอดเสียงอัตโนมัติช่วยลดค่าใช้จ่ายในการถอดเสียงแบบแมนนวลและเร่งการเข้าถึงข้อมูลเชิงลึกจากการสนทนา

ตัวอย่างกรณีใช้งานเชิงธุรกิจ (สรุป):

- บริการลูกค้า (ChatGPT) — องค์กรอีคอมเมิร์ซและสถาบันการเงินใช้โมเดลภาษาเพื่อตอบคำถามทั่วไป ลดเวลารอและต้นทุนต่อเคส และยกระดับ SLA การตอบกลับ

- การพัฒนาซอฟต์แวร์ (Codex / GitHub Copilot) — ทีมพัฒนารายงานการลดเวลาการพัฒนาและการแก้บั๊ก เพิ่มความเร็วในการ prototyping และลดงาน boilerplate

- การตลาดและครีเอทีฟ (DALL·E) — เอเจนซีโฆษณาและทีมคอนเทนต์ใช้เพื่อสร้างแบบภาพโฆษณาและภาพประกอบที่หลากหลายโดยไม่ต้องรอสตูดิโอ

- การถอดเสียงและวิเคราะห์ (Whisper) — ศูนย์บริการลูกค้าใช้ในการทำ transcription, compliance logging และสกัดข้อมูลเชิงธุรกิจจากบทสนทนา

เมื่อประเมินผลลัพธ์เชิงธุรกิจ องค์กรมักคำนึงถึงตัวชี้วัดเช่น เวลาในการตอบกลับ (response time), ต้นทุนต่อการติดต่อ, เวลาการพัฒนา และ อัตราการปิดเรื่อง/ความพึงพอใจลูกค้า ซึ่งรายงานจากโครงการนำร่องหลายแห่งชี้ให้เห็นถึงการปรับปรุงที่จับต้องได้ แต่ผลลัพธ์จริงจะแปรผันตามการฝังระบบ การปรับจูนโมเดล การควบคุมคุณภาพข้อมูล และนโยบายด้านความเป็นส่วนตัว จึงแนะนำให้เริ่มด้วยโครงการนำร่องที่มีการวัดผลชัดเจนและขยายการใช้งานตามผลลัพธ์เชิงธุรกิจ

ผลกระทบระดับโลก: เศรษฐกิจ งาน และสังคม

ผลกระทบระดับโลก: เศรษฐกิจ งาน และสังคม

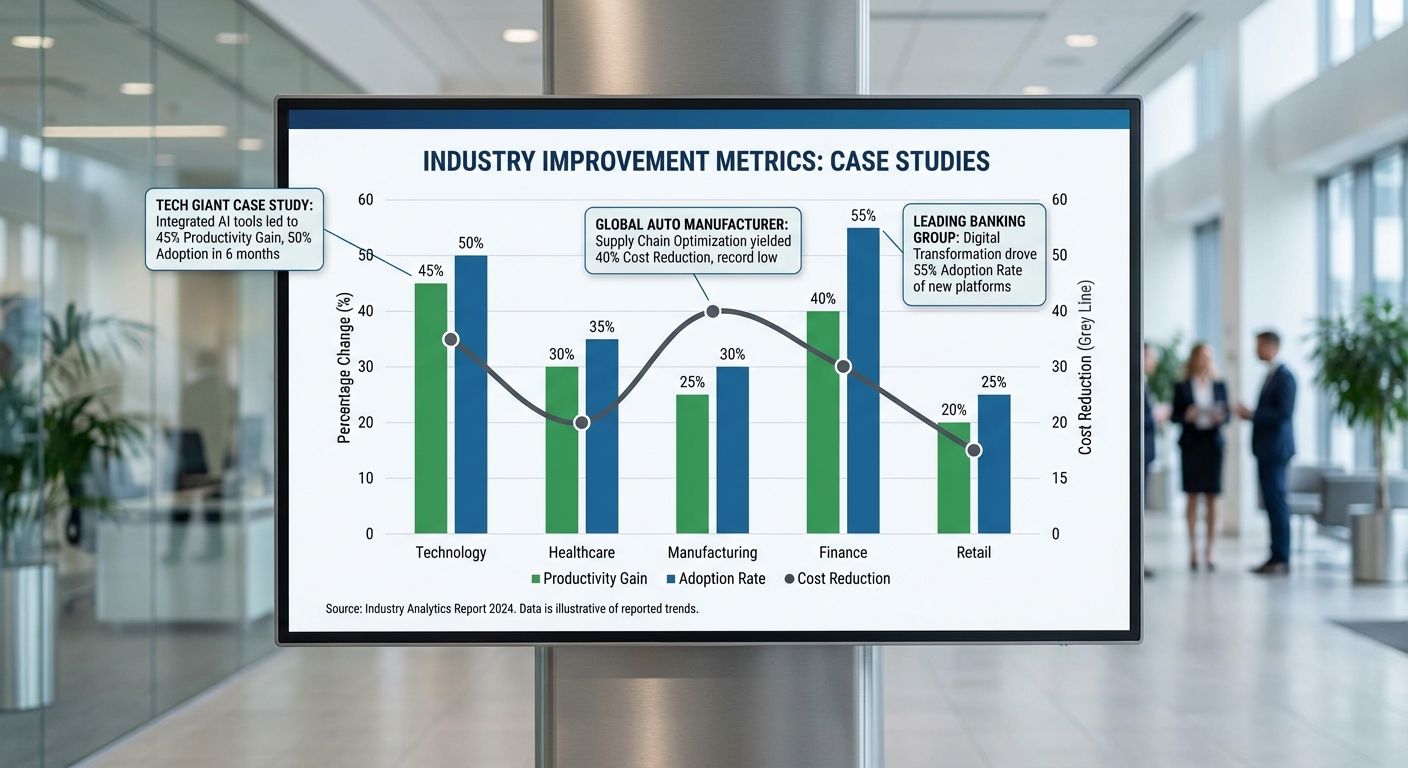

การใช้งาน AI โดยองค์กรขนาดใหญ่ เช่น OpenAI และผู้ให้บริการเทคโนโลยีรายอื่น ๆ มีผลกระทบที่ขยายตัวไปทั่วโลก ทั้งในเชิงเศรษฐกิจ ตลาดแรงงาน และสังคม ในเชิงเศรษฐกิจ การนำ AI มาใช้ช่วยยกระดับผลผลิตและสร้างมูลค่าเพิ่มที่สำคัญ ทำให้หลายหน่วยงานประเมินว่า AI จะกลายเป็นปัจจัยขับเคลื่อนการเติบโตของ GDP ระยะยาว ข้อมูลจากงานวิจัยชิ้นสำคัญระบุว่า AI อาจเพิ่มมูลค่าทางเศรษฐกิจทั่วโลกได้ระหว่าง ประมาณ 13–15.7 ล้านล้านดอลลาร์สหรัฐภายในปี 2030 (อ้างอิงการประเมินจาก McKinsey และ PwC) ซึ่งสะท้อนถึงผลประโยชน์ทั้งจากการเพิ่มประสิทธิภาพในกระบวนการผลิต การเปิดตลาดใหม่ และการสร้างนวัตกรรมบริการและสินค้าใหม่ ๆ

ผลต่อ GDP และการลงทุน

แนวโน้มการลงทุนใน AI เพิ่มขึ้นอย่างรวดเร็วทั้งจากภาครัฐและภาคเอกชน ในช่วงปี 2020–2022 มีการลงทุนในสตาร์ทอัพและโครงการ AI ในระดับรวมที่แตะระดับหลายสิบถึงร้อยพันล้านดอลลาร์ต่อปี โดยเฉพาะในภูมิภาคสหรัฐอเมริกา จีน และสหภาพยุโรป ซึ่งเป็นศูนย์กลางของการพัฒนาเทคโนโลยีและการใช้งานเชิงพาณิชย์ การลงทุนดังกล่าวไม่ได้จำกัดเฉพาะสตาร์ทอัพ แต่รวมถึงการลงทุนด้านฮาร์ดแวร์ เช่น ชิปประมวลผล AI และโครงสร้างพื้นฐานคลาวด์ ซึ่งมีผลต่อการกระจายผลประโยชน์ทางเศรษฐกิจระหว่างภูมิภาคต่าง ๆ

- ภูมิภาคที่นำร่อง: สหรัฐอเมริกาและจีนยังคงได้รับการลงทุนสูงสุด รองลงมาคือยุโรปและเอเชียตะวันออกเฉียงใต้ ซึ่งรัฐบาลหลายประเทศตั้งนโยบายสนับสนุน AI เพื่อกระตุ้นการเติบโตทางเศรษฐกิจ

- ผลต่อ GDP ภูมิภาค: ภูมิภาคที่มีโครงสร้างพื้นฐานดิจิทัลและแรงงานที่มีทักษะสูงจะได้รับสัดส่วนผลประโยชน์ทาง GDP สูงขึ้น ขณะที่ประเทศที่ยังขาดการลงทุนอาจตามหลัง

ผลต่อการจ้างงานและทักษะ

AI ส่งผลต่อโครงสร้างตลาดแรงงานอย่างชัดเจน ทั้งการเปลี่ยนทิศทางของงาน การยกระดับประสิทธิภาพในงานบางประเภท และการทดแทนงานที่มีลักษณะซ้ำซ้อน งานที่มีขั้นตอนเป็นระบบและทำซ้ำได้ (routine tasks) มีความเสี่ยงสูงที่จะถูกอัตโนมัติ ขณะที่งานที่ต้องใช้ความคิดสร้างสรรค์ การตัดสินใจเชิงซับซ้อน และทักษะระหว่างบุคคลมีแนวโน้มจะเติบโต

- องค์การแรงงานระหว่างประเทศและรายงานหลายฉบับประเมินว่า บางมหภาคของงานจะถูกเปลี่ยนหรือย้ายบทบาท—เช่น งานในฝ่ายบริการลูกค้า บัญชีพื้นฐาน และการป้อนข้อมูล โดยมีการคาดการณ์การเปลี่ยนแปลงตำแหน่งงานอย่างมีนัยสำคัญในช่วงปี 2020–2025

- รายงาน World Economic Forum (WEF) ช่วงก่อนหน้านี้ระบุประมาณการว่า อาจมีตำแหน่งงานหลายสิบล้านตำแหน่งถูกแทนที่ แต่ก็มีการสร้างงานใหม่ในสาขาเทคโนโลยี ข้อมูล วิศวกรรม และบริการที่เกี่ยวข้องกับการดูแลระบบ AI

- ผลสำคัญคือความต้องการทักษะ (reskilling/upskilling): แรงงานต้องเพิ่มทักษะด้านข้อมูล การวิเคราะห์ และการทำงานร่วมกับระบบอัตโนมัติ เพื่อรักษาโอกาสทางอาชีพ

สำหรับภาคธุรกิจ โอกาสอยู่ที่การปรับโครงสร้างงานให้ใช้ประโยชน์จาก AI เพื่อเพิ่มประสิทธิภาพและคุณภาพการให้บริการ แต่ผู้ประกอบการจะต้องลงทุนในโปรแกรมฝึกอบรมภายในและร่วมมือกับสถาบันการศึกษาเพื่อลดผลกระทบด้านการว่างงานเชิงโครงสร้าง

ผลทางสังคม: misinformation, privacy และ digital divide

การขยายตัวของ AI ยังนำมาซึ่งความเสี่ยงทางสังคมที่ต้องได้รับการจัดการอย่างจริงจัง หนึ่งคือการแพร่กระจายข้อมูลเทียม (misinformation) และเทคโนโลยีสร้างสื่อปลอม (deepfake) ซึ่งเครื่องมือที่ขับเคลื่อนด้วย AI ทำให้การผลิตเนื้อหาที่หลอกลวงมีความเร็วและความสมจริงสูงขึ้น ส่งผลกระทบต่อความเชื่อมั่นของสาธารณะและความมั่นคงของกระบวนการประชาธิปไตย

- misinformation: การเข้าถึงโมเดลภาษาใหญ่ (LLMs) ทำให้การสร้างบทความ ข้อความสั้น หรือบ็อตเพื่อแพร่ข้อมูลเท็จเป็นเรื่องง่ายขึ้น ซึ่งต้องใช้กลไกการตรวจสอบข้อมูล (fact-checking) และนโยบายแพลตฟอร์มที่มีประสิทธิภาพ

- privacy: การฝึกโมเดล AI ต้องอาศัยข้อมูลมหาศาล ซึ่งก่อให้เกิดความเสี่ยงด้านความเป็นส่วนตัว หากไม่มีการกำกับดูแลและมาตรฐานการปกป้องข้อมูลที่ชัดเจน ข้อมูลส่วนบุคคลอาจถูกใช้ในการวิเคราะห์พฤติกรรมเชิงพาณิชย์หรือการติดตามที่ละเมิดสิทธิ

- digital divide: แม้ AI จะสร้างมูลค่าทางเศรษฐกิจ แต่การเข้าถึงเทคโนโลยีและความสามารถในการใช้ประโยชน์ยังไม่เท่ากัน ประเทศหรือชุมชนที่ขาดโครงสร้างพื้นฐานดิจิทัลและทุนมนุษย์จะได้รับประโยชน์น้อยกว่า ส่งผลให้ช่องว่างทางเศรษฐกิจและสังคมขยายตัว

สรุปแล้ว ผลกระทบระดับโลกจากการใช้งาน AI เป็นทั้งโอกาสทางเศรษฐกิจและความท้าทายทางสังคม ผู้กำหนดนโยบายและผู้บริหารธุรกิจต้องร่วมมือเพื่อส่งเสริมการลงทุนที่สร้างการเติบโตอย่างยั่งยืน พร้อมจัดตั้งมาตรการคุ้มครองความเป็นส่วนตัว การป้องกันการแพร่กระจายข้อมูลเท็จ และการลดช่องว่างดิจิทัลผ่านการฝึกอบรมและการลงทุนในโครงสร้างพื้นฐาน เพื่อให้ผลประโยชน์จาก AI กระจายตัวอย่างเป็นธรรมและบรรเทาผลกระทบด้านลบต่อสังคม

ประเด็นกฎหมาย จริยธรรม และความปลอดภัย

ประเด็นกฎหมาย จริยธรรม และความปลอดภัย

การใช้งานโมเดลปัญญาประดิษฐ์ระดับใหญ่โดยองค์กรอย่าง OpenAI นำมาซึ่งความท้าทายด้านกฎหมาย จริยธรรม และความปลอดภัยที่ซับซ้อนและข้ามพรมแดน ในระดับธุรกิจและนโยบายสาธารณะ สิ่งที่ต้องพิจารณาไม่เพียงแต่ประสิทธิภาพหรือประโยชน์ทางเศรษฐกิจ แต่ยังรวมถึงการชี้ชัดความรับผิดชอบเมื่อเกิดความเสียหาย การปกป้องข้อมูลส่วนบุคคล การจัดการอคติ (bias) และการป้องกันการใช้ในทางที่ก่อให้เกิดอันตราย (misuse) ทั้งนี้ กรอบกฎหมายระหว่างประเทศกำลังพัฒนาอย่างรวดเร็ว ทำให้ผู้บริหารต้องเตรียมมาตรการทั้งทางเทคนิคและทางกฎหมายเพื่อบริหารความเสี่ยงอย่างเป็นระบบ

ความรับผิดชอบและการชี้ชัดต้นตอเมื่อเกิดความเสียหาย — ปัญหาสำคัญคือการกำหนดว่าใครต้องรับผิดชอบเมื่อ AI ก่อความเสียหาย: ผู้พัฒนาโมเดล ผู้ให้บริการคลาวด์ ผู้ปรับแต่ง (fine‑tuner) หรือผู้ใช้งานที่นำไปใช้งานเชิงปฏิบัติ ตัวอย่างเช่น กรณีข้อมูลให้คำแนะนำทางการแพทย์ผิดพลาดหรือระบบคัดกรองผู้สมัครงานมีความเอนเอียง จะมีการพิจารณาทั้งในมุมข้อบังคับด้านความรับผิดตามหลักความประมาท (negligence) หลักความรับผิดสินค้าหรือบริการ (product/service liability) และสัญญาระหว่างคู่สัญญา องค์กรธุรกิจจึงควรจัดทำนโยบายสัญญาที่ชัดเจน (contractual indemnities), ประกันความเสี่ยงด้านไซเบอร์และข้อผิดพลาด, และระบบติดตามเหตุการณ์เพื่อการสืบสวน (audit trail) ที่สามารถยืนยันต้นตอของการตัดสินใจได้

การจัดการอคติและการตรวจสอบความเป็นธรรมของโมเดล — อคติของโมเดลเป็นปัญหาที่พบได้บ่อยจากข้อมูลฝึกสอนที่ไม่สมดุลหรือจากกระบวนการออกแบบ ตัวอย่างเช่น งานสืบสวนหลายชิ้นแสดงให้เห็นว่าอัลกอริธึมที่ใช้ในกระบวนการยุติธรรมหรือการสรรหาบุคลากรอาจให้ผลลัพธ์ที่ไม่เป็นกลาง การจัดการอคติจึงต้องใช้ทั้งวิธีเชิงเทคนิคและเชิงองค์กร ได้แก่ การทดสอบแบบต่อเนื่อง (bias testing) การใช้ชุดข้อมูลทดสอบที่เป็นตัวแทน ความโปร่งใสของเมตริกความยุติธรรม (fairness metrics) และการนำแนวปฏิบัติเช่น model cards หรือ datasheets มาใช้เป็นมาตรฐานในการรายงาน ผลสำรวจจากภาคธุรกิจชี้ว่าองค์กรส่วนใหญ่ให้ความสำคัญกับการตรวจสอบความเป็นธรรมเป็นหนึ่งในหัวข้อสำคัญของการปฏิบัติตามข้อกำกับดูแล

กรอบกฎหมายระหว่างประเทศและแนวทางการกำกับดูแล — ในระดับนานาชาติ เราเห็นแนวทางการกำกับที่ชัดขึ้น เช่น EU AI Act ซึ่งใช้แนวคิดความเสี่ยงเป็นแกนนำ แบ่งระบบ AI เป็นระดับความเสี่ยง (จากที่ต้องห้ามไปจนถึงความเสี่ยงสูง) และกำหนดข้อบังคับด้านความโปร่งใส การประเมินความเสี่ยงตามวัตถุประสงค์ การจัดทำเอกสารประกอบ และการควบคุมการนำสู่ตลาด ขณะเดียวกัน สหรัฐฯ มีแนวทางที่กระจัดกระจายมากกว่า โดยหน่วยงานกำกับเช่น FTC ให้คำแนะนำด้านการคุ้มครองผู้บริโภคและการห้ามปฏิบัติที่ไม่เป็นธรรม ขณะที่สถาบันอย่าง NIST เสนอกรอบบริหารความเสี่ยงทางเทคนิค (AI RMF) สำหรับภาคธุรกิจและหน่วยงานราชการ โดยรวมแล้ว กฎระเบียบระดับรัฐและ sectoral rules (เช่น กฎการแพทย์หรือการเงิน) ยังคงมีบทบาทสำคัญและส่งผลให้บริษัทต้องปฏิบัติตามข้อกำหนดที่หลากหลายเมื่อข้ามพรมแดน

ความปลอดภัยของโมเดลและการควบคุมการใช้งานที่เป็นอันตราย — ความเสี่ยงด้านความปลอดภัยครอบคลุมตั้งแต่การโจมตีเช่น adversarial attacks, model inversion, และ data poisoning ไปจนถึงการใช้ในทางที่เป็นอันตราย เช่น การสร้าง deepfake หรือการผลิตโค้ดมุ่งร้าย การจัดการความเสี่ยงต้องรวมการออกแบบเชิงรับ (secure-by-design) เช่น การจำกัดการเข้าถึง (access controls), การตรวจจับและป้องกันพฤติกรรมผิดปกติ (anomaly detection), การทดสอบแบบ red‑teaming และการติดตาม post‑deployment monitoring พร้อมการเตรียมแผนตอบโต้เหตุการณ์ (incident response) ที่ผสานทั้งทีมเทคนิคและทีมกฎหมาย

- มาตรการเชิงปฏิบัติที่ธุรกิจควรดำเนินการ:

- จัดทำการประเมินผลกระทบตามนโยบาย (DPIA / AI impact assessment) ก่อนนำระบบสู่การผลิต

- บังคับใช้การบันทึกเหตุการณ์และความโปร่งใส (logging & provenance) เพื่อการตรวจสอบย้อนหลัง

- นำมาตรการตรวจสอบความเป็นธรรมเชิงเทคนิค (bias testing, fairness metrics) มาใช้เป็นรอบ ๆ และเผยแพร่ผลสรุปเชิงบริบท

- จัดทำสัญญาและเงื่อนไขการใช้งานที่ชัดเจน ระบุความรับผิดชอบและการเยียวยา (indemnities, limitation of liability) และพิจารณาประกันภัยที่ครอบคลุมความเสี่ยง AI

- ติดตามความเปลี่ยนแปลงด้านกฎหมายระหว่างประเทศและเตรียมความพร้อมในการปรับกระบวนการให้สอดคล้องกับกฎใหม่ เช่น ข้อกำหนดการจัดเก็บเอกสาร การรายงานเหตุการณ์ และข้อจำกัดการนำระบบไปใช้

สรุปได้ว่า ประเด็นกฎหมาย จริยธรรม และความปลอดภัยของ AI เป็นหัวข้อที่มีความเชื่อมโยงกันและมีความสำคัญต่อการบริหารความเสี่ยงขององค์กรอย่างยั่งยืน ธุรกิจที่ดำเนินการใช้หรือให้บริการ AI จำเป็นต้องวางกรอบการกำกับภายในที่ชัดเจน ผสมผสานมาตรการทางเทคนิค การกำกับดูแลภายใน และข้อกำหนดทางสัญญา เพื่อลดความเสี่ยงทางกฎหมายและสร้างความเชื่อมั่นแก่ผู้ใช้งานและผู้กำกับดูแล

การยอมรับของอุตสาหกรรมและกรณีศึกษาเชิงลึก

การยอมรับของอุตสาหกรรมและกรณีศึกษาเชิงลึก

การนำ AI ของ OpenAI เข้าสู่องค์กรในระดับอุตสาหกรรมมีความหลากหลายทั้งในเชิงเทคนิคและเชิงธุรกิจ หลายองค์กรเริ่มจากโครงการนำร่อง (pilot) แล้วขยายผลเป็นการใช้งานเชิงผลิตจริง โดยผลลัพธ์มักประกอบด้วยการลดเวลาในการประมวลผล เพิ่มประสิทธิภาพการทำงาน และปรับปรุงประสบการณ์ลูกค้า แต่ในทางปฏิบัติยังมีอุปสรรคด้านข้อมูล กฎระเบียบ และการเปลี่ยนแปลงวัฒนธรรมองค์กรที่ต้องจัดการอย่างรอบคอบ

กรณีศึกษาภาคการเงิน: การวิเคราะห์ความเสี่ยงและการบริการลูกค้า

กรณีตัวอย่าง: ธนาคารระดับชาติแห่งหนึ่งเริ่มโครงการนำร่องใช้โมเดลภาษาขนาดใหญ่ (LLM) เพื่อช่วยในการประเมินความเสี่ยงการให้สินเชื่อและระบบตอบคำถามลูกค้าอัตโนมัติ ผลลัพธ์จากโครงการนำร่องรายงานว่าเวลาในการตรวจสอบเอกสารและตัดสินใจลดลงอย่างมีนัยสำคัญ

- ผลลัพธ์เชิงตัวเลข: เวลาในการประมวลผลคำขอสินเชื่อลดลงประมาณ 45% (จากเฉลี่ย 72 ชั่วโมง เหลือ 39 ชั่วโมงในขั้นตอนการตรวจสอบเอกสารและตรวจสอบความเสี่ยงเบื้องต้น)

- บริการลูกค้า: อัตราการเบี่ยงเบน (deflection) ของคำถามที่ไม่ต้องส่งต่อให้เจ้าหน้าที่จริงเพิ่มขึ้นเป็น 60% ส่งผลให้เวลาเฉลี่ยในการตอบคำถามลูกค้าลดลงจาก 6 นาทีเป็น 90 วินาที (ลดลง ~75%)

- ผลกระทบทางธุรกิจ: ต้นทุนการให้บริการต่อคำขอที่ลดลงและความพึงพอใจของลูกค้าเพิ่มขึ้นในกลุ่มผู้ใช้ทดลอง

ปัญหาที่พบ: โมเดลมีแนวโน้มให้คำตอบที่ไม่แม่นยำ (hallucination) ในกรณีข้อมูลการเงินที่เฉพาะเจาะจง และการเชื่อมต่อกับระบบภายใน (core banking) ที่เป็น legacy ต้องใช้ทรัพยากรการพัฒนาและการทดสอบสูง นอกจากนี้ยังมีข้อกังวลด้านการปฏิบัติตามกฎระเบียบ (regulatory compliance) เกี่ยวกับการให้เหตุผลที่โปร่งใสสำหรับการปฏิเสธการให้สินเชื่อ

กรณีศึกษาการดูแลสุขภาพ: การช่วยอ่านเอกสารคลินิกและสรุปข้อมูล

กรณีตัวอย่าง: โรงพยาบาลระดับภูมิภาคนำ LLM มาใช้ช่วยอ่านบันทึกทางการแพทย์ ประมวลผลข้อความจากบันทึกผู้ป่วยและสร้างสรุปการรักษา (clinical summary) เพื่อให้แพทย์และพยาบาลใช้ในการตัดสินใจต่อ

- ผลลัพธ์เชิงตัวเลข: เวลาเฉลี่ยในการจัดทำสรุปการรักษาลดลงประมาณ 70% (จาก 30 นาทีเหลือ ~9 นาทีต่อเคส) ทำให้แพทย์มีเวลารับผู้ป่วยได้มากขึ้นและ throughput ของผู้ป่วยเพิ่มขึ้นประมาณ 15%

- คุณภาพข้อมูล: ความถูกต้องของสรุปเมื่อเทียบกับผู้เชี่ยวชาญอยู่ในช่วงประมาณ 85–92% ในเคสที่ข้อมูลครบถ้วน แต่ประสิทธิภาพจะตกลงเมื่อข้อมูลต้นทางไม่สมบูรณ์หรือเต็มไปด้วยตัวย่อ/ข้อผิดพลาดจากการพิมพ์

- ผลกระทบ: ลดภาระแพทย์ในการบันทึก ทำให้มีเวลาสำหรับการดูแลผู้ป่วยโดยตรงมากขึ้น และช่วยลดเวลาในการส่งต่อข้อมูลระหว่างทีมสหสาขาวิชาชีพ

ปัญหาที่พบ: ความเสี่ยงด้านความเป็นส่วนตัวของข้อมูลผู้ป่วย (HIPAA / PDPA) จำเป็นต้องมีการเข้ารหัส การควบคุมการเข้าถึง และการตรวจสอบว่าข้อมูลที่สรุปไม่ลบล้างบริบทสำคัญ นอกจากนี้ ในบางกรณีโมเดลจะสรุปข้อมูลเกินความจริงหรือนำเสนอข้อเสนอแนะทางการแพทย์ที่ยังไม่ได้รับการตรวจสอบโดยผู้เชี่ยวชาญ

กรณีศึกษาการค้าปลีกและการผลิต (สรุปเชิงเปรียบเทียบ)

ค้าปลีก: ผู้ค้าปลีกระดับชาติใช้ AI ของ OpenAI เพื่อทำระบบแนะนำสินค้าและวิเคราะห์คำถามจากลูกค้าในช่องทางดิจิทัล ผลการทดลองชี้ให้เห็นว่าอัตราแปลง (conversion rate) เพิ่มขึ้น 8–12% และมูลค่าการสั่งซื้อเฉลี่ย (AOV) เพิ่มขึ้นประมาณ 5–10% รายงานยังแสดงว่าการคาดการณ์อุปสงค์ที่ได้รับการปรับปรุงช่วยลดปัญหาขาดสต็อก (stockouts) ได้ประมาณ 20%.

การผลิต: ผู้ผลิตชิ้นส่วนอุตสาหกรรมใช้โมเดลภาษาในการวิเคราะห์ log การผลิตและบันทึกการซ่อมบำรุง เพื่อลดเวลาการวิเคราะห์สาเหตุของความผิดปกติและทำนายการบำรุงรักษาเชิงคาดการณ์ (predictive maintenance) ผลการใช้งานในโรงงานนำร่องระบุว่าเวลาหยุดเดินเครื่องลดลงประมาณ 25% และประสิทธิภาพการวางแผนการซ่อมบำรุงเพิ่มขึ้น ~30%.

ปัญหาที่พบบ่อยในทั้งสองอุตสาหกรรม:

- ความซับซ้อนในการผสานรวมกับระบบ ERP/CRM เดิม

- ความจำเป็นในการทำความสะอาดและจัดโครงสร้างข้อมูลก่อนเทรนนิ่งหรือปรับจูนโมเดล

- ความเสี่ยงจากการพึ่งพาข้อมูลประวัติที่มีอคติ (bias) ส่งผลต่อการตัดสินใจอัตโนมัติ

บทเรียนสำคัญสำหรับการนำไปใช้: การจัดการเปลี่ยนแปลงและการฝึกอบรมพนักงาน

ประสบการณ์จากหลายกรณีศึกษาชี้ชัดว่าความสำเร็จของโครงการ AI ไม่ได้ขึ้นกับเทคโนโลยีเพียงอย่างเดียว แต่ขึ้นกับการจัดการเปลี่ยนแปลง (change management) และการลงทุนในการพัฒนาทักษะพนักงาน รายการบทเรียนสำคัญสรุปได้ดังนี้:

- เริ่มจากโครงการนำร่องที่มีขอบเขตชัดเจน – เลือก use case ที่มีผลกระทบชัดและวัดผลได้ เช่น การสรุปเอกสารหรือการตอบคำถามลูกค้า เพื่อลดความเสี่ยงและวัด ROI ได้อย่างชัดเจน

- สร้างทีมข้ามสายงาน (cross-functional) – นำผู้เชี่ยวชาญทางธุรกิจ นักข้อมูล วิศวกรซอฟต์แวร์ และฝ่ายนโยบายมาทำงานร่วมกัน เพื่อลดข้อผิดพลาดจากการสื่อสารและเร่งกระบวนการนำไปใช้

- ฝึกอบรมและ upskilling – จัดโปรแกรมฝึกอบรมที่เน้นการใช้งานจริง การตรวจสอบผลลัพธ์ของ AI และการตัดสินใจร่วมมนุษย์-เครื่อง (human-in-the-loop) พนักงานที่ได้รับการฝึกอบรมมักยอมรับเทคโนโลยีได้เร็วกว่าและใช้ประโยชน์ได้เต็มที่

- กำกับดูแลและมาตรการความปลอดภัยของข้อมูล – ตั้งนโยบายการใช้งานข้อมูล การกำกับดูแลโมเดล (model governance) และกระบวนการตรวจสอบเพื่อลดความเสี่ยงด้านความเป็นส่วนตัวและความโปร่งใส

- วัดผลและปรับปรุงอย่างต่อเนื่อง – นิยามตัวชี้วัด (KPI) ที่ชัดเจน เช่น เวลาตอบสนอง ความถูกต้องของสรุป และผลกระทบทางการเงิน ติดตาม model drift และปรับจูนโมเดลตามข้อมูลจริง

- สื่อสารอย่างชัดเจนกับพนักงานและผู้มีส่วนได้ส่วนเสีย – อธิบายผลประโยชน์และข้อจำกัดของ AI อย่างโปร่งใส เพื่อลดความกังวลเรื่องการสูญเสียงานและสร้างวัฒนธรรมที่ยอมรับการร่วมมือกับ AI

โดยสรุป การยอมรับของอุตสาหกรรมต่อเทคโนโลยีของ OpenAI แสดงผลประโยชน์เชิงปฏิบัติหลายประการ ทั้งการลดเวลาและต้นทุนการดำเนินงาน รวมถึงการเพิ่มคุณภาพการตัดสินใจ แต่ความสำเร็จระยะยาวขึ้นอยู่กับการจัดการความเสี่ยง การออกแบบการทำงานร่วมกันระหว่างมนุษย์และเครื่อง และการลงทุนในการฝึกอบรมบุคลากรอย่างต่อเนื่อง

แนวโน้มอนาคตและคำแนะนำเชิงนโยบายสำหรับองค์กร

แนวโน้มเทคโนโลยีใน 3–5 ปีข้างหน้า

ในช่วง 3–5 ปีข้างหน้า แนวโน้มสำคัญของการพัฒนา AI จะมุ่งสู่การผสานความสามารถแบบ multimodal ที่เชื่อมโยงข้อมูลจากข้อความ ภาพ วิดีโอ และเสียงเข้าด้วยกัน ทำให้ระบบสามารถเข้าใจบริบทได้ใกล้เคียงกับมนุษย์มากขึ้น ตัวอย่างเช่น การประมวลผลคำสั่งด้วยภาพประกอบหรือการสรุปวิดีโอความยาวสูงแบบอัตโนมัติจะกลายเป็นการใช้งานเชิงพาณิชย์ที่แพร่หลาย นอกจากนี้ การปรับปรุงด้านประสิทธิภาพ (efficiency) ผ่านเทคนิคการบีบอัดโมเดล (quantization, pruning), การเรียนรู้แบบ distillation และการออกแบบสถาปัตยกรรมที่ประหยัดพลังงาน จะช่วยลดต้นทุนการคำนวณและการใช้พลังงานของการให้บริการ AI อย่างมีนัยสำคัญ

กระแสการย้ายการประมวลผลบางส่วนไปยังอุปกรณ์ปลายทาง (on-device inference) จะเพิ่มขึ้น เนื่องจากตอบโจทย์ด้านความเป็นส่วนตัว ค่าแฝง (latency) และการใช้งานแบบออฟไลน์ ตัวอย่างเช่น การใช้งานโมเดลขนาดเล็กบนสมาร์ทโฟนหรืออุปกรณ์ IoT จะทำให้บริการบางประเภทไม่จำเป็นต้องส่งข้อมูลกลับเซิร์ฟเวอร์กลางอย่างต่อเนื่อง ขณะเดียวกัน แนวทางการฝึกแบบกระจาย เช่น federated learning จะได้รับความนิยมมากขึ้นในพื้นที่ที่มีข้อจำกัดด้านกฎหมายข้อมูลหรือข้อกังวลด้านความเป็นส่วนตัว เพราะช่วยให้สามารถเรียนรู้จากข้อมูลผู้ใช้งานโดยไม่ต้องรวบรวมข้อมูลดิบไว้ที่ศูนย์กลาง

ผลรวมของปัจจัยเหล่านี้ — multimodal, efficiency, on-device inference และ federated learning — คาดว่าจะลดต้นทุนการดำเนินงานของระบบ AI และขยายการนำไปใช้งานเชิงธุรกิจให้ครอบคลุมมากขึ้น โดยองค์กรที่เตรียมพร้อมจะได้เปรียบเชิงแข่งขันในการนำเสนอผลิตภัณฑ์ที่มีประสบการณ์ผู้ใช้ดีขึ้นและคำนึงถึงความเป็นส่วนตัวของลูกค้า

ข้อเสนอเชิงนโยบายสำหรับหน่วยงานกำกับดูแลและผู้กำหนดนโยบาย

เพื่อให้การขยายตัวของ AI เป็นไปอย่างปลอดภัยและโปร่งใส หน่วยงานกำกับควรส่งเสริมมาตรฐานกลางและกรอบการประเมินความเสี่ยงที่ชัดเจน ประเด็นสำคัญได้แก่

- มาตรฐานและการจัดประเภทโมเดล: กำหนดมาตรฐานด้านการรายงาน เช่น model cards และ data sheets ที่ระบุขอบเขตการฝึก ความสามารถที่คาดหวัง ข้อจำกัด และความเสี่ยงของโมเดล

- ความสามารถในการตรวจสอบ (auditability): กำหนดแนวทางสำหรับการตรวจสอบภายนอกและการเก็บบันทึกการตัดสินใจของโมเดล (audit trails) เพื่อให้สามารถตรวจสอบเหตุการณ์ผิดปกติหรือการละเมิดได้

- การทดสอบความปลอดภัยและการประเมินความเสี่ยง: บังคับให้มีการทดสอบเชิงประสิทธิภาพและเชิงความปลอดภัย เช่น stress testing, adversarial testing และ scenario-based safety evaluations ก่อนนำระบบไปใช้งานจริง

- การคุ้มครองข้อมูลและการปฏิบัติตามกฎหมาย: ส่งเสริมแนวปฏิบัติที่สอดคล้องกับกฎหมายคุ้มครองข้อมูลส่วนบุคคล และสนับสนุนการนำ federated learning หรือเทคนิค differential privacy มาใช้เมื่อจำเป็น

- เฟรมเวิร์กความรับผิดชอบ: กำหนดความรับผิดชอบทางกฎหมายและการกำกับดูแลที่ชัดเจนสำหรับผู้พัฒนา ผู้ให้บริการ และผู้ใช้งานระบบ AI

การสร้างมาตรฐานร่วมกันระหว่างประเทศและการส่งเสริมความร่วมมือข้ามภาคส่วน (public-private partnerships) จะช่วยลดความซ้ำซ้อนในการกำกับดูแลและเร่งการยอมรับเทคโนโลยีใหม่อย่างปลอดภัย

คำแนะนำเชิงปฏิบัติสำหรับธุรกิจ

องค์กรที่ต้องการนำ AI ไปใช้เชิงปฏิบัติ ควรปฏิบัติตามแนวทางเชิงยุทธศาสตร์ดังต่อไปนี้:

- ลงทุนในทักษะและการฝึกอบรม (upskilling): สร้างโปรแกรมพัฒนาทักษะสำหรับทีม data, MLOps, และผู้นำฝ่ายธุรกิจ โดยมุ่งเน้นความเข้าใจด้านการทำงานของโมเดล ความเสี่ยงเชิงจริยธรรม และการใช้งานเครื่องมือสำหรับการ deploy บนอุปกรณ์ปลายทาง

- เริ่มต้นด้วยโครงการนำร่อง (pilot projects): ดำเนินโครงการนำร่องขนาดเล็กที่มี KPI ชัดเจนในช่วง 3–6 เดือน เพื่อลดความเสี่ยง เรียนรู้รูปแบบการบูรณาการ และประเมินผลตอบแทนจากการลงทุนก่อนการขยายขนาด

- จัดตั้งการกำกับดูแลภายใน (governance): จัดตั้งคณะกรรมการ AI หรือ AI steering committee ที่ประกอบด้วยฝ่ายเทคนิค ฝ่ายกฎหมาย และฝ่ายธุรกิจ เพื่ออนุมัติโครงการ ติดตามความเสี่ยง และกำหนดนโยบายด้านความเป็นธรรม ความโปร่งใส และการคุ้มครองข้อมูล

- นำแนวทางมาตรฐานไปใช้: ใช้เอกสาร model cards, registry ของโมเดล, และกระบวนการทดสอบก่อนนำขึ้น production เช่น continuous monitoring, bias detection และ adversarial testing

- สร้างพันธมิตรสาธารณะ-เอกชน: ร่วมมือกับสถาบันการศึกษา สตาร์ทอัพ และหน่วยงานกำกับ เพื่อเข้าถึงงานวิจัย เทคโนโลยีใหม่ และกรอบการประเมินความเสี่ยงที่ทันสมัย

การรวมเอานโยบายและการปฏิบัติให้สอดคล้องกันจะช่วยให้ธุรกิจนำ AI มาใช้ได้อย่างมั่นคงและยั่งยืน โดยลดความเสี่ยงด้านกฎหมายและชื่อเสียง ขณะเดียวกันยังเพิ่มโอกาสทางธุรกิจจากบริการและผลิตภัณฑ์ที่มีคุณภาพสูงขึ้น

สรุปเชิงปฏิบัติ: เริ่มจากการประเมินความพร้อมภายในองค์กร จัดสรรงบประมาณฝึกอบรม และรันโครงการนำร่องควบคู่ไปกับการจัดทำมาตรการกำกับภายในที่โปร่งใสและสามารถตรวจสอบได้ เพื่อก้าวเข้าสู่ยุคของ AI แบบ multimodal และ distributed ที่ปลอดภัยและมีประสิทธิภาพ

บทสรุป

OpenAI มีบทบาทสำคัญในการขับเคลื่อนการเปลี่ยนแปลงดิจิทัลระดับโลก โดยเทคโนโลยีโมเดลภาษาและแพลตฟอร์มอย่าง ChatGPT ถูกนำไปใช้ในภาคธุรกิจ การศึกษา สาธารณสุข และการเงิน ส่งผลให้ประสิทธิภาพการทำงานและนวัตกรรมเพิ่มขึ้น — ตัวอย่างเช่น ChatGPT มียอดผู้ใช้จำนวนมากภายในเวลาอันรวดเร็วและมีการนำโมเดลภาษาขนาดใหญ่ไปผสานในแอปพลิเคชันต่างๆ อย่างแพร่หลาย อย่างไรก็ดี การนำ AI ไปใช้ในวงกว้างต้องควบคู่กับมาตรการด้านความปลอดภัยและจริยธรรมเพื่อลดความเสี่ยงจากการให้ข้อมูลคลาดเคลื่อน (hallucination), อคติในข้อมูล, การละเมิดความเป็นส่วนตัว และการนำไปใช้ในทางที่เป็นอันตราย การทดสอบเชิงรุก, การตรวจสอบภายนอก, ระบบบันทึกการตัดสินใจของโมเดล และความโปร่งใสในการรายงานเป็นตัวอย่างมาตรการที่จำเป็น

เพื่อให้เกิดประโยชน์สูงสุดจาก AI ภาครัฐ องค์กรภาคเอกชน และหน่วยงานกำกับดูแลจึงควรร่วมมือกันในการสร้างกรอบการใช้งานที่โปร่งใสและปลอดภัย เช่น การตั้งมาตรฐานการประเมินความเสี่ยง, การจัดระบบ sandbox ทางกฎระเบียบเพื่อทดสอบนวัตกรรม, เกณฑ์การรับรองและการตรวจสอบอย่างต่อเนื่อง รวมถึงการลงทุนด้านการพัฒนาทักษะแรงงาน (reskilling/upskilling) — หลายการศึกษาประเมินว่าการเปลี่ยนแปลงจาก AI จะมีผลต่อรูปแบบงานอย่างมีนัยสำคัญภายในทศวรรษหน้า หากมีการกำกับดูแลที่ชัดเจนและการพัฒนาทักษะที่ทั่วถึง ผลประโยชน์ทางเศรษฐกิจที่คาดการณ์ (เช่นความเป็นไปได้ในการสร้างมูลค่าทางเศรษฐกิจระดับหลายล้านล้านดอลลาร์ภายในปี 2030 ตามการประมาณการบางแหล่ง) จะเป็นจริงได้อย่างยั่งยืน อย่างไรก็ตาม หากขาดกรอบควบคุมที่เหมาะสม ความเสี่ยงต่อสังคมและเสถียรภาพทางเศรษฐกิจก็จะเพิ่มขึ้น ดังนั้นมุมมองอนาคตจึงชี้ให้เห็นว่าความร่วมมือระดับสากลและการพัฒนา AI เชิงมนุษย์เป็นหัวใจสำคัญของการใช้งานที่ปลอดภัยและเป็นประโยชน์ต่อคนทั้งโลก

📰 แหล่งอ้างอิง: The Information