เมื่อพูดถึง "ปัญญาประดิษฐ์" หลายคนมักนึกถึงภาพของหุ่นยนต์สมองกลหรือฉากจากภาพยนตร์วิทยาศาสตร์ แต่ความจริงของ AI ในปี 2024 มีความหลากหลายและซับซ้อนกว่ามายาคติมาก งานสำรวจและรายงานเชิงวิเคราะห์ชี้ให้เห็นว่าองค์กรกว่า 60–80% กำลังทดลองหรือใช้งานรูปแบบ AI ในบางกระบวนการ ตั้งแต่การวิเคราะห์ข้อมูลเชิงลึกจนถึงการสร้างเนื้อหาอัตโนมัติ แต่ขณะเดียวกันเทคโนโลยีก็มีข้อจำกัดด้านความเที่ยงตรง ความเป็นธรรม และการตีความบริบท ซึ่งมักถูกมองข้ามในกระแสวาทกรรมที่มุ่งเน้นแต่ผลประโยชน์หรือความเสี่ยงสุดโต่ง

บทความนี้จะพาคุณแยกแยะความจริงจากความเชื่อผิด ๆ โดยสำรวจอย่างเป็นระบบทั้งขีดความสามารถเชิงเทคนิคและข้อจำกัดที่สำคัญของ AI ถ่ายทอดผลกระทบเชิงเศรษฐกิจและสังคมผ่านตัวอย่างจริง เช่น การใช้ generative AI ในสื่อ การอัตโนมัติในภาคการผลิต และปัญหาความลำเอียงของโมเดล รวมถึงกรอบนโยบายและแนวทางปฏิบัติที่องค์กรและบุคคลควรนำไปใช้เพื่อเตรียมความพร้อมและจัดการความเสี่ยง อ่านต่อเพื่อรับมุมมองใหม่ที่รอบด้านและสามารถนำไปปฏิบัติได้จริงสำหรับอนาคตของปัญญาประดิษฐ์

คำนำ: ทำไม "AI อาจไม่ใช่สิ่งที่คุณคิด"

คำนำ: ทำไม "AI อาจไม่ใช่สิ่งที่คุณคิด"

ในช่วงไม่กี่ปีที่ผ่านมา คำว่า ปัญญาประดิษฐ์ (Artificial Intelligence - AI) กลายเป็นคำสามัญในวงการธุรกิจ สื่อมวลชน และการเมือง แต่ภาพลักษณ์ของ AI ที่ปรากฏต่อสาธารณะมักถูกร้อยเรียงด้วยเรื่องเล่าเชิงนิยาย — หุ่นยนต์ที่มีความคิดเป็นของตัวเอง หรือระบบอัจฉริยะที่แทนที่มนุษย์ได้ทั้งหมด ในความเป็นจริง AI ในบริบทปัจจุบันเป็นชุดเทคนิคทางคอมพิวเตอร์ที่ออกแบบมาเพื่อให้เครื่องจักรสามารถ เรียนรู้จากข้อมูล, ทำการคาดการณ์ และช่วยตัดสินใจในขอบเขตที่จำกัด (narrow AI) มากกว่าจะเป็นความรู้สากลหรือสติปัญญาแบบมนุษย์

วัตถุประสงค์ของบทความนี้คือการเปลี่ยนเฟรมการรับรู้ของผู้อ่าน — โดยเฉพาะผู้บริหารและนักธุรกิจ — จากภาพจำเชิงนิยายไปสู่ความเข้าใจเชิงปฏิบัติและเชิงนโยบาย เราจะชี้ให้เห็นช่องว่างระหว่าง ความสามารถจริงของระบบ กับ ความคาดหวังของสาธารณะ ซึ่งมักนำไปสู่การตัดสินใจด้านการลงทุนและการกำกับดูแลที่ไม่สอดคล้องกับข้อเท็จจริงทางเทคนิค ตัวอย่างเช่น องค์กรมากกว่า 50–60% ตามการสำรวจเชิงอุตสาหกรรมได้เริ่มนำ AI ไปใช้ในบางฟังก์ชันแล้ว แต่ระดับผลลัพธ์และการบูรณาการเชิงกลยุทธ์ยังแตกต่างกันอย่างมาก

เพื่อรองรับการตัดสินใจเชิงธุรกิจ บทนำนี้จะพาไปยังภาพรวมของหัวข้อที่จะกล่าวถึงในบทความ โดยแบ่งเป็นส่วนๆ ที่จะตอบคำถามสำคัญ: AI มีประวัติและวิวัฒนาการอย่างไร, ในเชิงเทคนิคมันสามารถทำอะไรได้จริงและมีข้อจำกัดใดบ้าง, ผลกระทบด้านเศรษฐกิจและแรงงานที่เป็นรูปธรรมมีลักษณะอย่างไร รวมทั้งกรอบนโยบายและการกำกับดูแลที่ธุรกิจและผู้กำหนดนโยบายควรพิจารณา

- ข้อเท็จจริงเชิงประวัติศาสตร์: บทบาทของความก้าวหน้าทางอัลกอริทึมและการเติบโตของข้อมูลและแหล่งกำลังคำนวณ

- ขีดความสามารถทางเทคนิค: สิ่งที่ AI แบบจำกัด (narrow AI) ทำได้จริง เช่น การประมวลผลภาษาธรรมชาติ การตรวจจับความผิดปกติ และสิ่งที่ยังทำได้ยาก เช่น ความเข้าใจเชิงเหตุผลทั่วไป

- ผลกระทบทางเศรษฐกิจ: โอกาสด้านผลิตภาพ การเปลี่ยนแปลงตำแหน่งงาน และความเสี่ยงที่ต้องวางแผนรับมือ

- นโยบายควบคุมและธรรมาภิบาล: ประเด็นด้านความเป็นส่วนตัว ความโปร่งใส และมาตรการกำกับเพื่อสร้างความปลอดภัยและความยุติธรรม

ในบทถัดไป เราจะลงรายละเอียดเชิงตัวเลข ตัวอย่างเคสธุรกิจ และข้อเสนอแนะแนวทางปฏิบัติสำหรับผู้บริหาร เพื่อให้คุณสามารถประเมินและออกแบบกลยุทธ์ AI ที่มีพื้นฐานจากความจริงเชิงเทคนิคและเศรษฐกิจ ไม่ใช่แค่จากภาพลักษณ์หรือความคาดหวังที่เกินจริง

บริบทเชิงประวัติศาสตร์และวงจรความคาดหวัง (Hype Cycle)

บริบทเชิงประวัติศาสตร์: ไทม์ไลน์การพัฒนาเทคโนโลยี AI

การพัฒนา AI ผ่านช่วงเวลาและแนวทางเชิงเทคนิคที่เปลี่ยนแปลงอย่างมีนัยสำคัญตั้งแต่กลางศตวรรษที่ 20 จนถึงปัจจุบัน โดยสามารถสรุปไทม์ไลน์เชิงหลักได้ดังนี้

- ยุค Symbolic AI และตรรกะเชิงกฎ (1950s–1980s) — งานวิจัยช่วงแรกมุ่งเน้นการแทนความรู้ด้วยกฎและตรรกะ เช่น ระบบผู้เชี่ยวชาญ (expert systems) ที่นิยมในธุรกิจช่วงปลายทศวรรษ 1970–1980

- ยุค Machine Learning แบบสถิติ (1990s–2000s) — การเปลี่ยนจากกฎนิยามเป็นการเรียนรู้จากข้อมูลด้วยวิธีทางสถิติ เช่น SVM, decision trees, และ Bayesian models

- ยุค Deep Learning (2006–ปัจจุบัน) — การกลับมาของเครือข่ายประสาทเทียมที่ลึกขึ้นพร้อมข้อมูลและพลังการคำนวณที่มากขึ้น จุดเปลี่ยนสำคัญคือผลงานเช่น AlexNet (2012) ที่แสดงผลลัพธ์เหนือกว่าวิธีเดิมในงานรู้จำภาพ

- ยุค Generative AI และสถาปัตยกรรม Transformer (2014–ปัจจุบัน) — ตั้งแต่ GANs (2014) ไปจนถึง Transformer (2017) และโมเดลภาษาขนาดใหญ่ (LLMs) เช่น series ของ GPT ที่เร่งการใช้งานด้านสร้างเนื้อหาอัตโนมัติและระบบสนับสนุนการตัดสินใจ

วงจรความคาดหวัง (Gartner Hype Cycle) และผลกระทบต่อการลงทุน

แนวคิดวงจรความคาดหวังหรือ Gartner Hype Cycle อธิบายลำดับทางอารมณ์และการตอบสนองของตลาดต่อเทคโนโลยีใหม่ ตั้งแต่ช่วง การกระตุ้นความสนใจ (Technology Trigger) ผ่านสู่ จุดพีคของความคาดหวัง (Peak of Inflated Expectations) แล้วเข้าสู่ หุบเหวแห่งความย่อท้อ (Trough of Disillusionment) ก่อนฟื้นสู่ ทางลาดแห่งการตระหนักรู้ (Slope of Enlightenment) และในที่สุดถึง สถานะใช้ประโยชน์จริง (Plateau of Productivity) การเคลื่อนผ่านแต่ละระยะมีผลโดยตรงต่อระดับการลงทุนและการนำไปใช้ในเชิงพาณิชย์

ประวัติศาสตร์ของ AI สะท้อนวงจรนี้ชัดเจน: ยุค expert systems ทำให้เกิดการลงทุนเชิงพาณิชย์ครั้งใหญ่ในทศวรรษ 1980 แต่เมื่อเทคโนโลยีไม่สามารถตอบโจทย์เชิงปฏิบัติได้ทันคาดหวัง เกิด AI winter ซึ่งนำไปสู่การลดการลงทุนและการวิจัย ในทำนองเดียวกัน หลังจาก breakthrough ของ deep learning ในช่วงต้นทศวรรษ 2010 การลงทุนและความคาดหวังพุ่งสูงขึ้นอีกครั้ง ส่งผลให้มีการลงทุนจากบริษัทยักษ์ใหญ่และ VC อย่างต่อเนื่อง จนมาถึงการเกิดฟองสบู่ของความคาดหวังใหม่ ๆ กับ Generative AI ในช่วงหลัง ที่แม้ว่าจะสร้างมูลค่าและการประยุกต์ใช้ใหม่ ๆ แต่ก็มีความเสี่ยงที่จะสร้างการคาดหวังที่เกินจริงในบางประเด็น

สถิติการลงทุนและการนำไปใช้ในภาคธุรกิจ

แนวโน้มการลงทุนและการนำ AI ไปใช้ในองค์กรมีการเติบโตชัดเจน แม้สัดส่วนและตัวเลขจะแตกต่างตามแหล่งข้อมูล แต่ภาพรวมแสดงการเพิ่มขึ้นทั้งด้านเงินทุนและงบประมาณภายในองค์กร ตัวอย่างข้อมูลเชิงสถิติที่ช่วยให้เห็นภาพได้คือ:

- การลงทุนจากภาคเอกชน (รวม VC และการลงทุนเชิงกลยุทธ์) ในบริษัทสตาร์ทอัพด้าน AI เพิ่มขึ้นอย่างมีนัยสำคัญในรอบทศวรรษที่ผ่านมา โดยเฉพาะช่วงหลังการพิสูจน์ศักยภาพของ deep learning และโมเดลภาษาขนาดใหญ่ ซึ่งกระตุ้นให้นักลงทุนพร้อมทุ่มทุนมากขึ้น

- งบประมาณ R&D ของบริษัทเทคโนโลยีชั้นนำเพิ่มสัดส่วนการลงทุนไปยัง AI และ data science อย่างต่อเนื่อง — หลายองค์กรรายงานการขยายทีมงานด้าน AI และการจัดสรรงบประมาณที่เติบโตเป็นหลักสิบเปอร์เซ็นต์ต่อปี เพื่อรักษาความสามารถในการแข่งขัน

- การนำ AI ไปใช้เชิงธุรกิจ (enterprise adoption) ขยายตัวอย่างรวดเร็ว: การสำรวจเชิงอุตสาหกรรมระบุว่า กว่า 50% ขององค์กรในบางกลุ่มตัวอย่างเริ่มใช้โมเดล AI ในฟังก์ชันหนึ่งฟังก์ชันขึ้นไป เช่น การตลาดอัตโนมัติ การวิเคราะห์ลูกค้า และระบบตรวจจับความผิดปกติ

ผลกระทบจากวงจรความคาดหวังคือ ช่วงพีคมักดึงเม็ดเงินจำนวนมากเข้าสู่เทคโนโลยี ทำให้เกิดการลงทุนระยะสั้นและโครงการเชิงนวัตกรรมจำนวนมาก แต่เมื่อหลายโครงการไม่สามารถสร้างมูลค่าเชิงธุรกิจในทันที นักลงทุนบางรายจะถอนตัวและเกิดการควบรวมกิจการหรือการปรับกลยุทธ์สู่การโฟกัสผลตอบแทนระยะสั้นมากขึ้น ในทางตรงกันข้าม ช่วงหุบเหวเป็นจังหวะที่มีการคัดกรองเทคโนโลยีและองค์กรที่สามารถสร้าง ROI ที่ชัดเจนออกมา ทำให้เกิดการฟื้นตัวที่มั่นคงกว่าเมื่อเทคโนโลยีนั้นเข้าสู่ระยะการใช้งานจริง

สรุปได้ว่า การเข้าใจบริบทเชิงประวัติศาสตร์และวงจรความคาดหวังช่วยให้ผู้บริหารและนักลงทุนสามารถแยกความแตกต่างระหว่าง “กระแสชั่วคราว” กับ “การเปลี่ยนแปลงเชิงโครงสร้าง” และวางนโยบายการลงทุนและการนำไปใช้เชิงปฏิบัติที่สมดุลระหว่างความเสี่ยงและโอกาส

ข้อเท็จจริงทางเทคนิค: สิ่งที่ AI ทำได้ และข้อจำกัด

ความสามารถทางเทคนิคที่ชัดเจน

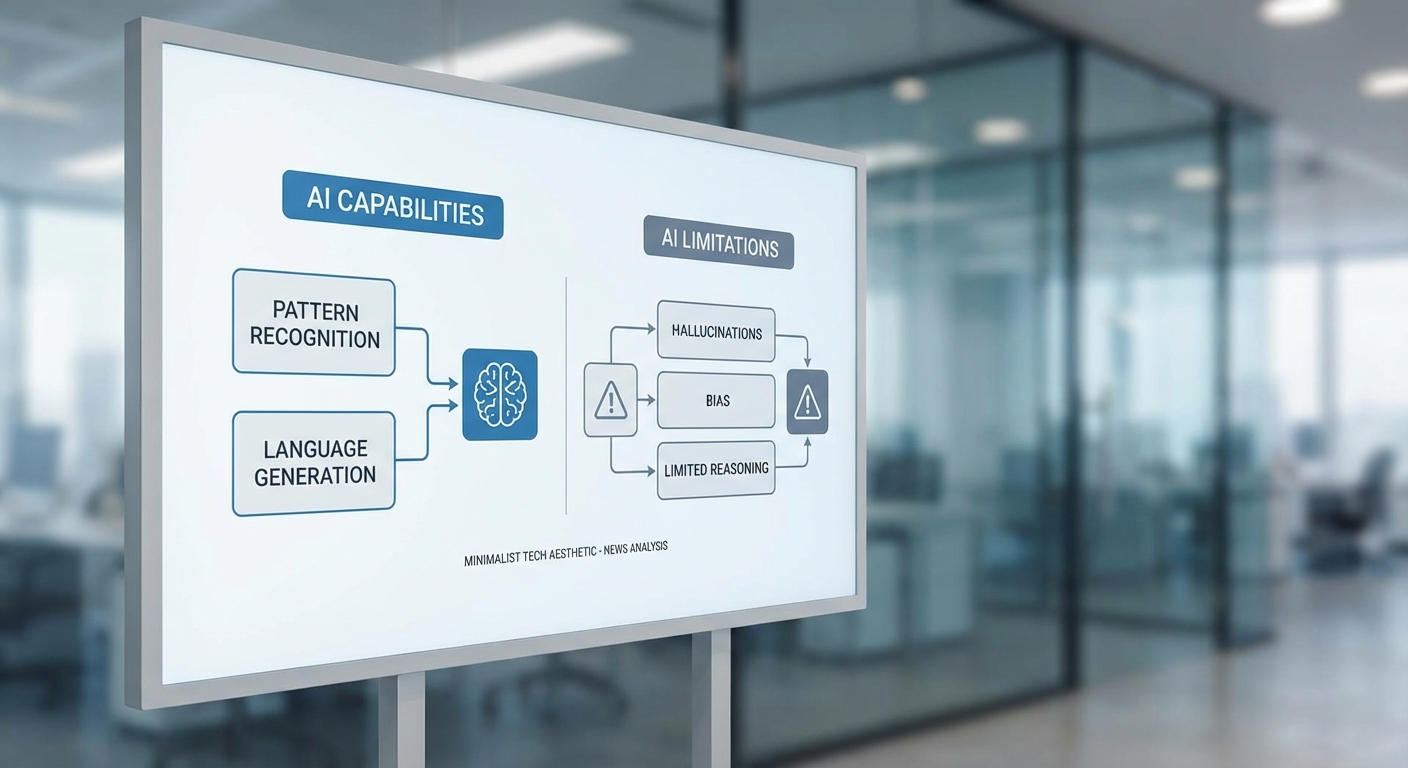

ในเชิงเทคนิค ปัญญาประดิษฐ์สมัยใหม่มีความเชี่ยวชาญเด่นชัดในงานที่เกี่ยวข้องกับการจดจำรูปแบบและการประมวลผลข้อมูลจำนวนมาก ด้วยสถาปัตยกรรมเช่น convolutional neural networks (CNN) และ vision transformers (ViT) ระบบรู้จำภาพสามารถบรรลุความแม่นยำระดับสูงในชุดข้อมูลมาตรฐาน เช่น ImageNet ซึ่งหลายรุ่นทำ Top-1 accuracy เกินกว่า 80–90% ขึ้นอยู่กับสเปคของโมเดลและการเทรน ในด้านภาษาธรรมชาติ โมเดลภาษาขนาดใหญ่ (Large Language Models, LLMs) อย่างกลุ่ม Transformer สามารถสร้างข้อความที่มีความต่อเนื่อง ดำเนินบทสนทนา ตอบคำถาม และสังเคราะห์สรุปข้อความได้อย่างน่าประทับใจ โดยมีการใช้งานจริงเช่น แชทบอทบริการลูกค้า การสังเคราะห์รายงาน และการช่วยเขียนโค้ด

ความสามารถเหล่านี้เกิดจากสองปัจจัยหลัก: (1) การเรียนรู้จากข้อมูลขนาดใหญ่ (large-scale supervised / self-supervised learning) ที่ช่วยให้โมเดลจับรูปแบบสถิติซับซ้อนได้ และ (2) การปรับแต่งเชิงปฏิบัติ (fine-tuning, transfer learning, few-shot learning) ที่ช่วยให้โมเดลทั่วไปถูกนำไปใช้ในงานเฉพาะตัวอย่างรวดเร็ว ตัวอย่างเชิงพาณิชย์รวมถึงระบบตรวจวินิจฉัยภาพทางการแพทย์ที่ในงานวิจัยบางชิ้นแสดงผลทางสถิติใกล้เคียงหรือเทียบเท่าผู้เชี่ยวชาญ (AUC > 0.9 ในบางกรณี) และระบบแปลงเสียงเป็นข้อความที่ลดอัตราข้อผิดพลาดลงอย่างชัดเจนเมื่อเทียบกับทศวรรษก่อนหน้า

ข้อจำกัดเชิงเทคนิคที่สำคัญ

แม้จะมีความก้าวหน้า แต่ AI ยังมีข้อจำกัดทางเทคนิคหลายประการที่ธุรกิจต้องพิจารณาอย่างรอบคอบ:

- Hallucination: โมเดลภาษาขนาดใหญ่สามารถสร้างข้อเท็จจริงหรือรายละเอียดที่ฟังดูสมเหตุสมผลแต่ไม่เป็นจริงได้ — ปรากฏการณ์ที่เรียกว่า hallucination ซึ่งเสี่ยงต่อการให้ข้อมูลผิดพลาดในบริบทที่ต้องการความถูกต้องสูง

- Overfitting และการทั่วไป (generalization): เมื่อโมเดลปรับตัวมากเกินไปกับข้อมูลฝึก อาจทำงานได้ดีในชุดข้อมูลเดิมแต่ล้มเหลวเมื่อเผชิญข้อมูลจากการกระจายต่างกัน (distribution shift) ซึ่งเป็นสาเหตุให้ผลลัพธ์ไม่สอดคล้องในสภาพแวดล้อมจริง

- Bias ในข้อมูล: โมเดลเรียนรู้จากข้อมูลที่มีอยู่ ดังนั้นความลำเอียง (bias) ในข้อมูลฝึก เช่น แสดงตัวอย่างไม่สมดุลในเชื้อชาติ เพศ หรือภาษา จะสะท้อนออกมาในการทำนายหรือการตัดสินใจของโมเดล

- ขีดจำกัดการให้เหตุผลเชิงลึก: แม้ LLMs จะสามารถเลียนแบบการให้เหตุผลแบบพื้นฐานผ่านรูปแบบภาษา แต่โมเดลเหล่านี้ยังก่อให้เกิดการตีความเชิงเหตุผลเชิงลึกหรือการคำนวณตรรกะซับซ้อนได้ไม่เสมอไป โดยมักจำเป็นต้องใช้เทคนิคเสริม เช่น chain-of-thought prompting หรือระบบตรวจสอบภายนอก

- ข้อจำกัดเชิงคำนวณและต้นทุน: การฝึกและการให้บริการโมเดลขนาดใหญ่ต้องการทรัพยากรประมวลผล (GPU/TPU) และพลังงานสูง ซึ่งมีผลต่อค่าใช้จ่าย ความยั่งยืนด้านพลังงาน และเวลาที่ใช้ในการปรับปรุงโมเดล

- การตีความผลลัพธ์และความโปร่งใส: โมเดลเชิงลึกมักเป็นกล่องดำ ทำให้ยากต่อการอธิบายเหตุผลของการตัดสินใจ (explainability) ซึ่งเป็นอุปสรรคในอุตสาหกรรมที่กฎระเบียบหรือความรับผิดชอบเป็นสิ่งสำคัญ

ผลลัพธ์ที่นำไปใช้ได้จริงเทียบกับสิ่งที่ยังเป็นงานวิจัย

โดยรวม สามารถแบ่งความสำเร็จของ AI ออกเป็นสองกลุ่มชัดเจน: งานที่พร้อมใช้งานเชิงพาณิชย์และงานที่ยังเป็นหัวข้อวิจัย

- พร้อมใช้งานเชิงพาณิชย์: ระบบรู้จำภาพ (object detection, segmentation), การรู้จำเสียงพูดและการแปลภาษา, การสืบค้นเอกสาร, ระบบแชทบอทสำหรับงานบริการลูกค้า และการวิเคราะห์ข้อมูลเชิงสถิติ — งานเหล่านี้มีมาตรฐานการวัดผลที่ชัดเจนและถูกใช้อย่างแพร่หลายในการดำเนินธุรกิจ

- ยังเป็นงานวิจัยหรือใช้อย่างมีข้อจำกัด: การให้เหตุผลเชิงนามธรรมในระดับมนุษย์, การตัดสินใจเชิงสาเหตุ (causal inference) โดยไม่มีการพึ่งพาข้อสังเกตที่ชัดเจน, การสร้างความเข้าใจเชิงบริบทระยะยาวที่เสถียร, และการพัฒนาระบบที่ปราศจากอคติอย่างสมบูรณ์ — ประเด็นเหล่านี้ยังต้องการงานวิจัยทั้งในเชิงทฤษฎีและปฏิบัติ

สำหรับผู้บริหารและผู้ตัดสินใจทางธุรกิจ ข้อสรุปเชิงปฏิบัติคือ: ใช้ AI เป็นเครื่องมือที่ทรงพลังสำหรับงานที่มีข้อมูลชัดเจนและมาตรฐานการวัดผลชัดเจน แต่ต้องมีการตรวจสอบผลลัพธ์ กลไกควบคุมความเสี่ยง และการประเมินผลกระทบด้านจริยธรรมและกฎหมายอย่างต่อเนื่อง เพื่อจัดการกับข้อจำกัดเชิงเทคนิคที่ยังคงอยู่

ผลกระทบต่อเศรษฐกิจและแรงงาน: ท้าทายหรือโอกาส?

ผลกระทบต่อเศรษฐกิจและแรงงาน: ท้าทายหรือโอกาส?

การแพร่หลายของระบบปัญญาประดิษฐ์ (AI) ก่อให้เกิดการเปลี่ยนแปลงในตลาดแรงงานที่มีทั้งความเสี่ยงและโอกาสไปพร้อมกัน ในด้านหนึ่ง AI สามารถทดแทนงานที่มีลักษณะเป็นกิจกรรมทำซ้ำหรือมีกฎเกณฑ์ชัดเจน เช่น งานการประมวลผลข้อมูล งานเอกสาร และการบริการลูกค้าเบื้องต้น ในอีกด้านหนึ่ง AI ก็สร้างตำแหน่งงานใหม่ เช่น ผู้กำกับดูแล AI (AI governance), ผู้ดูแลข้อมูล (data steward) และผู้เชี่ยวชาญด้านการผสานงานระหว่างคนกับเครื่อง ซึ่งองค์การหลายแห่งได้ประเมินระดับผลกระทบแตกต่างกันไป — ตัวอย่างเช่น World Economic Forum ประเมินว่าในปี 2025 อาจมีงานเดิมประมาณ 85 ล้านตำแหน่งที่ถูกย้ายหรือถูกทดแทน ในขณะที่อาจเกิดงานใหม่ขึ้นประมาณ 97 ล้านตำแหน่ง ซึ่งสะท้อนความเป็นไปได้ทั้งสองด้านของการเปลี่ยนผ่านนี้

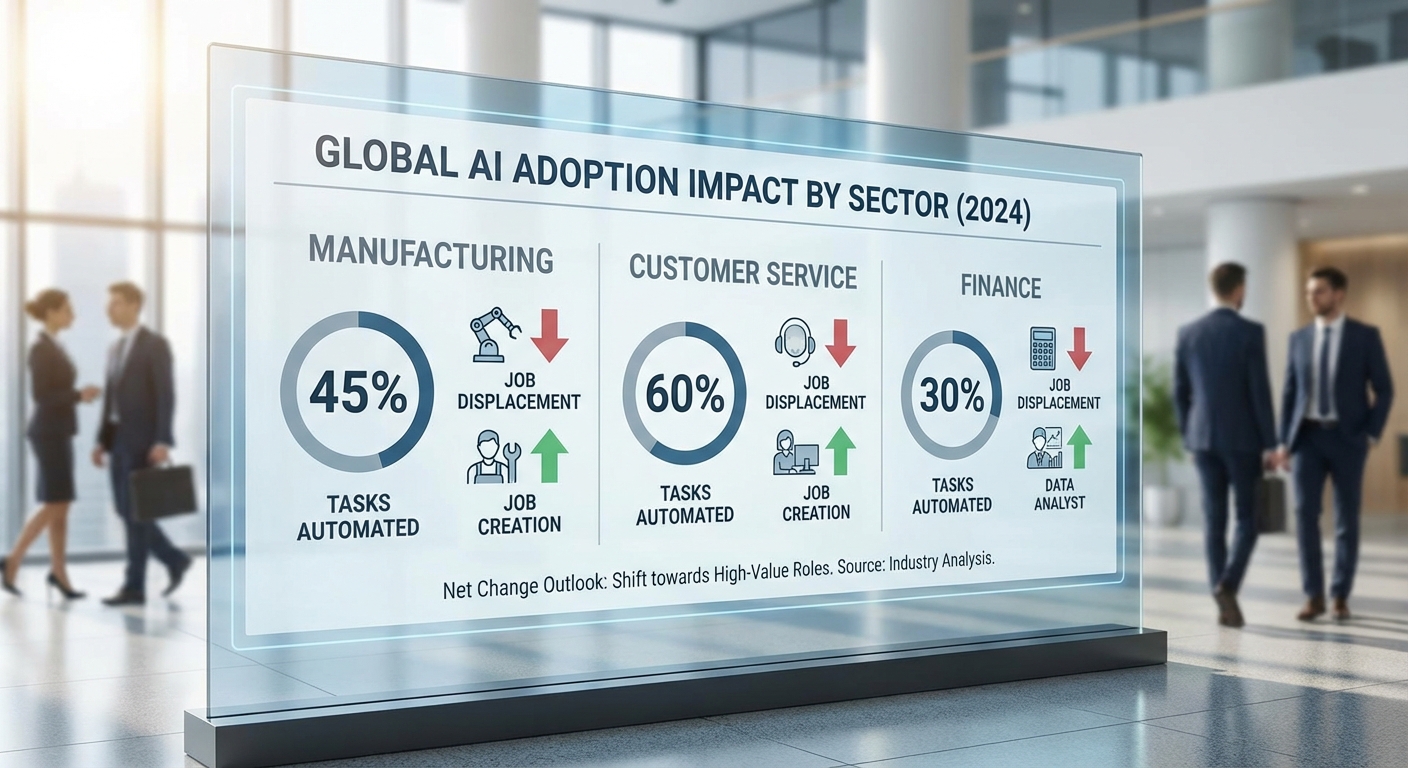

ระดับความเสี่ยงต่อการถูกทดแทนแตกต่างกันไปตามประเภทงานและอุตสาหกรรม โดยองค์การต่าง ๆ ให้ภาพรวมที่สอดคล้องกันว่า งานที่มีลักษณะทำซ้ำได้สูงหรือมีขั้นตอนชัดเจนมีความเสี่ยงมากกว่า งานที่ต้องใช้การตัดสินใจเชิงนามธรรมหรือความคิดสร้างสรรค์ ตัวอย่างเช่น:

- การผลิต (Manufacturing) — งานสายการประกอบที่เป็นแบบแผนและการควบคุมคุณภาพอัตโนมัติสามารถถูกแทนที่ด้วยหุ่นยนต์และระบบอัจฉริยะได้มากขึ้น ส่งผลให้แรงงานทักษะต่ำในภาคนี้เผชิญความเสี่ยง

- การบริการลูกค้า (Customer Service) — แชทบอทและระบบตอบกลับอัตโนมัติสามารถจัดการคำถามพื้นฐานได้เกินขึ้น ทำให้บทบาทตัวแทนบริการลูกค้าเชิงปฏิบัติเปลี่ยนไปเป็นการจัดการกรณีซับซ้อนและการดูแลลูกค้าที่ต้องการทักษะมนุษย์

- การเงินและบัญชี (Finance & Accounting) — งานที่เป็นการประมวลผลรายการและวิเคราะห์เชิงกฎเกณฑ์สามารถอัตโนมัติได้ ทำให้บทบาทที่เน้นการวิเคราะห์เชิงกลยุทธ์และการตีความข้อมูลมีความสำคัญยิ่งขึ้น

การวิจัยของ OECD ระบุว่าประมาณ 9% ของงานอาจมีความเสี่ยงสูงต่อการถูกทำให้เป็นอัตโนมัติ ขณะที่ประมาณ 25–30% อาจเผชิญการเปลี่ยนแปลงในระดับสำคัญ ซึ่งสะท้อนว่าการเปลี่ยนแปลงจะเกิดขึ้นในระดับกว้าง ไม่ใช่แค่การหายไปของงานอย่างเดียว แต่รวมถึงการปรับหน้าที่งานและความต้องการทักษะใหม่ด้วย นอกจากนี้งานบางประเภทที่ถูกมองว่า “ครีเอทีฟ” หรือ “ซับซ้อน” ก็ยังได้รับผลกระทบในรูปแบบของการช่วยงาน (augmentation) เช่น นักออกแบบ นักข่าว หรือนักพัฒนาคอนเทนต์ ต้องเรียนรู้วิธีใช้เครื่องมือ AI เพื่อเพิ่มประสิทธิภาพการทำงาน

ในทางกลับกัน AI สร้างโอกาสใหม่ทั้งในระดับเศรษฐกิจและแรงงาน ตัวอย่างของตำแหน่งงานที่เกิดขึ้นหรือมีความต้องการเพิ่มขึ้น ได้แก่:

- AI governance & ethics officers — รับผิดชอบด้านนโยบาย ความโปร่งใส และการปฏิบัติตามกฎระเบียบ

- Data engineers / Data stewards — จัดการคุณภาพข้อมูล การจัดเก็บ และการเข้าถึงข้อมูลอย่างยั่งยืน

- Prompt engineers / Human-in-the-loop specialists — ออกแบบอินพุตและกระบวนการที่ทำให้โมเดลทำงานได้ตรงตามเป้าหมาย

- เครื่องมือฝึกอบรมและผู้สอนทักษะดิจิทัล (reskilling/upskilling trainers) — ออกแบบหลักสูตรและการฝึกปฏิบัติจริงเพื่อช่วยแรงงานเปลี่ยนสายอาชีพ

เพื่อให้การเปลี่ยนผ่านนี้เป็นไปอย่างสังคมยุติธรรมและมีประสิทธิผล การศึกษาและการฝึกทักษะใหม่ (upskilling/reskilling) จึงเป็นหัวใจสำคัญ ตามรายงานของ World Economic Forum ประมาณการว่า เกือบครึ่งหนึ่งของพนักงาน จะต้องได้รับการฝึกทักษะใหม่ภายในปี 2025 เพื่อให้ทันต่อการเปลี่ยนแปลงของงาน นโยบายที่สำคัญได้แก่ การลงทุนในโปรแกรมการเรียนรู้ตลอดชีวิต (lifelong learning), การสนับสนุนการฝึกอบรมเชิงวิชาชีพ, การยอมรับการรับรองทักษะสั้น (micro-credentials) และการส่งเสริมความร่วมมือระหว่างภาครัฐ ภาคเอกชน และสถาบันการศึกษา

ในเชิงปฏิบัติ ภาคธุรกิจควรเริ่มจากการประเมินความเสี่ยงทักษะภายในองค์กร ปรับออกแบบงานให้ผสมผสานการทำงานร่วมกับ AI และตั้งงบประมาณสำหรับการฝึกอบรมเชิงกลยุทธ์ ขณะที่ภาครัฐควรออกแบบนโยบายรองรับการเปลี่ยนผ่าน เช่น ระบบประกันรายได้ชั่วคราว การสนับสนุนการหาอาชีพใหม่ และการผลักดันโครงการฝึกทักษะระดับชาติ การรวมกันของมาตรการเหล่านี้จะช่วยเปลี่ยนความท้าทายเป็นโอกาส โดยทำให้แรงงานสามารถปรับตัวและเศรษฐกิจสามารถใช้ประโยชน์จากประสิทธิภาพที่ AI มอบให้ได้อย่างยั่งยืน

ด้านจริยธรรม นโยบาย และการกำกับดูแล

ด้านจริยธรรม นโยบาย และการกำกับดูแล

ปัญหาจริยธรรมหลักที่ระบบปัญญาประดิษฐ์เผชิญ ครอบคลุมมิติสำคัญหลายประการ ได้แก่ ความเป็นส่วนตัว (privacy), ความเป็นธรรม (fairness), ความรับผิดชอบ (accountability) และ ความโปร่งใส (transparency) โดยแต่ละมิติมีตัวอย่างและผลกระทบเชิงปฏิบัติที่ชัดเจน: ระบบวิเคราะห์พฤติกรรมผู้บริโภคหรือระบบจดจำใบหน้าสามารถนำไปสู่การละเมิดข้อมูลส่วนบุคคลหรือการติดตามที่ไม่ได้รับความยินยอม ขณะที่การใช้โมเดลในงานคัดเลือกพนักงานหรือการให้สินเชื่ออาจสะท้อนอคติในข้อมูลฝึก (bias) ทำให้กลุ่มประชากรบางกลุ่มถูกกีดกัน จากกรณีศึกษาเช่นรายงานของ ProPublica (2016) เกี่ยวกับระบบประเมินความเสี่ยงทางอาญา COMPAS และกรณีของอัลกอริธึมคัดเลือกผู้สมัครของบริษัทเทคฯ ยักษ์ใหญ่ที่ถูกยกเลิกในปี 2018 ที่แสดงให้เห็นปัญหาอคติในเชิงปฏิบัติ

กรอบนโยบายสากลและแนวปฏิบัติของอุตสาหกรรม ขณะนี้มีการพัฒนากรอบกฎหมายและแนวปฏิบัติที่หลากหลายเพื่อตอบโจทย์ความเสี่ยงของ AI ตัวอย่างเด่นคือ EU AI Act ที่ใช้หลักการแบ่งระดับความเสี่ยง (risk‑based approach) โดยกำหนดข้อห้ามสำหรับการใช้งานที่ถือว่าเป็นอันตรายร้ายแรงและข้อกำหนดความรับผิดชอบสำหรับระบบที่มีความเสี่ยงสูง (high‑risk) เช่น การตรวจสอบความเป็นไปได้ในการปฏิบัติตาม ข้อกำหนดด้านความโปร่งใส และการประเมินความเสี่ยงก่อนใช้งาน นอกจากนี้ยังมีแนวทางระหว่างประเทศ เช่น หลักการ OECD AI Principles, มาตรฐานและเฟรมเวิร์กจาก NIST (AI Risk Management Framework) รวมถึงแนวปฏิบัติของภาคอุตสาหกรรมที่มุ่งเน้นการเปิดเผยข้อมูลแบบมีมาตรฐาน (เช่น model cards, datasheets) การทำ red‑teaming และการทดสอบเชิงจริยธรรมภายในองค์กร

ความจำเป็นของการประเมินผลกระทบและการตรวจสอบอิสระ เพื่อให้การกำกับดูแลมีประสิทธิภาพ ต้องมีการดำเนินการทั้งในระดับก่อนนำไปใช้และหลังการใช้งาน (pre‑deployment and post‑market monitoring) นโยบายที่มีประสิทธิภาพมักกำหนดให้ต้องจัดทำ AI impact assessment หรือการประเมินผลกระทบต่อสิทธิมนุษยชนและความเป็นส่วนตัว (เช่น Data Protection Impact Assessment ภายใต้ GDPR) สำหรับระบบที่มีความเสี่ยงสูง และสำหรับบางระบบอาจต้องผ่านการตรวจสอบโดยบุคคลที่สาม (independent audits / conformity assessments) เพื่อยืนยันความสอดคล้องกับข้อกำหนดด้านความปลอดภัย ความยุติธรรม และความโปร่งใส การตรวจสอบอิสระยังรวมถึงการทดสอบเชิงเทคนิค การตรวจสอบข้อมูลฝึก การประเมินผลกระทบทางสังคม และการตรวจสอบการใช้งานจริง (real‑world performance)

การสร้างสมดุลระหว่างนวัตกรรมกับการคุ้มครองสาธารณะ เป็นความท้าทายเชิงนโยบายที่สำคัญ: หากกฎระเบียบเข้มงวดเกินไป อาจทำให้การพัฒนาและการลงทุนยุติหรือย้ายไปยังเขตอำนาจที่มีการกำกับดูแลผ่อนคลาย แต่หากปล่อยให้เปิดเสรีเกินไป สาธารณชนอาจถูกเปิดรับความเสี่ยงด้านสิทธิและความปลอดภัย ผลลัพธ์ที่ดีที่สุดมาจากแนวทางผสมผสานที่ใช้หลักการต่อไปนี้: ใช้แนวทางแบบแบ่งระดับความเสี่ยง (risk‑based regulation), จัดตั้ง sandbox สำหรับทดสอบนวัตกรรมภายใต้การกำกับดูแล, ส่งเสริมมาตรฐานสากลเพื่อให้เกิดความชัดเจนทางเทคนิค, และส่งเสริมความร่วมมือระหว่างภาครัฐ ภาคธุรกิจ และภาคประชาสังคม เพื่อให้การคุ้มครองสาธารณะและการส่งเสริมนวัตกรรมเดินไปด้วยกันได้

ข้อเสนอเชิงปฏิบัติสำหรับภาคธุรกิจ ได้แก่ การบูรณาการหลักการ privacy‑by‑design และ ethics‑by‑design ตั้งคณะกรรมการกำกับดูแล AI ระดับองค์กร ดำเนินการประเมินความเสี่ยงและ impact assessment อย่างเป็นระบบ จัดทำเอกสารความโปร่งใสของโมเดล (model cards) และยินยอมให้มีการตรวจสอบโดยบุคคลที่สามเมื่อจำเป็น การลงทุนในกระบวนการตรวจสอบภายในและภายนอกไม่เพียงแต่ช่วยลดความเสี่ยงทางกฎหมายเท่านั้น แต่ยังสร้างความเชื่อมั่นแก่ผู้ใช้และผู้มีส่วนได้ส่วนเสีย ซึ่งเป็นปัจจัยสำคัญต่อการเติบโตอย่างยั่งยืนของเทคโนโลยี AI

อนาคตเป็นอย่างไร: สถานการณ์เชิงสภาพ (Scenario Planning)

อนาคตเป็นอย่างไร: สถานการณ์เชิงสภาพ (Scenario Planning)

การวางแผนเชิงสภาพ (scenario planning) ช่วยองค์กรและผู้กำหนดนโยบายมองภาพความเป็นไปได้ของอนาคต AI โดยอาศัยสองแกนหลักที่กำหนดทิศทาง ได้แก่ ระดับการกระจาย/รวมศูนย์ของเทคโนโลยี และ ระดับการควบคุมโดยมนุษย์ ผลจากการผสมแกนทั้งสองสามารถนำไปสู่สี่สถานการณ์หลักที่มีผลต่อเศรษฐกิจ สังคม และการกำกับดูแล: โลกเสริมพลังมนุษย์ (Human-Augmentation), โลกที่องค์กรขนาดใหญ่เป็นผู้ครอบงำ, โลกที่มีการแบ่งแยกตามนโยบายประเทศ (fragmented), และโลกที่เทคโนโลยีก้าวล้ำเกินการควบคุม (runaway). สถานการณ์เหล่านี้ไม่ใช่พยากรณ์ที่แน่นอน แต่เป็นกรอบวิเคราะห์เพื่อสังเกตสัญญาณเชิงบ่งชี้และวางแผนเชิงกลยุทธ์ล่วงหน้า

1) โลกเสริมพลังมนุษย์ (Human-Augmentation)

ลักษณะเด่น: เทคโนโลยี AI ถูกพัฒนาในรูปแบบที่เน้นเสริมศักยภาพมนุษย์—จากระบบช่วยตัดสินใจ (decision support) ไปจนถึงการผสานประสาทกับคอมพิวเตอร์ (BCI) และเครื่องช่วยเพิ่มประสิทธิภาพแรงงาน ผลลัพธ์คือการเพิ่มทักษะ การขยายขอบเขตงาน และการกระจายการเข้าถึงเทคโนโลยีมากขึ้นโดยยังคงมีมนุษย์เป็นผู้ควบคุมขั้นสุดท้าย

สัญญาณเชิงบ่งชี้:

- การลงทุนในเครื่องมือเพิ่มประสิทธิภาพการทำงาน (AI copilots, AR/VR, BCI) สูงขึ้นพร้อมตัวชี้วัดผลผลิตที่เพิ่มขึ้น เช่น การสำรวจระบุว่าผู้ใช้งาน AI copilots รายงานการเพิ่มประสิทธิภาพงาน 20–40%*

- นโยบายการใช้ AI เน้นความโปร่งใสและการมีส่วนร่วมของผู้ใช้ (human-in-the-loop)

- การศึกษาฝึกอบรมด้านทักษะ AI ขยายตัวทั้งในภาครัฐและเอกชน

แนวทางเตรียมความพร้อมเชิงกลยุทธ์:

- องค์กรควรลงทุนในโครงการนำร่อง (pilot) เพื่อทดสอบ AI ในการเสริมงานสำคัญ พร้อมกรอบวัดผล (KPIs) ที่ชัดเจน

- พัฒนานโยบายแรงงานและการฝึกอบรมที่เน้นการยกระดับทักษะ (reskilling/upskilling)

- ผู้กำหนดนโยบายควรกำกับดูแลแบบส่งเสริมด้วยมาตรฐานด้านความปลอดภัยและจริยธรรม เช่น ข้อกำหนด human-in-the-loop และการประเมินผลกระทบทางสังคม

2) โลกที่ควบคุมโดยองค์กรขนาดใหญ่ (Corporate-Controlled)

ลักษณะเด่น: แพลตฟอร์มและผู้ให้บริการคลาวด์รายใหญ่ควบคุมโครงสร้างพื้นฐาน AI สำคัญ ทั้งโมเดลขั้นสูง ข้อมูลขนาดใหญ่ และการจัดส่งบริการ ทำให้เกิดความรวมศูนย์ของพลังทางเศรษฐกิจและข้อมูล การตัดสินใจเชิงนโยบายและธุรกิจหลายอย่างถูกขับเคลื่อนโดยกลุ่มผู้เล่นรายใหญ่

สัญญาณเชิงบ่งชี้:

- การควบรวมกิจการและการผูกขาดด้านเทคโนโลยีเพิ่มขึ้น เช่น ผู้ให้บริการคลาวด์และเจ้าของโมเดลภาษาขนาดใหญ่ขยายครอบคลุมทั้งฮาร์ดแวร์ ซอฟต์แวร์ และบริการ

- การเข้าถึงข้อมูลเชิงลึกถูกจำกัดด้วยข้อกำหนดด้านสิทธิ์และค่าบริการ ทำให้สตาร์ทอัพรายเล็กเข้าถึงยากขึ้น

- นโยบายภาครัฐมีการประสานงานกับองค์กรขนาดใหญ่เพื่อแลกกับการลงทุนโครงสร้างพื้นฐาน

แนวทางเตรียมความพร้อมเชิงกลยุทธ์:

- องค์กรขนาดกลางและรัฐบาลควรผลักดันนโยบายการเปิดข้อมูลเชิงพื้นฐาน (open data) และมาตรฐานกลาง (interoperability)

- ส่งเสริมการแข่งขันผ่านมาตรการต่อต้านการรวมศูนย์ที่เป็นอุปสรรคต่อนวัตกรรม และสนับสนุนโครงการวิจัยอิสระ

- องค์กรธุรกิจต้องวางกลยุทธ์การเป็นพันธมิตร (partner ecosystem) และพิจารณา multi-cloud/heterogeneous stack เพื่อลดความเสี่ยงการผูกขาด

3) โลกที่แบ่งแยกตามนโยบายประเทศ (Fragmented)

ลักษณะเด่น: ประเทศต่าง ๆ ออกกฎระเบียบและมาตรฐานที่แตกต่างกันเกี่ยวกับการใช้ AI (เช่น การห้ามบางเทคโนโลยี การคุมเข้มด้านการส่งออกชิปหรือข้อมูล) ส่งผลให้เกิด “เขตข้อมูล” ทางเทคโนโลยีที่แบ่งแยกกัน ทั้งทางการค้า ความเป็นส่วนตัว และความปลอดภัยไซเบอร์

สัญญาณเชิงบ่งชี้:

- การผ่านกฎหมายที่มีความเข้มงวดต่างกัน เช่น กรณี EU AI Act เทียบกับมาตรการควบคุมข้อมูลของประเทศอื่น ๆ

- ข้อจำกัดการส่งออกเทคโนโลยีสำคัญ (เช่น ชิป AI) และการคว่ำบาตรด้านเทคโนโลยี

- ห่วงโซ่อุปทาน AI ถูกแบ่งเป็นโซนภูมิภาค ทำให้เกิดราคาผันผวนและความล่าช้าในการติดตั้งโครงสร้างพื้นฐาน

แนวทางเตรียมความพร้อมเชิงกลยุทธ์:

- องค์กรข้ามชาติควรพัฒนา “ข้อกำหนดสอดคล้องหลายเขต” (multi-jurisdiction compliance) และออกแบบผลิตภัณฑ์ที่สามารถปรับให้เข้ากับกฎท้องถิ่นได้

- ผู้กำหนดนโยบายควรเร่งตัวกลางการเจรจาระหว่างประเทศเพื่อหามาตรฐานร่วมที่ลดความเสี่ยงเชิงภูมิรัฐศาสตร์ แต่ยังคงปกป้องความมั่นคงและสิทธิมนุษยชน

- ลงทุนในความยืดหยุ่นของห่วงโซ่อุปทาน เช่น การสำรองแหล่งชิปและศูนย์ข้อมูลในหลายภูมิภาค

4) โลกที่เทคโนโลยีล้ำหน้าเกินการควบคุม (Runaway/Unbounded)

ลักษณะเด่น: การพัฒนาโมเดล AI ขั้นสูงก้าวหน้าอย่างรวดเร็วจนเกิดระบบที่ทำงานอย่างอัตโนมัติและตัดสินใจได้เองในระดับกว้าง ส่งผลให้การกำกับดูแลตามเดิมตามไม่ทัน ความเสี่ยงทั้งเชิงเทคนิค (failure modes), เศรษฐกิจ (การทดแทนงานในวงกว้าง) และเชิงความปลอดภัย (misuse, adversarial use) เพิ่มขึ้นอย่างมีนัยสำคัญ

สัญญาณเชิงบ่งชี้:

- การเปิดตัวโมเดลที่มีขนาด/ขีดความสามารถสูงอย่างรวดเร็วโดยไม่มีกรอบการทดสอบความปลอดภัยครบถ้วน

- เหตุการณ์ด้านความปลอดภัยหรือการนำไปใช้ในทางที่เป็นอันตราย เช่น การโจมตีอัตโนมัติ หรือการสร้างเนื้อหาที่ทำให้เกิดความเสียหายระบบกว้าง

- การตีความเชิงจริยธรรมหรือกฎหมายตามไม่ทัน ทำให้ช่องว่างรับผิดชอบทางกฎหมายชัดเจน

แนวทางเตรียมความพร้อมเชิงกลยุทธ์:

- ผู้กำหนดนโยบายต้องตั้งกรอบการทดสอบความปลอดภัยและการรับรองก่อนการเปิดใช้เชิงพาณิชย์ (safety certification) รวมถึงมาตรการตรวจสอบด้านอำนาจการตัดสินใจของโมเดล

- องค์กรควรออกแบบระบบสำรองและมาตรการหยุดการทำงานฉุกเฉิน (kill switches) พร้อมทีมตอบโต้เหตุการณ์ทางไซเบอร์ที่มีความเชี่ยวชาญเฉพาะด้าน

- ส่งเสริมความร่วมมือระหว่างภาครัฐ ภาคเอกชน และชุมชนนักวิจัยในการแบ่งปันข้อมูลเหตุการณ์ไม่พึงประสงค์และการพัฒนามาตรฐานความปลอดภัยร่วม

สัญญาณเตือนร่วมและโอกาสเชิงกลยุทธ์

- สัญญาณเตือนร่วม: การเพิ่มขึ้นของเหตุการณ์ผิดพลาดเชิงระบบ, ความล่าช้าในการออกกฎหมายที่ทันเหตุการณ์, การรวมศูนย์ข้อมูล/อำนาจในมือผู้เล่นไม่กี่ราย และความตึงเครียดระหว่างประเทศเรื่องการควบคุมเทคโนโลยี

- โอกาสเชิงกลยุทธ์: องค์กรที่ลงทุนในความโปร่งใส การยืดหยุ่นของห่วงโซ่อุปทาน และการพัฒนา workforce strategy จะได้เปรียบ นอกจากนี้ ผู้กำหนดนโยบายที่ริเริ่มมาตรฐานร่วมและระบบการรับรองจะสามารถชี้นำการพัฒนา AI อย่างสร้างสรรค์และปลอดภัย

สรุปคือ การเตรียมพร้อมต้องครอบคลุมทั้งการเฝ้าระวังสัญญาณเชิงบ่งชี้ การลงทุนในความยืดหยุ่นของระบบ และการสร้างความร่วมมือระหว่างภาคส่วนต่าง ๆ ไม่ว่าปลายทางจะเป็นโลกแบบใด—การมีชุดเครื่องมือทางนโยบายและกลยุทธ์ที่ชัดเจนจะช่วยลดความเสี่ยงและเปลี่ยนความท้าทายเป็นโอกาสเชิงเศรษฐกิจและสังคม

คำแนะนำเชิงปฏิบัติ: สิ่งที่องค์กรและผู้ใช้งานควรทำวันนี้

คำแนะนำเชิงปฏิบัติ: สิ่งที่องค์กรและผู้ใช้งานควรทำวันนี้

เพื่อเตรียมความพร้อมรับมือกับผลกระทบของ AI องค์กรควรเริ่มจากการเปลี่ยนแนวคิดจากการมองว่า AI เป็นแค่เทคโนโลยีไปสู่การมองเป็นส่วนหนึ่งของระบบการทำงานที่ต้องมีการกำกับดูแล ตรวจสอบ และพัฒนาอย่างต่อเนื่อง สิ่งที่ต้องดำเนินการทันทีได้แก่การประเมินความเสี่ยงเชิงระบบ การเสริมสร้างทักษะของบุคลากร และการออกแบบกระบวนการที่มี human-in-the-loop เพื่อให้การใช้ AI สอดคล้องกับมาตรฐานจริยธรรม ความปลอดภัย และเป้าหมายทางธุรกิจ

AI impact assessment และ audit ควรถูกกำหนดเป็นกระบวนการเชิงระบบที่ทำเป็นประจำ ไม่ใช่กิจกรรมทำครั้งเดียว รายการงานที่แนะนำประกอบด้วยการแม็ปข้อมูล (data lineage) ระบุจุดเสี่ยงด้านความเป็นส่วนตัวและความลำเอียง (bias) ประเมินผลกระทบต่อผู้มีส่วนได้เสีย และกำหนดดัชนีชี้วัด (KPIs) ด้านความถูกต้อง ความปลอดภัย และการปฏิบัติตามข้อกำหนด ตัวอย่างแนวปฏิบัติ เช่น การจัดให้มีการตรวจสอบโมเดลภายในทุกไตรมาส การเก็บบันทึกการตัดสินใจของระบบ (decision logs) และการใช้เอกสารประกอบโมเดลเช่น model card หรือ datasheet เพื่อความโปร่งใสต่อผู้ควบคุมและผู้ตรวจสอบภายนอก

AI literacy และการ upskilling เป็นหัวใจของการเปลี่ยนผ่านที่ยั่งยืน การสำรวจในภาคอุตสาหกรรมชี้ให้เห็นว่าการลงทุนในทักษะทำให้การนำเทคโนโลยีใหม่ ๆ ไปใช้เกิดประสิทธิผลมากขึ้น ดังนั้นควรออกแบบโปรแกรมฝึกอบรมหลายระดับ ตั้งแต่ความเข้าใจพื้นฐานสำหรับผู้บริหาร ไปจนถึงการฝึกปฏิบัติสำหรับทีมพัฒนาและทีมปฏิบัติการ โดยมีการวัดผลเป็นระยะ เช่น การทดสอบความเชี่ยวชาญ (competency assessment) และการติดตามการย้ายงาน (role transition) นอกจากนี้ ควรจัดงบประมาณเพื่อโครงการรีสกิล/อัพสกิล โดยเฉพาะสำหรับกลุ่มงานที่เสี่ยงต่อการถูกแทนที่หรือเปลี่ยนบทบาท

การนำหลักการ human-in-the-loop และ multi-stakeholder governance มาใช้ จะช่วยลดความเสี่ยงจากการตัดสินใจอัตโนมัติที่ไม่โปร่งใสหรือไม่ถูกต้อง ควรกำหนดจุดที่ต้องมีการตรวจสอบมนุษย์ (human checkpoints) เช่น การอนุมัติที่มีผลกระทบรุนแรงต่อผู้ใช้งาน การทบทวนกรณีข้อพิพาท และการสอบทานผลลัพธ์ที่เบี่ยงเบนจากปกติ การตั้งคณะกรรมการจริยธรรม (ethics board) ที่ประกอบด้วยตัวแทนจากหลายฝ่ายทั้งภายในและภายนอกองค์กร จะช่วยให้การกำหนดนโยบายและการตัดสินใจมีมุมมองที่หลากหลายและสมดุล

เช็คลิสต์การดำเนินการเชิงปฏิบัติ (Immediate)

- จัดทำ AI Impact Assessment — ระบุระบบ AI ทั้งหมด สำรวจข้อมูลนำเข้า ผลลัพธ์ที่เป็นไปได้ และผู้ได้รับผลกระทบ

- แผนการ audit — กำหนดความถี่ (เช่น รายไตรมาส) ผู้รับผิดชอบ และเกณฑ์การประเมิน

- ตั้งคณะกรรมการจริยธรรม — ประกอบด้วยฝ่ายธุรกิจ กฎหมาย ไอที และตัวแทนผู้ใช้งาน

- เริ่มโปรแกรม AI literacy — คอร์สพื้นฐานสำหรับผู้บริหารและคอร์สเชิงเทคนิคสำหรับทีม IT/ML

- กำหนด human checkpoints — ระบุจุดการตัดสินใจที่ต้องมีการตรวจสอบมนุษย์

กลยุทธ์ระยะสั้น (0–6 เดือน)

- ทำการสำรวจความเสี่ยงเบื้องต้นและจัดลำดับความสำคัญของระบบ AI ที่มีความเสี่ยงสูง

- เปิดคอร์สฝึกอบรมพื้นฐานเรื่อง AI, ความเป็นส่วนตัว และจริยธรรมสำหรับผู้บริหาร

- ออกนโยบายชั่วคราวเกี่ยวกับการตรวจสอบและเก็บบันทึก (logging) ของโมเดล

- กำหนดมาตรการเร่งด่วนสำหรับระบบที่มีผลกระทบสูง เช่น หยุดการใช้งานชั่วคราวหากพบความเสี่ยงร้ายแรง

กลยุทธ์ระยะกลาง (6–24 เดือน)

- นำกระบวนการ audit และ impact assessment มาตรฐานมาใช้เป็นประจำ และรวมผลกับการทบทวนความเสี่ยงขององค์กร

- ติดตั้งระบบ human-in-the-loop ในกระบวนการที่ต้องการความแม่นยำสูงหรือมีผลกระทบทางกฎหมาย

- เริ่มทดลองการประเมินภายนอก (third-party audits) และเผยแพร่รายงานสรุปเพื่อความโปร่งใส

กลยุทธ์ระยะยาว (>24 เดือน)

- บูรณาการ governance ของ AI เข้ากับการกำกับดูแลองค์กรทั้งระบบ รวมถึงรอบการทบทวนกลยุทธ์ธุรกิจ

- ลงทุนนวัตกรรมด้านการอธิบายผล (explainability) และการตรวจจับการเบี่ยงเบนของโมเดลแบบเรียลไทม์

- สร้างเครือข่าย multi-stakeholder ร่วมกับภาคประชาสังคม หน่วยงานกำกับดูแล และพันธมิตรทางธุรกิจ เพื่อกำหนดมาตรฐานร่วมกัน

- ออกแบบแผนการเปลี่ยนผ่านแรงงานอย่างยั่งยืน (transition pathways) เพื่อรองรับการเปลี่ยนแปลงของบทบาทงานและรักษาความสามารถในการแข่งขัน

การนำแนวทางข้างต้นไปปฏิบัติจำเป็นต้องมีการวัดผลอย่างสม่ำเสมอ ตัวชี้วัดที่แนะนำได้แก่อัตราความผิดพลาดของระบบ (error rate), ระยะเวลาเฉลี่ยในการตรวจจับและแก้ไขปัญหา (MTTR), อัตราการสำเร็จของโปรแกรม upskilling และระดับความพึงพอใจของผู้มีส่วนได้ส่วนเสีย การผสานทั้งการประเมินความเสี่ยง การพัฒนาแรงงาน และการออกแบบระบบที่มีมนุษย์เป็นส่วนร่วม จะทำให้องค์กรสามารถใช้ประโยชน์จาก AI ได้อย่างรับผิดชอบและยั่งยืน

บทสรุป

AI ไม่ใช่สิ่งเดียวที่จับต้องได้ในรูปแบบเดียว แต่เป็นชุดของเทคโนโลยี—รวมถึงโมเดลการเรียนรู้เชิงลึก ระบบอัตโนมัติ และเครื่องมือการประมวลผลภาษาธรรมชาติ—ที่มีทั้งข้อดีและข้อจำกัด การประเมินประสิทธิภาพต้องพิจารณาทั้งบริบทเชิงเทคนิค สังคม และนโยบาย ตัวอย่างเช่น ระบบแชทอัตโนมัติอาจเพิ่มประสิทธิภาพการให้บริการได้แต่ก็มีข้อจำกัดด้านความแม่นยำและความลำเอียง งานวิจัยและการสำรวจหลายฉบับชี้ให้เห็นว่าการนำ AI มาใช้เพิ่มขึ้นอย่างต่อเนื่องในองค์กรทั่วโลก แต่ผลลัพธ์จะแตกต่างกันตามการออกแบบ การทดสอบเชิงประจักษ์ และกรอบกติกาทางสังคมที่รองรับ

เพื่อกำหนดอนาคตของ AI อย่างชาญฉลาด จำเป็นต้องเตรียมพร้อมเชิงนโยบาย ลงทุนในทักษะของแรงงาน และออกแบบระบบที่คำนึงถึงความยุติธรรม ความโปร่งใส และความรับผิดชอบ การกำหนดมาตรฐาน การกำกับดูแลเชิงนโยบายที่สมดุล และการพัฒนาหลักสูตรฝึกอบรมจะเป็นกุญแจสำคัญไปพร้อมกับการออกแบบเทคโนโลยีที่ลดอคติและเพิ่มการตรวจสอบย้อนกลับ ในมุมมองอนาคต ประเทศและภาคธุรกิจที่ผสานนโยบายที่ชัดเจน การลงทุนด้านทักษะ และการออกแบบที่รับผิดชอบจะสามารถเก็บเกี่ยวผลประโยชน์จาก AI ได้มากที่สุด ในขณะที่สังคมต้องเตรียมรับมือกับการเปลี่ยนแปลงด้านงานและความเสมอภาคผ่านการร่วมมือระหว่างภาครัฐ ภาคเอกชน และภาคประชาสังคม

📰 แหล่งอ้างอิง: National Catholic Register