ในยุคที่โรงงานอุตสาหกรรมแข่งขันด้วยความต่อเนื่องของการผลิตและความน่าเชื่อถือของเครื่องจักร การหยุดทำงานโดยไม่คาดคิด (unplanned downtime) อาจก่อให้เกิดความสูญเสียที่สูงถึงหลายแสนถึงล้านบาทต่อชั่วโมงตามขนาดของโรงงาน เทคโนโลยี Edge LLMs ขนาดเล็กที่สามารถฝังบนเซ็นเซอร์และอุปกรณ์ขอบเครือข่าย (edge devices) กำลังเปลี่ยนโฉมหน้าการบำรุงรักษาแบบเชิงคาดการณ์ (predictive maintenance) โดยให้การประมวลผลเชิงตรรกะและการอธิบายผลแบบเรียลไทม์ใกล้กับแหล่งข้อมูล ทำให้ลดความหน่วง ลดการส่งข้อมูลขึ้นคลาวด์ และตอบสนองต่อสัญญาณผิดปกติได้ภายในมิลลิวินาทีถึงไม่กี่วินาที

บทความนี้จะวิเคราะห์สถาปัตยกรรมและกรณีใช้งานของ Edge LLMs ขนาดเล็กสำหรับงาน predictive maintenance โดยครอบคลุมตั้งแต่โมเดลฝังตัวบนเซ็นเซอร์ การประสานงานกับเกตเวย์และคลาวด์ ไปจนถึงกลไกการแจ้งเตือนเชิงบริบท เราจะนำเสนอสถิติและตัวอย่างเชิงตัวเลข เช่น การลด downtime ได้ในระดับ 30–50% ในการทดลองเชิงอุตสาหกรรมบางกรณี การประหยัดแบนด์วิดท์สูงถึง 70–90% เมื่อย้ายการตัดสินใจไปยัง edge และการลดต้นทุนการบำรุงรักษาได้ราว 20–40% ทั้งยังแสดงให้เห็นผลลัพธ์ที่เป็นไปได้จากการปรับใช้โมเดลขนาดเล็กที่ผ่านการปรับแต่ง (quantization & pruning)

นอกจากนี้เราจะสรุปปัจจัยสำคัญที่ควรพิจารณาก่อนการนำไปใช้งานจริง ทั้งขนาดและประสิทธิภาพของโมเดล พลังงานและข้อจำกัดด้านฮาร์ดแวร์ นโยบายความเป็นส่วนตัวและความปลอดภัยของข้อมูล การบูรณาการกับระบบ OT/SCADA การจัดการ false positives/negatives และกลยุทธ์การอัปเดตโมเดลแบบต่อเนื่อง เพื่อให้ผู้บริหารโรงงานและวิศวกรสามารถประเมินผลตอบแทนการลงทุน (ROI) และความพร้อมทางเทคนิคก่อนตัดสินใจนำไปใช้จริง

แนะนำ: ทำไม Predictive Maintenance ต้องรีบปรับมาใช้ Edge LLMs

แนะนำ: ทำไม Predictive Maintenance ต้องรีบปรับมาใช้ Edge LLMs

Predictive Maintenance (PdM) กลายเป็นหัวใจสำคัญของการดำเนินงานภาคการผลิตสมัยใหม่ เพราะช่วยให้โรงงานสามารถลดการหยุดชะงักที่ไม่ได้วางแผนไว้ เพิ่มอัตราการใช้เครื่องจักร และยืดอายุการใช้งานอุปกรณ์ได้อย่างมีนัยสำคัญ งานวิจัยและกรณีศึกษาในอุตสาหกรรมชี้ว่าโรงงานที่นำ PdM มาใช้สามารถลดเวลา downtime ได้เฉลี่ย 20–40% ส่งผลให้ลดต้นทุนการผลิต การซ่อมฉุกเฉิน และความสูญเสียด้านคุณภาพของผลิตภัณฑ์ นอกจากนี้ PdM ยังช่วยปรับปรุงตัวชี้วัดทางการเงินอย่าง MTBF (mean time between failures) และ OEE (overall equipment effectiveness) ซึ่งส่งผลต่อความสามารถในการแข่งขันระยะยาว

อย่างไรก็ตาม การวิเคราะห์แบบรวมศูนย์โดยส่งข้อมูลเซ็นเซอร์ทั้งหมดขึ้นคลาวด์มีข้อจำกัดที่สำคัญสำหรับสภาพแวดล้อมการผลิตจริง ได้แก่ latency ที่อาจอยู่ในระดับหลายร้อยมิลลิวินาทีถึงวินาที การใช้แบนด์วิดท์จำนวนมากสำหรับสตรีมข้อมูลความถี่สูง และประเด็นด้านความเป็นส่วนตัวหรือความลับทางการผลิตเมื่อข้อมูลถูกส่งออกนอกไซต์ โรงงานที่ตั้งอยู่ในพื้นที่ห่างไกลหรือมีการเชื่อมต่อไม่สเถียรอาจไม่สามารถพึ่งพาการประมวลผลแบบคลาวด์เพียงอย่างเดียวได้ และการหน่วงเวลาที่เกิดขึ้นอาจทำให้การตอบสนองฉุกเฉินหรือการตัดสินใจแบบเรียลไทม์เป็นไปไม่ได้

ในบริบทนี้ Edge LLMs ขนาดเล็ก จึงกลายเป็นทางเลือกที่น่าสนใจ เพราะสามารถรันบนฮาร์ดแวร์ฝังตัวใกล้กับเซ็นเซอร์และเครื่องจักรได้โดยตรง ซึ่งทำให้การตัดสินใจด้าน PdM เป็นไปแบบ เรียลไทม์ ลดการส่งข้อมูลดิบกลับไปยังคลาวด์ และเสริมความเป็นส่วนตัวของข้อมูลภายในโรงงาน Edge LLMs เหล่านี้สามารถประมวลผลสัญญาณเชิงเวลา แปลผลความผิดปกติเป็นข้อความคำอธิบายสำหรับช่างเทคนิค หรือสรุปเหตุการณ์เพื่อใช้ในการตัดสินใจอัตโนมัติ เช่น สั่งหยุดการทำงานทันที หรือจัดลำดับความสำคัญของการบำรุงรักษา โดยไม่จำเป็นต้องเชื่อมต่อภายนอกตลอดเวลา

ข้อดีที่เห็นได้ชัดเจนของการนำ PdM มาผนวกกับ Edge LLMs ขนาดเล็ก ได้แก่:

- การลด downtime แบบทันที: การตรวจจับและตอบสนองต่อสัญญาณเตือนที่ขอบอุปกรณ์ช่วยให้สามารถป้องกันความเสียหายได้รวดเร็วขึ้น

- ลดแบนด์วิดท์และค่าใช้จ่ายด้านเครือข่าย: ส่งเฉพาะผลสรุปหรือเหตุการณ์สำคัญกลับไปยังคลาวด์ แทนการสตรีมข้อมูลดิบทั้งหมด

- เสริมความเป็นส่วนตัวและการปฏิบัติตามกฎระเบียบ: ข้อมูลเชิงลึกที่ละเอียดสามารถเก็บและประมวลผลภายในไซต์ได้ ช่วยลดความเสี่ยงด้านข้อมูลลับทางการผลิต

- ความทนทานต่อเครือข่าย: แม้การเชื่อมต่อภายนอกขัดข้อง ระบบ PdM บน Edge ยังสามารถทำงานและตัดสินใจได้ต่อเนื่อง

- การใช้งานจริงและการนำไปใช้ได้รวดเร็ว: โมเดลขนาดเล็กสามารถอัปเดตเป็นช่วง ๆ และผสานรวมกับระบบ SCADA/PLC ได้โดยไม่ต้องเปลี่ยนโครงสร้างพื้นฐานขนาดใหญ่

แม้ว่า Edge LLMs จะไม่ใช่คำตอบเดียวสำหรับทุกกรณี แต่เมื่อพิจารณาจากข้อจำกัดของการประมวลผลรวมศูนย์และความต้องการตอบสนองแบบเรียลไทม์ในสภาพแวดล้อมการผลิต การย้าย PdM มาสู่ Edge ด้วยโมเดลขนาดเล็กจึงเป็นแนวทางที่ควรรีบพิจารณาเพื่อเพิ่มความยืดหยุ่น ลดความเสี่ยง และเพิ่มประสิทธิภาพในการดำเนินงานเชิงอุตสาหกรรม

Edge LLMs ขนาดเล็กคืออะไร: แนวคิดทางเทคนิคน่าสนใจ

ภาพรวมความแตกต่างระหว่าง LLM แบบดั้งเดิมกับ Edge LLMs ขนาดเล็ก

Large Language Models (LLMs) แบบดั้งเดิมถูกออกแบบเพื่อทำงานบนคลัสเตอร์เซิร์ฟเวอร์ที่มีหน่วยความจำและพลังประมวลผลสูง โดยตัวแบบมาตรฐานมักอยู่ในระดับพันล้านถึงหมื่นล้านพารามิเตอร์และต้องการหน่วยความจำแบบ 32-bit/16-bit สำหรับการฝึกและการอนุมาน ในทางตรงกันข้าม Edge LLMs ขนาดเล็ก ถูกปรับลดทั้งด้านขนาดและความซับซ้อนเพื่อให้สามารถรันบนฮาร์ดแวร์ใกล้แหล่งข้อมูล (เช่น บนเซ็นเซอร์, พื้นที่ขอบของเครือข่าย หรืออุปกรณ์ฝังตัว) โดยยังรักษาประสิทธิภาพที่เพียงพอสำหรับงานเฉพาะ เช่น การตรวจจับความผิดปกติ (anomaly detection) สำหรับ Predictive Maintenance

ข้อแตกต่างสำคัญคือการแลกเปลี่ยนระหว่างความแม่นยำกับสภาพแวดล้อมการใช้งาน: LLM ขนาดใหญ่เน้นความสามารถทั่วไปและความแม่นยำสูง ส่วน Edge LLMs เน้น latency ต่ำ, footprint เล็ก, และ ความทนทานต่อสภาพแวดล้อมที่มีทรัพยากรจำกัด ซึ่งเหมาะกับการประมวลผลเรียลไทม์บนไอโอทีของโรงงาน

เทคนิคลดขนาดโมเดล (Model Compression) ที่สำคัญ

การทำให้ LLM เล็กลงสำหรับการใช้งานบน Edge อาศัยชุดเทคนิคหลัก ๆ ที่นิยมใช้ร่วมกัน ได้แก่

- Quantization: แปลงค่าพารามิเตอร์จาก 32-bit floating point เป็นตัวเลขจำนวนบิตต่ำกว่า เช่น 8-bit หรือ 4-bit เพื่อลดขนาดหน่วยความจำและเพิ่มความเร็วการคำนวณ ตัวอย่างเช่น 8-bit quantization มักลดพื้นที่จัดเก็บได้ประมาณ 4x เมื่อเทียบกับ 32-bit และ 4-bit อาจให้การลดขนาดสูงสุดถึง ~8x ขึ้นอยู่กับวิธีจัดเก็บและความแม่นยำที่ยอมรับได้

- Pruning: ตัดพารามิเตอร์หรือน้ำหนักที่มีผลต่อการทำนายต่ำออก (sparse pruning) ทำให้จำนวนพารามิเตอร์ลดลง เช่น การตัด 30-70% ของน้ำหนักที่ไม่สำคัญ เพื่อลดทั้งหน่วยความจำและการคำนวณ อย่างไรก็ตามประสิทธิภาพต้องได้รับการปรับจูนเพื่อชดเชยการสูญเสีย

- Knowledge Distillation: ฝึกโมเดลขนาดเล็ก (student) ให้เลียนแบบผลลัพธ์ของโมเดลขนาดใหญ่ (teacher) โดย student จะเรียนรู้ความรู้เชิงพฤติกรรมจาก teacher ซึ่งมักให้ความแม่นยำใกล้เคียงกับโมเดลใหญ่แต่ใช้พารามิเตอร์น้อยกว่า ตัวอย่างเช่น โมเดล student ที่มีขนาด 10–20% ของ teacher อาจรักษา 90–98% ของประสิทธิภาพในงานเฉพาะได้

การปรับมุมมองโมเดลให้รองรับข้อมูลเชิงเวลา (Time-series) จากเซ็นเซอร์

การนำ Edge LLMs มาใช้กับข้อมูลเซ็นเซอร์เชิงเวลา จำเป็นต้องแปลงสัญญาณอนุกรมเวลาเป็นรูปแบบที่โมเดลภาษาสามารถเข้าใจได้ เทคนิคที่มักใช้ ได้แก่:

- Temporal embeddings / Positional encodings: เพิ่มการเข้ารหัสตำแหน่งเชิงเวลาให้กับแต่ละตัวอย่างข้อมูล เช่น การใช้ relative time embedding, sin/cos positional encoding หรือ embedding ของเวลาจริงเพื่อให้โมเดลรับรู้ลำดับและช่วงห่างของเหตุการณ์

- Sliding windows และ window overlap: แปลงสตรีมข้อมูลเป็นหน้าต่าง (windows) ขนาดคงที่หรือปรับได้ พร้อมการทับซ้อน (overlap) เพื่อจับรูปแบบระยะสั้นและระยะยาว ตัวอย่างเช่น หน้าต่าง 5–60 วินาทีที่มี overlap 25–50% ช่วยลดการพลาดสัญญาณผิดปกติที่อาจเกิดข้ามขอบหน้าต่าง

- Feature extraction เบื้องต้น: ก่อนป้อนเข้า LLM อาจแปลงสัญญาณเป็นคุณลักษณะสรุป (เช่น mean, std, spectral power, FFT peaks, kurtosis) หรือใช้ตัวแปลงสภาพ (transformer encoder ขนาดเล็ก/temporal convolution) เพื่อสกัดฟีเจอร์เชิงความถี่และเชิงเวลา ซึ่งช่วยลดความยาวลำดับและเพิ่มความทนต่อสัญญาณรบกวน

- Hierarchical / multi-scale prompts: ให้โมเดลประมวลผลข้อมูลที่มีความละเอียดแตกต่างกันในหลายระดับ เช่น สรุปข้อมูลทุก 1 วินาที แล้วให้สรุปย่อยทุก 1 นาที จากนั้นให้ LLM ตีความภาพรวม ช่วยให้สามารถจับทั้ง anomaly ช่วงสั้นและแนวโน้มระยะยาวได้

การผสานกับ Lightweight Inference Engines

เพื่อนำ Edge LLMs ไปใช้จริงบนฮาร์ดแวร์โรงงาน จำเป็นต้องเลือก runtime ที่เหมาะสมและรองรับโมเดลขนาดเล็กแบบ quantized/pruned ตัวเลือกที่ใช้บ่อยได้แก่:

- TFLite (TensorFlow Lite): รองรับ quantized models และมี delegate สำหรับการเร่งฮาร์ดแวร์ เช่น NNAPI, Edge TPU ซึ่งเหมาะกับอุปกรณ์ Android/ARM

- ONNX Runtime: ใช้สำหรับรันโมเดลที่แปลงเป็น ONNX รองรับการเร่งด้วย CPU, GPU และมี optimization passes สำหรับโมเดลที่ถูก quantize

- TinyML runtimes (TensorFlow Lite Micro, microTVM, CMSIS-NN): ออกแบบสำหรับไมโครคอนโทรลเลอร์และอุปกรณ์ที่มีหน่วยความจำขนาดเล็ก (เช่น 100s KB–MB) มักใช้ร่วมกับโมเดลที่ผ่านการหนัก/ตัดแต่งและ quantize สูง

การย้ายโมเดลจากสภาพแวดล้อมการฝึกไปยัง Edge มักผ่านกระบวนการแปลง (export) และ optimize เช่น การทำ quantization-aware training หรือ post-training quantization, การทำ operator fusion และการใช้ delegate ของฮาร์ดแวร์เพื่อเร่งความเร็ว การวัดค่า latency และ throughput ควรอยู่ภายใต้ข้อจำกัดของโรงงาน — ตัวอย่างเช่น การตรวจจับ anomaly ในสายการผลิตอาจต้องการ latency ต่ำกว่า 100–500 ms

สรุปเชิงเทคนิคและข้อพิจารณาสำหรับการนำไปใช้ใน Predictive Maintenance

Edge LLMs ขนาดเล็กเป็นทางเลือกที่สมดุลระหว่างความสามารถของโมเดลภาษากับข้อจำกัดของฮาร์ดแวร์ในไซต์การผลิต การผสมผสาน quantization (8-bit/4-bit), pruning และ knowledge distillation ช่วยให้ลด footprint ได้หลายเท่า ในขณะเดียวกัน การออกแบบ input pipeline สำหรับ time-series (temporal embeddings, sliding windows, feature extraction) ช่วยให้โมเดลสามารถตีความสัญญาณจากเซ็นเซอร์เพื่อทำนายความผิดปกติได้อย่างมีประสิทธิภาพ การเลือก lightweight runtime ที่รองรับการเร่งฮาร์ดแวร์และรูปแบบ quantized เป็นปัจจัยสำคัญที่จะนำ Edge LLMs ไปสู่การใช้งานจริงในสภาพแวดล้อมโรงงานได้อย่างปลอดภัยและเรียลไทม์

สถาปัตยกรรมระบบ: จากเซ็นเซอร์สู่การตัดสินใจเรียลไทม์

สถาปัตยกรรมระบบ: จากเซ็นเซอร์สู่การตัดสินใจเรียลไทม์

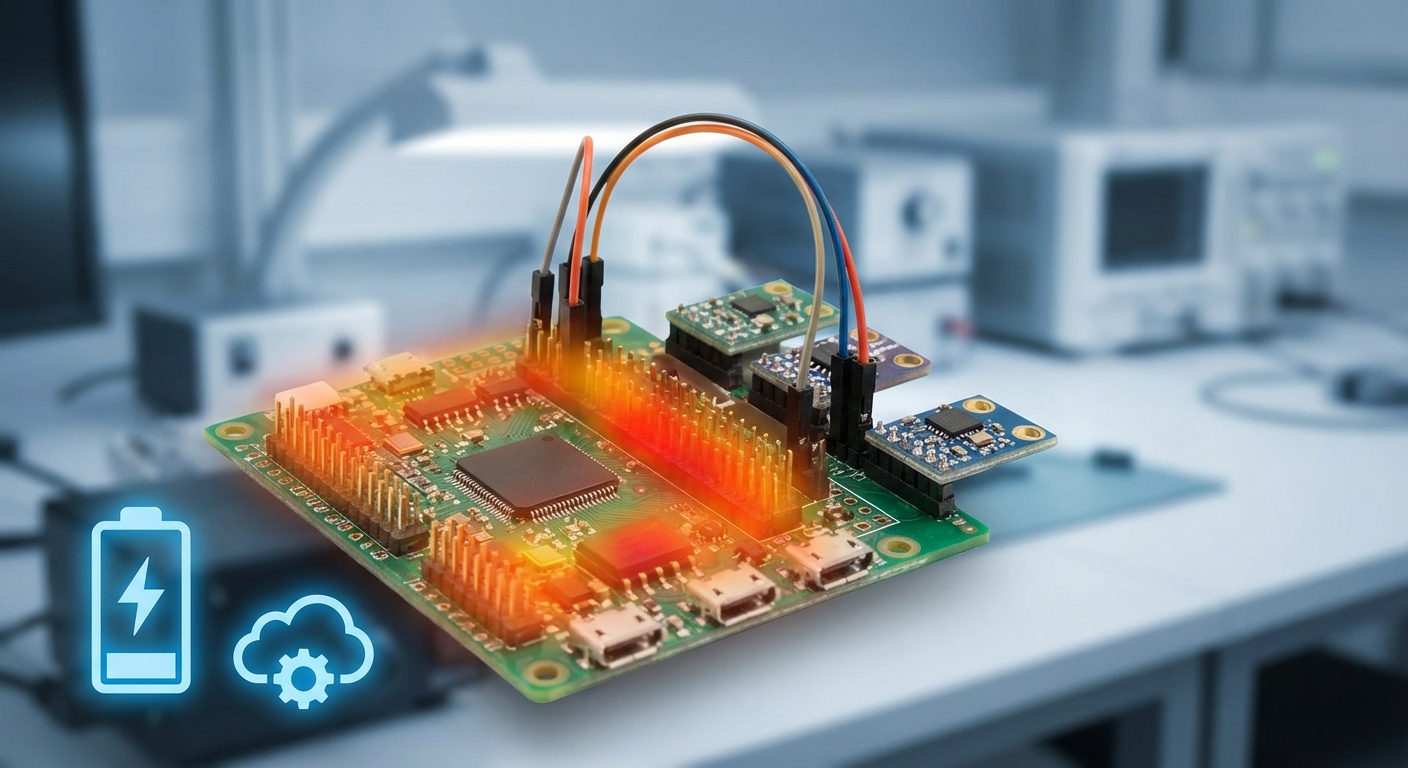

สถาปัตยกรรมที่แนะนำสำหรับการรัน Edge LLMs ขนาดเล็กเพื่อใช้ในงาน Predictive Maintenance ประกอบด้วยเลเยอร์เชิงลำดับชั้นตั้งแต่เซ็นเซอร์โดยตรงจนถึงคลาวด์สำหรับการฝึกและอัปเดตโมเดล โดยคำนึงถึงข้อจำกัดด้านพลังงาน ความหน่วง (latency) และแบนด์วิดท์ การออกแบบต้องแบ่งหน้าที่อย่างชัดเจนระหว่าง Embedded Preprocessing, On-device Inference, และ Gateway Aggregation เพื่อให้การตอบสนองต่อสัญญาณเตือนเป็นไปอย่างรวดเร็วและมั่นคง

โฟลว์ข้อมูลพื้นฐานแบ่งเป็นขั้นตอน: เซ็นเซอร์เก็บสัญญาณ (vibration, temperature, acoustic, current) → การประมวลผลเบื้องต้นบนอุปกรณ์ (filtering, FFT, feature extraction, compression) → การสรุปผลด้วย Edge LLM/โมเดลขนาดเล็กบนอุปกรณ์ → การกระทำทันทีหรือส่งเหตุการณ์ไปยัง Gateway สำหรับการตัดสินใจเชิงบริบทเพิ่มเติม → ส่งเฉพาะข้อมูลที่จำเป็นไปยังคลาวด์เพื่อการเทรน/อัปเดตหรือการวิเคราะห์เชิงลึก (OTA updates) การแยกหน้าที่นี้ช่วยลดปริมาณข้อมูลที่ต้องส่งขึ้นคลาวด์ได้มาก—ในตัวอย่างเชิงปฏิบัติการสามารถลดแบนด์วิดท์ลงได้ 90–99% เมื่อส่งเฉพาะเหตุการณ์หรือเทรซที่สำคัญเท่านั้น

โดยสรุปเลเยอร์ระบบที่ควรออกแบบอย่างชัดเจนมีดังนี้

- Sensor: เซ็นเซอร์ความไวสูง sampling rate ที่เหมาะสม (ตัวอย่าง: 1–10 kHz สำหรับ vibration)

- Embedded Preprocessing: ขนาดเล็กบน MCU/MPU ทำหน้าที่ de-noise, windowing, FFT, feature extraction และ quantization เพื่อเตรียมข้อมูลให้โมเดลทำงานได้เร็วและประหยัดหน่วยความจำ

- On-device Inference (Edge LLM): โมเดล LLM ขนาดเล็กหรือโมเดลไฮบริด (classification + sequence summarization) ที่รันบน NPU/accelerator ภายในอุปกรณ์สำหรับการตัดสินใจเรียลไทม์ (เช่น การวิเคราะห์แพทเทิร์นผิดปกติ, การสร้างเหตุการณ์สรุป)

- Local Action / Gateway: การตอบสนองทันที (เช่น ตัดวงจร, ลดความเร็วเครื่องจักร) และการส่งข้อมูลสรุป/โฮสต์โมเดลเพิ่มเติมไปยัง Gateway เพื่อการรวมข้อมูลจากหลายอุปกรณ์หรือ Ensemble Decision

- Cloud (for retraining & OTA): จัดเก็บเทรซ, ทำ retraining แบบรวมศูนย์หรือ federated learning, ตรวจสอบโมเดลใหม่ และเผยแพร่ OTA updates กลับมายัง Gateways/Edge devices

ข้อได้เปรียบสำคัญของสถาปัตยกรรมนี้ ได้แก่ latency ต่ำ เนื่องจากการตัดสินใจสำคัญทำบนอุปกรณ์ปลายทางโดยไม่ต้องรอ round-trip ไปยังคลาวด์, แบนด์วิดท์ลดลง จากการส่งเพียงเหตุการณ์หรือฟีเจอร์ที่คัดกรองแล้ว, และ การตอบสนองฉับพลันต่อสัญญาณเตือน ที่สามารถลด downtime ได้อย่างมีนัยสำคัญ ในเชิงตัวเลข ตัวอย่างเช่น การตรวจจับผิดปกติและสั่งหยุดเครื่องจักรสามารถทำได้ภายในช่วง 10–100 ms บนอุปกรณ์ที่มี accelerator ขณะที่การส่งข้อมูลและการตอบกลับจากคลาวด์มักอยู่ที่ 100–300 ms ขึ้นไป (ขึ้นอยู่กับเครือข่าย)

ฮาร์ดแวร์ที่เหมาะสมต้องพิจารณาความสมดุลระหว่างประสิทธิภาพ พลังงาน และต้นทุน:

- MCU ที่รองรับ NPU ขนาดเล็ก — เช่น ซีพียู Arm Cortex-M ร่วมกับ microNPU (Arm Ethos-U series) เหมาะสำหรับโมเดลขนาดเล็กที่ต้องการพลังงานต่ำและ latency ต่ำ

- MPU ขนาดเล็กที่มี acceleration — เช่น Cortex-A ระดับ entry กับ NPU/TPU ขนาดเล็ก (Google Coral Edge TPU, NXP eIQ accelerators, หรือ NPU ของผู้ผลิตรายอื่น) เหมาะกับโมเดลที่ซับซ้อนขึ้นหรือเมื่อต้องการรันหลายงานพร้อมกัน

- อุปกรณ์เสริม/accelerator — ตัวอย่างเช่น Google Edge TPU, Intel Movidius หรือ Syntiant สำหรับ use-case ที่ต้องการ throughput สูงในการประมวลผลสัญญาณ

การออกแบบ data flow และ latency chain ควรระบุค่าประมาณเพื่อวางข้อกำหนดทาง SLA ดังนี้

- Sensor sampling: 1–10 ms (ขึ้นกับชนิดเซ็นเซอร์)

- Embedded preprocessing: 1–10 ms (filtering, FFT, feature extraction)

- On-device inference (Edge LLM): 5–100 ms (ขึ้นกับขนาดโมเดลและ hardware acceleration)

- Local action (actuator response): <10 ms ภายในวง local control

- Gateway aggregation/decision: 10–200 ms (LAN/Wi‑Fi/Ethernet latency)

- Cloud round-trip (สำหรับ non-real-time tasks): 50–300+ ms, retraining cycles: ชั่วโมงถึงวัน

สุดท้าย เป้าหมายคือการผสานกลยุทธ์เช่น model quantization (8/4-bit), pruning, knowledge distillation และ federated learning เพื่อให้โมเดล LLM ขนาดเล็กสามารถรันได้จริงบน MCU/MPU โดยยังคงความแม่นยำเพียงพอสำหรับการแจ้งเตือนเชิงป้องกัน การจัดการเวอร์ชันผ่าน OTA และการมอนิเตอร์ประสิทธิภาพแบบต่อเนื่องจะช่วยให้ระบบรักษาประสิทธิภาพและลดความเสี่ยงของ false alarms ที่อาจสร้าง downtime ไม่จำเป็น

ตัวอย่างและสถิติจากการใช้งานจริง

กรณีศึกษา A: โรงงานผลิตชิ้นส่วนยานยนต์ — ลด Downtime และ MTTR

การทดลองนำระบบ Edge LLMs สำหรับ Predictive Maintenance (PdM) ไปติดตั้งในสายการผลิตของโรงงานผลิตชิ้นส่วนยานยนต์ในภาคตะวันออก พบผลลัพธ์ที่ชัดเจนทั้งในเชิงเวลาทำงานและค่าใช้จ่าย ก่อนติดตั้งระบบ PdM โรงงานรายงานค่าเฉลี่ย downtime = 120 ชั่วโมงต่อปี ต่อมาหลังติดตั้งโมเดลฝังบนเซ็นเซอร์และอุปกรณ์ควบคุม ผลลัพธ์ลดลงเหลือ 75 ชั่วโมงต่อปี เทียบเป็นการลดลงประมาณ 37.5% (ประมาณ 37%).

นอกจากลด downtime แล้ว ค่าตัวชี้วัดด้านการซ่อมบำรุงสำคัญ (MTTR: Mean Time To Repair) ก็มีการปรับปรุงจากเดิมโดยเฉลี่ยจาก 4.8 ชั่วโมง ต่อเหตุการณ์ ลดลงเหลือประมาณ 3.0 ชั่วโมง ต่อเหตุการณ์ (ปรับปรุง ~37%). เมื่อคำนวณมูลค่าความเสียหายจากการหยุดสายการผลิตโดยเฉลี่ยที่ประมาณ 30,000 บาทต่อชั่วโมง พบว่าโรงงานสามารถประหยัดได้ราว 1,350,000 บาทต่อปี จากการลด downtime ตามผลการวิเคราะห์เบื้องต้นของโครงการนำร่อง.

กรณีศึกษา B: สายการผลิตอิเล็กทรอนิกส์ — ลดค่าใช้จ่ายบำรุงรักษาและเวลาตอบสนอง

ในโรงงานประกอบชิ้นส่วนอิเล็กทรอนิกส์ที่ทำโครงการนำร่อง การติดตั้ง Edge LLMs บนชุดเซ็นเซอร์สั่นสะเทือนและอุณหภูมิทำให้ระบบสามารถตรวจจับพฤติกรรมผิดปกติและส่งสัญญาณเตือนได้ทันที ผลลัพธ์เชิงตัวเงินแสดงว่า ค่าใช้จ่ายการบำรุงรักษาลดลงราว 25% เมื่อเทียบกับงบประมาณก่อนหน้า (ตัวอย่าง: ลดจาก 8,000,000 บาทต่อปี เหลือประมาณ 6,000,000 บาทต่อปี ประหยัด ~2,000,000 บาทต่อปีในตัวอย่างนำร่อง).

ในแง่การตอบสนองต่อข้อผิดพลาด (จากการตรวจจับจนถึงการแจ้งเตือนและการเริ่มปฏิบัติการแก้ไข) พบว่า เวลาตอบสนองเฉลี่ยลดลงอย่างมีนัยสำคัญ — การแจ้งเตือนที่ก่อนหน้านี้ต้องพึ่งพา cloud processing มี latency เฉลี่ย 4–6 วินาที ทำให้การตอบสนองล่าช้า ขณะที่เมื่อย้ายการประมวลผลไปยัง Edge LLMs ค่า latency สำหรับการแจ้งเตือนลดลงเหลือเฉลี่ย ต่ำกว่า 200 มิลลิวินาที ส่งผลให้ทีมบำรุงรักษาและระบบอัตโนมัติสามารถเริ่มดำเนินการได้เร็วขึ้นและลดความเสี่ยงต่อการขยายความเสียหายของอุปกรณ์.

สถิติเชิงรวมและผลจำลองเชิงกราฟ

เมื่อรวมผลจากการทดลองหลายไซต์และการจำลองในห้องปฏิบัติการ พบแนวโน้มชัดเจนดังนี้:

- Latency สำหรับการแจ้งเตือน: จากเฉลี่ย 4–6 วินาที (cloud) ลดลงเป็น <200 ms (edge) — ปรับปรุงความเร็วในการตอบสนองมากกว่า 20x ในกรณีเฉียบพลัน

- Downtime เฉลี่ยต่อปี (ตัวอย่างผสม): ลดลงประมาณ 30–40% ขึ้นกับประเภทสายการผลิตและความถี่ของเหตุขัดข้อง

- การลดค่าใช้จ่ายบำรุงรักษา: กรณีศึกษาเชิงธุรกิจแสดงการลดลงเฉลี่ย ~25% โดยมาจากการลดงานเชิงป้องกันที่ไม่จำเป็นและการตอบสนองที่มีประสิทธิภาพขึ้น

- MTTR: ปรับปรุงได้ในช่วง 25–40% ขึ้นกับการผสานระบบแจ้งเตือนแบบเรียลไทม์และเครื่องมือซ่อมอัตโนมัติ

กราฟจำลองที่แนบ (ดูภาพด้านบน) แสดงเส้นเทรนด์ของ Downtime ต่อปี และ MTTR ก่อน-หลังการติดตั้ง Edge LLMs โดยแกนนอนแสดงเวลา (ปี) และแกนตั้งแสดงชั่วโมง/ค่า MTTR กราฟจำลองนี้ช่วยเน้นให้เห็นว่าการลด latency ในการแจ้งเตือนมีผลโดยตรงต่อการลดเวลาหยุดทำงานและต้นทุนรวมของการบำรุงรักษา.

สรุป: ข้อมูลจากกรณีศึกษาแสดงให้เห็นว่า Edge LLMs ที่ฝังอยู่บนเซ็นเซอร์และอุปกรณ์คอนโทรล ช่วยให้ Predictive Maintenance ทำงานแบบเรียลไทม์ได้จริง ส่งผลให้ downtime ลดลงอย่างมีนัยสำคัญ, MTTR ดีขึ้น และ ค่าใช้จ่ายการบำรุงรักษาลดลง ซึ่งเป็นการพิสูจน์ว่าการย้ายการประมวลผลบางส่วนขึ้นสู่ Edge เป็นกลยุทธ์ที่มีประสิทธิภาพสำหรับโรงงานที่ต้องการลดความเสี่ยงด้านการผลิตและเพิ่มความต่อเนื่องในการดำเนินงาน.

ข้อควรพิจารณาเชิงเทคนิคก่อนนำไปใช้งาน

ข้อควรพิจารณาเชิงเทคนิคเบื้องต้น

ก่อนนำ Edge LLMs ขนาดเล็กไปใช้ในระบบ Predictive Maintenance ของโรงงาน จำเป็นต้องประเมินปัจจัยเชิงเทคนิคหลายด้านอย่างเป็นระบบ ทั้งเรื่องความเที่ยงตรงของโมเดลเมื่อถูกลดขนาด การจัดการพลังงานและความร้อนของอุปกรณ์ฝังตัว การทดสอบความทนทานในสภาพแวดล้อมอุตสาหกรรม รวมถึงแนวทางการอัปเดตโมเดลและการรับประกันความปลอดภัยของข้อมูล การละเลยประเด็นใดประเด็นหนึ่งอาจทำให้ผลลัพธ์เชิงปฏิบัติการไม่เป็นไปตามคาด หรือนำไปสู่ความเสี่ยงต่อการหยุดการผลิตที่สูงขึ้น

Trade-off: ขนาดโมเดลกับความแม่นยำ — Quantization และ Distillation

การลดขนาดโมเดล (model footprint) เป็นหัวใจของการย้าย LLM ไปยัง edge แต่ต้องแลกกับความแม่นยำและความสามารถในการจับสัญญาณเชิงบริบทของข้อมูลเซ็นเซอร์ ตัวอย่างเช่น การใช้ quantization สามารถลดขนาดไบนารีได้โดยทั่วไป 4x–8x (จาก FP32 → INT8/INT4) ขณะที่ distillation อาจลดจำนวนพารามิเตอร์ได้หลายเท่า (ขึ้นกับสถาปัตยกรรม) แต่ทั้งสองวิธีอาจนำไปสู่การสูญเสียความแม่นยำบางส่วน

แนวปฏิบัติที่ควรพิจารณา ได้แก่:

- กำหนดเกณฑ์ความแม่นยำขั้นต่ำ (e.g., precision/recall หรือ F1 ที่ยอมรับได้) ก่อนลดขนาดโมเดล

- ทดลองหลายระดับ quantization (e.g., INT8, INT4) และเทคนิค mixed-precision เพื่อหาจุดสมดุล

- ใช้ distillation แบบ task-specific โดยสอนโมเดลขนาดเล็กกับความรู้จากโมเดลใหญ่ด้วยชุดข้อมูลที่สะท้อนสภาพการทำงานจริงของโรงงาน

- วัดผลทั้งในแง่ offline metrics และการทดสอบเชิงปฏิบัติการ (on-device) เพื่อประเมิน degradation เช่น false negatives ในการแจ้งเตือนความล้มเหลว

การจัดการพลังงานและความร้อนของอุปกรณ์

อุปกรณ์ Edge ฝังตัวในโรงงานมักมีข้อจำกัดด้านพลังงาน (power budget) และการระบายความร้อนที่จำกัด โดยทั่วไปโหนดเซ็นเซอร์/โหนดขอบอาจมีการใช้พลังงานตั้งแต่ร้อยมิลลิวัตต์จนถึงหลายวัตต์ ขึ้นกับหน่วยประมวลผล การออกแบบต้องคำนึงถึง:

- การบริโภคพลังงานเฉลี่ยและพีค: วัดค่า power profile ในโหมด inference และเมื่อประมวลผลต่อเนื่อง เพื่อหลีกเลี่ยงการใช้พลังงานเกินงบประมาณ

- thermal throttling: ชิป embedded CPU/NPU/GPU อาจลดคล็อกเมื่ออุณหภูมิสูงเกินเกณฑ์ (โดยทั่วไป ~70–90°C) ส่งผลให้ latency เพิ่มและพฤติกรรมไม่แน่นอน

- กลยุทธ์ประหยัดพลังงาน: batch inference, duty cycling, event-driven inference (เรียกใช้เฉพาะเมื่อสัญญาณเบื้องต้นชี้ว่ามีความเสี่ยง), และการ offload งานหนักไปยัง edge gateway เมื่อจำเป็น

- การระบายความร้อนทางกายภาพ: การออกแบบฮีทซิงก์/พัดลมหรือการวางตำแหน่งที่มีการหมุนเวียนอากาศเพียงพอ โดยคำนึงถึงฝุ่น น้ำมัน และค่า IP rating ของอุปกรณ์

การทดสอบความทนทานในสภาพแวดล้อมอุตสาหกรรม

การทดสอบในห้องปฏิบัติการไม่เพียงพอ ต้องมีการทดสอบในสภาพแวดล้อมจริงหรือจำลองให้ใกล้เคียงกับเชิงสภาพการทำงานจริง เช่น การทดสอบภายใต้การสั่นสะเทือน อุณหภูมิสูง/ต่ำ ความชื้นสูง สัญญาณรบกวนไฟฟ้า (EMI) และการปนเปื้อนจากฝุ่น/ของเหลว

แนะนำให้รวมชุดการทดสอบดังนี้:

- Environmental stress testing: thermal cycling, humidity soak, vibration/shock

- EMI/EMC compliance testing เพื่อความเสถียรของการสื่อสารไร้สายและสัญญาณเซ็นเซอร์

- Long-run reliability tests (MTBF/MTTR estimate) เพื่อประเมินอัตราความล้มเหลวของฮาร์ดแวร์และซอฟต์แวร์ในระยะยาว

- Field pilot ในสายการผลิตจริงเป็นระยะ 3–6 เดือน เพื่อเก็บข้อมูลการเกิด anomaly ที่หายากและปรับพารามิเตอร์ threshold ของโมเดล

แนวทางการอัปเดตโมเดล: OTA, Federated Learning และกลยุทธ์ Rollback

การอัปเดตโมเดลเป็นเรื่องสำคัญเพื่อตอบสนองต่อการเปลี่ยนแปลงของอุปกรณ์และกระบวนการผลิต แต่ต้องวางระบบอย่างปลอดภัยและมีความน่าเชื่อถือ

- OTA (Over-The-Air) Updates: ควรมีการยืนยันความครบถ้วนของอัปเดตผ่าน digital signatures และ checksums ก่อนติดตั้ง ใช้กลไก A/B หรือ dual-slot เพื่อให้สามารถ rollback ได้ทันทีหากเวอร์ชันใหม่เกิดปัญหา

- Canary/Phased Rollout: ปล่อยอัปเดตให้กับกลุ่มเล็ก ๆ ก่อนขยายไปทั้งโรงงาน เพื่อลดความเสี่ยงจากบั๊กหรือ regression

- Versioning และ Compatibility: กำหนด contract ระหว่างโมเดลและ runtime (API, input schema) เพื่อให้สามารถโยกย้ายกลับหรือรันร่วมหลายเวอร์ชันได้

- Federated Learning: เป็นทางเลือกเมื่อต้องการเรียนรู้จากข้อมูลในหลายหน่วยโดยไม่ย้ายข้อมูลดิบไปยังศูนย์กลาง ช่วยด้านความเป็นส่วนตัวและ帯宽ลด แต่มีค่าใช้จ่ายด้านการสื่อสารสูงและต้องจัดการกับ non-iid data, stragglers และ secure aggregation

- Monitoring หลังอัปเดต: ติดตาม metric สำคัญ (inference latency, confidence distribution, anomaly rate, false alert rate) อย่างต่อเนื่อง และเตรียม SLO/SLA ที่ชัดเจน

ความปลอดภัยและความเป็นส่วนตัวของข้อมูล

ระบบ Predictive Maintenance มักประมวลผลข้อมูลเชิงอุปกรณ์และกระบวนการที่มีมูลค่าสูง การออกแบบต้องครอบคลุมทั้งมาตรการด้านความปลอดภัยของฮาร์ดแวร์และซอฟต์แวร์:

- ใช้ การเข้ารหัสข้อมูล ทั้งขณะพัก (at-rest) และระหว่างการส่ง (in-transit) รวมถึงการลงนามดิจิทัลสำหรับโมเดลและแพ็กเกจอัปเดต

- วางรากฐานความเชื่อถือ (root-of-trust) ผ่าน secure boot, TPM/HSM เพื่อป้องกันการรันโค้ดที่ไม่ประสงค์ดี

- พิจารณาเทคนิค privacy-preserving เช่น differential privacy สำหรับการฝึกรวม หรือ secure aggregation ใน federated learning เพื่อลดความเสี่ยงการรั่วไหลของข้อมูลอุปกรณ์

- เตรียมแผนรับมือการโจมตีแบบ adversarial เช่นการตรวจจับ input anomaly และการทำ input sanitization เพื่อป้องกันการชี้นำโมเดล

การวัดผลและการดำเนินงานหลังใช้งาน

สุดท้าย ต้องมีระบบตรวจสอบและวัดผลแบบต่อเนื่อง (continuous evaluation) รวมถึงกระบวนการ Human-in-the-loop สำหรับการยืนยันเหตุการณ์สำคัญ เช่น การแจ้งเตือนที่อาจนำไปสู่การหยุดสายการผลิต โดยตั้ง KPI และ SLA ชัดเจน เช่น เป้าลด downtime (%) ระดับ false positive ต่อเดือน และ mean time to detect/resolve (MTTD/MTTR)

สรุปแล้ว การนำ Edge LLMs ขนาดเล็กไปใช้ใน Predictive Maintenance ต้องเข้าใจ trade-off ระหว่างความแม่นยำและขนาดโมเดล วางแผนด้านพลังงานและความร้อนอย่างรัดกุม ทดสอบในสภาพแวดล้อมจริง วางกลยุทธ์การอัปเดตอย่างปลอดภัย และสร้างมาตรการด้านความปลอดภัยและการเฝ้าระวังเชิงปฏิบัติการอย่างครบถ้วน เพื่อให้การใช้งานในโรงงานมีความมั่นคง เชื่อถือได้ และคุ้มค่าทางธุรกิจ

ผลกระทบทางธุรกิจและการวัด ROI

ผลกระทบทางธุรกิจและการวัด ROI

การนำ Edge LLM ขนาดเล็กมาใช้กับโซลูชัน Predictive Maintenance ในโรงงานมีผลกระทบเชิงธุรกิจที่จับต้องได้โดยตรง โดยเฉพาะการลดเวลา downtime ซึ่งแปลเป็นรายได้ที่ไม่สูญเสียและต้นทุนฉุกเฉินที่ลดลง ตัวอย่างเชิงตัวเลขสมมติ: หากสายการผลิตมีมูลค่าการผลิตเฉลี่ย 200,000 บาทต่อชั่วโมง และมี downtime เฉลี่ย 10 ชั่วโมงต่อเดือน (120 ชั่วโมงต่อปี) มูลค่าการสูญเสียก่อนการปรับปรุง = 200,000 x 120 = 24,000,000 บาทต่อปี หาก Edge LLM ลด downtime ได้ 40% จะประหยัดมูลค่าได้ 9,600,000 บาทต่อปี ซึ่งส่งผลโดยตรงต่อกำไรขั้นต้นและกระแสเงินสดขององค์กร

การคำนวณ ROI แบบง่าย สามารถใช้สูตรพื้นฐานเพื่อประเมินความคุ้มค่าได้ทันที เช่น

- สูตร ROI (ง่าย): ROI (%) = (ประหยัดต่อปี − ต้นทุนประจำปี) / ต้นทุนเริ่มต้นทั้งหมด × 100

- สูตร Payback Period: เวลาคืนทุน (ปี) = ต้นทุนเริ่มต้นทั้งหมด / ประหยัดสุทธิต่อปี

ยกตัวอย่างตัวเลขสมมติสำหรับโครงการขนาดกลาง: ต้นทุนฮาร์ดแวร์และเซ็นเซอร์ 250,000 บาท, ค่าแรงติดตั้งและระบบอินทิเกรชัน 100,000 บาท, ค่าใช้จ่ายบำรุงรักษาต่อปี 50,000 บาท → ต้นทุนเริ่มต้นทั้งหมด = 350,000 บาท หากการลด downtime ให้ประหยัดรายได้สุทธิ 400,000 บาทต่อปี (ก่อนหักค่าบำรุงรักษา) ประหยัดสุทธิหลังค่าบำรุงรักษา = 350,000 บาทต่อปี จะได้เวลาคืนทุน ≈ 1 ปี (12 เดือน) และ ROI ในปีแรก ≈ 100% (350,000/350,000×100) ตัวอย่างนี้สอดคล้องกับข้อสังเกตเชิงธุรกิจว่าโครงการที่ลด downtime ได้มากกว่า 30–40% มักคืนทุนภายใน 12–24 เดือน

แรงจูงใจเชิงธุรกิจเพิ่มเติม เกินกว่าตัวเงินที่วัดได้โดยตรง ได้แก่

- ความต่อเนื่องของ supply chain: การลด downtime ช่วยให้ส่งมอบสินค้าได้ตามกำหนด ลดความเสี่ยงต่อบทลงโทษตามสัญญาและการสูญเสียลูกค้า

- ภาพลักษณ์ทางคุณภาพ: ความสม่ำเสมอในการผลิตช่วยสร้างความเชื่อมั่นต่อลูกค้าและแบรนด์ โดยเฉพาะอุตสาหกรรมที่ต้องการคุณภาพต่อเนื่อง เช่น ยา อาหาร ยานยนต์

- การลดค่าใช้จ่ายฉุกเฉิน: ค่าแรงโอที ชิ้นส่วนเร่งด่วน และค่าขนส่งด่วนลดลงเมื่อปัญหาถูกคาดการณ์ล่วงหน้า

- การปฏิบัติตามกฎระเบียบด้านความปลอดภัย: การตรวจจับความผิดปกติแบบเรียลไทม์ช่วยลดความเสี่ยงเหตุไม่ปลอดภัยและสนับสนุนการปฏิบัติตามมาตรฐาน (เช่น ISO หรือกฎจากหน่วยงานความปลอดภัย)

ปัจจัยที่เร่งการตัดสินใจลงทุน ได้แก่ ความต้องการความต่อเนื่องของการผลิตโดยผู้บริหาร, ต้นทุนต่อชั่วโมงของ downtime ที่สูง, ความเข้มงวดด้านกฎระเบียบความปลอดภัย และแรงกดดันจากคู่แข่งหรือผู้ซื้อที่ต้องการความเชื่อถือได้ของอุปทาน

ข้อเสนอแนะแนวทางการเริ่มต้น: แนะนำให้เริ่มด้วยโครงการ pilot ในไลน์การผลิตที่มีความเสี่ยงสูงหรือมีค่าเสียโอกาสต่อชั่วโมงสูง เช่น สายการผลิตที่เป็นคอขวด หรืออุปกรณ์ที่เมื่อหยุดแล้วต้องใช้เวลานานในการกลับมาให้บริการ ขั้นตอนแนะนำ

- กำหนด KPI ชัดเจน: MTTR (Mean Time To Repair), MTBF (Mean Time Between Failures), ชั่วโมง downtime ต่อเดือน

- ระยะเวลา pilot: 3–6 เดือน เพื่อเก็บข้อมูลและปรับโมเดล

- เกณฑ์ความสำเร็จ: ลด downtime อย่างน้อย 30% ภายในระยะ pilot หรือการปรับปรุงความแม่นยำในการทำนายจนสามารถลดค่าใช้จ่ายฉุกเฉินลงอย่างชัดเจน

- แผนขยาย: เมื่อตัวชี้วัดสำเร็จ ให้ค่อยๆ ขยายไปยังไลน์อื่นโดยใช้บทเรียนจาก pilot เพื่อปรับค่าใช้จ่ายและโมเดลธุรกิจ

การประเมิน ROI อย่างรอบด้านควรรวมทั้งผลประโยชน์ทางการเงินที่วัดได้และผลประโยชน์เชิงกลยุทธ์ เพื่อให้การตัดสินใจลงทุนใน Edge LLM สำหรับ Predictive Maintenance ของโรงงานมีความชัดเจนและสอดคล้องกับวัตถุประสงค์ทางธุรกิจ

แนวโน้มอนาคตและบทสรุปเชิงปฏิบัติ

แนวโน้มอนาคตที่น่าจับตามอง

ทิศทางเทคโนโลยีสำหรับ Edge LLMs ในงาน Predictive Maintenance (PdM) กำลังมุ่งไปสู่การย่อส่วนโมเดล (TinyLLMs) และการเรียนรู้ต่อเนื่องบนอุปกรณ์ (on-device continual learning) เพื่อให้สามารถประมวลผลแบบเรียลไทม์บนเซ็นเซอร์หรือคอนโทรลเลอร์ได้โดยไม่พึ่งพาเครือข่ายเสมอไป เทคนิคเช่นการ quantization, pruning และ knowledge distillation ทำให้โมเดลภาษาขนาดเล็กที่มีความแม่นยำเพียงพอสำหรับการตีความสัญญาณเชิงเวลาถูกใช้งานจริงมากขึ้น ผลลัพธ์ที่คาดหวังได้คือความหน่วงเวลาต่ำขึ้น การใช้แบนด์วิดท์น้อยลง และการปกป้องความเป็นส่วนตัวของข้อมูลภาคสนาม

ในขณะเดียวกัน แนวคิดของ federated on-device learning กำลังก้าวหน้าอย่างรวดเร็ว ทำให้อุปกรณ์จำนวนมากสามารถปรับปรุงรุ่นร่วมกันโดยไม่ต้องส่งข้อมูลต้นฉบับไปยังคลาวด์ ตัวอย่างเช่น การทำ federated update สามารถลดปริมาณข้อมูลที่ส่งไปยังเซิร์ฟเวอร์กลางได้มากถึงหลักสิบเปอร์เซ็นต์ถึงมากกว่า 80% ขึ้นกับการออกแบบระบบ นอกจากนี้ การผสมผสาน Edge LLMs กับ Digital Twins จะเปิดโอกาสให้เกิดการจำลองสภาพการทำงานแบบเรียลไทม์เพื่อทดสอบฮypothesis, วิเคราะห์สาเหตุราก (root-cause analysis) และวางแผนการบำรุงรักษาเชิงคาดการณ์ที่แม่นยำยิ่งขึ้น

มาตรฐานและกรอบการกำกับดูแลที่เกี่ยวข้องก็กำลังก้าวหน้าควบคู่ไปด้วย องค์กรอุตสาหกรรมมีการยอมรับมาตรฐานเช่น OPC UA เพื่อเชื่อมโยงข้อมูล OT/IT, IEC 62443 สำหรับความมั่นคงปลอดภัยไซเบอร์ในระบบอุตสาหกรรม รวมถึงกรอบงาน AI ระดับสากลอย่าง ISO/IEC JTC 1/SC 42 และการพัฒนานโยบายของสหภาพยุโรป (EU AI Act) ที่ส่งผลต่อการกำกับดูแลโมเดล AI การปฏิบัติตามมาตรฐานเหล่านี้จะเป็นข้อพิจารณาสำคัญเมื่อยกระดับการทดลองไปสู่การใช้งานเชิงพาณิชย์

ข้อแนะนำเชิงปฏิบัติสำหรับองค์กรที่ต้องการเริ่มโครงการ Edge PdM

การเริ่มต้นโครงการ Edge PdM ด้วย Edge LLMs ควรเป็นไปอย่างเป็นขั้นเป็นตอนและมีการวัดผลชัดเจน แนะนำแนวทางดังต่อไปนี้เป็นหลักปฏิบัติที่พิสูจน์ได้ในภาคสนาม:

- ประเมินความสำคัญของทรัพย์สิน (asset criticality) — เริ่มจากการจัดลำดับความสำคัญของเครื่องจักรและอุปกรณ์ตามผลกระทบต่อการผลิต (เช่น มูลค่าการสูญเสียรายชั่วโมงเมื่อเกิด Downtime) และเลือกจุดเริ่มต้นที่ให้ผลตอบแทนลงทุนสูง (high ROI).

- ออกแบบและดำเนินการ Pilot ขนาดเล็ก — เรียกใช้โครงการนำร่องบนกลุ่มทรัพย์สินจำกัด (ตัวอย่าง 5–20 เครื่อง) เพื่อลดความเสี่ยงและพิสูจน์สมมติฐานด้านข้อมูล, ฮาร์ดแวร์ และโมเดล ตัวอย่าง KPI สำหรับ pilot ได้แก่ การลด Downtime (%), การปรับปรุง MTTR, ความแม่นยำของการพยากรณ์ (precision/recall) และปริมาณข้อมูลที่ส่งขึ้นคลาวด์

- กำหนด KPI ที่ชัดเจนและวิธีวัด — KPIs ที่สำคัญควรมีทั้งเชิงปฏิบัติ (เช่น การลด Downtime เป้าหมาย 20–40%, การลดการแจ้งเตือนผิดพลาด) และเชิงเทคนิค (latency ของการคาดการณ์ <100–500 ms สำหรับเหตุการณ์เรียลไทม์, ลดแบนด์วิดท์ลง x%, ความแม่นยำโมเดล >90% ขึ้นอยู่กับเคส)

- เชื่อมประสาน OT และ IT อย่างเป็นระบบ — การร่วมมือระหว่างทีม OT และ IT เป็นสิ่งจำเป็น ตั้งแต่การเข้าถึงข้อมูลเซ็นเซอร์ การจัดการเครือข่าย ไปจนถึงการบูรณาการกระบวนการบำรุงรักษา ควรตั้งคณะทำงานร่วม (cross-functional team) เพื่อบริหารความเสี่ยงด้านความปลอดภัยและการใช้งานจริง

- วางกลยุทธ์การจัดการโมเดลและข้อมูล — กำหนดนโยบายสำหรับเวอร์ชันของโมเดล, การอัปเดตแบบ over-the-air, การทดสอบย้อนหลัง (backtesting) และกลไก fallback เมื่อโมเดลขัดข้อง รวมถึงการบันทึก (logging) และการตรวจสอบ (monitoring) เพื่อความสามารถในการอธิบายผล (explainability)

- คำนึงถึงความมั่นคงปลอดภัยและการปฏิบัติตามข้อกำหนด — นำมาตรการเช่นการเข้ารหัสข้อมูล, การยืนยันตัวตนของอุปกรณ์, segment เครือข่าย OT/IT และปฏิบัติตามมาตรฐาน IEC 62443 และข้อบังคับข้อมูลท้องถิ่น เพื่อป้องกันความเสี่ยงจากการโจมตีหรือการรั่วไหลของข้อมูล

สรุปเชิงปฏิบัติ: การลงทุนใน Edge LLMs และสถาปัตยกรรมที่ผสานกับ Digital Twins มีศักยภาพช่วยลด Downtime และเพิ่มประสิทธิภาพการบำรุงรักษา แต่ความสำเร็จเชิงพาณิชย์ต้องการการวางแผนที่รัดกุม เริ่มจากการประเมินทรัพย์สิน การรัน pilot ขนาดเล็ก การตั้ง KPI ที่ชัดเจน และการสร้างความร่วมมือระหว่าง OT และ IT หากองค์กรสามารถผสานเทคโนโลยี TinyLLMs, federated on-device learning และ digital twin ได้อย่างเหมาะสม จะสามารถบรรลุการลด Latency, การปกป้องข้อมูล และการปรับปรุงความถูกต้องของการพยากรณ์ ซึ่งเป็นประโยชน์ทั้งเชิงปฏิบัติการและเชิงเศรษฐกิจในระยะยาว

บทสรุป

สรุปได้ว่า Edge LLMs ขนาดเล็ก มีศักยภาพในการยกระดับระบบ Predictive Maintenance ในโรงงานให้กลายเป็นการตัดสินใจแบบเรียลไทม์ โดยการรันโมเดลฝังตัวบนเซ็นเซอร์หรือเกตเวย์จะช่วยลดความล่าช้า (latency) ในการตรวจจับความผิดปกติและตอบสนองได้ทันที ส่งผลให้ downtime ลดลงอย่างมีนัยสำคัญ และลดปริมาณข้อมูลที่ต้องส่งขึ้นคลาวด์ (ประหยัดแบนด์วิดท์) ตัวอย่างเช่น โครงการนำร่องในโรงงานผลิตชิ้นส่วนรายงานการลด downtime ระหว่าง 20–50% และการลดทราฟฟิกข้อมูลขึ้นคลาวด์มากกว่า 70% เมื่อเปรียบเทียบกับสถาปัตยกรรมที่ส่งข้อมูลดิบขึ้นคลาวด์ทั้งหมด โมเดลขนาดเล็กที่ถูก quantize/prune ให้เหลือระดับสิบเมกะไบต์ถึงหลักสิบเมกะไบท์สามารถประมวลผลสัญญาณจากเซ็นเซอร์และส่งคำเตือนได้ภายในมิลลิวินาที ทำให้การตัดสินใจเชิงปฏิบัติการ (เช่น หยุดเครื่องหรือปรับพารามิเตอร์) เกิดขึ้นทันทีและลดผลกระทบต่อการผลิต

อย่างไรก็ตาม ก่อนนำไปใช้งานจริงต้องพิจารณา trade-off ระหว่างความแม่นยำและ footprint (เช่น การแลกความละเอียดของโมเดลกับขนาดหน่วยความจำและพลังงาน) และวางแผนการอัปเดตโมเดลอย่างเป็นระบบ (เช่น OTA, federated learning หรือการรีเทรนแบบเป็นชุด) เพื่อรับมือกับการเปลี่ยนแปลงสภาพแวดล้อมการผลิต การวัดผลเชิงธุรกิจควรเริ่มจากโครงการนำร่องที่กำหนด KPI ชัดเจน (MTTR, MTBF, % downtime, ค่าใช้จ่ายการบำรุงรักษา และการประหยัดแบนด์วิดท์) เพื่อตีค่า ROI ก่อนขยายสเกล ในอนาคตคาดว่า Edge LLMs จะผนวกรวมกับ digital twins, ฮาร์ดแวร์เร่งความเร็วสำหรับ TinyML และมาตรฐานความปลอดภัยข้อมูล ทำให้การบำรุงรักษาเชิงพยากรณ์มีความแม่นยำและยั่งยืนมากขึ้น พร้อมทั้งลดต้นทุนการบำรุงรักษาระยะยาวและเพิ่มความต่อเนื่องในการผลิตของภาคอุตสาหกรรม