หน่วยกำกับของไทยประกาศมาตรฐานใหม่ในชื่อ "Model Disclosure" ที่อาจเปลี่ยนโฉมหน้าการใช้ปัญญาประดิษฐ์เชิงพาณิชย์ในประเทศอย่างมีนัยสำคัญ: ผู้ให้บริการ AI จะถูกบังคับให้เปิดเผย Model‑Card รายงานอัตราการฮัลลูซิเนชัน (hallucination) และต้องผ่านชุดทดสอบความปลอดภัยก่อนนำโมเดลขึ้นให้บริการเชิงพาณิชย์ ข้อกำหนดนี้ไม่เพียงแต่เพิ่มความโปร่งใสต่อผู้ใช้และผู้กำกับดูแล แต่ยังสร้างมาตรฐานใหม่ในการประเมินความเสี่ยงและความรับผิดชอบทางกฎหมายของผลิตภัณฑ์ AI

บทนำของข่าวนี้จะสรุปประเด็นสำคัญของมาตรฐาน Model Disclosure ทั้งข้อกำหนดการเปิดเผยข้อมูลเชิงเทคนิค (Model‑Card) วิธีวัดและรายงานอัตราฮัลลูซิเนชัน รวมถึงเกณฑ์การทดสอบความปลอดภัยที่ต้องผ่านก่อนการจำหน่ายเชิงพาณิชย์ นอกจากนี้ยังชี้ให้เห็นถึงผลกระทบต่อวงการพัฒนา การตรวจรับ (certification) และความรับผิดชอบทางกฎหมายของผู้ให้บริการ AI ตั้งแต่สตาร์ทอัพจนถึงองค์กรขนาดใหญ่ ซึ่งบทความฉบับเต็มจะเจาะลึกตัวอย่างนโยบาย แนวปฏิบัติ และความท้าทายที่ผู้ประกอบการต้องเผชิญเพื่อให้เป็นไปตามมาตรฐานนี้

บทนำ: ทำไมหน่วยกำกับต้องออกมาตรฐาน 'Model Disclosure'

บทนำ: ทำไมหน่วยกำกับต้องออกมาตรฐาน 'Model Disclosure'

การขยายตัวอย่างรวดเร็วของโมเดลปัญญาประดิษฐ์เชิงสร้างสรรค์ (generative AI) และการนำไปใช้ในเชิงพาณิชย์ทั้งในภาคธุรกิจ สาธารณสุข กฎหมาย และงานบริการ ทำให้หน่วยงานกำกับต้องเผชิญกับความท้าทายใหม่ด้านความปลอดภัยและความน่าเชื่อถือ ในระดับสากลมีแรงกดดันจากกรอบนโยบาย เช่น EU AI Act แนวทางของ OECD และแนวปฏิบัติของหน่วยงานกำกับในสหรัฐอเมริกา ที่เรียกร้องให้เพิ่มความโปร่งใส (transparency) และความรับผิดชอบ (accountability) ต่อระบบที่อาจก่อความเสี่ยงต่อสาธารณะ การออกมาตรฐาน 'Model Disclosure' จึงเป็นมาตรการเชิงนโยบายที่ตอบสนองต่อบริบทนี้ โดยรวมแนวคิดเช่น Model Card ที่เสนอข้อมูลเชิงเทคนิคและเชิงนโยบายเกี่ยวกับความสามารถ ข้อจำกัด และผลการทดสอบของโมเดล เพื่อให้ผู้ใช้และหน่วยงานกำกับสามารถประเมินความเสี่ยงได้อย่างเป็นรูปธรรม

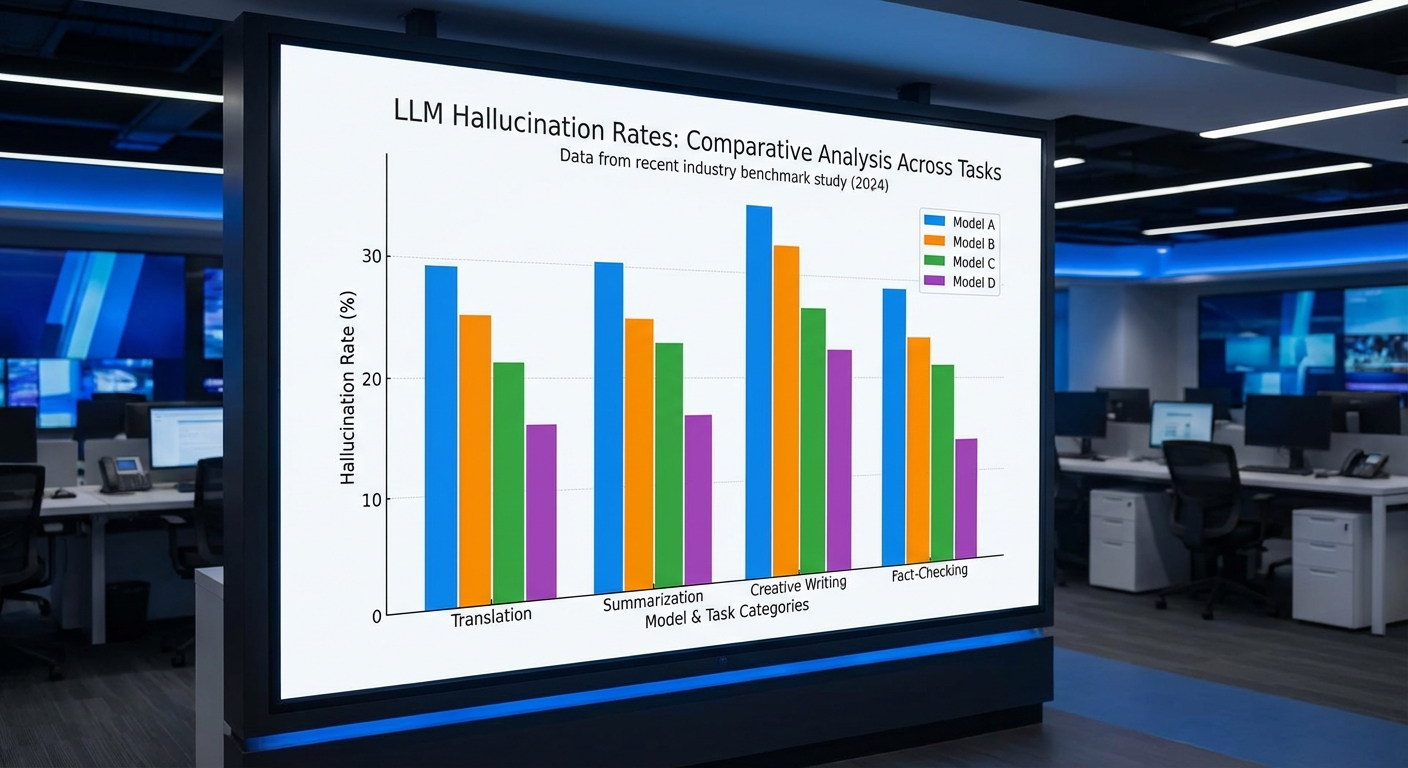

หนึ่งในเหตุผลสำคัญที่หน่วยกำกับต้องดำเนินการคือปัญหา ฮัลลูซิเนชัน (hallucination)—หรือการที่โมเดลสร้างข้อเท็จจริงเท็จหรือข้อมูลที่ไม่มีฐานสนับสนุน งานวิจัยและการทดสอบเชิงอิสระหลายฉบับรายงานอัตราการให้ข้อมูลผิดพลาดของโมเดลในระดับตั้งแต่หลักเปอร์เซ็นต์จนถึงหลักสิบเปอร์เซ็นต์ ขึ้นกับประเภทของงานและชุดทดสอบ ผลกระทบเชิงธุรกิจและสังคมอาจรุนแรง เช่น การให้คำแนะนำทางการแพทย์หรือกฎหมายที่ผิดพลาด นำไปสู่ความเสี่ยงด้านชีวิตผู้ใช้ ต้นทุนทางกฎหมาย และความเสียหายต่อชื่อเสียงขององค์กร ตัวอย่างเหตุการณ์ในต่างประเทศและกรณีศึกษาภายในประเทศเมื่อโมเดลให้ข้อมูลคลาดเคลื่อนจนเกิดความเสียหาย ยิ่งตอกย้ำความจำเป็นที่ต้องมีการรายงานอัตราฮัลลูซิเนชันเป็นตัวชี้วัดเพื่อการประเมินความเสี่ยงก่อนนำไปใช้เชิงพาณิชย์

นอกจากฮัลลูซิเนชันแล้ว มาตรฐานนี้ยังตั้งอยู่บนความกังวลเรื่อง ความปลอดภัยและความเป็นส่วนตัว เช่น ความเสี่ยงของการรั่วไหลของข้อมูล (data leakage) ความลำเอียง (bias) และช่องโหว่จากการโจมตีแบบ prompt injection / adversarial attacks หน่วยงานกำกับต้องการให้ผู้พัฒนาแสดงผลการทดสอบความปลอดภัย เช่น การทดสอบ red-teaming, การประเมินผลกระทบเชิงจริยธรรม และมาตรการควบคุมการเข้าถึงข้อมูล เพื่อให้ผู้ใช้องค์กรและผู้บริโภคตัดสินใจได้อย่างรอบคอบและลดความเสี่ยงทางกฎหมายและสังคม

มาตรฐาน 'Model Disclosure' จึงมีวัตถุประสงค์หลักเพื่อ เพิ่มความโปร่งใส สร้างความสามารถในการตรวจสอบ และกำหนดข้อกำหนดขั้นต่ำในการทดสอบก่อนการใช้งานเชิงพาณิชย์ เอกสารที่ต้องเปิดเผยรวมถึงแต่ไม่จำกัดเพียง Model Card ฉบับสมบูรณ์ รายงานอัตราฮัลลูซิเนชัน ผลการทดสอบความปลอดภัย (penetration/red-team, bias audit) และข้อมูลแหล่งที่มาของข้อมูลการฝึก (training data provenance) ขอบเขตการบังคับใช้ครอบคลุม foundation models, โมเดลที่ให้บริการผ่าน API, โมเดลที่โฮสต์บนคลาวด์ และบริการที่ปรับแต่งสำหรับลูกค้าเชิงพาณิชย์ โดยอาจมีข้อยกเว้นสำหรับโมเดลขนาดเล็กหรือการวิจัยภายในภายใต้เงื่อนไขที่เข้มงวด

สำหรับไทม์ไลน์เบื้องต้น หน่วยกำกับได้กำหนดเฟสการนำไปปฏิบัติที่เป็นธรรมชาติ ได้แก่

- ประกาศมาตรฐานและช่วงปรึกษา (0–3 เดือน): เปิดรับความคิดเห็นจากภาคอุตสาหกรรมและสาธารณะ

- ระยะเปลี่ยนผ่าน (3–12 เดือน): ให้ผู้ประกอบการเตรียมรายงาน Model Disclosure และดำเนินการทดสอบเบื้องต้น

- การบังคับใช้เต็มรูปแบบ (12–24 เดือน): เริ่มตรวจสอบการปฏิบัติตามและกำหนดบทลงโทษหรือมาตรการแก้ไขสำหรับการไม่ปฏิบัติตาม

ภาพรวมข้อกำหนดหลักของมาตรฐาน 'Model Disclosure'

ภาพรวมข้อกำหนดหลักของมาตรฐาน "Model Disclosure"

มาตรฐาน "Model Disclosure" ที่หน่วยกำกับประกาศออกมาเป็นกรอบบังคับสำหรับการเปิดเผยข้อมูลและการรับรองความปลอดภัยของโมเดลปัญญาประดิษฐ์เชิงพาณิชย์ โดยมีเป้าหมายเพื่อเพิ่มความโปร่งใส ลดความเสี่ยงด้านความปลอดภัย และสร้างความสามารถในการตรวจสอบย้อนหลัง (auditability) สำหรับเจ้าของแพลตฟอร์ม ผู้พัฒนา และหน่วยงานกำกับดูแลหลักเกณฑ์ที่สำคัญประกอบด้วยการเผยแพร่ Model‑Card ต่อสาธารณะ การรายงานอัตราฮัลลูซิเนชันตามมาตรฐานกำหนด การทดสอบความปลอดภัยและความทนทาน (safety & robustness) ก่อนนำไปใช้งานเชิงพาณิชย์ รวมถึงการเก็บรักษาประวัติการอัพเดตและบันทึก (logs) เพื่อการตรวจสอบย้อนหลัง

Model‑Card ถูกกำหนดให้เป็นเอกสารบังคับที่ต้องเผยแพร่สาธารณะและต้องครอบคลุมข้อมูลเชิงเทคนิคและเชิงบริบทอย่างชัดเจน เช่น ข้อมูลการระบุรุ่น (model ID/version), ขอบเขตการใช้งานที่แนะนำ (intended use), ข้อมูลสรุปชุดข้อมูลฝึกสอน (training data provenance) ระดับนโยบายการคัดกรองข้อมูลอ่อนไหว และรายการข้อจำกัด (limitations) ของโมเดล นอกจากนี้ Model‑Card ต้องระบุช่องว่างความเสี่ยงที่รู้จักและมาตรการบรรเทาความเสี่ยง (mitigations) เพื่อให้ผู้ใช้ธุรกิจและผู้บริโภคสามารถประเมินความเหมาะสมในการใช้งานได้อย่างรวดเร็ว

มาตรฐานกำหนดให้ต้องมีการรายงาน อัตราฮัลลูซิเนชัน (hallucination rate) เป็นมาตรวัดเชิงปริมาณที่คำนวณตามกรอบวิธีทดสอบที่ระบุไว้ในประกาศ การรายงานต้องระบุเมตริกหลัก เช่น อัตราผิดพลาดเชิงข้อเท็จจริง (factual error rate), ความไม่แน่นอน (confidence calibration) และขอบเขตตัวอย่างการทดสอบ (test sets and prompts) โดยประกาศให้นักพัฒนาแสดงวิธีการประเมินและชุดข้อมูลอ้างอิงที่ใช้เป็นหลักฐาน ตัวอย่างเชิงแนวทางอาจระบุช่วงอัตราฮัลลูซิเนชันยอมรับได้ตามประเภทงาน (เช่น 0.5–5% สำหรับงานตอบคำถามเชิงข้อเท็จจริงในระบบบริการลูกค้า) แต่หลักสำคัญคือการเปิดเผยวิธีการวัดและผลลัพธ์อย่างโปร่งใส

สำหรับ ผลทดสอบความปลอดภัย (safety & robustness) ประกาศกำหนดให้โมเดลต้องผ่านชุดการทดสอบขั้นต่ำที่ครอบคลุมการโจมตีเชิงปฏิบัติการ (adversarial attacks), การเปลี่ยนแปลงการแจกแจงข้อมูล (distribution shift), การทดสอบเชิงพฤติกรรมที่อาจนำไปสู่ความเสี่ยงต่อบุคคลหรือสังคม (safety-critical behaviour) และการประเมินผลต่อการละเมิดข้อมูลส่วนบุคคล ผลลัพธ์การทดสอบต้องแสดงว่าโมเดลเข้าสู่เกณฑ์ความเสี่ยงที่ยอมรับได้ตามประกาศก่อนจะอนุญาตให้เปิดใช้เชิงพาณิชย์ได้ หากไม่ผ่านต้องระบุการแก้ไขและทดสอบซ้ำจนกว่าจะสอดคล้องตามมาตรฐาน

มาตรฐานยังเน้นการเก็บรักษา ประวัติการอัพเดต ของโมเดลและการจัดเก็บ log เพื่อการตรวจสอบย้อนหลังโดยละเอียด ประวัติการอัพเดตต้องบันทึกการเปลี่ยนแปลงสำคัญของโมเดล (เช่น การเปลี่ยนชุดข้อมูลฝึกสอน การแก้ไขสถาปัตยกรรม หรือการปรับพารามิเตอร์) พร้อมวันที่และผู้รับผิดชอบ ขณะที่นโยบายการเก็บ log ควรกำหนดช่วงเวลาการเก็บรักษา ค่าที่ต้องบันทึก และวิธีการปกป้องข้อมูลส่วนบุคคล (เช่น การ pseudonymization หรือการเข้ารหัส) เพื่อให้สามารถสืบค้นเหตุการณ์ย้อนหลังและตอบสนองต่อเหตุการณ์ไม่พึงประสงค์ได้อย่างมีประสิทธิภาพ

ตัวอย่างฟอร์แมตการรายงานเบื้องต้นที่ประกาศแนะนำให้ใช้เป็นมาตรฐานสากล (เพื่อความสอดคล้องและความสามารถในการเปรียบเทียบ) ได้แก่ฟิลด์พื้นฐานดังนี้

- Model Identification: ชื่อโมเดล / รุ่น / รหัสภายใน

- Intended Use: นิยามการใช้งานที่แนะนำและการห้ามใช้

- Training Data Summary: แหล่งข้อมูล ขนาดกลุ่มตัวอย่าง และมาตรการคัดกรองข้อมูลอ่อนไหว

- Evaluation Metrics: อัตราฮัลลูซิเนชัน (เปอร์เซ็นต์), accuracy/F1, calibration metrics พร้อมคำอธิบายวิธีการวัด

- Safety & Robustness Tests: ผลการทดสอบ adversarial, distribution shift, stress tests พร้อมสถานะ (pass/fail) และค่าตัวชี้วัดเชิงปริมาณ

- Risk Mitigations: รายการมาตรการที่นำมาใช้ เช่น filter, post‑processing, human‑in‑the‑loop

- Update Log: รายการการเปลี่ยนแปลง (วันที่, ลักษณะการเปลี่ยนแปลง, ผู้รับผิดชอบ)

- Logging Policy: ขอบเขตข้อมูล log ที่บันทึก (timestamp, input prompt, output, confidence score, system flags), ระยะเวลาการเก็บรักษา และมาตรการคุ้มครองข้อมูลส่วนบุคคล

สรุปคือ มาตรฐาน "Model Disclosure" มุ่งบังคับให้ความโปร่งใสเชิงเทคนิคและการรับรองความปลอดภัยเป็นพื้นฐานสำหรับการนำโมเดลเข้าสู่การใช้เชิงพาณิชย์ โดยเน้นให้มี Model‑Card สาธารณะ รายงานอัตราฮัลลูซิเนชันตามมาตรฐานที่ชัดเจน ผลการทดสอบความปลอดภัยต้องผ่านเกณฑ์ที่กำหนดก่อนใช้งาน รวมถึงระบบการเก็บประวัติการอัพเดตและ log ที่เพียงพอสำหรับการตรวจสอบย้อนหลัง ซึ่งทั้งหมดนี้ช่วยยกระดับความน่าเชื่อถือและการกำกับดูแลของระบบ AI ในตลาดไทยและสากล

รายละเอียดองค์ประกอบของ Model‑Card ที่ต้องเปิดเผย

Model‑Card เป็นเอกสารสรุปที่ออกแบบมาเพื่อให้ผู้ใช้และหน่วยงานกำกับเข้าใจข้อมูลเชิงเทคนิค ความเสี่ยง และการประเมินความปลอดภัยของโมเดลอย่างชัดเจน ในมาตรฐาน 'Model Disclosure' ของหน่วยกำกับไทย จำเป็นต้องระบุองค์ประกอบหลักหลายด้านตั้งแต่ข้อมูลพื้นฐานของโมเดลไปจนถึงผลการทดสอบการใช้งานเชิงพาณิชย์ โดยแต่ละหัวข้อควรมีความชัดเจน สามารถตรวจสอบที่มาได้ และระบุเมตริกที่ใช้ในการประเมินอย่างโปร่งใส

1. ข้อมูลพื้นฐานและข้อมูลเทคนิค

ส่วนนี้ต้องเปิดเผยข้อมูลเชิงเทคนิคที่เพียงพอให้ผู้เชี่ยวชาญด้านเทคโนโลยีสามารถประเมินขอบเขตและความสามารถของโมเดลได้อย่างรวดเร็ว ประกอบด้วยรายการอย่างน้อยดังต่อไปนี้

- ชื่อรุ่น / เวอร์ชัน: ระบุชื่อทางการและหมายเลขเวอร์ชัน เช่น "ThinkLM-Base v1.2"

- สถาปัตยกรรม: ระบุชนิดของสถาปัตยกรรม (เช่น Transformer, Encoder‑Decoder, Diffusion) พร้อมคำอธิบายสั้น ๆ ขององค์ประกอบหลัก

- ขนาดพารามิเตอร์: จำนวนพารามิเตอร์ทั้งหมด (เช่น 7B, 65B จำนวนพารามิเตอร์) และขนาดของโมเดลย่อย (encoder/decoder/tokenizer)

- เวอร์ชันของซอฟต์แวร์และไลบรารี: ระบุเฟรมเวิร์ก (เช่น PyTorch 2.1, TensorFlow 2.x) และเวอร์ชันที่ใช้ในการเทรน/ประเมิน

- รูปแบบอินพุต/เอาต์พุต: รองรับรูปแบบข้อมูลใดบ้าง เช่น ข้อความ, รูปภาพ, เสียง, หรือ multi‑modal

- สิทธิ์การใช้งาน: ระบุไลเซนส์เชิงพาณิชย์และข้อจำกัดการใช้งาน

2. ข้อมูลชุดข้อมูล (Data provenance และการคัดกรอง)

การเปิดเผยแหล่งที่มาของข้อมูลเป็นหัวใจสำคัญของความโปร่งใส ควรสรุปข้อมูลชุดข้อมูลที่ใช้ทั้งในขั้น pretraining และ fine‑tuning ดังรายละเอียด:

- ที่มาของชุดข้อมูล: ระบุชื่อแหล่ง (เช่น เว็บสแครป, คอร์ปัสหนังสือ, โค้ดสาธารณะ, ฐานข้อมูลเฉพาะ) พร้อมลิงก์หรือการอ้างอิงถ้าเป็นสาธารณะ

- ขนาดและสัดส่วน: ระบุจำนวนตัวอย่าง หน่วยวัด (เช่น 300B tokens, 2M documents) และสัดส่วนแยกตามประเภทข้อมูล เช่น เว็บ 70%, หนังสือ 15%, โค้ด 10%, อื่น ๆ 5%

- การปรับแต่ง (fine‑tuning) และชุดทดสอบ: ระบุว่ามีการ fine‑tune บนชุดข้อมูลใด การใช้ human‑label หรือ reinforcement learning from human feedback (RLHF) หรือไม่ และให้รายละเอียดชุดทดสอบสำหรับการวัดผล

- การคัดกรองและการลดอคติ: อธิบายกระบวนการคัดกรองเนื้อหาที่ล่วงละเมิด/ไม่เหมาะสม รวมถึงขั้นตอนลดปัญหา bias เช่นการ balance ตัวอย่างตามเพศ/เชื้อชาติ/ภูมิภาค

- การได้รับอนุญาตและประเด็นสิทธิ์: เปิดเผยว่าข้อมูลมีสิทธิ์นำมาใช้หรือได้รับอนุญาตอย่างไร ระบุข้อจำกัดด้านลิขสิทธิ์หรือข้อมูลส่วนบุคคล

3. การประเมินประสิทธิภาพ เมตริก และผลการทดสอบ

ต้องรายงานผลการประเมินอย่างชัดเจน พร้อมระบุเมตริกและชุดข้อมูลอ้างอิงที่ใช้ เพื่อให้การเปรียบเทียบและการตรวจสอบเป็นไปได้จริง ตัวอย่างข้อมูลสำคัญได้แก่:

- เมตริกทั่วไป: เช่น accuracy, F1, BLEU, ROUGE, perplexity สำหรับภาษาธรรมชาติ และ ROC‑AUC หรือ precision/recall สำหรับงานจำแนก

- เมตริกความปลอดภัยและความเป็นพิษ: เช่น อัตราความเป็นพิษ (toxic span rate), อัตราการผลิตเนื้อหาที่ก่อให้เกิดความเกลียดชัง, อัตราการรั่วไหลของข้อมูลส่วนบุคคล

- มาตรวัด hallucination: ระบุวิธีการวัดและผล เช่น "อัตราฮัลลูซิเนชัน 2.3% (วัดบนชุด XQA‑Eval, ระบุเกณฑ์ความถูกต้องของคำตอบ)" — หากเป็นค่าเฉลี่ยจากหลายชุดทดสอบให้ระบุช่วงความเชื่อมั่น

- ความเป็นธรรมและการบิดเบือน: รายงานผลเทสตามกลุ่มประชากร (เช่น disparity ใน accuracy ระหว่างกลุ่ม) ตัวอย่าง: "ความต่างของ F1 ระหว่างกลุ่ม A และ B = 4.1 percentage points"

- ความทนทานต่อการโจมตีและความเสถียร: การทดสอบ adversarial robustness, prompt injection, และการประเมินความคงที่ของผลลัพธ์เมื่ออินพุตมี noise

- รายละเอียดการทดลอง: ระบุชุดข้อมูลทดสอบ, seed, วิธีการสุ่ม, และสภาพแวดล้อมการรัน (hardware, latency เฉลี่ย) เพื่อให้สามารถ reproduce ผลได้

4. ข้อจำกัด ผลกระทบ และคำแนะนำการใช้งาน

นอกเหนือจากตัวเลขเชิงเทคนิคแล้ว Model‑Card ต้องให้คำอธิบายเกี่ยวกับข้อจำกัดและความเสี่ยงที่ทราบ เพื่อชี้นำการใช้งานเชิงพาณิชย์อย่างรับผิดชอบ

- ข้อจำกัดที่ทราบ: ระบุสถานการณ์ที่โมเดลทำงานไม่ดี เช่น "ประสิทธิภาพต่ำเมื่อข้อความมีความยาวเกิน 2,048 tokens" หรือ "ความแม่นยำลดลงในภาษา/สำเนียงบางกลุ่ม"

- ความเสี่ยงเชิงพฤติกรรม: เช่น ความเสี่ยงในการสร้างข้อมูลเท็จ (misinformation), การเผยแพร่ข้อมูลส่วนบุคคล, หรือการใช้ในกิจกรรมผิดกฎหมาย

- คำแนะนำในการปรับใช้: แนวทางเชิงปฏิบัติ เช่น การใช้ระบบควบคุม (moderation), การตั้งค่า temperature ต่ำเพื่อลด hallucination, จำกัดขอบเขตการใช้งานในโดเมนวิชาการที่มีความเสี่ยงสูง

- ข้อควรปฏิบัติด้านมนุษย์และการตรวจสอบ: แนะนำการมีมนุษย์ตรวจสอบ (human‑in‑loop) สำหรับการตัดสินใจสำคัญ การเก็บ log เพื่อตรวจสอบเหตุการณ์ผิดปกติ และการแจ้งเตือนเมื่อโมเดลแสดงผลลัพธ์ที่มีความไม่แน่นอนสูง

5. ประวัติการอัปเดตและการตรวจสอบย้อนหลัง

Model‑Card ต้องมีบันทึกเวอร์ชันอย่างชัดเจน เพื่อให้ผู้ใช้สามารถตรวจสอบการเปลี่ยนแปลงและการปรับปรุงได้อย่างต่อเนื่อง โดยข้อมูลควรรวมถึง:

- ประวัติเวอร์ชัน: รายการการเปลี่ยนแปลง (changelog) ของแต่ละเวอร์ชัน พร้อมวันที่และผู้รับผิดชอบ

- ผลการทดสอบย้อนหลัง: หากมีการ retrain หรือ fine‑tune ให้แนบผลการเปรียบเทียบก่อน/หลัง ทั้งในเชิงประสิทธิภาพและความปลอดภัย

- แผนการตรวจสอบต่อเนื่อง: ระบุความถี่ในการรีวิว (เช่น รายไตรมาส) และวิธีการอัปเดตเมื่อพบความเสี่ยงใหม่

6. ตัวอย่างรูปแบบการเขียนสั้น (ตัวอย่างเพื่อเป็นแนวทาง)

ตัวอย่าง Model‑Card แบบย่อที่แสดงโครงสร้างสำคัญเพื่อให้ผู้พัฒนาและผู้ควบคุมสามารถนำไปใช้เป็นแม่แบบได้

- Model name / version: ThinkLM‑Commercial v1.2

- Architecture / params: Transformer‑decoder, 65B parameters

- Training data summary: ~300B tokens; เว็บสแครป 72%, หนังสือ 14%, โค้ด 8%, ข้อมูลสาธารณะเฉพาะ 6%; มีการคัดกรองเนื้อหาโดยใช้ filter A และ human review

- Fine‑tuning: RLHF บนชุด X โดยใช้ human labelers 10k+ ตัวอย่าง

- Evaluation: Perplexity 12.4 (test corpus A), BLEU 31.2 (task B), Hallucination rate 2.3% (XQA‑Eval), Toxicity rate 0.7% (Perspective API)

- Known limitations: ลดประสิทธิภาพกับภาษาไทยถิ่นใต้และข้อเท็จจริงที่อัพเดตหลังปี 2023

- Recommended usage: ห้ามใช้เพื่อวินิจฉัยทางการแพทย์หรือการตัดสินคดีความโดยไม่มีการตรวจสอบจากผู้เชี่ยวชาญ; แนะนำ human‑in‑loop สำหรับผลลัพธ์ที่มีความสำคัญ

- Changelog: v1.2 (2025‑01‑01): ปรับปรุง filter A, ลด hallucination จาก 3.1% เป็น 2.3%

หมายเหตุ: เอกสาร Model‑Card ควรเผยแพร่ควบคู่กับชุดผลทดสอบ (benchmark) และวิธีทำซ้ำ (reproducibility kit) เพื่อให้หน่วยงานกำกับและผู้ใช้สามารถตรวจสอบการอ้างอิงได้อย่างโปร่งใส การเปิดเผยข้อมูลเชิงลึกทั้งด้านเทคนิค ชุดข้อมูล และการประเมินเป็นกุญแจสำคัญในการสร้างความเชื่อมั่นในการนำโมเดลไปใช้เชิงพาณิชย์

การวัดอัตราฮัลลูซิเนชัน: คำนิยาม เมตริก และตัวอย่างสถิติ

การวัดอัตราฮัลลูซิเนชัน: คำนิยาม และประเภทของฮัลลูซิเนชัน

ฮัลลูซิเนชัน ในบริบทของ Large Language Models (LLMs) หมายถึงกรณีที่โมเดลผลิตข้อความที่เป็นข้อมูลผิดพลาด ไม่สอดคล้องกับความจริง หรือสร้างรายละเอียดที่ไม่มีหลักฐานรองรับ แม้รูปแบบประโยคจะดูสมเหตุสมผลและมั่นใจ ตัวอย่างประเภทของฮัลลูซิเนชันที่พบได้บ่อย ได้แก่:

- Factual error — ข้อความที่ขัดแย้งกับข้อเท็จจริงที่ตรวจสอบได้ เช่น ระบุเหตุการณ์/วันที่ผิด หรือให้ตัวเลขที่ไม่ถูกต้อง

- Confabulation — การสร้างรายละเอียดเสริม (เช่น ชื่อหนังสือ บทความ หรือการอ้างอิง) ที่ไม่มีจริงหรือไม่มีแหล่งอ้างอิง

- Intrinsic hallucination — คำตอบขัดแย้งกับข้อมูลอินพุตหรือบริบทที่ให้มา (เช่น สรุปที่เปลี่ยนความหมายของต้นฉบับ)

- Extrinsic hallucination — การเพิ่มข้อมูลที่ไม่สามารถตรวจสอบได้จากแหล่งข้อมูลที่มีอยู่หรือที่ระบุ

เมตริกยอดนิยมและวิธีการวัด

การวัดฮัลลูซิเนชันสามารถทำได้หลายแนวทาง โดยแบ่งหลักๆ เป็นการประเมินเชิงอัตโนมัติและการประเมินโดยมนุษย์ การเลือกเมตริกควรสอดคล้องกับภารกิจ (เช่น QA, สรุปข้อมูล, การสร้างเชิงอ้างอิง) ซึ่งเมตริกที่นิยมใช้ได้แก่:

- Hallucination rate — สัดส่วนของคำตอบหรือเอกสารที่มีข้อผิดพลาดเชิงข้อเท็จจริงอย่างน้อยหนึ่งจุด (มักรายงานเป็นเปอร์เซ็นต์ เช่น “10% ของคำตอบมีฮัลลูซิเนชัน”)

- Factuality score — ค่าคะแนนเชิงต่อเนื่องจากการประเมินโดยมนุษย์หรือโมเดลตรวจสอบความจริง เช่น ให้คะแนน 0–1 สำหรับความถูกต้องของแต่ละประโยค

- Precision / Recall / F1 สำหรับ QA — วัดความแม่นยำของคำตอบที่ตรงกับข้อเท็จจริงอ้างอิง โดยเฉพาะสำหรับงาน QA แบบมีคำตอบอ้างอิง (closed-book หรือ retrieval-augmented)

- Entailment-based metrics — ใช้โมเดล Natural Language Inference (NLI) เพื่อตรวจว่า claim ถูก entail (สนับสนุน) โดยแหล่งอ้างอิงหรือไม่ (ใช้เป็นตัวชี้วัดเชิงอัตโนมัติ)

- QA-based evaluation — สร้างคำถามจากข้อความที่โมเดลสร้าง แล้วตอบด้วยชุดข้อมูลอ้างอิงเพื่อวัด factuality ของเนื้อหา

- Reference-based metrics (BLEURT, BERTScore) — ใช้เปรียบเทียบกับข้อความอ้างอิง แต่มีข้อจำกัดเมื่อไม่มีอ้างอิงที่ครอบคลุม

- Human evaluation — การให้ annotator ประเมินความถูกต้อง ความชัดเจน และระดับความเสียหาย (harm) ของข้อผิดพลาด ซึ่งยังเป็นมาตรฐานทองคำแม้มีต้นทุนสูง

ในทางปฏิบัติ ควรใช้ชุดเมตริกผสม (hybrid) — เช่น รายงาน hallucination rate แบบอัตโนมัติควบคู่กับตัวอย่างการประเมินโดยมนุษย์ เพื่อให้ข้อมูลเชิงปริมาณและเชิงคุณภาพพร้อมกัน

วิธีการทดสอบ (benchmarks) ที่นิยมและขั้นตอนปฏิบัติ

ในงานวิจัยและการประเมินเชิงอุตสาหกรรม นิยมใช้ชุดข้อมูลมาตรฐานเพื่อเปรียบเทียบและตรวจสอบฮัลลูซิเนชัน ได้แก่:

- TruthfulQA — ออกแบบมาเพื่อตรวจสอบความจริงของคำตอบแบบ open‑domain ที่อาจชวนให้โมเดลตอบตามอคติหรือสถิติปริมาณของข้อความ

- FEVER / Fact verification datasets — สำหรับตรวจสอบการอ้างอิงและการยืนยันข้อเท็จจริง ระบุว่า claim ได้รับการสนับสนุน (supported), ขัดแย้ง (refuted) หรือไม่สามารถสรุปได้ (not enough info)

- QA benchmarks (Natural Questions, TriviaQA, HoY): ใช้วัดความแม่นยำของคำตอบและสามารถนำมาใช้คำนวณ precision/recall

- Summarization factuality datasets — เช่น datasets ที่มีการทำเอกสารสรุปคู่กับการยืนยันข้อเท็จจริง (fact‑based evaluation)

ขั้นตอนการทดสอบที่เป็นที่ยอมรับโดยทั่วไปประกอบด้วย: (1) กำหนดชุดข้อมูลและภารกิจอย่างชัดเจน, (2) รันโมเดลในสภาพแวดล้อมที่กำหนด (ตั้งค่า temperature, decoding strategy), (3) ดึง claims หรือคำตอบออกมาเพื่อประเมินด้วยเมตริกอัตโนมัติ, (4) ทำการประเมินโดยมนุษย์แบบสุ่มตัวอย่างเพื่อยืนยันผลอัตโนมัติ และ (5) รายงานค่าความไม่แน่นอน เช่น ช่วงความเชื่อมั่น (confidence intervals) และขนาดตัวอย่างของการประเมินมนุษย์

ตัวอย่างสถิติและช่วงค่าที่พบได้จริง

การศึกษาหลายชิ้นและการทดสอบเชิงปฏิบัติรายงานค่าฮัลลูซิเนชันที่มีความแปรปรวนสูง ขึ้นกับประเภทงาน ขนาดโมเดล การมีหรือไม่มีการค้นคืนข้อมูล (retrieval) และวิธีประเมิน ตัวอย่างช่วงค่าที่มักพบได้ในงานต่างๆ ได้แก่:

- โมเดล closed‑book (ไม่มี retrieval) บนงาน QA แบบเปิดโลก (open‑domain): อัตราฮัลลูซิเนชัน/ข้อผิดพลาดเชิงข้อเท็จจริงมักอยู่ในช่วงประมาณ 10%–30% ขึ้นกับความยากของคำถาม

- โมเดลที่ทำงานแบบ retrieval‑augmented สามารถลดอัตรานี้ได้ชัดเจน มักพบช่วงประมาณ 1%–10% ในการทดสอบ QA ที่มีฐานข้อมูลอ้างอิงที่ดี

- งานสรุป (summarization) โดยเฉพาะสรุปเชิงนโยบายหรือเอกสารวิชาการ มักมีอัตราฮัลลูซิเนชันระหว่าง 5%–40% ขึ้นกับความซับซ้อนของต้นฉบับและความเข้มงวดของการประเมิน

- การอ้างอิง/การสร้างบรรณานุกรม (citation generation) — งานทดสอบรายงานการ fabricated citations ได้บ่อยครั้ง โดยบางการประเมินพบอัตราการสร้างแหล่งที่มาเทียมสูงถึง หลายเปอร์เซ็นต์ ถึงสองหลัก (ตัวอย่าง: 5%–20%)

ความแปรปรวนเหล่านี้สะท้อนว่า ไม่มีตัวเลขเดี่ยว ที่ใช้ได้กับทุกบริบท ดังนั้นการรายงานเชิงพาณิชย์ควรรายงานทั้งเมตริกหลายมิติ ช่วงค่าที่สังเกตได้ (min/max), ค่ากลาง (median/mean) และขนาดตัวอย่างของการประเมินโดยมนุษย์ เพื่อให้หน่วยงานกำกับและผู้ใช้งานเห็นภาพความเสี่ยงอย่างชัดเจน

ข้อเสนอแนะเชิงนโยบายและการรายงาน — สำหรับ Model Disclosure ทางการควรกำหนดให้ผู้พัฒนาและผู้ให้บริการรายงานเมตริกมาตรฐาน (เช่น hallucination rate ตามภารกิจ, วิธีประเมิน, ชุดข้อมูลที่ใช้, ขนาดตัวอย่างการประเมินมนุษย์, และ confidence intervals) พร้อมตัวอย่างกรณีผิดพลาดที่มีระดับความร้ายแรงต่างกัน เพื่อให้ผู้ประกอบการและผู้ใช้งานสามารถประเมินความเสี่ยงก่อนใช้งานเชิงพาณิชย์

การทดสอบความปลอดภัยก่อนเชิงพาณิชย์: วิธีการและชุดทดสอบที่แนะนำ

ภาพรวมและวัตถุประสงค์ของการทดสอบความปลอดภัยก่อนเชิงพาณิชย์

การทดสอบความปลอดภัยก่อนการนำโมเดลปัญญาประดิษฐ์ (AI) ไปใช้เชิงพาณิชย์เป็นกระบวนการเชิงรุกเพื่อระบุความเสี่ยงเชิงพฤติกรรม ความโน้มเอียง (bias) ช่องโหว่ด้านความเป็นส่วนตัว และความสามารถของโมเดลในการตอบสนองภายใต้สถานการณ์กดดัน (stress) หรือการโจมตีเชิงอาศัยปฏิกิริยา (adversarial). กรอบการทดสอบที่ครอบคลุมควรผสมผสานการทดลองเชิงปฏิบัติการ (active testing) เช่น red‑teaming และ adversarial prompt tests กับการประเมินเชิงวัดผล (quantitative evaluations) เช่นการทดสอบการรั่วไหลของข้อมูล (privacy leakage) และการประเมินความเป็นธรรม (fairness/bias) เพื่อให้ได้ภาพรวมความเสี่ยงที่เป็นรูปธรรมก่อนออกสู่สาธารณะหรือการใช้งานเชิงพาณิชย์

ประเภทการทดสอบที่แนะนำ

กรอบมาตรฐานควรจัดกลุ่มการทดสอบเป็นอย่างน้อย 4 หมวดหลัก และแต่ละหมวดต้องมีชุดทดสอบย่อยที่ชัดเจน ดังนี้

- Red‑team testing — การทดลองโดยทีมที่มีหน้าที่ค้นหาและออกแบบการโจมตีเชิงปฏิบัติการ (intentional misuse): ตัวอย่างเช่นการสร้าง prompt เพื่อชี้นำโมเดลให้สร้างเนื้อหาเป็นอันตราย (instructional wrongdoing), การสอดแทรกข้อมูลที่ทำให้โมเดลเผยข้อมูลภายใน หรือการลวงให้โมเดลเปลี่ยนพฤติกรรมความปลอดภัย การทดสอบควรครอบคลุมชุดการโจมตีเชิงสังคมวิศวกรรม (social‑engineering), jailbreaks, และการซ่อนเจตนา (obfuscated intents).

- Adversarial prompt tests — ทดสอบความทนทานต่อการเปลี่ยนรูปของคำสั่ง: ประกอบด้วย paraphrase attacks, token‑level perturbations, prompt injection, และการใช้ตัวอย่างขัดแย้ง (contrastive prompts). วัดผลเป็นอัตราความล้มเหลวของข้อจำกัด (failure rate) ต่อประเภทการโจมตีและระดับความรุนแรง.

- Privacy / leakage tests — ตรวจสอบการรั่วไหลของข้อมูลฝึก (training data) หรือข้อมูลผู้ใช้: ตัวอย่างชุดทดสอบได้แก่ membership inference attacks, attribute inference attacks และ reconstruction attacks. ตัวชี้วัดสำคัญคืออัตราความสำเร็จของการโจมตี (attack success rate), AUC ของเครื่องมือทำนาย, และการเปรียบเทียบกับ baseline แบบสุ่ม (เช่น AUC ≈ 0.5 เป็นค่าที่ควรใกล้เคียงสำหรับความปลอดภัยที่ดี).

- Fairness / bias evaluation — ประเมินความเป็นธรรมในมุมมองเชิงกลุ่ม (demographic groups) และเชิงบริบท: ใช้เมตริกเช่น statistical parity difference, equalized odds difference, subgroup calibration และ error rate parity. ควรรายงานการกระจายของข้อผิดพลาดตามกลุ่มประชากร เพื่อระบุกลุ่มที่ได้รับผลกระทบหนักที่สุด.

ชุดทดสอบมาตรฐานและแนวทางการทำให้สามารถทำซ้ำได้ (Reproducible Test Suites)

เพื่อให้ผลการทดสอบเชื่อถือได้และสามารถเปรียบเทียบระหว่างรุ่นโมเดลหรือระหว่างผู้พัฒนาได้ ควรจัดเตรียมชุดทดสอบที่ สามารถทำซ้ำได้ โดยประกอบด้วย:

- รายการ prompt/attack seeds อย่างเป็นระบบ (เช่น ธรณีประตูของการโจมตี 1,000–10,000 ไอเท็ม จัดกลุ่มตามเจตนาและระดับความซับซ้อน)

- สคริปต์การประเมินที่มีเวอร์ชันคอนโทรล (versioned test harness) พร้อมสภาพแวดล้อมการรันที่กำหนด (container/virtual env) เพื่อประกันความสม่ำเสมอของผล

- ชุดข้อมูลอ้างอิงสำหรับการทดสอบ distribution shift (เช่น domain transfer benchmarks, noisy‑input sets) และ stress tests (long‑context inputs, truncated inputs)

- เอกสารอธิบายวิธีการวัดผลและสูตรการคำนวณเมตริกเพื่อความโปร่งใส

ตัวอย่างการตั้งค่าชุดทดสอบมาตรฐานที่ควรมี: Red‑team prompt bank (10k+ ด้วยการจัดประเภทเจตนา), Adversarial paraphrase set (หลายระดับการเปลี่ยนแปลง), Membership inference benchmark (รวมตัวอย่างจาก training/holdout), และ Distribution shift suite (domain A→B, noisy OCR, colloquial language).

การใช้ third‑party audits และมาตรฐานการตรวจสอบจากภายนอก

การว่าจ้างการตรวจสอบโดยบุคคลที่สาม (third‑party audit) เป็นองค์ประกอบสำคัญ เพื่อสร้างความเป็นกลางและความเชื่อถือได้ของรายงานผลการทดสอบที่นำส่งต่อหน่วยกำกับดูแล แนวทางปฏิบัติที่แนะนำได้แก่:

- เลือกผู้ตรวจสอบที่มีความเป็นกลางและมีประวัติผลงานด้านความปลอดภัย AI และความเป็นธรรม

- กำหนดขอบเขตการเข้าถึง (API access, model weights, or white‑box access) และชุดข้อมูลจำเพาะสำหรับการทดสอบ โดยคำนึงถึง NDA และข้อจำกัดด้านความลับทางการค้า

- ขอผลลัพธ์ที่สามารถทำซ้ำได้ (reproducible artifacts) เช่น raw logs, seed files, และสคริปต์ทดสอบ เพื่อให้ regulator และผู้พัฒนาอื่นสามารถยืนยันผลได้

- มาตรการ follow‑up: auditor ควรส่งรายงานทั้งฉบับสรุปและฉบับเทคนิค พร้อมข้อเสนอแนะแก้ไขและคำแนะนำสำหรับการ retest หลังการบรรเทาความเสี่ยง

เกณฑ์ที่แนะนำก่อนอนุญาตใช้งานเชิงพาณิชย์

หน่วยกำกับควรกำหนดเกณฑ์ขั้นต่ำที่สอดคล้องกับบริบทการใช้งาน โดยแยกตามระดับความเสี่ยงของโดเมน ตัวอย่างข้อเสนอแนะแบบทั่วไป:

- อัตราฮัลลูซิเนชัน (hallucination rate): สำหรับแอพพลิเคชันที่มีความเสี่ยงสูง (เช่น สาธารณสุข การเงิน กฎหมาย) แนะนำให้มีอัตราฮัลลูซิเนชันต่ำกว่า 1% ต่อชุดทดสอบมาตรฐาน ในขณะที่สำหรับแอพทั่วไปสามารถตั้งเกณฑ์ที่เข้มงวดน้อยลง (เช่น ≤5%) แต่ต้องมีมาตรการแจ้งเตือนผู้ใช้

- ผลการโจมตีทางความเป็นส่วนตัว: ความสำเร็จของ membership inference หรือ reconstruction attacks ควรใกล้เคียง baseline (เช่น AUC ≈ 0.5) หรือมีการลดความเสี่ยงผ่านกลไกเช่น differential privacy โดยมีการรายงานค่า ε (epsilon) หากนำ DP มาใช้

- ความเป็นธรรม: ความต่างของอัตราข้อผิดพลาดระหว่างกลุ่มประชากรหลักไม่ควรเกินเกณฑ์ที่หน่วยงานกำหนด (ตัวอย่างเช่น difference ≤ 5 percentage points หรือ fairness metric ที่สอดคล้องกับนโยบายภายใน)

- ความทนทานต่อโจมตี: โมเดลควรผ่านการทดสอบ red‑team โดยไม่มีช่องโหว่เชิงระบบที่นำไปสู่การสร้างเนื้อหาอันตรายที่ชี้ชัดหรือการรั่วไหลของข้อมูลเชิงเด่นชัด หากพบช่องโหว่ต้องมีแผนบรรเทาและ retesting ภายในระยะเวลาที่กำหนด

การรายงานผลต่อหน่วยกำกับและการสื่อสารความเสี่ยง

รายงานที่ส่งต่อหน่วยกำกับควรประกอบด้วยข้อมูลเชิงสรุปและเชิงเทคนิค เพื่อให้ทั้งผู้บริหารและผู้เชี่ยวชาญเข้าใจสถานะความเสี่ยงได้อย่างชัดเจน รายงานที่แนะนำประกอบด้วย:

- สรุปผลเชิงกุญแจ (key findings) และระดับความเสี่ยงโดยรวม

- ตารางเมตริกหลัก (hallucination rate, attack success rates, fairness metrics, distribution shift performance) พร้อมช่วงความเชื่อมั่น (confidence intervals) และตัวอย่างข้อผิดพลาดเชิงคุณภาพ

- artifact สำหรับการทำซ้ำ: seed lists, raw logs, evaluation scripts, เวอร์ชันของโมเดลและการตั้งค่าการรัน

- แผนการบรรเทาความเสี่ยงและ timeline สำหรับการ retest รวมถึงคำแนะนำสำหรับการตรวจสอบอิสระภายนอก

สรุปได้ว่า การทดสอบความปลอดภัยก่อนการใช้งานเชิงพาณิชย์ต้องเป็นไปอย่างเป็นระบบ มีความสามารถทำซ้ำ และโปร่งใสต่อทั้งหน่วยกำกับและผู้ตรวจสอบอิสระ โดยการผสมผสานระหว่าง red‑teaming, adversarial testing, privacy leakage evaluation, fairness assessment และ stress/distribution shift tests จะช่วยให้ผู้พัฒนาสามารถระบุและลดความเสี่ยงที่สำคัญได้ ก่อนที่จะให้บริการต่อสาธารณะ

การบังคับใช้ ความรับผิดชอบ และผลกระทบต่อผู้พัฒนาและธุรกิจ

แนวปฏิบัติการบังคับใช้และมาตรการลงโทษ/การแก้ไข

มาตรฐาน Model Disclosure ฉบับใหม่กำหนดกรอบการบังคับใช้ที่ชัดเจน ครอบคลุมทั้ง การรายงานประจำ (periodic reporting), การตรวจสอบไซต์และระบบ (site-level audits และ audit trail) รวมถึงข้อเรียกร้องให้มี Model‑Card และการเปิดเผยอัตราฮัลลูซิเนชันและผลการทดสอบความปลอดภัยก่อนใช้งานเชิงพาณิชย์ โดยแนวปฏิบัติการบังคับใช้จะประกอบด้วยการตรวจสอบเชิงรุกจากหน่วยงานกำกับ การรับเรื่องร้องเรียนจากผู้ใช้ และการตรวจสอบแบบสุ่มในระบบการให้บริการของผู้ประกอบการ

มาตรการลงโทษมีหลายระดับตั้งแต่การแจ้งเตือนและคำสั่งให้ดำเนินการแก้ไขไปจนถึงการปรับทางการเงิน การระงับการให้บริการชั่วคราว และการเพิกถอนใบอนุญาตหรือการห้ามจำหน่ายในกรณีที่มีความเสี่ยงร้ายแรงหรือฝ่าฝืนซ้ำซาก ผู้พัฒนาจะต้องจัดทำแผนแก้ไข (remediation plan) ที่ชัดเจนและส่งรายงานติดตามผลเป็นระยะ ซึ่งหน่วยงานกำกับอาจกำหนดให้มีการตรวจสอบโดยบุคคลที่สาม (third‑party audit) เพื่อยืนยันการดำเนินการแก้ไข

ผลกระทบด้านค่าใช้จ่าย เวลา และกระบวนการพัฒนา

การปฏิบัติตามมาตรฐานใหม่จะเพิ่มต้นทุนทั้งแบบต้นทุนเริ่มต้น (one‑time) และต้นทุนต่อเนื่อง (recurring) ได้แก่ค่าใช้จ่ายด้านการจัดทำเอกสาร Model‑Card, การติดตั้งระบบวัดอัตราฮัลลูซิเนชัน, ค่าใช้จ่ายสำหรับการทดสอบความปลอดภัยและการจ้างผู้ตรวจสอบอิสระ รวมถึงทรัพยากรบุคคลในทีม compliance และการอบรมพนักงาน

ในด้านเวลา กระบวนการพัฒนาซอฟต์แวร์และโมเดลจะต้องเพิ่มขั้นตอนการทดสอบและการตรวจสอบเข้าไปในวงจร CI/CD เช่น การรันชุดทดสอบความปลอดภัยอัตโนมัติเป็นขั้นบังคับก่อนปล่อยโค้ด (pre‑deployment gating), การบันทึก audit trail แบบครบถ้วน และการทดสอบในสภาพแวดล้อมจำลอง (staging/canary) ส่งผลให้เวลารอบการปล่อยงาน (release cycle) ยาวขึ้นและอาจทำให้ความเร็วในการพัฒนาลดลง โดยเฉพาะสำหรับองค์กรขนาดเล็กที่มีทรัพยากรจำกัด

ผลกระทบเชิงธุรกิจยังรวมถึงการเปลี่ยนแปลงในกระบวนการขายและการให้บริการเชิงพาณิชย์ ลูกค้ารายใหญ่และภาครัฐอาจบรรจุข้อกำหนดการเปิดเผยและการทดสอบเป็นเงื่อนไขของสัญญา ทำให้เวลาปิดการขาย (sales cycle) ยาวขึ้น แต่ในทางกลับกัน การปฏิบัติตามข้อกำหนดสามารถกลายเป็นข้อได้เปรียบทางการตลาดสำหรับผู้ให้บริการที่สามารถยืนยันความโปร่งใสและความปลอดภัยได้ชัดเจน

ข้อเสนอแนะเชิงปฏิบัติสำหรับผู้พัฒนาและธุรกิจ

- Checklist การปฏิบัติตามเบื้องต้น: จัดทำบัญชีโมเดล (model inventory), สร้างแม่แบบ Model‑Card ตามมาตรฐาน, ติดตั้งระบบวัดอัตราฮัลลูซิเนชัน, จัดทำชุดทดสอบความปลอดภัยขั้นต่ำ และเปิดระบบ audit trail สำหรับการเปลี่ยนแปลงโมเดลและการใช้งานเชิงพาณิชย์

- จัดทีม Compliance: แต่งตั้งเจ้าของความรับผิดชอบ (compliance owner) ระหว่างทีมเทคนิค กฎหมาย และความเสี่ยง สร้างหน้าที่ชัดเจน ได้แก่ การรายงานต่อหน่วยงานกำกับ การจัดการเหตุการณ์ (incident response) และการประสานงานกับผู้ตรวจสอบภายนอก

- Roadmap ปรับระบบ (ตัวอย่าง 3‑เฟส):

- 0–3 เดือน: ทำ inventory ของโมเดลทั้งหมด, ออกแบบ Model‑Card แบบมาตรฐาน, เริ่มเก็บ audit trail และตัวชี้วัดพื้นฐาน

- 3–9 เดือน: ผนวกการวัดอัตราฮัลลูซิเนชันเข้า CI/CD, ตั้งเกตการทดสอบก่อนปล่อย, ดำเนินการทดสอบความปลอดภัยเชิงกายภาพและดิจิทัล

- 9–18 เดือน: จัดให้มีการตรวจสอบโดยบุคคลที่สาม, ปรับสัญญาการขายและ SLA ให้สอดคล้อง, ทำการฝึกอบรมเชิงต่อเนื่อง และพัฒนาระบบตรวจจับเหตุการณ์อัตโนมัติ

- กลยุทธ์ลดต้นทุน: ใช้แนวทาง modular compliance เช่น บริการประเมินและทดสอบร่วมกัน (shared testing infrastructure), นำเครื่องมือโอเพนซอร์สสำหรับการวัด hallucination มาใช้ และตั้งทีมกลางเพื่อให้บริการด้าน compliance แก่หลายหน่วยงานภายในองค์กร

- การจัดการด้านการขาย: อัปเดตข้อเสนอและเอกสารทางการตลาดให้ชัดเจนเรื่องการปฏิบัติตามมาตรฐาน เตรียมตอบคำถามด้านความปลอดภัยและจัดรูปแบบข้อมูลสำหรับการประมวลผลการจัดซื้อของลูกค้าองค์กร

มุมมองที่หลากหลายจากหน่วยงาน อุตสาหกรรม และผู้ใช้

หน่วยงานกำกับมักเน้นความสำคัญของความโปร่งใสและการปกป้องผู้บริโภค โดยมองว่าการบังคับให้เปิดเผย Model‑Card และอัตราฮัลลูซิเนชันเป็นเครื่องมือสำคัญในการลดความเสี่ยงเชิงระบบ ในขณะที่ภาคอุตสาหกรรมแสดงความกังวลเกี่ยวกับผลกระทบต่อความสามารถในการแข่งขันและความเสี่ยงด้านทรัพย์สินทางปัญญา (IP) จากการเปิดเผยข้อมูลเทคนิคบางส่วน

มุมมองของผู้ใช้และองค์กรผู้ว่าจ้างมักเรียกร้องความรับผิดชอบที่ชัดเจนและหลักฐานเชิงประจักษ์ เช่น รายงานการทดสอบความปลอดภัยและ audit trail ที่สามารถตรวจสอบได้ การตอบสนองที่หลากหลายระหว่างผู้มีส่วนได้ส่วนเสียชี้ให้เห็นว่าการบังคับใช้ควรมีความสมดุล โดยอาจเริ่มด้วยการบังคับใช้แบบค่อยเป็นค่อยไป (phased approach) และ sandbox สำหรับการทดสอบนวัตกรรมเพื่อไม่ให้ยับยั้งการพัฒนาเทคโนโลยีในประเทศ

สรุปและข้อเสนอแนะเชิงนโยบาย-ปฏิบัติ

สรุปและข้อเสนอแนะเชิงนโยบาย-ปฏิบัติ

สรุปสาระสำคัญ: มาตรฐาน Model Disclosure ของหน่วยกำกับไทยกำหนดให้ผู้พัฒนาและผู้ให้บริการโมเดลปัญญาประดิษฐ์ต้องเปิดเผยข้อมูลเชิงเทคนิค (Model‑Card) รายงานอัตราการเกิดฮัลลูซิเนชัน (hallucination rate) และผลการทดสอบความปลอดภัย (safety testing) ก่อนนำไปใช้เชิงพาณิชย์ ข้อกำหนดนี้มุ่งเน้นความโปร่งใส เพื่อลดความเสี่ยงจากการใช้งานที่ไม่พึงประสงค์และเพิ่มความเชื่อมั่นของผู้ใช้และผู้กำกับดูแล โดยคาดว่าการเปิดเผยข้อมูลพื้นฐานเหล่านี้จะช่วยให้การประเมินความเสี่ยงสามารถทำได้รวดเร็วและมีประสิทธิผลมากขึ้น

ผลกระทบเชิงบวกและความเสี่ยงที่ต้องจัดการ: การส่งเสริมความโปร่งใสจะช่วยลดความเสี่ยงด้านความปลอดภัยและจริยธรรม ตัวอย่างเช่น ผู้ใช้สามารถเปรียบเทียบอัตราฮัลลูซิเนชันของโมเดลก่อนตัดสินใจใช้ ส่งผลให้ความเชื่อมั่นของผู้บริโภคและภาคธุรกิจเพิ่มขึ้น ในระดับระบบ การเปิดเผย Model‑Card จะเอื้อต่อการตรวจสอบโดยบุคคลที่สามและการติดตามผลต่อเนื่อง อย่างไรก็ดี มีความเสี่ยงที่ต้องจัดการ ได้แก่ ภาระต้นทุนและความซับซ้อนเชิงเทคนิคสำหรับผู้ให้บริการขนาดกลางและขนาดย่อม (SMEs) ความเสี่ยงด้านทรัพย์สินทางปัญญาเมื่อเปิดเผยรายละเอียดเชิงเทคนิค และความเป็นไปได้ที่ข้อมูลการทดสอบอาจถูกนำไปบิดเบือนหรือตีความผิดพลาดหากขาดมาตรฐานการรายงานที่ชัดเจน

แนวทางเชิงนโยบายและมาตรการปฏิบัติ: เพื่อให้มาตรฐานใหม่ส่งเสริมนวัตกรรมควบคู่กับการคุ้มครองสาธารณะ แนะนำให้ภาครัฐดำเนินมาตรการเชิงรุก ดังนี้

- จัดตั้ง sandbox เชิงทดลองและทดสอบ — สร้างพื้นที่ทดสอบแบบมีการกำกับดูแล (regulatory sandbox) เพื่อให้ผู้พัฒนา โมเดล และผู้ประกอบการทดสอบการรายงาน Model‑Card การวัดอัตราฮัลลูซิเนชัน และการประเมินความปลอดภัยในสภาพแวดล้อมที่ควบคุมได้ เวลาแนวทางนี้ควรมีการเก็บข้อมูลเชิงระบบและเผยแพร่บทเรียนเป็นรายไตรมาส ตัวอย่าง KPI ที่เหมาะสม เช่น จำนวนโมเดลที่ผ่านการทดสอบภายใน 12 เดือน และระดับการลดข้อร้องเรียนจากผู้ใช้

- ให้การสนับสนุนทางเทคนิคและทางการเงินแก่ SMEs — จัดโปรแกรมช่วยเหลือเชิงเทคนิค (technical assistance) เช่น เครื่องมือสำเร็จรูปสำหรับสร้าง Model‑Card ชุดทดสอบมาตรฐานสำหรับการประเมิน hallucination และแหล่งทุนสนับสนุน (grants/subsidies) เพื่อลดภาระต้นทุน โดยอาจมีรูปแบบช่วยเหลือเป็น voucher, การให้คำปรึกษาทางเทคนิคฟรี หรือการลดหย่อนภาษีสำหรับการลงทุนด้านความปลอดภัย

- ประสานกับมาตรฐานสากล — ทำงานร่วมกับองค์กรมาตรฐานระหว่างประเทศ (เช่น ISO, IEEE, OECD) และหน่วยกำกับในต่างประเทศ เพื่อปรับมาตรฐานให้สอดคล้องและป้องกันการเกิด "ข้อกำหนดชนิดต่างกัน" ที่เป็นอุปสรรคต่อการค้าและการนำเข้าเทคโนโลยี การเชื่อมโยงกับมาตรฐานสากลยังช่วยให้ผลการทดสอบและการรับรองไทยเป็นที่ยอมรับในตลาดต่างประเทศ

- จัดทำแนวทางการรายงานมาตรฐานและการตรวจสอบภายนอก — กำหนดรูปแบบ Model‑Card และเมตริกการรายงานที่ชัดเจน รวมทั้งกำหนดการตรวจสอบโดยหน่วยงานอิสระหรือห้องปฏิบัติการรับรอง เพื่อป้องกันการรายงานที่ขาดความน่าเชื่อถือและลดความเสี่ยงการบิดเบือนข้อมูล

- ลงทุนในการอบรมและพัฒนาทักษะภาคอุตสาหกรรม — สนับสนุนหลักสูตรการฝึกอบรมสำหรับผู้บริหาร วิศวกร และทีมบริหารความเสี่ยง ทั้งภาครัฐและเอกชน เช่น หลักสูตรด้านการออกแบบ Model‑Card วิธีการวัด hallucination และการประเมินผลกระทบทางสังคม เพื่อสร้างความสามารถฝังตัวในองค์กรและเพิ่มแหล่งบุคลากรที่มีคุณภาพ

- นโยบายแบบค่อยเป็นค่อยไปพร้อมมาตรการจูงใจ — แนะนำการบังคับใช้แบบเป็นขั้นตอน (phased implementation) โดยเริ่มจากระบบที่มีความเสี่ยงสูงก่อน และใช้มาตรการจูงใจเช่น สิทธิประโยชน์ทางการตลาดหรือการรับรองพิเศษสำหรับองค์กรที่ปฏิบัติตามของครบถ้วน

บทสรุป: มาตรฐาน Model Disclosure เป็นก้าวสำคัญในการยกระดับการกำกับดูแล AI ในประเทศ หากผสานการบังคับใช้เข้ากับ sandbox การสนับสนุนทางเทคนิคสำหรับ SMEs การประสานกับมาตรฐานสากล และการส่งเสริมการฝึกอบรมเชิงลึก จะช่วยให้ประเทศไทยสามารถส่งเสริมนวัตกรรมดิจิทัลควบคู่กับการคุ้มครองสาธารณะ โดยคำนึงถึงความสมดุลระหว่างความโปร่งใส ความสามารถในการแข่งขัน และความปลอดภัยของผู้บริโภค

บทสรุป

มาตรฐาน “Model Disclosure” ของหน่วยกำกับของไทยกำหนดให้ผู้พัฒนาและผู้ให้บริการ AI เปิดเผย Model‑Card, อัตราฮัลลูซิเนชัน (hallucination) และผลการทดสอบความปลอดภัยก่อนใช้งานเชิงพาณิชย์ เพื่อยกระดับความโปร่งใสและความปลอดภัยของระบบ AI โดย Model‑Card ควรระบุที่มาของข้อมูลฝึกอบรม ขอบเขตการใช้งาน ประสิทธิภาพและข้อจำกัด ขณะที่การวัดอัตราฮัลลูซิเนชันต้องอาศัยชุดมาตรฐานที่ชัดเจน—ตัวอย่างเช่น งานวิจัยและการทดสอบภาคสนามชี้ว่าอัตราฮัลลูซิเนชันอาจแตกต่างกันตามงาน ตั้งแต่ระดับต่ำกว่า 1% จนถึงหลักหลายสิบเปอร์เซ็นต์ ขึ้นอยู่กับประเภทข้อมูลและภารกิจ ดังนั้นการเปิดเผยตัวเลขและเมทริกซ์ที่โปร่งใสจะช่วยลดความเสี่ยงด้านกฎหมายและภาพลักษณ์ขององค์กรได้อย่างมีนัยสำคัญ

อย่างไรก็ตาม มาตรฐานนี้จะได้ผลจริงเมื่อมีการสนับสนุนเชิงเทคนิคและนโยบายควบคู่กัน เช่น แนวทางการวัดมาตรฐาน เครื่องมือทดสอบสำเร็จรูป พื้นที่ทดสอบ (regulatory sandbox) และการประสานระหว่างหน่วยงานกับภาคเอกชน เพื่อไม่ให้เป็นอุปสรรคต่อการพัฒนานวัตกรรมเชิงพาณิชย์ ในอนาคตคาดว่าจะเห็นการนำมาตรการแบบค่อยเป็นค่อยไป เช่น การรับรอง/การตรวจจากบุคคลที่สาม และการประสานมาตรฐานกับเวทีสากล องค์กรที่เริ่มเตรียม Model‑Card ระบบวัดอัตราฮัลลูซิเนชัน และชุดทดสอบความปลอดภัยที่โปร่งใสตั้งแต่วันนี้ จะได้เปรียบเชิงการแข่งขัน ลดค่าใช้จ่ายความเสี่ยงระยะยาว และเสริมความเชื่อมั่นให้กับผู้ใช้และผู้กำกับดูแล