กองทัพสหรัฐฯ ประกาศเปิดเส้นทางอาชีพใหม่ด้านปัญญาประดิษฐ์ (AI) และการเรียนรู้ของเครื่อง (Machine Learning) สำหรับนายทหาร เพื่อเสริมศักยภาพทางเทคโนโลยีของกองกำลังและตอบโจทย์ความต้องการบุคลากรที่มีทักษะเฉพาะด้านในยุคดิจิทัล การเคลื่อนนี้ไม่ได้เป็นเพียงการเปิดหลักสูตรฝึกอบรม แต่ยังรวมถึงการสร้างโครงสร้างเส้นทางอาชีพภายในหน่วยงาน การร่วมมือกับสถาบันการศึกษาและบริษัทเทคโนโลยีชั้นนำ และการกำหนดกรอบกำกับดูแลด้านจริยธรรมเพื่อให้การใช้ AI มีความโปร่งใสและปลอดภัยสำหรับภารกิจทางทหาร

บทนำนี้จะพาอ่านประเด็นสำคัญ ได้แก่ รูปแบบการฝึกอบรมภายในที่กองทัพเตรียมจัดให้ นายทหารจะได้รับการรับรองหรือพัฒนาทักษะอย่างไร การร่วมมือระหว่างกองทัพกับมหาวิทยาลัยและอุตสาหกรรมเพื่อส่งเสริมการถ่ายทอดความรู้และนวัตกรรม ตลอดจนแนวทางกำกับดูแลจริยธรรมที่มุ่งควบคุมการใช้ AI ในงานปฏิบัติการจริง และตัวชี้วัดความสำเร็จที่กองทัพตั้งเป้า เช่น ด้านความสามารถของบุคลากร การนำเทคโนโลยีไปใช้งานได้จริง และความปลอดภัยของระบบ

การริเริ่มครั้งนี้สะท้อนถึงการเปลี่ยนแปลงเชิงกลยุทธ์ที่กองทัพต้องการเดินหน้า เพื่อให้ทันกับความก้าวหน้าทางเทคโนโลยีและแรงกดดันจากบริบทความมั่นคงโลก ในบทความต่อไป เราจะเจาะรายละเอียดโครงสร้างหลักสูตร ตัวอย่างความร่วมมือกับภาคการศึกษาและเอกชน แนวทางกำกับดูแลด้านจริยธรรม และมาตรการประเมินผลที่ใช้วัดความสำเร็จของเส้นทางอาชีพใหม่นี้

เบื้องต้น: ประกาศและความสำคัญ

เบื้องต้น: ประกาศและความสำคัญ

เมื่อเร็วๆ นี้ กระทรวงกลาโหมสหรัฐฯ (Department of Defense, DoD) ประกาศเปิดตัวเส้นทางอาชีพใหม่ด้านปัญญาประดิษฐ์ (AI) และการเรียนรู้ของเครื่อง (Machine Learning) สำหรับบุคลากรในกองทัพ โดยการประกาศนี้เกิดขึ้นร่วมกับการแถลงจากหน่วยงานภายในที่รับผิดชอบด้านดิจิทัลและ AI ของกระทรวง รวมถึงการสนับสนุนจากกองทัพบก กองทัพเรือ และกองทัพอากาศ เป้าหมายเชิงยุทธศาสตร์ที่ชัดเจนคือการเร่งความสามารถในการตัดสินใจบนพื้นฐานข้อมูล (data-driven decision-making) เพิ่มความคล่องตัวด้านการวิเคราะห์ และลดภาระงานที่ซ้ำซ้อนของบุคลากรทางทหารและพลเรือน

ในเชิงกรอบเวลาและขอบเขต โครงการนี้ถูกกำหนดในรูปแบบที่เริ่มต้นเป็นโปรแกรมนำร่อง (pilot) ก่อนขยายผล หากผลการประเมินเป็นไปตามเป้าหมาย โดยระยะทดลองคาดว่าจะครอบคลุมระยะเวลาหลายไตรมาสเพื่อประเมินทั้งความสามารถเชิงเทคนิคและผลกระทบต่อกำลังพล แผนงานยังระบุว่าจะมีการออกแบบเส้นทางอาชีพที่ครอบคลุมทั้งระดับนายทหารประจำการ (enlisted) เจ้าหน้าที่ผู้บังคับบัญชา (officers) และบุคลากรพลเรือนที่ทำงานด้านเทคนิค เพื่อสร้างทักษะตั้งแต่พื้นฐานด้านข้อมูลจนถึงการพัฒนาและการบูรณาการโมเดล AI เข้ากับระบบปฏิบัติการของหน่วยงาน

ในแง่ของขอบเขตการปฏิบัติการ ประกาศชี้ให้เห็นว่าโครงการจะถูกเปิดใช้งานทั้งในระดับหน่วยงานและระดับกองทัพ (service-wide และ joint-level) โดยคาดว่าจะเริ่มจากหน่วยงานที่มีภารกิจด้านข่าวกรอง การปฏิบัติการทางไซเบอร์ และการสนับสนุนโลจิสติกส์ ซึ่งเป็นพื้นที่ที่เทคโนโลยี AI สามารถยกระดับการตัดสินใจและลดงานที่ทำซ้ำได้ ทั้งนี้ มีการคาดการณ์เชิงอนุรักษ์ว่าการนำร่องอาจเริ่มจากหลักสิบถึงหลักร้อยตำแหน่ง ก่อนขยายเป็นหลายร้อยถึงหลายพันตำแหน่งหากได้รับงบประมาณและผลการทดลองเป็นไปตามที่ตั้งไว้

คำแถลงสำคัญจากเอกสารของกระทรวงระบุว่า "การสร้างเส้นทางอาชีพด้าน AI จะช่วยให้กำลังพลของเรามีทักษะที่จำเป็นต่อการตัดสินใจบนพื้นฐานข้อมูล และช่วยลดภาระงานที่ไม่จำเป็น เพื่อให้สามารถมุ่งเน้นหน้าที่ที่ต้องใช้การตัดสินใจเชิงยุทธศาสตร์" ขณะที่ผู้แทนหน่วยงานด้าน AI ของ DoD ยังย้ำว่าโครงการจะติดตามมาตรฐานด้านจริยธรรม การควบคุมคุณภาพของข้อมูล และความปลอดภัยของระบบอย่างใกล้ชิด

แหล่งข้อมูลหลักที่อ้างอิงในการสรุปส่วนนี้ได้แก่ แถลงการณ์ของกระทรวงกลาโหม (DoD), แถลงของหน่วยงานด้าน AI ภายในกระทรวง (เช่น หน่วยงานที่ทำหน้าที่ต่อเนื่องจาก JAIC/CDAO), แถลงของแต่ละกองทัพ (Army/Navy/Air Force) และเอกสารงบประมาณของ DoD ที่เกี่ยวข้องกับการลงทุนด้านเทคโนโลยีสารสนเทศและบุคลากร ในบทความต่อไปผู้อ่านจะพบการวิเคราะห์รายละเอียดของกรอบการฝึกอบรมที่เสนอ ผลกระทบต่อสายอาชีพทหารและพลเรือน การประเมินงบประมาณที่คาดว่าจะต้องใช้ รวมทั้งตัวอย่างการประยุกต์ใช้งานเบื้องต้นในภารกิจจริง

- แถลงการณ์ของกระทรวงกลาโหม (DoD) — ข้อความหลักและนโยบายเชิงยุทธศาสตร์

- แถลงของกองทัพบก/กองทัพเรือ/กองทัพอากาศ — มุมมองการนำไปปฏิบัติในระดับ service

- เอกสารงบประมาณของ DoD — ข้อมูลการจัดสรรงบประมาณสำหรับการฝึกอบรมและการจ้างงานด้านเทคโนโลยี

- คำชี้แจงจากหน่วยงานจัดการ AI ภายใน DoD (เช่น JAIC/CDAO) — แนวทางด้านมาตรฐาน ความปลอดภัย และจริยธรรม

โครงสร้างเส้นทางอาชีพ AI/ML: ตำแหน่งและพันธกิจ

โครงสร้างเส้นทางอาชีพ AI/ML: ตำแหน่งและพันธกิจ

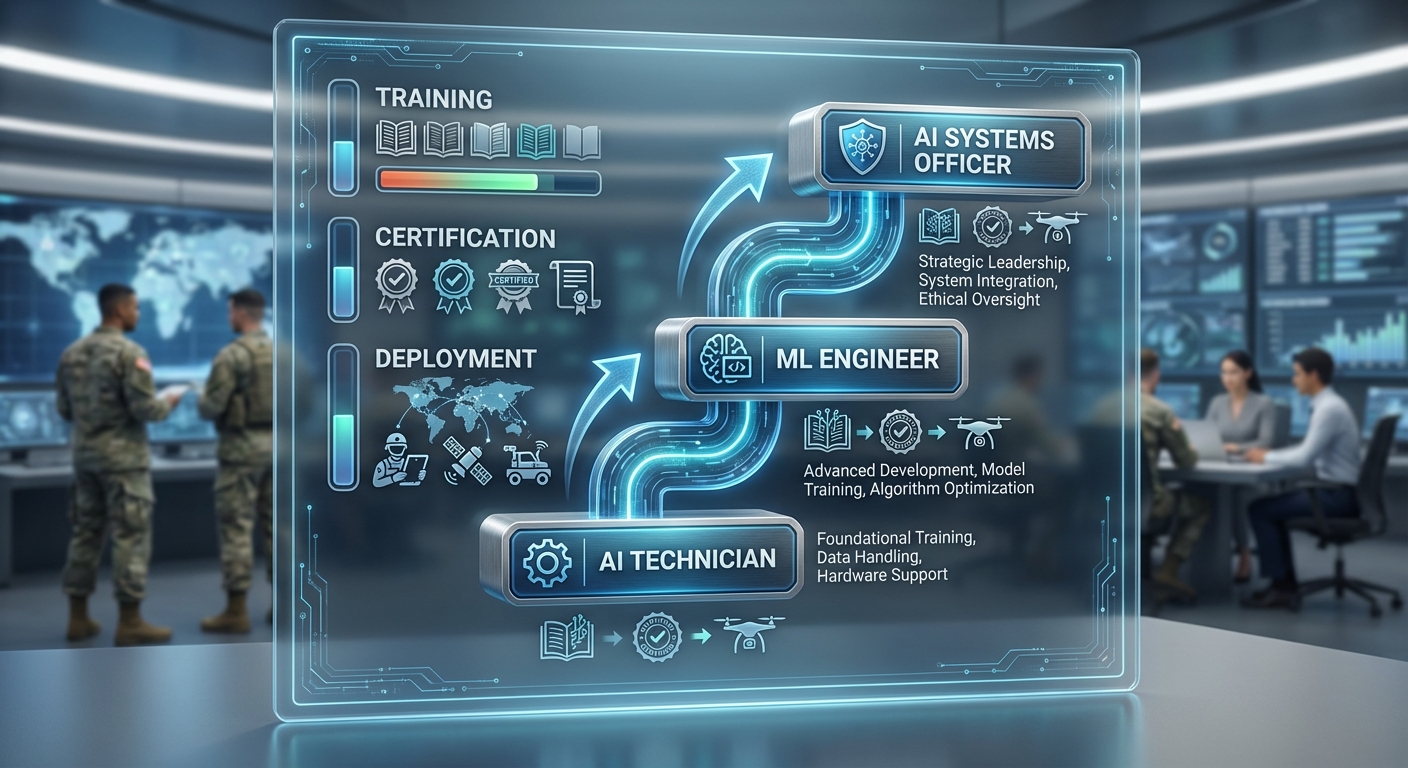

เส้นทางอาชีพใหม่ด้าน AI และการเรียนรู้ของเครื่องที่กองทัพสหรัฐฯ ประกาศออกแบบมาเพื่อรองรับงานตั้งแต่ระดับปฏิบัติการจนถึงการบริหารและบูรณาการระบบเชิงยุทธศาสตร์ โดยโครงสร้างหลักแบ่งเป็นสามชั้นตามหน้าที่และความรับผิดชอบ: entry-level technician (ผู้ปฏิบัติงานเริ่มต้น), data scientist / ML engineer (ผู้วิเคราะห์ข้อมูลและพัฒนาระบบเรียนรู้ของเครื่อง), และ AI systems officer (นายทหารระดับผู้บริหารระบบ AI ระดับกองกำลัง) แต่ละชั้นมีพันธกิจชัดเจนตั้งแต่การเก็บและเตรียมข้อมูล การพัฒนาโมเดล การทดสอบ การปรับใช้เชิงปฏิบัติการ จนถึงการกำหนดนโยบายความปลอดภัยและการกำกับดูแลด้านจริยธรรม

ตัวอย่างตำแหน่งและหน้าที่ (entry → specialist → officer)

- Entry-level AI/ML Technician (MOS-AI01)

หน้าที่: ทำงานกับชุดข้อมูลพื้นฐาน การเตรียมข้อมูล (data wrangling), การรันเทรนนิ่งเบื้องต้นบนโมเดลที่ถูกออกแบบแล้ว, การบำรุงรักษาโหนดเซิร์ฟเวอร์และอุปกรณ์ฝังตัวที่ใช้งาน AI โดยปกติรับเข้าด้วยยศระดับทหารเกณฑ์/พลทหาร (E-1 ถึง E-4)

- Data Scientist / ML Engineer (MOS-AI02)

หน้าที่: ออกแบบสถาปัตยกรรมโมเดล, ทำ feature engineering, ปรับจูน hyperparameters, นำโมเดลเข้าสู่สภาพแวดล้อมทดสอบและการผลิต, ทำงานร่วมกับทีมไซเบอร์และผู้ปฏิบัติการสนาม โดยมักเป็นระดับชั้นชำนาญงาน (E-5 ถึง E-7 หรือนายทหารชั้นผู้บังคับการเข้ามาทำหน้าที่ทางเทคนิค)

- AI Systems Officer (MOS-AI03 / Commissioned Officer)

หน้าที่: กำกับดูแลโครงการ AI ระดับองค์กร ออกแบบนโยบายการใช้งาน การกำกับดูแลเชิงจริยธรรมและความปลอดภัย รับผิดชอบการผสานระบบกับหน่วยงานพันธมิตร และเป็นผู้นำทีมข้ามสาขา โดยยศเริ่มตั้งแต่ O-1 (Second Lieutenant) ขึ้นไป

การกำหนด MOS หรือสายงานใหม่ และวิธีการเลื่อนขั้น

กองทัพจะกำหนด Military Occupational Specialty (MOS) ใหม่หรือปรับเรตติ้งหน้าที่ที่มีอยู่ โดยตัวอย่างโมเดลการดำเนินการคือการสร้างรหัส MOS สำหรับแต่ละบทบาท (เช่น MOS-AI01, MOS-AI02, MOS-AI03) พร้อมกรอบความสามารถ (competency framework) ที่ผูกกับการฝึกอบรมและการรับรอง เมทริกซ์นี้จะระบุความรู้ ทักษะ และประสบการณ์ที่ต้องการสำหรับการเลื่อนขั้น เช่น:

- เพื่อเลื่อนจาก MOS-AI01 → MOS-AI02 ต้องมีเวลาในตำแหน่งอย่างน้อย 24–36 เดือน, ผ่านการฝึกขั้นกลาง 120 ชั่วโมง, และผ่านการสอบประเมินภายใน

- เพื่อเลื่อนเป็น MOS-AI03 (Officer) จะต้องสำเร็จโปรแกรม commissioning หรือผ่าน Selection Board, มีประสบการณ์โครงการ AI ระดับหน่วยอย่างน้อย 3 ปี และได้รับการรับรองด้านการบริหารโครงการหรือการกำกับดูแลเทคโนโลยี

ตัวอย่างแผนผังสายอาชีพ (career ladder) แบบสมมติ เพื่อช่วยให้มองเห็นภาพ:

- Level 1 — AI Technician (MOS-AI01): อายุงาน 0–2 ปี, รับผิดชอบ data ingestion, maintenance (คาดว่า 60% ของผู้รับเข้าจะอยู่ในระดับนี้ในปีแรก)

- Level 2 — Senior Technician / Junior ML Engineer (MOS-AI01 → MOS-AI02): อายุงาน 2–5 ปี, ทำ model development และ deployment, นำทีมงานขนาดเล็ก

- Level 3 — ML Engineer / Data Scientist (MOS-AI02): อายุงาน 5–10 ปี, รับผิดชอบโปรเจกต์ระดับกองพล, เป็น SME ด้านโมเดล

- Level 4 — AI Systems Officer (MOS-AI03): อายุงาน 8+ ปี, บริหารโครงการข้ามหน่วย, กำหนดนโยบายและกลยุทธ์

ตามโมเดลนี้ สมมติอัตราการเลื่อนขั้นเฉลี่ย: 40% จาก Level 1 → Level 2 ภายใน 3 ปี, 25% จาก Level 2 → Level 3 ภายใน 5–7 ปี, และประมาณ 10–15% ที่ข้ามไปสู่บทบาทเจ้าหน้าที่บริหาร (Officer track) ขึ้นกับความต้องการเชิงยุทธศาสตร์และผลงานเชิงเทคนิค

การรับรองภายนอกและมาตรฐานที่ใช้ยืนยันทักษะ

กองทัพมักจะยอมรับการรับรองจากสถาบันที่เป็นที่ยอมรับเพื่อยืนยันความชำนาญและอำนวยความสะดวกในการโยกย้ายทักษะไปยังภาคพลเรือน ตัวอย่างการรับรองและมาตรฐานที่จะถูกรวมไว้ในเส้นทางอาชีพใหม่ ได้แก่:

- มาตรฐานกรอบความสามารถ: NIST NICE Framework สำหรับทักษะไซเบอร์และข้อมูล

- การรับรองด้านข้อมูลและการวิเคราะห์: Certified Analytics Professional (CAP), CompTIA Data+, (สมมติ) Certified Data Scientist (CDS)

- การรับรองเฉพาะแพลตฟอร์ม/vendor: AWS Certified Machine Learning – Specialty, Google Professional Machine Learning Engineer, Microsoft Azure AI Engineer Associate, TensorFlow Developer Certificate

- การรับรองด้านความปลอดภัยและการกำกับดูแล: CISSP/PCC for security governance, GIAC certifications สำหรับการทดสอบความปลอดภัยของ AI

- การรับรองภายในกองทัพ: Certificate of Military AI Proficiency (สมมติ) ที่ผูกกับคะแนนการปฏิบัติงานและชั่วโมงฝึกอบรม

การรวมมาตรฐานภายนอกเหล่านี้เข้ากับ MOS matrix จะทำให้การประเมินผู้สมัครและการเลื่อนขั้นเป็นไปอย่างชัดเจน เช่น การให้คะแนนพิเศษ 10–20% สำหรับผู้ถือ Google หรือ AWS certs เมื่อพิจารณาเลื่อนขั้น รวมถึงการยกคะแนนสำหรับการมีใบรับรองด้านความปลอดภัยข้อมูล เมื่อระบบ AI ถูกนำไปใช้ในภารกิจที่มีความเสี่ยงสูง

โดยสรุป เส้นทางอาชีพ AI/ML ของกองทัพที่ออกแบบมาใหม่นี้เป็นการผสานกรอบ MOS ที่ชัดเจนกับมาตรฐานการรับรองระดับสากลและกลไกการเลื่อนขั้นที่เกี่ยวข้องกับเวลาในตำแหน่ง ผลงานโครงการ และการได้มาซึ่งใบรับรองเชิงเทคนิค — ทั้งหมดนี้เพื่อให้ทหารมีเส้นทางความก้าวหน้าเชิงอาชีพที่สามารถวัดผลได้และเป็นที่ยอมรับทั้งในหน่วยทหารและภาคพลเรือน

โครงสร้างการฝึกอบรมและพัฒนาทักษะ

โครงสร้างการฝึกอบรมและพัฒนาทักษะ

กองทัพสหรัฐฯ วางกรอบการฝึกอบรมด้านปัญญาประดิษฐ์ (AI) และการเรียนรู้ของเครื่อง (ML) ในรูปแบบหลายชั้น (multi-tiered) เพื่อให้ครอบคลุมตั้งแต่ความรู้พื้นฐานจนถึงทักษะเชิงปฏิบัติการที่พร้อมใช้งานจริง กรอบนี้ออกแบบมาเป็นการเรียนรู้แบบผสมผสาน (blended learning) ประกอบด้วยการฝึกภายในกองทัพ การร่วมมือกับสถาบันอุดมศึกษา และการว่าจ้างผู้เชี่ยวชาญภาคอุตสาหกรรม ทั้งหมดผสานกับแล็บจำลอง/สนามฝึกเพื่อทดสอบในสภาวะใกล้เคียงการปฏิบัติจริง เป้าหมายสำคัญ คือย่นระยะเวลาจากการฝึกสู่การปฏิบัติจริง และสร้างกรอบการรับรองผลลัพธ์ที่วัดได้

รูปแบบการฝึก

- ภายในกองทัพ (In-house) — ค่ายฝึกและศูนย์วิทยาการของกองทัพจัดหลักสูตรพื้นฐานและภาคปฏิบัติ ให้การฝึกแบบต่อเนื่องกับเจ้าหน้าที่ภายในหน่วยงาน เหมาะสำหรับการถ่ายทอดแนวทางปฏิบัติที่เกี่ยวเนื่องกับภารกิจเฉพาะ (mission-tailored).

- ร่วมกับมหาวิทยาลัย (Academic Partnerships) — พัฒนาโปรแกรมร่วมกับสถาบันชั้นนำ เพื่อให้เข้าถึงหลักการเชิงวิชาการ การวิจัย และหลักสูตรระดับบัณฑิต เช่น หลักสูตรปริญญาระดับกลาง/สูงหรือ micro-credential ที่ได้รับการยอมรับทางวิชาชีพ

- จ้างภาคเอกชน (Industry Contracting) — ใช้ผู้เชี่ยวชาญจากภาคเอกชนในการจัดอบรมเชิงปฏิบัติจริง ตลอดจนการให้คำปรึกษาเรื่องการติดตั้งระบบ (model deployment), MLOps และการจัดการข้อมูลขนาดใหญ่

หลักสูตรตัวอย่างและระยะเวลา

โครงสร้างหลักสูตรแบ่งเป็นชั้นตามระดับความเชี่ยวชาญ โดยผสมผสานระหว่างการเรียนในห้องเรียน การเรียนออนไลน์ และการฝึกภาคสนาม ตัวอย่างกรอบเวลาเชิงตัวอย่างมีดังนี้:

- Bootcamp พื้นฐาน (12 สัปดาห์) — เน้นพื้นฐานคณิตศาสตร์/สถิติ (พีชคณิตเชิงเส้น, แคลคูลัสเบื้องต้น, ความน่าจะเป็น), การเขียนโปรแกรม (Python, libraries เช่น NumPy/Pandas), แนวคิดพื้นฐานของ ML (supervised/unsupervised) โดยทั่วไปมีชั่วโมงฝึกหัดแบบเข้มข้นประมาณ 20–30 ชั่วโมง/สัปดาห์ ตัวอย่างผลลัพธ์คาดหวัง ได้แก่ นักเรียนสามารถพัฒนาต้นแบบโมเดลง่ายๆ และประเมินผลเบื้องต้นได้

- หลักสูตรเชิงปฏิบัติ (3–6 เดือนต่อเนื่อง) — เน้นการทำงานกับชุดข้อมูลจริง (data wrangling, feature engineering), การสร้าง pipeline การฝึก, การประเมินเชิงสถิติ และการนำโมเดลขึ้นใช้งาน (containerization, CI/CD สำหรับ MLOps)

- On-the-Job Training / Apprenticeship (6–12 เดือน) — การทำโปรเจกต์ภารกิจจริงภายใต้การดูแลของที่ปรึกษา, การบูรณาการกับระบบปฏิบัติการภายในหน่วย เช่น ระบบข่าวสารสอดแนม (ISR) หรือการวางแผนโลจิสติกส์

- Advanced Pipeline & Specialization (หลัง Bootcamp) — คอร์สเฉพาะทาง เช่น Deep Learning, Computer Vision, Natural Language Processing, Secure AI, Model Explainability ซึ่งอาจใช้เวลาเพิ่มเติม 3–9 เดือน ขึ้นกับความลึกของเนื้อหา

แล็บจำลองและสนามฝึก

การฝึกต้องมีสภาพแวดล้อมที่เลียนแบบการปฏิบัติจริง: แล็บข้อมูล (data labs) ที่มีชุดข้อมูลจริง/สังเคราะห์, cyber ranges สำหรับทดสอบความปลอดภัยของโมเดล, และสนามฝึกเชิงปฏิบัติการที่บูรณาการกับหน่วยปฏิบัติ เพื่อทดสอบการทำงานของระบบในสถานการณ์กดดัน ตัวอย่างกิจกรรมรวมถึง tabletop exercises, red-team/blue-team assessments และการ deploy แบบ incremental ในสภาวะแวดล้อมจำกัดก่อนขยายสู่การใช้งานจริง

การเรียนร่วมกับมหาวิทยาลัยและแพลตฟอร์มออนไลน์

การร่วมมือกับสถาบันชั้นนำช่วยให้เข้าถึงงานวิจัยและคอร์สเชิงทฤษฎี ส่วนการใช้แพลตฟอร์มออนไลน์ (เช่น Coursera, edX, Udacity หรือ vendor-specific เช่น AWS/Azure/Google Cloud certifications) ช่วยให้สามารถสเกลการฝึกอย่างรวดเร็วและรองรับการเรียนรู้ต่อเนื่อง ระบบเรียนผสมนี้ช่วยให้ทหารสามารถเรียนตามจังหวะงาน (self-paced) พร้อมทั้งรับรองด้วย micro-credentials หรือใบรับรองจากมหาวิทยาลัยและผู้ให้บริการคลาวด์

การประเมินผลและตัวชี้วัดความสำเร็จ

- ระยะเวลาพร้อมปฏิบัติจริง (Time-to-Operational) — เป้าหมายเชิงนโยบายอาจระบุว่าเจ้าหน้าที่ระดับพื้นฐานควรพร้อมนำไปใช้ในงานจริงภายใน 3–6 เดือนหลังเริ่มโปรแกรม (ขึ้นกับความซับซ้อนของหน้าที่)

- อัตราการผ่านการรับรอง (Certification Pass Rate) — ตั้งเป้าการผ่านใบรับรองขั้นพื้นฐานไม่น้อยกว่า 75–85% ต่อรุ่น และการผ่านมาตรฐานเชิงปฏิบัติ (practical assessment) ไม่น้อยกว่า 70%

- KPIs ในเชิงปฏิบัติ — เช่น จำนวนโมเดลที่ deploy สำเร็จต่อรุ่น, เวลาเฉลี่ยในการแก้ปัญหา (MTTR) ของระบบ AI, ประสิทธิภาพโมเดล (accuracy/F1) และอัตราการนำผลลัพธ์ไปใช้ในภารกิจจริง

- ผลกระทบต่ออาชีพ — การติดตามเส้นทางอาชีพ (promotion, retention) เพื่อประเมินมูลค่าการลงทุนด้านการฝึกอบรม

แหล่งงบประมาณและการรับรองผลลัพธ์

แหล่งเงินทุนอาจมาจากการจัดสรรงบประมาณของกระทรวงกลาโหมและหน่วยงานย่อย (R&D และ training budgets), โครงการร่วมทุนภาครัฐ-เอกชน (public-private partnerships), ทุนวิจัยจากสถาบันการศึกษา รวมถึงโปรแกรมทุนการศึกษาสำหรับบุคลากร เช่น รายได้จากโครงการพัฒนากำลังพลหรือสิทธิประโยชน์การศึกษาทหาร (GI Bill ในกรณีพลเรือนที่เคยรับราชการ) นอกจากนี้ยังสามารถใช้การร่วมทุนกับผู้ให้บริการคลาวด์และผู้พัฒนาเทคโนโลยีเพื่อแลกกับการสนับสนุนด้านทรัพยากรและใบรับรอง

การรับรองผลลัพธ์ควรประกอบด้วยทั้ง ใบรับรองทางวิชาการ, การรับรองจากผู้ให้บริการคลาวด์/แพลตฟอร์ม และ การประเมินเชิงปฏิบัติ ที่มีมาตรฐานชัดเจน ข้อมูลเชิงสถิติของโครงการควรถูกเก็บในระบบติดตามผล (dashboard) เพื่อรายงานต่อผู้บริหาร เช่น อัตราการผ่านการรับรอง, เวลาเฉลี่ยสู่การปฏิบัติจริง, และผลลัพธ์ต่อภารกิจ เพื่อให้สามารถปรับหลักสูตรและจัดสรรทรัพยากรได้อย่างมีประสิทธิภาพ

ผลกระทบต่อการปฏิบัติการและความพร้อมรบ

ผลกระทบต่อการปฏิบัติการและความพร้อมรบ

การเปิดเส้นทางอาชีพด้าน AI และการเรียนรู้ของเครื่องสำหรับนายทหารจะมีผลกระทบโดยตรงต่อรูปแบบการปฏิบัติการและระดับความพร้อมรบของกองทัพในหลายมิติ โดยเฉพาะการบูรณาการความสามารถด้านปัญญาประดิษฐ์เข้ากับระบบสนับสนุนการรวบรวมข่าวกรอง การตรวจตรา และการลาดตระเวน (ISR) ระบบโลจิสติกส์ และงานบำรุงรักษาเชิงคาดการณ์ การมีบุคลากรที่เชี่ยวชาญจะช่วยให้การนำโมเดล ML ไปใช้ในภารกิจจริงเป็นไปอย่างต่อเนื่องและปรับปรุงได้รวดเร็วขึ้น ส่งผลให้เวลาในการตัดสินใจสั้นลงและความแม่นยำของข้อมูลสำหรับผู้บังคับบัญชาดีขึ้น

ตัวอย่าง use cases ที่คาดว่าจะได้ประโยชน์อย่างชัดเจน ได้แก่:

- ISR (Intelligence, Surveillance, Reconnaissance) — การใช้ ML ในการผสานข้อมูลจากเซนเซอร์หลายแหล่ง (sensor fusion) และการทำ object detection อัตโนมัติ สามารถเพิ่มอัตราการตรวจจับเป้าหมายและลดอัตราส่วนสัญญาณรบกวน ตัวอย่างเชิงปริมาณ: เพิ่มความแม่นยำการคัดกรองจาก ~70% เป็น ~85–95% ในบางกรณี และลดเวลาที่นักวิเคราะห์ใช้ในการตรวจสอบภาพลง 40–60%.

- โลจิสติกส์และห่วงโซ่อุปทาน — การคาดการณ์ความต้องการ (demand forecasting) และการเพิ่มประสิทธิภาพเส้นทางโดย ML ช่วยลดต้นทุนการขนส่งและปรับปรุงความสม่ำเสมอของการส่งมอบ KPI ที่วัดได้อาจรวมถึง: ลดเวลาการส่งมอบเฉลี่ย 20–35%, ลดต้นทุนเชื้อเพลิง/การขนส่ง 10–25%, และเพิ่ม fill-rate ของสต็อกสำคัญขึ้น 15–40%.

- การบำรุงรักษาเชิงคาดการณ์ (Predictive Maintenance) — การวิเคราะห์สัญญาณจากอุปกรณ์ทำให้สามารถทำนายความล้มเหลวก่อนเกิดเหตุได้จริง ส่งผลให้เวลาที่ระบบพร้อมปฏิบัติการ (mission-capable time) เพิ่มขึ้น ตัวอย่างเชิงตัวเลข: ลดเวลาหยุดใช้งานโดยไม่คาดคิด (unscheduled downtime) 30–50% และลดค่าใช้จ่ายในการซ่อมบำรุงรวม 15–30%.

เพื่อประเมินผลลัพธ์ด้านการปฏิบัติการ ควรวัดตัวชี้วัดเชิงปริมาณที่ชัดเจน เช่น เวลาตอบสนอง (time-to-decision), ความแม่นยำในการตรวจจับ/คัดกรอง (detection/precision), อัตรา false positive/false negative, mean time to repair (MTTR), mission-capable rate และ ต้นทุนต่อปฏิบัติการ โดยเป้าหมายเบื้องต้นที่สามารถตั้งได้เป็นตัวเลขประมาณการ เช่นลดเวลาตัดสินใจของผู้บังคับบัญชาระดับสนามจากหลายชั่วโมงเหลือเป็นระยะเวลาเป็นนาที (ลดลง 30–70%) ขึ้นกับความซับซ้อนของภารกิจและความพร้อมของข้อมูล

อย่างไรก็ตาม การขึ้นกับ AI มากขึ้นย่อมมาพร้อมความเสี่ยงเชิงปฏิบัติการที่ต้องคำนึงถึงอย่างจริงจัง ได้แก่:

- ความเสี่ยงจากความผิดพลาดของระบบ (system brittleness) — โมเดล ML อาจทำงานไม่ถูกต้องภายใต้สถานการณ์นอกขอบเขตข้อมูลฝึก (out-of-distribution) ส่งผลให้การรับรู้สถานการณ์ผิดพลาด ซึ่งในภารกิจจริงอาจทำให้การตัดสินใจล่าช้าหรือผิดพลาด

- การโจมตีเชิงข้อมูลและ adversarial risk — คู่ต่อสู้อาจใช้เทคนิคปั่นป่วนข้อมูลหรือการโจมตี adversarial ทำให้โมเดลประเมินสถานการณ์ผิดพลาดได้เร็วขึ้น

- การพึ่งพามากเกินไปและการเสื่อมทักษะ — หากบุคลากรพึ่งพาระบบอัตโนมัติมากเกินไป ทักษะการวิเคราะห์เชิงมนุษย์อาจลดลง ส่งผลให้เมื่อระบบล้มเหลว การฟื้นตัวช้าหรือตัดสินใจผิดพลาด

- ความเสี่ยงจากความล้มเหลวแบบ single point — การวางสถาปัตยกรรมที่มีจุดล้มเหลวเดียว (เช่นบริการจัดการโมเดลศูนย์กลาง) อาจทำให้การปฏิบัติการทั้งหมดหยุดชะงักหากถูกทำลายหรือถูกทำให้ไร้ประสิทธิภาพ

เพื่อบรรเทาความเสี่ยงเหล่านี้ ควรออกแบบแนวทางปฏิบัติที่รวม human-in-the-loop, ระบบสำรอง (redundancy), การทดสอบความทนทานต่อภัยคุกคาม (adversarial testing), การตรวจสอบแบบต่อเนื่อง (continuous validation) และเกณฑ์ออกจากการใช้งานเมื่อโมเดลไม่เชื่อถือได้ ตัวอย่างการวัดผลการป้องกันได้แก่อัตราการฟื้นตัวจากความผิดพลาด (recovery time) ภายในชั่วโมง/นาที, อัตราความผิดพลาดที่ยอมรับได้ต่อภารกิจ (acceptable error threshold) และการออกแบบ fallback plans เพื่อให้การปฏิบัติการสามารถดำเนินต่อได้แม้ระบบ AI จะชะงัก

โดยสรุป การมีเส้นทางอาชีพด้าน AI สำหรับนายทหารมีศักยภาพเปลี่ยนแปลงรูปแบบการปฏิบัติการและยกระดับความพร้อมรบได้อย่างสำคัญ ทั้งด้านประสิทธิภาพ ความเร็ว และความแม่นยำ แต่ต้องมาพร้อมกับกรอบการบริหารความเสี่ยงที่ชัดเจนและการรักษาความสามารถของมนุษย์เพื่อป้องกันผลกระทบเมื่อระบบไม่ทำงานตามที่คาดหวัง

การสรรหา ประเมิน และกลยุทธ์การรักษากำลังคน

การสรรหา ประเมิน และกลยุทธ์การรักษากำลังคน

การขยายเส้นทางอาชีพด้านปัญญาประดิษฐ์ (AI) และการเรียนรู้ของเครื่อง (ML) ภายในกองทัพสหรัฐฯ จำเป็นต้องเริ่มจากระบบสรรหาที่ออกแบบมาเพื่อแข่งขันกับภาคเอกชน ทั้งในด้านเงินเดือน สิทธิประโยชน์ และโอกาสการพัฒนาอาชีพ ในทางปฏิบัติ กองทัพสามารถใช้มาตรการหลายรูปแบบร่วมกัน เช่น แพ็กเกจแรงจูงใจทางการเงิน (signing bonuses, retention bonuses, special/critical skills pay), ทุนการศึกษาและโครงการสนับสนุนการศึกษา (เช่นทุน STEM, โปรแกรม SMART scholarship) และ การบรรจุเข้าบรรดาศักดิ์โดยตรง (direct commissioning) สำหรับผู้มีวุฒิขั้นสูงหรือประสบการณ์เชิงเทคนิคที่ตรงความต้องการ ตัวอย่างเช่น การเสนอทุนเต็มจำนวนเพื่อเรียนปริญญาโทด้าน ML พร้อมข้อผูกมัดการรับราชการ หรือการมอบสิทธิพิเศษด้านการอนุมัติ clearance และการเลื่อนตำแหน่งที่เร่งด่วนสำหรับบุคลากรที่มีทักษะจำเป็น

การประเมินทักษะทางเทคนิคต้องเป็นไปตามมาตรฐานที่สามารถวัดได้และสอดคล้องกับความต้องการภารกิจ วิธีปฏิบัติที่ได้ผลรวมถึงการใช้ แบบทดสอบเชิงเทคนิค เช่น coding challenges, algorithmic assessments, และการทดลองปฏิบัติในสภาพแวดล้อมจำลอง (simulation-based assessments) รวมถึงการใช้การแข่งขันภายในหรือแพลตฟอร์มคล้าย Kaggle เพื่อคัดเลือกผู้มีผลงานโดดเด่น นอกจากการทดสอบเชิงเทคนิคแล้ว ควรมีกรอบความสามารถ (competency framework) ที่เชื่อมโยงกับเส้นทางอาชีพ (career ladder) เช่น ระบุชัดว่าระดับไหนต้องมีทักษะด้าน MLOps, model governance, หรือ security-aware AI นอกจากนี้ การรับรองความสามารถผ่านใบประกาศจากภายนอก (เช่น ใบรับรองคลาวด์/ML ของผู้ให้บริการรายใหญ่) จะช่วยให้ทักษะถูกยอมรับได้ง่ายเมื่อต้องย้ายไปสู่ภาคพลเรือน

เพื่อรักษาบุคลากรระยะยาว กองทัพต้องผสานทั้งมาตรการทางการเงินและไม่ใช่ทางการเงิน กลยุทธ์การรักษา ที่มีประสิทธิผลได้แก่ การกำหนดเส้นทางอาชีพที่ชัดเจนและโปร่งใส การจัดสรรเวลาสำหรับการเรียนต่อและวิจัย การให้โอกาสทำงานร่วมกับโครงการความท้าทายสูง (high-impact missions) ซึ่งเป็นจุดเด่นที่ภาคเอกชนมอบไม่ได้เสมอ รวมถึงการสร้างความร่วมมือกับอุตสาหกรรมและมหาวิทยาลัยเพื่อให้บุคลากรสามารถแลกเปลี่ยนความรู้และมีความก้าวหน้าเชิงเทคนิคอย่างต่อเนื่อง ตัวอย่างมาตรการ: สิทธิ์เข้าเรียนหลักสูตรปริญญาโทโดยไม่เสียค่าใช้จ่าย การจ่ายเงินชดเชยสำหรับการได้ใบรับรองเฉพาะทาง และโปรแกรม mentorship ที่เชื่อมโยงกับผู้นำด้าน AI ภายในกองทัพ

- มาตรการสรรหา (Recruitment): signing/retention bonuses, scholarships (เช่นทุน STEM/SMART-like), direct commissioning สำหรับผู้มีปริญญาเอกหรือประสบการณ์อุตสาหกรรม

- การประเมินทักษะ (Assessment): แบบทดสอบเชิงเทคนิค, การประเมินแบบจำลองงานจริง (simulation), portfolio/competition-based evaluation, ใบรับรองภายนอก

- การรักษาอาชีพ (Retention): เส้นทางอาชีพชัดเจน, โอกาสการศึกษาต่อ, งานที่มีความหมายและมีผลต่อภารกิจ, พันธมิตรภาคอุตสาหกรรม, สวัสดิการพิเศษ

ความเสี่ยงที่สำคัญคือการสูญเสียบุคลากรไปยังภาคเอกชน โดยเฉพาะเมื่อค่าตอบแทนในอุตสาหกรรมเทคโนโลยีมักสูงกว่าเงินเดือนของเจ้าหน้าที่ทหารหลายหมื่นถึงหลายแสนดอลลาร์ต่อปี โดยทั่วไปเงินเดือนวิศวกร AI ในภาคเอกชนอาจอยู่ในช่วงประมาณ $120,000–$200,000 ขึ้นไป ขณะที่ตำแหน่งผู้เชี่ยวชาญระดับสูงและผู้จัดการผลิตภัณฑ์ในบริษัทเทคโนโลยีชั้นนำอาจได้รับผลตอบแทนรวม (รวมหุ้น/โบนัส) สูงกว่านั้น ซึ่งเป็นปัจจัยกดดันการรักษากำลังคนของกองทัพ

มาตรการรับมือกับความเสี่ยงนี้ต้องเป็นทั้งเชิงนโยบายและเชิงปฏิบัติ ได้แก่:

- ปรับโครงสร้างค่าตอบแทนและสิทธิประโยชน์ เช่น เพิ่ม special pay หรือ retention bonus สำหรับทักษะวิกฤต และโครงการจ่ายคืนเงินกู้การศึกษา

- สร้างความยืดหยุ่นในการสลับบทบาท (flexible service models) เช่น การเปิดให้มีรูปแบบการปฏิบัติงานแบบร่วม (reserve/civilian-hybrid), short-term industry detailees, หรือการให้ลาพักไปทำงานภาคเอกชนภายใต้ข้อตกลงทางกฎหมายเพื่อลดแรงจูงใจลาออกถาวร

- เพิ่มมูลค่าที่ไม่ใช่การเงิน เช่น โอกาสทำงานกับปัญหาที่มีผลกระทบระดับชาติ, สิทธิ์ในการเข้าถึงโครงงานวิจัยระดับสูง, การรับรองและพอร์ตโฟลิโอที่โอนย้ายได้เมื่อเปลี่ยนงาน

- ลงทุนในการพัฒนาอย่างต่อเนื่อง โดยการให้ทุนเรียนต่อ ฝึกอบรมภายใน และการร่วมพัฒนาเทคโนโลยีกับพันธมิตรภายนอก เพื่อให้บุคลากรเห็นเส้นทางก้าวหน้าทางวิชาชีพภายในกองทัพ

สรุปได้ว่า การสร้างและรักษากำลังคนด้าน AI ภายในกองทัพต้องอาศัยชุดมาตรการสรรหา ประเมิน และรักษาอย่างบูรณาการ โดยผสมผสานแรงจูงใจทางการเงิน นโยบายการพัฒนาทางวิชาชีพ และรูปแบบการทำงานที่ยืดหยุ่น เพื่อแข่งขันกับภาคเอกชนและลดความเสี่ยงการสูญเสียบุคลากรที่เป็นทรัพยากรสำคัญต่อความมั่นคงและนวัตกรรมของกองทัพ

จริยธรรม นโยบายความปลอดภัย และการกำกับดูแล AI

จริยธรรมและมาตรการกำกับดูแลเชิงปฏิบัติ

การประยุกต์ใช้ปัญญาประดิษฐ์ในกองทัพจำเป็นต้องยึดหลักจริยธรรมอย่างเข้มงวด โดยเฉพาะอย่างยิ่งเมื่อตัดสินใจที่อาจส่งผลกระทบต่อชีวิตมนุษย์ แนวปฏิบัติ human-in-the-loop ควรถูกกำหนดเป็นมาตรฐานสำหรับการตัดสินใจเชิงปฏิบัติการที่เกี่ยวข้องกับการใช้กำลังหรือการเลือกปฏิบัติ ตัวอย่างเช่น ระบบช่วยตัดสินใจด้านเป้าหมายต้องมีผู้บังคับบัญชามนุษย์ตรวจสอบและยืนยันก่อนการปฏิบัติการ ทั้งนี้ควรกำหนดระดับการควบคุมมนุษย์ตามความรุนแรงของผลกระทบ (risk tiering) เพื่อให้ความรับผิดชอบและการตัดสินใจเป็นไปอย่างชัดเจนและสามารถตรวจสอบย้อนหลังได้

มาตรการ auditing และ bias mitigation ต้องบูรณาการตั้งแต่ขั้นตอนการออกแบบข้อมูลและการเทรนนิ่ง โดยใช้แนวทางเช่น dataset documentation (datasheets, model cards), การสุ่มตรวจเชิงสถิติ และการทดสอบข้ามกลุ่มประชากร (cross-demographic testing) เพื่อป้องกันความลำเอียง ตัวอย่างเช่น งานวิจัยของ NIST พบว่าระบบจดจำใบหน้ามีข้อผิดพลาดแตกต่างกันอย่างมีนัยสำคัญระหว่างกลุ่มเพศและเชื้อชาติ ซึ่งแสดงให้เห็นว่าการประเมินเชิงปริมาณและการแก้ไขเบื้องต้นเป็นสิ่งจำเป็นก่อนนำระบบไปใช้ในบริบททางทหาร

การปกป้องข้อมูลและการทดสอบความน่าเชื่อถือของโมเดล

ข้อมูลทหารมักมีความอ่อนไหวสูง ทั้งข้อมูลส่วนบุคคลของกำลังพล ข้อมูลยุทธศาสตร์ และข้อมูลเซนเซอร์ที่เกี่ยวข้อง การควบคุมการเข้าถึงด้วยมาตรการเช่น การเข้ารหัสข้อมูลระหว่างพักและระหว่างส่ง (encryption-at-rest and in-transit), การจัดการคีย์ที่เข้มงวด, และการแบ่งระดับสิทธิ์การเข้าถึง (role-based access control) เป็นพื้นฐาน นอกเหนือจากนั้นควรใช้เทคนิคความเป็นส่วนตัวเช่น differential privacy หรือ federated learning เมื่อเป็นไปได้เพื่อลดความเสี่ยงของการรั่วไหลของข้อมูลต้นฉบับ

การทดสอบความน่าเชื่อถือของโมเดลต้องรวมการประเมินด้านความปลอดภัยเชิงเทคนิค (adversarial robustness), การทดสอบสภาพแวดล้อมจริง (field testing), และการทดสอบเพื่อหาจุดล้มเหลว (stress testing) แนะนำให้มีกระบวนการ red-team/blue-team แบบสม่ำเสมอเพื่อค้นหาช่องโหว่เชิงปฏิบัติการและประเมินผลกระทบจากการโจมตีเชิงข้อมูล นอกจากนี้ควรกำหนดมาตรฐานการวัดความถูกต้อง ความเสถียร และความสามารถในการอธิบายผลลัพธ์ (explainability) ก่อนอนุมัติใช้งาน

กรอบกำกับดูแล การยอมรับจากสาธารณะ และความร่วมมือระหว่างพันธมิตร

ในแง่ของกรอบกำกับดูแล ควรยึดตามหลักการและแนวทางที่หน่วยงานด้านความมั่นคงระหว่างประเทศและองค์กรมาตรฐานเสนอไว้ เช่น DoD AI Ethical Principles ที่ระบุหลักการ 5 ประการ (Responsible, Equitable, Traceable, Reliable, Governable) รวมถึงการประสานกับกรอบการบริหารความเสี่ยงของ NIST (AI RMF) และกฎหมายอำนาจหน้าที่ที่เกี่ยวข้อง เช่น กฎหมายว่าด้วยการคุ้มครองข้อมูลส่วนบุคคลและกฎหมายสงคราม (laws of armed conflict)

การยอมรับจากสาธารณะและพันธมิตรเกิดขึ้นได้จากความโปร่งใสในการกำหนดนโยบาย การเผยแพร่รายงานการตรวจสอบที่ไม่เปิดเผยข้อมูลความลับเชิงยุทธศาสตร์ และการเปิดรับการประเมินจากบุคคลที่สาม (third‑party audits) เพื่อสร้างความเชื่อมั่น ตัวอย่างแนวปฏิบัติที่ควรพิจารณาได้แก่ การเปิดเผยเกณฑ์การทดสอบพื้นฐาน (benchmarking), การเผยแพร่ผลการตรวจสอบที่คัดกรองความลับ, และการร่วมมือกับพันธมิตรเพื่อพัฒนามาตรฐานร่วม (interoperable standards)

ข้อเสนอแนะเชิงสถาบัน: คณะกรรมการภายในและกลไกตรวจสอบภายนอก

- คณะกรรมการจริยธรรม AI ภายในกองทัพ — ประกอบด้วยผู้เชี่ยวชาญด้านเทคโนโลยี ข้อมูล กฎหมาย และจริยธรรม รวมถึงตัวแทนจากหน่วยงานปฏิบัติการ เพื่อทำหน้าที่ประเมินความเสี่ยง จัดชั้นความเสี่ยง (risk categorization) และอนุมัติการใช้งานในแต่ละกรณี

- คณะกรรมการตรวจสอบภายนอก/ที่ปรึกษาอิสระ — ควรมีผู้เชี่ยวชาญจากสถาบันวิชาการ องค์กรไม่แสวงหากำไร และพันธมิตรระหว่างประเทศ มาให้ความเห็นเชิงนโยบายและตรวจสอบการปฏิบัติตามหลักสิทธิมนุษยชนและกฎหมายระหว่างประเทศ

- กลไกการรายงานและการตรวจสอบต่อเนื่อง — ระบบบันทึกการตัดสินใจ (decision logs), การเก็บ audit trails, และการตรวจสอบเป็นระยะ (periodic compliance reviews) เพื่อให้สามารถเรียกดูและสืบสวนได้เมื่อเกิดปัญหา

- มาตรการรับผิดชอบและการเยียวยา — กำหนดนโยบายชัดเจนเกี่ยวกับความรับผิดชอบทางกฎหมายและการเยียวยาในกรณีที่เกิดความเสียหายจากการใช้งาน AI

สรุปคือ กองทัพควรสร้างระบบกำกับดูแลที่ผสมผสานมาตรการทางเทคนิคและสถาบัน เพื่อให้การใช้งาน AI เป็นไปอย่างปลอดภัย เชื่อถือได้ และชอบธรรม การนำหลักการ human oversight, auditing ที่แข็งแกร่ง, การป้องกันและลด bias ในข้อมูล, การทดสอบความน่าเชื่อถือของโมเดล และการมีคณะกรรมการภายในร่วมกับกลไกตรวจสอบภายนอก จะช่วยลดความเสี่ยงและเพิ่มความชอบธรรมของโครงการ AI ในบริบททางทหารทั้งในสายตาของสังคมและพันธมิตรระหว่างประเทศ

ความร่วมมือกับภาคเอกชนและการเปรียบเทียบตลาดแรงงานพลเรือน

ความร่วมมือกับภาคเอกชน สถาบันการศึกษา และศูนย์วิจัย

เพื่อสร้างเส้นทางอาชีพด้านปัญญาประดิษฐ์ (AI) และการเรียนรู้ของเครื่อง (ML) ที่มีประสิทธิภาพ กองทัพสหรัฐฯ มักจะผสานความร่วมมือกับพาร์ทเนอร์หลากหลายรูปแบบ ได้แก่ ผู้ให้บริการคลาวด์และแพลตฟอร์ม AI รายใหญ่ (เช่น Google Cloud, Microsoft Azure, AWS, NVIDIA), ผู้ผลิตฮาร์ดแวร์และซอฟต์แวร์เฉพาะทาง และผู้รับเหมาด้านความมั่นคง (เช่น Lockheed Martin, Raytheon) เพื่อเข้าถึงทรัพยากร เทคโนโลยี และสภาพแวดล้อมทดสอบที่ทันสมัย

ในส่วนของสถาบันการศึกษา กองทัพมักจัดทำความร่วมมือกับมหาวิทยาลัยชั้นนำที่มีโปรแกรมด้าน AI/ML เข้มข้น (เช่น MIT, Stanford, Carnegie Mellon, Georgia Tech และ Naval Postgraduate School) ในรูปแบบของหลักสูตรร่วม โครงการวิจัยร่วม (joint labs) และทุนการศึกษาเพื่อพัฒนาความรู้เชิงลึก นอกจากนี้ ศูนย์วิจัยของรัฐและของกระทรวงกลาโหม (เช่น DARPA, Army Research Lab, Air Force Research Laboratory) มีบทบาทเป็นศูนย์กลางกลางที่เชื่อมโยงงานวิจัยขั้นสูงกับการใช้งานจริงในภาคสนาม

ตัวอย่างกลไกความร่วมมือที่ปฏิบัติได้จริง ได้แก่ โครงการแลกเปลี่ยนบุคลากรระหว่างกองทัพกับบริษัทเทคโนโลยี (detail-for-development หรือ fellowship models), โปรแกรมฝึกงานระยะสั้นและระยะยาวสำหรับทหารและพลเรือน, การให้สิทธิการเข้าถึงคลาวด์และชุดเครื่องมือ AI ภายใต้ข้อตกลงพิเศษ, รวมถึงการร่วมลงทุนในศูนย์ฝึกหรือห้องปฏิบัติการที่มีมาตรการปกป้องข้อมูลและมาตรฐานความปลอดภัยสูง

การเปรียบเทียบค่าตอบแทน โอกาสในตลาดพลเรือน และความเสี่ยงต่อการสูญเสียบุคลากร (attrition)

ตลาดแรงงานพลเรือนสำหรับงาน AI/ML ยังคงเติบโตอย่างรวดเร็ว โดยหลายแหล่งข้อมูลระบุว่าตำแหน่งที่เกี่ยวข้องกับ AI/ML มีอัตราการเติบโตสูงกว่าค่าเฉลี่ยอุตสาหกรรมไอที ตัวอย่างเช่น รายงานอุตสาหกรรมหลายฉบับระบุการเติบโตสะสมของงาน AI/ML ในช่วงหลายปีที่ผ่านมาอยู่ในช่วงตัวเลขเลขหลักสอง (เช่น 15–40% ในบางช่วงเวลา) ส่งผลให้ความต้องการบุคลากรมีสูงต่อเนื่อง

ด้านค่าตอบแทน ผู้ประกอบการภาคเอกชนเสนอเงินเดือนเฉลี่ยและแพ็กเกจผลตอบแทนที่น่าสนใจสำหรับวิศวกร ML และนักวิจัย AI — โดยทั่วไปเงินเดือนพื้นฐานในสหรัฐฯ สำหรับตำแหน่ง ML Engineer/Machine Learning Scientist มักอยู่ในช่วงประมาณ $120,000–$160,000 ต่อปี ขึ้นอยู่กับตำแหน่งและพื้นที่ (ข้อมูลจากรายงานของ Glassdoor/Indeed/LinkedIn ในช่วงไม่กี่ปีที่ผ่านมา) ขณะที่กองทัพให้ค่าตอบแทนในรูปแบบฐานเงินเดือนตามยศและระดับประสบการณ์ บวกด้วยสิทธิประโยชน์เช่นที่อยู่อาศัย บริการสาธารณสุข และบำนาญ ซึ่งเมื่อนำมาคำนวณเป็นมูลค่ารวมแล้วอาจทำให้แพ็กเกจของกองทัพมีความสามารถในการแข่งขันในบางกรณี แต่โดยทั่วไปค่าตอบแทนตรงที่เป็นเงินสดในภาคพลเรือนมักสูงกว่าโดยเฉพาะสำหรับผู้ที่มีทักษะด้าน AI/ML เชิงลึก

ผลกระทบต่อการรักษากำลังคน (attrition) มีความสำคัญ: เมื่อทหารผ่านการฝึกที่มีมูลค่าสูงแล้ว พบว่าความเสี่ยงที่บุคลากรจะลาออกและย้ายไปสู่ภาคเอกชนมีแนวโน้มสูง เพราะภาคเอกชนเสนอเงินเดือนตรงกว่า โอกาสเติบโตอย่างรวดเร็ว และสภาพแวดล้อมการทำงานแบบเริ่มอิสระ ดังนั้นหากกองทัพไม่สามารถเสนอเส้นทางอาชีพที่ชัดเจน ค่าตอบแทนที่แข่งขันได้ หรือโอกาสพัฒนาที่สอดคล้องกับตลาดภายนอก อัตราการสูญเสียบุคลากรที่มีทักษะสูงอาจเพิ่มขึ้นอย่างมีนัยสำคัญ

ข้อเสนอเชิงนโยบายเพื่อเสริมความสามารถในการแข่งขันของกองทัพ

- ปรับโครงสร้างค่าตอบแทนและโบนัสเชิงทักษะ — จัดสรรโบนัสการรักษา (retention bonuses), เงินตอบแทนพิเศษสำหรับทักษะ AI/ML, และค่าตอบแทนให้ตรงกับค่าตลาดของภาคเอกชนเมื่อต้องการรักษาคนสำคัญ

- ขยายความร่วมมือเชิงยุทธศาสตร์กับภาคเทคและมหาวิทยาลัย — ทำข้อตกลงร่วมวิจัย การให้ใบรับรองหรือปริญญาแบบร่วม และโปรแกรม fellowship/secondment ที่เปิดทางกลับมาทำงานในกองทัพหลังจากการปฏิบัติในภาคเอกชน

- พัฒนาเส้นทางอาชีพที่ชัดเจนและโปรไฟล์ทักษะที่ถ่ายโอนได้ — สร้างกรอบอาชีพ (career ladder) สำหรับตำแหน่ง AI/ML ที่รวมการฝึกอบรมต่อเนื่อง การรับรอง และการบันทึกผลงานเพื่อเพิ่มความชัดเจนและโอกาสเลื่อนตำแหน่ง

- เพิ่มการเข้าถึงทรัพยากรและโครงสร้างพื้นฐาน — ให้การเข้าถึงคลาวด์ พื้นที่ทดสอบ และชุดข้อมูลที่ได้รับการเปิดใช้งาน (ภายใต้มาตรการความปลอดภัย) เพื่อให้ทหารสามารถทำวิจัยและพัฒนาได้เทียบเท่าภาคเอกชน

- สร้างโปรแกรมร่วมจ้างและการหมุนเวียนบุคลากร — เปิดโอกาสให้บุคลากรทำงานร่วมกับบริษัทเอกชนภายใต้สัญญาระยะสั้น (detail, rotation) เพื่อเก็บเกี่ยวประสบการณ์ภายนอกโดยยังคงผูกพันกับกองทัพ

- วางมาตรการป้องกันความเสี่ยงการสูญเสียบุคลากร — ใช้นโยบายการผูกมัดเป็นลำดับขั้น เช่น การให้ทุนการศึกษาที่ผูกพันด้วยระยะเวลาบริการหลังการศึกษา และการเสนอแพ็กเกจสวัสดิการที่ส่งผลต่อความพึงพอใจระยะยาว

สรุปคือ ความสามารถในการแข่งขันของกองทัพในการดึงและรักษาบุคลากร AI/ML ขึ้นอยู่กับการผสมผสานระหว่างการให้ค่าตอบแทนที่เหมาะสม โอกาสฝึกอบรมและความก้าวหน้าในอาชีพ และการสร้างความร่วมมือที่เชื่อมโยงกับนวัตกรรมในภาคเอกชนและสถาบันการศึกษา การออกแบบนโยบายที่ยืดหยุ่นและมุ่งเน้นคุณค่าทั้งทางการเงินและทางอาชีพจะเป็นกุญแจสำคัญในการรักษากำลังคนที่มีทักษะสูงไว้กับองค์กรระยะยาว

แผนการดำเนินงาน ตัวชี้วัดความสำเร็จ และกรอบเวลา

แผนการดำเนินงานและกรอบเวลา (Timeline)

การนำเส้นทางอาชีพด้าน AI และการเรียนรู้ของเครื่องไปใช้ในกองทัพสหรัฐฯ ควรแบ่งเป็นสามระยะหลัก ได้แก่ ระยะทดสอบ (pilot), ระยะขยายผล (scale-up) และระยะบูรณาการเต็มรูปแบบ (full integration) โดยระยะเวลาที่แนะนำเป็นกรอบเวลาเชิงปฏิบัติการเพื่อการวางแผนทรัพยากรและการประเมินผลอย่างเป็นระบบ:

- ระยะ Pilot (12–18 เดือน): เปิดโปรแกรมฝึกอบรมเบื้องต้นกับหน่วยนำร่อง 3–5 หน่วยงาน รวมทั้งพัฒนาหลักสูตรการรับรองเบื้องต้น การติดตั้งระบบต้นแบบ และการวัดผลเชิงประสิทธิภาพสำหรับกรณีใช้งานจริง โดยมีการเก็บข้อมูลพื้นฐาน (baseline) สำหรับตัวชี้วัดทุกตัว

- ระยะ Scale-up (18–36 เดือน): ขยายการฝึกและการประยุกต์ใช้ไปยังหน่วยปฏิบัติการเพิ่มเติม ปรับปรุงหลักสูตรให้ครบถ้วน เปิดศูนย์ฝึกเฉพาะทาง และเริ่มรวม AI ในกระบวนการปฏิบัติการหลายรูปแบบ พร้อมการตั้งค่า governance และมาตรการความปลอดภัยของข้อมูล

- ระยะ Full Integration (36–60 เดือน): บูรณาการเส้นทางอาชีพและความสามารถด้าน AI เป็นส่วนหนึ่งของโครงสร้างกำลังประจำ (enduring capabilities) ครอบคลุมการรับรองตามมาตรฐาน บุคลากรสำคัญในบทบาท AI มีเส้นทางเลื่อนตำแหน่ง และระบบ AI ถูกผนวกรวมเข้ากับการตัดสินใจเชิงปฏิบัติการในระดับกว้าง

ตัวชี้วัดความสำเร็จเชิงปริมาณและเชิงคุณภาพ (KPIs)

การกำหนด KPIs ที่ชัดเจนทั้งเชิงปริมาณและเชิงคุณภาพเป็นหัวใจสำคัญของการติดตามผล เพื่อให้สามารถประเมินความคืบหน้าและผลกระทบต่อภารกิจได้อย่างเป็นรูปธรรม ตัวอย่าง KPIs ที่แนะนำมีดังนี้:

- การรับรองและกำลังคน: จำนวนบุคลากรที่ผ่านการรับรองตามระดับ (เลเวล 1–3) ต่อปี เช่น เป้าหมายเบื้องต้นของระยะ Pilot = 200–500 คน, ระยะ Scale-up = 2,000–5,000 คน, ระยะ Full Integration = 20,000+ คน

- Readiness Metrics: สัดส่วนนายทหาร/หน่วยที่ผ่านเกณฑ์ AI-readiness (ระบบ, เครือข่าย, ความรู้) เช่น เป้าหมาย 70% ในระยะ Scale-up และ 90% ในระยะ Full Integration

- ประสิทธิผลของการตัดสินใจ: เวลาที่ระบบ AI ช่วยลดในการตัดสินใจ (เชิงเฉลี่ย) เช่น ลดเวลาในการตัดสินใจ 20–40% ในกรณีใช้งานที่เหมาะสม และอัตราความถูกต้อง/ความแม่นยำของคำแนะนำจากโมเดล (accuracy, precision/recall)

- การคงอยู่และการพัฒนาอาชีพ: อัตราการคงอยู่ของบุคลากรที่ผ่านการฝึก (retention) เช่น ปรับเป้าหมายเพิ่มขึ้น 5–10% ต่อปีเมื่อเทียบกับกลุ่มควบคุม และสัดส่วนผู้ผ่านการรับรองที่ได้เลื่อนตำแหน่งภายใน 3 ปี

- ผลการดำเนินงานภารกิจ: ตัวชี้วัดเช่นเวลาการปฏิบัติภารกิจต่อจุดหมาย, อัตราความผิดพลาด, การลดทรัพยากรที่ใช้ในการตัดสินใจ (cost-per-decision) และ uptimes/availability ของระบบ (เช่น 99% SLA สำหรับระบบสำคัญ)

- คุณภาพการฝึกอบรม: อัตราการผ่านการทดสอบ (pass rate) ของหลักสูตร, คะแนนความพึงพอใจของผู้เรียน, และตัวชี้วัดการถ่ายโอนความรู้ไปยังภาคปฏิบัติ (on-the-job performance)

แหล่งงบประมาณและการรายงานผลต่อหน่วยงานกำกับ

การจัดสรรงบประมาณควรผสานหลายแหล่งเพื่อสร้างความยืดหยุ่นและความต่อเนื่อง โดยแหล่งเงินทุนที่เป็นไปได้รวมถึง:

- งบประมาณประจำของกระทรวงกลาโหม (DoD budget lines): สำหรับการฝึกอบรมบุคลากร, โครงสร้างพื้นฐาน และการบูรณาการระบบภายในหน่วย

- เงินสนับสนุนจากหน่วยงานวิจัยและนวัตกรรม: เช่น DARPA, Defense Innovation Unit และโครงการ R&D ที่ได้รับการจัดสรรเพื่อพัฒนาขีดความสามารถเฉพาะทาง

- เงินทุนตามสัญญาและความร่วมมือภาคเอกชน: การร่วมทุน (public-private partnerships) สำหรับการพัฒนาเครื่องมือฝึกอบรม, การรับรอง และแพลตฟอร์มการเรียนรู้

- การจัดสรรพิเศษจากสภาคองเกรส: สำหรับการขยายสเกลหรือโครงการนำร่องที่มีความสำคัญระดับชาติ

การรายงานผลควรมีความโปร่งใสและสอดคล้องกับระเบียบกำกับดูแล โดยมีช่องทางและความถี่ที่แนะนำดังนี้:

- รายงานเป็นประจำ (Quarterly dashboards): เผยแพร่ต่อผู้บริหารระดับสูงของ DoD, ผู้บัญชาการกองทัพแต่ละเหล่าทัพ และคณะทำงานด้าน AI ภายในหน่วยงาน เพื่อใช้ในการตัดสินใจเชิงนโยบายและการจัดสรรงบประมาณ

- รายงานประจำปีต่อสภาคองเกรสและหน่วยงานกำกับ: สรุปผลการดำเนินงานเชิงกลยุทธ์, ความคืบหน้า KPIs หลัก, และการใช้งบประมาณ รวมถึงคำชี้แจงเรื่องความเสี่ยงและแผนบรรเทา

- การตรวจสอบอิสระและการประเมินโดยบุคคลที่สาม: มอบหมายให้ GAO, Inspector General ของ DoD หรือนักประเมินภายนอกทำการตรวจสอบประจำช่วงเวลาเพื่อยืนยันความถูกต้องของข้อมูลและการปฏิบัติตามหลักธรรมาภิบาล

- การสื่อสารสาธารณะแบบคัดกรอง: รายงานสรุปสำหรับสาธารณะและผู้มีส่วนได้ส่วนเสียโดยคำนึงถึงการปกป้องข้อมูลลับและความมั่นคง โดยเผยแพร่เป็นรายงานสรุปรายปีหรืออินโฟกราฟิกที่ไม่เปิดเผยรายละเอียดที่เป็นความลับ

กรอบการประเมินและการปรับปรุงอย่างต่อเนื่อง

เพื่อให้โครงการมีความยั่งยืน จำเป็นต้องมีวงจรการประเมินและการปรับปรุง (M&E loop) ที่ชัดเจน ซึ่งรวมถึงการตั้ง baseline ก่อนเริ่ม, การเก็บข้อมูลแบบต่อเนื่อง, การวิเคราะห์เชิงสาเหตุ (root-cause analysis) เมื่อตัวชี้วัดไม่เป็นไปตามเป้า และการทบทวนเชิงนโยบายทุก 12 เดือน โดยแนะนำให้รวมการทดสอบภาคปฏิบัติ (field trials), after-action reviews ภายหลังการใช้งานจริง และการอัปเดตหลักสูตรตามเทคโนโลยีและภัยคุกคามที่เปลี่ยนแปลง

เมื่อรวมกรอบเวลา KPIs แหล่งงบประมาณ และกลไกการรายงานเข้าไว้ด้วยกัน กองทัพจะสามารถติดตามความคืบหน้า ประเมินผลกระทบเชิงปฏิบัติการ และปรับกลยุทธ์อย่างเป็นระบบ เพื่อให้เส้นทางอาชีพด้าน AI เป็นทรัพยากรเชิงยุทธศาสตร์ที่สนับสนุนภารกิจได้อย่างยั่งยืน

บทสรุป

การเปิดเส้นทางอาชีพด้านปัญญาประดิษฐ์และการเรียนรู้ของเครื่องของกองทัพสหรัฐฯ ถือเป็นก้าวสำคัญที่นำทักษะทางเทคนิคมาเชื่อมกับความพร้อมรบ โดยช่วยสร้างแรงจูงใจให้กำลังพลพัฒนาความชำนาญด้านการออกแบบ สอน และดูแลโมเดล AI สำหรับงานยุทธศาสตร์ ตัวอย่างการดำเนินการรวมถึงโปรแกรมฝึกอบรมร่วมกับมหาวิทยาลัยและอุตสาหกรรม ซึ่งคาดว่าจะต้องการบุคลากรเพิ่มเติมในระดับหลายพันคนภายใน 3–5 ปีข้างหน้า อย่างไรก็ตาม ความท้าทายที่สำคัญยังคงอยู่ทั้งเรื่องการสรรหาและการรักษาบุคลากรที่มีทักษะสูง การกำกับดูแลข้อมูลและระบบ (governance) รวมถึงการป้องกันความเสี่ยงจากความเอนเอียงของโมเดล การโจมตีแบบ adversarial และปัญหาด้านความปลอดภัยของข้อมูล

ความสำเร็จของโครงการนี้ขึ้นกับการวัดผลด้วยตัวชี้วัดที่ชัดเจน เช่น เวลาในการปรับใช้ระบบ (deployment time), ความแม่นยำและความเที่ยงธรรมของโมเดล, อัตราการลดข้อผิดพลาดของระบบ และความพร้อมในการตอบสนองต่อภัยคุกคามไซเบอร์ ตัวอย่างความร่วมมือที่ได้ผลดีคือหลักสูตรร่วมระหว่างกองทัพกับมหาวิทยาลัยชั้นนำและบริษัทเทคโนโลยี เพื่อสร้างเส้นทางรับรองทักษะ (certification pathways) และการฝึกภาคสนามที่จำลองสถานการณ์จริง กรอบจริยธรรมที่เข้มแข็ง — ครอบคลุมการกำกับดูแลการใช้ข้อมูล การทบทวนผลกระทบด้านสิทธิมนุษยชน และมาตรการตรวจสอบและถ่วงดุล — จะเป็นกุญแจสำคัญในการลดความเสี่ยงและสร้างความไว้วางใจทั้งภายในหน่วยงานและต่อสาธารณะ

มองไปข้างหน้า กองทัพควรผสมผสานการลงทุนด้านการศึกษา สร้างมาตรฐานความสามารถและเมตริกการปฏิบัติที่ชัดเจน ส่งเสริมพันธมิตรภาครัฐ–เอกชน และเตรียมกลไกทดสอบความทนทานของระบบ (red teaming / blue teaming) เพื่อรับมือกับภัยคุกคามใหม่ ๆ ความยั่งยืนของเส้นทางอาชีพนี้จะขึ้นอยู่กับการส่งเสริมวัฒนธรรมการเรียนรู้ตลอดชีวิต การประเมินผลโดยใช้ข้อมูลเชิงปริมาณ และการประกันว่าการใช้งาน AI สอดคล้องกับกรอบจริยธรรมที่โปร่งใสและเข้มงวด ซึ่งร่วมกันจะทำให้เทคโนโลยี AI สนับสนุนความพร้อมรบได้อย่างปลอดภัยและมีประสิทธิภาพในระยะยาว

📰 แหล่งอ้างอิง: Federal News Network